FireRedASR:多言語高精度音声認識のためのオープンソースモデル

はじめに

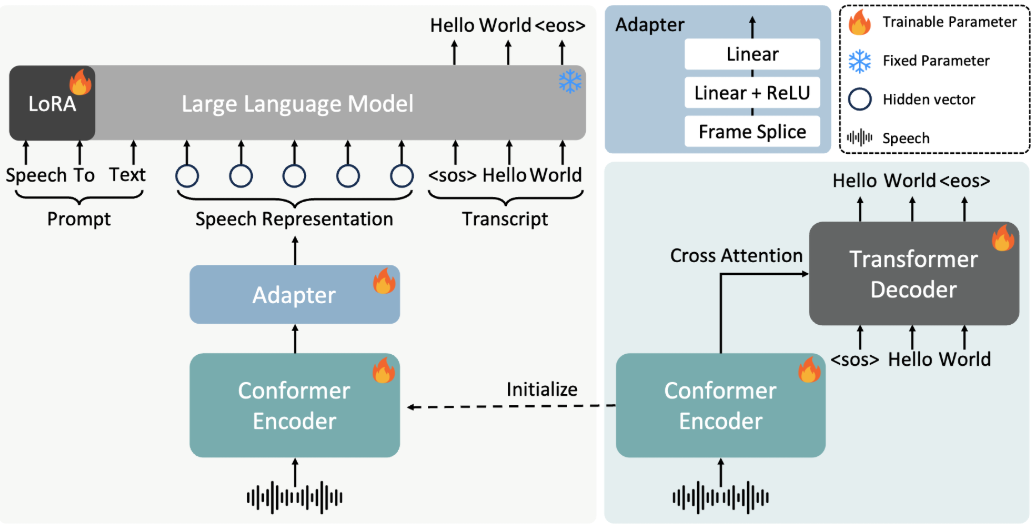

FireRedASRは、Little Red Book FireRedチームによって開発され、オープンソース化された音声認識モデルで、自動音声認識(ASR)ソリューションに高精度で多言語サポートを提供することに重点を置いています。FireRedASRは主に2つのバージョンに分かれています。FireRedASR-LLMは極めて高い精度を追求し、プロフェッショナルなニーズに適しています。FireRedASR-AEDは効率とパフォーマンスのバランスをとり、リアルタイムアプリケーションに適しています。2025年現在、このモデルは中国語マンダリン試験(CER 3.05%)で最適記録を樹立し、マルチシナリオテストでも好成績を収め、インテリジェントアシスタント、ビデオ字幕生成などの分野に広く応用されている。

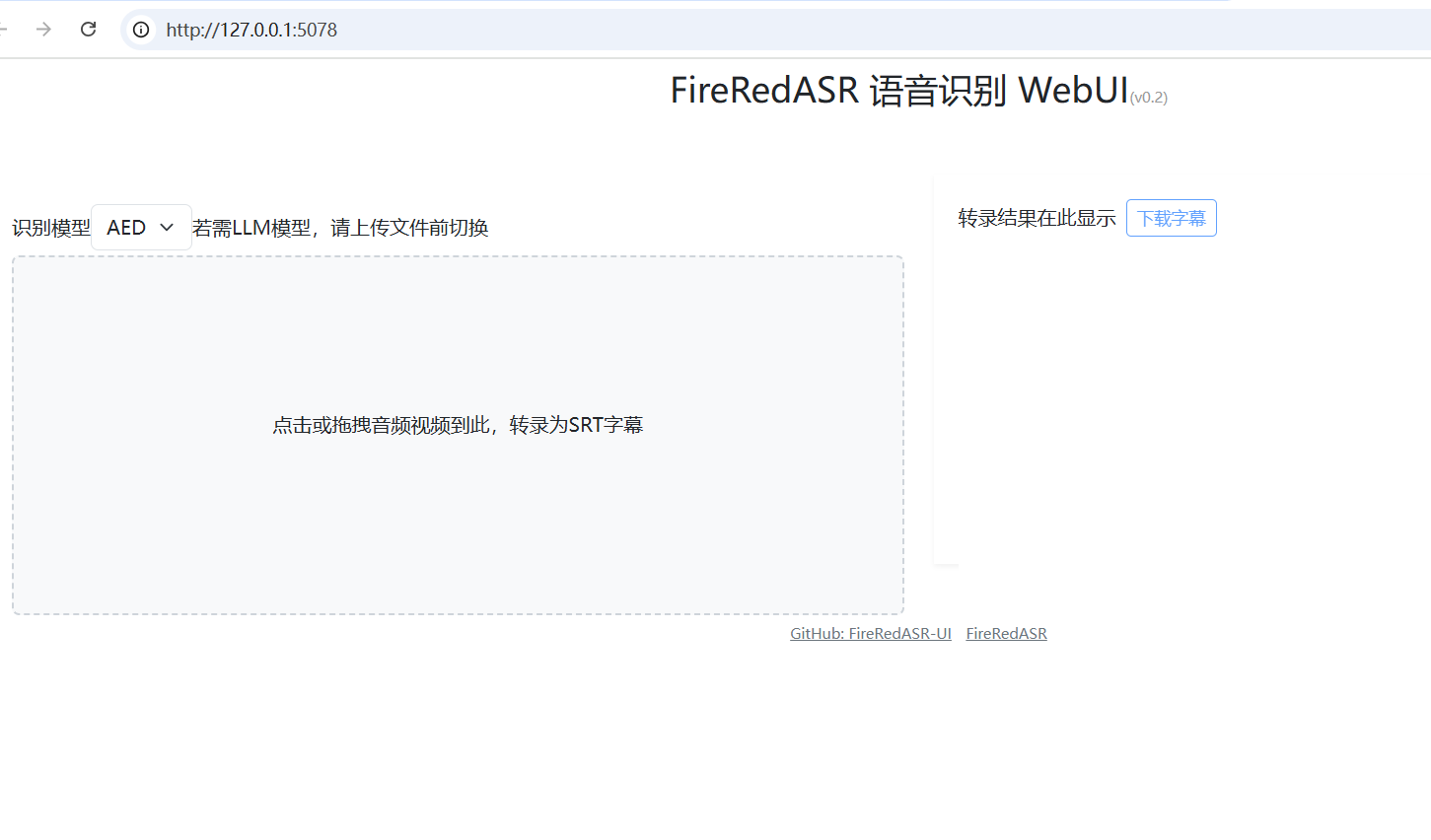

FireRedASR: WebUI ワンクリックインストーラ: https://github.com/jianchang512/fireredasr-ui

機能一覧

- 業界トップクラスの認識精度で、北京語、中国語方言、英語の音声合成をサポート。

- 歌詞認識機能を提供し、特にマルチメディアコンテンツの処理に適しています。

- FireRedASR-LLMとFireRedASR-AEDの2つのバージョンは、それぞれ高精度と高効率推論のニーズを満たすために含まれています。

- コミュニティによる二次開発やカスタマイズされたアプリケーションをサポートするオープンソースのモデルと推論コード。

- 短い動画、ライブストリーミング、音声入力など、さまざまな音声入力シーンに対応できる。

- バッチ音声処理をサポートしており、大規模なデータ転写作業に適しています。

ヘルプの使用

設置プロセス

FireRedASRを動作させるには、特定の開発環境設定が必要です:

1.プロジェクト・ウェアハウスのクローン

ターミナルを開き、以下のコマンドを入力してFireRedASRプロジェクトをローカルにクローンします:

git clone https://github.com/FireRedTeam/FireRedASR.git

終了したら、プロジェクト・カタログにアクセスする:

cd FireRedASR

- Python環境の作成

依存関係を確実に分離するために、Condaを使って別のPython環境を作成することを推奨する。以下のコマンドを実行してください:

conda create --name fireredasr python=3.10

環境を活性化させる:

conda activate fireredasr

- 依存関係のインストール

このプロジェクトはrequirements.txtファイルには必要な依存関係がすべて含まれている。インストール・コマンドは以下の通り:

pip install -r requirements.txt

インストールが完了するまで待ちます。ネットワークがスムーズであることを確認し、ダウンロードを高速化するために科学的なインターネットツールが必要な場合があります。

- 訓練済みモデルのダウンロード

- ファイアレッドASR-AED-LGitHubまたはHugging Faceから直接学習済みモデルをダウンロードし、それを

pretrained_models/FireRedASR-AED-Lフォルダー - ファイアレッドASR-LLM-Lモデルのダウンロードに加えて、Qwen2-7B-Instructモデルを

pretrained_modelsフォルダにFireRedASR-LLM-Lディレクトリにソフトリンクを作成する:

ln -s ../Qwen2-7B-Instruct

- インストールの確認

以下のコマンドを実行して、インストールが成功したかどうかを確認する:

python speech2text.py --help

ヘルプメッセージが表示されれば、環境は正しく設定されている。

使用方法

FireRedASRは、コマンドラインとPython APIの2つの方法を提供しており、以下は操作プロセスの主な機能の詳細です。

コマンドライン操作

- 単一ファイル転写(AEDモデル)

FireRedASR-AED-Lを使用して音声ファイル(最大60秒)を処理します:

python speech2text.py --wav_path examples/wav/BAC009S0764W0121.wav --asr_type "aed" --model_dir pretrained_models/FireRedASR-AED-L

--wav_path音声ファイルのパスを指定します。--asr_typeこの場合は "aed "です。--model_dirモデルフォルダを指定します。

出力は端末に表示される。例えば、書き起こされたテキスト・コンテンツ。

- 単一ファイル転写(LLMモデル)

FireRedASR-LLM-Lを使用して音声を処理します(最大30秒):

python speech2text.py --wav_path examples/wav/BAC009S0764W0121.wav --asr_type "llm" --model_dir pretrained_models/FireRedASR-LLM-L

パラメータの意味は上記と同じで、出力は転写されたテキストである。

PythonのAPI操作

- モデルの読み込みと書き起こし

PythonスクリプトでFireRedASRモデルを呼び出す:

from fireredasr.models.fireredasr import FireRedAsr

# 初始化 AED 模型

model = FireRedAsr.from_pretrained("aed", "pretrained_models/FireRedASR-AED-L")

batch_uttid = ["BAC009S0764W0121"]

batch_wav_path = ["examples/wav/BAC009S0764W0121.wav"]

results = model.transcribe(

batch_uttid, batch_wav_path,

{"use_gpu": 1, "beam_size": 3, "nbest": 1, "decode_max_len": 0}

)

print(results)

- フロム_プレトレイン指定されたモデルをロードします。

- 書き写す書き起こしタスクを実行し、結果をテキストのリストとして返す。

- 結果を最適化するためのパラメータ調整

- 使用GPUGPUアクセラレーションを使用する場合は1、CPUを使用する場合は0に設定します。

- ビームサイズデフォルトは3。

- 最高デフォルトは 1 です。

注目の機能操作

- 歌詞認識

FireRedASR-LLMは歌詞認識に優れています。曲の音声を入力し(30秒以上かからないようにしてください)、実行します:python speech2text.py --wav_path your_song.wav --asr_type "llm" --model_dir pretrained_models/FireRedASR-LLM-L**業界トップクラスの認識率で曲のテキストとして出力。 **

- 多言語サポート

方言や英語音声の場合は、上記のコマンドまたはAPIを直接使用すると、モデルが自動的に適応されます。例えば、英語の音声を処理する場合:model = FireRedAsr.from_pretrained("llm","pretrained_models/FireRedASR-LLM-L") results = model.transcribe(["english_audio"],["path/to/english.wav"],{"use_gpu":1}) print(results)

ほら

- オーディオの長さ制限AEDは60秒までサポートされるが、それを超えると幻覚の問題が発生する可能性がある。LLMは30秒までサポートされるが、それ以上の長時間の行動は未定。

- バッチファイルパフォーマンスの劣化を避けるため、入力音声の長さが同じになるようにしてください。

- ハードウェア要件CPUの処理速度が遅くなる可能性があるため、大規模なモデルの実行にはGPUを使用することをお勧めします。

以上の手順により、ユーザーはFireRedASRを簡単に使い始めることができ、インストールから使用までの全プロセスを完了することができます。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません