アナリストのアルベルト・ロメロは、OpenAIのGPT-5の登場はかなり遅れていると推測している。

新年をエキサイティングに始めよう!

- GPT-5によって生成される可能性がある

GPT-5は実在する。実在するだけでなく、あなたの見えないところですでに世界を形成しているのだ。オープンAIはGPT-5を開発したが、何百万人もの人々に公開するよりもROIがはるかに高いため、社内にとどめている。 チャットGPT ユーザーである。さらに、ROI(投資対効果)は お金じゃない。 むしろ、それ以外の何かだ。お分かりのように、アイデアは単純である。課題は、それを指し示す手がかりをつなぎ合わせることである。この記事では、私が考える手がかりが最終的につながる理由を掘り下げていく。

あらかじめお断りしておくが、これは純粋な憶測である。証拠はすべて公開されているが、私が正しいことを確認するためのリークや社内の噂はない。実際、私はこの記事を通じてこの仮説を構築しているのであって、単に共有しているわけではない。私は特権的な情報を持っていないし、たとえ持っていたとしても守秘義務契約に縛られている。この仮説に説得力があるのは 論理的 .正直なところ、この噂マシーンを始めるのに他に何が必要なんだ?

信じるか信じないかはあなた次第。たとえ私が間違っていたとしても--いずれ答えはわかるだろうが--私は楽しい探偵ゲームだと思う。コメント欄で憶測を交わすのは自由だが、建設的で思慮深いものにしてほしい。必ず最初に記事全体に目を通してください。それ以外の議論は大歓迎です。

I. オーパス3.5の謎の失踪

GPT-5を探求する前に、同じように行方不明になっている遠縁のいとこであるAnthropic'sについて触れなければならない。 クロード 作品3.5。

ご存知のように、OpenAI、Google DeepMind、Anthropicの3大AIラボは、価格/レイテンシ対性能のスペクトラムをカバーするモデルポートフォリオを提供している、GPT-4o、GPT-4o mini、o1、o1-miniがある。 ジェミニ Ultra、Pro、Flash、AnthropicにはClaude Opus、Sonnet、Haikuがあり、目標は明確だ。コストに関係なく最高のパフォーマンスを求める人もいれば、手頃な価格で十分なソリューションを必要とする人もいる。すべてが理にかなっている。

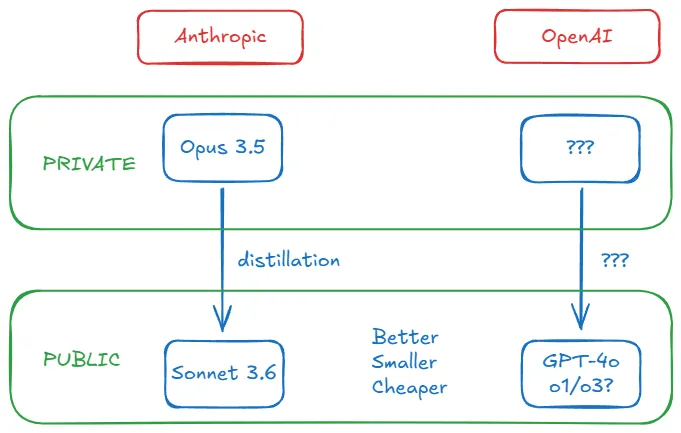

しかし、2024年10月に奇妙なことが起こった。誰もが アンソロピック GPT-4oに対抗してClaude Opus 3.5をリリース(2024年5月にリリース)すると、10月22日にClaude Sonnet 3.5のアップデート版(Sonnet 3.6として知られるようになった)をリリースし、これは姿を消し、AnthropicはGPT-4oと直接競合する製品を持たないままとなった。GPT-4o。奇妙だろう?ここで、Opus 3.5のタイムラインを簡単に見てみましょう:

- 10月28日、私は週刊誌のレビュー記事で「ソネット3.6は...という噂がある。期待されているOpus 3.5のトレーニングの失敗時に生成された中間チェックポイントである" と書いた。同日、r/ClaudeAIサブフォーラムに「Claude 3.5 Opus has been deprecated(クロード3.5のOpusは非推奨になった)」という投稿があり、Anthropic modelsのページにリンクが張られていた。この動きは、新たな資金調達に先立ち、投資家の信頼を維持するために行われたのではないかと推測されている。

- 11月11日、AnthropicのCEOであるダリオ・アモデイは、Lex FridmanのポッドキャストでOpus 3.5を発表した。

- 11月13日、ブルームバーグは、"トレーニング終了後、Anthropicは、3.5 Opusが評価において旧バージョンを上回ったが、モデルのサイズとランの構築コストを考えると、ブーストは期待を下回った "という初期の噂を確認した。 ダリオは、Opus 3.5のトレーニングが失敗しなかったにもかかわらず、結果が満足のいくものではなかったためと思われる、日付を示さなかった。へのフォーカスに注目してほしい。 コスト・パフォーマンス比 パフォーマンスだけではない。

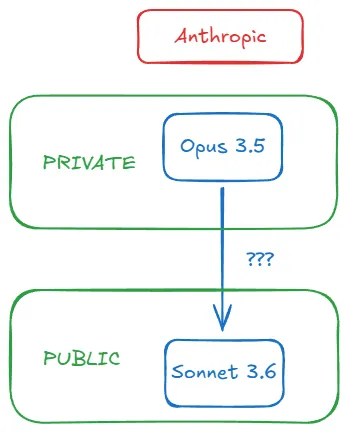

- 12月11日、半導体の専門家ディラン・パテルと彼のチームSemianalysisは、「Anthropicは、クロード3.5 Opusのトレーニングを完了し、良好なパフォーマンスを示した。Anthropicはクロード3.5 Opusのトレーニングを完了し、良い結果を出した。しかし、リリースしなかった。 クロード3.5オーパスによる合成データの生成 ボーナス・モデリングによってクロード3.5ソネットを大幅に強化する"

要するに、Anthropicはクロード・オーパス3.5をトレーニングしたのだが、結果が十分でなかったため、その名前を捨てたのである。Bloombergは、既存のモデルを凌駕しているが、推論コスト(モデルを使用するユーザーのコスト)が手の届かないものであることを確認し、Dylanのチームは、Sonnet 3.6と欠落していたOpus 3.5との関連性を明らかにした。

プロセス全体を図式化すると以下のようになる:

より良く、より小さく、より安く?

強力で高価なモデルを使ってデータを生成し、少し弱いが経済的なモデルを補強するプロセスを蒸留と呼ぶ。これは一般的な手法だ。この技術により、AIラボは事前学習だけでは限界を超えて、より小さなモデルのパフォーマンスを向上させることができる。

蒸留にはさまざまな方法があるが、ここでは触れない。覚えておくべき重要なことは、"教師 "としての強力なモデルが、"生徒 "モデルを[小さい、安い、速い]+から動かすことができるということである。 (をわずかに下回る。 小さい、安い、速い]に変身+。 恐るべき .ディランは、これがなぜAnthropicのOpus 3.5とSonnet 3.6の組み合わせに理にかなっているのかを説明する:

(新Sonnetの)推論コストは旧Sonnetと大きく変わっていませんが、モデルの性能は向上しています。3.5Opusでポストトレーニングすれば3.5Sonnetが手に入るのに、なぜコストの観点からわざわざ3.5Opusをリリースするのでしょうか?

コスト問題に話を戻すと、蒸留はパフォーマンスを向上させながら推論費用を抑制する。これは、Bloombergによって報告された核心的な問題に直接対処するものであり、AnthropicはOpus 3.5をリリースしないことを選択しました。(ディランは、これがオープンソースコミュニティがGPT-4に急速に追いついている理由であり、彼らはOpenAIの金鉱から直接金を奪っているのだと指摘している)

ソネット3.6が素晴らしいだけでなく、最も驚くべき啓示? トップレベル .Opus3.5まで蒸留することで、Anthropicのミッドレンジ・モデルはOpenAIのフラッグシップ・モデルを凌駕した(おそらく他の理由もあるだろうが、AIにおいて5ヶ月は十分に長い)。突然、高コストが高性能と同義であるという認識が崩れ始めた。

オープンエイのCEO、サム・アルトマンが「大きいことは良いことだ」と警告する時代は終わったのか?私はそれについて書いた。トップラボが秘密主義になったとき、彼らはパラメータ数を共有しなくなった。OpenAIが最後に公開したパラメータサイズは、2020年のGPT-3の1750億でした。2023年6月の噂では、GPT-4はハイブリッドエキスパートモデルで、パラメータは〜1.8兆でした。Semianalysisによるその後の詳細評価で、GPT-4は2023年7月に1兆7600億のパラメータを持つことが確認された。

2024年12月(今から1年半後)まで、AIの将来的な影響に焦点を当てた組織であるEpochAIの研究者であるEge Erdil氏は、GPT-4oやSonnet 3.6を含むフロンティアモデルのパラメータサイズがGPT-4よりも大幅に小さくなると推定している。両ベンチマークはGPT-4を上回っているが):

...第一世代のGPT-4oやクロード3.5ソネットのような現在のフロンティアモデルは、GPT-4よりも一桁小さいかもしれない。推定が大雑把なため、最大で2倍の誤差が生じる可能性があるが。

彼は、研究室がアーキテクチャの詳細を公表することなく、どのようにしてこの数字にたどり着いたかを詳しく説明しているが、それは我々にとっては重要なことではない。重要なのは、霧が晴れてきたということだ。AnthropicとOpenAIは同じような軌跡をたどっているようだ。彼らの最新モデルは優れているだけでなく、以前のモデルよりも小型で安価だ。AnthropicがOpus 3.5を蒸留することでこれを実現したことは知っている。しかし、OpenAIは何をしたのだろうか?

III.AIラボは普遍主義に突き動かされている

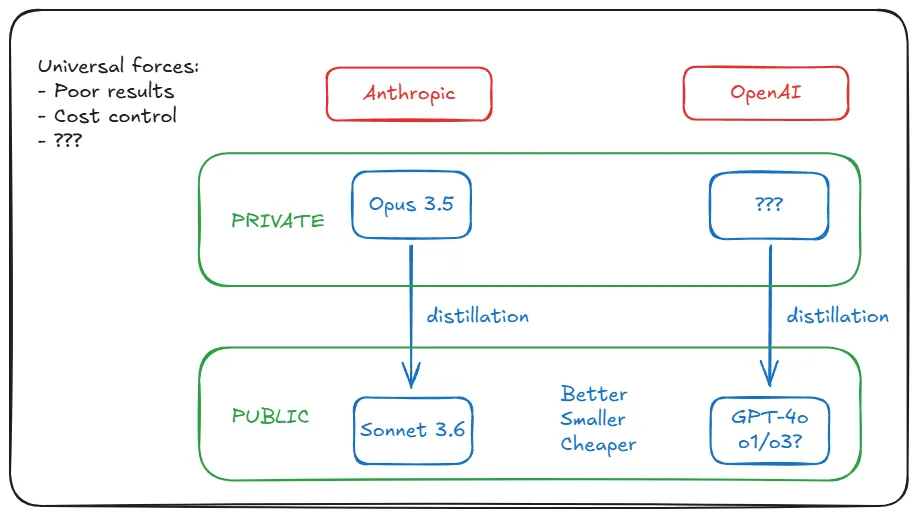

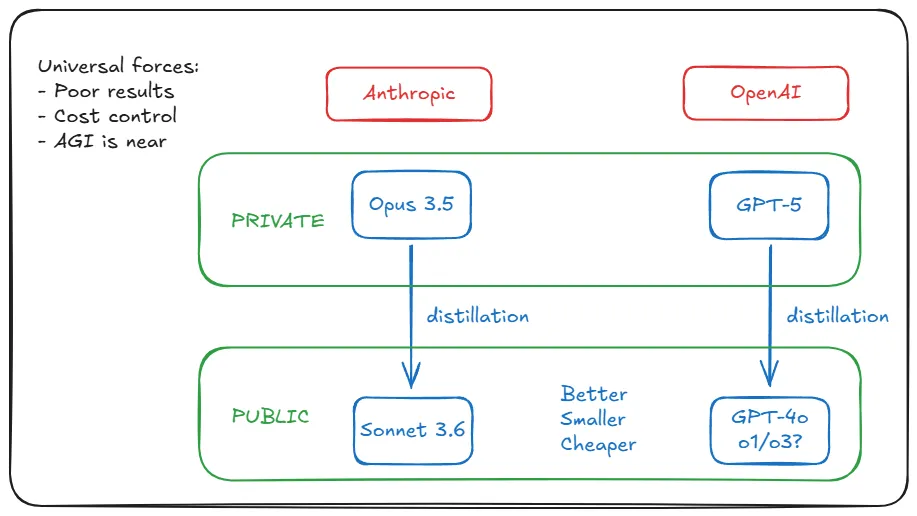

Anthropicの蒸留戦略は、Opus 3.5のトレーニング結果が芳しくないという特殊な状況に起因していると考える人もいるかもしれない。しかし、現実にはAnthropicの状況は特殊ではなく、Google DeepMindやOpenAIの最新のトレーニング結果も同様に満足のいくものではありません。(結果が悪いというのは モデルはもっと悪い。 )不十分なデータによる収穫の減少、トランスフォーマーアーキテクチャーの固有の限界、訓練前のスケーリング則のプラトーイングなどである。いずれにせよ、Anthropicの特定のコンテキストは、実際には普遍的なものである。

しかし、ブルームバーグの報道を思い出してほしい。これも共有された要因なのだろうか?ChatGPT/GPT-4ブーム後の需要の急増だ。ジェネレーティブAIは、ラボが継続的な拡大による損失を維持することが困難な速度で普及している。そのため、推論コストの削減を余儀なくされた(トレーニングは1回のみ、推論コストはユーザー数や使用量に応じて増大する)。毎週3億人のユーザーが利用するようになれば、運用コストは突然致命的なものになりかねない。

AnthropicがSonnet 3.6を蒸留で強化した要因は、指数関数的な強さでOpenAIに影響を及ぼしている。蒸留が効果的なのは、この2つの蔓延する課題を強みに変えるからだ。小さなモデルを提供することで推論コストの問題を解決する一方で、凡庸なパフォーマンスに対する世間の反発を避けるために大きなモデルはリリースしない。

エッジは、OpenAIはオーバートレーニングという選択肢を選ぶかもしれないと考えている。つまり、計算量的に最適でない状態で、より小さなモデルでより多くのデータをトレーニングすることだ。「推論がモデルの費用の大部分を占める場合、より小さなモデルでより多くのトークンをトレーニングするのが最善です。推論がモデルの経費の大部分を占める場合、より小さなモデルでより多くのトークンを訓練する方が良い。" しかし、オーバートレーニングはもはや実行不可能である。イーロン・マスクとイリヤ・サッツケバーが最近認めたように、AIラボは高品質の事前訓練データを使い果たした。

GPT-4oもクロード3.5ソネットも、より大きなモデルから蒸留されたものだろう。

ここまでのすべての手がかりは、OpenAIが、AnthropicがOpus 3.5で行ったこと(訓練と隠蔽)を、同じ方法(蒸留)で、同じ理由(結果の悪さ/コスト管理)で行っていることを示している。これは発見だ。しかし、ここからが重要なのです:オーパス3.5 まだ OpenAIのカウンターパートはどこに隠されているのか?会社の地下に隠されているのだろうか?その名前を当てる勇気はあるか?

IV.パイオニアは道を切り開かなければならない

分析の冒頭では、AnthropicのOpus 3.5イベントを検証する。そして、蒸留の概念をOpenAIに橋渡しし、Anthropicを動かしているのと同じ根本的な力がOpenAIにも作用していると説明します。しかし、私たちの理論は新たな障害にぶつかります。パイオニアとして、OpenAIはAnthropicがまだ遭遇していない障害に直面するかもしれません。

例えば、GPT-5のトレーニングに必要なハードウェア要件。ソネット3.6はGPT-4oに匹敵するが、リリースは5カ月後だ。GPT-5はより高性能で大規模という、より高いレベルにあると考えるべきだろう。推論コストだけでなく、トレーニングコストも高くなる。5億円のトレーニングコストがかかるかもしれない。既存のハードウェアで実現可能なのだろうか?

エジは再び解き放たれる:それは可能だ。このような巨大なものを3億人のユーザーに提供するのは現実的ではないが、トレーニングは問題ない:

例えば、GPT-4の50倍の大きさの100兆パラメータ・モデルで、推論コストは約3000ドル/100万出力トークン、出力レートは10~20トークン/秒である。しかし、これが実現可能であるためには、大規模なモデルが顧客にとって大きな経済的価値を生み出さなければならない。

しかし、マイクロソフト、グーグル、アマゾン(それぞれOpenAI、DeepMind、Anthropicのオーナー)でさえ、このような推論をする余裕はない。解決策は簡単だ。もし彼らが何兆ものパラメトリックモデルを一般に公開するつもりなら、「重要な経済的価値を生み出す」必要がある。だからそうしないのだ。

モデルをトレーニング。既存製品よりも優れたパフォーマンス」を発見した。しかし、「それを維持するための莫大なコストを正当化できるほどには改善されていない」ことを受け入れなければならない。(聞き覚えがあるだろうか?ウォール・ストリート・ジャーナル紙は1カ月前、GPT-5について、オーパス3.5に関するブルームバーグの報道と酷似した内容で報じている)

彼らは平凡な結果を報告する(物語を調整する柔軟性はある)。生徒のモデルを抽出するために、教師モデルとして内部に保持する。そして後者をリリースする。私たちはソネット3.6とGPT-4o、o1などを手に入れ、その安っぽい品質に歓喜する。オーパス3.5とGPT-5への期待は、私たちがより焦がれるようになっても、そのままである。彼らの金脈は輝き続けている。

V. アルトマンさん、あなたにはもっと理由があるはずです!

V. もちろん、アルトマンさんにはもっと理由があるでしょう!

ここまで調査を進めたとき、私はまだ完全には納得していなかった。すべての証拠がOpenAIの可能性を示唆しているのは事実だが、「もっともらしい」、あるいは「もっともらしい」と「現実」の間にはまだギャップがある。私はあなたのためにそのギャップを埋めるつもりはありません。しかし、私は議論をさらに強化することができる。

OpenAIがこのような運営をしているという証拠はまだあるのでしょうか?GPT-5のリリースを遅らせる理由は、パフォーマンスの低下と損失の増大以外にもっとあるのでしょうか?また、GPT-5に関するOpenAI幹部の公式声明から、どのような情報を引き出すことができるでしょうか?また、GPT-5に関するOpenAI幹部の公式声明から、どのような情報を引き出すことができるでしょうか?モデルのリリースを何度も延期することで、風評被害を受けるリスクはないのでしょうか?結局のところ、OpenAIはAI革命の顔であり、Anthropicはその影で活動している。Anthropicはこのような方法で活動する余裕があるが、OpenAIはどうだろうか?おそらく、代償がないわけではないだろう。

お金といえば、OpenAIとマイクロソフトのパートナーシップについて、関連する詳細を掘り下げてみよう。まず、よく知られている事実として、AGIの規約がある。OpenAIの構造に関するブログ記事には、運営方法、非営利団体との関係、取締役会との関係、マイクロソフトとの関係を定義する5つのガバナンス条項がある。第5の条項では、AGIを「経済的に価値のある努力のほとんどにおいて人間を凌駕することができる高度に自律的なシステム」と定義し、OpenAI理事会がAGIを実装したと宣言した時点で、「このシステムはマイクロソフトとの知的財産ライセンスおよびその他の商業上の条件から除外される。AGI以前の技術にのみ適用される、マイクロソフト社とのその他の商業条件"

言うまでもなく、両社ともパートナーシップの崩壊を望んでいるわけではない。その方法のひとつが、AGIのレッテルを貼られそうなシステムのリリースを遅らせることだ。「でもGPT-5は確かにAGIではない」とあなたは言うだろう。オープンAIとマイクロソフトは、AGIの定義を秘密裏に定めており、それは科学的な目的には関係ないが、法的には彼らのパートナーシップを定義している。AGIとは「少なくとも1000億ドルの利益を生み出すことができるAIシステム」である。

もしOpenAIが仮にGPT-5の準備が整っていないという口実でリリースを遅らせたとしたら、彼らはコストをコントロールし、世論の反発を防ぐということ以外にも達成できることがある。1,000億ドルというのは驚異的な数字だが、野心的な顧客がその上それだけの利益を上げることを止めることはできない。一方、はっきりさせておきたいのは、GPT-5が年間1000億ドルの経常収益をもたらすとOpenAIが予測すれば、AGI条項を発動してマイクロソフトと決別しても構わないということだ。

OpenAIがGPT-5をリリースしなかったことに対する世間の反応のほとんどは、それが十分でないからリリースしなかったという仮定に基づいている。仮にそれが事実であったとしても、OpenAIが外部で使用するよりも内部で使用する方が優れているかもしれないと考える懐疑的な人はいない。優れたモデルを作ることと、3億人に安く提供できる優れたモデルを作ることには大きな違いがある。それができなければ、やらないだろう。しかし、もしあなたが 不要 やるなら、やらない。以前は私たちのデータが必要だったから、彼らは最高のモデルを提供してくれた。しかし、もはやその必要はない。そして、彼らはもはや私たちのお金を追いかけてはいない。それはマイクロソフトのビジネスであって、彼らのビジネスではない。彼らはAGI、そしてASIを望んでいる。

六、これがすべてを変える理由

我々は終わりに近づいている。AnthropicがOpus 3.5を持っているように、OpenAIはすでにGPT-5を社内に持っている可能性が非常に高い。OpenAIがGPT-5をリリースしない可能性さえあります。世間は今、GPT-4oやClaude Sonnet 3.6だけでなく、o1/o3でパフォーマンスを測定しています。OpenAIがテストでスケーリングの法則を探求しているため、GPT-5のために越えなければならないハードルは上がり続けています。GPT-5がo1、o3、そしてこれからのoシリーズを本当に凌駕するようなものをリリースできるでしょうか。それに、彼らはもう私たちのお金もデータも必要としていない。

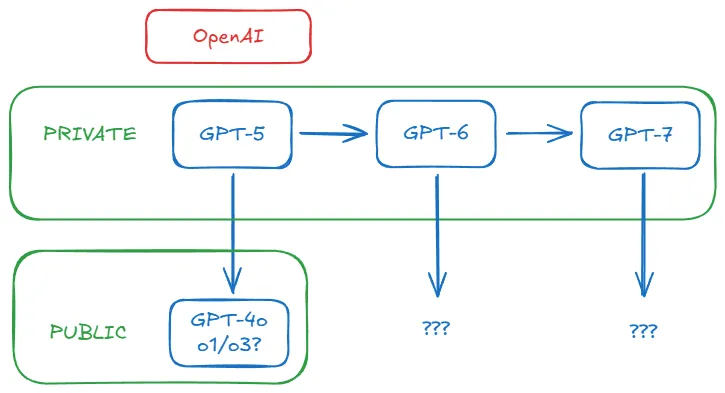

GPT-5、GPT-6、そしてそれ以降の新しいベースモデルのトレーニングは、OpenAIの内部では常に意味があったが、製品としては必ずしもそうではなかった。それはおそらく終わった。今、彼らにとって重要な唯一の目標は、次世代のモデルのためにより良いデータを生成し続けることだ。今後、ベースモデルはバックグラウンドで動作し、他のモデルに力を与え、自分たちだけでは達成できなかった偉業を達成させるかもしれない。秘密の洞窟から知恵を伝える隠遁老人のように。彼を見かけようが見かけまいが、我々は彼の知恵の結果を経験することになる。

GPT-5が最終的にリリースされたとしても、この事実は突然、ほとんど関係ないように思える。OpenAIとAnthropicが軌道に乗れば 再帰的自己改善 そうなれば、彼らが私たちに何を公表しようが、もはや問題ではなくなる。宇宙が急速に膨張し、遠くの銀河からの光がもはや私たちに届かないのと同じように。

それが、OpenAIがわずか3カ月でo1からo3にジャンプした理由かもしれない。それがo4、o5とジャンプしている理由でもある。彼らが最近ソーシャルメディア上で興奮しているのもそのためだろう。なぜなら、彼らは新しく改良された操作モードを実装しているからだ。

AGIに近づけば、ますます強力なAIを使えるようになると本当に思っているのか?私たちが使えるように、AIがあらゆる進歩を解放してくれるとでも?もちろん、そんなことは信じないだろう。彼らは、自分たちのモデルが他の誰も追いつけないほど自分たちを押し上げるだろうと最初に言ったとき、本気だったのだ。それぞれの新世代のモデルは、脱出速度のエンジンなのだ。成層圏から、彼らは別れを告げたのだ。

彼らが戻ってくるかどうかはまだわからない。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません