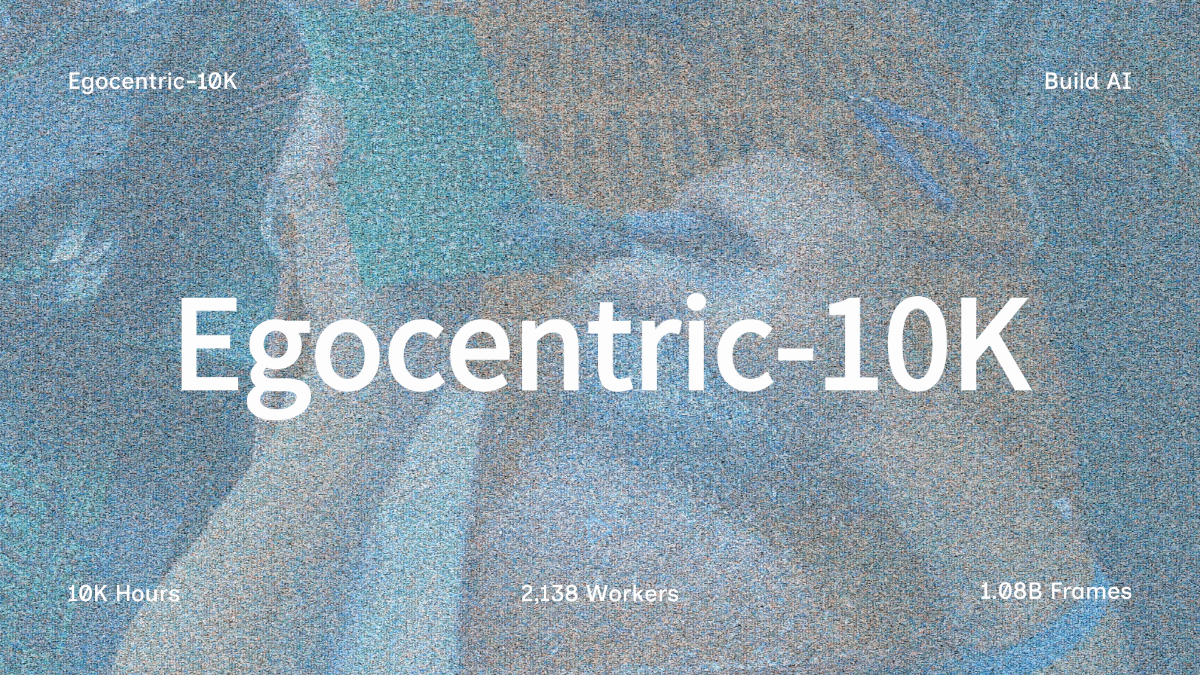

Egocentric-10K - ビルドAIのオープンソース一人称視点ロボットデータセット

Egocentric-10Kとは

Egocentric-10Kは、build.aiチームによってオープンソース化された、工場作業の大規模なエゴセントリックビデオデータセットである。このデータセットには10,000時間、合計10.8億フレームの動画が含まれ、2,138人の作業員が参加し、それぞれが平均約4.68時間の動画コンテンツを提供している。データセットは192,900のビデオクリップで構成され、それぞれの長さの中央値は180秒、ストレージサイズは16.4 TB、H.265/MP4フォーマット、解像度1080p、フレームレート30fpsで、作業シーンの密度が高く、手の見える頻度が高いことが特徴で、これまでの現場データセットと比較して大幅に改善されている。

エゴセントリック-10Kの機能的特徴

- 大規模データ世界で最も人気のあるビデオソースの一人称視点:10,000時間のビデオ、合計10億8,000万フレームは、研究者に大量の一人称視点データを提供する。

- 実際の工場環境このデータは、産業関連の研究にとって非常に実用的で現実的な、実際の工場のシナリオから完全に収集されたものである。

- 高密度運転このようなデータセットは、行動認識やタスク学習に適している。

- 多様な労働者の参画2,138人の労働者が参加し、それぞれが平均4.68時間のビデオを提供した。

- 効率的なストレージとフォーマット解像度1080p、フレームレート30fpsのH.265/MP4フォーマットは、ストレージ容量を最適化しながらビデオ品質を保証する。

- アクセスしやすく使いやすい大規模な機械学習やデータ分析に適した、高速な読み込みと処理が可能なWebDataset形式で整理されています。

- 多分野への応用ロボット学習、産業用ビジョン、動作認識など幅広い分野に応用でき、関連技術の開発・研究を強力にサポートします。

Egocentric-10Kの主な利点

- 実際のシナリオ・データ実際の工場環境で収集されたデータであるため、高度な現実性と実用性が保証され、産業シナリオ研究に適している。

- 膨大なデータ量10,000時間、合計10億8,000万フレームのビデオが含まれている。

- 高密度運転動作認識やタスク学習に適しているのは、動作シーンが密で、手の視認性が高い映像である。

- 多様なデータソース対象労働者は2,138人で、そのデータは幅広い業務スタイルと習慣をカバーしており、広く代表的なものとなっている。

- 効率的なデータフォーマットH.265/MP4フォーマットにより、高画質を維持しながら保存と転送の効率を最適化。

- 使いやすいWebDataset形式で整理されているため、読み込みと処理が速く、大規模な機械学習に適しています。

Egocentric-10Kの公式ウェブサイトは?

- HuggingFaceモデルライブラリ:: https://huggingface.co/datasets/builddotai/Egocentric-10K

Egocentric-10Kが向いている人

- ロボット工学研究者ロボットは、産業環境で動作するように訓練し、最適化するために使用することができます。

- コンピュータ・ビジョンの専門家産業用ビジョンシステムの開発とテストに豊富な一人称視点データを提供し、複雑な環境におけるシステムの認識と分析を強化します。

- 人工知能開発者機械学習やディープラーニングモデルの大規模な学習データを提供し、アルゴリズムの開発と最適化をサポートする。

- インダストリアル・オートメーション・エンジニア工業生産の効率と品質を向上させる、より効率的なオートメーション・ソリューションの研究開発を支援する。

- 学術研究者関連分野の学術研究に質の高いデータを提供し、理論研究と応用研究の発展を促進する。

- インダストリアル・データ・アナリスト作業員の行動を分析し、ワークフローを最適化し、生産性と安全性を向上させることができます。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません