DualPipe:大規模AIモデルの学習効率を向上させる双方向パイプライン並列アルゴリズム(DeepSeek Open Source Week Day 4)

はじめに

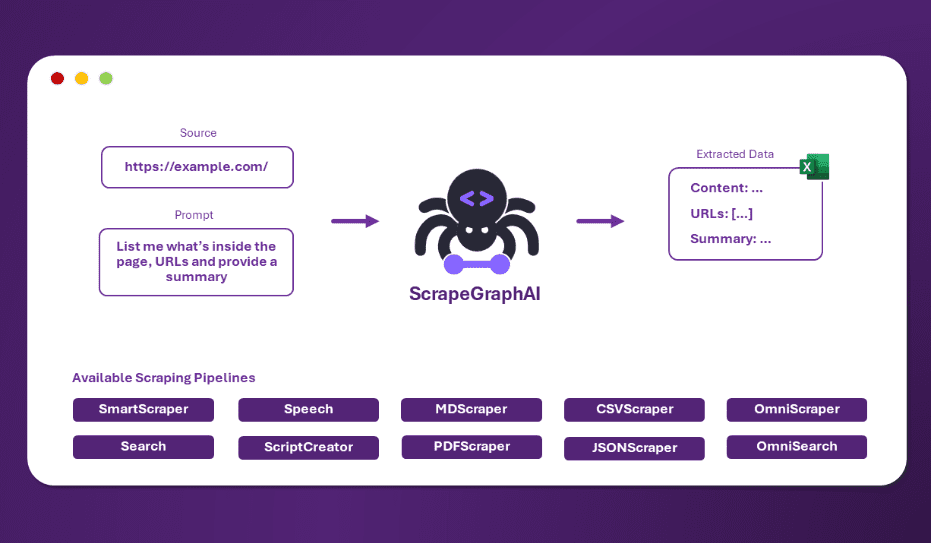

DualPipeは、DeepSeek-AIチームによって開発されたオープンソース技術で、大規模なAIモデルトレーニングの効率向上に焦点を当てています。これは革新的な双方向パイプライン並列アルゴリズムで、主にDeepSeek-V3とR1モデルのトレーニングにおいて計算と通信の完全なオーバーラップを実現するために使用され、パイプライン内の「バブル」(待ち時間)を効果的に削減し、トレーニングプロセスを高速化します。Jiashi Li氏、Chengqi Deng氏、Wenfeng Liang氏によって開発されたこのプロジェクトは、GitHubでオープンソース化され、AIコミュニティから注目を集めています。 DualPipeの中核的な利点は、最適化されたスケジューリングにより、マルチノードGPUクラスタ上でモデル学習を効率的に実行できることです。これにより、1兆パラメータ規模のモデル学習シナリオに適しており、AI研究者や開発者に新たな可能性を提供します。DualPipeは、AI研究者や開発者に新しい並列パラダイムを提供します。

機能一覧

- 双方向パイプライン・スケジューリングパイプラインの両端からのマイクロバッチの同時入力に対応し、計算と通信の高度なオーバーラップを可能にする。

- 組立ラインの気泡の減少アルゴリズムの最適化により、トレーニング中のアイドル待機時間を短縮。

- 大規模モデルのトレーニングをサポートこのシステムは、DeepSeek-V3のような非常に大規模なモデルにも適応可能で、何兆ものパラメータ学習ニーズに対応できる。

- 計算と通信のオーバーラップGPUの利用率を向上させるためのフォワードプロパゲーションとバックプロパゲーションにおける計算と通信タスクの並列処理。

- オープンソース・サポートPythonの完全な実装が提供されており、開発者は自由にダウンロード、変更、統合できる。

ヘルプの使用

DualPipeは開発者向けの高度なツールで、GitHubのオープンソースプロジェクトとして、スタンドアロンのグラフィカル・インターフェースはありませんが、コードベースとして利用可能です。以下は、開発者がすぐに使い始め、AIトレーニングプロジェクトに統合するのに役立つ詳細な使用ガイドです。

設置プロセス

DualPipeのインストールには、基本的なPythonとディープラーニングの環境が必要だ。以下はその手順である:

- 環境準備

- Python 3.8以降がシステムにインストールされていることを確認してください。

- GitHubからコードをダウンロードするためにGitをインストールする。

- 依存関係の衝突を避けるため、以下のコマンドで仮想環境を使用することを推奨する:

python -m venv dualpipe_env source dualpipe_env/bin/activate # Linux/Mac dualpipe_env\Scripts\activate # Windows

- クローン・コード・リポジトリ

ターミナルで以下のコマンドを入力し、DualPipeリポジトリをローカルにダウンロードします:git clone https://github.com/deepseek-ai/DualPipe.git cd DualPipe

- 依存関係のインストール

DualPipeは一般的なディープラーニングライブラリに依存しており、具体的な依存関係はリポジトリに明示されていませんが、その機能からPyTorchのような環境が必要だと推測されます。以下のコマンドで基本的な依存関係をインストールしてみてください:pip install torch torchvision特定のライブラリが見つからないというエラーが発生した場合は、プロンプトに従ってインストールを進めてください。

- インストールの確認

DualPipe はアルゴリズム・コードであり、スタンドアロン・アプリケーションではないため、検証を直接実行することはできません。しかし、コードファイル(例えばdualpipe.py) をクリックしてダウンロードが完了したことを確認する。

使用方法

DualPipeの中核にあるのは、開発者が既存のモデル学習フレームワーク(PyTorchやDeepSpeedなど)に統合する必要のあるスケジューリング・アルゴリズムだ。その仕組みはこうだ:

1.コード構造の理解

- 見せる

DualPipeフォルダに、メインコードはdualpipe.pyまたは同様の文書に記載する。 - アルゴリズム・ロジックを理解するには、コード・コメントと DeepSeek-V3 テクニカル・レポート(GitHub リポジトリの説明のリンク)をお読みください。レポートでは、DualPipeスケジューリングの例(8パイプライン・レベルと20マイクロバッチなど)について言及しています。

2.トレーニングの枠組みへの統合

- モデルとデータの準備すでにPyTorchベースのモデルとデータセットを持っていると仮定します。

- トレーニングサイクルの変更DualPipe のスケジューリング・ロジックをトレーニング・コードに組み込みます。簡単な例を示します:

# 伪代码示例 from dualpipe import DualPipeScheduler # 假设模块名 import torch # 初始化模型和数据 model = MyModel().cuda() optimizer = torch.optim.Adam(model.parameters()) data_loader = MyDataLoader() # 初始化 DualPipe 调度器 scheduler = DualPipeScheduler(num_ranks=8, num_micro_batches=20) # 训练循环 for epoch in range(num_epochs): scheduler.schedule(model, data_loader, optimizer) # 调用 DualPipe 调度 - 実装は実際のコードに合わせる必要があるので、(もしあれば)GitHubリポジトリのサンプルを参照することを推奨する。

3.ハードウェア環境の設定

- DualPipeはマルチノードGPUクラスター用に設計されており、少なくとも8個のGPU(NVIDIA H800など)での使用を推奨します。

- 通信の最適化を最大限に活用するために、クラスタがInfiniBandまたはNVLinkをサポートしていることを確認してください。

4.運転と試運転

- ターミナルでトレーニングスクリプトを実行する:

python train_with_dualpipe.py - ログ出力を観察し、計算と通信がうまく重なっているかどうかをチェックする。パフォーマンスのボトルネックがある場合は、マイクロバッチの数やパイプラインのレベルを調整する。

注目の機能操作

双方向パイプライン・スケジューリング

- 設定ファイルまたはコードでの設定

num_ranks(パイプラインのレベル数)とnum_micro_batches(マイクロバッチ数)。 - 構成例:8レベル、20マイクロバッチ、技術報告書のスケジューリング図を参照。

計算通信オーバーラップ

- 手作業を必要とせず、DualPipeは自動的にポジティブな計算を行います。

F)を逆算したものである。B)の通信タスクが重なる。 - ログのタイムスタンプを確認し、通信時間が計算に隠されていることを確認する。

組立ラインの気泡の減少

- 最適な構成は、マイクロバッチサイズを調整し(例えば20から16へ)、トレーニング時間の変化を観察することで見出された。

ほら

- ハードウェア要件デュアルパイプの利点はシングルカードでは十分に発揮できないため、マルチGPU環境を推奨します。

- ドキュメンテーション・サポートGitHubのページは情報量が少ないので、DeepSeek-V3のテクニカル・レポート(arXiv: 2412.19437)と合わせて深く研究することをお勧めします。

- 地域支援GitHubのIssuesページで質問したり、Xプラットフォームでの関連ディスカッション(@deepseek_aiの投稿など)を参考にしてください。

これらのステップに従うことで、開発者はDualPipeをプロジェクトに統合し、大規模モデルのトレーニング効率を大幅に改善することができます。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません