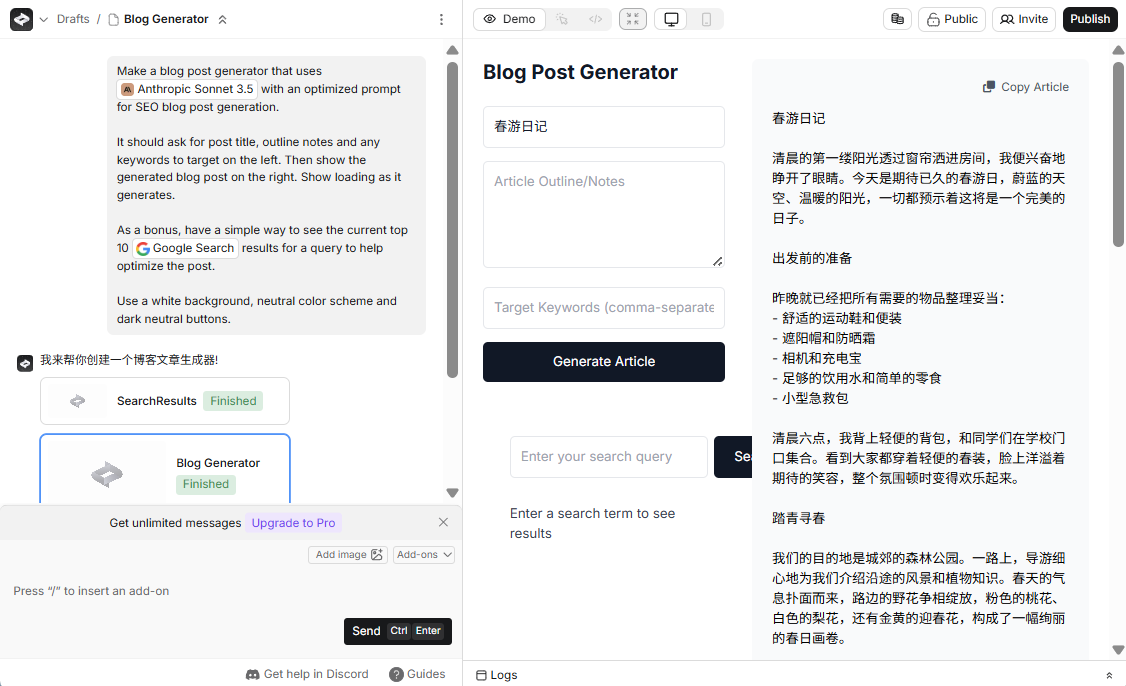

dots.vlm1 - Small Red Book Hi Lab オープンソース マルチモーダルラージモデル

dots.vlm1とは?

dots.vlm1は、Little Red Book hi lab.がオープンソース化した最初のマルチモーダル・マクロモデルです。ゼロから学習させた12億パラメータの視覚コーダーNaViTと ディープシーク dots.vlm1の視覚コーダーであるNaVlm1は、視覚認識とテキスト推論を得意とするLarge Language Model (LLM)です。dots.vlm1の視覚コーダーであるNaViTは、完全にスクラッチから学習され、ネイティブに動的解像度をサポートし、知覚能力を強化するためにテキスト監視に純粋な視覚監視を追加している。学習データには、多様な画像タイプとその説明をカバーする様々な合成データを導入し、データの質を向上させている。

dots.vlm1の主な機能

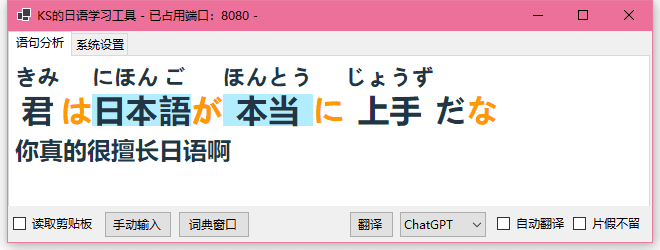

- 強い視覚的理解力複雑なチャート、表、文書、グラフなど、画像内のコンテンツを正確に認識・理解し、さまざまなビジュアルタスクの動的解像度をサポートします。

- 効率的なテキスト生成と推論DeepSeek V3 LLMに基づき、高品質のテキスト記述を生成し、数学やコードなどのテキスト推論タスクで高いパフォーマンスを発揮します。

- マルチモーダルデータ処理グラフィックとテキストのインターレースによるデータ処理をサポートし、視覚情報とテキスト情報を組み合わせて統合的な推論を行うことができるため、マルチモーダルなアプリケーションシナリオに適しています。

- 柔軟な適応と拡張MLPアダプタは視覚エンコーダと言語モデルを接続し、異なるタスクに柔軟に適応・拡張できるようにします。

- オープンソースと開放性開発者の研究やアプリケーション開発を支援し、マルチモーダル技術の発展を促進するために、完全なオープンソースコードとモデルを提供する。

dots.vlm1のプロジェクト・アドレス

- GitHubリポジトリ:: https://github.com/rednote-hilab/dots.vlm1

- ハグ顔モデルライブラリー:: https://huggingface.co/rednote-hilab/dots.vlm1.inst

- オンライン体験デモ:: https://huggingface.co/spaces/rednote-hilab/dots-vlm1-demo

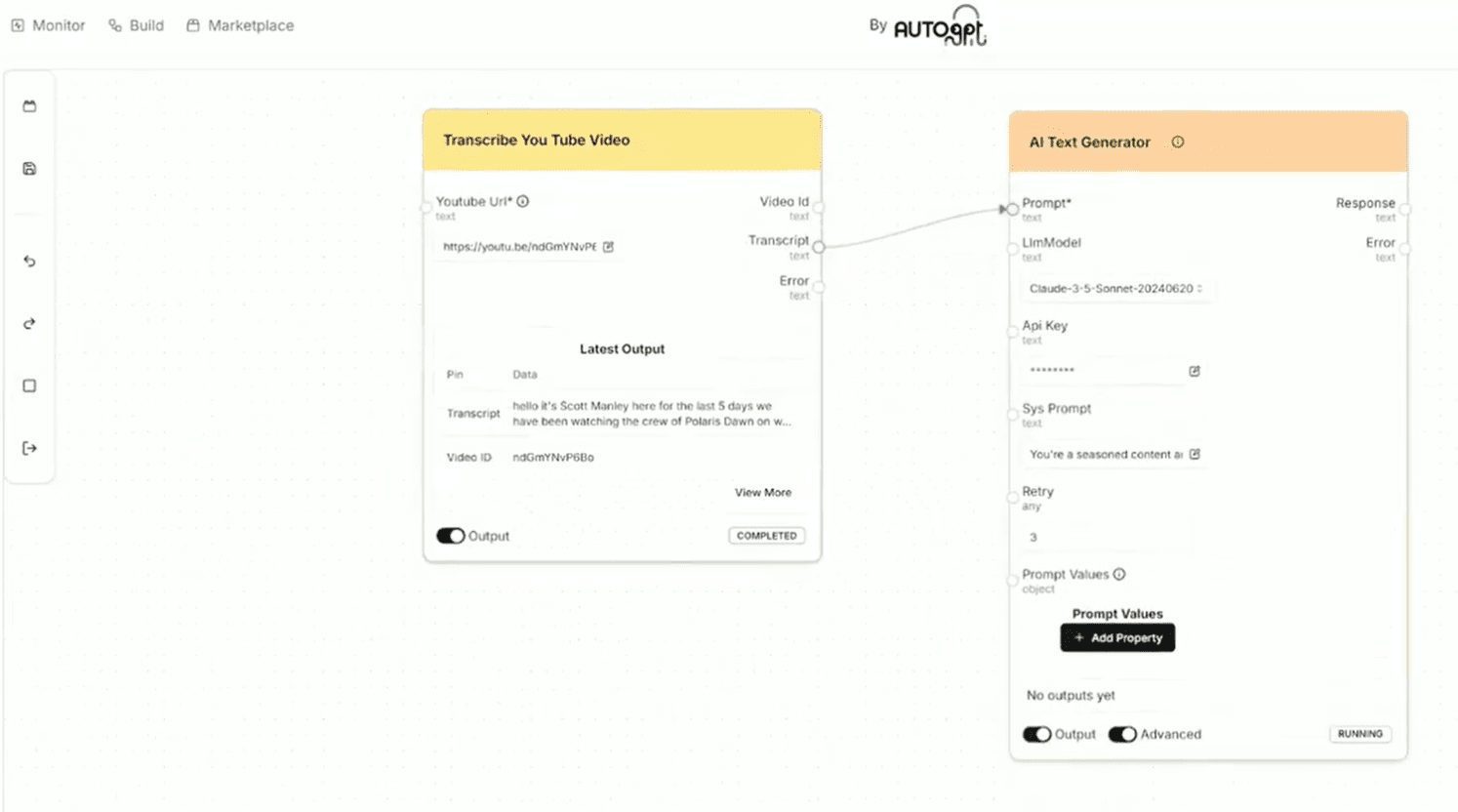

dots.vlm1の技術原理

- NaViTビジュアル・エンコーダ: dots.vlm1は、既存の成熟したモデルをベースに微調整されたものではなく、ゼロから学習された12億パラメータの視覚コーダーであるNaViTを使用。動的解像度をネイティブにサポートし、異なる解像度の画像入力を扱うことが可能。また、画像に対するモデルの認識を向上させるため、テキスト監視に加え、純粋に視覚的な監視を追加。

- マルチモーダルデータトレーニングこのモデルは、通常の画像、複雑な図表、文書、グラフなどの多様なマルチモーダル学習データと、それに対応するテキスト記述(Altテキスト、密なキャプション、接地など)を採用しています。WebページやPDFのような合成データのアイデアやグラフィックとテキストがインターリーブされたデータを導入することで、書き換えやクリーニングを通じてデータの品質を向上させ、モデルのマルチモーダル理解能力を高めます。

- 視覚と言語のモデリング融合dots.vlm1は、視覚エンコーダとDeepSeek V3 Large Language Model(LLM)を組み合わせ、軽量MLPアダプタを介して接続することで、視覚情報と言語情報の効果的な融合を可能にし、マルチモーダルなタスクの処理をサポートします。

- 3段階のトレーニング・プロセスモデルの学習は、視覚コーダーの事前学習、VLMの事前学習、VLMの事後学習の3段階に分けられる。画像の解像度を徐々に上げ、多様な学習データを導入することで、モデルの汎化能力とマルチモーダル課題処理能力を向上させる。

dots.vlm1の主な利点

- ゼロから訓練されたビジュアル・コーダーNaViTの視覚コーダーは、ネイティブの動的解像度をサポートし、視覚的知覚の上限を引き上げるために純粋な視覚的監督を行う。

- マルチモーダルなデータ革新マルチモーダル・マクロモデルを使用してウェブページデータを書き換えるだけでなく、多様な画像タイプとその説明をカバーするさまざまな合成データのアイデアを導入することで、学習データの質が大幅に向上する。

- SOTAに近いパフォーマンス視覚知覚と推論において、クローズドソースのSOTAモデルに迫る性能を達成し、オープンソースの視覚言語モデルの新たな性能上限を設定。

- 強力なテキスト機能テキスト推論が得意で、数学とコーディングのスキルもある。

- 柔軟な建築設計MLPアダプタは視覚エンコーダと言語モデルを接続し、異なるタスクに柔軟に適応・拡張できるようにします。

dots.vlm1の対象者

- 人工知能研究者マルチモーダル・マクロモデリングに興味があり、視覚や言語処理の分野での応用や改良を探求したい。

- 開発者とエンジニア画像認識、テキスト生成、視覚的推論などのマルチモーダル機能をプロジェクトに統合する必要性。

- 教育者このモデルは、複雑な図や文書、その他のコンテンツを生徒がよりよく理解し、分析できるよう、授業を支援するために使用することができます。

- コンテンツクリエーター高品質なグラフィックコンテンツを作成したり、コンテンツを推薦したり、パーソナライズされた作品を作る必要がある。

- ビジネスユーザーインテリジェントな顧客サービス、コンテンツ推薦、データ分析など、マルチモーダルデータを処理する必要があるビジネスシナリオでは、モデルを使用して効率と効果を向上させることができます。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません