ドルフィン:アジア言語認識とアジア言語のための音声テキストモデル

はじめに

Dolphinは、DataoceanAIが清華大学と共同で開発したオープンソースモデルで、アジア言語の音声認識と言語認識に特化している。東アジア、南アジア、東南アジア、中東の40言語と22の中国語方言をサポートしている。Dolphinは、音声をテキストに変換するだけでなく、品詞の検出(VAD)、音声の分割、言語の認識(LID)を行うことができます。シンプルに設計されており、コードとモデルの一部は開発者のためにGitHubで自由に利用できます。

機能一覧

- 40のアジア言語と22の中国語方言の音声テキストをサポート。

- 音声内の音声セグメントを検出する音声アクティビティ検出(VAD)を提供します。

- 音声の分割をサポートし、長い音声を小さなセグメントに分割して処理できます。

- 言語識別(LID)を導入して、音声の言語や方言を判別する。

- オープンソースのコードと、ユーザーによる修正やカスタマイズが可能なモデル。

- ベースとスモールの2つのモデルがあり、ニーズに合わせて選べる。

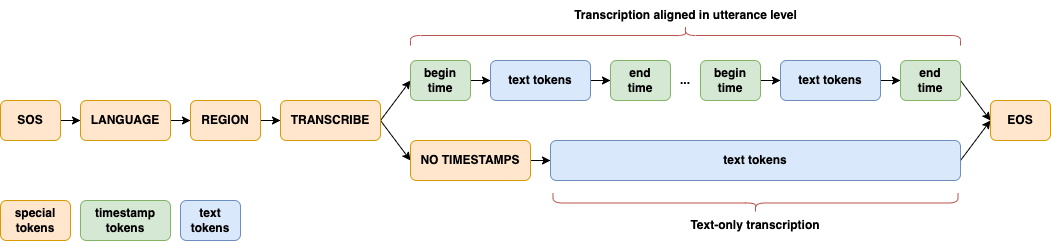

- 言語と地域を区別する2階層ラベリングシステムを使用する(例)。

<zh><CN>).

ヘルプの使用

Dolphinのインストールと使い方は簡単で、基本的なプログラミングスキルをお持ちの方であれば問題ありません。以下に詳しい手順を示します。

設置プロセス

- 環境を整える

Python 3.8以上、オーディオ処理にFFmpegが必要。- Pythonのチェック:ターミナルで、次のようにタイプする。

python --versionバージョンを確認する。 - Pythonはインストールされず、python.orgからダウンロードできる。

- FFmpegのインストール:お使いのシステムに合わせてコマンドを実行してください:

- Ubuntu/Debian:

sudo apt update && sudo apt install ffmpeg - macOS:

brew install ffmpeg - ウィンドウズ

choco install ffmpeg

アンインストールされたパッケージ管理ツールは、FFmpegのウェブサイトからダウンロードできます。

- Ubuntu/Debian:

- Pythonのチェック:ターミナルで、次のようにタイプする。

- ドルフィンのインストール

方法は2つある:- pipでインストール

それをターミナルに入力する:pip install -U dataoceanai-dolphinこれで最新の安定版がインストールされる。

- ソースコードからのインストール

最新の開発版を使用するには、GitHubから入手してください:- クローン倉庫

git clone https://github.com/DataoceanAI/Dolphin.git - カタログを見る

cd Dolphin - インストール:

pip install .

- クローン倉庫

- pipでインストール

- ダウンロードモデル

Dolphinには4つのモデルがあり、現在base(140M parameters)とsmall(372M parameters)が無料でダウンロードできます。- をとおして ハグする顔 モデルファイルを取得する。

- 指定したパスに保存する。

/data/models/dolphin/. - ベースモデルはより速く、スモールモデルはより正確だ。

使用方法

コマンドラインとPythonの操作がサポートされている。

コマンドライン操作

- 音声テキスト化

オーディオファイルを用意する(例audio.wav)と入力する:

dolphin audio.wav

システムは自動的にデフォルトモデルをダウンロードし、テキストを出力します。音声はWAV形式で、FFmpegで変換できます:

ffmpeg -i input.mp3 output.wav

- モデルとパスの指定

小型モデルを使う:

dolphin audio.wav --model small --model_dir /data/models/dolphin/

- 言語と地域の指定

二重層マーカーで中国語を認識する:

dolphin audio.wav --model small --model_dir /data/models/dolphin/ --lang_sym "zh" --region_sym "CN"

lang_symは言語コードで、例えば "zh"(中国語)。region_symは市外局番で、例えば "CN"(中国本土)。

言語の完全なリストについては 言語.md.

- フィル・ショート・オーディオ

音声が30秒未満の場合に利用可能--padding_speech true充填:

dolphin audio.wav --model small --model_dir /data/models/dolphin/ --lang_sym "zh" --region_sym "CN" --padding_speech true

Pythonコード操作

- オーディオとモデルの読み込み

Pythonで動作:

import dolphin

waveform = dolphin.load_audio("audio.wav") # 加载音频

model = dolphin.load_model("small", "/data/models/dolphin/", "cuda") # 加载模型

"cuda"GPUあり、GPUなし"cpu".

- 役員表彰

オーディオを処理して出力する:result = model(waveform) # 转文本 print(result.text) # 显示结果 - 言語と地域の指定

パラメータを追加する:result = model(waveform, lang_sym="zh", region_sym="CN") print(result.text)

注目の機能操作

- 音声アクティビティ検出(VAD)

スピーチセグメントを自動的に検出し、時間などでラベル付けします:0.0-2.5s: 你好 3.0-4.5s: 今天天气很好 - 言語識別(LID)

例えば、音声言語を決定する:dolphin audio.wav --model small --model_dir /data/models/dolphin/として出力する。

<zh>(中国語)または<ja>(日本語)。 - バイリンガル・マークアップ

言語と地域を2レベルのラベルで区別する。<zh><CN>(北京語)、<zh><TW>(台湾標準語)を使って、アジアの言語処理能力を高める。 - モデル・アーキテクチャ

エンコーダーにE-Branchformer、デコーダーにTransformerを採用したCTC-Attentionアーキテクチャは、アジア言語に最適化されている。

アプリケーションシナリオ

- 会議録

アジア多言語会議の録音をテキストに変換し、国際会議やローカル会議に最適。 - 方言研究

中国語22方言の音韻特徴を分析し、研究データを作成する。 - スマートデバイス開発

アジア言語での音声コントロールのためのスマートデバイスへの統合。

品質保証

- 対応言語は?

40のアジア言語と22の中国語方言をサポート。 言語.md. - GPUが必要ですか?

CPUでも動作しますが、GPU(CUDAサポート)の方が高速です。 - ベースモデルとスモールモデルの違いは何ですか?

ベースモデルはスモールモデル(140Mパラメータ)でエラー率は33.3%、スモールモデルはラージモデル(372Mパラメータ)でエラー率は25.2%である。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません