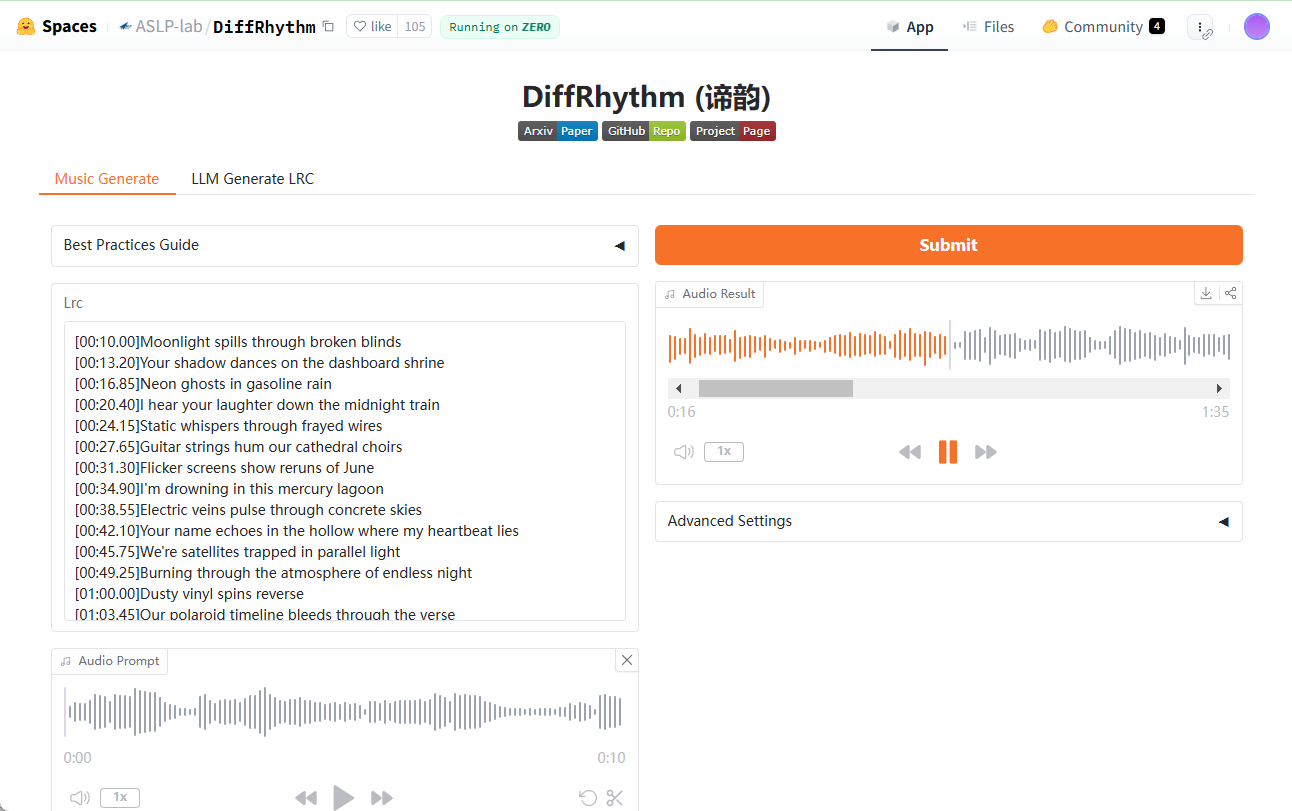

DiffRhythm:最大4分45秒の曲を10秒で生成。

はじめに

DiffRhythmはASLP-lab (Audio, Speech and Language Processing Group, Northwestern Polytechnical University)によって開発されたオープンソースプロジェクトで、人工知能技術によるエンドツーエンドの音楽制作に焦点を当てています。潜在拡散モデルに基づいており、ボーカルとバッキングボーカルを含む、最大4分45秒の完全な楽曲をわずか10秒で生成することができる。DiffRhythmのゴールは、複雑で生成時間が長く、断片的なものしか生成できないという従来の音楽生成モデルを解決することであり、音楽クリエイター、教育者、エンターテインメント業界のユーザーに適しています。

ComfyUIワークフローのカプセル化: Chttps://github.com/billwuhao/ComfyUI_DiffRhythm

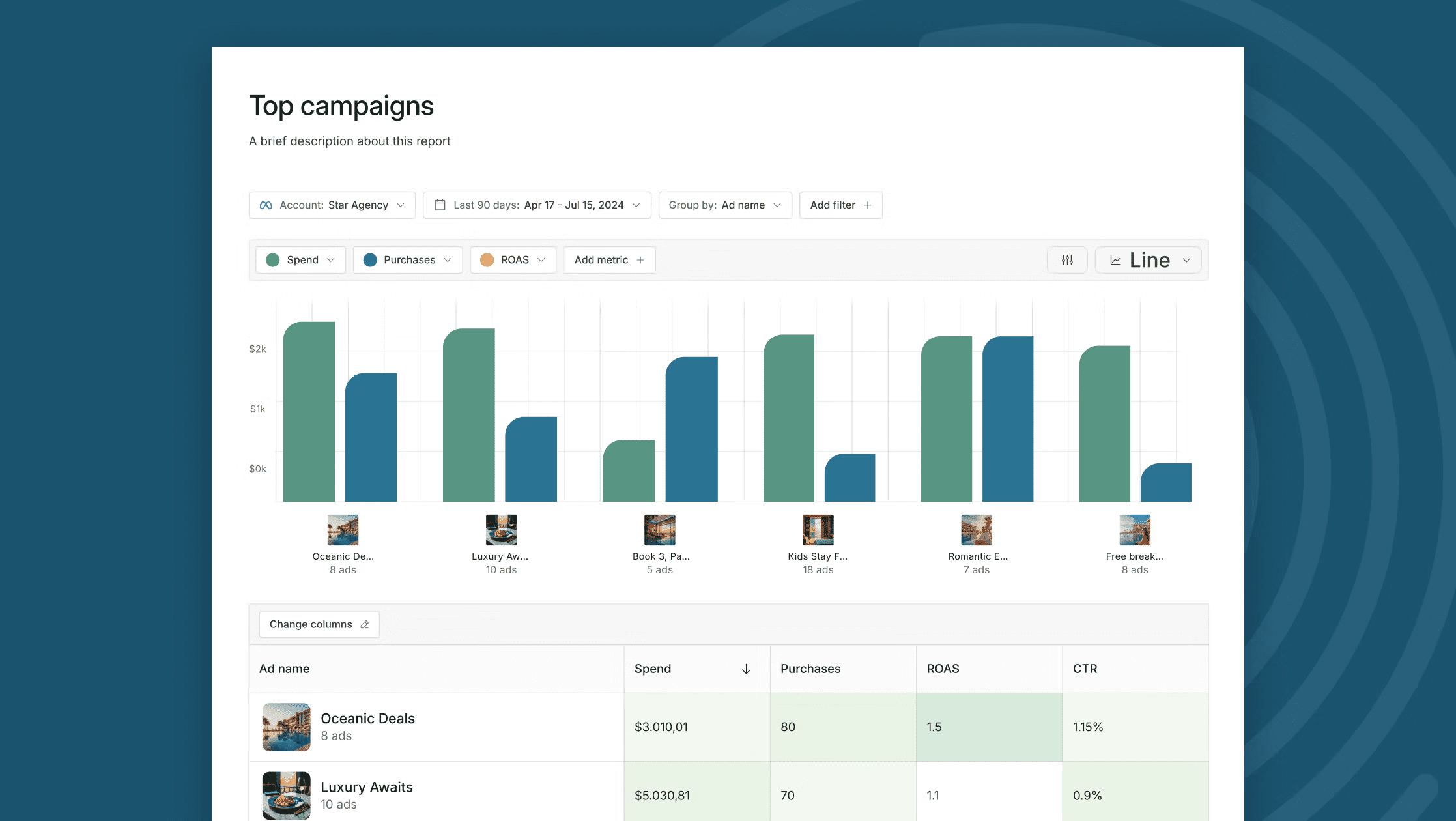

経験:https://huggingface.co/spaces/ASLP-lab/DiffRhythm

機能一覧

- エンド・ツー・エンドの楽曲生成歌詞とスタイル・キューを入力すると、ボーカルとバッキング・トラックを含む完全な楽曲が自動的に生成されます。

- 高速推論最大4分45秒の楽曲を10秒で生成。

- メロディーとシンクロした歌詞生成されたメロディーが、歌詞の音節やリズムに自然にマッチするようにする。

- スタイルのカスタマイズ複数の音楽スタイルキューをサポートし、ユーザーのニーズに合った音楽を生成します。

- オープンソース・サポート:: ユーザーが機能をカスタマイズしたり拡張したりできるように、ソースコードとモデルを提供する。

- 高品質出力音質や聴きやすさの面でも高い水準にある。

ヘルプの使用

設置プロセス

DiffRhythm は GitHub ベースのオープンソースプロジェクトであり、インストールと実行にはプログラミングの知識が必要です。以下は詳細なインストール手順です:

- 環境準備

- Python 3.8以上がコンピュータにインストールされていることを確認してください。

- GitHubからコードをダウンロードするためにGitをインストールする。

- 仮想環境を使用することをお勧めします。

venvもしかしたらconda)依存関係の衝突を避けるためである。

- プロジェクトコードのダウンロード

- ターミナルを開き、以下のコマンドを入力して DiffRhythm リポジトリをクローンします:

git clone https://github.com/ASLP-lab/DiffRhythm.git - プロジェクト・カタログにアクセスする:

cd DiffRhythm

- ターミナルを開き、以下のコマンドを入力して DiffRhythm リポジトリをクローンします:

- 依存関係のインストール

- プロジェクトは通常、以下を提供する。

requirements.txtファイルで、必要なPythonライブラリをリストしています。 - ターミナルで以下のコマンドを実行し、依存関係をインストールする:

pip install -r requirements.txt - このファイルを持っていない場合は、GitHubページの依存関係ノートやドキュメントを参照して、PyTorchなどのコアライブラリを手動でインストールすることができます。

- プロジェクトは通常、以下を提供する。

- 訓練済みモデルのダウンロード

- DiffRhythmのトレーニング済みモデルは、通常Hugging Faceやその他のクラウドストレージプラットフォームにホストされています。

- インタビュー ASLP-lab/DiffRhythm-base モデルファイルをダウンロードする(例

cfm_model.pt). - ダウンロードしたモデルファイルを、プロジェクトディレクトリの指定されたフォルダ(通常、ドキュメントに記載されています。

models/).

- インストールの確認

- ターミナルで簡単なテストコマンドを実行する(正確なコマンドはGitHubのREADMEファイルを参照):

python main.py --test - エラーが報告されなければ、インストールは成功です。

- ターミナルで簡単なテストコマンドを実行する(正確なコマンドはGitHubのREADMEファイルを参照):

DiffRhythmの使い方

DiffRhythmのコア機能は歌詞とスタイルキューを入力して曲を生成することです。以下に詳しい操作手順を示します:

1.インプットの準備

- 歌詞歌詞を書き、テキストファイルとして保存する。

lyrics.txt)、またはコマンドラインに直接入力する。 - スタイルのヒント例:"ポップ・ロック"、"クラシック・ピアノ"、"エレクトロニック・ダンス・ミュージック "など。

2.ソング・ジェネレーション

- ターミナルを開き、DiffRhythm プロジェクトディレクトリに入ります。

- generateコマンドを実行する(具体的なパラメーターは公式ドキュメントに基づく:)

python generate.py --lyrics "lyrics.txt" --style "pop rock" --output "song.wav"

- パラメータの説明

--lyrics歌詞ファイルのパスを指定します。--style音楽スタイルのキューを入力します。--output出力オーディオファイルのパスと名前を指定します。

- 約10秒待つと、指定したパスにWAV形式のオーディオファイルが生成されます。

3.出力のチェック

- 生成が完了したら

song.wavファイルを作成し、任意のオーディオプレーヤー(Windows Media PlayerやVLCなど)を使って再生します。 - 歌詞とメロディーがシンクロしているか、音質は期待通りかをチェックする。

注目の機能

- エンド・ツー・エンドの楽曲生成セグメンテーションの必要がなく、DiffRhythm は完全な楽曲を一度に生成します。ユーザーは歌詞とスタイルを提供するだけで、完成品を得るために追加のパラメーター調整は必要ありません。

- 高速推論非自己回帰的な構造と潜在拡散技術により、生成スピードは非常に速い。従来のモデルの生成時間が数分かかることが多いのに比べ、DiffRhythmの10秒生成は効率を大幅に向上させます。

- メロディーとシンクロした歌詞生成されたメロディーが歌詞と合わない場合は、歌詞の音節数を調整したり、スタイル・チップに「クリア・テンポ」などの記述を追加して、出力を最適化することができます。

- スタイルのカスタマイズ例えば、"ジャズ"、"フォーク"、"ヒップホップ "などです。スタイルキューが具体的であればあるほど、生成される音楽は期待されるものに近づくでしょう。

ヒントとコツ

- 歌詞の最適化長い歌詞よりも短い歌詞の方がメロディに合わせやすい。

- バッチ生成への呼び出しをループする簡単なスクリプトを書く。

generate.py一度に複数の曲を生成することができる。 - デバッグ出力生成された結果が満足のいくものでない場合は、ログファイル(もしあれば)をチェックするか、GitHubのドキュメントに記載されているようにモデルパラメーター(拡散ステップ数など)を調整してください。

ほら

- ハードウェア要件生成処理には高い計算資源が必要であり、高速化のためにGPUを搭載したコンピュータの使用を推奨する。

- オープンソース貢献プログラミングが得意なら、プロジェクトをフォークしてコードを最適化したり、新しい機能を追加したりして、プルリクエストを提出することができる。

- 著作権警告作成された音楽は、スタイルが類似しているため、著作権上のリスクがあります。

これらのステップを踏むことで、DiffRhythm をすぐに使い始めることができ、歌詞から楽曲を完成させるまでの過程を体験することができます!

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません