DeepSeek-V3/R1 推論システムの概要 (DeepSeek Open Source Week 6日目)

システム設計の原則

DeepSeek-V3/R1 の推論サービスの最適化目標は以下のとおりです:より高いスループットとより低いレイテンシー。

この2つの目的を最適化するために、DeepSeekはクロスノード・エキスパート・パラレリズム(EP)と呼ばれるソリューションを採用している。

- 第一に、EPはバッチサイズを大幅に拡張することで、GPU行列計算の効率を改善し、スループットを向上させます。

- 第二に、EPは複数のGPUにエキスパートを分散させ、各GPUはエキスパートのごく一部のみを処理することでレイテンシを削減します(メモリアクセス要件を削減)。

しかし、EPは主に2つの方法でシステムの複雑性を増大させる:

- EPはクロスノード通信を導入する。スループットを最適化するためには、適切な計算ワークフローを設計し、通信と計算をオーバーラップさせる必要がある。

- EPには複数のノードが含まれるため、データ並列処理(DP)そのものと、異なるDPインスタンス間の負荷分散が必要となる。

この記事では、以下の点に焦点を当てる。 ディープシーク これらの課題にどう対処するか:

- EPを使用してバッチサイズを拡張する。

- 通信遅延を計算の背後に隠す。

- ロードバランシングを行う。

大規模なノード間エキスパート並列(EP)

DeepSeek-V3/R1ではエキスパートの数が多いため(レイヤーあたり256人のエキスパートのうち8人しかアクティブ化されていない)、モデルのスパース性が高く、合計バッチサイズが非常に大きくなる。これにより、エキスパートあたりの十分なバッチサイズが確保され、高いスループットと低レイテンシが実現します。大規模なクロスノードEPは非常に重要である。

DeepSeekはプリポピュレーションとデコーディングの分離アーキテクチャを採用しているため、プリポピュレーションとデコーディングの段階で異なるレベルの並列性が使用される:

- プレポピュレーションフェーズ[ルーティングエキスパートEP32、MLA/共有エキスパートDP32]各展開ユニットは4ノードにまたがり、32の冗長ルーティング・エキスパートを持ち、各GPUは9つのルーティング・エキスパートと1つの共有エキスパートを扱います。

- デコードフェーズ[ルーティングエキスパートEP144、MLA/シェアリングエキスパートDP144]各配備ユニットは18ノードにまたがり、32の冗長ルーティング・エキスパートを持ち、各GPUは2つのルーティング・エキスパートと1つの共有エキスパートを管理します。

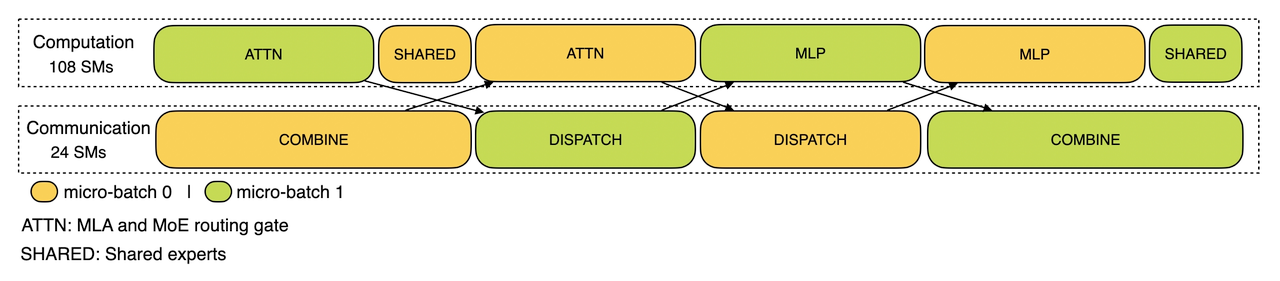

コンピューティングとコミュニケーションのオーバーラップ

大規模なクロスノードEPでは、大きな通信オーバーヘッドが発生します。これを軽減するために、DeepSeekは、リクエストのバッチを2つのマイクロバッチに分割することで、通信コストを隠蔽し、全体的なスループットを向上させるデュアルバッチオーバーラッピング戦略を採用する。プレポピュレーションフェーズでは、これら2つのマイクロバッチが交互に実行され、一方のマイクロバッチの通信コストは、もう一方のマイクロバッチの計算の背後に隠蔽される。

プレ人口フェーズの計算 - コミュニケーションのオーバーラップ

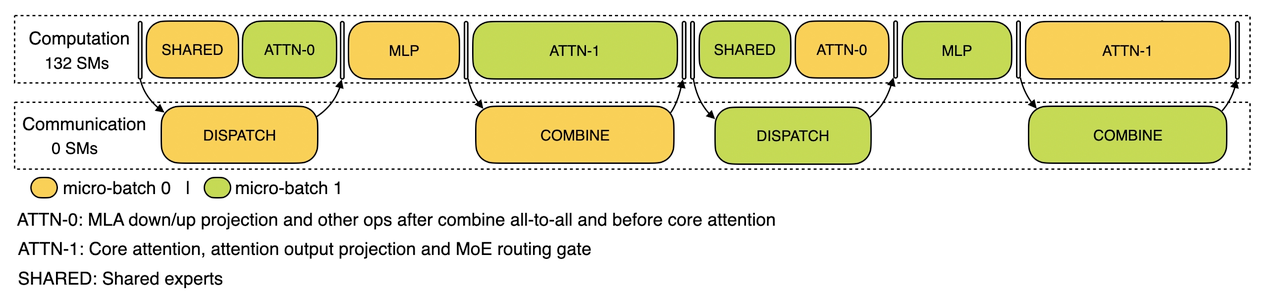

デコードフェーズでは、異なるステージの実行時間が不均一になる。そこでDeepSeekでは、注目レイヤーを2段階に細分化し、5段階のパイプラインを使用することで、計算と通信のシームレスなオーバーラップを実現している。

復号段階における計算と通信のオーバーラップ

DeepSeekの計算と通信のオーバーラップメカニズムの詳細については、以下をご覧ください。 https://github.com/deepseek-ai/profile-data.

最適な負荷分散を実現

大規模並列処理(DPとEPを含む)には重要な課題があります。1つのGPUが計算や通信で過負荷になると、性能のボトルネックとなり、他のGPUがアイドル状態の間にシステム全体の速度が低下します。リソースの利用率を最大化するため、DeepSeekはすべてのGPUで計算と通信の負荷のバランスをとるように努めています。

1.ロードバランサーの事前設定

- 重要な問題:DPインスタンス間でリクエスト数やシーケンス長が異なると、コアアテンション計算やスケジューリング送信の負荷が不均衡になる。

- 最適化の目標:

- GPU間でコア注意力計算のバランスをとる(コア注意力計算の負荷分散)。

- 各GPUへの入力を均等にする トークン 数(ロードバランシングを送信するスケジューリング)により、特定のGPUでの処理時間が長くなるのを防ぎます。

2.ロードバランサーの解読

- 主な問題点:DPインスタンス間でリクエスト数やシーケンスの長さが均一でないため、コアアテンション計算(KVCacheの使用量に関連)やスケジューリング送信の負荷に差が生じる。

- 最適化の目標:

- GPU間のKVCache使用量のバランス(コア・アテンション・コンピューティングの負荷分散)。

- GPUあたりのリクエスト数のバランスをとる(スケジューリング送信ロードバランシング)。

3.エキスパート並列ロードバランサー

- 重要な問題:与えられたMoEモデルに対して、エキスパートの負荷は本質的に高く、その結果、異なるGPU間でエキスパートの計算作業負荷が不均衡になる。

- 最適化の目標:

- 各GPUのエキスパート計算のバランスをとる(つまり、すべてのGPUの最大スケジューリング受信負荷を最小にする)。

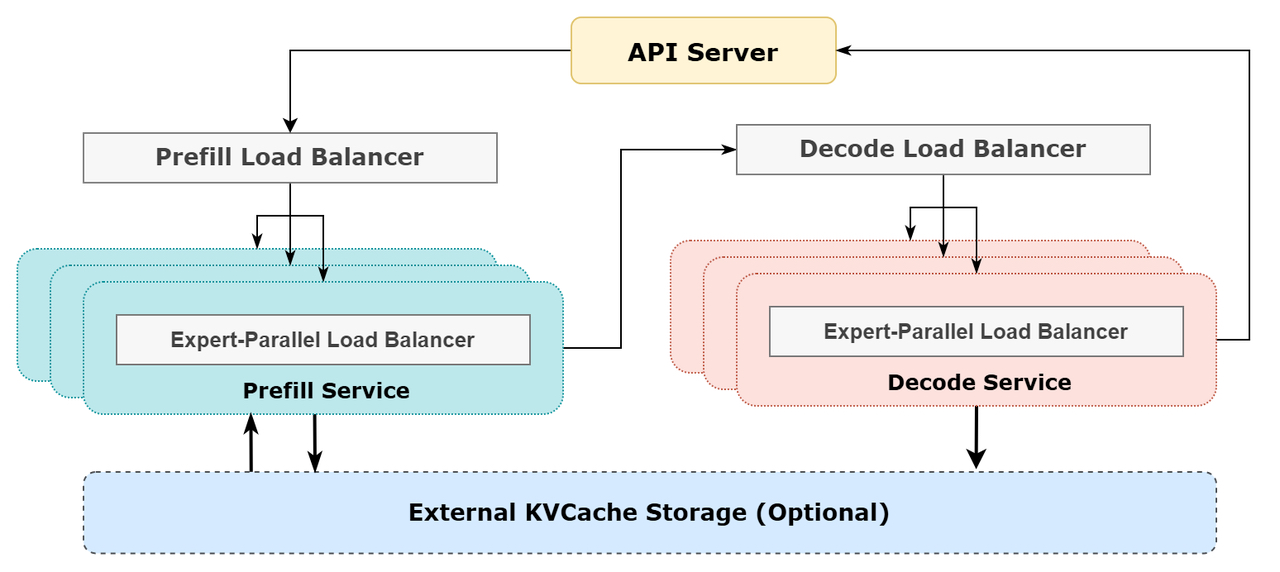

DeepSeekオンライン推論システムの概略図

DeepSeekオンライン推論システムの概略図

DeepSeekオンラインサービス統計

すべてのDeepSeek-V3/R1推論サービスは、H800 GPU上で、トレーニングに一致した精度で提供されます。具体的には、行列の乗算とスケジューリング転送はトレーニングと一致するFP8形式を使用し、コアMLAの計算と組み合わせ転送はBF16形式を使用して、最適なサービス性能を確保しています。

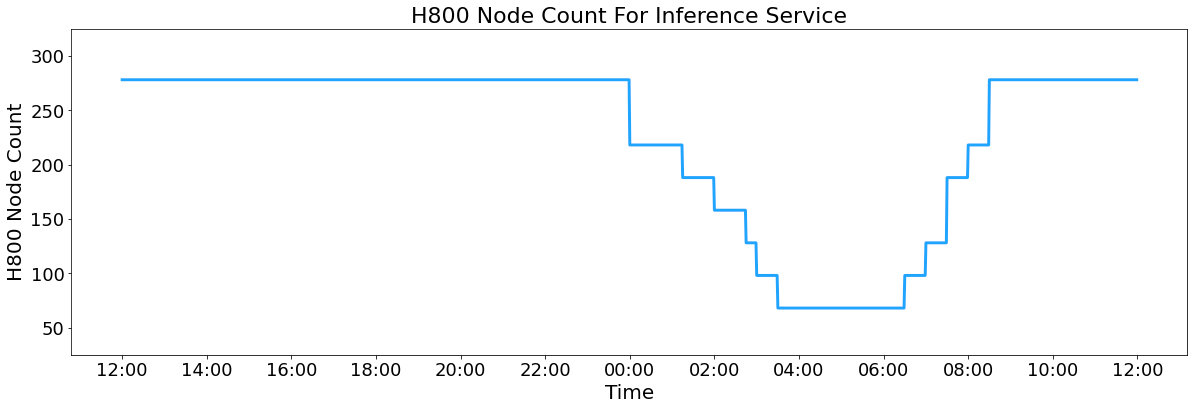

さらに、日中のサービス負荷が高く、夜間の負荷が低いため、DeepSeek は、日中のピーク時にすべてのノードで推論サービスを展開するメカニズムを実装しました。夜間の低負荷時間帯には、DeepSeek は推論ノードを減らし、リソース を調査とトレーニングに割り当てます。過去24時間(2025年2月27日12:00pm UTC+8から2025年2月28日12:00pm UTC+8)のV3推論サービスとR1推論サービスのピーク時のノード占有率は合計278ノードで、平均占有率は226.75ノード(各ノードには8個のH800 GPUが搭載)でした。H800 GPU1台のレンタルコストを1時間あたり2ドルと仮定すると、1日の総コストは87,072ドルです。

H800 推論サービスノード数

24時間の統計期間(2025年2月27日12:00 UTC+8 正午から2025年2月28日12:00 UTC+8 正午)中のV3とR1:

- 総入力トークン:608B、うち342Bトークン(56.3%)がディスク上のKVキャッシュにヒットした。

- 平均出力速度は毎秒20~22トークンで、各出力トークンの平均kvcache長は4,989トークンである。

- 各H800ノードは、プリポピュレーション時には平均~73.7kトークン/秒の入力スループット(キャッシュヒットを含む)、デコーディング時には平均~14.8kトークン/秒の出力スループットを提供する。

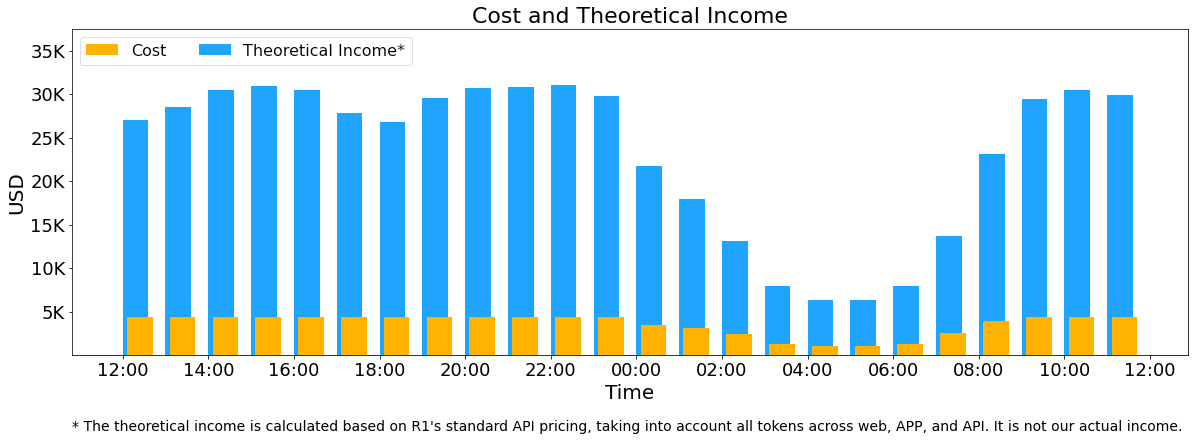

上記の統計には、ウェブ、アプリ、APIからのすべてのユーザーリクエストが含まれます。すべてのトークンが ディープシーク-R1 1日の総収入は562,027ドルで、価格設定(*)請求に基づくコストマージンは545%である。

(R1 価格:インプット・トークン(キャッシュ・ヒット)0.14ドル/M、インプット・トークン(キャッシュ・ミス)0.55ドル/M、アウトプット・トークン2.19ドル/M。

しかし、以下の理由により、ディープシークの実際の売上高はもっと低い:

- DeepSeek-V3の価格は、R1よりもかなり安い。

- 有料のサービスは一部のみ(ウェブとAPPへのアクセスは無料のまま)。

- 夜間割引はオフピーク時に自動的に適用される。

コストと理論的収益

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません