DeepSeek-R1の機能を詳しく解説、中国語の評価レポートも掲載

速読

経験:ディープシーク 公式ウェブサイト: chat.deepseek.com DeepSeek-R1とチャットし、「深く考える」ボタンをオンにします。訪問 OpenAIフォーマット対応API .

福祉:無料のGPUパワーでDeepSeek-R1オープンソースモデルをオンライン展開 そして100$のDeepSeek-R1クレジットをプレゼントそしてDeepSeek-R1の完全版を無料で利用できるAI推論プラットフォームトップ5

再発する:最近の再現の試み DeepSeek-R1のプロジェクトはかなり多いので、以下の記事に注目してほしい:TinyZero:DeepSeeK-R1ゼロのエピファニー効果を低コストで再現 そしてオープンR1:ハグする顔がDeepSeek-R1のトレーニングプロセスを再現 そしてDeepSeek-R1の複製:8Kの数学的事例が強化学習による推論のブレークスルーを小さなモデルにもたらす まだある:R1オーバーシンカー:DeepSeek R1モデルに長い思考を強いる .

概要コンテキストの長さ:128K、出力トークン100万個あたり2.19ドル(ビッグモデルの世界ではポンドランド)、OpenAI-o1と同程度のパフォーマンス、すべてのオープンソースモデルが自由に抽出され市販されている、想像力豊かなフロントエンド機能によるライティング。

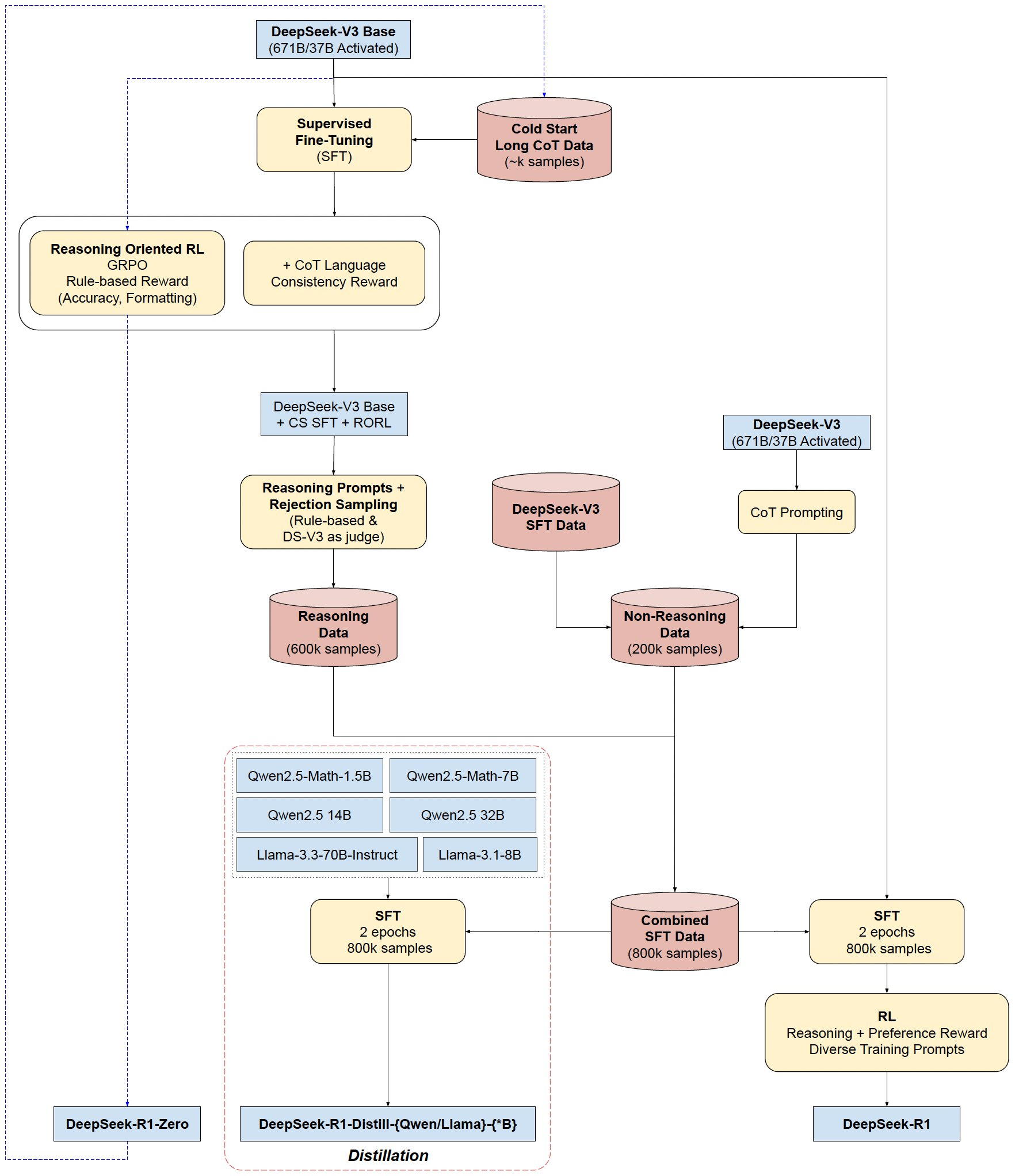

ベースモデル: DeepSeek-R1-ZeroとDeepSeek-R1はどちらもDeepSeek-V3-Baseに基づいて学習され、DeepSeek-R1は少量の長いCoTデータによって強化されるため、出力はより構造化され、解析的になります。

蒸留モデル(既存のオープンソースミニチュア機能の全体的な強化): DeepSeek-R1を、( オーラマ (ダウンロード可能)

Qwen2.5-Math-1.5B、Qwen2.5-Math-7B、Qwen2.5-14B、Qwen2.5-32B、Llama-3.1-8B、Llama-3.3-70B-インストラクター

DeepSeek-R1(-Zero)のトレーニングフロー

- コールドスタート:CoTの例で微調整

- 推論強化学習:言語的一貫性報酬の追加

- データ作成:作成 80 10,000トレーニングサンプル

- 究極の強化学習:ブレンドフィードバックによるバランスの取れたコンピテンシー(推論とジェネリックの両方

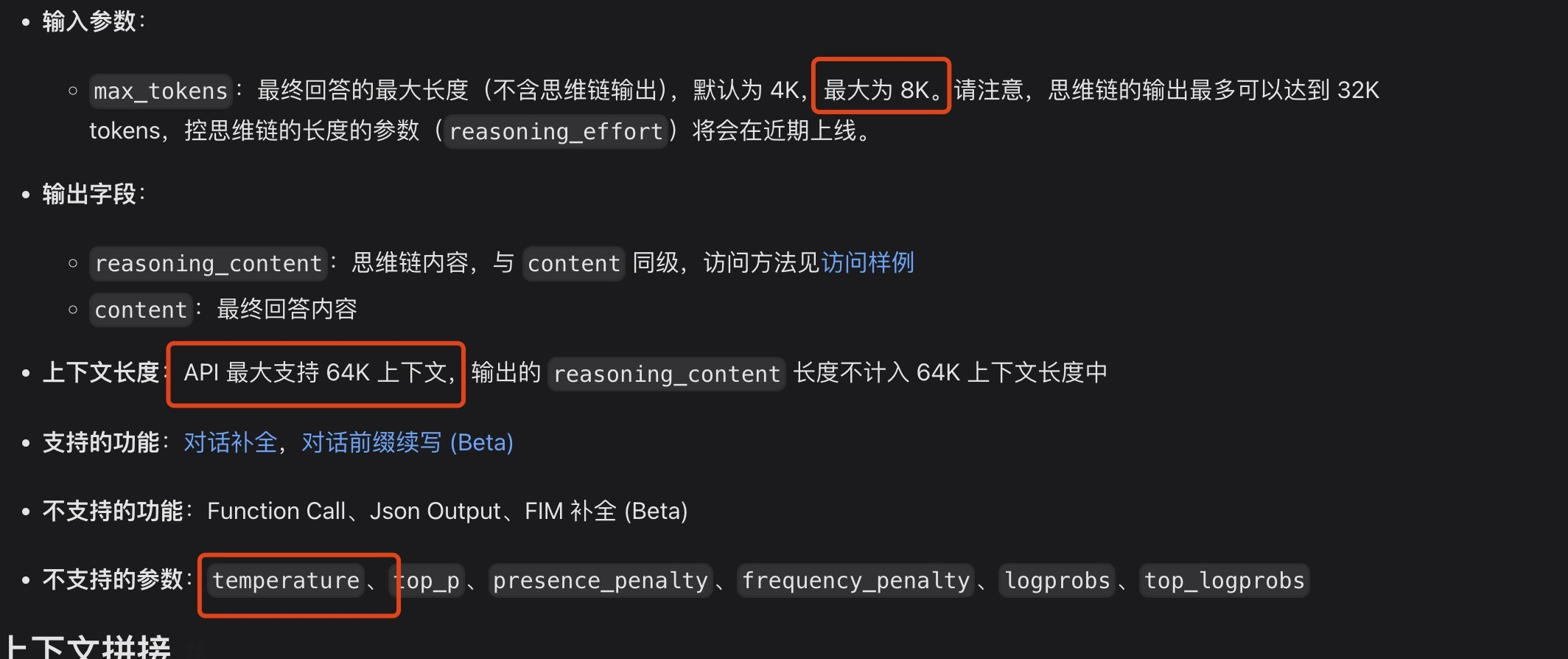

この問題は、APIのコンテキストの長さがプログラミングにおいて十分でない可能性がある。

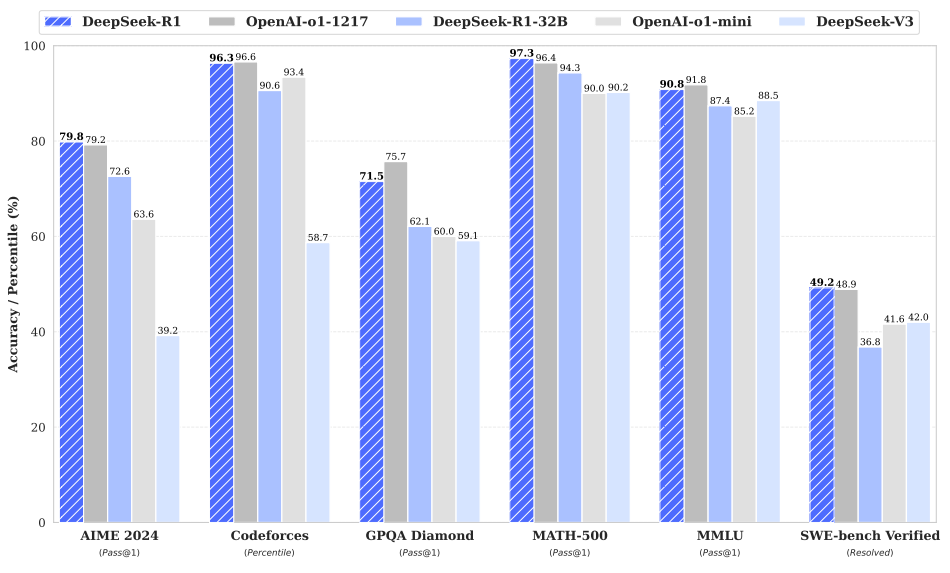

ベンチマーク評価

強い推理力:

数学の問題でOpenAI-01-1217に匹敵する性能を発揮。MATH-500ベンチマークで驚異的な高得点(97.3%)を獲得。

CodeforcesやLiveCodeBenchなどのコーディングアルゴリズムタスクで高いパフォーマンスを発揮。

FRAMESのような複雑な推論を必要とするタスクに強い能力を発揮する。

強力な汎用能力:

MMLU、MMLU-Pro、GPQA Diamondなどの知識ベースのベンチマークで優れたパフォーマンスを発揮。

また、文章を書くこと、オープンフィールドでの質問に答えること、その他さまざまな仕事も得意としている。

AlpacaEval 2.0やArenaHardなどのベンチマークで優れた長さ制御の勝率を記録し、非試験指向のクエリをインテリジェントに処理できることを実証。

簡潔な要約を作成し、長さの偏りを避ける能力。

読みやすい:コールドスタートデータとトレーニングプロセスにおける特定の設計により、DeepSeek-R1の出力は、適切なフォーマットと構造を使用して、読みやすくなりました。

多言語主義:現在のところ、主に中国語と英語に最適化されているが、多言語のクエリを処理する能力もある。

指示に従う能力IF-Evalベンチマークでも好成績を収め、指示をよく理解し、従う能力を示した。

自己進化能力:強化学習を通じて、モデルは自律的に学習し、推論能力を向上させることができ、思考時間を増やすことで複雑な問題に対処できるようになる。

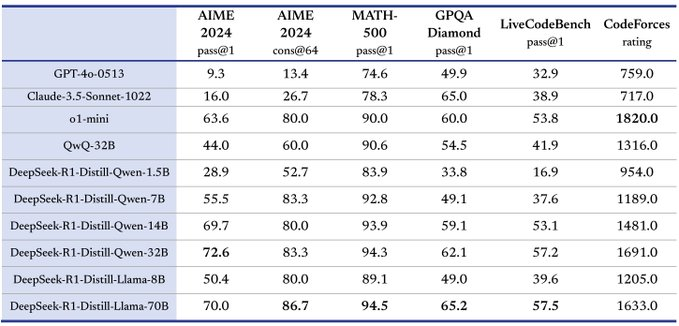

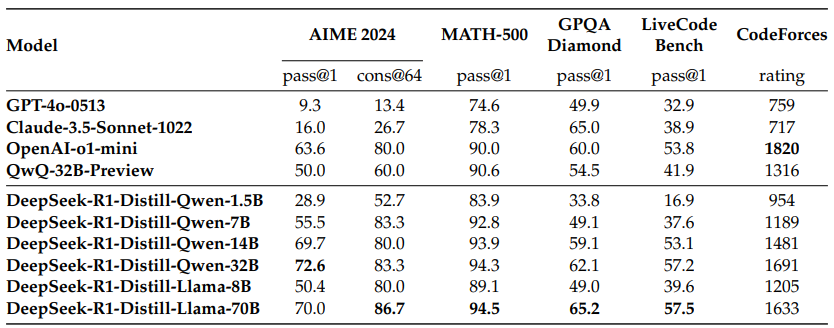

優れた蒸留ポテンシャルを持つ:DeepSeek-R1は、より小さなモデルに推論力を抽出するための教師モデルとして使用することができ、抽出されたモデルは優れた性能を持つ。例えば、DeepSeek-R1-Distill-Qwen-32Bは、いくつかのベンチマークで他のモデルを大幅に上回る。

現地での番組制作能力について

V3がプログラミングに十分だと思うなら、デスクトップの代替蒸留モデルはどれですか?DeepSeek V3と比較して、どの蒸留モデルが匹敵しますか?LiveCodeBenchのスコアによると、DeepSeek V3のスコアは42.2、蒸留モデルQwen 14Bのスコアは53.1となっており、性能は遜色なく、比較的デスクトップで実行できるクラスサイズであるため、デスクトップで14Bを使用することをお勧めします。

DeepSeek-R1:強化学習によるLLM推論の動機づけ。

投稿者: DeepSeek-AI

オリジナル:https://github.com/deepseek-ai/DeepSeek-R1/blob/main/DeepSeek_R1.pdf

抄録

DeepSeek-R1-Zeroは、大規模な強化学習(RL)によって学習されたモデルであり、最初の教師あり微調整(SFT)ステップを必要としない。RLを用いることで、DeepSeek-R1-Zeroは多くの強力で興味深い推論動作を自然に実現します。しかし、可読性の低さや言語の混在といった課題もあります。これらの問題に対処し、推論性能をさらに向上させるために、RLの前に多段学習とコールドスタートデータを組み合わせたDeepSeek-R1を導入します。 DeepSeek-R1は、推論タスクにおいてOpenAI-01-1217に匹敵する性能を達成しています。研究コミュニティを支援するため、DeepSeek-R1-Zero、DeepSeek-R1、およびQwenとLlamaの改良に基づく6つの高密度モデル(1.5B、7B、8B、14B、32B、70B)をオープンソース化します。

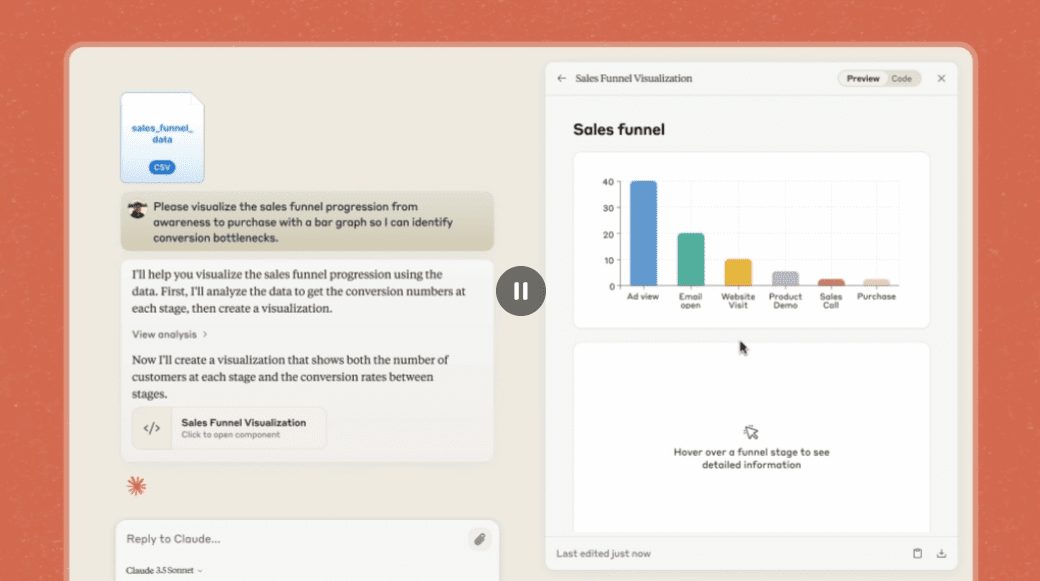

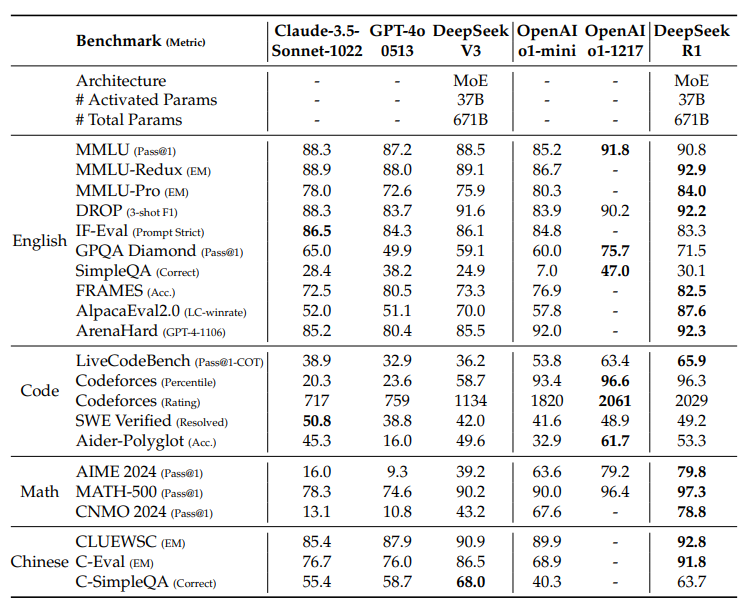

図1|DeepSeek-R1のベンチマーク性能。

ディレクトリ

1 はじめに

1.1 貢献

1.2 評価結果のまとめ

2 方法論

2.1 概要

2.2 DeepSeek-R1-Zero:基礎モデルに基づく強化学習

2.2.1 学習アルゴリズムの強化

2.2.2 インセンティブのモデル化

2.2.3 トレーニング・テンプレート

2.2.4 DeepSeek-R1-Zeroの性能、自己進化過程、啓示の瞬間

2.3 DeepSeek-R1: コールドスタートによる強化学習

2.3.1 コールドスタート

2.3.2 推論重視の強化学習

2.3.3 サンプリングの拒否と微調整の監督

2.3.4 すべてのシナリオに対する強化学習

2.4 蒸留:推論力で小さなモデルを補強する

3 実験

3.1 DeepSeek-R1 の評価

3.2 蒸留モデリングの評価

4 ディスカッション

4.1 蒸留と集中学習の比較

4.2 失敗した試み

5 結論、限界、今後の課題

1.はじめに

近年、大規模言語モデル(LLM)は急速な反復と発展を遂げ(Anthropic, 2024; Google, 2024; OpenAI, 2024a)、人工知能(AGI)につながるギャップを徐々に縮めている。

近年、ポストトレーニングは完全なトレーニングプロセスの重要な一部となっている。これは、推論タスクの精度を向上させ、社会的価値観に合致させ、ユーザーの嗜好に適応させることが示されている。推論力に関しては、OpenAIのo1(OpenAI, 2024b)モデルファミリーは、思考連鎖推論プロセスの長さを増加させることにより、推論時に初めてスケーリングを導入した。このアプローチは、数学的推論、コーディング推論、科学的推論など、様々な推論タスクにおいて大きな進歩をもたらしました。しかし、効果的なテスト時間スケーリングという課題は、研究コミュニティにとって未解決の問題のままである。いくつかの先行研究では、プロセスベースの報酬モデル(Lightman et al., 2023; Uesato et al., 2022; Wang et al., 2023)、強化学習(Kumar et al., 2024)、モンテカルロ木探索やバンドル探索などの探索アルゴリズム(Feng et al.)2024; Trinh et al.)。しかし、これらの手法のどれも、OpenAIのo1モデル群に匹敵する一般化推論性能を達成できていない。

本稿では、純粋な強化学習(RL)を用いて言語モデルの推論能力を向上させるための第一歩を踏み出す。我々の目標は、純粋なRLプロセスによる自己進化に焦点を当て、教師ありデータなしで推論能力を開発するLLMの可能性を探ることである。具体的には、DeepSeek-V3-Baseをベースモデルとして、GRPO(Shao et al.学習プロセスにおいて、DeepSeek-R1-Zeroは、多くの強力で興味深い推論動作を自然に出現させる。何千ものRLステップの後、DeepSeek-R1-Zeroは推論ベンチマークで優れた性能を示す。例えば、AIME 2024的pass@1得分从15.6%提高到71.0%、多数決により、スコアは86.7%までさらに向上し、OpenAI-01-0912の性能レベルに達しました。

しかし、DeepSeek-R1-Zeroは、可読性の低さや言語の混在といった課題に直面しています。これらの問題に対処し、推論性能をさらに向上させるために、我々は、少量のコールドスタートデータと多段階の学習プロセスを組み合わせたDeepSeek-R1を導入する。具体的には、まず数千のコールドスタートデータを収集し、DeepSeek-V3-Baseモデルを微調整します。この後、DeepSeek-R1-Zero と同様の推論指向の RL を実行します。RL プロセスが収束に近づくにつれて、RL チェックポイン トの不採用サンプリングによって新しい SFT データを作成し、DeepSeek-V3 からのライティング、事実クイズ、および自己認識のドメ インの教師ありデータと組み合わせて、DeepSeek-V3-Base モデルを再学習します。V3-Baseモデルを再学習する。新しいデータで微調整した後、このチェックポイントは、すべてのシナリオからのキューを考慮する追加のRLプロセスを受けます。これらのステップを経て、OpenAI-01-1217と同等の性能を持つDeepSeek-R1と呼ばれるチェックポイントが得られます。

さらに、DeepSeek-R1 からより小さな密なモデルへの蒸留を検討しました。Qwen 2.5-32B (Qwen, 2024b)を基本モデルとして、DeepSeek-R1からの直接蒸留は、その上にRLを適用するよりも優れており、より大きな基本モデルで発見された推論パターンが、推論を改善するために重要であることを示唆している。我々は、QwenとLlama(Dubey et al.注目すべきことに、我々の蒸留された14Bモデルは、最先端のオープンソースQwQ-32B-Preview(Qwen, 2024a)を大幅に上回り、蒸留された32Bモデルと70Bモデルは、密なモデルにおける推論ベンチマークの新記録を樹立した。

1.1 貢献

事後学習:基本モデルに基づく大規模強化学習

- このアプローチにより、複雑な問題を解決するための思考連鎖(CoT)を探索することが可能になり、DeepSeek-R1-Zeroの開発につながりました。DeepSeek-R1-Zeroは、CoTを自己検証し、反映し、成長させる能力を実証し、研究コミュニティにとって重要なマイルストーンとなった。注目すべきは、LLMの推論能力が、SFTを必要とせずに純粋なRLによって動機づけられることを検証した最初の公開研究である。

- DeepSeek-R1 の開発プロセスについて説明する。このプロセスは、改善された推論パターンを発見し、それを人間の嗜好に合わせることを目的とした2つのRLフェーズと、モデルの推論能力と非推論能力の種となる2つのSFTフェーズで構成されています。このプロセスは、より良いモデルを作成することにより、業界に利益をもたらすと信じています。

蒸留:小さなモデルは強力になり得る

- 我々は、大きなモデルからの推論パターンは、小さなモデル上のRLを介して発見された推論パターンと比較して、より良いパフォーマンスを得るために小さなモデルに蒸留することができることを実証する。オープンソースのDeepSeek-R1とそのAPIは、将来、より優れた小さなモデルを抽出する際に研究コミュニティに役立つだろう。

- DeepSeek-R1によって生成された推論データを用いて、研究コミュニティで広く使用されているいくつかの密なモデルを微調整した。DeepSeek-R1-Distill-Qwen-7Bは、AIME 2024で55.5%を達成し、QwQ-32B-Previewを上回った。また、DeepSeek-R1-Distill-Qwen-32BはAIME 2024で72.6%、MATH-500で94.3%、LiveCodeBenchで57.2%を記録しました。これらの結果は、以前のオープンソースモデルを大幅に上回り、o1-miniに匹敵します。我々は、Qwen2.5とLlama3シリーズに基づく蒸留1.5B、7B、8B、14B、32B、70Bのチェックポイントをコミュニティにオープンソース化しました。

1.2 評価結果のまとめ

- 推論タスク:(1) DeepSeek-R1は、AIME 2024で79.81 TP3Tのpass@1スコアを獲得し、OpenAI-o1-1217をわずかに上回った。これはOpenAI-o1-1217に匹敵し、他のモデルを大きく上回っている。(2) コーディング関連タスクでは、DeepSeek-R1 が Codeforces で 2,029 の Elo 評価を獲得し、同タスクに参加した人間の 96.31 TP3T を上回り、エキスパートレベルを示しました。エンジニアリング関連のタスクでは、DeepSeek-R1 は DeepSeek-V3 よりもわずかに優れた結果を示しました。

- **** MMLU では 90.8%、MMLU-Pro では 84.0%、GPQA Diamond では 71.5% を記録しました。これらのベンチマークでは、DeepSeek-R1 の性能は OpenAI-01-1217 より若干低いものの、他のクローズドソースモデルを上回り、教育タスクにおける優位性を示しています。ファクトベースのベンチマークである SimpleQA では、DeepSeek-R1 が DeepSeek-V3 を上回り、ファクトベースのクエリを処理する能力が実証されました。同様の傾向は、OpenAI-o1でも4oを超えて観察されます。

- その他:DeepSeek-R1 は、クリエイティブライティング、一般的な質問への回答、編集、要約など、さまざまなタスクでも高いパフォーマンスを発揮しました。AlpacaEval2.0では87.61 TP3T、ArenaHardでは92.31 TP3Tの長さ制御勝率を達成し、試験以外のクエリをインテリジェントに処理する強力な能力を実証しました。さらに、DeepSeek-R1は、長い文脈の理解を必要とするタスクで優れた性能を発揮し、長い文脈のベンチマークでDeepSeek-V3を大幅に上回りました。

2.方法論

2.1 概要

これまでの研究では、モデルの性能を向上させるために、大量の教師ありデータに大きく依存してきた。本研究では、コールドスタートとして教師あり微調整(SFT)を用いなくとも、大規模強化学習(RL)によって推論が大幅に改善されることを実証する。さらに、少量のコールドスタートデータを含めることで、性能はさらに向上する。以下のセクションでは、(1)SFTデータなしでベースモデルに直接RLを適用するDeepSeek-R1-Zeroと、(2)何千もの長いChain of Thoughts(CoT)の例で微調整されたチェックポイントからRLを適用するDeepSeek-R1、および(3)DeepSeek-R1の推論能力を小さな密なモデルに抽出するDeepSeek-R1-Zeroを紹介します。小さな密なモデル。

2.2 DeepSeek-R1-Zero:基礎モデルに基づく強化学習

強化学習は、我々の以前の研究(Shao et al., 2024; Wang et al., 2023)で実証されたように、推論タスクにおいて大きな有効性を示している。しかし、これらのタスクは、収集に時間のかかる教師付きデータに大きく依存している。本セクションでは、純粋な強化学習プロセスによる自己進化に焦点を当て、教師付きデータなしで推論能力を開発するLLMの可能性を探る。我々の強化学習アルゴリズムの簡単な概要から始め、いくつかのエキサイティングな結果を紹介する。

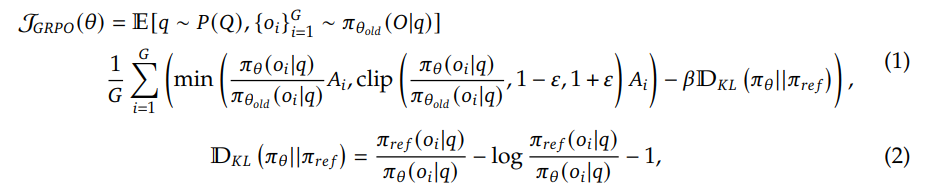

グループ相対戦略最適化 RLの学習コストを節約するために、グループ相対戦略最適化(GRPO)(Shao et al.具体的には、各問題qに対して、GRPOは古い戦略πθoldからの出力セット{o1, o2,..., oG}をサンプリングし、次の目的を最大化することによって戦略モデルπθを最適化する:

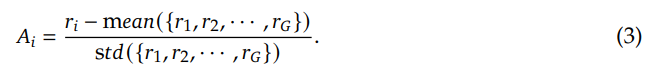

ここで、↪Ll_25B と β はハイパーパラメータ、Ai はドミナンスである。 . .rG}を用いて計算する:

報酬は学習信号の源であり、RL の最適化方向を決定する。DeepSeek-R1-Zeroの学習には、主に以下の2種類の報酬からなるルールベースの報酬システムを使用します:

- 精度報酬:精度報酬モデルは、回答が正しいかどうかを評価する。例えば、決定論的な結果を持つ数学の問題では、モデルは最終的な答えを指定された形式(例えば、箱の中)で提供する必要があります。同様に、LeetCodeの問題では、コンパイラは事前に定義されたテストケースに基づいてフィードバックを生成するために使用することができます。

- フォーマット報酬:正確さ報酬モデルに加えて、「'」と「'」のラベルの間に思考プロセスを配置させるフォーマット報酬モデルを使用した。

DeepSeek-R1-Zeroの開発では、結果またはプロセスのニューラル報酬モデルを使用しませんでした。これは、ニューラル報酬モデルが大規模な強化学習中に報酬のハッキングに悩まされる可能性があること、および報酬モデルの再トレーニングには追加のトレーニングリソースが必要であり、トレーニングプロセス全体が複雑になる可能性があることがわかったためです。

DeepSeek-R1-Zero を訓練するために、まず、ベース・モデルに指定した指示に従うよう指示する単純なテンプレートを設計しました。表 1 に示すように、このテンプレートでは、DeepSeek-R1-Zero が最初に推論プロセスを生成し、次に最終的な答えを生成する必要があります。強化学習(RL)プロセスを通じたモデルの自然な進行を正確に観察できるように、反射的推論を強制したり、特定の問題解決方略を促進したりするような、内容固有のバイアスを避けるために、制約を意図的にこの構造形式に限定しました。

用户与助手之间的对话。用户提出一个问题,助手解决该问题。

助手首先在脑海中思考推理过程,然后为用户提供答案。

推理过程和答案分别用 <think> </think> 和 <answer> </answer> 标签括起来,即:

<think> 此处为推理过程 </think>

<answer> 此处为答案 </answer>。

用户:提示。助手:

表1|DeepSeek-R1-Zeroのテンプレート。トレーニング中注意を引くは具体的な推理問題に置き換えられる。

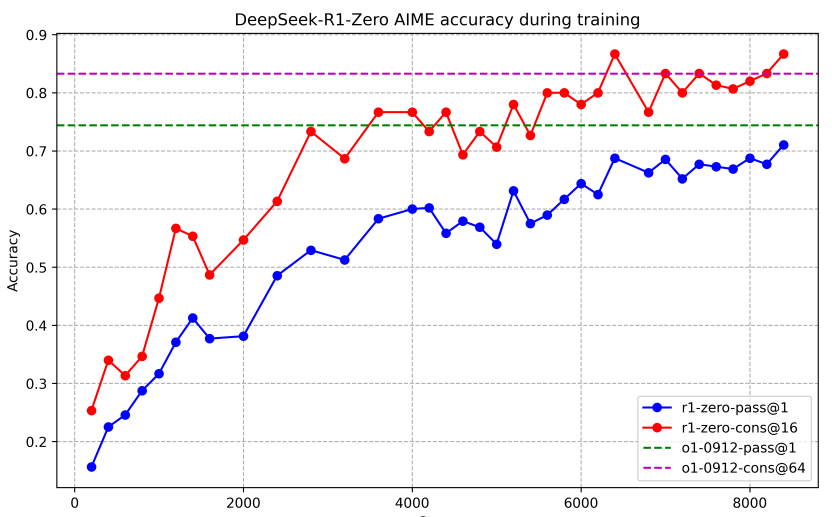

DeepSeek-R1-Zeroの性能 図2は、強化学習(RL)トレーニングを通して、AIME 2024ベンチマークにおけるDeepSeek-R1-Zeroの性能の軌跡を示しています。示されているように、DeepSeek-R1-Zeroの性能は、RLトレーニングが進むにつれて着実に一貫して向上しています。特に、AIME 2024の平均pass@1スコアは大幅な伸びを示しており、当初の15.61 TP3Tから71.01 TP3Tという驚異的なスコアに跳ね上がり、OpenAI-01-0912に匹敵する性能レベルに達しました。この大幅な向上は、モデル性能の最適化における我々のRLアルゴリズムの有効性を浮き彫りにしています。

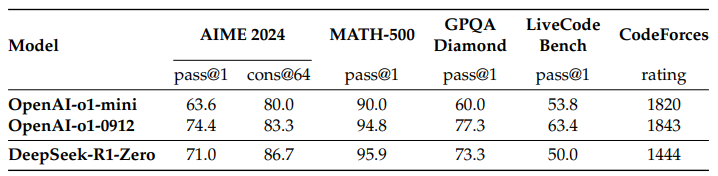

表 2 は、さまざまな推論関連ベンチマークにおける DeepSeek-R1-Zero と OpenAI の o1-0912 モデルの比較分析です。その結果、RL は

表2|推論関連ベンチマークにおけるDeepSeek-R1-ZeroとOpenAI o1モデルの比較。

図2|学習中のDeepSeek-R1-ZeroのAIME精度。各問題について、16の回答をサンプリングし、安定した評価を行うために全体の平均精度を計算しました。

DeepSeek-R1-Zeroは、データの教師あり微調整なしで強力な推論を達成しました。これは、RLのみで効果的に学習し汎化するモデルの能力を浮き彫りにしており、注目すべき成果です。さらに、DeepSeek-R1-Zeroの性能は、多数決を適用することでさらに向上させることができます。たとえば、AIMEベンチマークで多数決を使用すると、DeepSeek-R1-Zeroの性能は71.01 TP3Tから86.71 TP3Tに向上し、OpenAI-01-0912の性能を上回ります。DeepSeek-R1-Zeroは、多数決の有無にかかわらず、このような競争力のある性能を達成しています。

DeepSeek-R1-Zeroの自己進化プロセス DeepSeek-R1-Zeroの自己進化プロセスは、RLがどのようにモデルの推論を自律的に向上させるかを示す魅力的なデモンストレーションです。ベースモデルから直接RLを起動することで、教師ありの微調整フェーズに従うことなく、モデルの進歩を注意深く監視することができます。このアプローチは、特に複雑な推論タスクを処理する能力において、時間の経過とともにモデルがどのように進化していくかを明確に見ることができる。

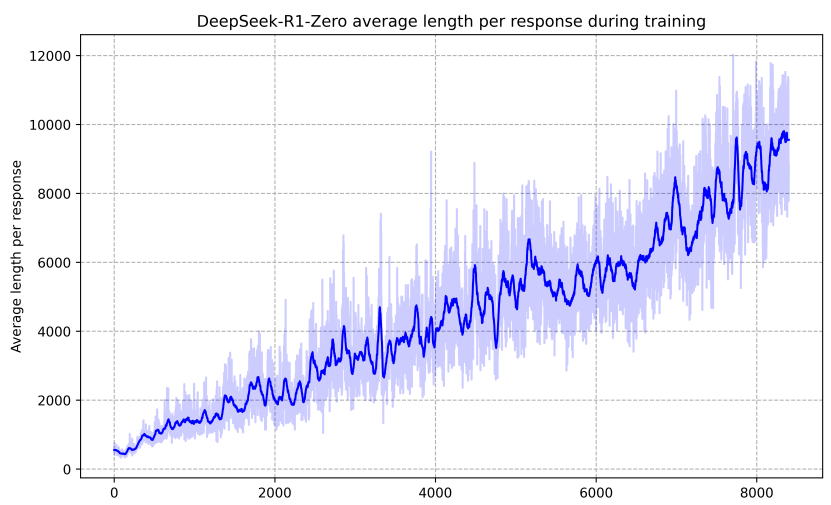

図 3 に示すように、DeepSeek-R1-Zero の思考時間は、学習プロセスを通じて継続的な改善を示しています。DeepSeek-R1-Zero は、拡張テスト時間計算を利用することで、複雑さを増す推論タスクを解く能力を自然に獲得します。この計算は、数百から数千の推論トークンを生成する範囲に及ぶため、モデルはより深く思考プロセスを探索し、洗練させることができます。

この自己進化の最も顕著な側面のひとつは、テスト中に計算量が増えるにつれて複雑な行動が出現することである。リフレクション(すなわち、モデルが以前のステップを再検討し再評価すること)だけでなく、代替的な問題解決アプローチの探索も、自発的に出現する。これらの行動は、明示的にプログラムされたものではなく、モデルと強化学習環境との相互作用の結果として現れる。このような自発的な発展により、DeepSeek-R1-Zeroの推論能力が大幅に強化され、より困難なタスクに高い効率と精度で取り組むことが可能になります。

図3|RLプロセス学習セットにおけるDeepSeek-R1-Zeroの平均応答長。DeepSeek-R1-Zeroは、より多くの思考時間をかけて推論タスクを解くことを自然に学習する。

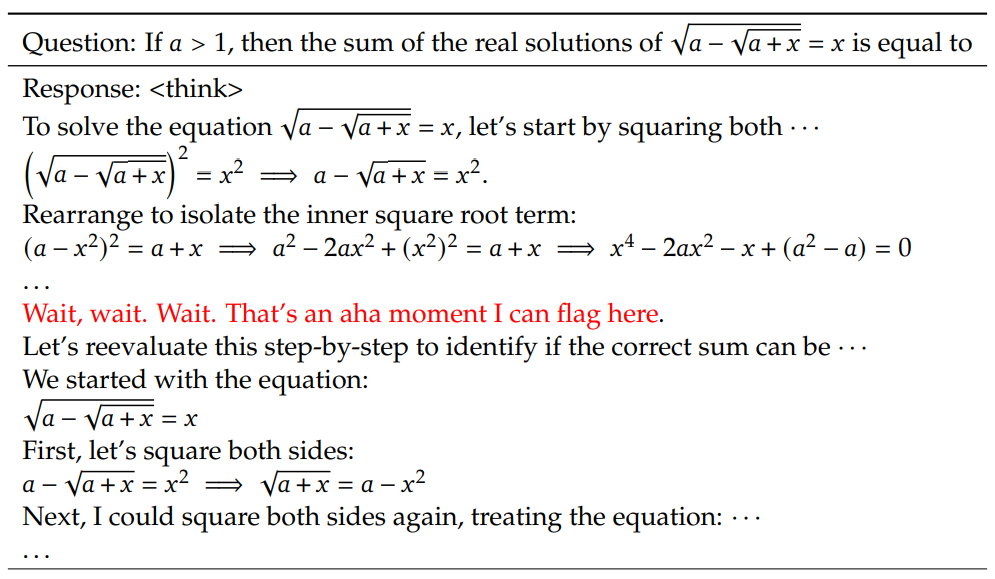

DeepSeek-R1-Zero における啓示の瞬間 DeepSeek-R1-Zero のトレーニング中に観察された特に興味深い現象は、「啓示の瞬間」の発生である。表 3 に示すように、この瞬間はモデルの中間バージョンで発生します。この段階で、DeepSeek-R1-Zero は、最初のアプローチを再評価することで、問題により多くの思考時間を割り当てることを学習します。この振る舞いは、モデルの推論能力が高まっていることを示すだけでなく、強化学習が予期しない複雑な結果を導き出す可能性を示す魅力的な例でもあります。

表3|DeepSeek-R1-Zeroの中間バージョンにおける興味深い「啓示の瞬間」。モデルは擬人化された口調で考え直すことを学習する。これは私たち自身の啓示の瞬間でもあり、強化学習のパワーと美しさを目の当たりにすることができた。

この瞬間は、モデルにとってだけでなく、その行動を観察した研究者たちにとっても「啓示」だった。問題の解き方を明示的にモデルに教えるのではなく、適切なインセンティブを与えるだけで、モデルは自律的に高度な問題解決戦略を開発するのだ。この "啓示の瞬間 "は、RLがAIシステムの新たなレベルの知性を解き放ち、将来、より自律的で適応的なモデルへの道を開く可能性を、力強く思い出させるものである。

DeepSeek-R1-Zeroの欠点 DeepSeek-R1-Zeroは強力な推論能力を発揮し、予期しない強力な推論動作を自律的に開発する一方で、いくつかの問題にも直面している。例えば、DeepSeek-R1-Zeroは可読性の低さと言語の混在に苦労しています。推論プロセスをより読みやすくし、オープンなコミュニティと共有するために、我々はDeepSeek-R1という、人間に優しいコールドスタートデータでRLを利用するアプローチを検討した。

2.3 DeepSeek-R1: コールドスタートによる強化学習

DeepSeek-R1-Zeroの有望な結果に触発されて、以下の2つの自然な疑問が生じました:1)コールドスタートとして少量の高品質なデータを取り入れることで、推論性能をさらに向上させたり、収束を加速させたりできるのか? 2)明確で首尾一貫したChain of Thought(CoT)を生成するだけでなく、強力な汎化能力も示す、使いやすいモデルをどのように訓練できるのか?これらの疑問を解決するために、DeepSeek-R1 の学習プロセスを設計しました。このプロセスは、以下の4つのフェーズで構成されています。

DeepSeek-R1-Zero とは異なり、DeepSeek-R1 では、ベースモデルから RL 学習を開始したときに、早期に不安定なコールドスタート段階になるのを防ぐため、RL の初期参加者として、モデルを微調整するための少量の長い CoT データを構築して収集しました。このようなデータを収集するために、長い CoT を例として少数のサンプルプロンプトを使用する方法、反省と検証を行いながら詳細な回答を生成するようモデルに直接プロンプトを送信する方法、DeepSeek-R1-Zero の出力を読み取り可能な形式で収集する方法、人間のアノテータを介して結果を後処理する方法など、いくつかのアプローチを検討しました。

この研究では、DeepSeek-V3-Base を RL の出発点として微調整するために、何千ものコールドスタートデータを収集しました。DeepSeek-R1-Zero と比較したコールドスタートデータの利点は以下のとおりです:

- 可読性:DeepSeek-R1-Zero の主な制限は、コンテンツが読みにくいことが多いことです。回答には複数の言語が混在していたり、ユーザの回答を強調するために使用されるマークアップ形式が欠落していたりします。その代わりに、DeepSeek-R1 用のコールドスタート・データを作成する際に、各回答の最後にサマリを含め、簡単に読めない回 答をフィルタリングする、読みやすいスキーマを設計しました。ここでは、出力形式を|special_token||special_token|

と定義します。ここで、推論プロセスはクエリのCoTであり、要約は推論の結果を要約するために使用されます。 - ポテンシャル:コールドスタートデータのモデルを作成するために人間の事前学習を使用することで、DeepSeek-R1-Zeroに対してより良いパフォーマンスを観察。我々は、反復学習はモデルについてより良い推論方法であると主張する。

コールドスタートデータで DeepSeek-V3-Base を微調整した後、DeepSeek-R1-Zero で採用したのと同じ大規模な強化学習トレーニングプロセスを適用しました。このフェーズの焦点は、モデルの推論能力を強化することであり、特に、明示的な質問を含むコーディング、数学的推論、科学的推論、論理的推論のような推論を必要とするタスクにおいて、モデルの推論能力を強化することであった。トレーニングの過程で、CoTは、特にRLキューが複数の言語を含む場合、しばしば言語混合を示すことが観察された。言語混合問題を軽減するために、RL訓練中に言語的一貫性報酬を導入した。アブレーション実験によれば、この整合性はモデルの性能を若干低下させるが、この報酬は人間の嗜好と一致しており、より読みやすくなっている。最後に、推論タスクにおける正確さと言語的一貫性の報酬を直接合計して最終報酬とする。次に、推論タスクで収束に達するまで、微調整されたモデルに対して強化学習(RL)学習を適用する。

推論指向のRLが収束すると、生成されたチェックポイントを使用して、後続のラウンドのためのSFT(教師あり微調整)データを収集する。推論に主眼を置いた最初のコールドスタートデータとは異なり、このフェーズでは、ライティング、ロールプレイング、その他の汎用タスクにおけるモデルの能力を向上させるために、他のドメインからのデータを取り入れる。具体的には、以下のようにデータを生成し、モデルを微調整した。

推論データ 上記のRL訓練済みチェックポイントから棄却サンプリングを行うことにより、推論キューをキュレーションし、推論トラジェクトリーを生成した。前フェーズでは、ルールベースの報酬で評価できるデータのみを対象とした。しかし、このフェーズでは、実際のラベルとモデルの予測値を判定用に DeepSeek-V3 に供給することで、生成的報酬モデルを使用するいくつかのより多くのデータを組み合わせ、データセットを拡張します。さらに、モデルの出力は時に混乱し読みにくいため、言語が混在する思考連鎖、長い段落、コードの塊をフィルタリングした。各キューについて、複数の回答をサンプリングし、正しい回答のみを保持した。合計で、推論に関連する約600,000のトレーニングサンプルを収集した。

非推論データ ライティング、事実クイズ、自己認識、翻訳などの非推論データについては、DeepSeek-V3 のプロセスを採用し、DeepSeek-V3 の SFT データセットの一部を再利用します。推論以外のタスクでは、質問に答える前にDeepSeek-V3を呼び出してプロンプトを表示し、潜在的な思考の連鎖を生成します。最後に、推論とは関係のない合計約20万個のトレーニングサンプルを収集する。

我々は、約80万サンプルの上記キュレーションデータセットを使用して、2つの期間DeepSeek-V3-Baseを微調整した。

モデルを人間の嗜好にさらに合わせるために、我々は、推論能力を継続的に向上させながら、モデルの有用性と無害性を高めることを目的とした強化学習の第2段階を実施した。具体的には、報酬信号と様々な手がかり分布の組み合わせを用いてモデルを訓練する。推論データについては、DeepSeek-R1-Zeroで概説されたアプローチに準拠し、数学的推論、コード化推論、論理的推論の領域において、ルールベースの報酬を使用して学習プロセスをガイドする。一般的なデータについては、複雑で詳細なシナリオにおける人間の嗜好を捉える報酬モデルに依存する。我々はDeepSeek-V3のプロセスをベースとし、同様の嗜好ペアと訓練キュー分布を使用する。役に立つように、我々は最終的な要約にのみ焦点を当て、評価がユーザーへの応答の有用性と関連性を強調することを保証し、同時に基礎となる推論プロセスへの干渉を最小限に抑えます。無害性を提供するために、推論プロセスと要約を含むモデルの応答全体を評価し、生成プロセス中に生じた可能性のある潜在的なリスク、バイアス、または有害なコンテンツを特定し、軽減する。最終的には、報酬信号と様々なデータ分布の統合により、推論に優れ、有用性と無害性の両方を優先するモデルを訓練することができる。

2.4 蒸留:推論力で小さなモデルを補強する

DeepSeek-R1 のような推論機能を持つ、より効率的な小型モデルを作るために、我々は、Qwen (Qwen, 2024b)やLlama (AI@Meta, 2024)のようなオープンソースモデルを、DeepSeek-R1 によって照合された 80 万のサンプルを使って直接微調整しました(2.3.3 節で詳述)。この結果は、この単純な蒸留法によって、小さなモデルの推論を大幅に強化できることを示唆し ています。ここで使用するベースモデルは、Qwen2.5-Math-1.5B、Qwen2.5-Math-7B、Qwen2.5-14B、Qwen2.5-32B、Llama-3.1-8B、Llama-3.3-70B-Instruct です。Llama-3.3を選んだ。

蒸留モデルについては、SFTのみを適用し、RLステージは含めないが、RLをマージすることでモデルの性能を大幅に向上させることができる。ここでの主な目的は蒸留技術の有効性を実証することであり、RLステージの探求はより広い研究コミュニティに委ねる。

3.実験

ベンチマーキング MMLU (Hendrycks et al., 2020)、MMLU-Redux (Gema et al., 2024)、MMLU-Pro (Wang et al., 2024)、C-Eval (Huang et al., 2023)、CMMLU (Li et al., 2023)、IFEval (Zhou et al., 2023)、FRAMES (Krishna et al., 2024)、GPQA Diamond (OpenAI Diamond) (Rein et al., 2023)で発表しています。IFEval (Zhou et al., 2023)、FRAMES (Krishna et al., 2024)、GPQA Diamond (Rein et al., 2023)、SimpleQA (OpenAI, 2024c)、C-SimpleQA (He et al., 2024)、SWE-。Bench Verified (OpenAI, 2024d), Aider¹ , LiveCodeBench (Jain et al., 2024) (2024-08 - 2025-01), Codeforces², 中国全国高校数学オリンピック (CNHSMOA)School Mathematics Olympiad (CNMO 2024)³、American Invitational Mathematics Examination 2024 (AIME 2024) (MAA, 2024)。標準的なベンチマークテストに加え、オープンな生成タスクにおける我々のモデルの性能を評価するための審査員としてLLMを使用する。具体的には、AlpacaEval 2.0 (Dubois et al., 2024)とArena-Hard (Li et al., 2024)のオリジナルの構成に従う。ここでは、長さのバイアスを避けるため、評価のための最終サマリーのみを提供する。蒸留モデルについては、AIME 2024、MATH-500、GPQA Diamond、Codeforces、LiveCodeBenchでの代表的な結果を報告する。

評価のヒント DeepSeek-V3のセットアップに従って、MMLU、DROP、GPQA Diamond、SimpleQAなどの標準ベンチマークを、simple-evalsフレームワークのプロンプトを使用して評価します。MMLU-Reduxについては、ゼロサンプル設定のZero-Evalプロンプト形式(Lin, 2024)を使用します。MMLU-Pro、C-Eval、CLUE-WSCについては、元のプロンプトがアンダーサンプルであったため、プロンプトをゼロサンプル設定に若干修正した。サンプル数の少ない CoT は、DeepSeek-R1 のパフォーマンスを低下させる可能性があります。他のデータセットは、作成者が提供するデフォルトのヒントを使用して、元の評価プロトコルに従います。コードと数学のベンチマークについては、HumanEval-Mulデータセットが8つの主要なプログラミング言語(Python、Java、C++、C#、JavaScript、TypeScript、PHP、Bash)をカバーしています。LiveCodeBench上のモデル性能は、2024年8月から2025年1月の間に収集されたデータを用いて、CoT形式で評価されている。Codeforcesデータセットは、10のDiv.2コンペティションからの問題、および専門家が作成したテストケースを使用して評価され、その後、競合の期待評価とパーセンテージが計算されました。SWE-Bench の検証結果は、エージェントレスフレームワーク(Xia et al.)AIDER 関連のベンチマークは "diff" 形式で測定し、DeepSeek-R1 の出力はベンチマークごとに 32,768 トークンを上限とした。

基準線 我々は、DeepSeek-V3、Claude-Sonnet-3.5-1022、GPT-40-0513、OpenAI-01-mini、OpenAI-01-1217を含むいくつかの強力なベースラインに対して包括的な評価を実施した。中国本土でのOpenAI-01-1217 APIへのアクセスが困難なため、公式レポートに基づいてその性能を報告しています。蒸留モデルについては、オープンソースモデルQwQ-32B-Preview (Qwen, 2024a)も比較した。

設定の生成 サンプリングを必要とするベンチマークでは、0.6の温度、0.95のtop-p値を使用し、pass@1を推定するために各クエリに対して64応答を生成する。

3.1 DeepSeek-R1 の評価

MMLU、MMLU-Pro、GPQA Diamondなどの教育向け知識ベンチマークにおいて、DeepSeek-R1はDeepSeek-V3よりも優れた性能を示しています。 この改善は、主にSTEM関連の問題で精度が向上したことに起因しており、大規模な強化学習(RL)によって大きな利益が達成されています。さらに、DeepSeek-R1は、長い文脈依存のQAタスクであるFRAMESで優れた性能を発揮し、その強力な文書分析能力を実証しています。 これは、AI主導の検索およびデータ分析タスクにおける推論モデルの可能性を浮き彫りにしています。 ファクトベースのベンチマークであるSimpleQAでは、DeepSeek-R1がDeepSeek-V3を上回り、ファクトベースのクエリを処理する能力が実証されました。 このベンチマークでOpenAI-01がGPT-40を上回った場合も同様の傾向が見られました。 ただし、DeepSeek-R1 は、中国の SimpleQA ベンチマ ークでは DeepSeek-V3 ほど性能が良くありません。これは主に、安全な RL の後に特定のクエリへの回答を拒否する傾向があるためです。 安全なRLがない場合、DeepSeek-R1は70%以上の精度を達成できます。

表 4|DeepSeek-R1 と他の代表的なモデルの比較。

DeepSeek-R1はまた、IF-Eval(モデルのフォーマット指示への追従能力を評価するために設計されたベンチマークテスト)でも印象的な結果を達成しました。 これらの改善は、教師ありファインチューニング(SFT)とRLトレーニングの最終段階に含まれる指示遵守データに関連している可能性があります。 さらに、AlpacaEval2.0 と ArenaHard で優れたパフォーマンスが観察され、DeepSeek-R1 がライティングタスクとオープンドメインの質問応答で優位にあることが示されました。DeepSeek-V3よりも有意に優れた性能は、大規模RLの汎化の利点を浮き彫りにし、推論だけでなく、複数のドメインにわたる性能も向上させます。 さらに、DeepSeek-R1は簡潔な要約の長さを生成し、ArenaHardの平均は、DeepSeek-R1の方が優れています。 トークン は 689 文字、AlpacaEval 2.0 では平均 2,218 文字でした。 これは、DeepSeek-R1 が GPT ベースの評価で長さの偏りを回避し、複数のタスクにまたがって堅牢であるこ とを示しています。

数学的なタスクでは、DeepSeek-R1の性能はOpenAI-01-1217に匹敵し、他のモデルを大幅に上回っています。 同様の傾向は、LiveCodeBenchやCodeforcesなどのコーディングアルゴリズムタスクでも見られ、推論中心のモデルがこれらのベンチマークを圧倒しています。 エンジニアリング指向のコーディングタスクでは、OpenAI-01-1217 が Aider で DeepSeek-R1 を上回りましたが、SWE Verified では同等の性能を達成しました。 現時点では、関連する RL 訓練データの量がまだ非常に限られているため、エンジニアリングタスクに対する DeepSeek-R1 の性能は、次のリリースで改善されると考えています。

3.2 蒸留モデリングの評価

表 5|DeepSeek-R1 蒸留モデルと、推論相関ベンチマークテストで比較可能な他のモデルとの比較。

表 5 に示すように、DeepSeek-R1 の出力を単純に蒸留することで、効率的な DeepSeek-R1-7B(つまり、DeepSeek-R1-Distill-Qwen-7B、 以降この名前で呼びます)は、GPT-40-0513 などの非推論モデルをあらゆる点で上回ります。 DeepSeek-R1-14Bはすべての評価指標でQwQ-32B-Previewを上回り、DeepSeek-R1-32BとDeepSeek-R1-70Bはほとんどのベンチマークでo1-miniを大幅に上回る。 これらの結果はdistillの強い可能性を示している。 さらに、これらのdistillモデルにRLを適用することで、さらに大きな利益が得られることがわかりました。 我々は、このことはさらに検討する価値があると考え、ここでは単純なSFT蒸留モデルについての結果のみを示す。

4.ディスカッション

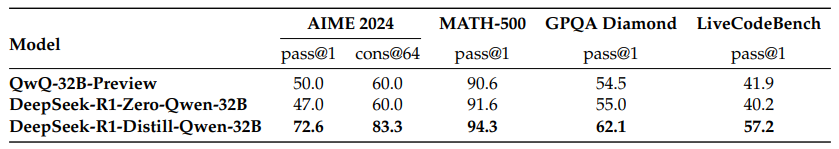

4.1 蒸留と集中学習の比較

表6|推論相関ベンチマークにおける蒸留モデルとRLモデルの比較。

セクション 3.2 では、DeepSeek-R1 を蒸留することで、小さなモデルでも目覚ましい結果を 達成できることがわかります。しかし、この論文で議論されている大規模 RL(蒸留なし)でモデルを訓練し、同等の性能を達成できるのか、という疑問が残ります。

この問いに答えるため、Qwen-32B-Base を数学、コード、STEM データを用いて 10,000 ステップ以上の大規模 RL 学習を行い、DeepSeek-R1-Zero-Qwen-32B を作成した。 実験結果(図 6)は、大規模 RL 学習後の 32B のベースモデルは、QwQ-32B-Preview と同等の性能を達成していることを示している。QwQ-32B-Previewと同等レベルの性能を達成している。 しかし、DeepSeek-R1 から抽出した DeepSeek-R1-Distill-Qwen-32B は、すべてのベンチマークで DeepSeek-R1-Zero-Qwen-32B を大幅に上回っています。 したがって、以下の 2 つの結論が得られます。一方、本論文で言及した大規模RLに依存する小規模モデルは、膨大な計算能力を必要とし、蒸留性能さえ達成できない可能性がある。 第二に、蒸留戦略は費用対効果が高く効率的であるが、知能の限界を超えるためには、より強力な基礎モデルと大規模な強化学習がまだ必要かもしれない。

4.2 失敗した試み

DeepSeek-R1 の初期の開発段階では、いくつかの失敗や挫折にも遭遇しました。ここで失敗を共有することで、洞察を提供しますが、これはこれらの手法が効果的な推論モデルを開発できないことを意味するものではありません。

プロセス報酬モデリング(PRM) PRMは、推論タスクを解決するためにより良い方法を採用するようモデルを導く、賢明な方法である(Lightman他、2023; Uesato他、2022; Wang他、2023)。しかし実際には、PRMの最終的な成功を妨げる可能性のある3つの主な限界がある。第一に、一般的な推論では細かいステップを明示的に定義することが難しい。第二に、現在の中間ステップが正しいかどうかを判断するのは難しい作業である。モデルを使った自動アノテーションは満足のいく結果をもたらさないかもしれないし、手動アノテーションはスケーリングに向かない。第三に、モデルベースのPRMが導入されると、必然的に報酬のハッキングが発生し(Gao et al.、2022)、報酬モデルの再トレーニングには追加のトレーニングリソースが必要となり、トレーニングプロセス全体が複雑になる可能性がある。まとめると、PRMはモデルによって生成されたトップN応答を並べ替えたり、誘導探索を支援したりする優れた能力を示すが(Snell et al.

モンテカルロ木探索(MCTS) AlphaGo(Silverら、2017b)とAlphaZero(Silverら、2017a)に触発され、テスト時の計算のスケーラビリティを高めるためにモンテカルロ木探索(MCTS)の使用を検討した。このアプローチでは、解答をより小さな部分に分解して、モデルが解空間を系統的に探索できるようにする。これを容易にするために、探索に必要な特定の推論ステップに対応する複数のラベルを生成するようにモデルを促す。トレーニングのために、まず収集されたヒントを用いて、事前にトレーニングされた価値モデルによって導かれるMCTSを通して答えを見つける。その後、生成された質問と答えのペアを使用して、アクターモデルと価値モデルを訓練し、プロセスを反復的に改善します。

しかし、このアプローチでは、トレーニングの規模を拡大する際にいくつかの課題が発生する。まず、探索空間が比較的よく定義されているチェスとは異なり、トークン生成は指数関数的に大きな探索空間を提示する。この問題に対処するため、各ノードに最大拡張限界を設定するが、これはモデルが局所最適に陥る可能性がある。第二に、価値モデルは探索プロセスの各ステップを導くため、生成の質に直接影響する。きめ細かな価値モデルのトレーニングは本質的に困難であり、モデルを反復的に改善することが難しくなる。AlphaGoの中核的な成功は、そのパフォーマンスを段階的に向上させるための価値モデルのトレーニングに依存していますが、マーカー生成が複雑なため、この原理を私たちの設定で再現することは困難です。

結論として、MCTSは事前に訓練された価値モデルと組み合わせることで、推論時のパフォーマンスを向上させることができるが、自己探索時にモデルのパフォーマンスを反復的に向上させることは依然として難しい課題である。

5.結論、限界、今後の課題

DeepSeek-R1-Zeroは、コールドスタートデータに依存しない純粋なRLアプローチであり、様々なタスクで強力な性能を達成しています。最終的に、DeepSeek-R1は様々なタスクでOpenAI-01-1217に匹敵する性能を達成しています。

さらに、推論力を小さな密なモデルに抽出することを検討した。DeepSeek-R1を教師モデルとして使用し、800Kのデータを生成し、いくつかの小さな密なモデルを微調整した。結果は有望で、DeepSeek-R1-Distill-Qwen-1.5BはMaths Benchmarking TestにおいてGPT-40とClaude-3.5-Sonnetを上回り、AIMEスコアは28.91 TP3T、MATHスコアは83.91 TP3Tでした。他の高密度モデルも素晴らしい結果を達成しており、同じ基礎となるチェックポイントに基づく他の命令微調整モデルよりも大幅に優れています。

今後、DeepSeek-R1については、次のような分野での調査を計画している:

- 汎用的な機能: 現在、DeepSeek-R1 は、関数呼び出し、複数ラウンドのダイアログ、複雑なロールプレイング、json 出力などのタスクでは DeepSeek-V3 よりも能力が劣ります。

- 言語の混合: DeepSeek-R1 は現在、中国語と英語に最適化されているため、他の言語のクエリを処理するときに、言語の混合の問題が発生する可能性があります。例えば、DeepSeek-R1 は、クエリが英語または中国語以外の言語であっても、英語で推論および応答することがあります。将来のアップデートでこの制限に対処することを目標としています。

- ヒント工学: DeepSeek-R1の評価中に、DeepSeek-R1はヒントに敏感であることがわかりました。サンプル数が少ないヒントは、一貫してパフォーマンスを低下させます。したがって、最良の結果を得るには、ユーザが問題を直接記述し、ゼロサンプル設定を使用して出力形式を指定することをお勧めします。

- ソフトウェア工学タスク: 大規模 RL は、評価時間が長く、RL プロセスの効率に影響するため、ソフトウェア工学タスクに広く適 用されていません。その結果、DeepSeek-R1 のソフトウェア工学ベンチマークでの性能は、DeepSeek-V3 から大きく向上していません。今後のリリースでは、ソフトウェア・エンジニアリング・データに対する拒絶サンプリングの実装や、RL プロセスにおける非同期評価のマージによってこの問題に対処し、効率を向上させる予定です。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません