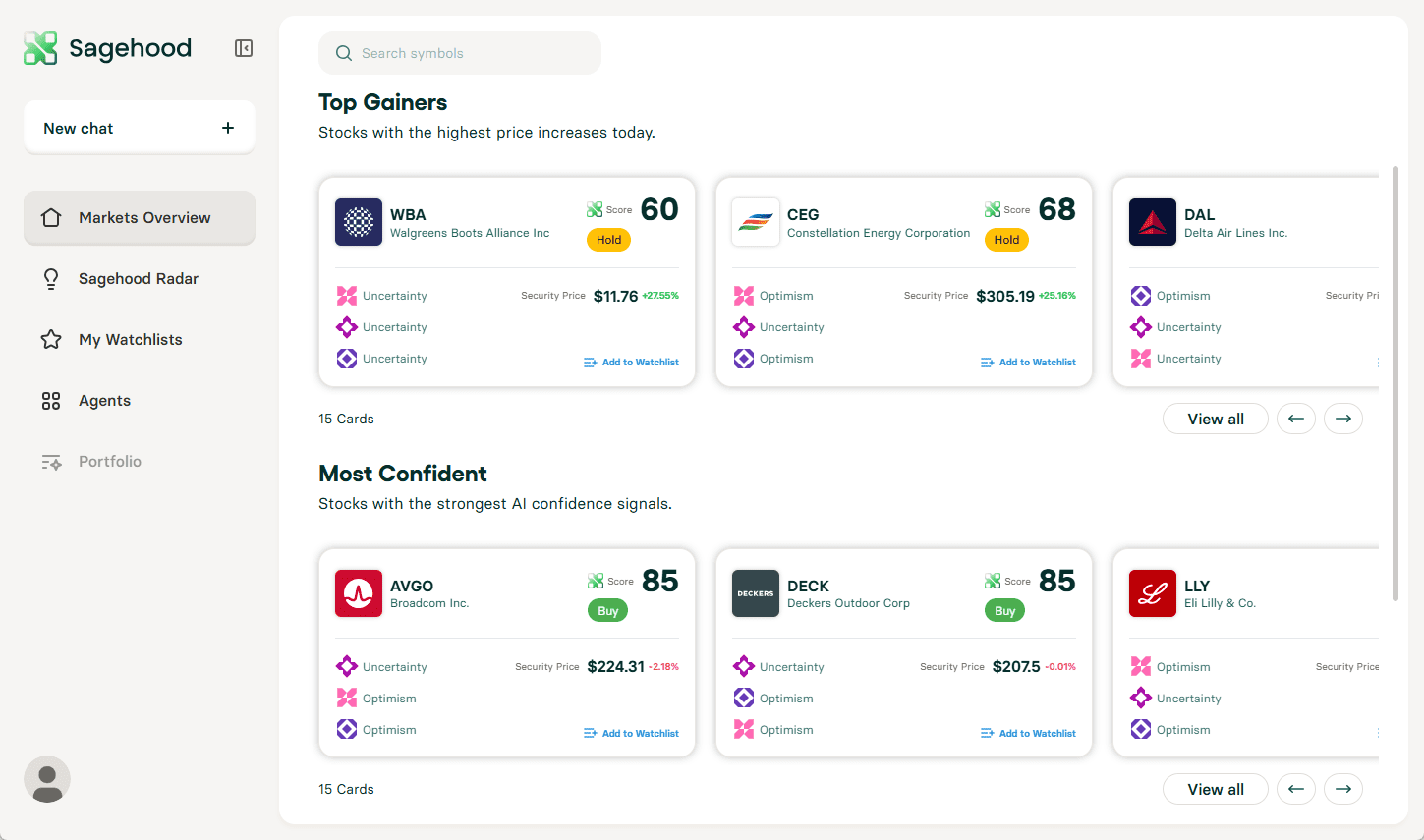

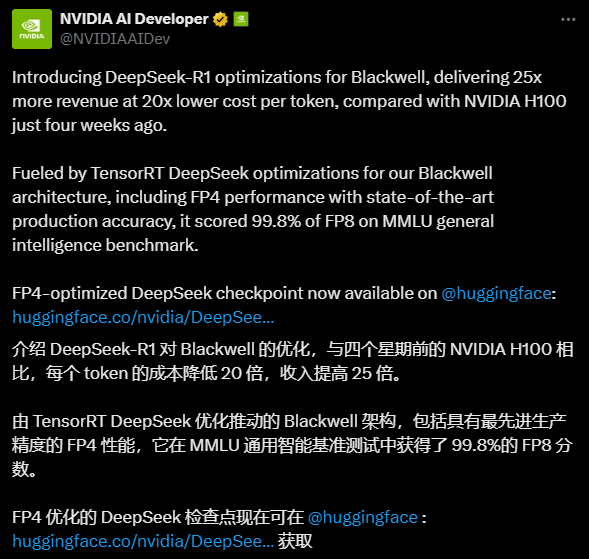

DeepSeek-R1-FP4:DeepSeek-R1の推論を25倍高速化したFP4最適化バージョン

はじめに

DeepSeek-R1-FP4は、NVIDIAによってオープンソース化され、最適化された言語モデルです。 ディープシーク AIの ディープシーク-R1 開発TensorRT Model Optimizerを使用して重みと活性化値をFP4データ型に定量化し、高性能を維持しながらリソース要件を大幅に削減します。オリジナルのモデルと比較して、ディスク容量とGPUメモリが約1.6倍削減され、本番環境での効率的な推論に最適です。NVIDIAのBlackwellアーキテクチャー向けに最適化されたこのモデルは、1回あたりの推論速度が最大25倍高速化されるとしている。 トークン 20倍安価で、強力なパフォーマンスの可能性を示している。最大128Kのコンテキスト長をサポートするため、複雑なテキストタスクの処理に適しており、商用・非商用に関わらずオープンであるため、開発者に費用対効果の高いAIソリューションを提供する。

機能一覧

- 効率的な推論FP4量子化を用いて推論速度を劇的に向上させ、リソース使用量を最適化。

- ロング・コンテクスト・サポートこれは長いテキスト生成タスクの処理に適している。

- TensorRT-LLMの展開TensorRT-LLMフレームワークを使用して、NVIDIA GPU上で実行するために迅速にデプロイすることができます。

- オープンソース利用:: 商用・非商用のシナリオをサポートし、自由な改変と派生開発を可能にします。

- パフォーマンス最適化Blackwellアーキテクチャのために設計され、非常に高い推論効率と費用対効果を提供します。

ヘルプの使用

インストールと展開プロセス

DeepSeek-R1-FP4の導入には、特定のハードウェアとソフトウェア環境のサポート、特にNVIDIA GPUとTensorRT-LLMフレームワークが必要です。以下は、ユーザがすぐに使い始められるように、詳細なインストールと使用法のガイドです。

1.環境準備

- ハードウェア要件NVIDIAブラックウェル・アーキテクチャGPU(B200など)を推奨し、少なくとも8つのGPUが必要です(各GPUのVRAMは未量子化で~336GB、モデル要件を満たすための量子化後は~1342GB)。小規模なテストでは、少なくとも1つの高性能GPU(A100/H100など)を推奨します。

- ソフトウェア依存:

- オペレーティングシステム:Linux(例:Ubuntu 20.04以降)。

- NVIDIAドライバ:最新バージョン(CUDA 12.4以上をサポート)。

- TensorRT-LLM: 最新のmasterブランチバージョンは、GitHubソースからコンパイルする必要があります。

- Python: 3.11以降。

- その他の図書館

tensorrt_llmそしてtorchその他

2.ダウンロードモデル

- インタビュー ハグする顔 ページファイルとバージョン」タブをクリックします。

- モデルファイルをダウンロードする(例

model-00001-of-00080.safetensors(など、合計80スライス、合計サイズは400GB以上)。 - ファイルをローカル・ディレクトリに保存する。

/path/to/model/.

3.TensorRT-LLMのインストール

- 最新のTensorRT-LLMリポジトリをGitHubからクローンする:

git clone https://github.com/NVIDIA/TensorRT-LLM.git cd TensorRT-LLM

- コンパイルしてインストールする:

make build pip install -r requirements.txt - インストールを確認する:

python -c "import tensorrt_llm; print(tensorrt_llm.__version__)"

4.展開モデル

- 提供されているサンプルコードを使用してモデルをロードし、実行します:

from tensorrt_llm import SamplingParams, LLM # 初始化模型 llm = LLM( model="/path/to/model/nvidia/DeepSeek-R1-FP4", tensor_parallel_size=8, # 根据 GPU 数量调整 enable_attention_dp=True ) # 设置采样参数 sampling_params = SamplingParams(max_tokens=32) # 输入提示 prompts = [ "你好,我的名字是", "美国总统是", "法国的首都是", "AI的未来是" ] # 生成输出 outputs = llm.generate(prompts, sampling_params) for output in outputs: print(output) - 上記のコードを実行する前に、GPUリソースが正しく割り当てられていることを確認してください。リソースが不足している場合は

tensor_parallel_sizeパラメーター

5.機能操作ガイド

効率的な推論

- DeepSeek-R1-FP4の核となる強みは、FP4量子化技術です。手動でモデルパラメータを調整する代わりに、ユーザはハードウェアがBlackwellアーキテクチャをサポートしていることを確認するだけで、推論速度が向上します。実行時に

max_tokensパラメータは、リソースの浪費を避けるために出力長を制御する。 - 例:ターミナルでPythonスクリプトを実行し、さまざまなプロンプトを入力し、出力の速度と質を観察する。

ロングコンテクスト処理

- このモデルは最大128Kまでのコンテキストの長さをサポートしており、長い記事の生成や複雑なダイアログの処理に適している。

- 作戦:「"on's "作戦」。

prompts5,000語の記事の冒頭など、長い文脈を入力し、次にmax_tokens=1000テキストは以下のテキストと同じように生成される。実行後、生成されたテキストの一貫性を確認してください。 - 注意:長いコンテキストはメモリ使用量を増加させる可能性があるため、GPUメモリ使用量を監視することをお勧めします。

パフォーマンス最適化

- Blackwell GPUを使用する場合、推論において25倍のスピードアップの恩恵を直接受けることができます。他のアーキテクチャー(例えばA100)を使用した場合、性能向上は若干低くなる可能性がありますが、それでも未量子化モデルよりはかなり優れています。

- 操作の提案:マルチGPU環境では、以下のように調整してください。

tensor_parallel_sizeハードウェアリソースをフルに活用するためのパラメータです。例えば、8 GPUは8、4 GPUは4に設定されます。

6.よくある質問と解決策

- ビデオメモリ不足メモリーのオーバーフローを指摘された場合は、以下のようにしてください。

tensor_parallel_sizeまたは、定量化されていないバージョン(コミュニティが提供するGGUFフォーマットなど)を使用する。 - 遅い推論TensorRT-LLMが正しくコンパイルされ、GPUアクセラレーションが有効になっていることを確認してください。

- 出力異常入力プロンプトのフォーマットをチェックし、特殊文字がモデルの邪魔にならないことを確認する。

使用上の推奨事項

- 初期使用簡単なヒントから始め、徐々に文脈の長さを長くして、モデルのパフォーマンスに慣れてください。

- 生産環境配備前に複数のプロンプトをテストし、出力が期待に沿うことを確認する。ロードバランシングツールを使用してマルチユーザーアクセスを最適化することをお勧めします。

- 開発者のカスタマイズ:: モデルは、コード生成やQ&Aシステムのような特定のタスクに対応するために、オープンソースライセンスに基づいて変更することができます。

これらの手順により、ユーザーはDeepSeek-R1-FP4を迅速に導入して使用し、効率的な推論の利便性を享受することができます。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません