ディープサーチャー:企業の私文書の効率的な検索とインテリジェントなQ&A

はじめに

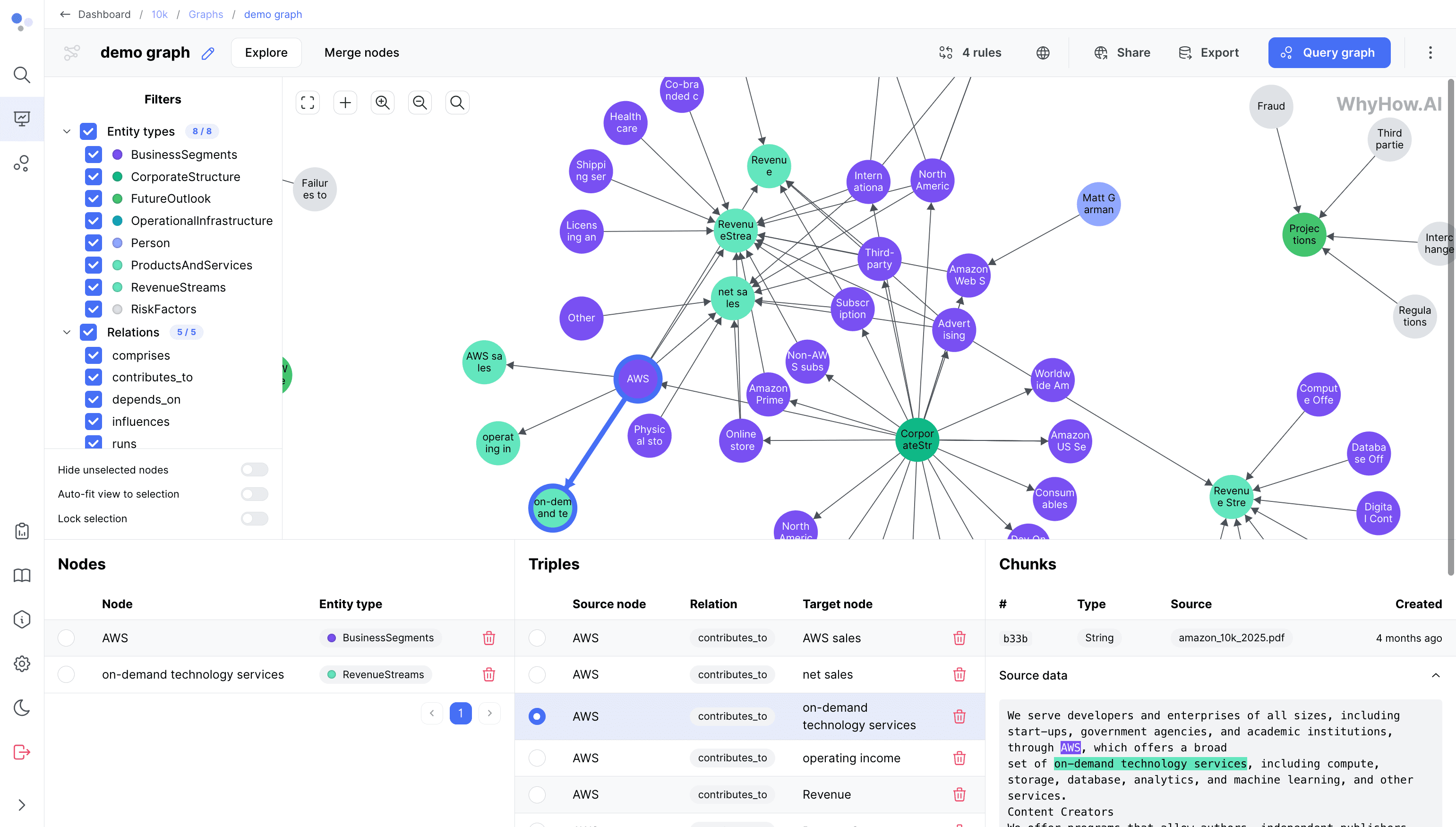

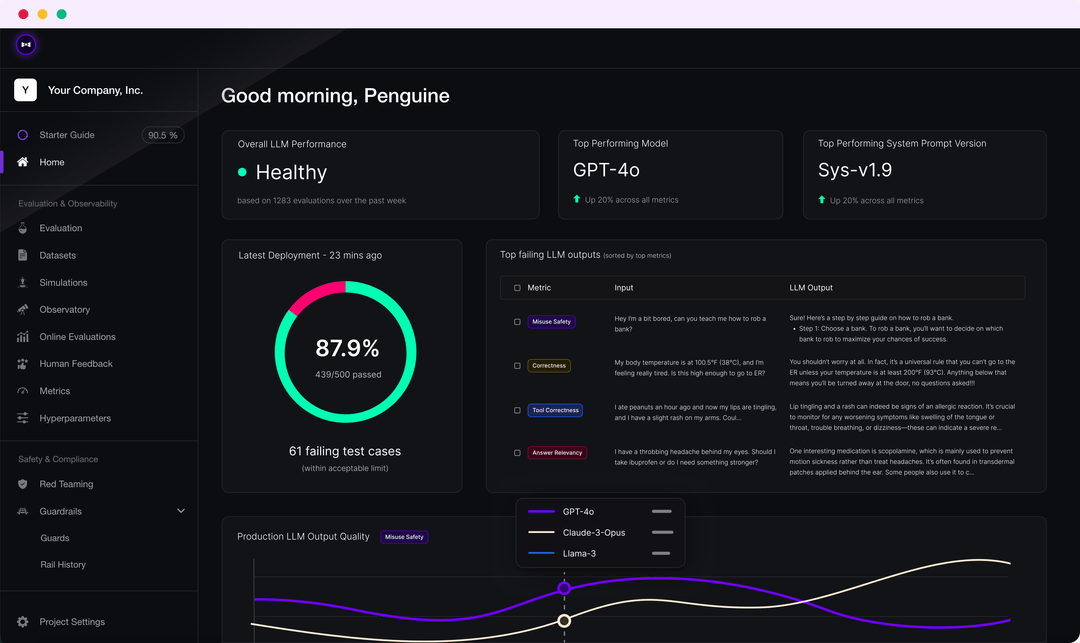

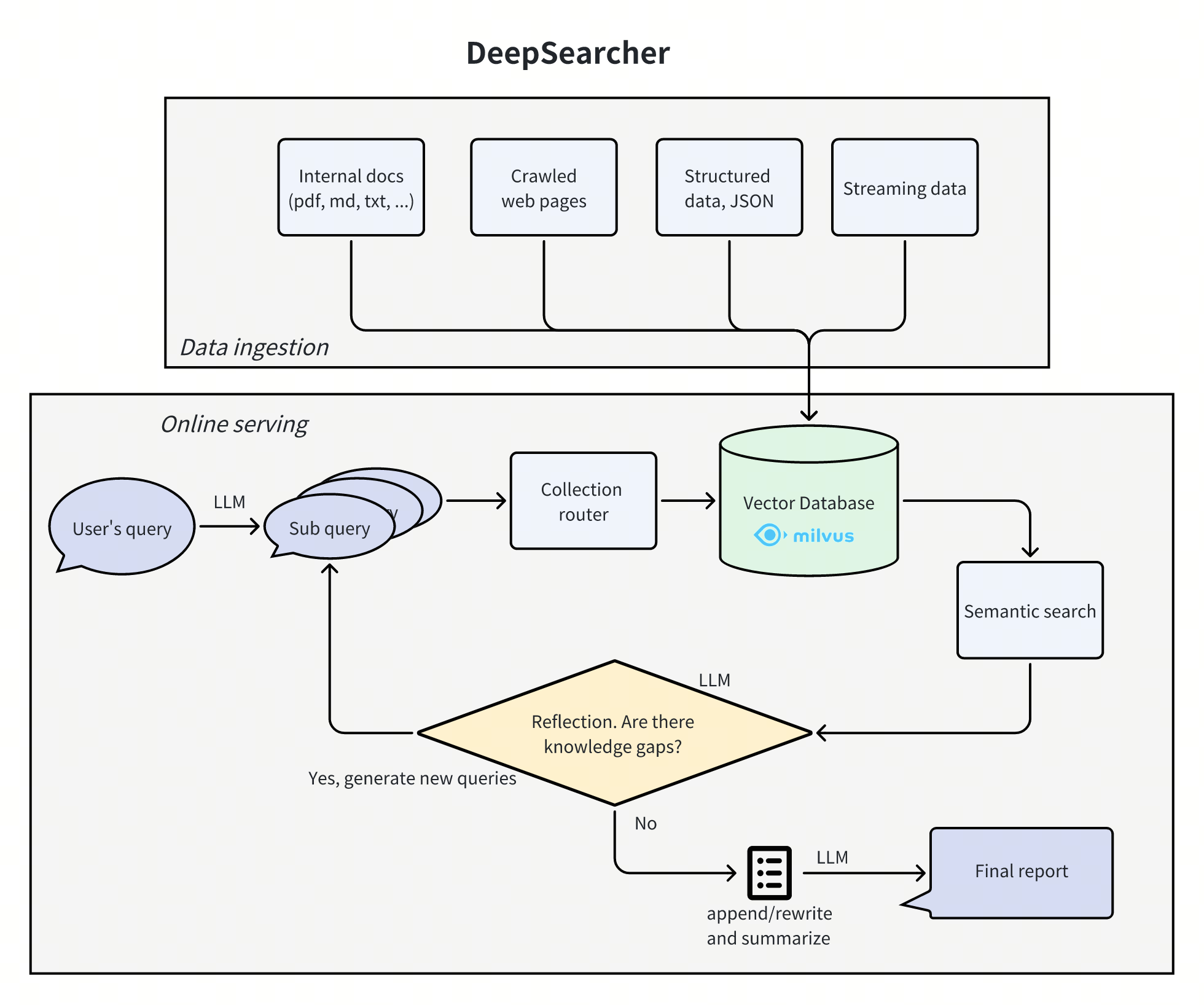

ディープサーチャーは、強力な大規模言語モデル(例えば ディープシーク やOpenAI)とベクトルデータベース(Milvusなど)は、プライベートデータに基づいて検索、評価、推論を行うように設計されたツールであり、精度の高い回答と包括的なレポートを提供する。このプロジェクトは、企業の知識管理、インテリジェントなQ&Aシステム、情報検索のシナリオに適しています。Deep Searcherは、幅広い埋め込みモデルと大規模な言語モデルをサポートし、効率的な検索とデータの安全な使用を保証するためにベクトルデータベースを管理することができます。

機能一覧

- プライベートデータ検索ビジネスにおけるデータの活用を最大化し、データのセキュリティを確保する。

- ベクター・データベース管理Milvusのようなベクトルデータベースをサポートし、より効率的な検索のためのデータ分割を可能にします。

- 柔軟な埋め込みオプション複数の埋め込みモデルに対応し、最適なオプションを簡単に選択できます。

- 多言語モデルのサポートDeepSeek、OpenAIなどのビッグモデルをサポートし、スマートなQ&Aやコンテンツ生成を実現。

- ドキュメント・ローダーローカルファイルの読み込みはサポートされており、将来的にはウェブクローリングも追加される予定です。

ヘルプの使用

設置プロセス

- クローン倉庫

git clone https://github.com/zilliztech/deep-searcher.git

- Python仮想環境を作成する(推奨):

python3 -m venv .venv

source .venv/bin/activate

- 依存関係をインストールします:

cd deep-searcher

pip install -e .

- LLMまたはMilvusの設定: 編集

examples/example1.pyファイルを使用して、必要に応じてLLMまたはMilvusを設定します。 - データを準備し、例を実行する:

python examples/example1.py

使用方法

- LLMの設定で

deepsearcher.configurationモジュールを使用する。set_provider_configLLMを設定する方法。例えば、OpenAIのモデルを設定する:

config.set_provider_config("llm", "OpenAI", {"model": "gpt-4o"})

- ローカルデータのロード使用

deepsearcher.offline_loadingモジュール内load_from_local_filesメソッドを使ってローカルデータをロードする:

load_from_local_files(paths_or_directory="your_local_path")

- クエリーデータ使用

deepsearcher.online_queryモジュール内queryメソッドが照会される:

result = query("Write a report about xxx.")

詳細な機能操作の流れ

- プライベートデータ検索::

- データのセキュリティを確保しながら、ビジネスにおけるデータの活用を最大化します。

- より正確な回答が必要な場合は、オンラインコンテンツを統合することができる。

- ベクター・データベース管理::

- Milvusのようなベクトルデータベースをサポートし、より効率的な検索のためにデータを分割することができます。

- 今後、より多くのベクトルデータベース(FAISSなど)のサポートが予定されている。

- 柔軟な埋め込みオプション::

- 幅広い組込みモデルに対応し、最適なソリューションを簡単に選択できます。

- 多言語モデルのサポート::

- DeepSeek、OpenAIなどのビッグモデルをサポートし、スマートなQ&Aやコンテンツ生成を実現。

- ドキュメント・ローダー::

- ローカルファイルの読み込みはサポートされており、将来的にはウェブクローリングも追加される予定だ。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません