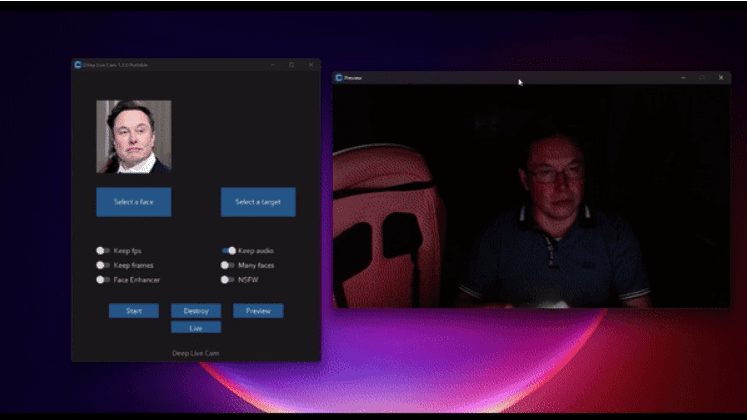

ディープライブカム:オープンソースのリアルタイムAI顔交換ツール、リアルタイムでライブ顔交換するための写真

はじめに

Deep Live CamはオープンソースのAIツールで、1枚の写真からリアルタイムで顔を置き換え、深いフェイクビデオを生成できるように設計されている。高度なディープラーニングアルゴリズムを使用することで、生放送やビデオ通話中にリアルタイムで顔を入れ替えることができ、ユーザーのプライバシーを保護し、興味を持たせることができます。Deep Live Camは、CPU、NVIDIA CUDA、Apple Siliconなど複数のプラットフォームをサポートしており、エンターテインメント、教育、アート制作、広告など幅広い分野に適しています。

機能一覧

- リアルタイムの顔置き換え:1枚の写真を通して、ビデオ内の顔をリアルタイムで置き換える。

- マルチプラットフォーム対応:主要なオペレーティングシステムおよびハードウェアプラットフォームと互換性があります。

- GPUアクセラレーション:処理速度を向上させるNVIDIA CUDAアクセラレーションをサポート。

- コンテンツ監査メカニズム:技術が不適切なシナリオで使用されるのを防ぐための不正使用防止メカニズムが組み込まれています。

- オープンソース・コード:プロジェクトのコードはGitHubにホストされており、ユーザーが自由にダウンロードして変更することができます。

ヘルプの使用

設置プロセス

- 環境準備::

- Python 3.10以降がインストールされていることを確認してください。

- pip、git、ffmpeg、その他の開発ツールをインストールする。

- Windowsユーザーの場合は、Visual Studio 2022ランタイムもインストールする必要があります。

- クローンと設定::

- Deep-Live-CamのGitHubリポジトリをローカル環境にクローンする:

git clone https://github.com/hacksider/Deep-Live-Cam.git - 必要なモデルファイルをダウンロードし、ドキュメントのガイドラインに従って指定されたディレクトリに配置します:

- GFPGANv1.4

- inswapper_128_fp16.onnx

- Deep-Live-CamのGitHubリポジトリをローカル環境にクローンする:

- 依存するインストール::

- プロジェクトに必要な依存ライブラリをインストールするには、pipを使用します。 潜在的な依存関係の衝突を避けるために、仮想環境を使用することをお勧めします:

pip install -r requirements.txt

- プロジェクトに必要な依存ライブラリをインストールするには、pipを使用します。 潜在的な依存関係の衝突を避けるために、仮想環境を使用することをお勧めします:

- ランニングプログラム::

- コマンドラインからDeep-Live-Camを起動します:

python run.py - ソース映像とターゲット映像を選択し、リアルタイムのフェイススワップ効果を観察する。

- コマンドラインからDeep-Live-Camを起動します:

- GPUアクセラレーション::

- NVIDIA GPUをお持ちの方は、CUDAツールキットをインストールし、適切な環境変数を設定することで、フェイススワップ処理を高速化することができます:

pip uninstall onnxruntime onnxruntime-gpu pip install onnxruntime-gpu==1.16.3 python run.py --execution-provider cuda

- NVIDIA GPUをお持ちの方は、CUDAツールキットをインストールし、適切な環境変数を設定することで、フェイススワップ処理を高速化することができます:

使用プロセス

- ソース画像とターゲットビデオを選択::

- プログラム開始後、目的の顔を含む画像とターゲット画像またはビデオを選択します。

- 加工開始::

- Start "ボタンをクリックすると、プログラムが処理を開始し、リアルタイムで顔が変化するエフェクトが表示されます。

- 出力を見る::

- 処理が完了したら、ファイルエクスプローラーを開き、選択した出力ディレクトリに移動して、生成されたフェイススワップ動画を表示します。

- カメラモード::

- 顔を選択し、「ライブ」ボタンをクリックし、プレビューが表示されるまで数秒待つ。

- OBSなどの画面録画ツールを使ったストリーミング。

ほら

- 初めてプログラムを実行する場合、インターネット接続の速度にもよりますが、約300MBのモデルファイルをダウンロードする必要があります。

- 顔を変更したい場合は、別の写真を選択するだけで、プレビューモードが再開されます。

資源

https://github.com/hacksider/Deep-Live-Cam

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません