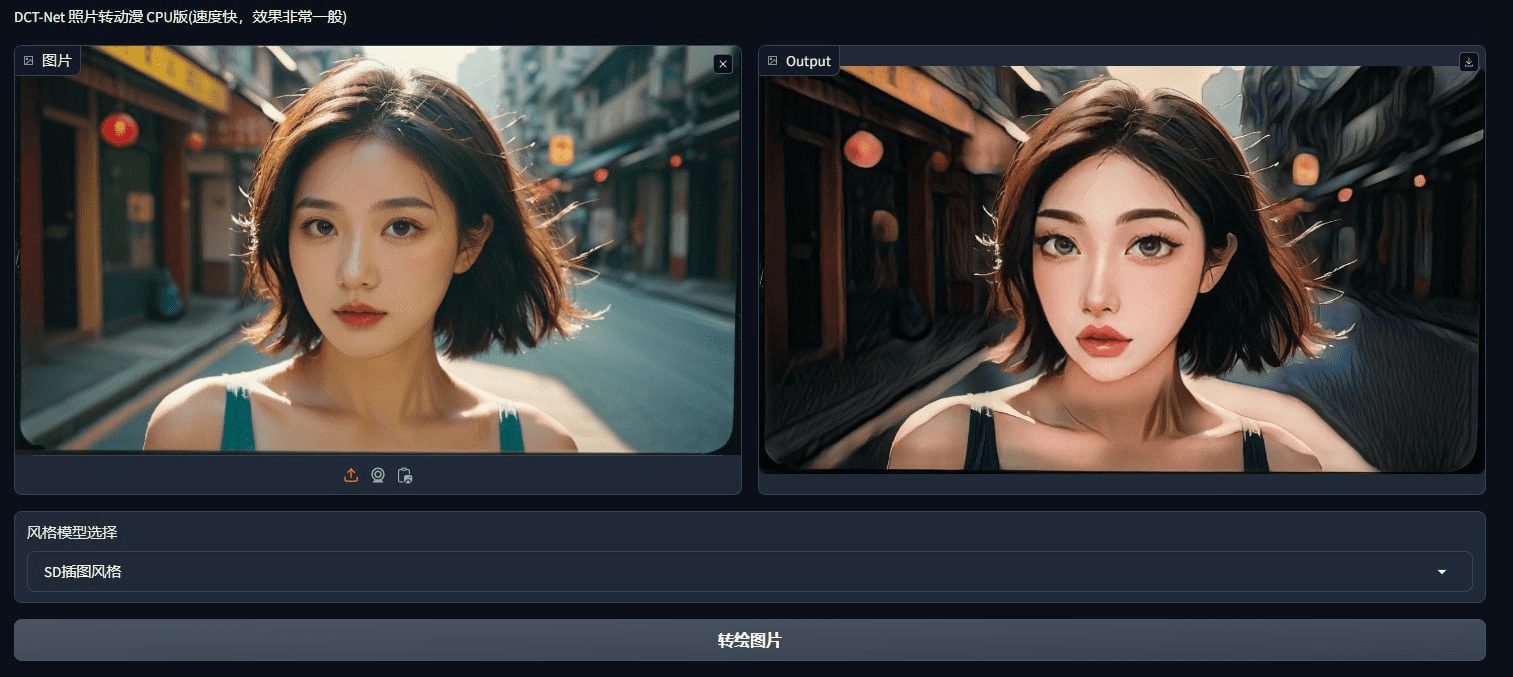

DCT-Net:写真やビデオをスタイリッシュなアニメに変換するオープンソースツール

はじめに

DCT-Netは、DAMOアカデミーと北京大学王宣コンピューター技術研究所によって開発されたオープンソースプロジェクトであり、アニメーションのための画像の様式化された変換を実現することを目的としている。DCT-Netは様々な事前学習モデルを提供し、カスタマイズされたスタイルデータの学習をサポートします。映画やゲーム業界にも適しています。

機能一覧

- 幅広い芸術スタイルをカバーする幅広い事前学習済みモデルを提供

- カスタム・スタイル・データによるトレーニングをサポート

- オンライントライアル、ローカル環境設定不要

- CPUとGPUの両方の環境をサポートする効率的なパフォーマンス

- 画像と動画のスタイル変換

ヘルプの使用

インストールと設定

- 依存関係のインストールまず

modelscopeライブラリーは以下のコマンドでインストールできる:pip install "modelscope[cv]" -f https://modelscope.oss-cn-beijing.aliyuncs.com/releases/repo.html - 訓練済みモデルのダウンロードコードの最初の実行時に、モデルは自動的に事前学習ファイルをダウンロードします。

イメージスタイル変換

- モデルの定義DCT-Netモデルで変換する顔のスタイルを5種類定義する:

model_dict = { "anime": "damo/cv_unet_person-image-cartoon_compound-models", "3d": "damo/cv_unet_person-image-cartoon-3d_compound-models", "handdrawn": "damo/cv_unet_person-image-cartoon-handdrawn_compound-models", "sketch": "damo/cv_unet_person-image-cartoon-sketch_compound-models", "art": "damo/cv_unet_person-image-cartoon-artstyle_compound-models" } - 画像を読み込んで変換する::

import os import cv2 from IPython.display import Image, display, clear_output from modelscope.pipelines import pipeline from modelscope.utils.constant import Tasks from modelscope.outputs import OutputKeys style = "anime" # 可选 "anime", "3d", "handdrawn", "sketch", "art" filename = "4.jpg" img_path = 'picture/' + filename img_anime = pipeline(Tasks.image_portrait_stylization, model=model_dict["anime"]) result = img_anime(img_path) save_name = 'picture/images/' + os.path.splitext(filename)[0] + '_' + style + '.jpg' cv2.imwrite(save_name, result[OutputKeys.OUTPUT_IMG]) clear_output() display(Image(save_name))

ビデオスタイル変換

- ビデオフレームの抽出::

video = 'sample_video.mp4' video_file = 'movie/' + video image_dir = 'movie/images/' vc = cv2.VideoCapture(video_file) i = 0 if vc.isOpened(): rval, frame = vc.read() while rval: cv2.imwrite(image_dir + str(i) + '.jpg', frame) i += 1 rval, frame = vc.read() vc.release() - ビデオフレームの変換画像変換と同じ方法で各フレームにスタイルを設定し、変換されたフレームをビデオに統合します。

ワンクリックインストーラーダウンロード

Lite(CPU版、マンガスタイルのみ継承)

https://drive.uc.cn/s/eab2a6fad2dd4 パスワード:XTQi

フルバージョン

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません