好奇心:LangGraphを使ったパープレクシティのようなAI検索ツールの構築

はじめに

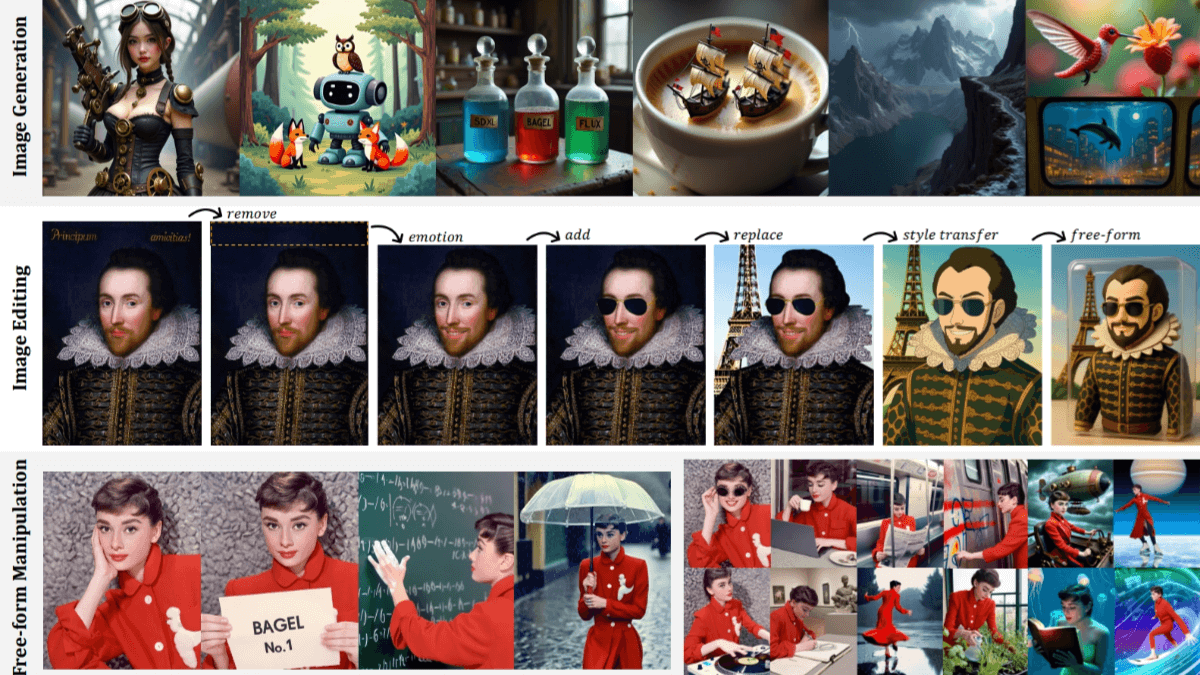

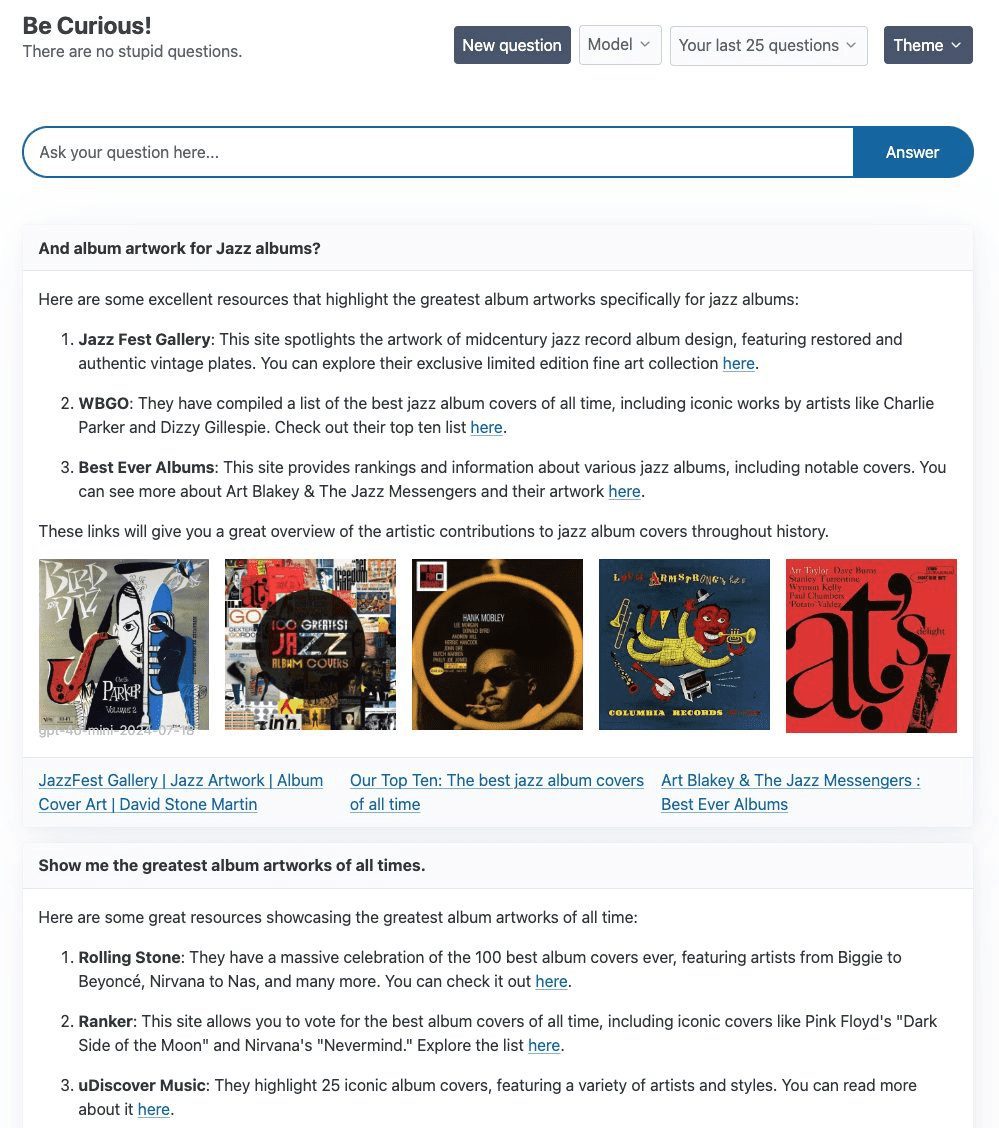

キュリオシティは、主に次のようなものを使って探索と実験を行うことを目的としたプロジェクトである。 ラングラフ とFastHTMLの技術スタックを構築することを目標としています。 複雑さAI 検索製品のプロジェクトの中心は、シンプルな リ・アクト エージェントは タヴィリー キュリオシティは、OpenAIのgpt-4o-mini、Groqのllama3-groq-8b-8192-tool-use-previewを含む、さまざまな大規模言語モデル(LLM)をサポートしている。 オーラマ このプロジェクトでは、技術的な実装だけでなく、高品質のビジュアルとインタラクティブな体験を保証するために、フロントエンドのデザインにも多くの時間を費やしている。

機能一覧

- LangGraphとFastHTMLテクノロジースタックを使う

- 統合されたTavily検索 強化されたテキスト生成

- gpt-4o-mini、llama3-groq、llama3.1を含む複数のLLMをサポート。

- 柔軟なバックエンド・スイッチング機能を提供

- フロントエンドはFastHTMLで構築され、WebSocketsストリーミングをサポートしています。

ヘルプの使用

インストール手順

- クローン倉庫

git clone https://github.com/jank/curiosity - 最新の Python3 インタプリタがあることを確認してください。

- 仮想環境をセットアップし、依存関係をインストールする:

python3 -m venv venv source venv/bin/activate pip install -r requirements.txt - 確立

.envファイルを作成し、以下の変数を設定する:OPENAI_API_KEY=<your_openai_api_key> GROQ_API_KEY=<your_groq_api_key> TAVILY_API_KEY=<your_tavily_api_key> LANGCHAIN_TRACING_V2=true LANGCHAIN_ENDPOINT="https://api.smith.langchain.com" LANGSMITH_API_KEY=<your_langsmith_api_key> LANGCHAIN_PROJECT="Curiosity" - プロジェクトを実行する:

python curiosity.py

使用ガイドライン

- プロジェクトの開始走る

python curiosity.pyその後、プロジェクトはローカル・サーバー上で起動し、実行される。 - LLMを選択LLM (例: gpt-4o-mini, llama3-groq, llama3.1)を選択します。

- Tavilyで検索ダイアログにクエリを入力すると、ReActエージェントがTavily検索でテキスト生成を強化します。

- フロントエンド・インタラクションこのプロジェクトのフロントエンドはFastHTMLで構築され、WebSocketストリーミングをサポートし、リアルタイムのレスポンスを保証します。

一般的な問題

- LLMの切り替え方法で

.envファイルで適切なAPIキーを設定し、プロジェクト開始時に希望のLLMを選択してください。 - ウェブソケットの問題WebSocketが理由なく終了する問題が発生した場合は、ネットワーク接続とサーバー構成を確認することをお勧めします。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません