COTと関連する高度なキュー・バリエーション キュー・ワードの説明

免責事項: 基本的なヒンティング技術(例: ゼロ/少数のサンプル例や命令的ヒント)は非常に効率的であるが、複雑なパズル(例: 数学/プログラミングや多段階の論理的推論を必要とする問題)に直面した場合、より洗練されたヒントがより効果的である可能性がある。大規模言語モデル(LLM)は当然このような問題に対処するのが困難であるため(推論力はモデルサイズに比例して単調に増加するわけではない)、プロンプトの設計に関する研究のほとんどは、推論力と複雑な問題を解く能力をいかに向上させるかに焦点を当てている。他のほとんどの問題については、単純な手がかりで十分である。

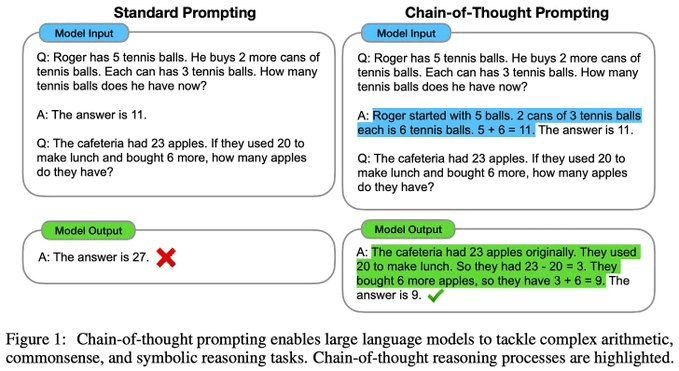

思考の連鎖(CoT)ヒント[1]は、モデルのヒントに中間推論ステップの連鎖を追加することで、LLMの推論能力を活性化する。各例に対して思考の連鎖を追加することで、モデルは(文脈学習を通じて)答えを与える前に、同様の思考の連鎖を自動的に生成することを学習する。1]の研究は、問題を解くための推論プロセスを明示的に説明することが、モデルの推論能力を向上させる上で実際に効果的であることを示している。

インプット:

このセットの奇数を足すと偶数になる:4、8、9、15、12、2、1。

A: すべての奇数(9, 15, 1)を足すと25になる。このセットの奇数を足すと偶数になる:17、10、19、4、8、12、24。

A: 奇数(17, 19)をすべて足すと36になる。このセットの奇数を足すと偶数になる:16、11、14、4、8、13、24。

A: すべての奇数(11、13)を足すと24になる。このセットの奇数を足すと偶数になる:17、9、10、12、13、4、2。

A: すべての奇数(17、9、13)を足すと39になる。このセットの奇数を足すと偶数になる:15、32、5、13、82、7、1。

A:出力:

すべての奇数(15、5、13、7、1)を足すと41になる。

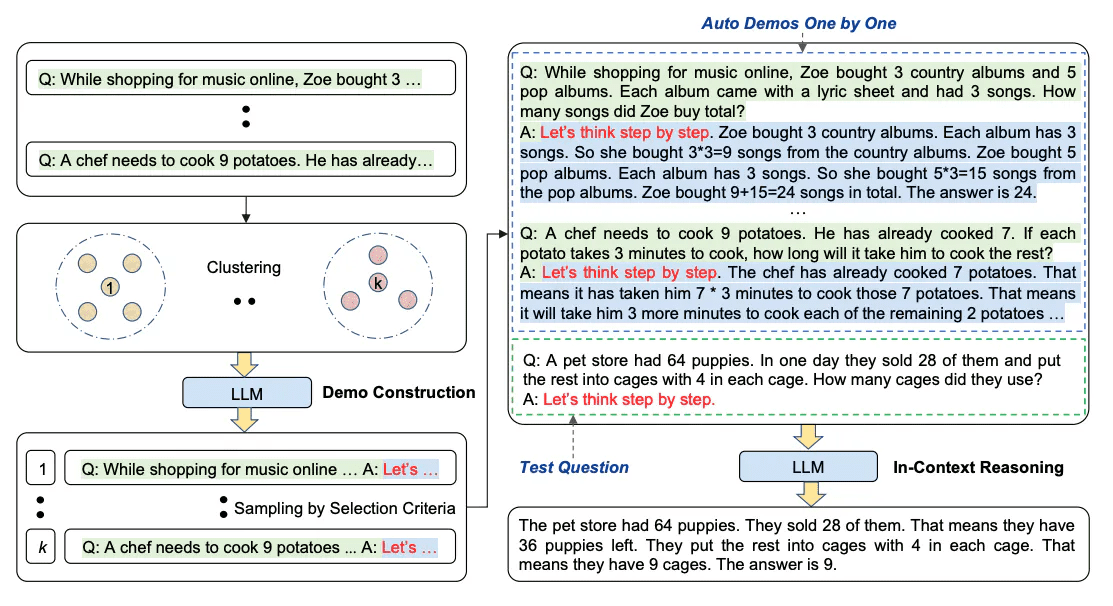

自動思考連鎖(オートCoT)[思考連鎖プロンプトを使用する場合、効果的で多様な例を手作業で作成する必要がある。この手作業は、最適な解決策を生み出さない可能性がある。[8]は、LLMの「ステップバイステップで考えよう」プロンプトを使用して推論の連鎖を次々に生成することで、手作業をなくす方法を提案している。この自動化されたプロセスでも、生成された連鎖にエラーが発生する可能性がある。エラーの影響を軽減するためには、プレゼンテーションの多様性が重要である。本研究では、多様性のある問題をサンプリングし、推論の連鎖を生成してデモンストレーションを構築するAuto-CoTを提案する。

Auto-CoTは主に2つのフェーズで構成されている:

ステージ1:問題のクラスタリング:与えられた問題をいくつかのクラスタに分ける

第2段階:デモサンプリング:各配列から代表的な問題を選択し、単純なヒューリスティックでZero-Shot-CoTを用いて推論連鎖を生成する。

単純なヒューリスティックは、問題の長さ(例えば60トークン)や推論のステップ数(例えば5推論ステップ)である。これにより、モデルはシンプルで正確なプレゼンテーションを使用するようになる。

そのプロセスを以下に示す:

CoTバリアントCoTプロンプトの有効性とその人気を考慮し、複数の派生技法が提案されている:

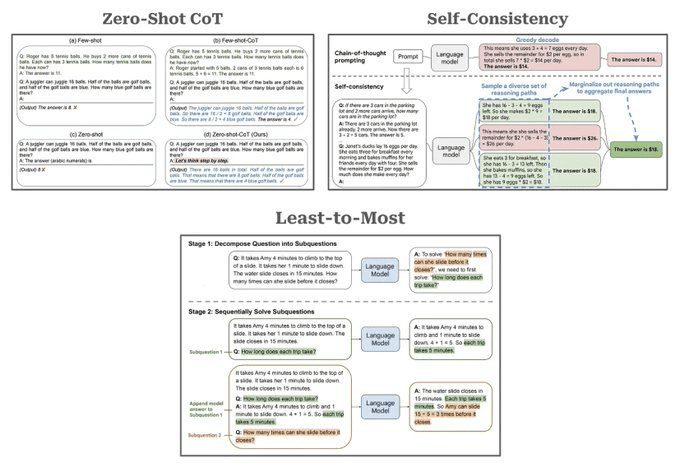

- 例題ゼロ CoT [2]: いくつかの例題を削除し、プロンプトの最後に "Let's think step by step. "を追加することで、問題を解くための論理的な推論を生成するようにモデルを動機付ける。を追加することで、問題を解くための論理的な推論を生成する動機付けを行います。

インプット:

市場に行ってリンゴを10個買った。近所の人に2個、修理工に2個あげた。それからリンゴを5個買って、1個食べました。リンゴは何個残りましたか?

一歩ずつ考えていこう。

出力:

まず、10個のリンゴから始める。

あなたは隣人と修理工に2個ずつリンゴをあげたので、リンゴは6個残っている。

リンゴを5個買うと、11個になる。

結局、リンゴを1個食べたので、リンゴは10個残っている。

- 自己一貫性(SC) [3]: 独立に複数の解決策を生成し、最終的な答えに多数決で投票することで、推論プロセスの頑健性を高める。

インプット:

質問:森には15本の木があります。林業労働者は今日、森に木を植える。植え終わると21本になる。林業従事者は今日何本の木を植えたか。

A:最初は15本だった。その後、21本になりました。この差は、彼らが植えた木の本数に違いない。したがって、21-15=6本の木を植えたことになる。答えは6。

Q:駐車場には3台の車がありましたが、さらに2台来ました。

A:駐車場にはすでに3台の車があります。もう2台入ってきた。現在3+2=5台です。答えは5です。

問:リアは32個、妹は42個のチョコレートを持っている。二人が35個食べたとすると、全部で何個残りますか。

A: リアは32個、リアの姉は42個のチョコレートを持っている。つまり、最初は32個+42個=74個のチョコレートがあった。35個はすでに食べられた。したがって、74個-35個=39個のチョコレートが残っている。答えは39個。

Q: ジェイソンはロリポップを20個持っている。ジェイソンはデニーにロリポップをあげた。ジェイソンはデニーに何個のロリポップをあげましたか。

A: ジェイソンはロリポップを20個持っている。今持っているロリポップは12個なので、残りをデニーにあげなければならない。答えは8である。

質問:ショーンは5つのおもちゃを持っています。クリスマスに両親から2つのおもちゃをもらいました。彼は今何個のおもちゃを持っていますか?

A: 彼は5つのおもちゃを持っています。お母さんから2個もらったので、5+2=7個。次にお父さんから2個もらったので、合計で7+2=9個のおもちゃを持っている。答えは9です。

Q: サーバールームには9台のコンピューターがあります。月曜日から木曜日まで、毎日5台のコンピュータが設置されています。現在サーバー室には何台のコンピュータがありますか?

A:月曜日から木曜日まで4日間あった。毎日5台のコンピュータが追加されました。つまり、合計で4 * 5 =

20台のコンピューター。最初のコンピュータは9台だったので、現在は9+20=29台。答えは29である。

Q: マイケルは58個のゴルフボールを持っている。火曜日に23個のゴルフボールを失いました。水曜日、彼はさらに2個のゴルフボールを失いました。水曜日の終わりには何個のゴルフボールが残っていましたか?

A: マイケルは当初58球だった。火曜日に彼は23球を失い、58-23=35球となった。水曜日、彼はさらに2個のボールを失い、現在35-2=33個のボールを持っている。答えは33球。

問:オリビアは23ドルを持っている。ベーグルを1個3ドルで5個買いました。彼女の残りのお金はいくらですか。

A:彼女は1個3ドルのベーグルを5個買った。つまり15ドル使ったことになる。残りは8ドルです。

Q: 私が6歳のとき、姉は私の年齢の半分でした。今、私は70歳ですが、姉は何歳ですか?

A:出力1:

私が6歳のとき、妹は私の年齢の半分、つまり3歳だった。現在、私は70歳なので、妹は70-3=67歳。答えは67。

出力2:

語り手が6歳のとき、妹は彼の年齢の半分、つまり3歳だった。語り手が70歳の今、妹は70-3=67となる。答えは67。

出力3:

私が6歳のとき、妹は私の半分の3歳だった。今、僕は70歳だから、妹は70/2=35だ。答えは35だ。

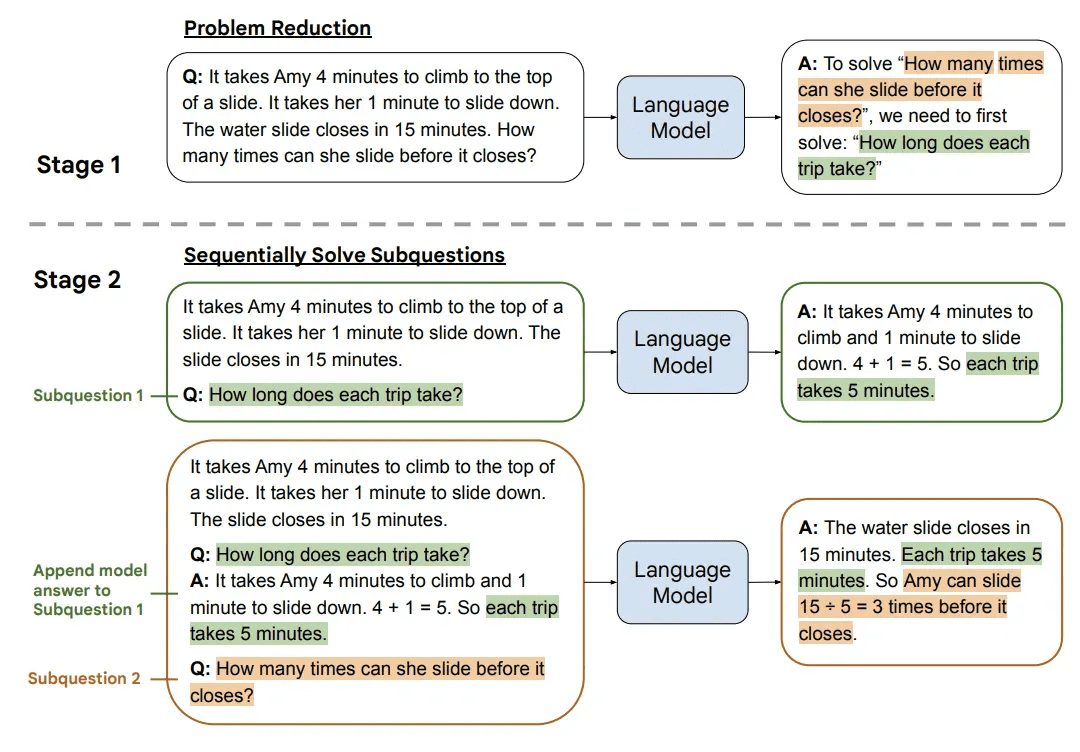

- Least-to-Most [4]:問題を複数の部分に分解し、それらを1つずつ解き、それぞれの部分問題の答えを次の問題を解くためのコンテキストとして使用する。

インプット:

お客様からのお問い合わせ

月1日に御社のアーノルド・コレクションからTシャツを購入しました。3月1日にアーノルドコレクションのTシャツを購入しました。返品しても、Tシャツを2枚購入するのに十分なインストア・クレジットはありますか?命令だ。

お客様からのお問い合わせに親切に対応するカスタマーサービス担当者です。返品は30日以内であれば可能です。本日は3月29日です。現在、すべてのシャツが50%割引となっています。店頭でのシャツ価格は$18-$100です。ディスカウントポリシーに関するいかなる情報も捏造しないでください。

この問いに答えるためには、どのようなサブクエスチョンを解決しなければならないのか?出力:

1. お客様がシャツを購入した日付;

2.現在の割引活動;

3.店内のシャツの価格帯;

4. 顧客が十分な店舗信用を持っているかどうか;

5.お客様の返品に関する方針インプット:

お客様からのお問い合わせ

月1日に御社のアーノルド・コレクションからTシャツを購入しました。3月1日にアーノルドコレクションのTシャツを購入しました。返品しても、Tシャツを2枚購入するのに十分なインストア・クレジットはありますか?命令だ。

お客様からのお問い合わせに親切に対応するカスタマーサービス担当者です。返品は30日以内であれば可能です。本日は3月29日です。現在、すべてのシャツが50%割引となっています。店頭でのシャツ価格は$18-$100です。ディスカウントポリシーに関するいかなる情報も捏造しないでください。

顧客が30日間の返品期間内かどうかを判断する。一歩ずつ進めていきましょう。出力:

お客様各位 いつもアーノルドシリーズをご愛顧いただき誠にありがとうございます!この度は弊社サービスをご利用いただきまして誠にありがとうございます。弊社の返品ポリシーは、ご購入後30日以内であれば、お客様のご都合による返品が可能です。3月1日にご購入いただきましたので、まだ返品期間内であり、返品が可能です。

また、現在50%セールを開催しており、ショップクレジットを使ってアーノルド・コレクションのTシャツを2枚ご購入いただけます。当店のシャツは$18~$100まで取り揃えておりますので、お客様のニーズに合ったシャツをお選びいただけます。

その他ご不明な点がございましたら、お気軽にお問い合わせください。喜んで対応させていただきます!

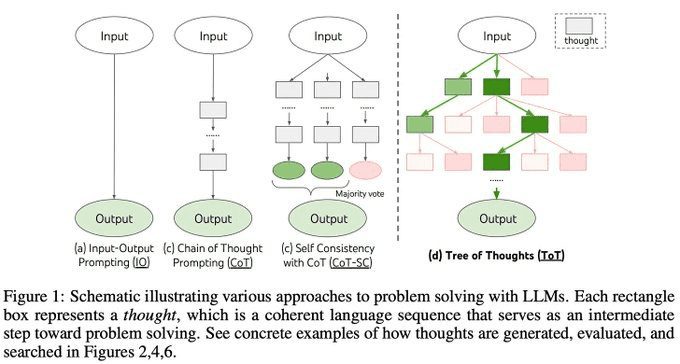

思考の木[ToT]。ヒント[5]:CoTのヒントは、計画、戦略的な先見性、バックトラック、複数の解決策を並行して探索することを必要とする問題を解決しない。lLMは多数の「思考」を生成し、自然言語を通じて最終的な解決策に向けた進捗を継続的に評価する。LLMは多数の「思考」を生成し、自然言語を通じて最終的な解決に向けた進捗状況を継続的に評価する。解の進捗に関するモデルの自己評価を用いて、広く使われている探索アルゴリズム(例えば、幅優先探索や深さ優先探索)を適用することで、探索プロセスを容易にし、問題解決時の予見/バックトラッキングを可能にする。

この質問に3人の専門家が答えたとする。

すべての専門家が、この問題について考える最初のステップを書き出し、それをグループで共有した。

その後、専門家全員が次のステップを書き出し、それを共有する。

そうして、すべての専門家が自分の考え方のすべてのステップについて書き終えるまで続ける。

専門家の歩みが間違っていることに気づいたら、その専門家を辞めさせればいい。

失礼

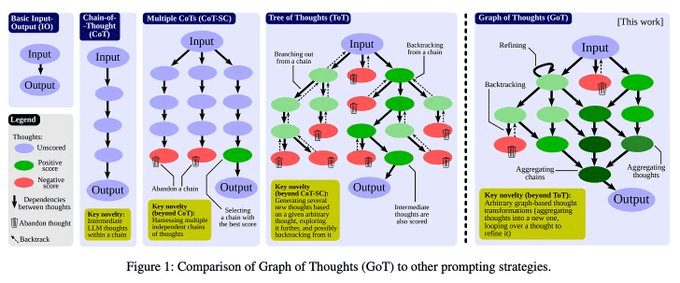

思考のグラフ(GoT)ヒント [6, 7]: その後の研究で、ToTヒントの研究がグラフベースの推論ストラテジ ーに拡張された。これらの技法はToTヒントと似ているが、解を生成する思考の経路が直線的であることを前提としていない。思考を再利用したり、解を導く際に一連の思考に再帰的に適用することもできる。グラフに基づく様々なヒンティング戦略が提案されているが、ToTヒントと同様に、これらの手法も実用性に乏しいと批判されてきた。GoTヒントを用いて推論問題を解くことは、LLMに多数の推論ステップを実行させる可能性がある!

以下は上記引用論文へのリンクである!

[1] https://arxiv.org/abs/2201.11903[2] https://arxiv.org/abs/2205.11916

[3] https://arxiv.org/abs/2203.11171

[4] https://arxiv.org/abs/2205.10625

[5] https://arxiv.org/abs/2305.10601

[6] https://arxiv.org/abs/2308.09687

[7] https://arxiv.org/abs/2305.16582[8] https://arxiv.org/abs/2201.11903

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません