中国ベースの全血DeepSeek-R1蒸留データセット、中国R1蒸留SFTデータセットをサポート

はじめに

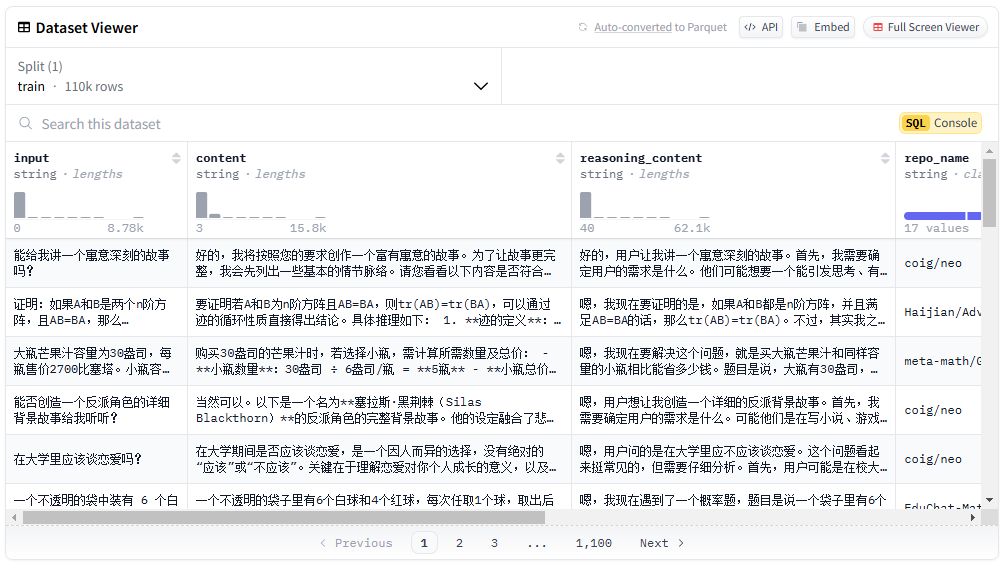

中国語DeepSeek-R1蒸留データセットは、機械学習と自然言語処理研究をサポートするために設計された110Kのデータを含むオープンソースの中国語データセットです。このデータセットはLiu Cong NLPチームによって公開され、数学的データだけでなく、論理的推論、小洪水、志など、一般的な種類のデータも多数含まれている。データセットの蒸留プロセスは、DeepSeek-R1公式から提供された詳細に従って厳密に行われ、データの高い品質と多様性を保証しています。ユーザーはHugging FaceとModelScopeプラットフォームでこのデータセットを無料でダウンロードして使用することができる。

機能一覧

- 多様なデータタイプ数学、論理的推論、一般的なデータの種類などを含む。

- 質の高いデータDeepSeek-R1によって提供された公式詳細に従って蒸留された。

- フリー・オープンソースHugging FaceとModelScopeのプラットフォームから無料でダウンロードできます。

- 複数のアプリケーションに対応機械学習や自然言語処理など、幅広い研究分野に応用可能。

- 詳細データ配信データの詳細な分類と定量的情報を提供。

ヘルプの使用

設置プロセス

- Hugging FaceまたはModelScopeプラットフォームをご覧ください。

- Chinese-DeepSeek-R1-Distill-data-110k」で検索。

- ダウンロードリンクをクリックし、適切な形式を選択してダウンロードしてください。

使用方法

- データセットのロードPython環境

datasetsライブラリーはデータセットをロードする。

from datasets import load_dataset

dataset = load_dataset("Congliu/Chinese-DeepSeek-R1-Distill-data-110k")

- データを見る使用

datasetオブジェクトは、データセットの基本情報とサンプルを表示します。

print(dataset)

print(dataset['train'][0])

- データ前処理単語分割や重複排除など、研究ニーズに応じたデータの前処理。

from transformers import BertTokenizer

tokenizer = BertTokenizer.from_pretrained('bert-base-chinese')

tokenized_data = dataset.map(lambda x: tokenizer(x['text'], padding='max_length', truncation=True))

- モデルトレーニング前処理されたデータを使用したモデル学習。

from transformers import BertForSequenceClassification, Trainer, TrainingArguments

model = BertForSequenceClassification.from_pretrained('bert-base-chinese')

training_args = TrainingArguments(output_dir='./results', num_train_epochs=3, per_device_train_batch_size=16)

trainer = Trainer(model=model, args=training_args, train_dataset=tokenized_data['train'])

trainer.train()

注目機能 操作手順

- 数理データ処理数学のデータには、"段階的に推論し、最終的な答えを{}の中に入れてください "というプロンプトを追加してください。

def add_math_prompt(example):

example['text'] = "请一步步推理,并把最终答案放到 \\boxed {}。" + example['text']

return example

math_data = dataset.filter(lambda x: x['category'] == 'math').map(add_math_prompt)

- 論理的推論 データ処理論理的で一貫性のあるデータを保証するための論理的推論データの特別な取り扱い。

def process_logic_data(example):

# 自定义逻辑处理代码

return example

logic_data = dataset.filter(lambda x: x['category'] == 'logic').map(process_logic_data)© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません