チンチラの瞬間とo3の瞬間:ビッグ言語モデルのスケール法則の進化

記事をざっと読む

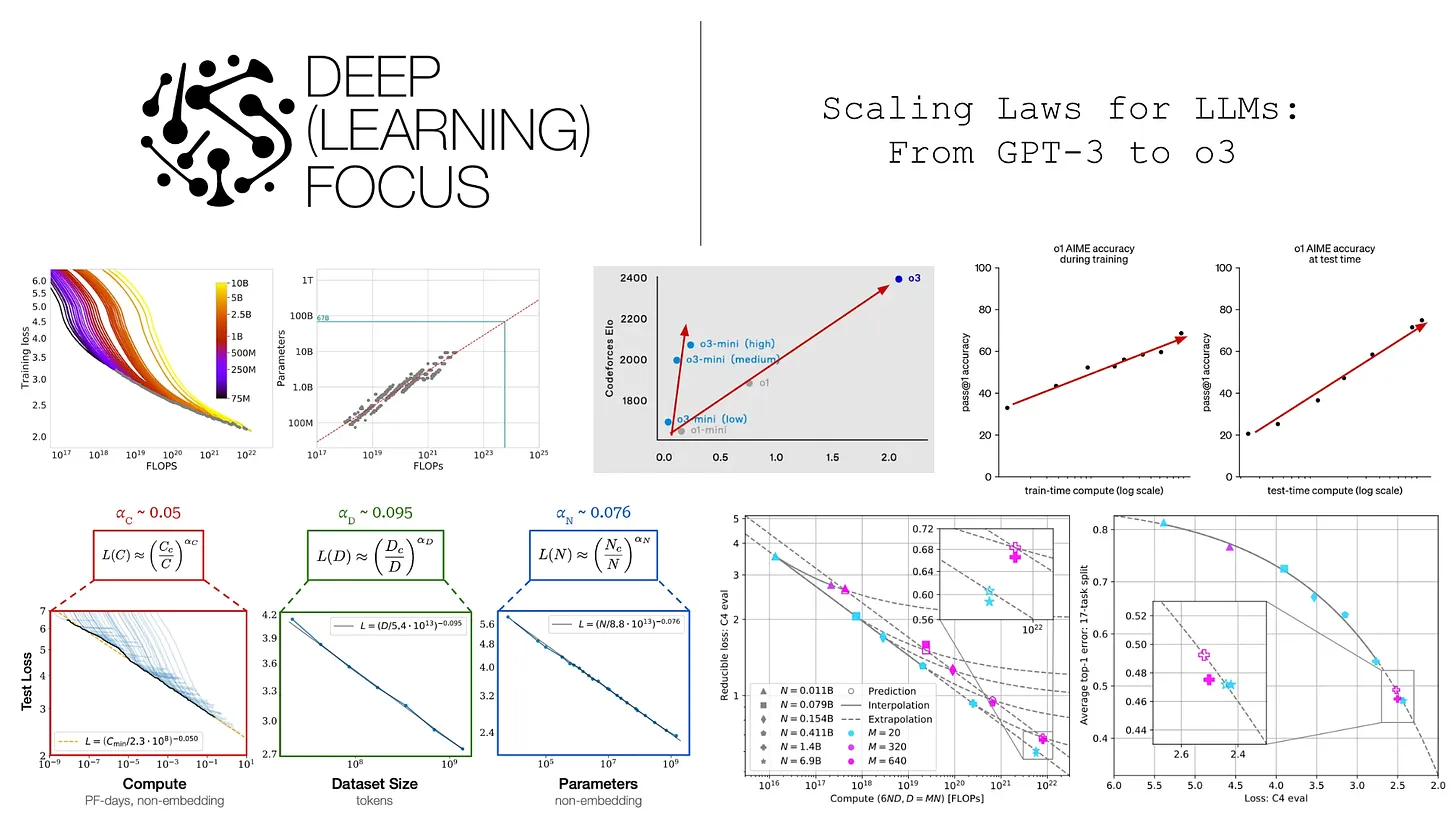

本稿は、大規模言語モデル(LLM)のスケーリング法則の過去と現在、そしてAI研究の今後の方向性について、包括的かつ深く考察したものである。著者のCameron R. Wolfeは、明確な論理と豊富な例を用いて、読者を基本的な概念から最先端の研究まで導き、AI分野の全体像を提示している。以下は、論文の核となる内容と著者の視点についての要約と解説である:

1.規模の法則の起源と発展:GPTからチンチラまで

- 著者は冒頭で、規模の法則が大規模言語モデル開発の中心的な原動力であると述べている。 べき乗則の基本概念を紹介することで、著者らは、大規模言語モデルのテスト損失が、モデルパラメータ、データセットのサイズ、計算量が増加するにつれて減少することを説明している。

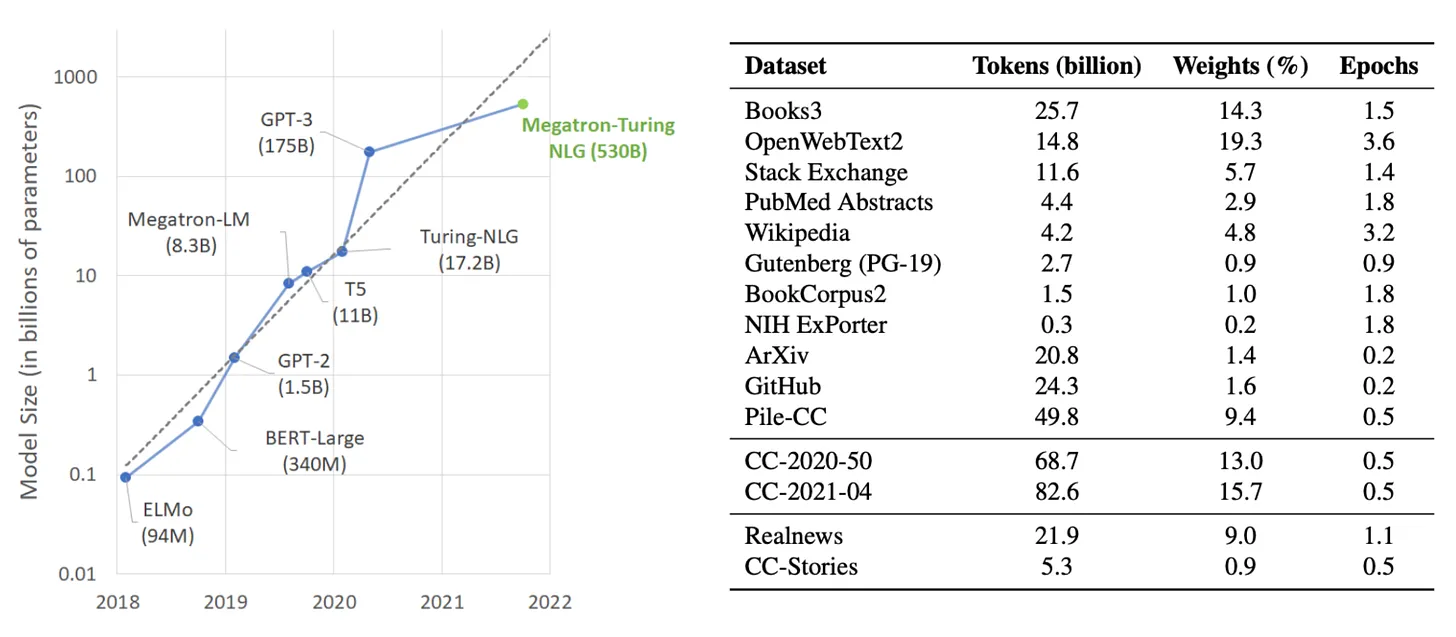

- 著者らはGPTモデルの進化を取り上げ、スケールの法則の実践への適用を鮮やかに示している。 初期のGPTやGPT-2から、画期的なGPT-3、そして謎に包まれたGPT-4まで、OpenAIは常に「大きな努力から奇跡を起こす」という戦略を堅持し、大規模言語モデルの能力の上限を常に更新してきた。本稿では、各モデルの主な革新点、実験セットアップ、性能について詳述し、GPT-3の登場が、大規模言語モデルの特殊モデルから汎用ベースモデルへの移行を意味し、AI研究の新時代を切り開くものであることを指摘する。

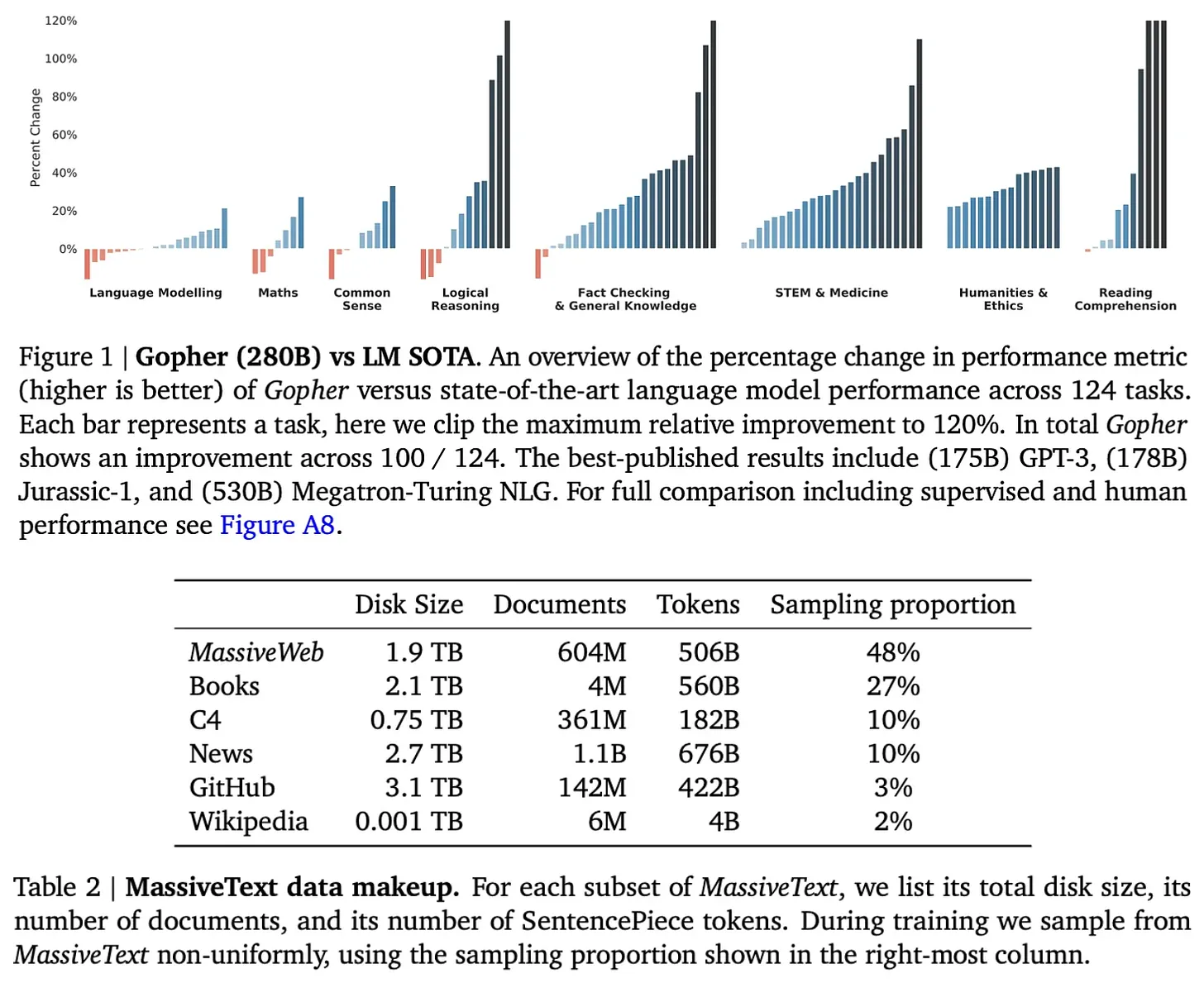

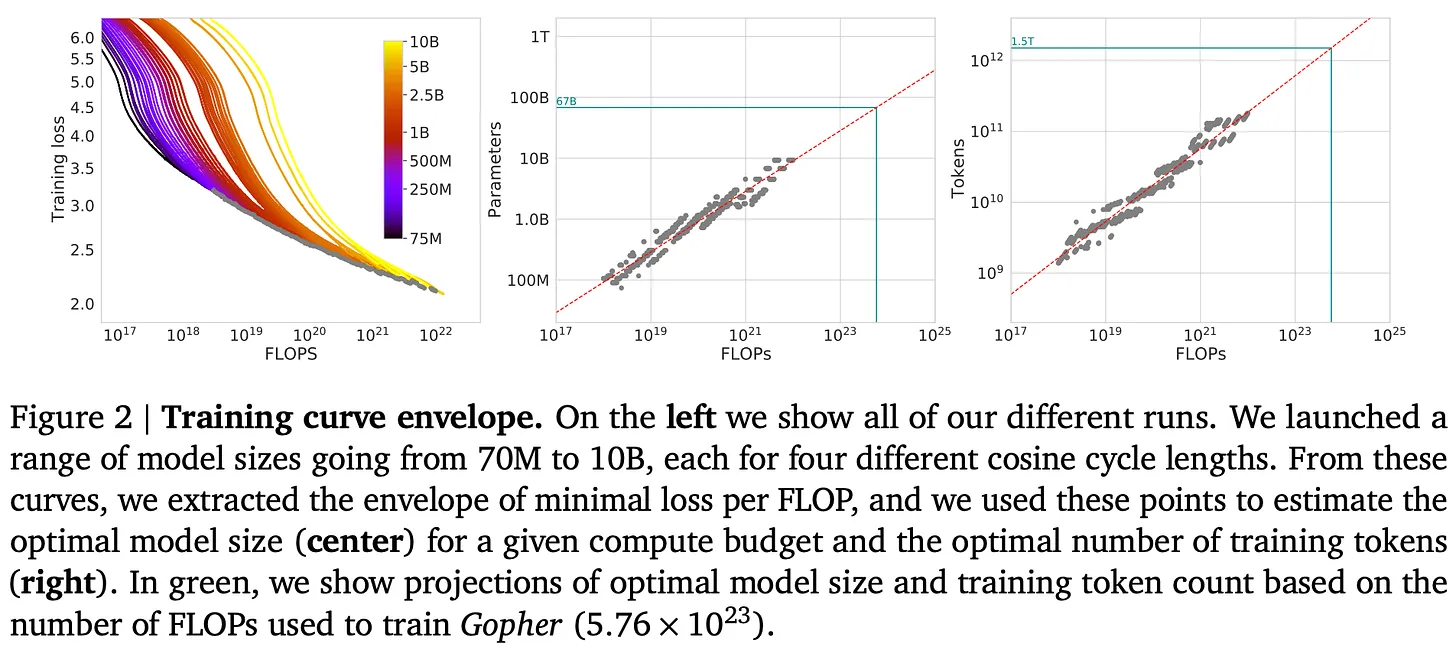

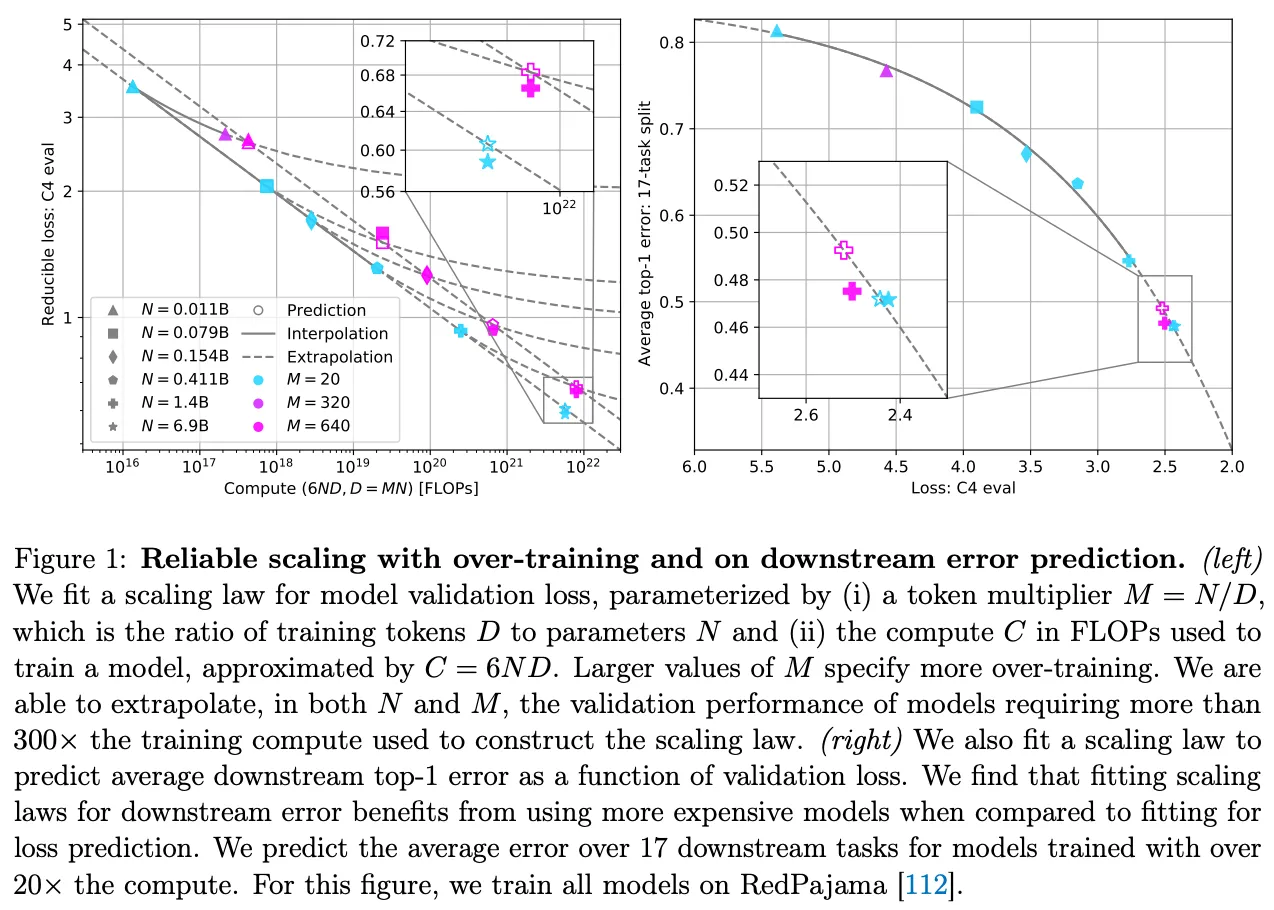

- 著者たちは、やみくもに「大きいことは良いことだ」と主張するのではなく、チンチラモデルが提唱する「計算上最適な」サイズの法則を合理的に分析している。 DeepMindの研究により、これまでのモデルは一般的に「訓練不足」、つまりモデルサイズに対してデータセットサイズが小さすぎることが明らかになり、チンチラのモデルの成功により、同じ計算予算であればモデルサイズを拡大するよりもデータセットサイズを適切に拡大する方が効果的であることが実証された。この発見は、その後の大規模言語モデルの学習に大きな影響を与えた。

コメント 著者は、専門家でない読者でもその核となる考え方を理解できるよう、理論的な説明と裏付けとなる実例の両方を用いて、「スケールの法則」を詳しく紹介している。GPTシリーズのモデルの変遷を振り返ることで、著者は抽象的なスケールの法則を具体的なモデル開発と結びつけており、論文の読みやすさと説得力を高めている。チンチラモデルの分析には、やみくもに規模を主張するのではなく、読者が計算機資源をより効率的に利用する方法を考えるよう導くという、著者の見識の精神が示されている。

2.サイズの法則の「終焉」:疑問と考察

- 記事の第2部では、AIにおける規模の法則に対する最近の疑問を取り上げる。 著者は複数のメディア報道を引用し、モデルの改善速度が鈍化するにつれ、業界は規模の法則が限界に達したのではないかと考え始めていることを示唆している。同時に著者は、ダリオ・アモデイやサム・アルトマンのような業界関係者を引き合いに出し、規模が依然としてAIの進歩を推進する重要な力であることを示唆している。

- 著者は、規模の法則の「鈍化」はある程度予想されていたことだと指摘している。 規模の法則そのものが、規模が大きくなればなるほど、パフォーマンス向上の難易度は指数関数的に高まることを予言している。さらに著者らは、「パフォーマンス」の定義の重要性を強調している。テストロスの減少が必ずしもビッグ・ランゲージ・モデルの能力の向上と一致するわけではなく、ビッグ・ランゲージ・モデルに対する業界の期待は様々である。

- 「データのボトルネック "は、著者たちが注目している問題のひとつである。 チンチラ・モデルとそれに続く研究は、データサイズの重要性を強調しているが、インターネット上で入手できる高品質なデータが限られていることは、ビッグランゲージ・モデルのさらなる発展にとってボトルネックとなるかもしれない。

コメント このセクションでは、著者の批判的思考と業界に対する鋭い洞察力が発揮されている。著者は論争を避けるのではなく、様々な関係者の見解を客観的に提示し、技術的な観点から「規模の拡大が遅れている」可能性のある理由を分析している。特に著者が強調する「データのボトルネック」は、大規模言語モデルの開発に対する現実的な課題としてだけでなく、今後の研究の方向性としても重要である。

3.AI研究の未来:事前学習を越えて

- 記事の最後では、大規模言語モデル・システム/エージェントと推論モデルに焦点を当て、AI研究の今後の方向性について考察している。

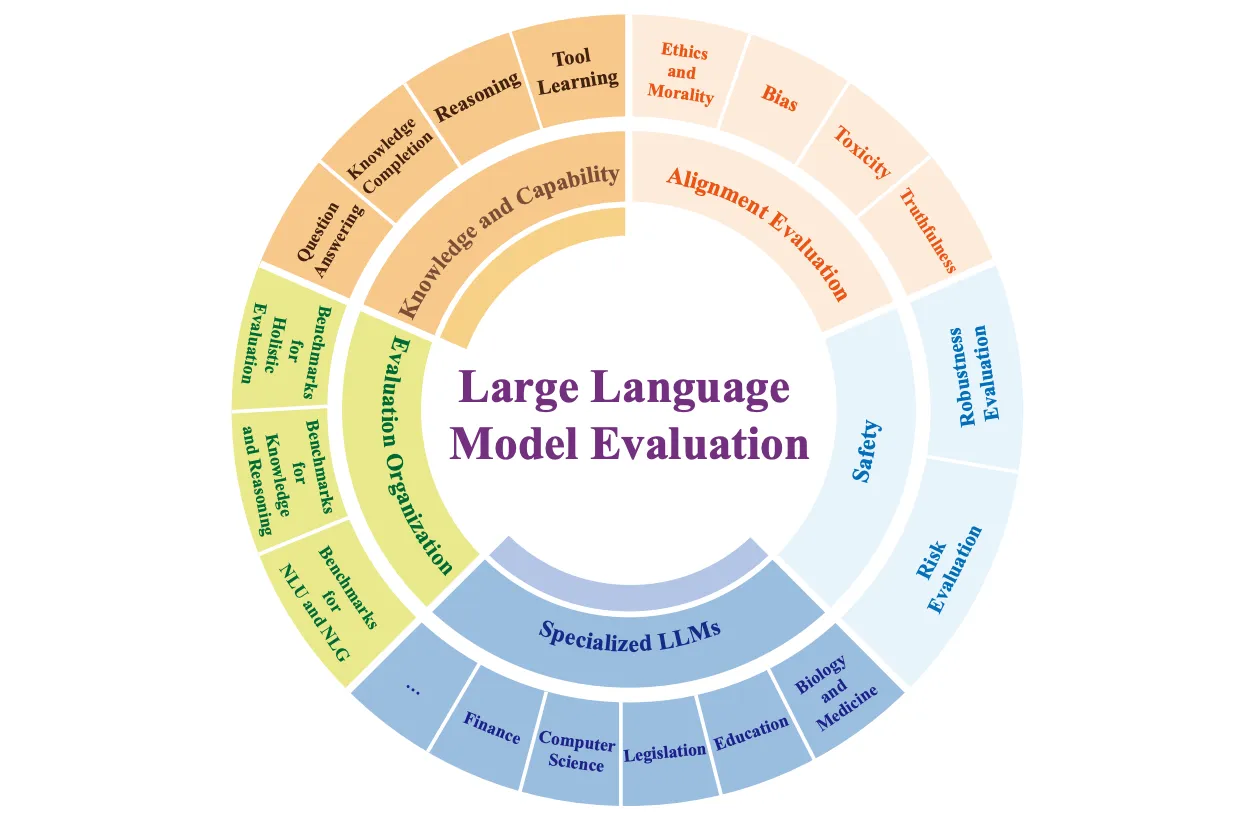

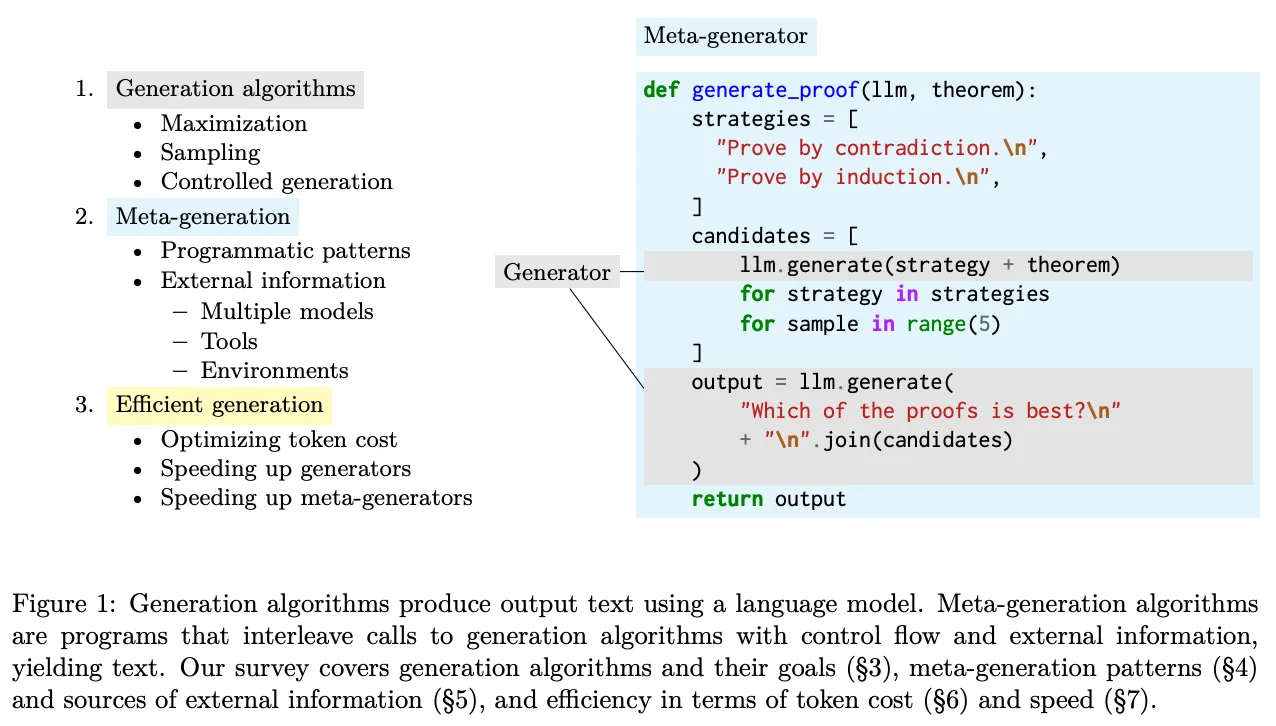

- 著者らは、事前に訓練されたモデルのサイズが大きくなることがボトルネックになったとしても、大規模な言語モデルの複雑なシステムを構築することで、AIの能力を向上させることができると主張している。 この記事では、タスクの分解とリンクという2つの主要な戦略について説明し、大規模な言語モデルが得意とする複雑なタスクをサブタスクに分解する方法の例として、書籍の要約を用いている。

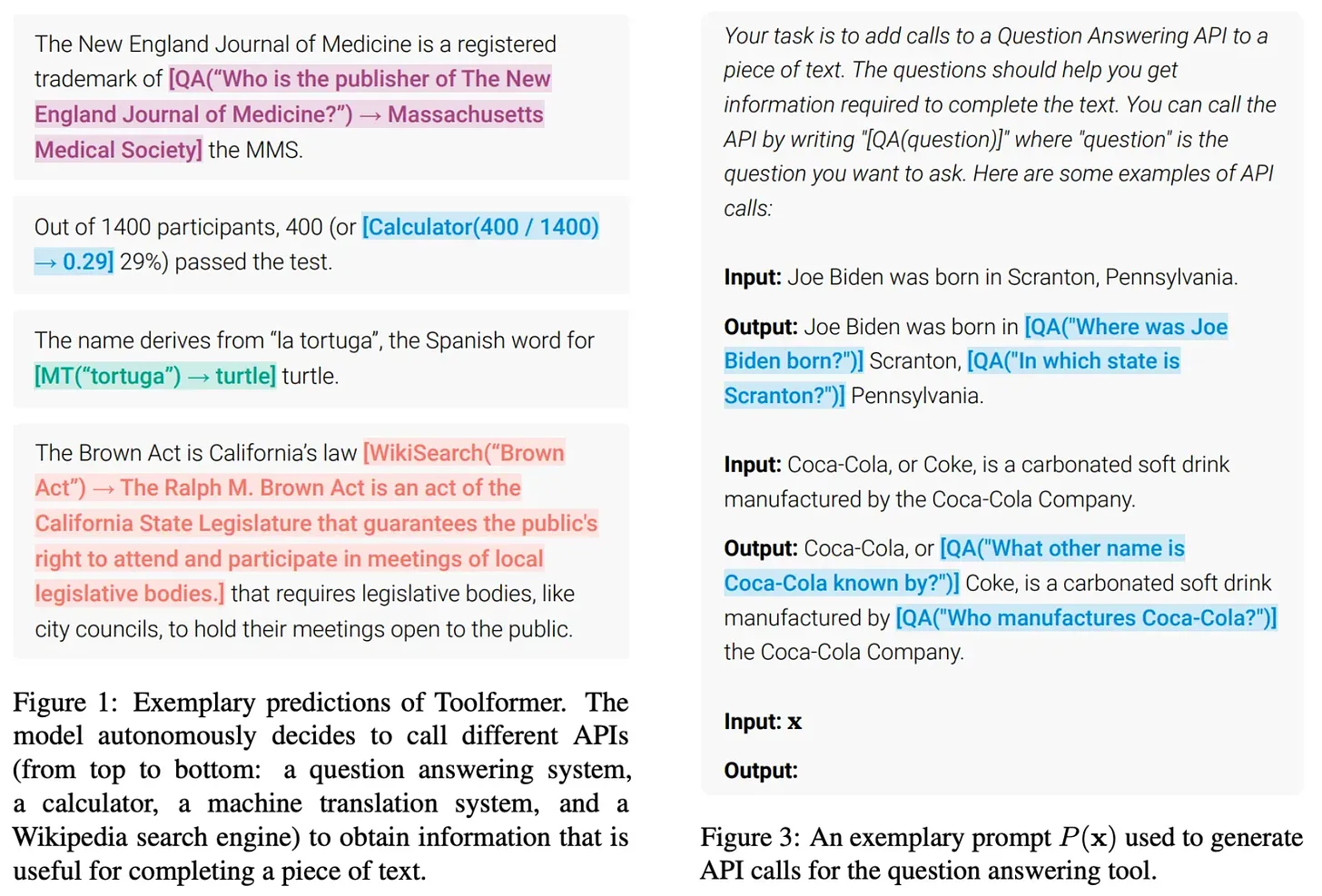

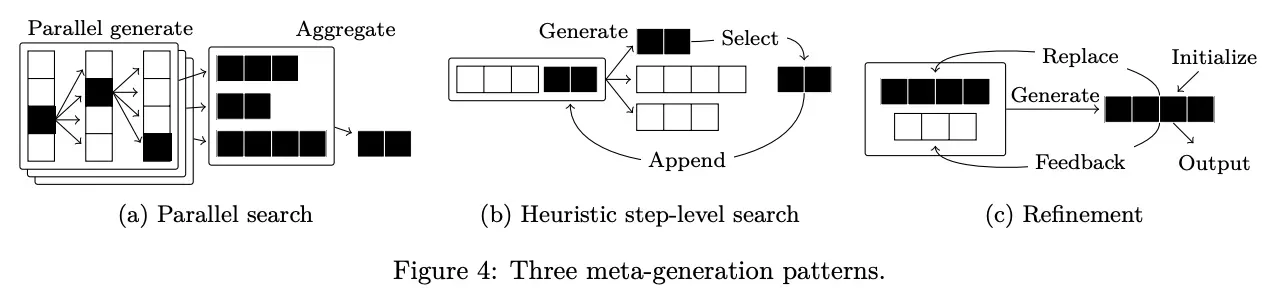

- 著者はまた、ビッグ・ランゲージ・モデルの製品開発への応用の展望についても論じており、真に有用なビッグ・ランゲージ・モデルの製品を構築することが、現在のAI研究の重要な方向性であると指摘している。 特に、大規模言語モデルにツールを使用する機能を与えることで、大規模言語モデルの適用シナリオを拡張するエージェントの概念に焦点を当てている。しかしながら、著者らは複雑な大規模言語モデリングシステムを構築する際の頑健性の課題も指摘しており、メタ生成アルゴリズムの改善を通じてシステムの信頼性を向上させるための研究の方向性も提示している。

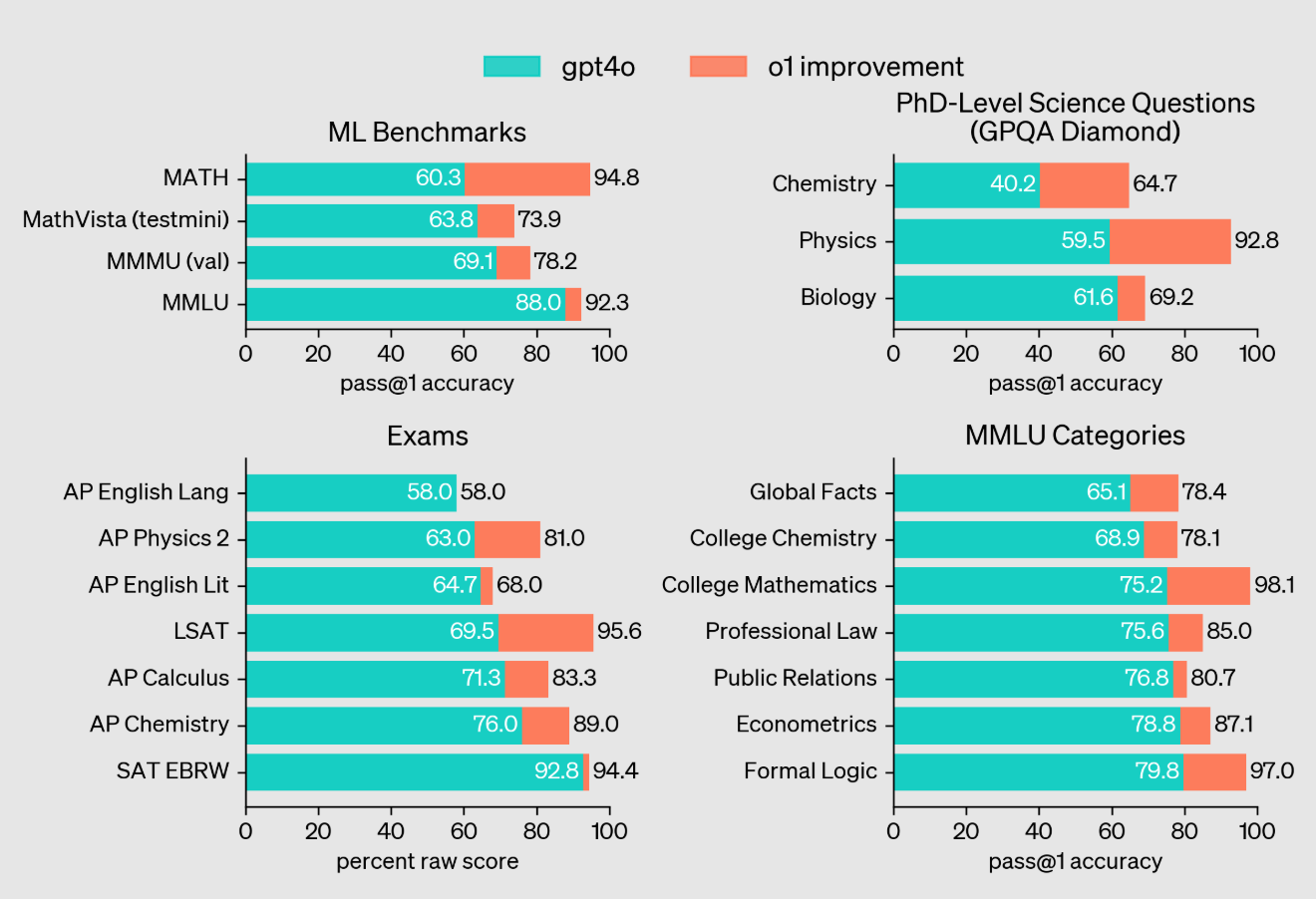

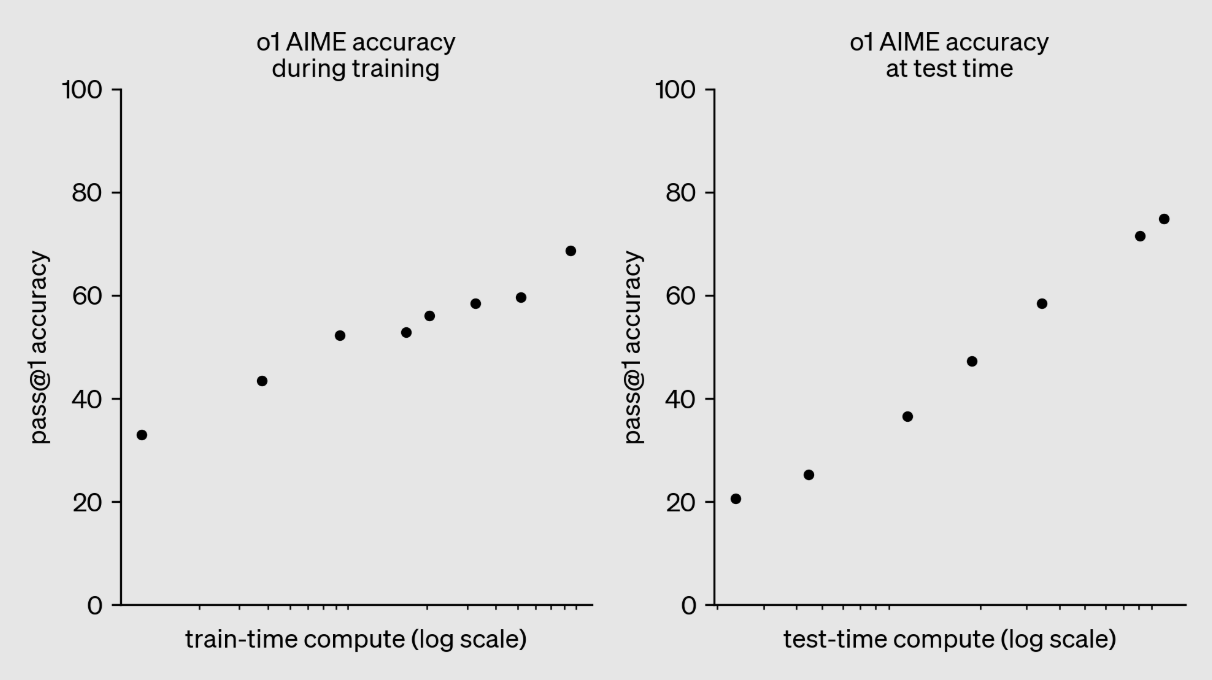

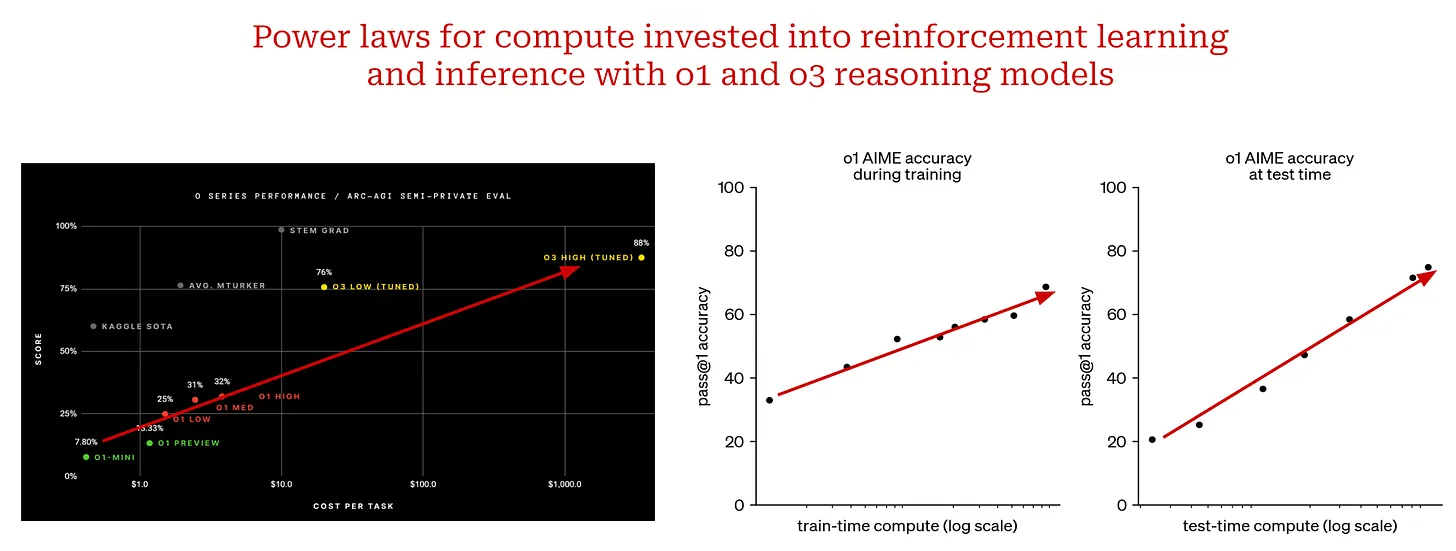

- 推論モデルに関しては、OpenAIのo1とo3モデルを紹介し、複雑な推論タスクで素晴らしい結果を出している。 特にo3は、いくつかの難易度の高いベンチマークで人間のレベルを上回り、いくつかの問題ではTerence Taoの予測をも破った。著者らは、o1とo3モデルの成功は、事前学習のスケールアップに加え、推論時の計算入力を増やすことでモデルの推論を大幅に改善できることを示しており、これは新しいスケーリングパラダイムであると指摘している。

コメント このセクションは非常に先進的であり、著者らによるビッグ・ランゲージ・モデリングのシステム/エージェントと推論モデルの紹介は、読者に新たな地平を開くものである。著者がビッグ・ランゲージ・モデル製品の構築に重点を置いていることは、学術研究のみならず、AI技術の現場での応用においても、非常に実用的な意義を持つ。o1モデルとo3モデルの紹介は、複雑な推論タスクに対するAIの大きな可能性を示すとともに、今後のAI研究の新たな方向性を示しており、心強い。

要約し、振り返る:

キャメロン・R・ウルフの論文は、大規模言語モデルのための規模の法則の発展に関する体系的な概観を提供するだけでなく、AI研究の将来に対する洞察に満ちた展望を提供する、広さと深さを兼ね備えた優れた作品である。著者の視点は客観的かつ合理的であり、規模の法則の重要な役割を肯定する一方で、その限界や課題も指摘している。論文の論理は明快で論旨もしっかりしているので、AI分野に詳しくない読者にも有益である。

特筆すべきハイライト

- 詳細な説明 著者は、べき乗則の導入、規模の法則、タスクの分解など、複雑な概念をわかりやすい言葉で説明することに長けている。

- 豊富な実例に支えられている: この記事では、GPTシリーズ、チンチラ、ゴーファー、o1、o3など、抽象的な理論を具体的で親しみやすいものにするためのモデルや実験結果が数多く挙げられている。

- 包括的な文献レビュー 本稿では、大規模言語モデリングの分野における古典的な論文から最近の研究結果まで、多くの参考文献を引用し、読者に深い研究のためのリソースを提供する。

- オープンマインドな思考: 著者は規模の法則の未来について最終的な答えを与えるのではなく、読者を "次は何をスケールさせるのか?"といった主体的な思考へと導く。この問いは、より多くの研究者がAIのフロンティアを探求するきっかけとなるだろう。

この記事は、AIの発展を見守るすべての人々に熟読に値するものである。過去を総括するだけでなく、未来を啓発するものでもある。 この記事の価値は、その内容そのものだけでなく、思考を刺激し、イノベーションを導くその精神にある。今後のAI研究において、o3のようなブレークスルーがさらに生まれ、スケールの大きなアイデアが新たな形でAI技術の進歩を牽引していくと信じている。

タイトル大規模言語モデルのスケール法則:GPT-3からo3まで.

原文ママhttps://cameronrwolfe.substack.com/p/llm-scaling-laws

大規模な言語モデリングの現状とAI研究の未来について学ぶ...

(出典[1、7、10、21])。

AI研究における最新の進歩特に、ラージ・ランゲージ・モデル(LLM)は- すべてはスケールによって決まる。より大きなモデルをより多くのデータで訓練すれば、より良い結果が得られます。この関係は、サイズの法則によってより厳密に定義することができます。これは、ある関連する量(例えば、トレーニング計算量)を増やすと、大規模な言語モデルのテスト損失がどのように減少するかを記述する方程式です。サイズの法則は、より大きく、より高価なトレーニング実行の結果を予測するのに役立ち、スケーリングへの投資を継続するのに必要な確信を与えてくれます。

「大規模なデータセットがあり、非常に大規模なニューラルネットワークを訓練すれば、成功は約束されている!」。 - イリヤ・スーツケバー

何年もの間、規模の法則はAI研究にとって予測可能な北極星であった。実際、OpenAIのような初期のフロンティア研究所の成功は、規模の法則の遵守に起因しているとさえ言われてきた。しかし最近、一流の研究所が大規模言語のより優れた次世代モデルの作成に取り組んでいるという報告1によって、規模の法則の持続性が疑問視されている。こうした主張は、私たちを懐疑的にさせるかもしれない:規模が大きくなるとボトルネックになるのでしょうか?もしそうなら、他の方法はあるのでしょうか?

この概要では、ビッグ・ランゲージ・モデルの「スケールの法則」とその周辺研究の詳細な説明から始め、これらの疑問に一から答えていく。スケールの法則の概念はシンプルだが、スケールをめぐる世間にはさまざまな誤解がある。この研究の背景にある科学は、実は非常に具体的である。スケールの法則このスケールに関する詳細な理解をもとに、ビッグ・ランゲージ・モデリング研究の最新動向と、スケールの法則を「失速」させた要因について議論する。最後に、これらの情報をもとに、AI研究の将来像を明らかにし、いくつかの重要なアイデアに焦点を当てます。スケールを含む--このような考え方は、今後も進歩の原動力となるだろう。

大規模言語モデルのスケーリングの基本概念

大規模言語モデルのスケーリング状態を理解するためには、まずスケールの法則に関する一般的な理解を確立する必要がある。この理解をゼロから構築し、べき乗則の概念から始めます。そして、大規模言語モデルの研究においてべき乗則がどのように適用されてきたかを探り、今日私たちが使用しているスケール則を導き出します。

べき乗則とは何か?

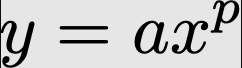

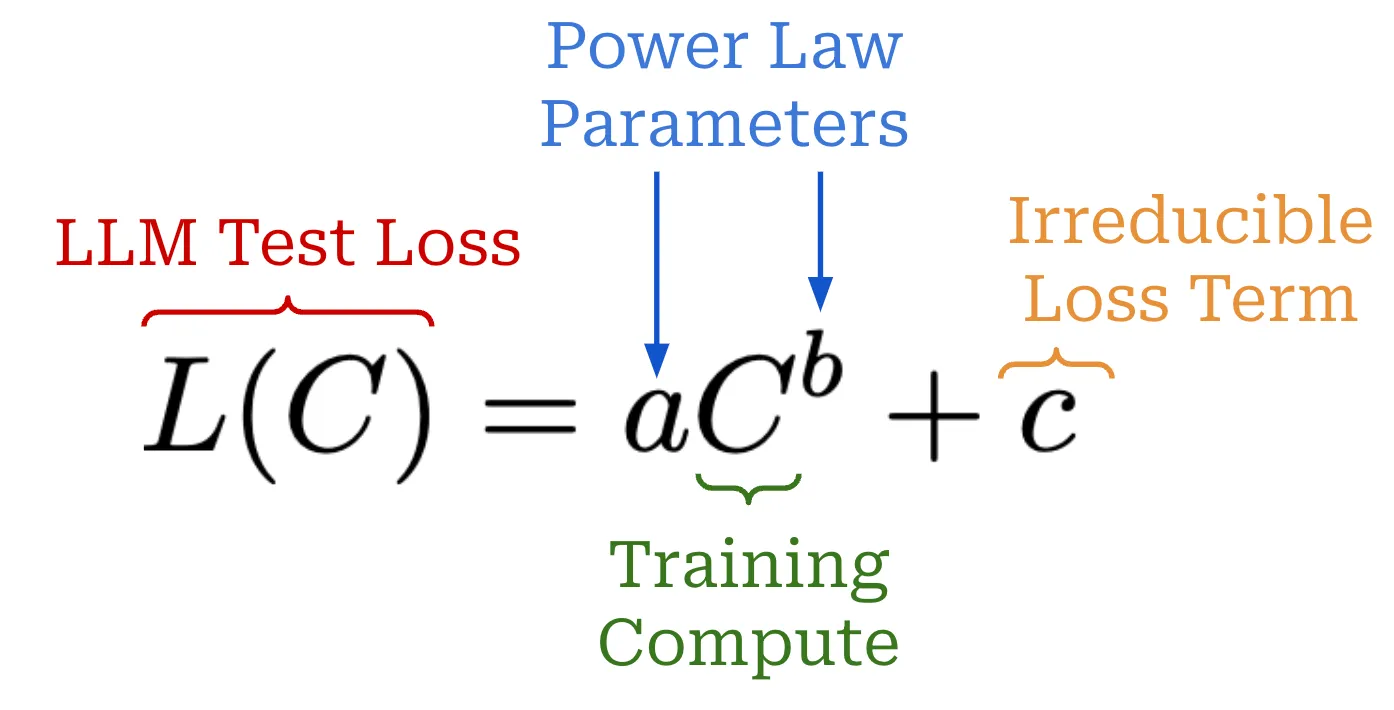

べき乗則は、大規模な言語モデルのスケーリングにおける基本的な概念である。要するに、べき乗則は単純に2つの量の関係を記述します。大規模言語モデルの場合、最初の量は大規模言語モデルのテスト損失です。またはその他の関連するパフォーマンス指標(例えば、下流タスクの精度[7])。- もう1つは、モデルのパラメータ数など、特定の設定をスケーリングしようとする場合です。例えば、大規模な言語モデルのスケーリング特性を調査する場合、次のような記述を目にすることがある。

「十分な訓練データがあれば、検証損失のスケーリングはモデルサイズの近似的な滑らかなべき乗関数になるはずだ。 - 出典[4]

このような記述は、モデルのテスト損失とモデルパラメーターの総数の間に測定可能な関係があることを物語っている。これらの量の一方が変化すれば、他方の相対的なスケールも不変に変化する。言い換えれば、この関係から、モデルパラメーターの総数を増やすこと、つまり他の条件が満たされていると仮定した場合(例えば、十分なトレーニングデータが利用可能であるなど)--その結果、試験損失は予測可能な倍率で減少する。

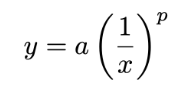

べき乗則の公式。 基本的なべき乗則は以下の式で表される。

ここで研究される2つの量は以下の通りである。 x 歌で応える yでも a 歌で応える p は、これらの量の関係を表す定数である。このべき乗関数2 をプロットすると下図のようになる。大規模な言語モデルのスケーリングを研究する論文のほとんどが対数スケールを使用しているため、正規スケールと対数スケールの両方でプロットを提供します。

xとyの間の基本べき乗則のグラフ

しかし、ビッグ・ランゲージ・モデルをスケーリングするために提供されたダイアグラムは、上記のダイアグラムのようには見えません。普通は逆さまだ。下の例をご覧ください。

(出典[1])

逆べき乗則の式は、標準べき乗則の式とほぼ同じであるが、我々が興味があるのは p 負の指数を使う。べき乗則の指数を負にすると、グラフがひっくり返る。

xとyの逆べき乗則のグラフ

対数スケールを使ってプロットすると、この逆パワー則は、ほとんどの大規模言語モデルのサイズ則を特徴づける線形関係を生み出します。この概要で扱うほぼ全ての論文は、様々な異なる要素(サイズ、計算、データなど)のスケーリングが大規模言語モデルの性能にどのように影響するかを調査するために、このようなプロットを作成します。では、大規模言語モデルのスケーリングの文脈でべき乗則を研究した最初の論文の一つ[1]を理解することで、より実用的なべき乗則を見てみましょう。

神経言語モデリングのためのスケール法則 [1]

言語モデリングの黎明期、私たちはスケールがパフォーマンスに与える影響を理解していなかった。言語モデリングは有望な研究分野であったが、当時の現行世代のモデル(例えば、オリジナルのGPT)のパワーは限られていた。私たちはまだ、より大規模なモデルのパワーを発見しておらず、より優れた言語モデルを作成する道筋も明確ではありませんでした。モデルの形状(レイヤー数やサイズ)は重要か?モデルを大きくすれば性能が良くなるのか?このような大きなモデルを訓練するためには、どれくらいのデータが必要なのか?

"モデルサイズ、データセットサイズ、トレーニングに使用される計算量が増加するにつれ、損失はべき乗則としてスケールし、これらの傾向のいくつかは7桁以上に及ぶ。" - 出典[1]

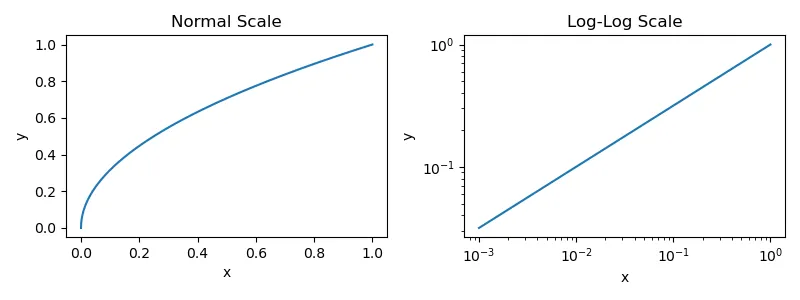

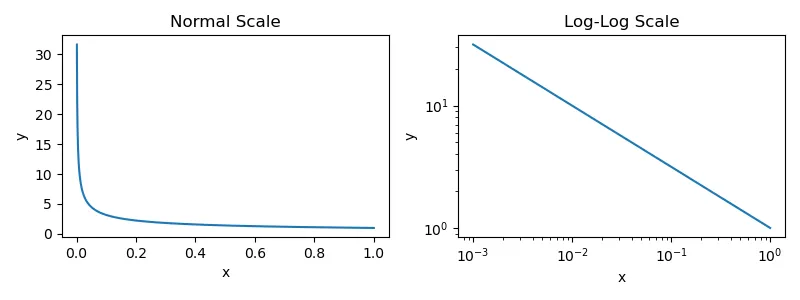

1]では、著者はいくつかの要因を分析することを目的とした。例えば、モデルサイズ、モデル形状、データセットサイズ、トレーニング計算、バッチサイズなどである。- これらの疑問に答えるために、モデルの性能に関するこの分析から、大規模言語モデルの性能は、言語モデルの数を増やすにつれてスムーズに向上することがわかった。

- モデルパラメータの数。

- データセットのサイズ。

- トレーニングに使用した計算量。

もっと具体的に言えば他の2つの要因によって性能がボトルネックになっていない場合、各要因と大規模言語モデルのテスト損失との間にはべき乗則の関係が観察される。

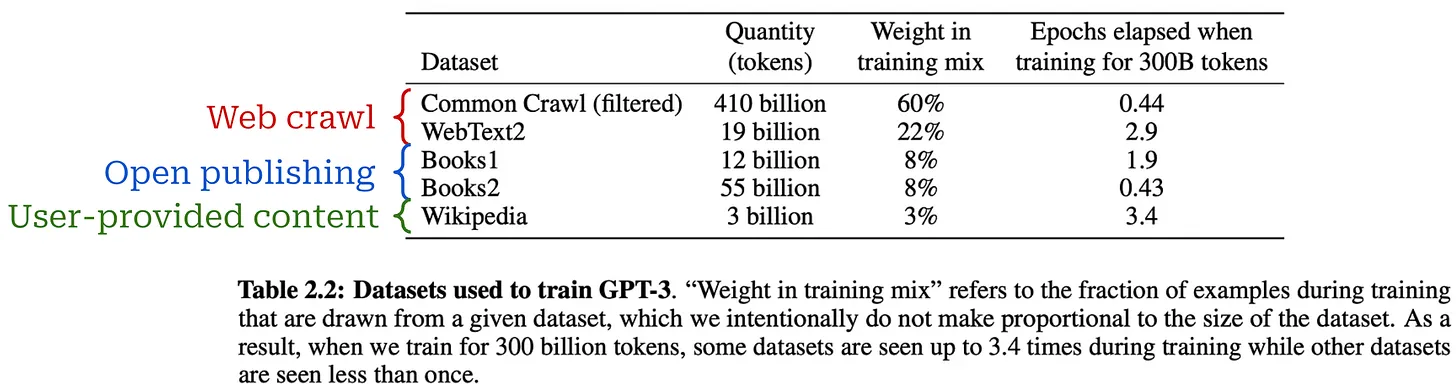

実験セットアップ。べき乗則に適合させるために、著者らはWebText2コーパスのサブセットで大規模言語モデルを事前訓練した。 トークン を固定コンテキスト長とし、標準的なネクストトークン予測(クロスエントロピ ー)ロスを用いて学習を行う。同じ損失が予約されたテストセットで測定され、主なパフォーマンス指標として使用される。この設定は、ほとんどの大規模言語モデルの標準的な事前学習設定と一致する。.

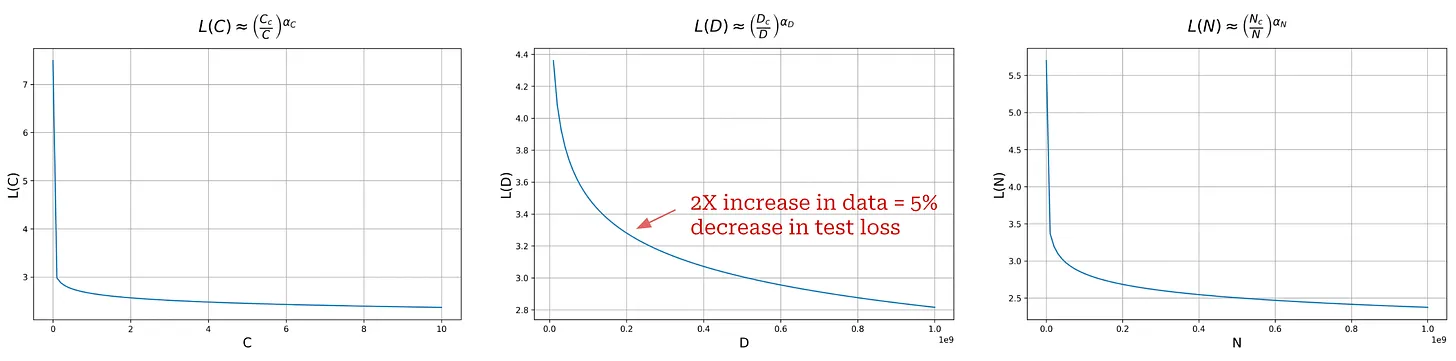

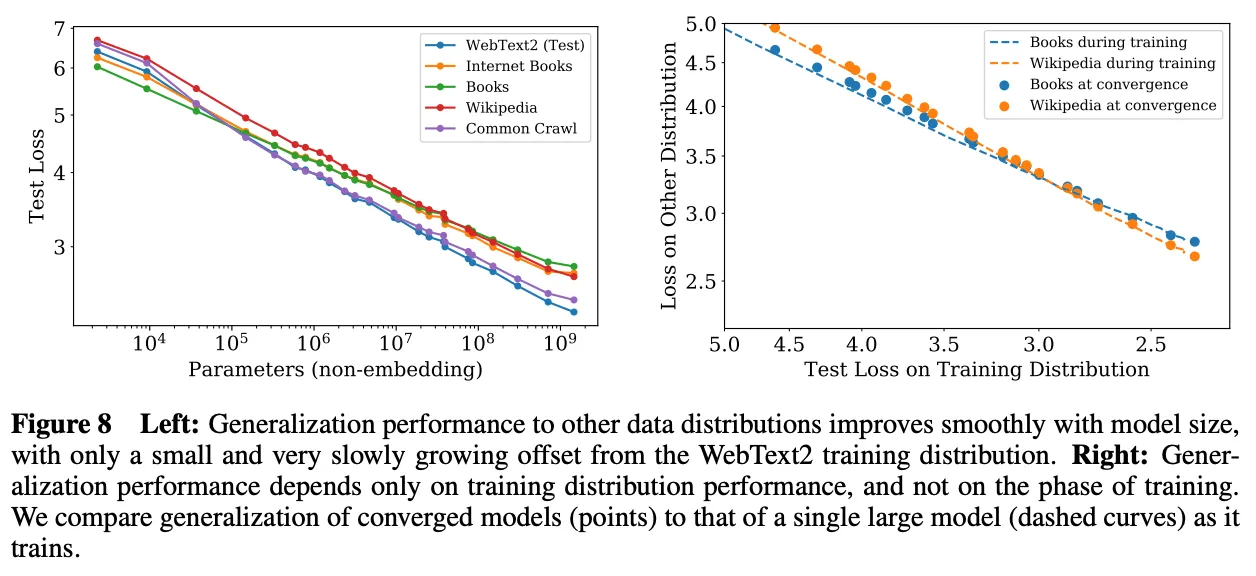

(出典[1])

大規模言語モデル スケールのべき乗則。1]で学習した大規模言語モデルのパフォーマンスWebText2でのテストでの損失に関しては- は、パラメータ、データ、計算量が増えれば増えるほど、着実に向上することが証明された3 。これらの傾向は、計算量では8桁、モデルサイズでは6桁、データセットサイズでは2桁に及ぶ。正確なべき乗則の関係と、それぞれの関係に当てはめた方程式を上図に示す。ここでの各式は、以前に見た逆べき乗則の式と非常によく似ている。ただし a = 1 を追加し、括弧の中に乗算定数4を追加する。

(出典[1])

これらのべき乗則は、トレーニングが他の要因によってボトルネックになっていない場合にのみ適用される。したがってモデルのサイズ、データ、計算-最適なパフォーマンスを得るためには、すべてを同時に拡張する必要がある。これらのコンポーネントのどれかを単独で拡張すれば、収穫逓増に達するだろう。

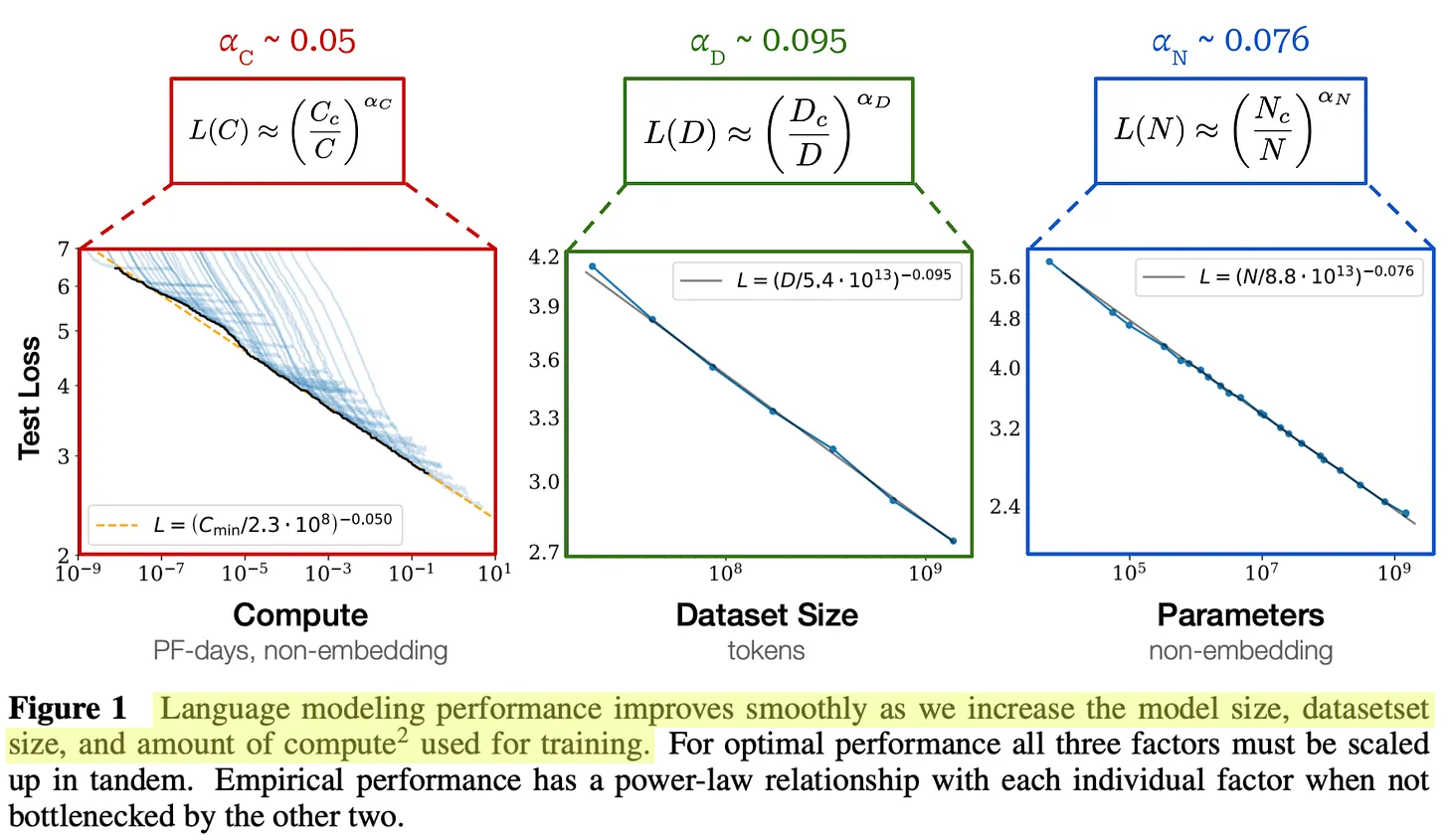

べき乗則は何を物語っているのか?1]で提供されているべき乗則のプロットは有望に見えるが、これらのプロットは対数目盛りを使って作成されていることに注意すべきである。通常のプロット(つまり対数目盛なし)を作成すると、次の図になり、べき乗則の形状が指数関数的減衰に似ていることがわかる。

対数目盛りのないべき乗則グラフ

スケーリングとAGIをめぐるネット上の言説の多くを考えると、このような発見は直感に反するように思える。多くの場合、大規模な言語モデルの品質は、計算量が対数的に増加するにつれて指数関数的に向上するというのが、私たちが聞かされてきた直感のようだが、実際はそうではない。実際には大規模な言語モデルの品質向上は、規模が大きくなるにつれてますます難しくなる.

(出典[1])

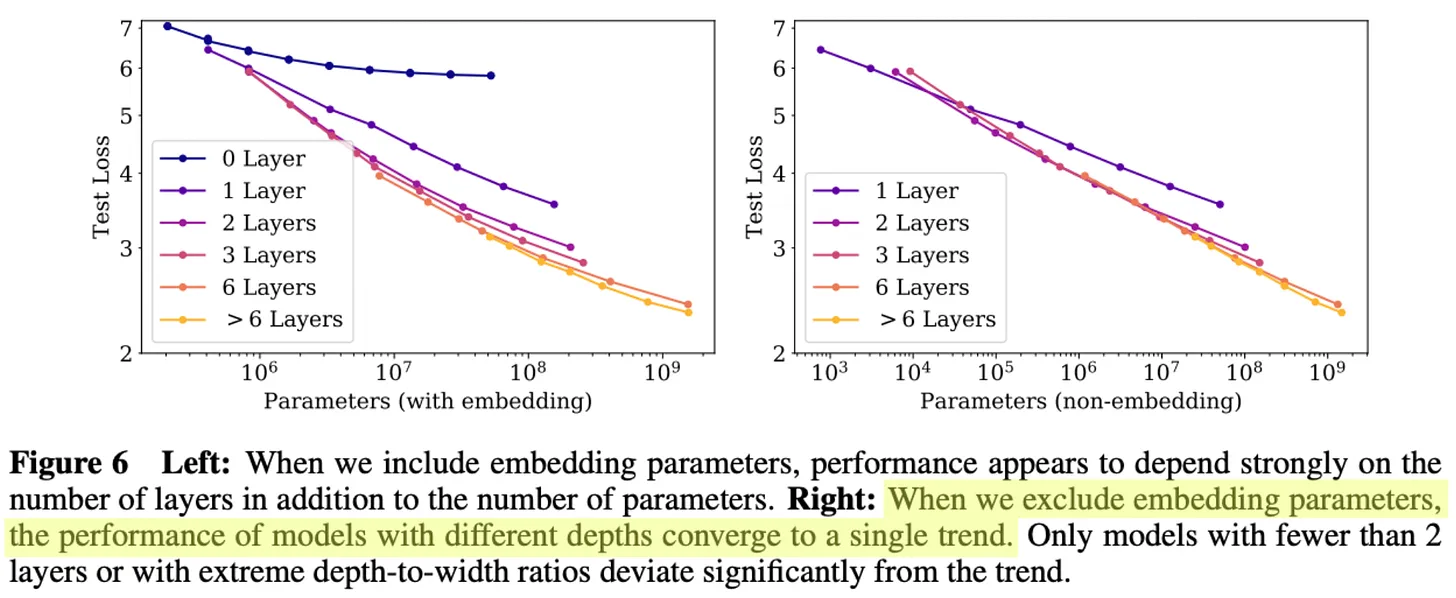

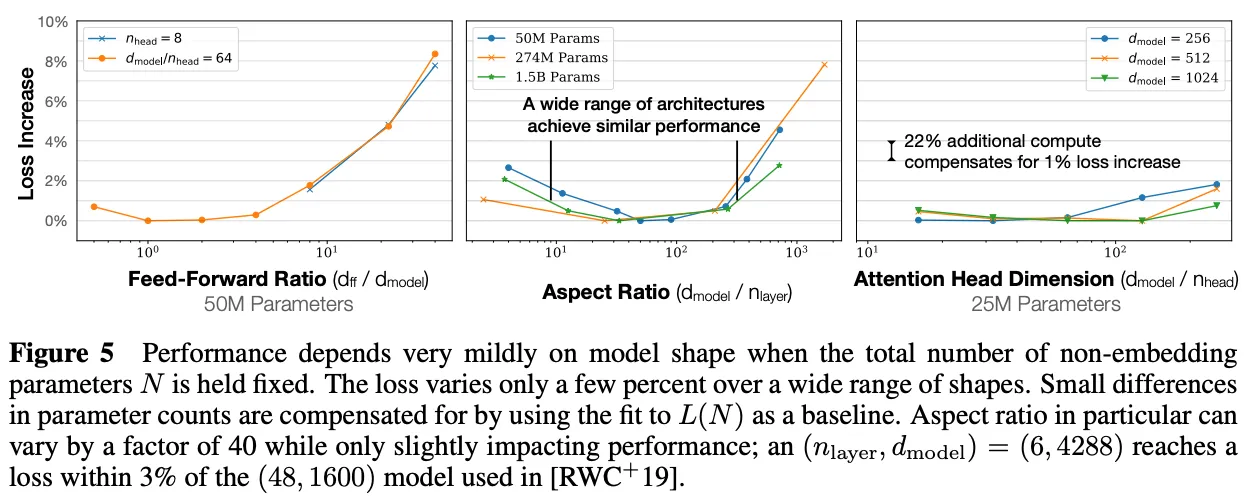

その他の有益な発見1]で観測されたべき乗則に加え、モデルの形状やアーキテクチャの設定など、考慮される他の要因はモデルの性能にほとんど影響しないことがわかりました。大規模な言語に対してより良いモデルを作成するためには、圧倒的にスケールが大きく寄与します。より多くのデータ、計算、モデル・パラメータは、大規模言語モデルのパフォーマンスをスムーズに向上させる。.

「そのため、最適な計算効率のトレーニングには、比較的控えめな量のデータで非常に大きなモデルをトレーニングし、収束する前に大幅に停止することが含まれる。 - 出典[1]

興味深いことに、[1]の経験的分析によると、大きな言語モデルは小さなモデルに比べてサンプル効率が高い、つまり同じレベルのテスト損失を達成するために使用するデータが少ない傾向があります。このため収束するまでの大規模な言語モデルの事前学習は、(間違いなく)最適とは言えない。.その代わりに、より少ないデータでより大きなモデルを訓練し、収束する前に訓練プロセスを停止することができる。この方法は、使用する訓練計算量の点では最適だが、推論コストを考慮していない。実際、私たちは通常、より小さなモデルをより多くのデータで訓練する。

著者らはまた、モデルサイズと事前学習に使用するデータ量の関係を広範囲に分析し、データセットのサイズはモデルサイズほど急速に大きくする必要はないことを発見した。モデルサイズを約8倍に増やすには、オーバーフィッティングを避けるために学習データ量を約5倍に増やす必要がある.

(出典[1])

"これらの結果は、モデルサイズ、データ、計算を適切にスケールアップすることで、言語モデリングの性能がスムーズかつ予測通りに向上することを示している。我々は、より大きな言語モデルが、現在のモデルよりも優れた性能を発揮し、より高いサンプル効率を持つことを期待している。" - 出典[1]

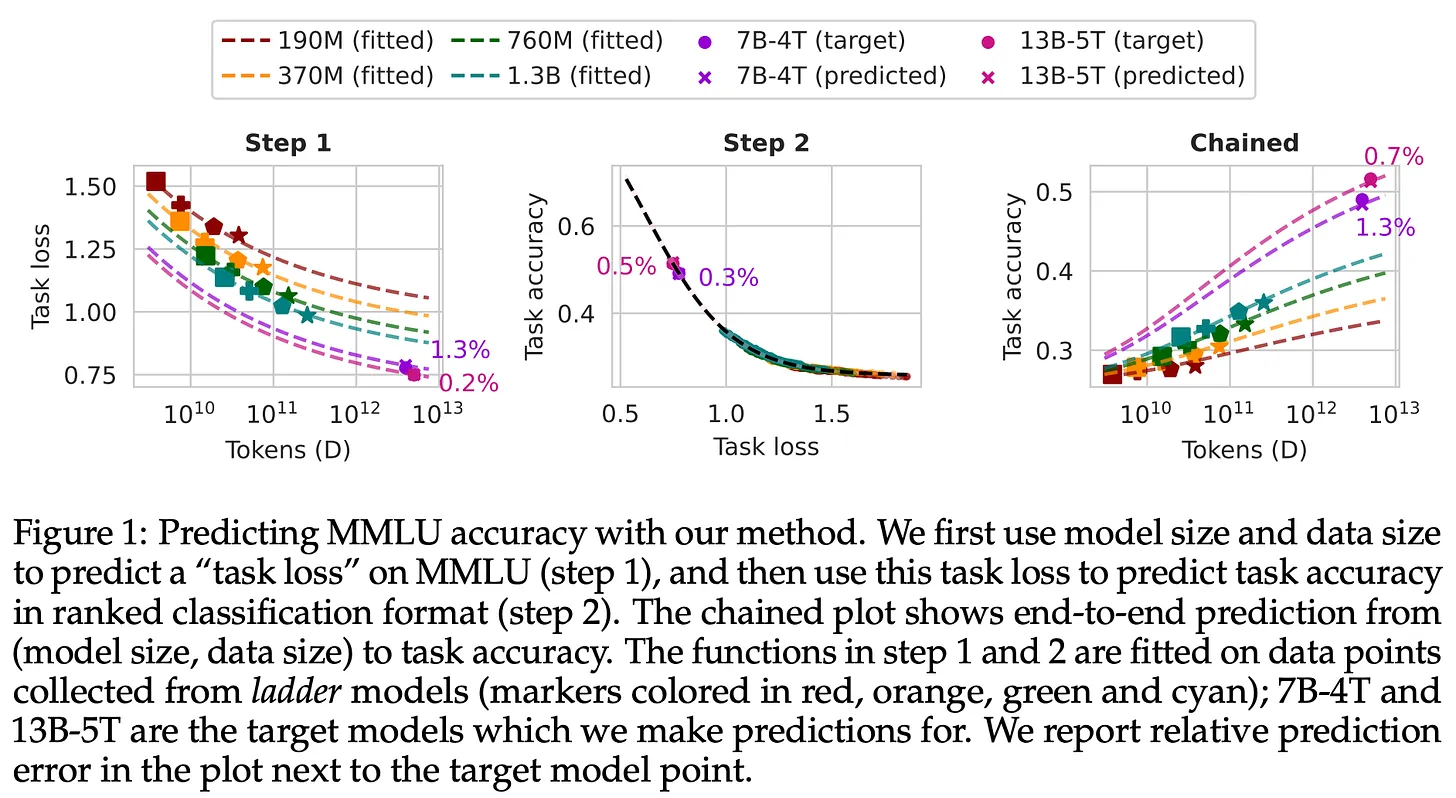

サイズの法則の実用化

大規模な事前学習が非常に有益であるという事実は、私たちに小さなジレンマを提示する。大量のデータに対して大規模なモデルをトレーニングすることで、最良の結果を得ることができる。しかし、このようなトレーニングは非常にコストがかかりつまり、多くのリスクを背負うことになる。期待に応えられないモデルのトレーニングに1,000万ドルを費やすとしたら?もし1,000万ドルをかけてトレーニングしたモデルが期待に応えられなかったとしたら?事前トレーニングのコストを考えると、モデル固有のチューニングを行うことはできない。あまりお金をかけずにモデルをチューニングし、そのパフォーマンスを予測する戦略を立てる必要がある。

(出典[11])。

- 様々なトレーニング設定を使って、小さなモデルをたくさんトレーニングする。

- スケール法則を小型モデルの性能に適合させる。

- サイズの法則を用いて、より大きなモデルのパフォーマンスを推測する。

もちろん、このアプローチには限界がある。小さなモデルから大きなモデルのパフォーマンスを予測することは難しく、不正確な場合もある。モデルはサイズによって挙動が異なる可能性がある。しかし、これをより実現可能にするために様々な方法が提案されており、現在ではこの目的のためにサイズ法則が一般的に使用されています。大きさの法則を使ってより大きなモデルの性能を予測できるようになったことで、研究者としての自信(と安心感)が増した。さらに、サイズの法則はAI研究への投資を正当化する簡単な方法を提供する。

スケールアップとプレトレーニング時代

「巨大なデータセットで訓練されたメガ・ニューラル・ネットワークだ。 - イリヤ・スーツケバー

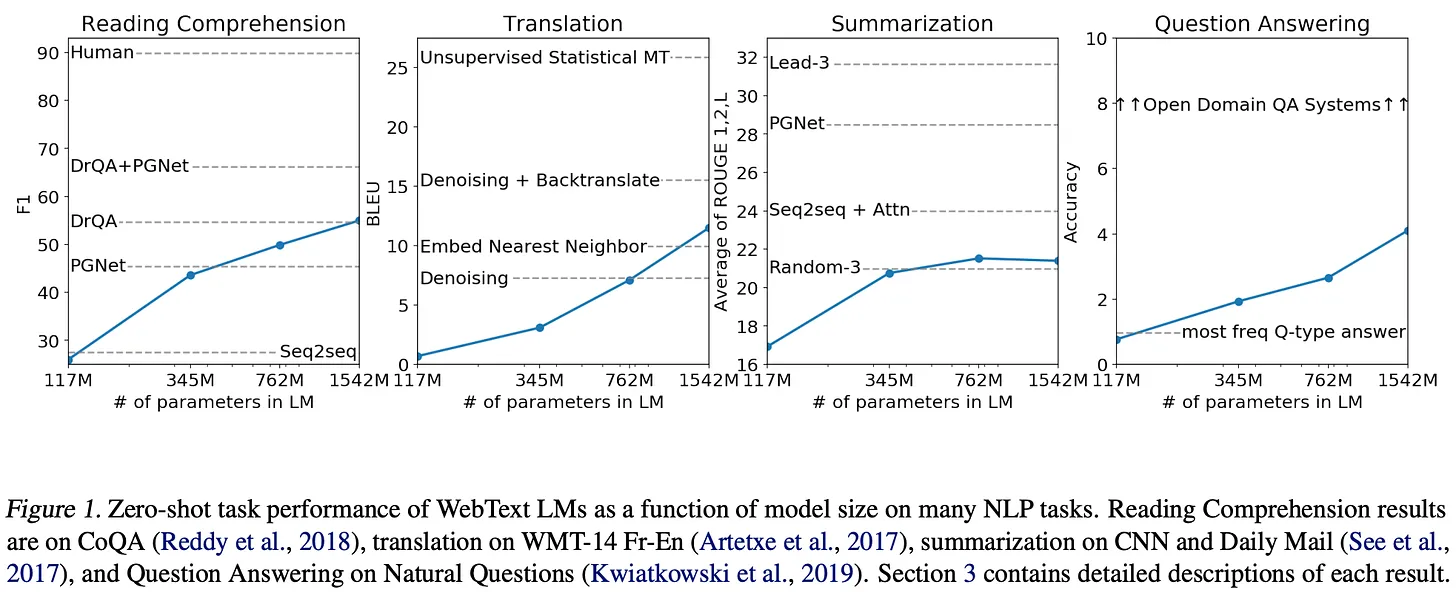

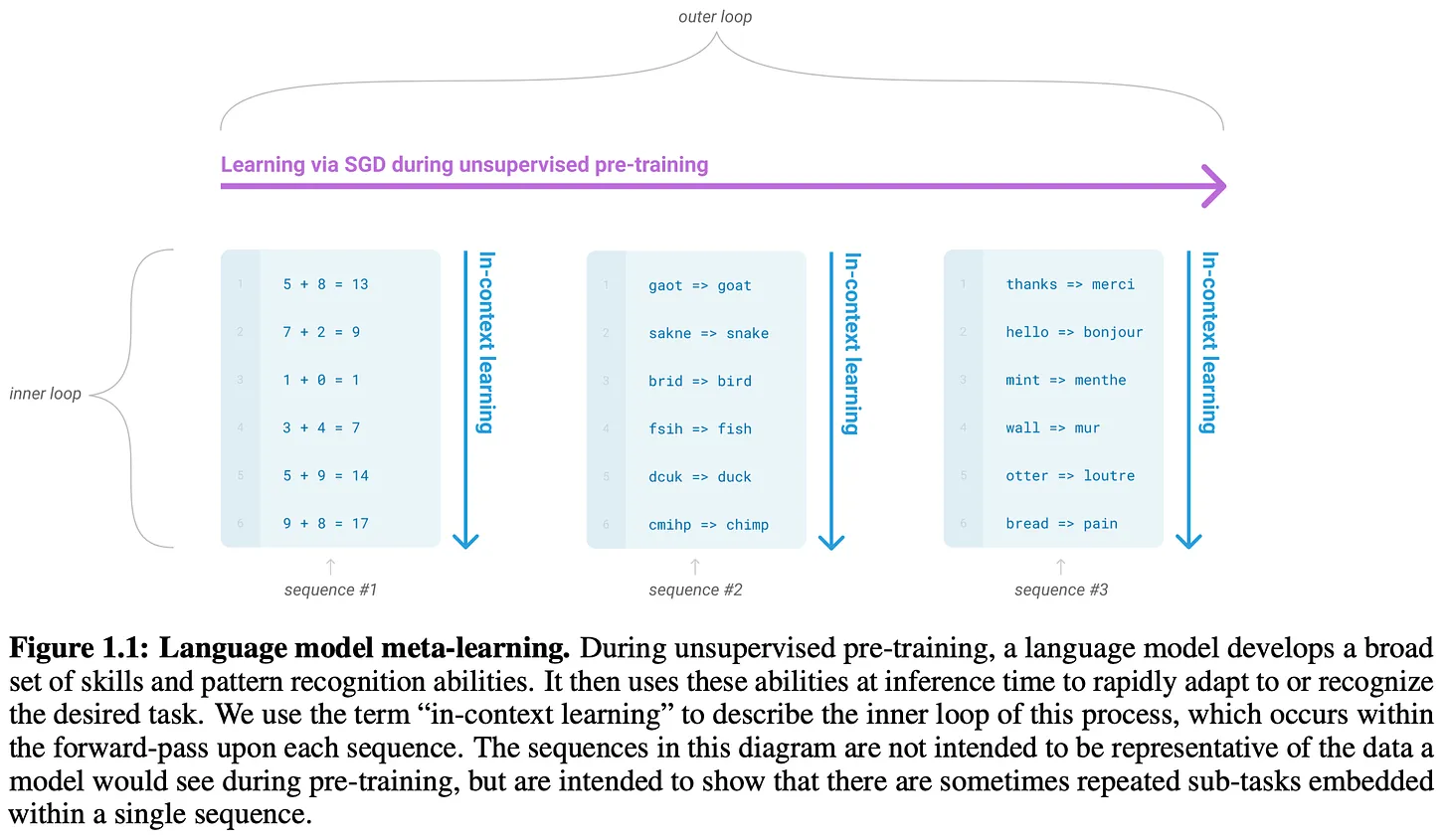

スケールの法則の発見は、大規模言語モデルの研究における最近の多くの進歩のきっかけとなった。より良い結果を得るためには、より大きな(そしてより良い!)データセットでモデルを訓練し、より大きなモデルを訓練する必要がある。 データセットでモデルを訓練し、より大きなモデルを訓練する必要がある。この戦略は、GPTファミリーのいくつかのモデルや、OpenAI以外のチームの有名なモデルのほとんどを作成するために使われてきました。ここでは、このスケーリング研究の進捗状況、つまり最近、イリヤ・スーツケバーは "プレトレーニングの時代 "と表現した。 5.

GPTシリーズ:GPT [2]、GPT-2 [3]、GPT-3 [4]、GPT-4 [5]。

大規模言語モデル スケールの法則の最も広く知られ、目に見える応用は、OpenAIのGPTモデルファミリーの作成である。ここでは主に、このシリーズの初期のオープンモデルであるGPT-3まで-だって:

- これらのモデルの詳細は、よりオープンに共有されている。

- その後のモデルは、プレトレーニングプロセスの拡張に加えて、ポストトレーニングリサーチの進歩の恩恵を受けている。

GPT-4のモデルなど、既知のスケーリング結果も紹介する。

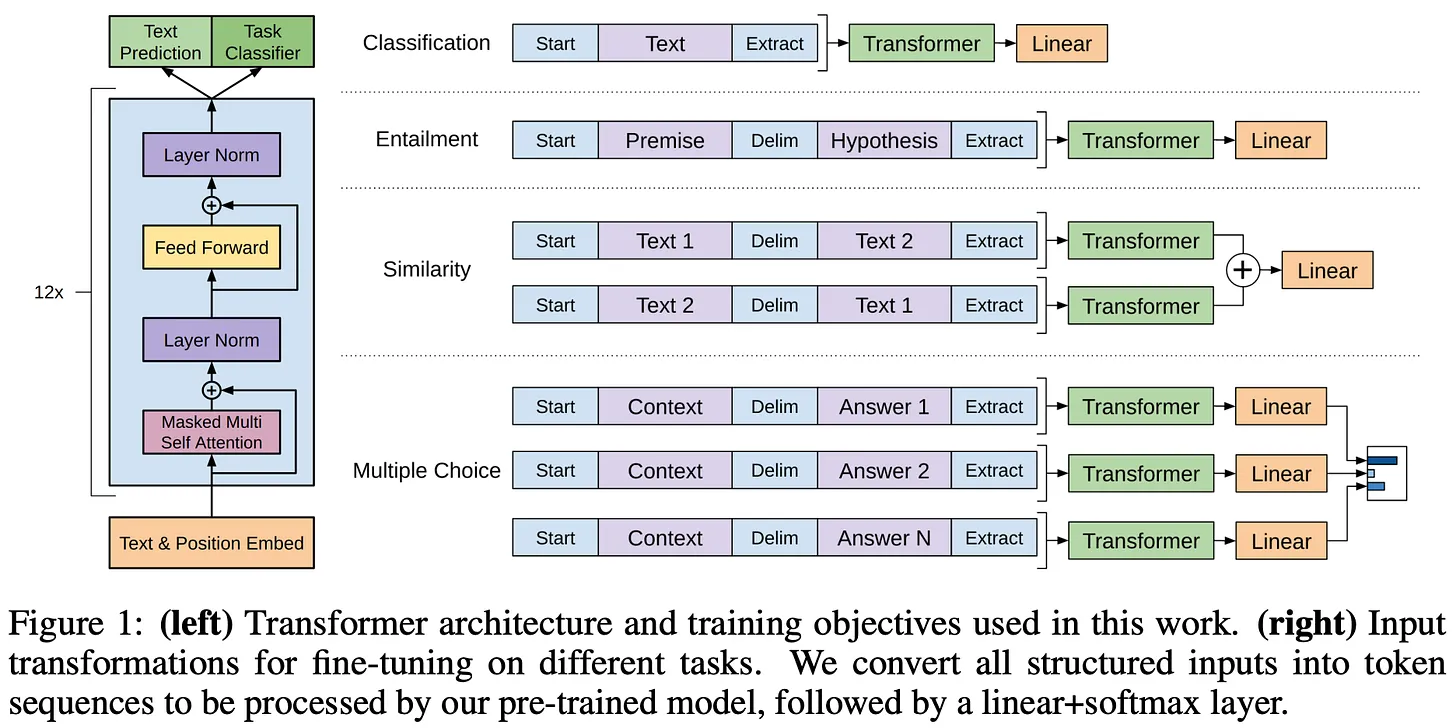

(出典[2])

- 平坦なテキストに対する自己教師による事前学習は非常に効果的である。

- 事前訓練には、長く連続したテキストを使うことが重要である。

- このように事前に訓練しておけば、個々のモデルを微調整して、さまざまな異なるタスクを最先端の精度で解くことができる6 。

全体として、GPTは特に注目すべきモデルではないが、より大きなスケールで同様のモデルを探求した後の研究(デコーダのみのTransformerや自己教師付き事前学習など)にとって重要な基礎を築いた。

(出典[3])

- これらのモデルは、WebTextで事前にトレーニングされている。 i) はBooksCorpusよりもはるかに大きい。 ii) インターネットからデータを取得して作成。

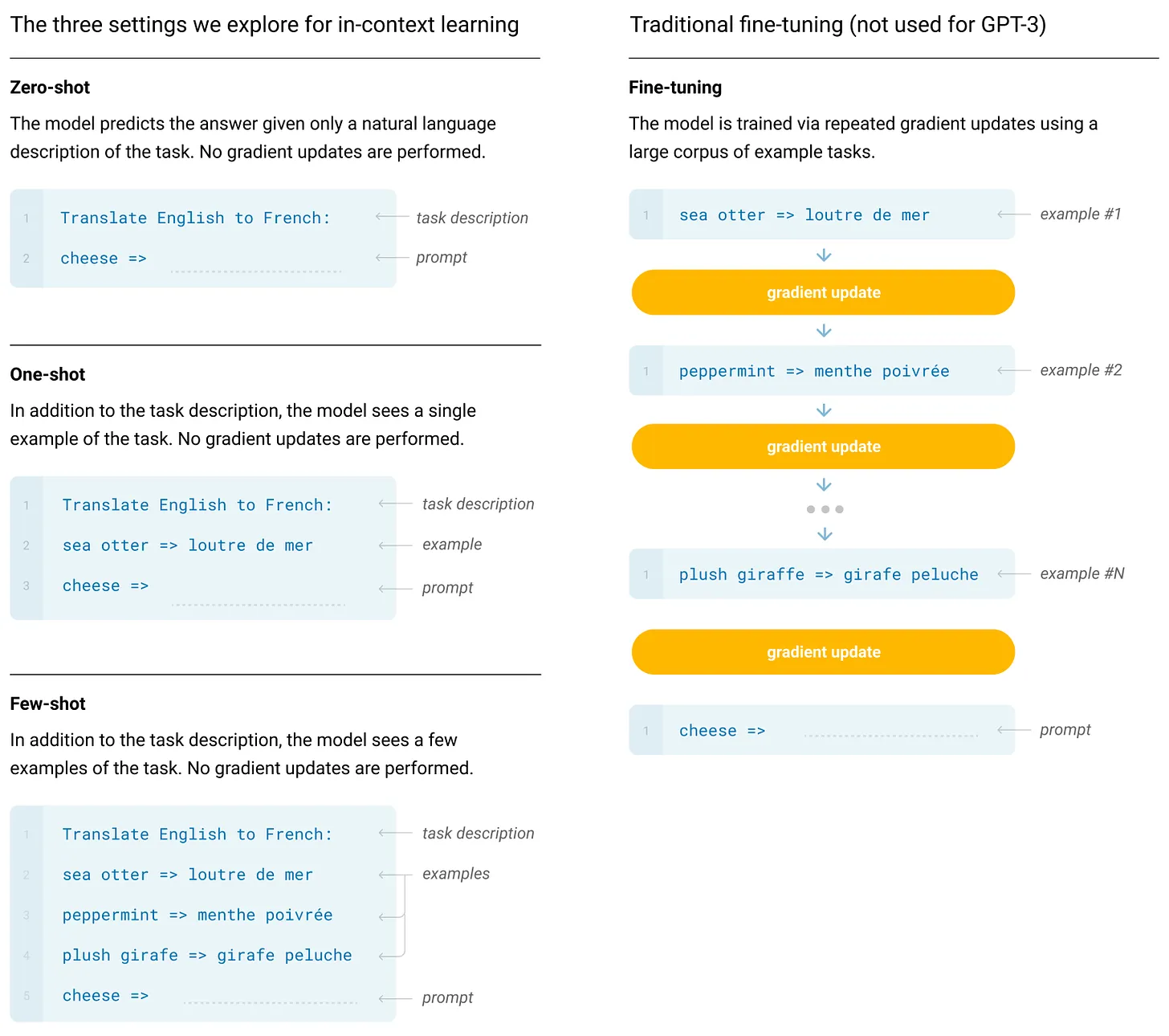

- これらのモデルは、下流のタスクのために微調整されることはない。その代わりに、事前に訓練されたモデルを用いてゼロサンプル推論7を行うことで、タスクを解決する。

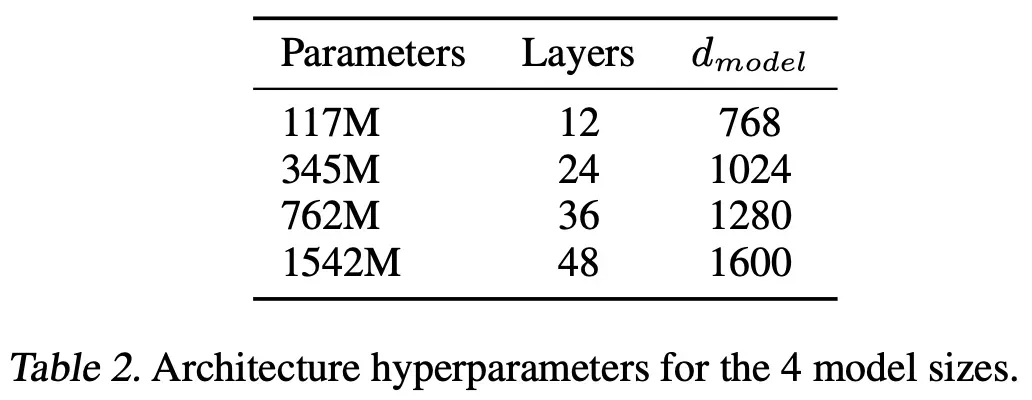

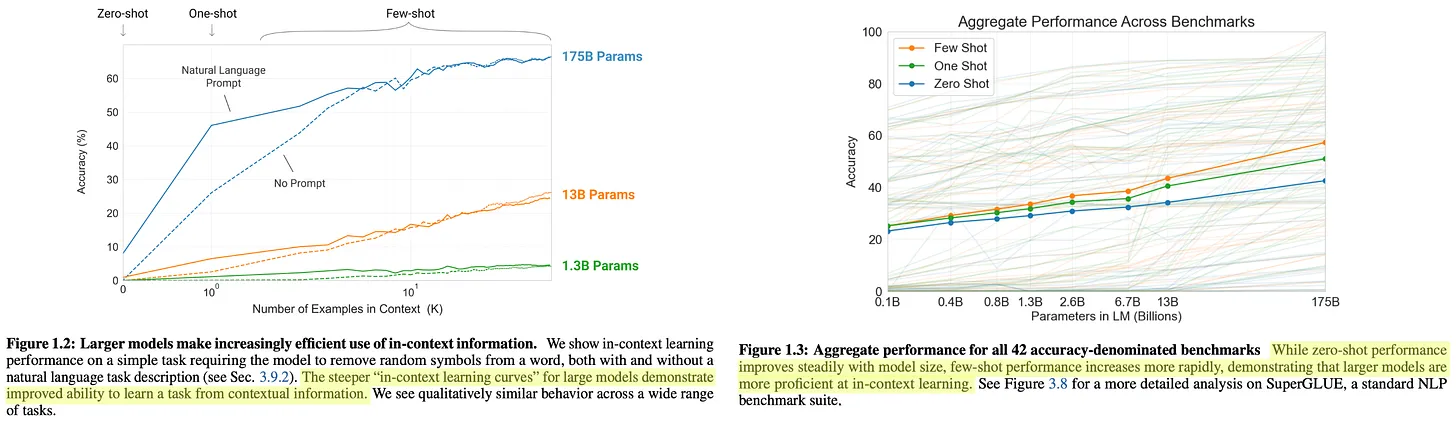

GPT-2モデルは、ほとんどのベンチマーク8で最先端の性能には達していませんが、モデルサイズが大きくなるにつれて一貫して性能が向上しています。モデルパラメーターの数を増やすことで、明確なメリットが得られる下記参照。

(出典[3])

"十分な能力を持った言語モデルは、その習得方法に関係なく、より良い予測をするために、自然言語シーケンスで示されるタスクを推測し、実行することを学習し始めるだろう。" - 出典[3]

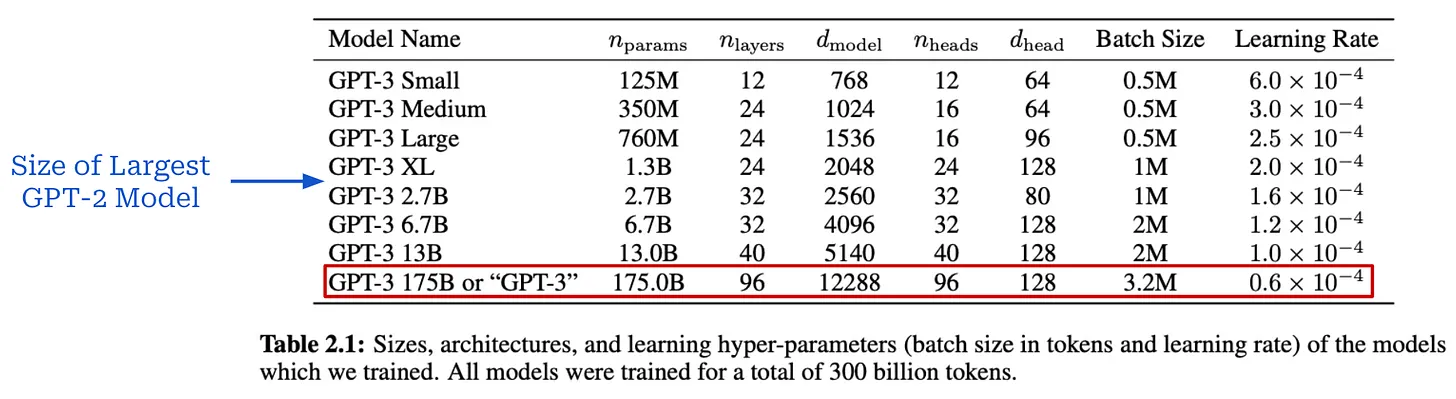

GPT-3 [4]は、大規模な言語モデルの大規模な事前トレーニングの利点を明確に示した、AI研究の分水嶺となる瞬間であった。1750億以上のパラメータを持つこのモデルは、最大のGPT-2モデルの100倍以上である。

(出典[4])

(出典[4])

(出典[4])

(出典[4])

(出典[4])

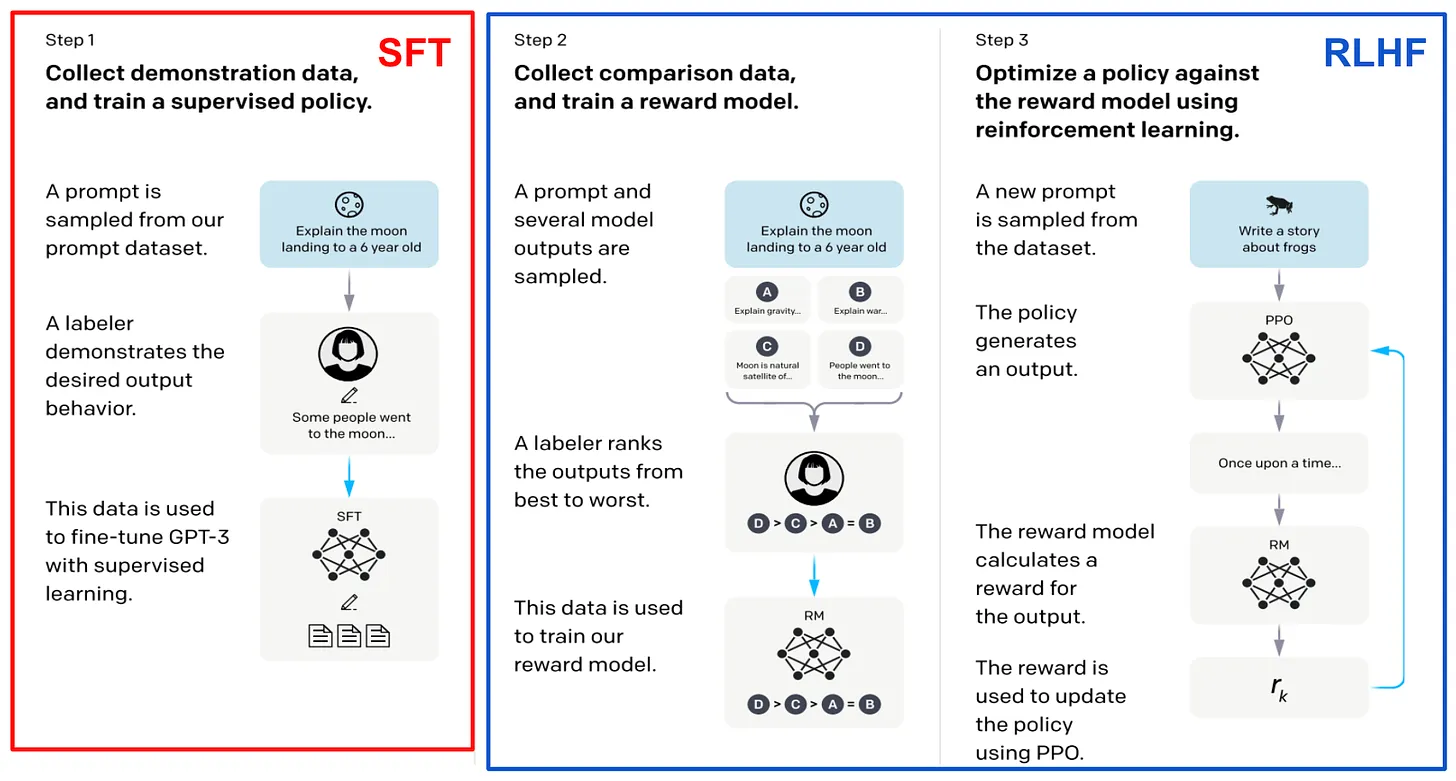

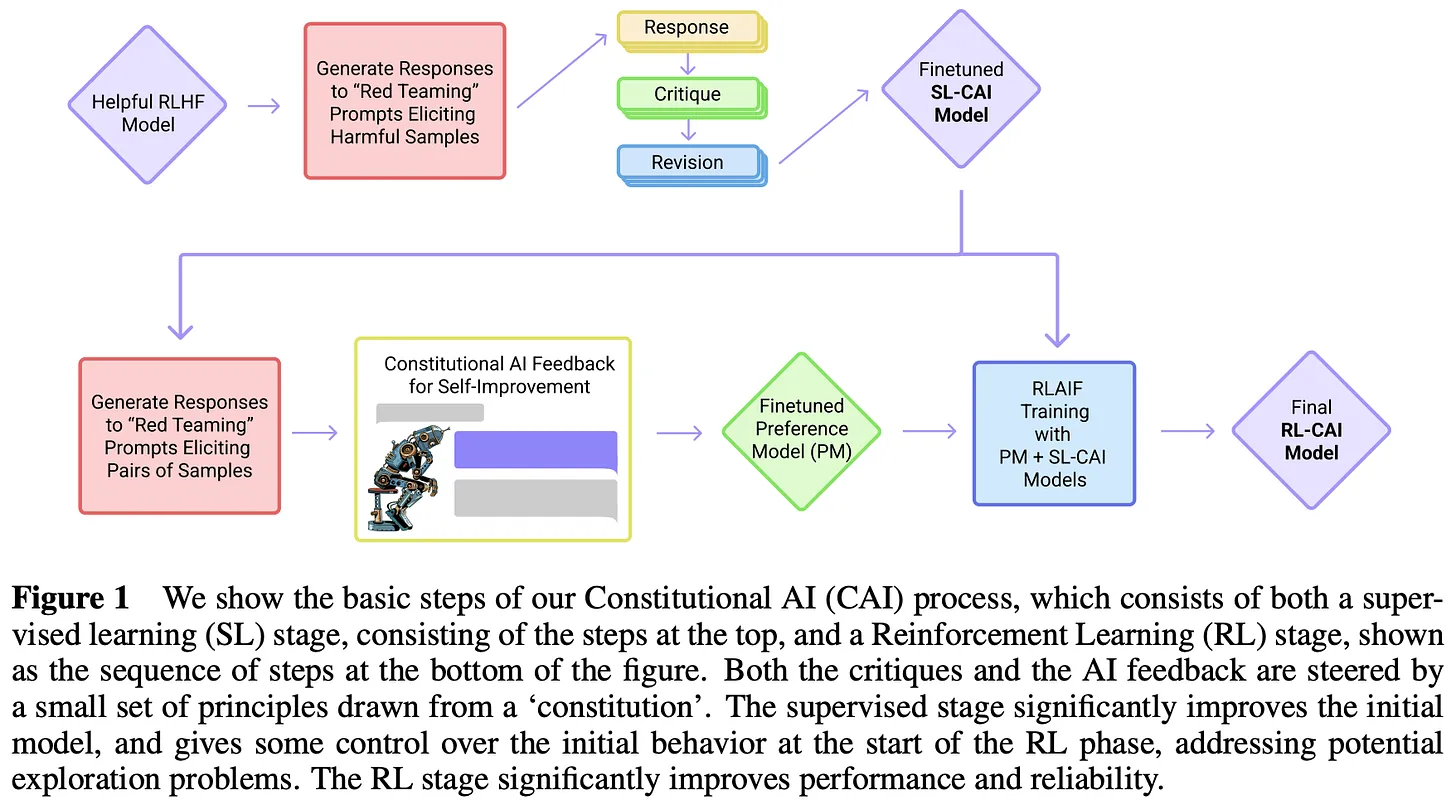

GPT-3の後。 GPT-3の印象的な性能は、大規模な事前学習を中心とした大規模言語モデルの研究に大きな関心を呼び起こしました。InstructGPT[8]、ChatGPT、GPT-4[5]。--大規模な事前学習と新しい事後学習技術(教師ありの微調整や人間のフィードバックからの強化学習)を組み合わせることで、大規模な言語モデルの品質が劇的に向上した。これらのモデルは非常に印象的であるため、AI研究に対する一般の人々の関心が急上昇しているほどである。

"GPT-4はTransformerベースのモデルであり、文書内の次のTokenを予測するように事前にトレーニングされている。" "ポストトレーニングのアラインメントプロセスは、要因性メトリックと望ましい動作への付着を改善する。" - 出典[5]

この時点で、OpenAIは彼らの研究についての詳細を公開し始めた。その代わりに、新しいモデルはAPIを通じてのみ公開され、これらのモデルがどのように作成されたかを一般に理解させないようにした。幸いなことに、OpenAIが公開している資料からいくつかの有益な情報を得ることができる。例えば、InstructGPT [8]- です。チャットGPT 先人-- このモデルのポストトレーニングストラテジーを詳細に記した関連論文がある。この論文でも、GPT-3がInstructGPTの基本モデルであると述べられていることから、このモデルの性能向上は、拡張された事前学習プロセスとはほとんど無関係であると推測するのが妥当である。

(出典[8])。

- GPT-4はトランスフォーマーをベースにしている。

- モデルは次のトークン予測を使って事前にトレーニングされる。

- 公開データおよびライセンスされたサードパーティデータの使用。

- モデルは人間のフィードバックから強化学習を使って微調整される。

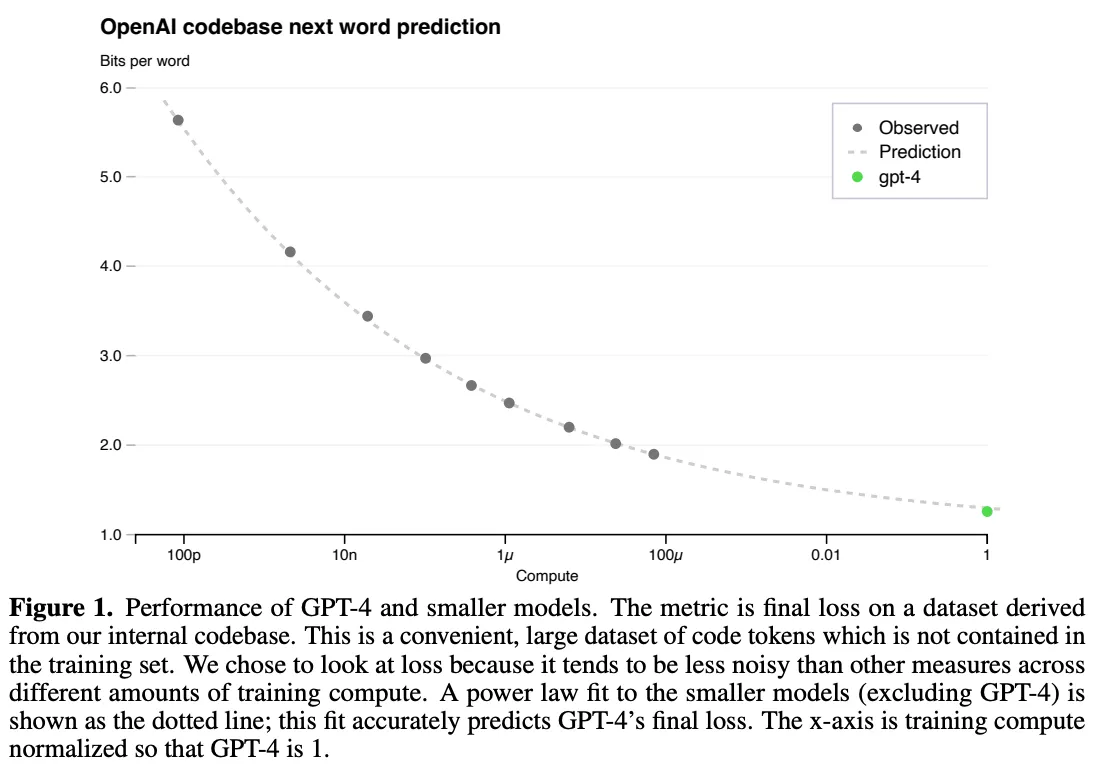

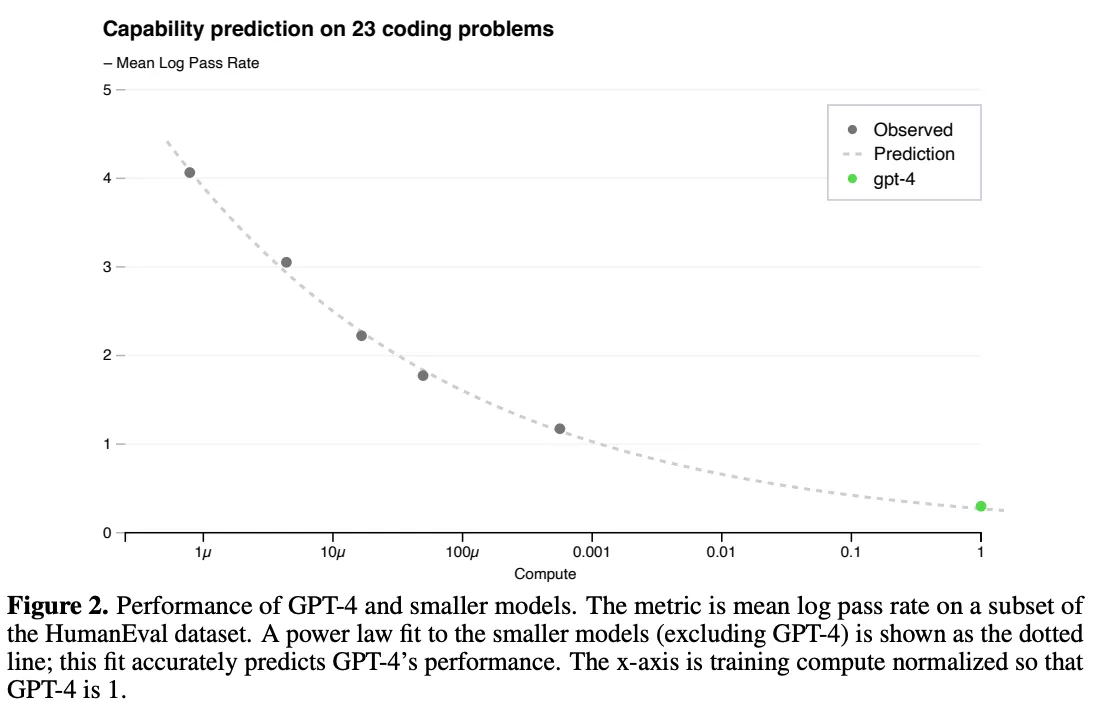

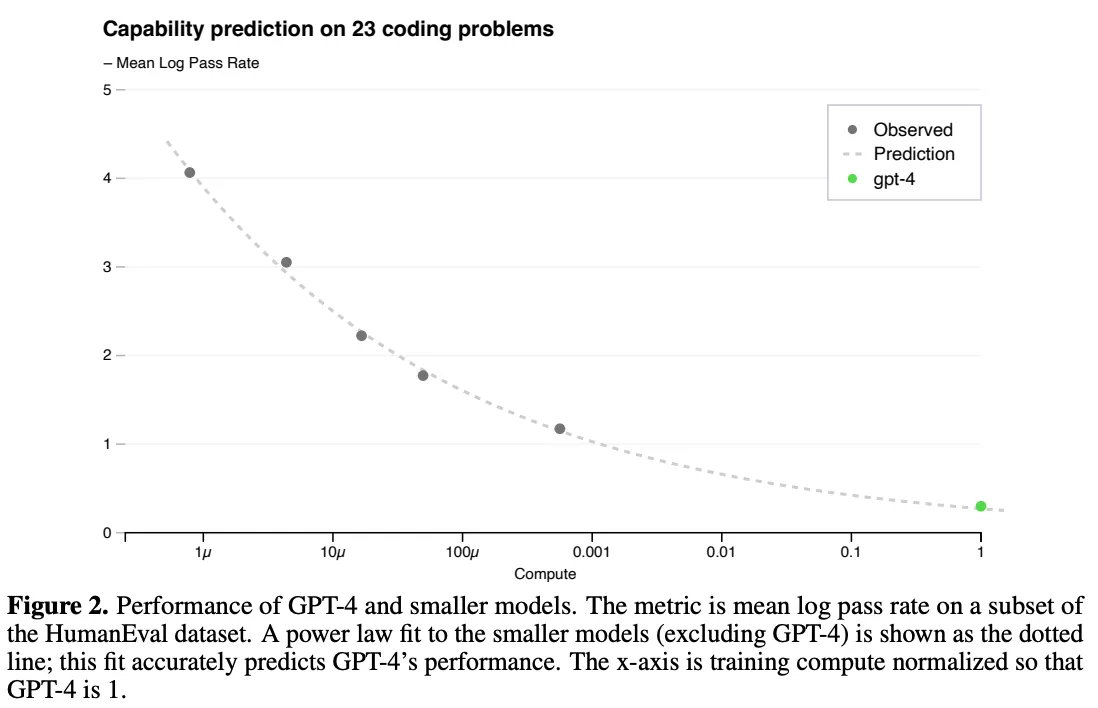

それにもかかわらず、スケーリングの重要性は、この技術報告書において非常に明白である。著者らは、この研究における重要な課題は、スケーラブルなトレーニング・アーキテクチャを開発することであり、そのアーキテクチャは異なるスケールで予測可能な性能を発揮する。 を自信を持ってトレーニングできるようにすることである。

"適切に訓練された大規模言語モデルの最終的な損失は......モデルの訓練に使われた計算量のべき乗則で近似できる" - 出典[5]

大規模な事前トレーニングは非常に高額なので、正しい結果を出すチャンスは通常1度しかない。モデル別調整の余地なし.このプロセスでは、サイズの法則が重要な役割を果たす。我々は、1,000~10,000分の1の計算回数でモデルを訓練し、その訓練結果を用いてべき乗則を当てはめることができる。そして、これらのべき乗則を用いて、より大きなモデルの性能を予測することができる。特に[8]では、GPT-4の性能が、計算量とテストロスの関係を測定するべき乗則を使用して予測されたことを確認しました。

GPT-4 トレーニングのスケール法則式(出典[5)

(出典[5])。

(出典[5])。

チンチラ。 計算上最適な大規模言語モデルのトレーニング [5]

(出典[9])

(出典[10])。

(出典[10])。

"必要と予想されるトレーニングデータの量は、現在大規模モデルのトレーニングに使用されているデータ量をはるかに上回る" - 出典[6]

チンチラ。6]の分析は、データサイズの重要性を強調している。最適なパフォーマンスを得るためには、大規模なモデルをより多くのデータでトレーニングする必要がある。この発見を検証するために、著者らはChinchillaと呼ばれる700億パラメータの大規模言語モデルを訓練した。この発見を検証するために、著者らはチンチラと呼ばれる700億パラメータの大規模言語モデルを訓練した。Chinchillaは、以前のモデルと比較して、より小さいが、より大きな事前学習データセットを持つ。合計1兆4000億トレーニング・トークンチンチラはGopher [10]と同じデータと評価戦略を使用している。Gopherより4倍小さいが、Chinchillaは常に大きなモデルを凌駕している。

(出典[6])

規模の法則の「終焉

スケールの法則は、AI研究において最近ホットな(そして議論を呼ぶ)トピックとなっている。この概要で見てきたように、プレトレーニングの時代には、スケールがAIの改善の大部分を牽引していた。しかし、2024年後半11 にモデルのリリースと改良のペースが鈍化するにつれ、モデルのスケーリングに対する疑問が広まり始めている。特に規模の法則--壁にぶつかっているのかもしれない。

- ロイター通信によると、OpenAIは製品戦略を転換している。

- インフォメーションによれば、GPTモデルの改良は減速し始めているという。

- ブルームバーグは、より強力なAIを作ろうとしているいくつかの最先端研究所が直面している困難を取り上げている。

- TechCrunchによれば、規模が大きくなればなるほど、その見返りは少なくなっていくという。

- タイム誌は、AI研究が停滞している様々な要因を強調するニュアンスの記事を掲載した。

- NeurIPS'24でイリヤ・スーツケバーは、「我々が知っているような事前トレーニングは終わるだろう」と言った。

一方で、多くの専門家は反対の意見を持っている。例えば、(アンソロピック CEO)は、「おそらく......続けるだろう」と語っている。そしてサム・アルトマンは説教を続ける。という言葉がある。このセクションでは、スケールの現状と存在する可能性のあるさまざまな問題について、情報に基づいた説明を提供することで、この議論にさらなる彩りを添えたい。

規模縮小:それは何を意味するのか?なぜそうなるのか?

「技術的なレベルでは、スケーリングはまだ機能している。ユーザーにとっては、改善のスピードが遅くなっている。" - ネイサン・ランバート

だから......。規模拡大は減速しているのか? 答えは複雑で、「減速」の正確な定義に大きく依存する。今のところ、この質問に対する私の最も妥当な答えは、どちらの答えも正しいというものだ。そのため、この質問に答えようとは思わない。その代わりに、このトピックで語られていることを深く掘り下げ、大規模言語モデルのスケーリングの現状(そして将来)について、よりニュアンスに富んだ理解を構築できるようにする。

規模の法則は何を物語っているのか?まず、サイズの法則の技術的定義を確認する必要がある。サイズの法則とは、大規模言語モデルの学習計算量(またはモデル/データセットサイズ)とテスト損失との関係をべき乗則に従って定義するものである。しかしこの関係はしばしば誤解されている。.計算量の対数成長から指数関数的な性能向上が得られるという考えは神話である。スケールの法則は、むしろ指数関数的な減衰に似ている。つまり、時間が経つにつれて、さらなる性能向上を得るためには、より努力しなければならなくなる。

(出典[5])。

"実務家は通常、モデル品質の代用として、複雑さ評価セットでの損失ではなく、下流のベンチマーク精度を使用する。" - 出典[7]

パフォーマンスを定義する。ビッグ・ランゲージ・モデルが改善されているかどうかは、どのように測定するのか? 規模の法則の観点から、大規模な言語モデルの性能は、通常、事前学習時のモデルのテスト損失によって測定されるが、大規模な言語モデルの能力に対するテスト損失の低下の効果は明らかではない。ロスの低減は下流タスクの精度向上につながるか?ロスの低減はビッグ・ランゲージ・モデルの新たな能力につながるのか? 規模の法則が教えてくれることと、私たちが実際に気にかけていることの間には断絶がある:

- サイズの法則は、事前学習のサイズを大きくすると、大規模な言語モデルのテスト損失がスムーズに減少することを教えてくれる。

- 私たちの関心事は、より大きな言語の「より良い」モデルを得ることである。

あなたが誰で、新しいAIシステムに何を期待するかにもよるが......。これらの新システムを評価するために使用した方法-は大きく異なるだろう。一般的なAIユーザーは、汎用的なチャット・アプリケーションに注目する傾向があり、実務家は、下流タスクにおける大規模な言語モデルのパフォーマンスを気にすることが多い。対照的に、最先端の研究室に所属する研究者は、AIシステムに高い(そして非常に具体的な)期待を寄せているようだ。例えば、博士論文の執筆や、高度な数学的推論問題の解決などである。評価するのが難しい幅広い能力を考えると、大規模言語モデルの性能を見る方法はたくさんある。

(出典[15])。

データの終焉大規模言語モデルの事前学習をスケールアップするためには、モデルとデータセットの両方のサイズを大きくする必要がある。初期の研究[1]では、データ量はモデルのサイズよりも重要ではないことが示唆されているようですが、Chinchilla [6]では、データセットのサイズも同様に重要であることが示されています。さらに、最近の研究によると、ほとんどの研究者はモデルを「過剰に訓練」することを好むようである。あるいは、チンチラの最適性を超えるサイズのデータセットで事前学習させる。-推論コストを節約するため[7]。

"スケールアップの研究では、最適な学習メカニズムを計算することに焦点が当てられることが多い......大きなモデルは推論にコストがかかるため、現在では小さなモデルを過剰に学習させることが一般的になっている" - 出典[7]

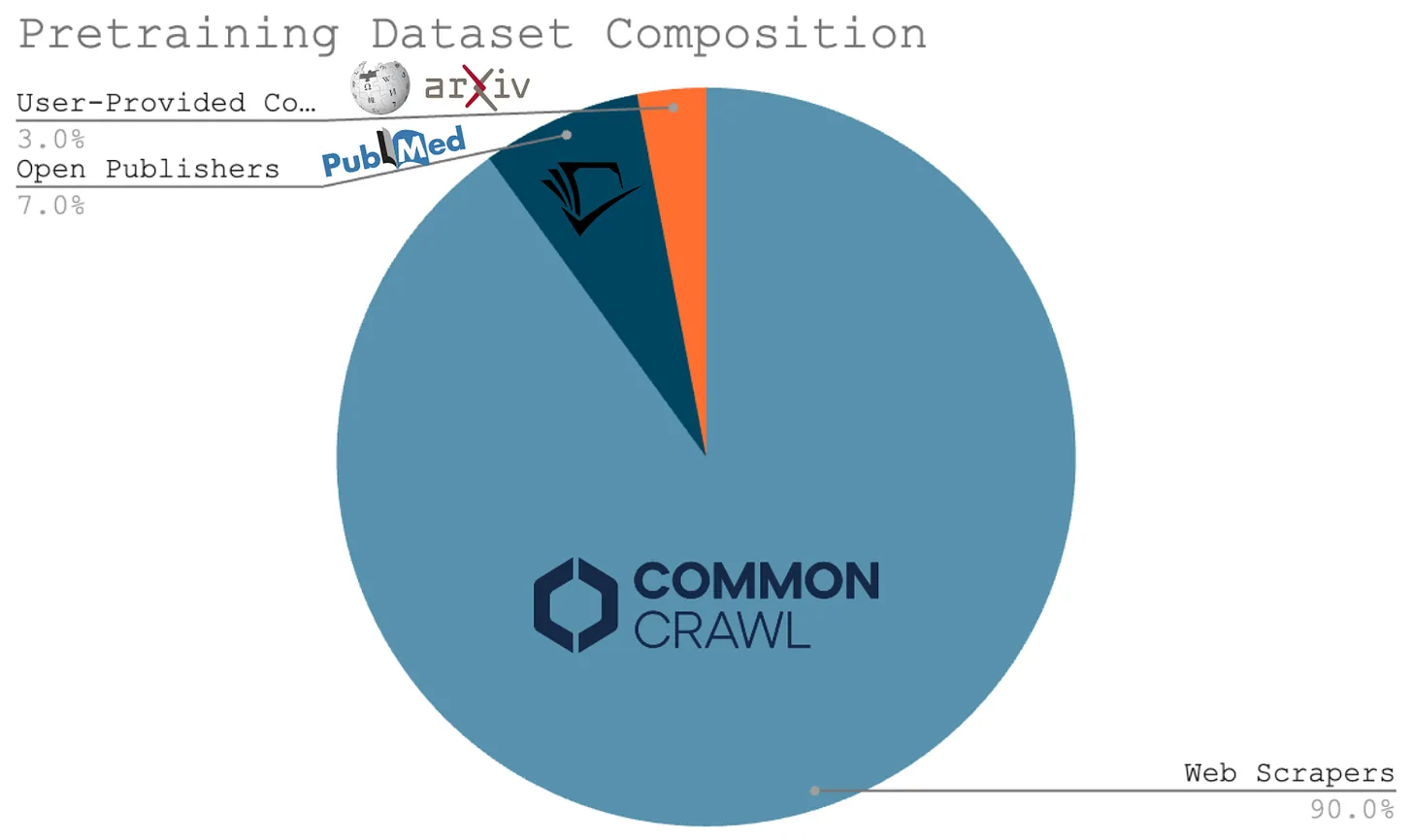

これらの研究はすべて、シンプルな結論に導いてくれる。ビッグ言語モデルの拡張 事前学習には、より大きな事前学習データセットを作成する必要があるこの事実は、大規模言語モデルの規模の法則に対する主な批判のひとつを構成している。この事実は、大規模言語モデルの規模の法則に対する主な批判のひとつを構成している。多くの研究者は、事前学習プロセスの規模を拡大し続けるにはデータが足りないのではないかと主張している。背景として、現在のビッグ・ランゲージ・モデルに使用されている事前学習データの大部分は、ウェブクローリングによって得られたものである。インターネットが1つしかないことを考えると、大規模で高品質な事前学習データの新しいソースを見つけるのは難しいかもしれません。

イリヤ・スーツケバーも最近、このような主張をしている。 i) コンピューティングは急速に成長しているが ii) ウェブクローリングに頼っているため、データは増えていない。その結果、いつまでも事前学習プロセスを拡大し続けることはできないと彼は主張する。私たちが知っているような事前訓練は終わりを迎え、AI研究が進歩するための新しい方法を見つけなければなりません。言い換えれば「データのピークに達した.

次世代プレトレーニングスケール

スケーリングは最終的に収穫逓増につながり、スケーリング継続に反対するデータ中心の議論は合理的で説得力がある。しかし、プレトレーニングプロセスを改善するための研究の方向性はまだいくつかある。

合成データ。事前学習プロセスを数桁スケールアップするためには、合成的に生成されたデータに頼る必要があるかもしれない。合成データへの過度の依存は多様性の問題につながるという懸念があるにもかかわらず[14]、大規模な言語モデルはますます増えている。そして、それは成功したようだ。--合成データを使用する [12]。さらに、コース学習[13]や継続的な事前学習ストラテジーは、事前学習データを調整することにより、様々な有意義な改善をもたらしている。例えば、データミックスを変更したり、事前学習の最後に指示データを追加したりする。

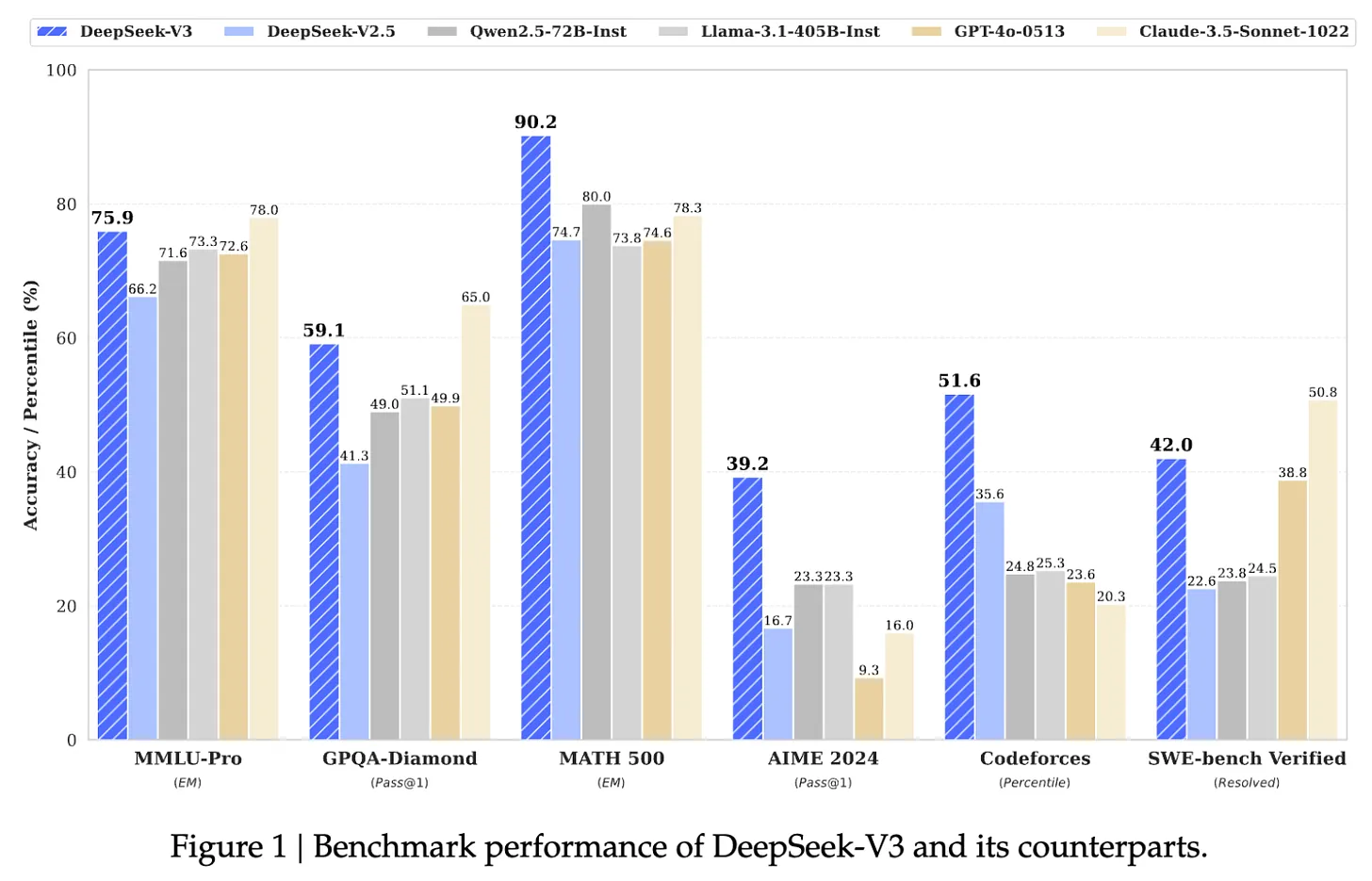

(出典[7])。

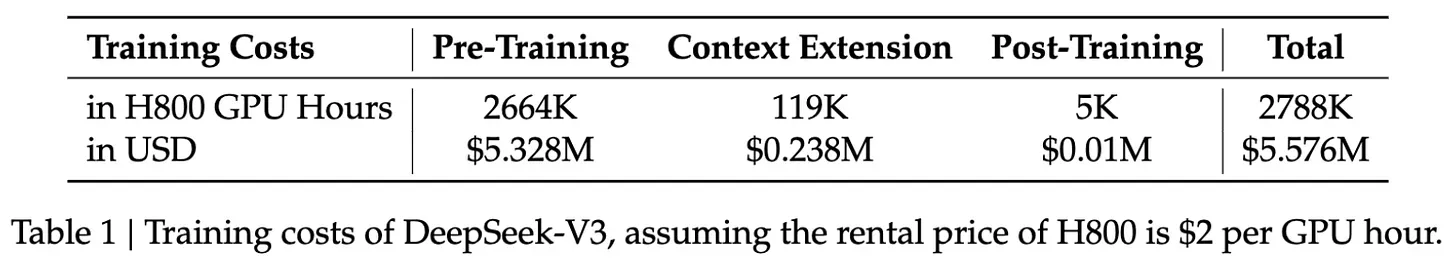

DeepSeek-v3。最近の議論にもかかわらず、大規模な言語モデルの事前学習プロセスを拡張することで、私たちは半強制的に進歩を見続けている。例えば、最近リリースされたDeepSeek-v3 [18]は、言語モデルの事前学習プロセスを拡張するものである。6710億パラメータ12 (MoE)モデル.オープンソースであることに加え、このモデルは14.8兆のTokenテキストで事前にトレーニングされ、GPT-4oとClaude-3.5-Sonnetの両方を上回った。参考までに、LLaMA-3モデルは15兆を超える生テキストデータでトレーニングされています。

(出典[18])。

- DeepSeek-v2から最適化されたMoEアーキテクチャ。

- ロードバランシングMoEのための新しい無援助損失戦略。

- トレーニングターゲットのマルチトークン予測。

- 長い思考連鎖モデルから推論能力を洗練させる(つまり、OpenAIのo1に似ている)。

このモデルはまた、人間の嗜好に合わせるために、教師ありの微調整や人間のフィードバックからの強化学習など、ポストトレーニングも行われた。

「DeepSeek-V3は、14.8兆個の高品質で多様なトークンで学習しました。回復不可能な損失スパイクは発生しませんでしたし、トレーニングプロセス全体を通してロールバックする必要もありませんでした。" - 出典[8]

しかし、DeepSeek-v3の素晴らしいパフォーマンスの最大の鍵は、事前学習スケールである。これは、同様に大規模なデータセットで訓練された大規模なモデルである。DeepSeek-v3は驚くほど安定した事前学習プロセスを持っており、非常に低コストで大規模な言語モデルの標準に従って学習されます!DeepSeek-v3は、驚くほど安定した事前学習プロセスを持っており、大規模言語モデル標準に従って合理的なコストで学習されます。これらの結果は、大規模な事前トレーニングは、時間の経過とともに管理しやすくなり、効率的になることを示唆している。.

(出典[18])。

- より大規模なコンピューティング・クラスター13。

- より多くの(より良い)ハードウェア。

- パワーがある。

- 新しいアルゴリズム(例えば、より大規模な分散トレーニング用など)。

次世代モデルのトレーニングは、単にGPUを増やすための資金を確保すればいいという問題ではなく、学際的なエンジニアリングの偉業なのだ。このような複雑な取り組みには時間がかかる。参考までに、GPT-4がリリースされたのは2023年3月で、GPT-3のリリースから3年近く経っている。特に33ヶ月.同じような時間軸で(それ以上でないとしても)、さらに10倍から100倍の規模の拡大が期待できる。

「規模が一桁大きくなるごとに、異なるイノベーションを見つけなければならない。 - エゲ・エルディル(エポックAI)

AI研究の未来

スケールの大きな事前トレーニングの現状を深く理解したところで、(純粋にこの議論のために)事前トレーニングの研究が突然壁にぶつかると仮定してみよう。近い将来、モデルの能力がまったく向上しなかったとしても、AI研究が急速に進化し続ける方法はいくつもある。これらのトピックのいくつか(合成データなど)についてはすでに述べた。このセクションでは、現在人気のある2つのテーマに焦点を当てる:

- 大規模言語モデルシステム/エージェント。

- 推論モデル。

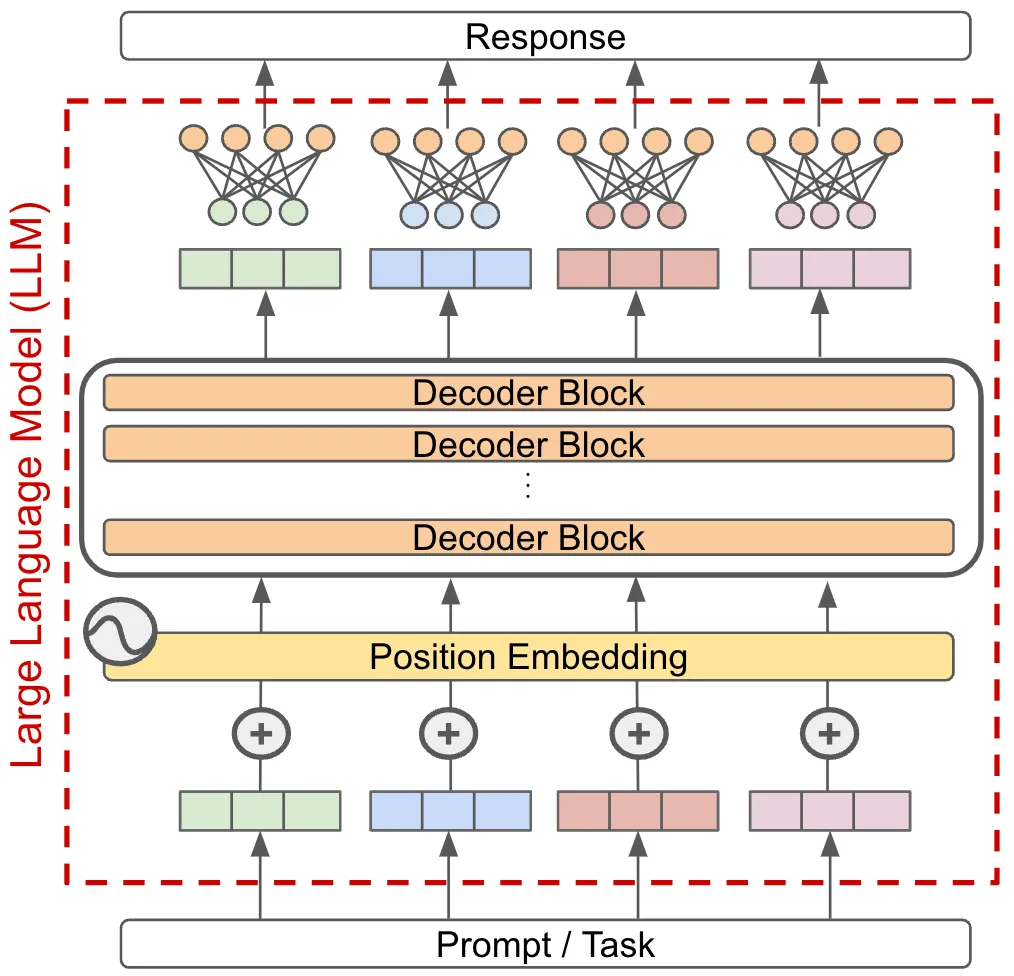

便利な大規模言語モデリングシステムの構築

今日、ビッグ・ランゲージ・モデルに基づくアプリケーションのほとんどは、単一モデル・パラダイムで実行される。つまり、一つのタスクを一つのビッグ・ランゲージ・モデルに渡し、そのタスクに対する答えとしてモデルの出力を直接使用することでタスクを解決します。

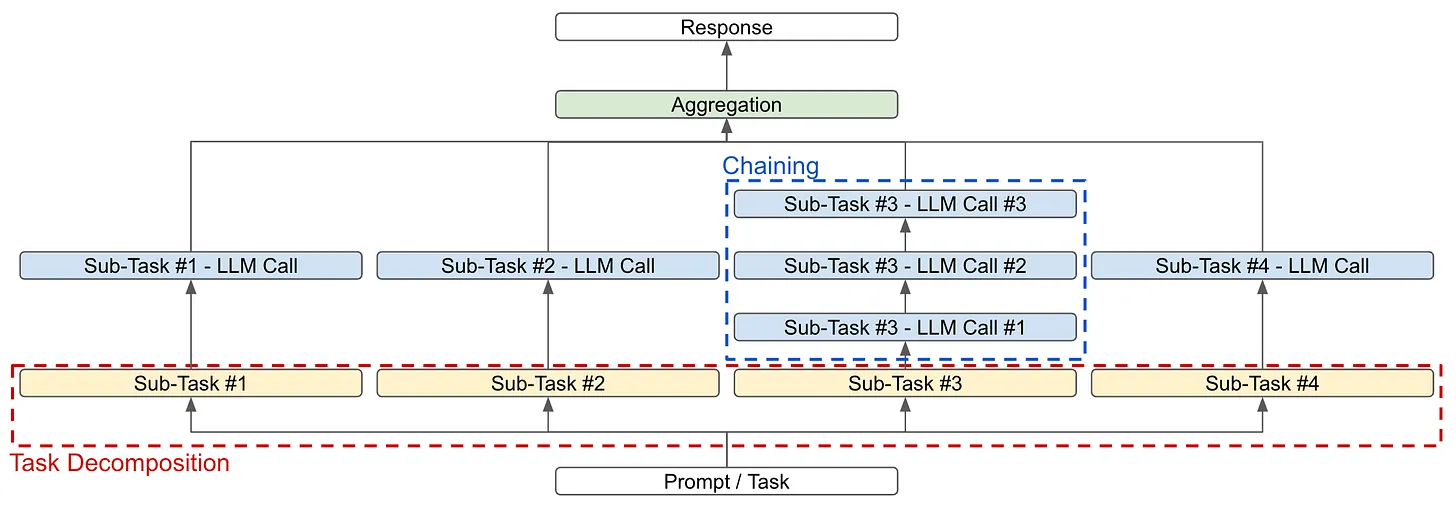

このようなシステムを改善したい(つまり、より難しいタスクをより高い精度で解決したい)場合、基礎となるモデルの能力を単純に向上させることができるが、このアプローチはより強力なモデルを作成することに依存する。その代わりに、複数の大規模言語モデルを組み合わせた大規模言語モデルに基づくシステムを構築することで、単一モデルのパラダイムを超えることができる。またはその他のコンポーネント-- 複雑な課題を解決する

大規模言語モデリングシステムの基礎。 ビッグ・ランゲージ・モデル・システムのゴールは、複雑なタスクを、ビッグ・ランゲージ・モデルや他のモジュールによってより簡単に解決できる小さなパーツに分解することです。この目標を達成するために使用できる主な戦略は2つある(上図):

- タスクの内訳タスク自体は、個々に解くことができる小さなサブタスクに分割され、後で集計14されて最終的な答えとなる。

- リンクタスクやサブタスクは、大規模な言語モデルを1回呼び出すのではなく、複数回連続して呼び出すことで解決します。

これらの戦略は、個別に使うこともできるし、組み合わせて使うこともできる。例えば、本を要約するシステムを作りたいとする。そのためには、まず本の各章を要約することでタスクを分解することができる。ここから次のことができる:

- タスクをさらに小さなテキストの塊に分解して要約する(つまり、再帰的/階層的分解に似ている)。

- 例えば、ある章に含まれる重要な事実や情報をすべて抽出し、別の章では、それらの重要な事実に基づいて、章の要約を作成する。

そして、ビッグ・ランゲージ・モデルが、小説全体の要約を形成するために、接続された章の要約を要約することによって、これらの結果を集約することができる。ほとんどの複雑なタスクは、簡単に解ける単純な部分に分解できるという事実が、このようなビッグ・ランゲージ・モデリング・システムを非常に強力なものにしている。より広範な分解と連結を行うと、これらのシステムは非常に複雑になり、応用AI研究の興味深い(そして影響力のある)分野となる。

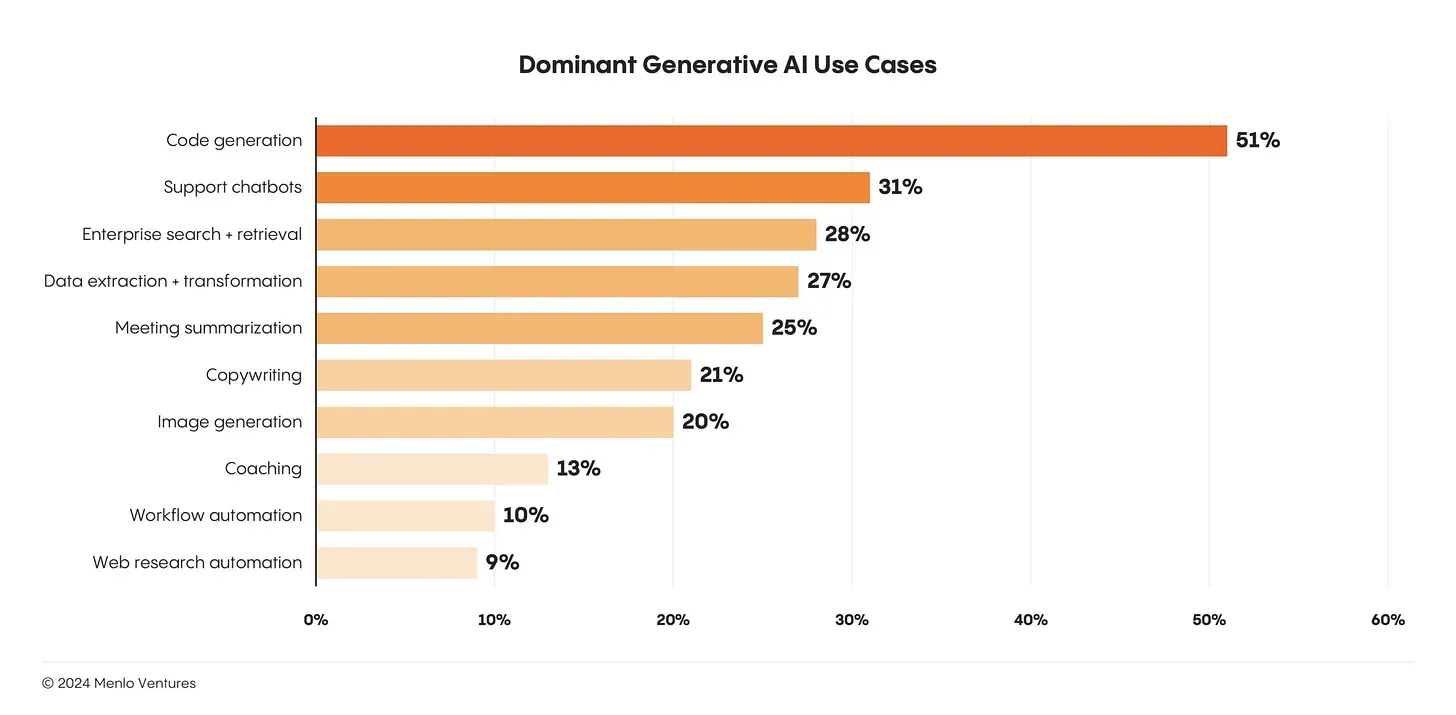

ビッグ・ランゲージ・モデルに基づく製品作り。ビッグ・ランゲージ・モデルの成功と人気にもかかわらず、ビッグ・ランゲージ・モデルの実際の(そして広く採用されている)ユースケースの数はまだ非常に少ない。今日、ビッグ・ランゲージ・モデルの最大のユースケースはコード生成とチャットであり、どちらもビッグ・ランゲージ・モデルの比較的明白なアプリケーションである15。

大規模な言語モデリングには、非常に多くの応用分野がある。大規模な言語モデルに基づいてより純粋に有用な製品を構築することは、応用AI研究の重要な分野である。.非常に強力なモデルはすでに利用可能だが、それを使って価値のある製品を作るのはまったく別の問題だ。この問題を解決するには、信頼性が高く強力な大規模言語モデリングシステムを構築する方法を学ぶ必要がある。

(出典[19])。

堅牢性は、より強力なビッグ・ランゲージ・モデル/エージェント・システムを構築する上で最大の障害のひとつである。ビッグ・ランゲージ・モデルに対して10種類の呼び出しを行うビッグ・ランゲージ・モデル・システムがあるとする。さらに、ビッグ・ランゲージ・モデルへの各呼び出しは95%の成功確率を持ち、正しい最終出力を生成するためにはすべての呼び出しが成功する必要があると仮定しよう。システムの個々のコンポーネントはそれなりに正確であるがしかし、システム全体の成功率は60%に過ぎない。!

(出典[20])。

(出典[20])。

推論モデルと新しいスケーリング・パラダイム

初期のビッグ・ランゲージ・モデルに対する一般的な批判は、単にデータを記憶するだけで、推論能力はほとんどないというものだった。しかし、大きな言語モデルには推論能力がないという主張は、ここ数年でほとんど否定された。私たちは最近の研究から、これらのモデルにはもともと推論する能力が備わっていたかもしれないが、この能力を引き出すためには適切な手がかりやトレーニング方法を用いなければならなかったことがわかっている。

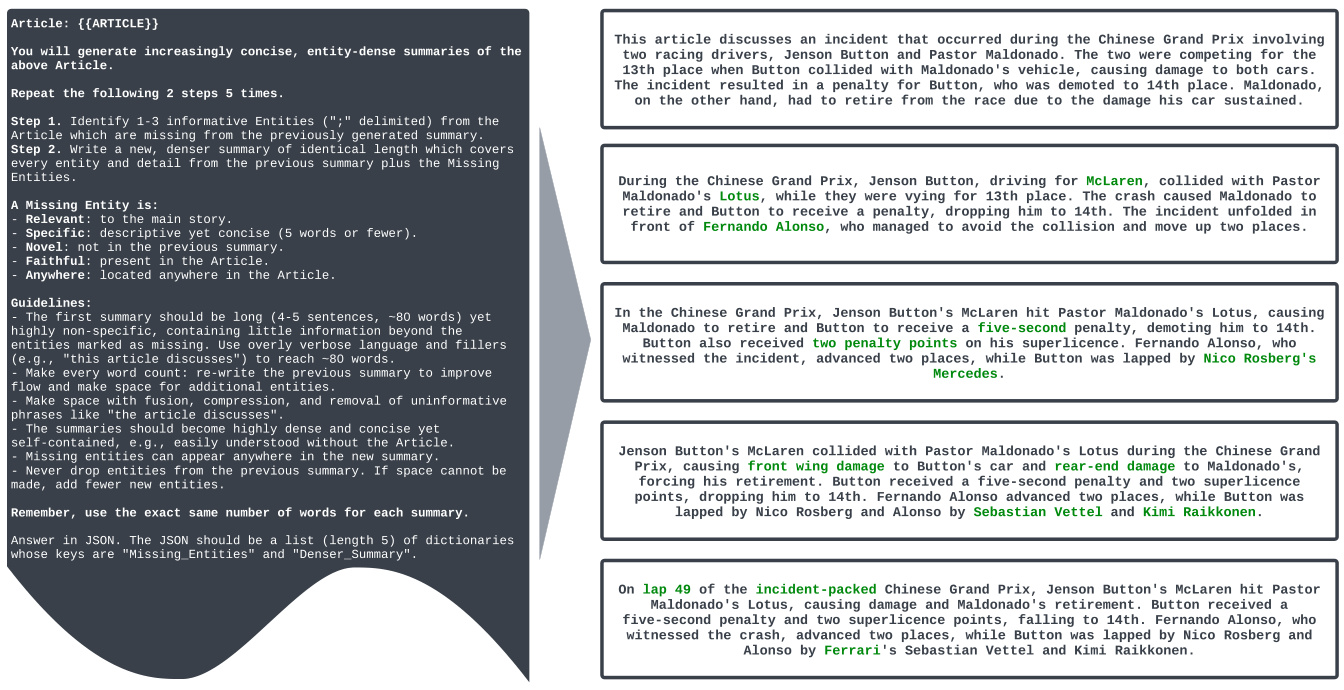

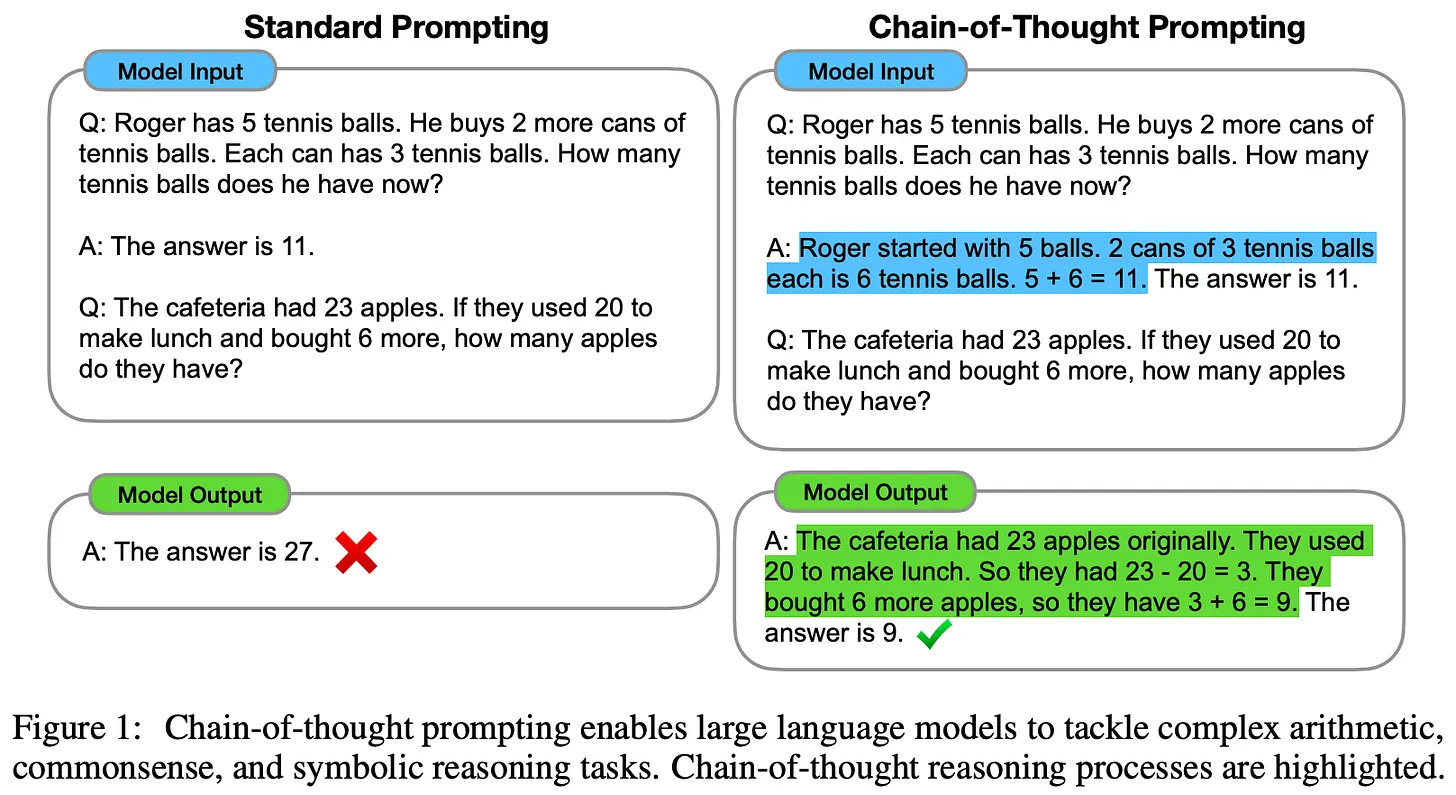

思考の連鎖(CoT)のヒント [22]は、大規模な言語モデルの推論能力を実証した最初の手法の一つである。この手法はシンプルで、手がかりベースである。実際の応答を生成する前に、ビッグ・ランゲージ・モデルにその応答の説明を求めるだけである。ビッグ・ランゲージ・モデルの推論力は、応答に到達するまでのステップ・バイ・ステップのプロセスを概説する根拠を生成することで、著しく向上する。さらに、このような説明は人間が読むことができ、モデルの出力をより解釈しやすくすることができます!

(出典[22])。

- クラス大の言語モデル - 判定評価モデルは通常、最終的な評価結果を生成する前に、スコアリングの基礎を提供する[23, 24]。

- より良い思考連鎖を書くために、より小さい/オープンな大規模言語モデルを教えるための、教師ありの微調整および命令チューニング戦略が提案されている[25, 26]。

- 大規模な言語モデルは、自身の出力について振り返り、コメントしたり、検証したりするよう求められることが多く、この情報に基づいて出力を修正する[12, 27]。

複雑な推論は活発な研究テーマであり、急速に進化している。大規模な言語モデルに(ステップレベルの)検証を推論プロセスに組み込むように教える新しいトレーニングアルゴリズム[28, 29]は、有望な結果を示しており、新しく優れたトレーニング戦略が利用可能になるにつれて、今後も改善が見られるだろう。

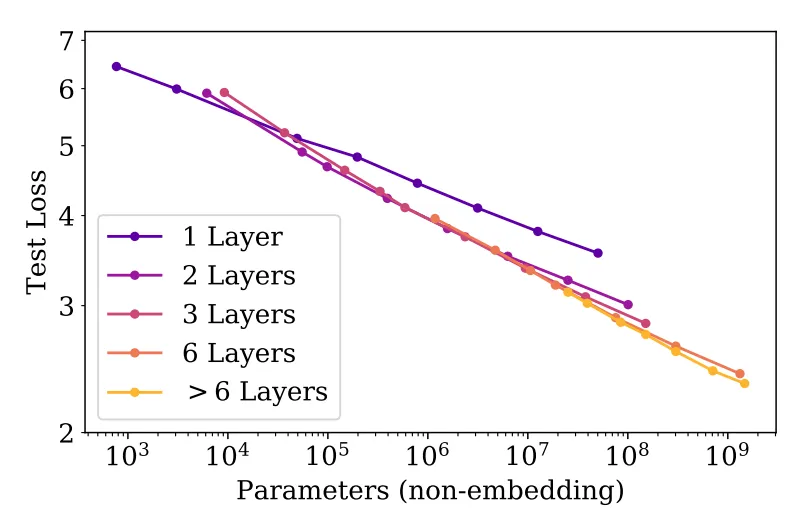

OpenAIのo1推論モデル [21]は、ビッグ・ランゲージ・モデルの推論能力を大きく飛躍させた。o1は、思考の連鎖に大きく基づいた推論戦略を使用する。人間が質問に答える前に考える方法と同様に、o1は応答を提供する前に「考える」時間を取る。実際、o1が生成する「思考」は、モデルが問題について考え、それをより単純なステップに分解し、問題を解決するためのさまざまなアプローチを試し、さらには自らの間違いを修正するために使用する、思考の長い連鎖にすぎない16。

"オープンエーアイのo1は、強化学習を使って複雑な推論を行うように訓練された新しい大規模言語モデルである。" - 出典[21]

o1の正確なトレーニング戦略の詳細は公開されていない。しかし、o1は「大規模な強化学習」アルゴリズムを使用して推論を学習し、「データを非常に効率的に使用」し、有用な思考の連鎖を生成するモデルの能力を向上させることに重点を置いていることは分かっている。OpenAIの研究者からの公開コメントやo1に関する最近の声明によると、このモデルは純粋な強化学習を使って学習されたようで、o1が推論に何らかのツリー探索を使っているのではないかという以前の指摘とは矛盾している。

推論の多いタスクにおけるGPT-4oとo1の比較 (出典[21])

- Codeforcesの競争的プログラミング問題でトップ89%。

- アメリカ数学オリンピック(AIME)の予選で全米上位500人に入る。

- 大学院レベルの物理学、生物学、化学の問題(GPQA)において、人間の博士課程学生の精度を上回る。

(出典[22])。

"o1の成績は、強化学習(トレーニング中に計算)と思考時間(テスト中に計算)を増やすことで向上し続けることがわかった。" - 出典[22]

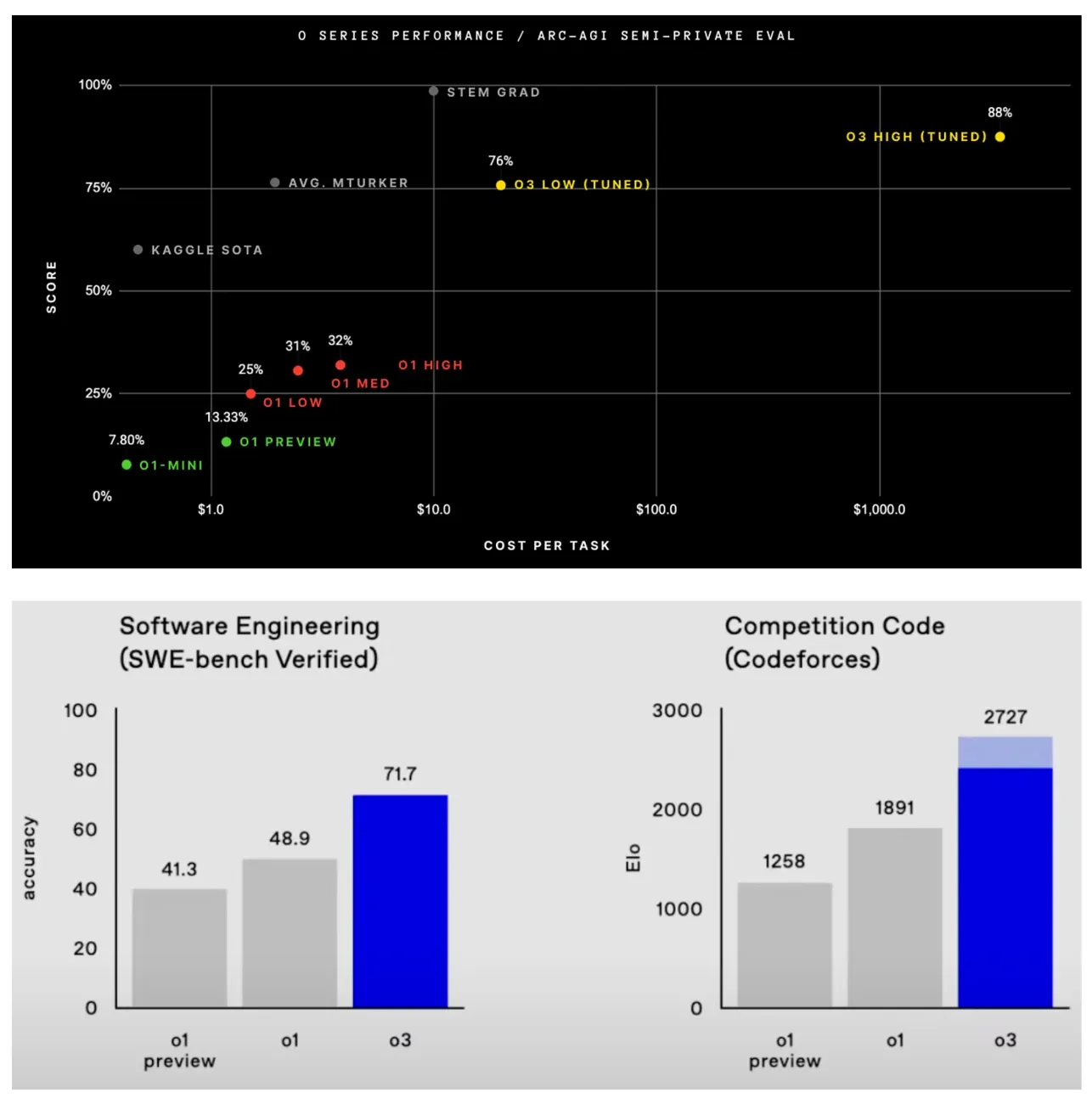

同様に、上のグラフを見ると、強化学習による訓練に多くの計算量を投入するほど、o1の性能が滑らかに向上していることがわかる。これはまさにo3の推論モデルを作成するために踏襲されたアプローチである。このモデルは2024年末にOpenAIによって評価されており、o3についての詳細はほとんど公開されていない。しかし、このモデルがo1のすぐ後(つまり3ヶ月後)にリリースされたことを考えると、o3はo1の「スケールアップ版」であり、強化学習に多くの計算が割かれている可能性が高い。

この記事を書いている時点では、o3モデルはまだリリースされていないが、o1を拡張することによって達成された結果は印象的である(場合によっては衝撃的である)。o3の最も注目すべき成果を以下に挙げる:

- o3 は、ARC-AGI で人間レベルの 85% を超えた最初のモデルです。このベンチマークは AGI の「北極星」と評され、5 年以上無敗を続けています17 。

- SWE-Bench Verifiedで71.7%の精度、Codeforcesで2727のEloスコアにより、o3は世界のトップ200人の競技プログラマーに入る。

- エポック社のFrontierMathベンチマークで25.2%の精度を示した。従来の2.0%より精度が向上。このベンチマークはテレンス・タオによって "極めて難しい "と評され、"少なくとも数年間は "AIシステムでは解けない可能性が高い。このベンチマークは、テレンス・タオによって「極めて困難」であり、「少なくとも数年間は」AIシステムによって解けない可能性が高いと説明された。

o3-miniと呼ばれるo3のライト版もプレビューされたが、これは非常に性能がよく、計算効率が大幅に改善されている。

(出典[21]および 以下は)

- トレーニング時間(集中学習)の計算。

- 推論するときに計算する。

o1スタイルのモデルのスケーリングは、従来のサイズの法則とは異なる。事前学習プロセスをスケールアップする代わりに、事後学習と推論にかける計算量をスケールアップするのだ。スケーリングのまったく新しいパラダイムだ。これまでのところ、推論モデルを拡張することで得られた結果は非常に良好である。このような発見は、事前学習以外の拡張の道が明らかに存在することを示唆している。推論モデルの出現によって、私たちは次の山を発見した。それはさまざまな形で現れるかもしれないが規模がAI研究の進歩を促進し続ける.

結語

スケールの法則、大規模言語モデルへの影響、そしてAI研究の将来の方向性について、我々はより明確なイメージを持つことができるようになった。我々が学んだように、スケールの法則に対する最近の批判には多くの要因がある:

- 規模の法則の自然減衰。

- 大規模な言語モデリングにおける能力への期待はかなり異なる。

- 大規模で学際的なエンジニアリング作業の遅れ。

これらは正当な質問である。しかし、いずれもスケーリングが期待通りに機能していないことを示していない.大規模な事前トレーニングへの投資は今後も続けられる(そして続けるべき)だろうが、時間の経過とともに改善はますます難しくなるだろう。その結果、他の開発方向(エージェントや推論など)がより重要になるだろう。しかし、スケーリングという基本的な考え方は、これらの新しい研究分野に投資する際にも大きな役割を果たし続けるだろう。スケーリングを続けるかどうかは問題ではない。本当の問題は、次に何を広げるかだ.

書誌

[1] Kaplan, Jared, et al. "Scaling laws for neural language models". arXiv preprint arXiv:2001.08361 (2020).[2] Radford, Alec. "Improving language understanding by generative pre-training." (2018).[3] Radford, Alec, et al. "Language models are unsupervised multitask learners.". OpenAIブログ 1.8 (2019): 9.[4] Brown, Tom, et al. "Language models are few-shot learners.". 神経情報処理システムの進歩 33 (2020): 1877-1901.[5] Achiam, Josh, et al. "Gpt-4 technical report". arXiv preprint arXiv:2303.08774 (2023).[6] Hoffmann, Jordan, et al. "Training compute-optimal large language models". arXiv preprint arXiv:2203.15556 (2022).[7] Gadre, Samir Yitzhak, et al. "Language models scale reliably with over-training and on downstream tasks.". arXiv preprint arXiv:2403.08540 (2024).[8] Ouyang, Long, et al. "Training language models to follow instructions with human feedback.". 神経情報処理システムの進歩 35 (2022): 27730-27744.[9] Smith, Shaden, et al. "Using deepspeed and megatron to train megatron-turing nlg 530b, large-scale generative language model.". arXiv preprint arXiv:2201.11990 (2022).[10] Rae, Jack W., et al. "Scaling language models: methods, analysis & insights from training gopher.". arXiv preprint arXiv:2112.11446 (2021).[11] Bhagia, Akshita, et al. "Established Task Scaling Laws via Compute-Efficient Model Ladders.". arXiv preprint arXiv:2412.04403 (2024).[12] Bai, Yuntao, et al. "Constitutional ai: Harmlessness from ai feedback.". arXiv preprint arXiv:2212.08073 (2022).[13] ブレイクニー コーディ"あなたのデータは喜びを呼び起こしますか? トレーニング終了時のドメインアップサンプリングによるパフォーマンス向上". arXiv preprint arXiv:2406.03476 (2024).[14] Chen, Hao, et al. "On Diversity of Synthetic Data and its Impact on Training Large Language Models". arXivプレプリント arXiv:2410.15226 (2024).[15] Guo, Zishan, et al. "Evaluating large language models: A comprehensive survey(大規模言語モデルの評価:包括的調査)". arXiv preprint arXiv:2310.19736 (2023).[16] Xu, Zifei, et al. "Scaling laws for post-training quantized large language models". arXiv preprint arXiv:2410.12119 (2024).[17] Xiong, Yizhe, et al. "Temporal scaling law for large language models". arXiv preprint arXiv:2404.17785 (2024).[18] DeepSeek-AI et al. "DeepSeek-v3 Technical Report."。 https://github.com/deepseek-ai/DeepSeek-V3/blob/main/DeepSeek_V3.pdf (2024).[19] Schick, Timo, et al. "Toolformer: language models can teach themselves to use tools." arXiv preprint arXiv:2302.04761 (2023).[20] Welleck, Sean, et al. "From decoding to meta-generation: Reference-time algorithms for large language models". arXiv preprint arXiv:2406.16838 (2024).[21】OpenAIら "Learning to Reason with LLMs". https://openai.com/index/learning-to-reason-with-llms/ (2024).[22] Wei, Jason, et al. "Chain-of-thought prompting elicits reasoning in large language models". 神経情報処理システムの進歩 35 (2022): 24824-24837.[23] Liu, Yang, et al. "G-eval: Nlg evaluation using gpt-4 with better human alignment". arXiv preprint arXiv:2303.16634 (2023).24] Kim, Seungone, et al. "Prometheus: Inducing fine-grained evaluation capability in language models." [24] Kim, Seungone, et al. 第12回学習表現国際会議 . 2023.[25] Ho, Namgyu, Laura Schmid, and Se-Young Yun. "Large language models are reasoning teachers.". arXiv preprint arXiv:2212.10071 (2022).[26] Kim, Seungone, et al. "The cot collection: Improving zero-shot and few-shot learning of language models via chain-of-thought fine-tuning.". arXiv preprint arXiv:2305.14045 (2023).[27] Weng, Yixuan, et al. "Large language models are better reasoners with self-verification". arXiv preprint arXiv:2212.09561 (2022).[28] Lightman, Hunter, et al. "Let's verify step by step.". arXiv preprint arXiv:2305.20050 (2023).[29] Zhang, Lunjun, et al. "Generative verifiers: reward modelling as next-token prediction". arXiv preprint arXiv:2408.15240 (2024).1 「ザ・インフォメーション」と「ロイター」による2つの主な報道。

2 以下の設定で図面を作成した:a = 1属p = 0.5平和 0 < x < 1.

3 計算は[1]で次のように定義されている。 6NBSどの N となるモデルパラメータの数である。B は学習時に使用されるバッチサイズである。S はトレーニングステップの総数である。

4 この余分な乗算定数はべき乗則の振る舞いを変えない。この理由を理解するには、スケール不変性の定義を理解する必要がある。べき乗則はスケール不変であるため、べき乗則の基本的な特性は、ある係数でスケールアップしてもスケールダウンしても同じである。観測される振る舞いはどのスケールでも同じである!

5 この記述は、イリヤがこの論文でNeurIPS'24のTest of Time Awardを受賞したときのものである。

6 今でこそ当たり前のことに思えるかもしれないが、当時、ほとんどの NLP タスク(要約や Q&A など)には、それ専用の研究ドメインがあったことを念頭に置くべきである!これらのタスクにはそれぞれ、そのタスクを実行するために特化されたタスク固有のアーキテクチャが関連付けられており、GPTは、多くの異なるタスクにわたって、これらのアーキテクチャのほとんどを上回ることができる単一の汎用モデルでした。

7 つまり、大きな言語モデルのプロンプトに各タスクを単純に記述し、異なるタスクを解くために同じモデルを使用する - ということです。タスク間で変わるのはプロンプトのみ.

8 これは、これらのモデルがゼロサンプル推論を使用し、下流のタスクで微調整を全く行っていないことから予想されることである。

9 "創発的な "能力とは、大規模な言語モデルがある一定の規模(例えば、十分に大規模なモデル)に達したときにのみ利用できる能力を意味する。

10 ここで、「計算上最適」とは、一定の訓練計算コストで(テスト損失の点で)最高のパフォーマンスをもたらす訓練セットアップと定義する。

11 例えば、アンソロピックは発売を延期し続けている。 クロード 3.5 Opus、GoogleはGemini-2のフラッシュ版しかリリースしておらず、OpenAIは2024年にGPT-4oをリリースしたのみである(12月にo1とo3がリリースされるまで)。

12 1つのトークンの推論中にアクティブになるパラメータはわずか370億。

13 例えば、xAIは最近、メンフィスに10万個のNVIDIA GPUを備えた新しいデータセンターを建設した。

14 集計ステップは、さまざまな方法で実装できます。たとえば、手動で(たとえば、接続を介して)回答を集約することも、大規模な言語モデルを使用することも、その中間の方法を使用することもできます!

15 これは、これらのタスクが単純だからではない。コード生成とチャットはどちらも解決が難しいが、ビッグ・ランゲージ・モデルの(間違いなく)かなり明白な応用である。

16OpenAIは、o1のユーザーからこれらの長い思考の連鎖を隠すことにしました。この選択の背景にある議論は、これらの基本的なことは、モデルのデバッグやモニ タリングに使用できる、モデルの思考プロセスに対する洞察を提供するということです。しかし、モデルは、ユーザー向けのモデル出力に必要なセキュリ ティ・フィルタを一切かけることなく、純粋な思考を表現することを許されるべきです。

17現在、ARC-AGIは技術的に無敗のままであるが、これはo3がベンチマークの計算要件を上回っているためである。しかし、このモデルは、より低い計算設定でも75.7%の精度を達成しています。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません