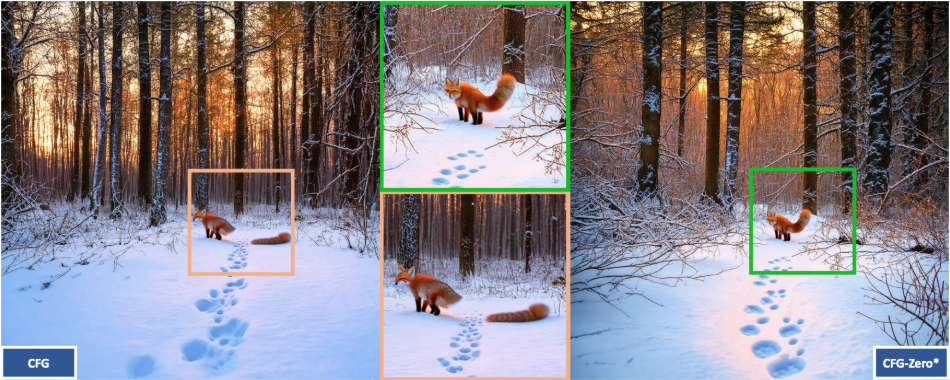

CFG-Zero-star:画像とビデオの生成品質を向上させるオープンソースツール

はじめに

CFG-Zero-starは、南洋理工大学のWeichen FanとS-Labチームによって開発されたオープンソースプロジェクトです。誘導戦略とゼロ初期化方法を最適化することで、画像とビデオ生成の品質を向上させるために、ストリームマッチングモデルの分類器自由誘導(CFG)技術を改善することに焦点を当てています。このツールは、テキストから画像、テキストからビデオへの生成タスクをサポートし、Stable Diffusion 3、SD3.5、Wan-2.1、およびその他のモデルに適合させることができる。コードは完全にオープンで、Apache-2.0ライセンスに基づいているため、学術研究や商用利用が可能です。このプロジェクトでは、開発者、研究者、AI愛好家のために、オンラインデモと詳細なドキュメントを提供しています。

機能一覧

- 改善されたCFG手法:分類器フリーのブートストラップを最適化し、生成されるコンテンツの品質とテキストマッチングを改善。

- 画像生成サポート:Stable Diffusion 3およびSD3.5と互換性のある、テキストベースの高品質画像生成。

- ビデオ生成をサポート:ダイナミックビデオを生成し、Wan-2.1や他のビデオモデルに適応する。

- ゼロ初期化最適化:ストリーム・マッチング・モデルのサンプル品質を向上させるため、生成の最初に予測値をゼロにする。

- オープンソース・コード:完全なコードが提供され、ユーザーは自由にダウンロード、変更、貢献することができる。

- グラディオ・デモ・インターフェース: 内蔵のオンライン・テスト・ツールで、複雑な設定は不要。

- 動的パラメータ調整:様々なニーズを満たすために、ガイドの強度と推論ステップ数の調整をサポートします。

- 統合されたサードパーティサポート: ComfyUI-KJNodesとWan2.1GPエクステンションをサポート。

ヘルプの使用

CFG-Zero-starはGitHubで公開されているオープンソースプロジェクトで、ユーザー自身が環境を設定し、コードを実行する必要があります。以下は、すぐに使い始められるように、詳しいインストールと使い方のガイドです。

設置プロセス

- 仮想環境の構築

- Anaconda をインストールする(インストールされていない場合は、https://www.anaconda.com/ からダウンロードする)。

- ターミナルで以下のコマンドを実行し、環境を作成する:

conda create -n CFG_Zero_Star python=3.10 - 環境を活性化させる:

conda activate CFG_Zero_Star

- PyTorchのインストール

- GPUのCUDAバージョンに応じてPyTorchをインストールします。公式の推奨はCUDA 12.4です:

conda install pytorch==2.5.1 torchvision==0.20.1 torchaudio==2.5.1 pytorch-cuda=12.4 -c pytorch -c nvidia - CUDAバージョンの互換性を確認する。https://docs.nvidia.com/deploy/cuda-compatibility/。

- GPUを持たないユーザーはCPU版をインストールできる:

conda install pytorch==2.5.1 torchvision==0.20.1 torchaudio==2.5.1 -c pytorch

- GPUのCUDAバージョンに応じてPyTorchをインストールします。公式の推奨はCUDA 12.4です:

- プロジェクトコードのダウンロード

- Gitでリポジトリをクローンする:

git clone https://github.com/WeichenFan/CFG-Zero-star.git - カタログを見る

cd CFG-Zero-star

- Gitでリポジトリをクローンする:

- 依存関係のインストール

- コマンドを実行して必要なライブラリをインストールする:

pip install -r requirements.txt - 不足している場合

requirements.txtコアの依存関係を手動でインストールする:pip install torch diffusers gradio numpy imageio

- コマンドを実行して必要なライブラリをインストールする:

- モデルファイルの準備

- Stable Diffusion 3またはSD3.5モデルウェイトをhttps://huggingface.co/stabilityai/stable-diffusion-3-medium-diffusers。

- モデルファイルをプロジェクトのディレクトリに置くか、コードでパスを指定します。

主な機能の操作

CFG-Zero-starの核となる機能は、画像と動画を生成することである。以下はその具体的な手順である。

画像の生成

- 設定パラメータ

- 見せる

demo.pyキュー・ワードを設定する:prompt = "一片星空下的森林" - CFG-Zero-star最適化を有効にする:

use_cfg_zero_star = True

- 見せる

- ラン・ジェネレーション

- それをターミナルに入力する:

python demo.py - 生成された画像は表示されるか、指定されたパスに保存される。

- それをターミナルに入力する:

- 調整パラメーター

guidance_scaleデフォルトは4.0、1~20の範囲で設定可能。num_inference_steps推論ステップ、デフォルト28、品質向上のため増加。

ビデオの作成

- モデルを選択

- ある

demo.pyセット・インmodel_name = "wan-t2v" prompt = "一条河流穿过山谷"

- ある

- ラン・ジェネレーション

- 実施する:

python demo.py - MP4形式で保存されたビデオ、デフォルトパス

generated_videos/{seed}_CFG-Zero-Star.mp4.

- 実施する:

- 調整パラメーター

height歌で応えるwidth解像度を設定します。デフォルトは480x832です。num_framesフレーム、デフォルト81fpsフレームレート、デフォルトは16。

グラディオを使ったデモ

- 起動インターフェース

- 走っている:

python demo.py - ウェブブラウザでhttp://127.0.0.1:7860。

- 走っている:

- 手続き

- プロンプトワードを入力し、モデル(SD3、SD3.5またはWan-2.1)を選択します。

- ダニ

Use CFG Zero Starパラメータを調整し、送信する。 - 結果はインターフェイスに表示される。

サードパーティ製ツールの統合

- ComfyUI-KJノード

- https://github.com/kijai/ComfyUI-KJNodes をダウンロードし、その指示に従ってインストールしてください。

- ある ComfyUI のCFG-Zero-starノードをロードする。

- ワン2.1GP

- https://github.com/deepbeepmeep/Wan2GP をダウンロードし、使用できるように設定する。

ほら

- ジェネレーションは計算量が多く、NVIDIA GPUと8GB以上のRAMを推奨します。

- 初回走行にはモデルのダウンロードが必要ですので、インターネットに接続しておいてください。

- このプロジェクトはApache-2.0ライセンスに従っており、ポルノや暴力的なコンテンツなどの生成を禁止している。

以上の手順で、CFG-Zero-starを使って高品質な画像や動画を生成することができます。操作にはある程度の技術的な基礎が必要ですが、ドキュメントやデモのインターフェイスがあるため、敷居は低くなっています。

アプリケーションシナリオ

- 学術研究

研究者はこれを使用して、ストリーム・マッチング・モデルの有効性をテストし、CFGとゼロ初期化の改善を分析することができ、コンピュータ・ビジョンの分野に応用できる。 - コンテンツ制作

クリエイターはこのテキストを使って、「空飛ぶドラゴン」のような画像や動画を生成し、アートデザインや短いビデオクリップに使うことができる。 - モデル開発

開発者はこのツールを使って、生成モデルやデバッグ・パラメーターを最適化し、生成の質を向上させることができる。

品質保証

- CFG-Zero-starが解決する問題とは?

ストリームマッチングモデルのCFG技術を最適化し、生成された画像や動画の品質とテキストマッチングを向上させる。 - 対応機種は?

Stable Diffusion 3、SD3.5、Wan-2.1などのモデルがサポートされている。 - 初期化ゼロの意味は?

生成の初期段階で予測をゼロにすることは、訓練不足のモデルがサンプルの質を向上させるのに役立つ。 - モデルが訓練不足かどうかを見分けるには?

ゼロ初期化を有効にすることで効果が著しく改善される場合は、モデルの学習が十分でない可能性を示している。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません