CAG:RAGより40倍高速なキャッシュ強化生成法

CAG(Cache Augmented Generation)は、RAG(Retrieval Augmented Generation)の40倍高速で、知識獲得に革命をもたらす。リアルタイムで外部データを取得する代わりに、すべての知識がモデルのコンテキストにあらかじめロードされる。これは、巨大なライブラリーを、必要なときにパラパラと見ることができる持ち運び可能なツールキットに凝縮したようなもので、CAGの実装はエレガントだ:

- ドキュメントはまず、LLMのコンテキストウィンドウに収まるように前処理される。

- 処理されたコンテンツは、Key-Valueキャッシュにエンコードされる。

- 最終的に、このキャッシュはメモリーかハードディスクに保存され、いつでも呼び出せるようになる

HotPotQAやSQuADのようなベンチマークデータセットにおいて、CAGは40倍速いだけでなく、著しく正確で首尾一貫している。これは、検索エラーや不完全なデータの問題がなく、グローバルにコンテキストをキャプチャする能力によるものである。

実用化の面では、医療診断、金融分析、顧客サービスなどの分野で有望視されている。複雑なアーキテクチャのメンテナンス負担を回避しながら、AIシステムが高いパフォーマンスを維持することを可能にする。

結局のところ、CAGの革新性は「持ち運び」を「持ち運び」に変えることであり、これは効率を向上させるだけでなく、AI展開の新たな可能性を開くものでもある。これは次世代のAIアーキテクチャーのスタンダードになるかもしれない。

参考文献

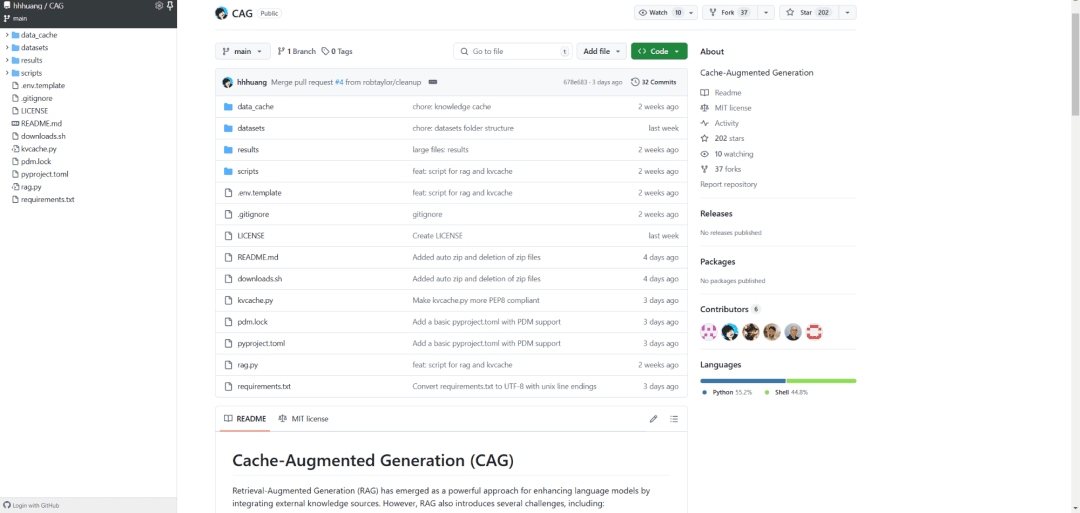

[1] https://github.com/hhhuang/CAG

[2] https://arxiv.org/abs/2412.15605

[3] ロング・コンテクストLLMがロング・イン・コンテクスト学習に苦戦: https://arxiv.org/pdf/2404.02060v2

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません