BetterWhisperX:話者から切り離された自動音声認識により、高精度の単語レベルのタイムスタンプを提供

はじめに

BetterWhisperXは、効率的で正確な自動音声認識(ASR)サービスを提供することに焦点を当てたWhisperXプロジェクトの最適化バージョンです。BetterWhisperXは、音素レベルでの強制アライメント、音声アクティビティに基づくバッチ処理、話者分離など、多くの先進技術を統合しています。このツールは、高速テープ起こし(large-v2モデルを使用した場合、最大70倍のリアルタイム速度)をサポートするだけでなく、正確な単語レベルのタイムスタンプと複数話者の認識も提供します。また、バックエンドにfaster-whisperを採用しており、大規模なモデルでも少ないGPUメモリで処理できるため、非常に高い性能/効率比を実現しています。

機能一覧

- クイックスピーチからテキストへ70倍速リアルタイム転写に対応した大型モデルlarge-v2を使用。

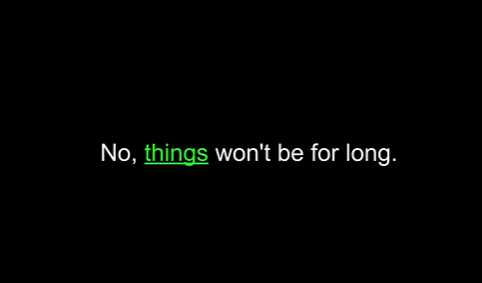

- 単語レベルのタイムスタンプ: wav2vec2アライメントにより、正確な単語レベルのタイムスタンプを提供。

- マルチスピーカー認識pyannote-audioによるスピーカーの分離とラベリング。

- 音声アクティビティ検出誤認識の低減とバッチ処理によるエラー率の大幅な上昇はない。

- 一括推論バッチ処理に対応し、処理効率を向上。

- 互換性: PyTorch 2.0とPython 3.10をサポートし、幅広い環境に対応。

ヘルプの使用

詳しい操作手順

- オーディオファイルの準備オーディオファイルのフォーマットがWAVまたはMP3であることと、音質がクリアであることを確認してください。

- 積載モデル要件に応じて適切なモデル(例えばlarge-v2)を選択し、メモリにロードする。

- トランスクリプションの実行transcribe関数を呼び出すと、音声からテキストへの変換処理が実行され、仮の変換結果が得られます。

- 整列タイムスタンプ正確なタイムスタンプを保証するために、align関数を使用して転写結果の単語レベルのタイムスタンプのアライメントを行う。

- スピーカー分離複数話者認識のためにdiarize関数を呼び出して、各話者のラベルと対応する音声断片を取得します。

- 結果出力最終結果をテキストファイルまたはJSON形式で保存し、その後の処理や分析に利用できます。

1.環境準備

- システム要件

- Python 3.10環境(仮想環境を作るにはmambaかcondaを推奨します。)

- CUDAおよびcuDNNのサポート(GPUアクセラレーションに必要)

- FFmpegツールキット

- インストールの手順

# 创建 Python 环境

mamba create -n whisperx python=3.10

mamba activate whisperx

# 安装 CUDA 和 cuDNN

mamba install cuda cudnn

# 安装 BetterWhisperX

pip install git+https://github.com/federicotorrielli/BetterWhisperX.git

2.基本的な使い方

- コマンドラインの使用法:

# 基础转录(英语)

whisperx audio.wav

# 使用大模型和更高精度

whisperx audio.wav --model large-v2 --align_model WAV2VEC2_ASR_LARGE_LV60K_960H --batch_size 4

# 启用说话人分离

whisperx audio.wav --model large-v2 --diarize --highlight_words True

# CPU 模式(适用于 Mac OS X)

whisperx audio.wav --compute_type int8

- Pythonのコード呼び出し:

import whisperx

import gc

device = "cuda"

audio_file = "audio.mp3"

batch_size = 16 # GPU 内存不足时可降低

compute_type = "float16" # 内存不足可改用 "int8"

# 1. 加载模型并转录

model = whisperx.load_model("large-v2", device, compute_type=compute_type)

audio = whisperx.load_audio(audio_file)

result = model.transcribe(audio, batch_size=batch_size)

# 2. 音素对齐

model_a, metadata = whisperx.load_align_model(language_code=result["language"], device=device)

result = whisperx.align(result["segments"], model_a, metadata, audio, device)

# 3. 说话人分离(需要 Hugging Face token)

diarize_model = whisperx.DiarizationPipeline(use_auth_token=YOUR_HF_TOKEN, device=device)

diarize_segments = diarize_model(audio)

result = whisperx.assign_word_speakers(diarize_segments, result)

3.パフォーマンス最適化の推奨

- GPUメモリの最適化:

- バッチサイズを小さくする (batch_size)

- 小型モデルの使用(例:大型ではなくベース)

- 軽量計算タイプを選択(int8)

- 多言語サポート:

- デフォルト対応言語:英語、フランス語、ドイツ語、スペイン語、イタリア語、日本語、中国語、オランダ語、ウクライナ語、ポルトガル語

- 使用する言語を指定する:

--language de(ドイツ語の例)

4.注意事項

- タイムスタンプは、特殊文字(数字や通貨記号など)に対して十分な精度が得られない場合がある。

- 複数の人が同時に話しているシーンの認識は効果的でない場合がある。

- スピーカーのセパレーションは現在も最適化中

- スピーカー分離機能を使用するには、ハギング・フェイスのアクセストークンが必要です。

- GPUドライバとCUDAバージョンの互換性の確保

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません