dots.vlm1 - Small Red Book Hi Lab オープンソース マルチモーダルラージモデル

dots.vlm1は、Little Red Book hi labがオープンソース化した初のマルチモーダルビッグモデルです。ゼロからトレーニングされた12億パラメータの視覚コーダーNaViTとDeepSeek V3 Large Language Model (LLM)をベースに、強力な視覚認識とテキスト推論を備えています。

LangExtract - 構造化情報を抽出するためのGoogleのオープンソースPythonライブラリ

LangExtractは、大規模言語モデル(LLM)を使用して、構造化されていないテキストから構造化された情報を抽出するGoogleオープンソースのPythonライブラリです。ユーザー定義のコマンドと少ないサンプル数で、...からの臨床メモのような重要な詳細を効率的に識別し、整理することができます。

Qwen-Image - Tongyi Qianqian、Qwen-Imageのオープンソース基本モデルを発表

Qwen-Imageは、Alibaba Tongyi Qianqianチームによってリリースされたオープンソースの画像生成ベースモデルです。200億のパラメータを持ち、マルチモーダル理解、高解像度コーディング、拡散モデリングの3つのモジュールを組み込んだマルチモーダル拡散変換アーキテクチャ(MMDiT)を採用しています。

Gemini 2.5 Deep Think - GoogleのAI推論モデル

Gemini 2.5 Deep Thinkは、複雑なタスクを解決するために設計されたGoogleのAI推論モデルである。国際数学オリンピック(IMO)2025で金メダルを獲得したモデルの亜種であり、並列推論によって複雑なタスクを解くように設計されている。

MindLink - KunlunWeiのオープンソース推論ビッグモデル

MindLinkは崑崙ワールドワイドウェブによって起動されたオープンソースの推論の大規模なモデルです。適応推論機構を使用すると、タスクの複雑さに応じて柔軟に推論モードを切り替えることができ、単純なタスクが迅速に生成され、複雑なタスクの詳細な推論、アカウントに効率と精度を取る。計画駆動型の推論のパラダイムは、 "考える "タグを削除するには、減らす...

MirageLSD - Decart AI、初のリアルタイムAI動画生成モデルを発表

MirageLSDは、Decart AIチームによる世界初のリアルタイムストリーミング拡散AIビデオモデルであり、40ミリ秒という低レイテンシーと24フレーム/秒のスムーズな出力で、無制限のリアルタイムビデオ生成を可能にする。

k2 - 月のダークサイド キミの最新MoE建築ベースモデル

k2は、Moonshot AIが提供する優れたコードとエージェント機能を備えたMoEアーキテクチャのベースモデルで、1Tの総パラメータと32Bの起動パラメータを備えています。一般知識推論、プログラミング、数学、エージェントの主要カテゴリにおけるベンチマーク性能テストにおいて、k2モデルは...

Grok 4 - マスクのxAIの最新大型モデル

Grok 4はxAIの最新大型AIモデルであり、Grok 4は前モデルに比べ推論能力が10倍向上している。このモデルの優れた推論能力は、SATやGREなどの難関試験で満点に近いスコアを可能にし、多くのベンチマークテストで他の最先端モデルを凌駕している...

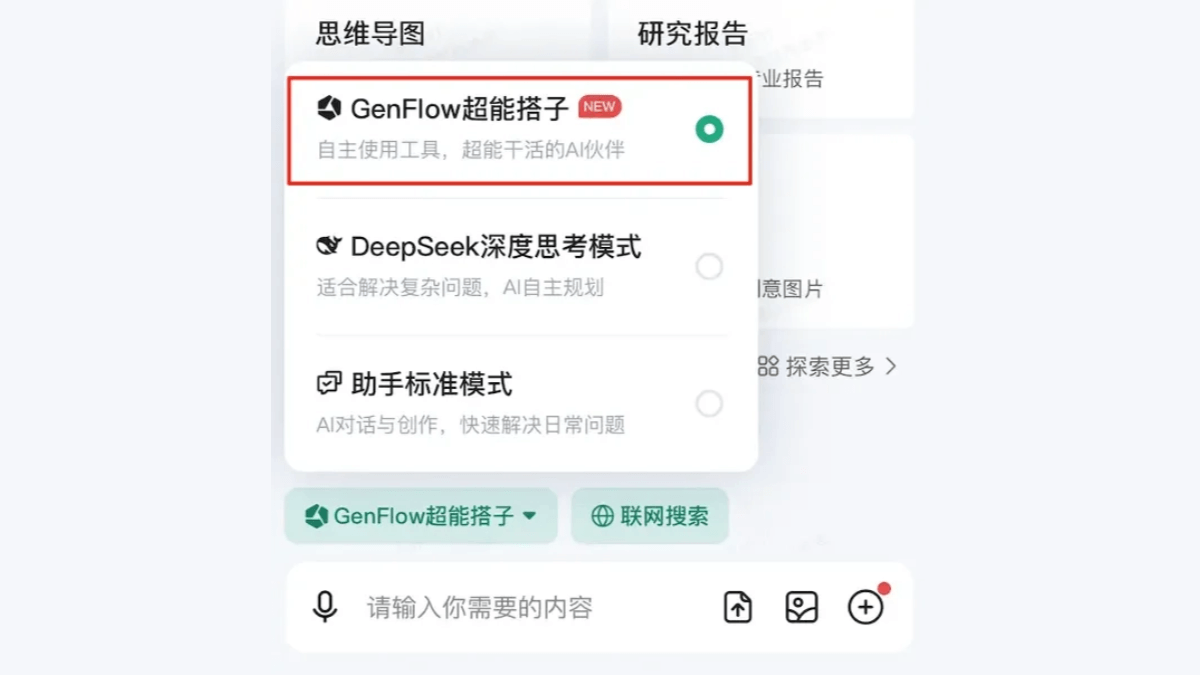

GenFlow Super Hitchhiker - 百度文庫の万能AIエージェント

GenFlow Super Hitchhikerは、百度文献図書館が発表した汎用AIエージェントで、ユーザーは自然言語コマンドを入力するだけで、タスクを独自に分解し、百度文献図書館の14億のドキュメントライブラリやオンラインリソースを呼び出し、PPT、レポート、チャート、ポスターなどのフルモダルコンテンツを極めて高速に生成することができる。

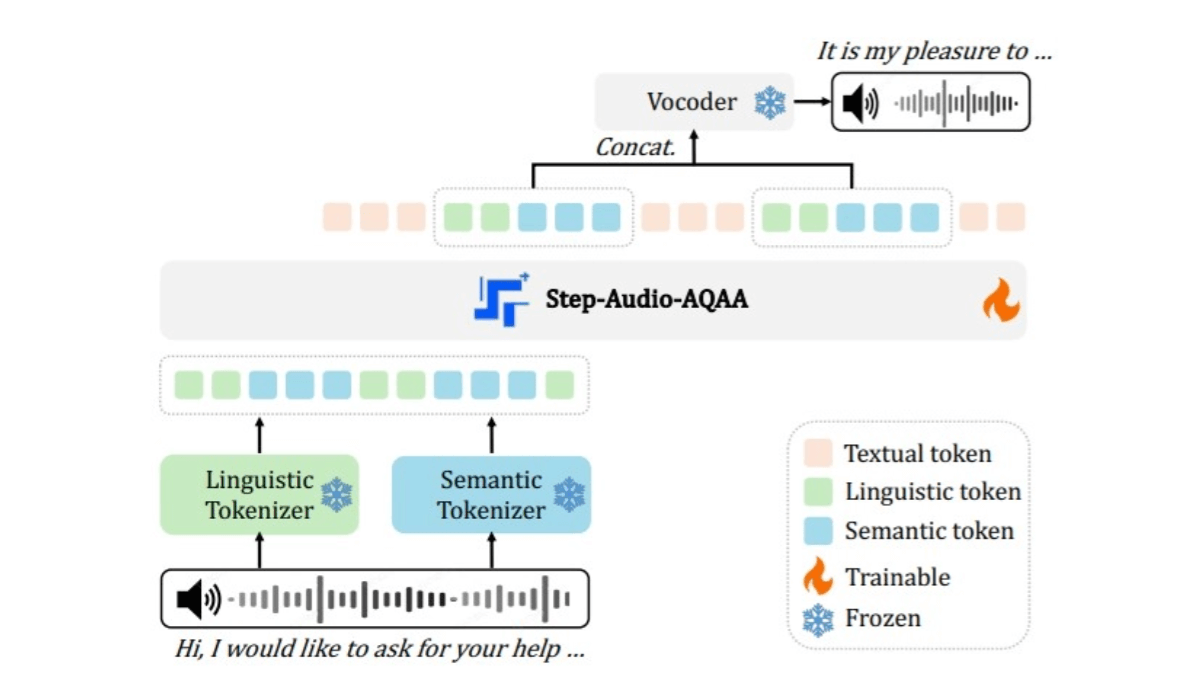

Step-Audio-AQAA - StepFunのエンドツーエンド・ビッグオーディオ言語モデル

Step-Audio-AQAAは、StepFunチームによる、Audio Query-Audio Answer (AQAA)タスクのためのエンドツーエンドの大規模音声言語モデルです。従来の自動音声認識(AQAA)に頼ることなく、音声入力を直接処理し、自然で正確な音声応答を生成することができます。