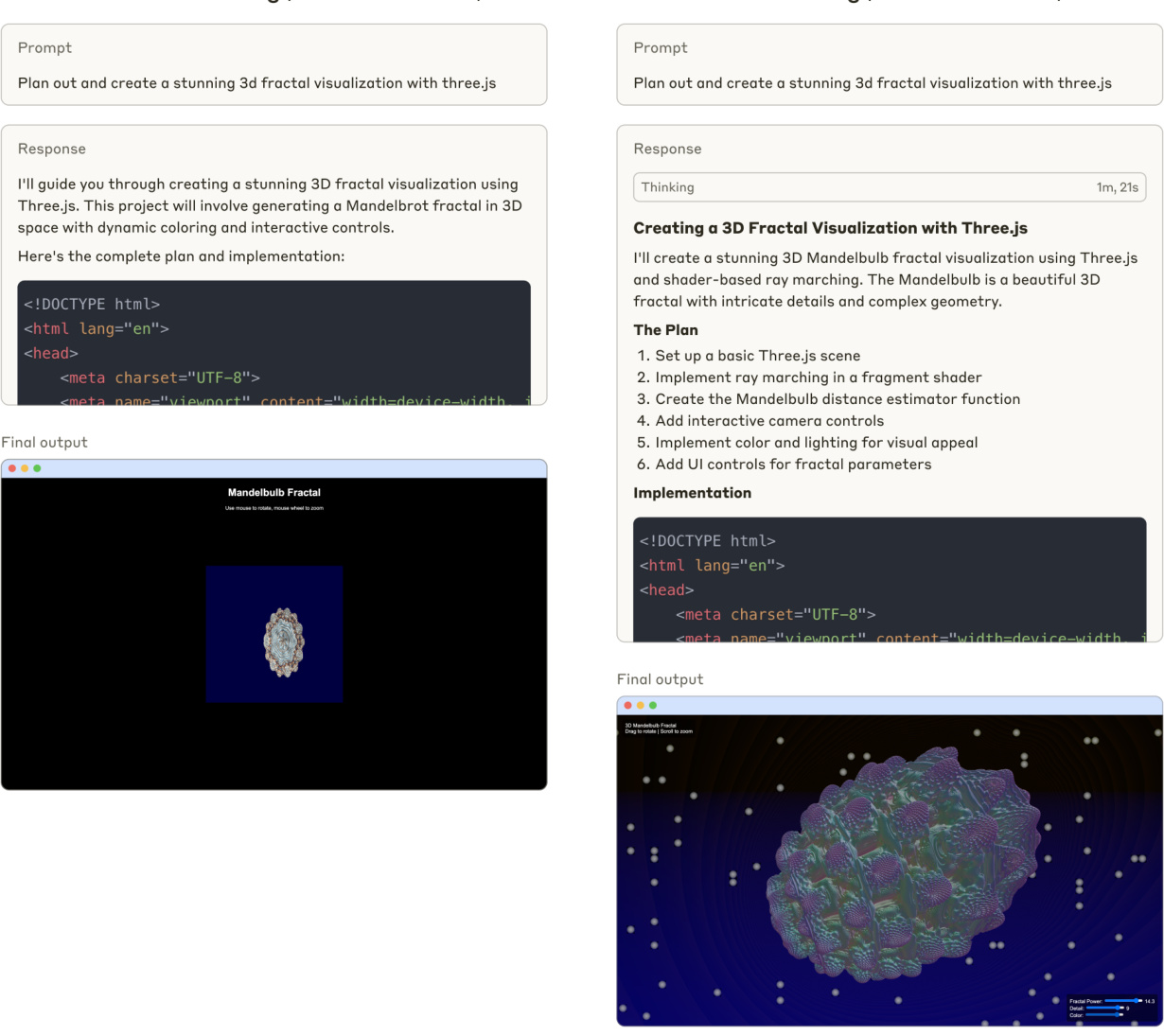

スノーフレーク、高品質な中国語検索のためのArctic Embed 2.0多言語ベクトルモデルをリリース

スノーフレークは、このたび アークティック・エンベッド L 2.0 歌で応える アークティック・エンベッドM 2.0 Arctic Embed 2.0は、私たちの最先端のエンベッディングモデルの次のイテレーションであり、多言語検索をサポートできるようになりました。Arctic Embed 2.0は、これまでのリリースの強固な基盤の上に構築されており、英語版のパフォーマンスやスケーラビリティを犠牲にすることなく多言語サポートを追加することで、さまざまな言語やアプリケーションにまたがる幅広いユーザーコミュニティのニーズに対応しています。多言語サポートを追加しました。

図1.10億以下のパラメータを持つオープンソース多言語埋め込みモデルの一方向性ボリューム集中検索性能。スコアはMTEB 検索 と、CLEF (ELRA, 2006)のサブセット(英語、フランス語、スペイン語、イタリア語、ドイツ語をカバー)における平均nDCG@10である。

妥協なき多言語主義

今回のArctic Embed 2.0のリリースでは、2つの利用可能なバリアントをリリースします。 GTE-マルチリンガル その上、3億500万個のパラメーター(うち1億1300万個は非埋め込み)を持つ、もうひとつの大規模なバリエーションは、検索品質に重点を置き、フェイスブックの XMLRラージ 5億6,800万個のパラメータ(うち3億300万個は非埋め込み)を持つロングコンテキストのバリアントの上に。どちらのサイズも最大8,192 トークン コンテキストの長さArctic Embed 2.0を開発するにあたり、私たちは既存の多くの多言語モデルが直面している課題を認識しました。多言語用に最適化すると、英語の検索品質が犠牲になることがよくあるのです。このため、この分野の多くのモデルは、英語版と多言語版の2つのバージョンを持っています。Arctic Embed 2.0は、ドイツ語、スペイン語、フランス語などの非英語言語において最高のパフォーマンスを発揮する一方、英語検索においては英語版のみの先行モデルを凌駕します。 アークティック・エンベッド M 1.5.

多言語対応の必要性とSnowflakeの卓越した英語検索へのコミットメントのバランスを慎重に取ることで、Arctic Embed 2.0を幅広いグローバルなユースケースに対応するユニバーサルな主力モデルとして構築しました。本書では、特に断りのない限り、すべての定性評価はタスク全体のNDCG@10平均スコアを参照しています。

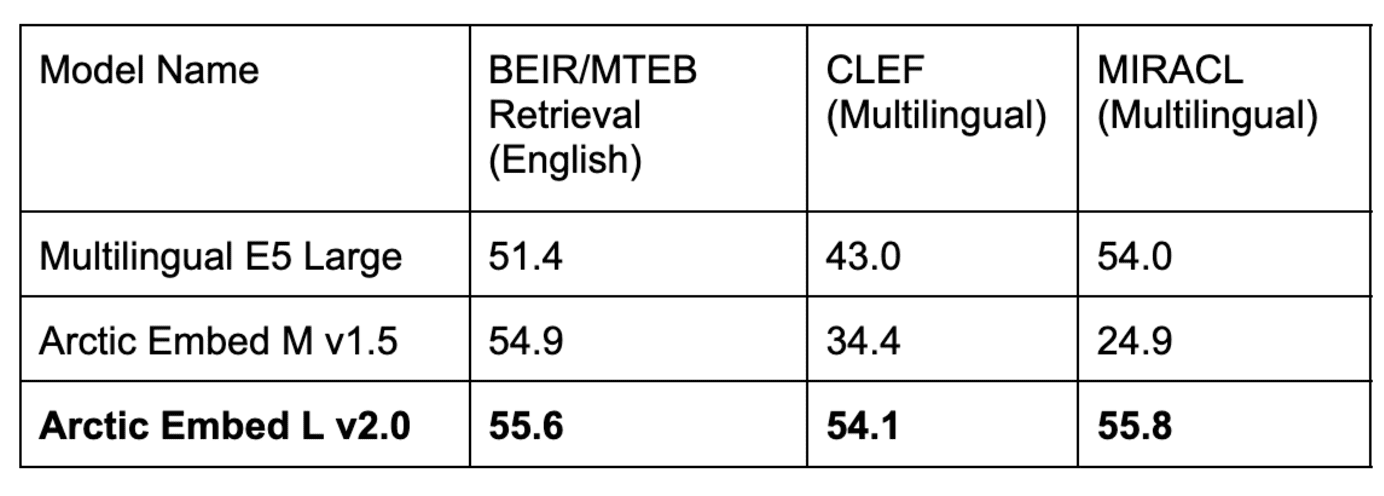

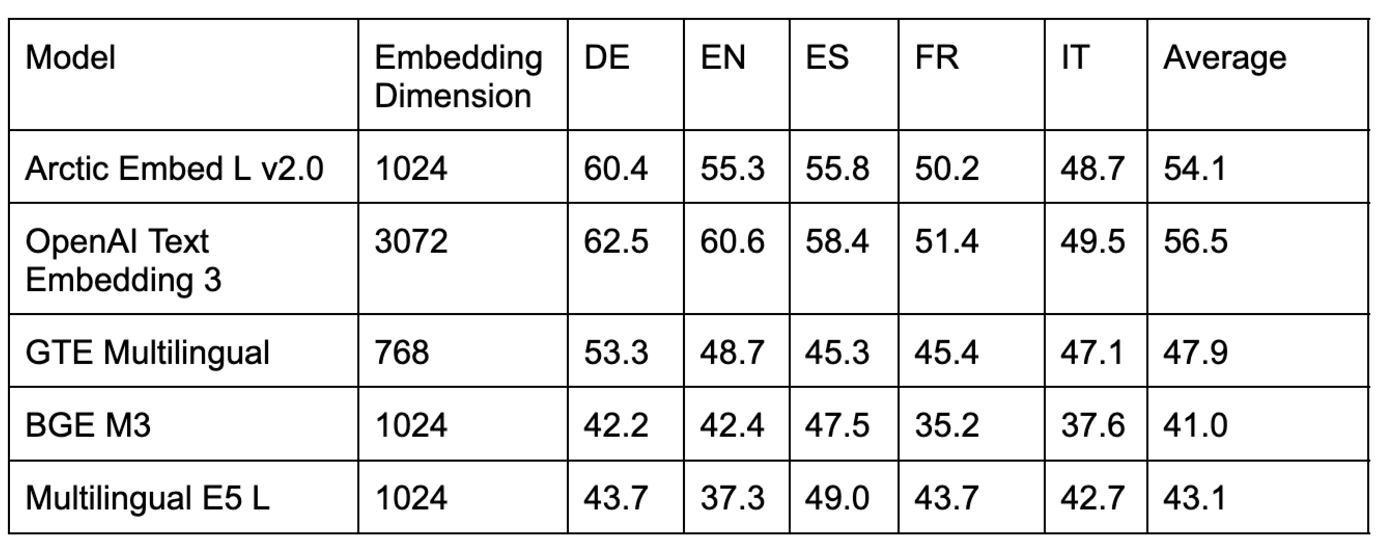

表1:Arctic Embed L v2.0モデルは、人気の高い英語MTEB検索ベンチマークで高スコアを達成し、いくつかの多言語ベンチマークでも高い検索品質を達成しています。Arctic Embedの以前の反復版は、英語では良好なパフォーマンスを示していますが、多言語では劣っています。英語のパフォーマンスは低下しました。CLEFとMIRACLのスコアは、ドイツ語(DE)、英語(EN)、スペイン語(ES)、フランス語(FR)、イタリア語(IT)の平均を反映しています。

Arctic Embed 2.0の多様で強力な機能セット

- エンタープライズクラスのスループットと効率: Arctic Embed 2.0モデルは、大企業のニーズに合わせて構築されています。私たちの「ラージ」モデルでさえ、パラメータは10億をはるかに下回り、高速で高スループットのエンベッディングを提供します。社内テストによると、NVIDIA A10 GPU上で、毎秒100ドキュメント(平均)以上を簡単に処理し、10ミリ秒未満のクエリエンベッディングレイテンシを達成しています。

- 妥協のない英語・非英語検索品質: Arctic Embed L 2.0は、そのコンパクトなサイズにもかかわらず、英語および非英語の様々なベンチマークデータセットでNDCG@10のスコアを達成し、学習ソリューションに含まれていない言語に対しても優れた汎化能力を発揮しました。これらのベンチマークスコアにより、Arctic Embed L 2.0は最先端の検索モデルのリーダー的存在となっています。

- マトリョーシカ表現学習(MRL)によるスケーラブルな検索: Arctic Embed バージョン2.0には、Arctic Embed 1.5で導入された定量化に適したMRL機能が搭載されており、大規模なデータセットの検索を行う際のコスト削減とサイズの最適化を可能にします。2つのモデルサイズにより、ユーザーは1ベクトルあたりわずか128バイト(OpenAIの人気モデルであるtext-embedding-3-largeの非圧縮エンベッディングより96倍小さい^1^)で高品質な検索を実現できます。Arctic Embed 1.5と同様に、Arctic Embed 2.0モデルもまた、圧縮された状態で複数のMRL対応の同業他社を凌駕し、品質の劣化が大幅に少なく、ベンチマークスコアも高くなっています。

- 真のオープンソース: Arctic Embed 2.0モデルは、寛大なApache 2.0ライセンスの下でリリースされている。

オープンソースの柔軟性とエンタープライズクラスの信頼性の融合

前モデルと同様、Arctic Embed 2.0モデルは、寛大なApache 2.0ライセンスの下でリリースされています。これらのモデルは、すぐに使用することができ、信頼性の高い多言語エンベッディングにより、さまざまな業種のアプリケーションをサポートし、優れた汎化機能を備えています。

Hugging FaceのCEOであるClément Delangue氏は、「多言語エンベッディングモデルは、英語を話す人だけでなく、世界中の人々がAIビルダーになるために不可欠です。これらの最先端のモデルをHugging Face上でオープンソースとして公開することで、スノーフレークはAIと世界に大きな貢献をしています。"

実際、特にオープンソースの選択肢の中でも、Arctic Embed 2.0ファミリーは、多言語検索ベンチマークで観察された汎化能力において、特別な注目に値する。ライセンス 言語横断評価フォーラム(CLEF)テスト・スイート 2000-2003我々のチームは、様々なオープンソースモデルのドメイン外検索の品質を測定することができた。 ミラクル 評価セットで得られたスコアと比較すると、その性能は低い。初期のオープンソースモデル開発者の中には、MIRACLの性能向上を犠牲にしてMIRACLの性能を向上させるために訓練シナリオを過剰にチューニングしたために、MIRACLの訓練データを過剰に適合させてしまった可能性があるという仮説を立てた。Arctic Embed 2.0モデルがどのようにトレーニングされたのか、またトレーニングの過程で何がわかったのか、今後の技術レポートにご期待ください。

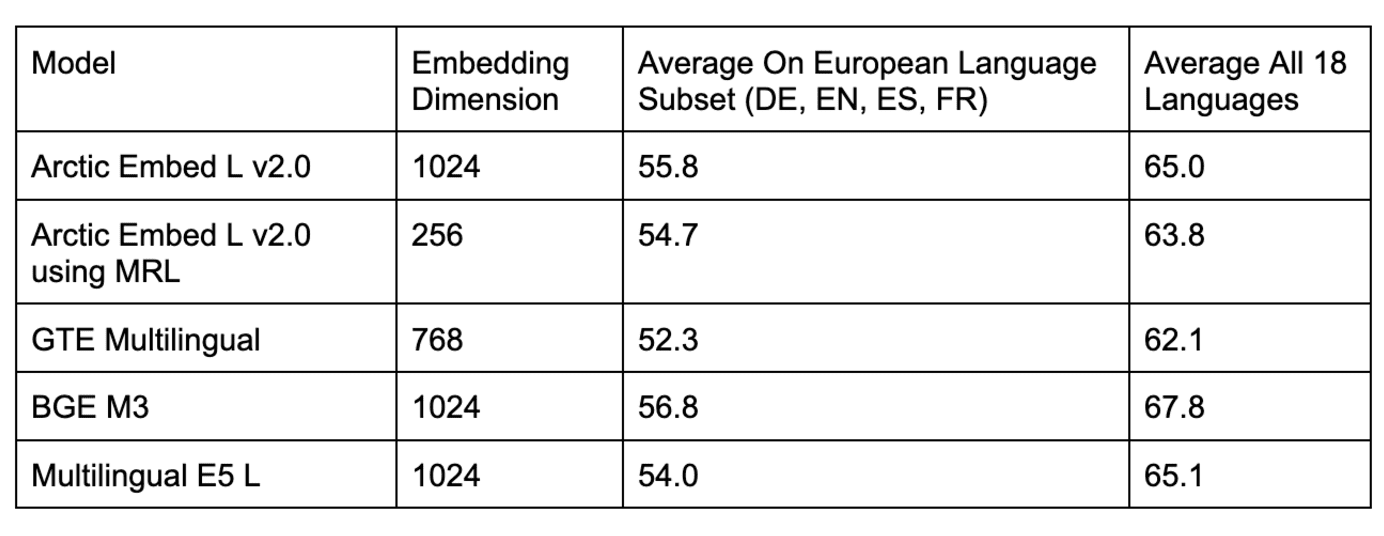

表2.領域外CLEFベンチマークの複数のデータセットにおける多言語検索モデルの比較。

表3.ドメイン内MIRACLベンチマークにおける複数のオープンソース多言語検索モデルの比較。

表2および表3に示すように、ドメイン内MIRACL評価のためのいくつかの一般的なオープンソースモデルを、以下のモデルと比較した。 アークティック・エンベッド L 2.0 のスコアは同程度ですが、領域外のCLEF評価では劣ります。また、一般的なクローズドソースモデル(OpenAIのtext-embedding-3-largeモデルなど)のベンチマークも行い、Arctic L 2.0の性能は主要なプロプライエタリモデルと同等であることがわかりました。

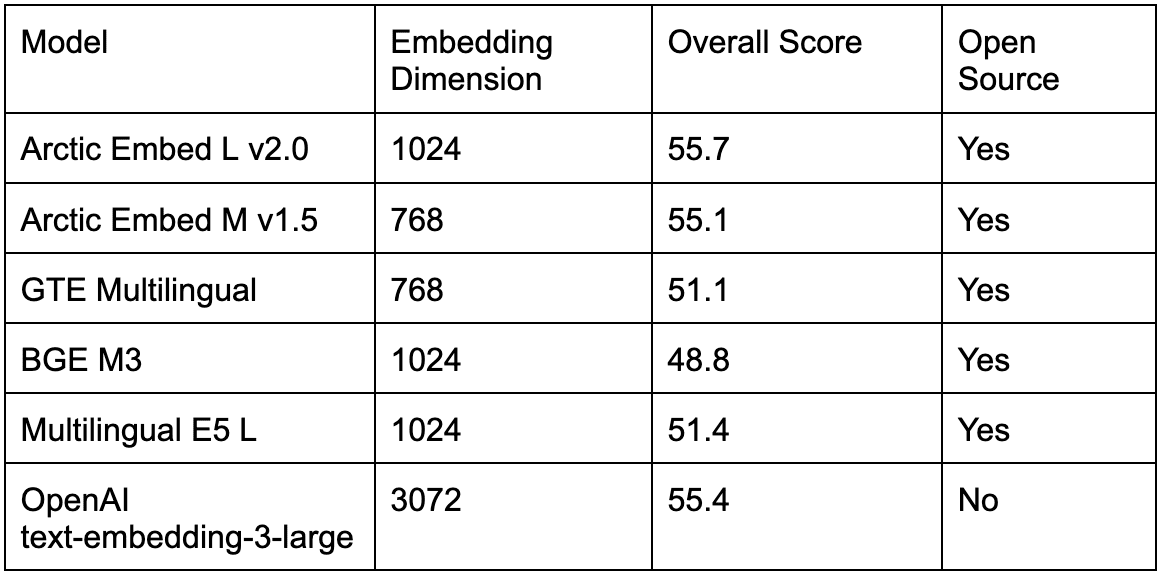

表4に示すように、既存のオープンソース多言語モデルは、一般的な英語MTEB検索ベンチマークテストでも、以下のテストよりも優れている。 アークティック・エンベッド L 2.0 は、さらに悪いことに、多言語検索をサポートしたいユーザーに対して、英語の検索品質の低下か、英語のみの検索に2つ目のモデルを使用することによる運用の複雑化かの選択を迫っていました。Arctic Embed 2.0のリリースにより、英語検索の品質を犠牲にすることなく、単一のオープンソースモデルに切り替えることができるようになりました。

表4.ドメイン内MTEB検索ベンチマークにおけるオープンソースとクローズドソースの多言語検索モデルの比較。

トレードオフのない圧縮と効率

スノーフレークは、組み込みモデルの設計において、効率とスケールを優先し続けている。スノーフレークは アークティック・エンベッド L 2.0これにより、ユーザは大規模なモデルの高品質な特徴を、1ベクトルあたり128バイトのストレージしか必要としないコンパクトな埋め込みに圧縮することができる。これにより、ローエンドのハードウェアで、数百万件の文書に対する検索サービスを低コストで提供することが可能になります。また、Arctic Embed 2.0の印象的な検索品質を、2つのサイズ(mediumとlarge)でそれぞれ1億と3億の非埋め込みパラメータに圧縮することで、埋め込みスループットの効率化を達成しました。

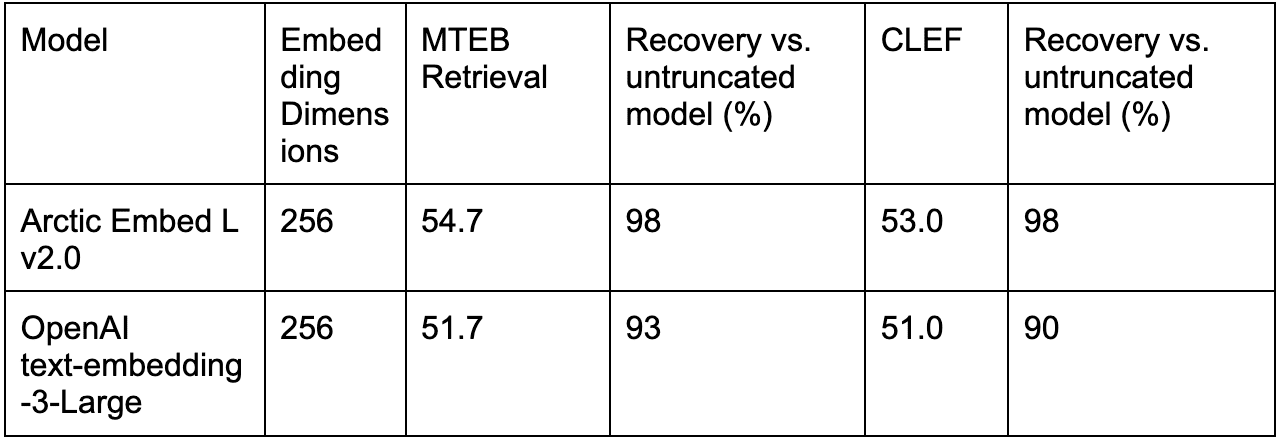

実際、規模に焦点を当てたメカニズムは アークティック・エンベッド L 2.0 本当に優れているのは、他のMRL学習済みモデル(OpenAIのtext-embedding-3-largeなど)と比べて、圧縮下でも優れた品質を達成できる点だ。

表5.は、OpenAIのテキスト埋め込み-3-largeと、Arctic Embed L 2.0を用いた切り捨て埋め込みとの性能を、英語のみ(MTEB検索)と多言語(CLEF)で比較したものです。

結論:多言語で効率的な検索の新基準

Arctic Embed 2.0により、Snowflakeは、多言語、効率的な埋め込みモデルの新しい標準を設定しました。さらに、テキスト埋め込み品質のフロンティアを、効率的であるだけでなく、緩やかなオープンソースにしました。Arctic Embed 2.0は、多言語ユーザーへのリーチの拡大、ストレージコストの削減、アクセシブルなハードウェアへのドキュメントの埋め込みなど、お客様の目標が何であれ、ニーズを満たす機能と柔軟性を提供します。

今後のテクニカルレポートでは、Arctic Embed 2.0の革新的な技術について詳しくご紹介します。まずは、Snowflakeでのエンベッディングをお試しください。

^1^ この計算では、非圧縮のベースラインにfloat32形式、つまり32ビットの数値が3,072個、1ベクトルあたり合計98,304ビットを使用している。これは、Arctic Embed 2.0モデルでMRLによって切り捨てられた256次元ベクトルをint4形式で保存する際に使用される1ベクトルあたり1,024ビット(1ベクトルあたり128バイトに相当)のちょうど96倍に相当する。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません