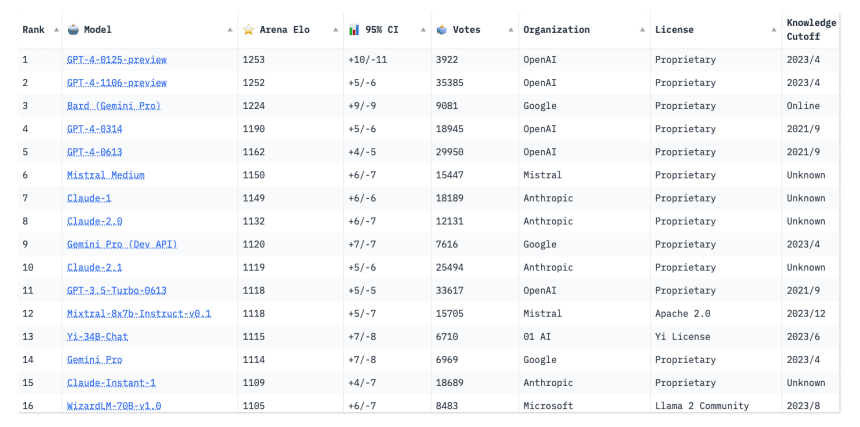

ChatGPTは依然として多くのAIチャートでトップだが、競合はそのすぐ後ろにいる

現在入手可能な最強のAIモデルはどうやって決まるのか?ランキングをご覧ください。

AIモデルのコミュニティによるリーダーボードは、ここ数カ月でオンライン上で人気が急上昇しており、AI分野における大手ハイテク企業の争いをリアルタイムで知ることができる。

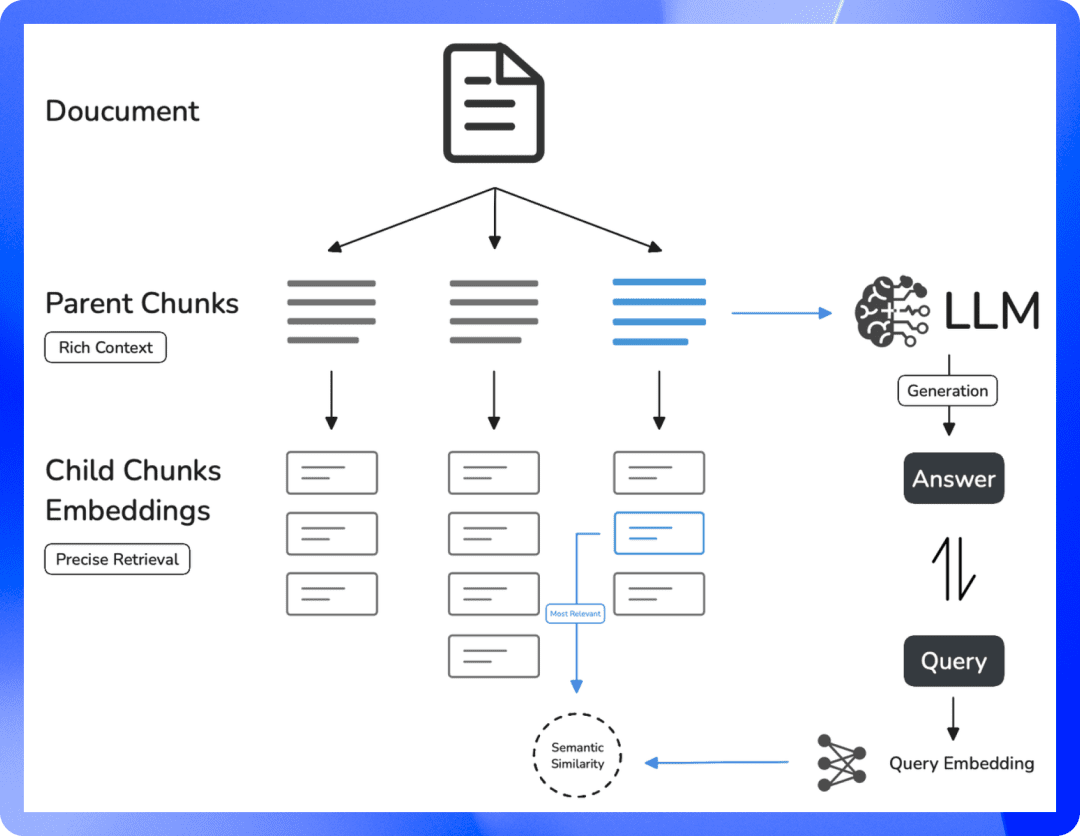

AIモデルは基本的に、特定の目的を達成するために設計されたコードに包まれた数学的数式の集合である。

グーグルのジェミニ(以前はバード)やパリの新興企業のように。 ミストラルAI Mistral-Mediumのような新規参入組は、AIコミュニティに活気を与え、リーダーボードのトップの座を争っている。

しかし、オープンエイのGPT-4は依然として優勢だ。

スタンフォード大学のコンピューターサイエンス博士課程に在籍し、チャットボット・アリーナのリーダーボードの共同制作者であるイン・シェンは言う。人々は、チャートが変化し続けるのを見るのが好きなのだと思います。それは、ゲームがまだ続いていて、まだ改善の余地があることを示しています」。

このランキングはAIモデルの能力テストに基づいており、AIが一般的にどのような能力を持ち、どのモデルが音声認識などの特定の用途に最も適しているかを把握するために設計されている。これらのテストは、ベンチマークテストと呼ばれることもあり、AIの発声が人間の声にどれだけ近いか、AIチャットボットがどれだけ人間的な反応をするかといった指標を通じてAIの性能を測定する。

AIが進化し続ける中、これらのテストを継続的に改善することも同様に重要である。

スタンフォード大学ヒューマン・ディメンション・センター人工知能研究所のヴァネッサ・パーリ研究部長は、「これらのベンチマークは完璧ではありませんが、今のところ、システムを評価する唯一の方法です」と語った。

同研究所の年次報告書「スタンフォード人工知能指数」は、様々な評価基準で長期的にAIモデルの技術的パフォーマンスを追跡している。パーリによると、昨年の報告書では50のベンチマークを調査したが、20しか含まれていなかった。今年は、より新しく包括的なベンチマークに焦点を当てるため、いくつかの古くなったベンチマークを削除する予定だ。

オープンソースの機械学習プラットフォームであるHugging Faceによって構築されたOpen LLM [Large Language Model]リーダーボードは、2月初旬の時点で4,200以上のモデルを評価し、ランク付けしている。

モデルたちは、読解力や数学的な問題解決力など、さまざまなカテゴリーにおける能力を評価するために設計された7つの主要ベンチマークテストに参加する。評価プロセスには、モデルの常識的な推論をテストし、誤った情報を広める傾向を測定する小学校の数学と科学の問題が含まれる。テストのなかには、多肢選択式のものもあれば、手がかりをもとにモデル自身が答えを導き出さなければならないものもある。

OpenAIのChatGPT-4はLMSYS Chatbot Arenaのリーダーボードのトップにあり、GoogleのGeminiviaが僅差で続いている。 LMSYS

訪問者は、特定のベンチマークテストにおける各モデルの具体的なパフォーマンスと、平均合計スコアを見ることができます。これまでのところ、どのベンチマークでも100点満点を達成したモデルはない。サンフランシスコの新興企業Abacus.AIが新たに開発したAIモデルSmaug-72Bは、平均80点を突破した最初のモデルとなった。

ハギング・フェイスの共同設立者兼最高科学責任者であるトーマス・ウルフは、多くの大規模言語モデルは、このようなテストですでに人間のベンチマークを上回っているという。この現象は通常、生徒が中学生から高校生に進級し、前段階の学習を徐々に卒業したときのように、モデルの能力が特定のテストを超えて向上したときに起こる。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません