エージェント・サービス・ツールキット:LangGraphに基づくAIインテリジェンス構築のための完全なツールセット

はじめに

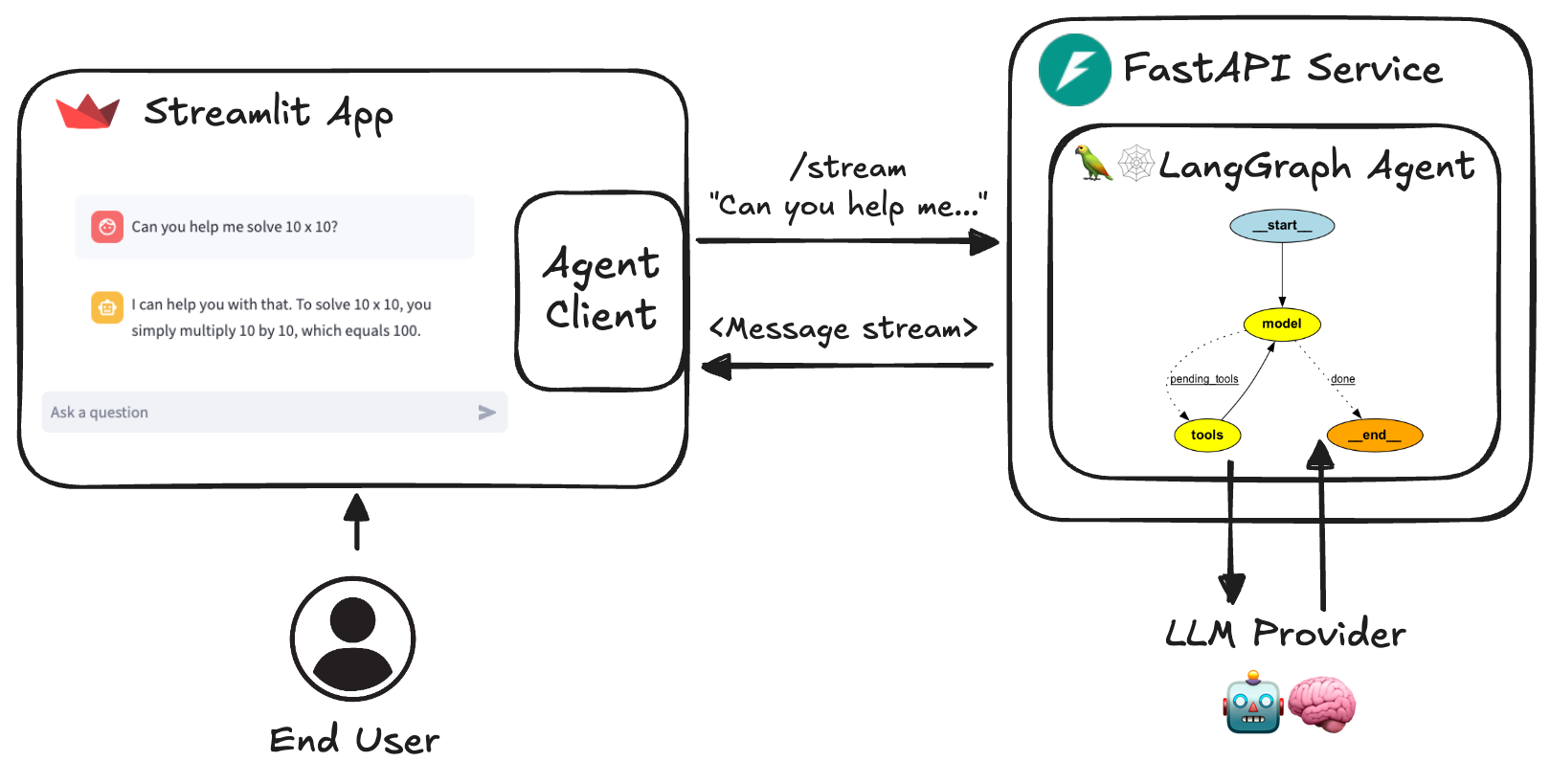

AIエージェント・サービス・ツールキットは、LangGraph、FastAPI、Streamlit上に構築された完全なツールセットで、開発者がAIエージェント・サービスを迅速に構築し、実行できるように設計されています。このツールキットは、様々なアプリケーションシナリオのために、ユーザ定義のエージェント機能とインタラクションをサポートする柔軟なフレームワークを提供します。チャットボット、データ分析ツール、その他のAIベースのサービスを開発する場合でも、ユーザーはツールキットを使用して迅速に実装することができます。ツールキットは、使いやすさと拡張性を念頭に設計されており、ユーザーは簡単な設定とコードの修正によって、必要な機能を簡単に統合することができます。

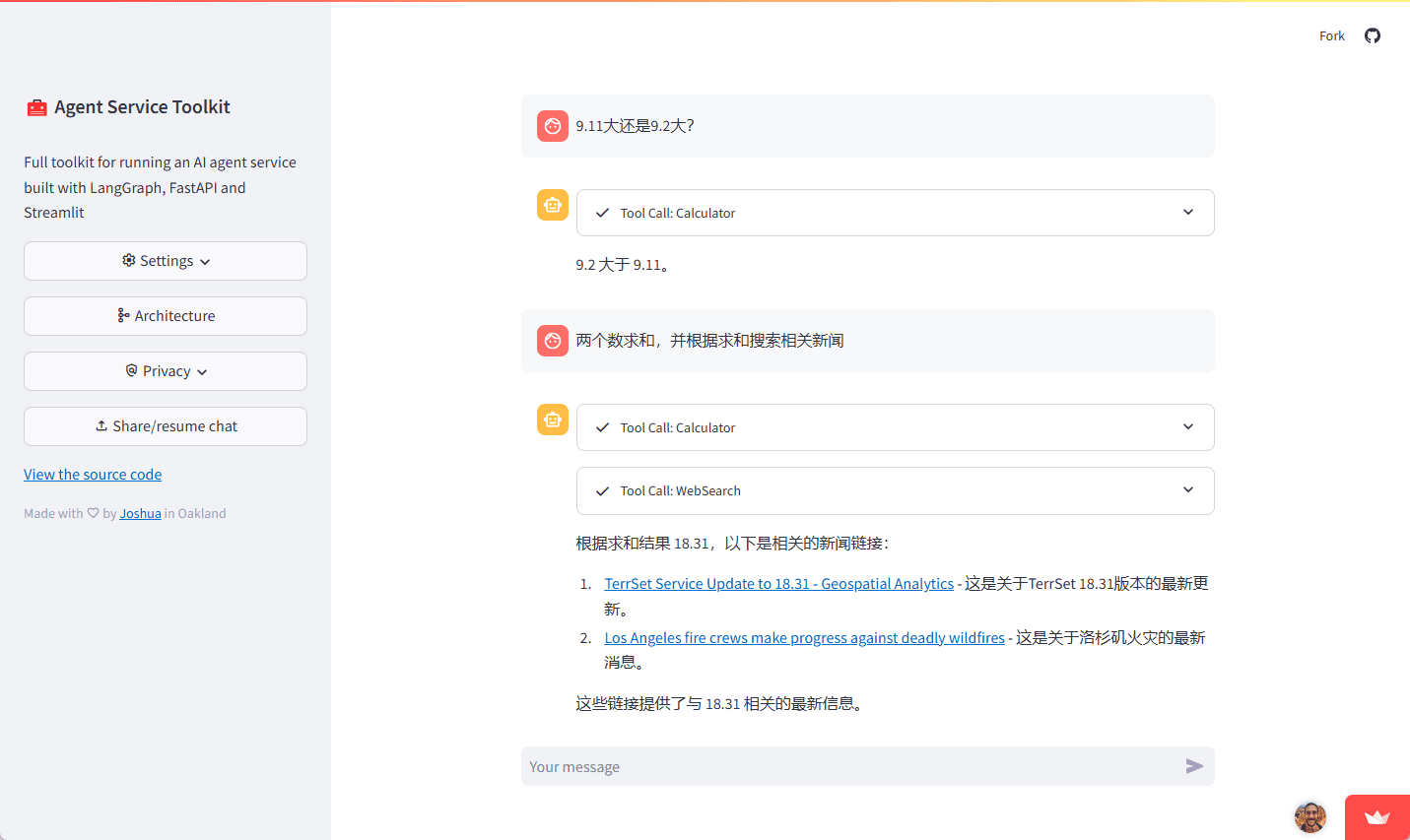

経験:https://agent-service-toolkit.streamlit.app/

エージェント・サービス・ツールキット・アーキテクチャ

機能一覧

- ラングラフエージェント 使用 ラングラフ フレームワークでカスタマイズ可能なエージェント

- FastAPI サービス ストリーミングと非ストリーミングのエンドポイントにサービスを提供。

- 高度なストリーミング処理 トークン・ベースとメッセージ・ベースのストリーミングに対応。

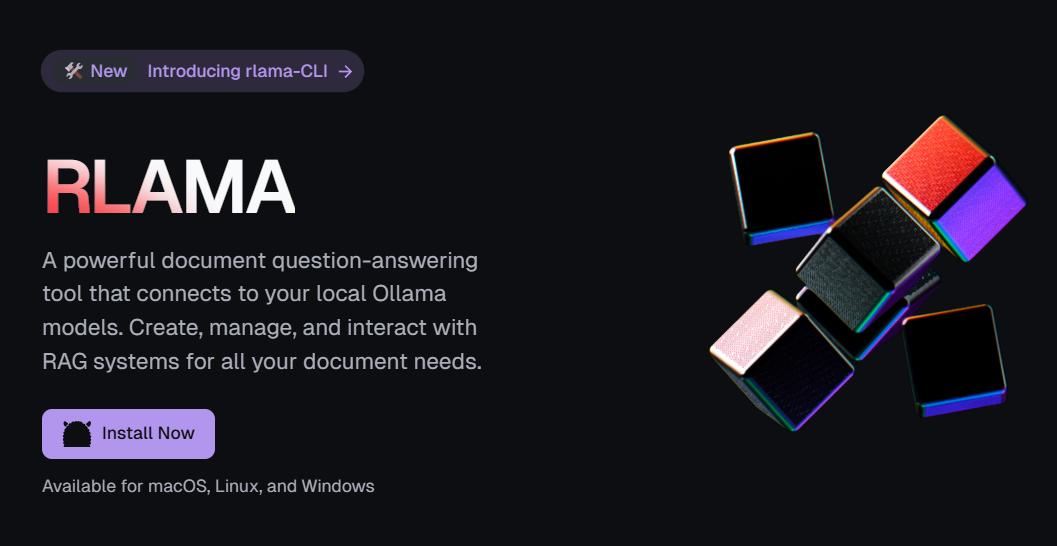

- コンテンツ監査 コンテンツ監査にLlamaGuardを導入(必須) グロック (APIキー)。

- ストリームリット・インターフェイス エージェントと対話するためのユーザーフレンドリーなチャットインターフェースを提供します。

- マルチエージェント対応 サービス内で複数のプロキシを実行し、URLパス経由で呼び出す。

- 非同期設計 async/awaitで同時リクエストを効率的に処理。

- フィードバック・メカニズム LangSmithと統合されたスターベースのフィードバックシステム。

- ダイナミック・メタデータ infoエンドポイントは、サービスや利用可能なエージェントやモデルに関する動的な構成メタデータを提供する。

- Dockerのサポート : 開発とデプロイを容易にするDockerfileとdocker composeファイルが含まれています。

- 試験 完全な単体テストと統合テストを含む。

ヘルプの使用

設置プロセス

- Pythonで直接実行する ::

- 少なくとも1つのLLM APIキーがあることを確認してください:

echo 'OPENAI_API_KEY=your_openai_api_key' >> .env- 依存関係をインストールし、同期する:

pip install uv uv sync --frozen- 仮想環境をアクティベートし、サービスを実行する:

source .venv/bin/activate python src/run_service.py- 別のターミナルで仮想環境を起動し、Streamlit アプリケーションを実行する:

source .venv/bin/activate streamlit run src/streamlit_app.py - Dockerで実行する ::

- 少なくとも1つのLLM APIキーがあることを確認してください:

bash echo 'OPENAI_API_KEY=your_openai_api_key' >> .env - Docker Composeで実行する:

bash docker compose up

- 少なくとも1つのLLM APIキーがあることを確認してください:

機能 操作の流れ

- ラングラフエージェント ::

- プロキシを定義する

src/agents/異なる能力を持つエージェントを定義するためのカタログ。 - プロキシの設定

langgraph.jsonファイルは、エージェントの動作と設定を構成します。

- プロキシを定義する

- FastAPI サービス ::

- サービスの開始: run

src/service/service.pyFastAPI サービスを開始します。 - エンドポイントへのアクセス:経由

/stream歌で応える/non-streamエンドポイントアクセスプロキシサービス。

- サービスの開始: run

- ストリームリット・インターフェイス ::

- 起動画面:実行

src/streamlit_app.pyStreamlitアプリケーションを起動する。 - インタラクティブな使用:ユーザーフレンドリーなチャットインターフェイスを介してエージェントと対話する。

- 起動画面:実行

- コンテンツ監査 ::

- LlamaGuardを設定する。

.envファイルに Groq API キーを追加して、コンテンツ監査を有効にします。

- LlamaGuardを設定する。

- マルチエージェント対応 ::

- 複数のプロキシを設定する

src/agents/複数のプロキシを定義し、異なるURLパスで呼び出すためのディレクトリ。

- 複数のプロキシを設定する

- フィードバック・メカニズム ::

- 統合フィードバックシステム: エージェントサービスにスターベースのフィードバックシステムが統合され、サービスを改善するためにユーザからのフィードバックを収集します。

- ダイナミック・メタデータ ::

- メタデータへのアクセス:経由

/infoエンドポイントは、サービスや利用可能なエージェントやモデルに関する動的な設定メタデータを取得します。

- メタデータへのアクセス:経由

- 試験 ::

- テストの実行

tests/サービスの安定性と信頼性を確保するための単体テストと統合テストを実行するためのカタログ。

- テストの実行

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません