エージェントAI:マルチモーダルインタラクションのフロンティアの世界を探る[フェイフェイ・リ-古典必読書]

エージェントAI:マルチモーダルインタラクションの地平を探る。

オリジナル:https://ar5iv.labs.arxiv.org/html/2401.03568

抄録

マルチモーダルAIシステムは、私たちの日常生活においてユビキタスになる可能性が高い。これらのシステムをよりインタラクティブなものにするための有望なアプローチのひとつは、物理的・仮想的環境における知能として実装することである。現在のところ、システムは、具現化された知能を作成するための基本的な構成要素として、既存の基本モデルを利用している。このような環境に知能を埋め込むことは、視覚データや文脈データを処理・解釈するモデルの能力に貢献し、より複雑で文脈を認識するAIシステムを作成するために不可欠である。例えば、ユーザーの行動、人間の行動、環境オブジェクト、音声表現、シーンの集合的な感情を感知できるシステムは、与えられた環境における知的体の反応に情報を与え、導くために使用することができる。マルチモーダル知能に基づく知能の研究を加速させるために、我々は「エージェントAI」を、視覚刺激、言語入力、およびその他の環境ベースのデータを知覚でき、意味のある身体化された行動を生成できる相互作用システムのクラスとして定義する。特に、外部知識、多感覚入力、人間のフィードバックを統合することにより、次の具現化された行動に基づく知能の予測を改善することを目的としたシステムを探求する。また、大規模なベースモデルの錯覚や、環境的に正しくない出力を生成する傾向も、地に足のついた環境で知的身体AIシステムを開発することで緩和できると主張する。エージェントAI」という新たな分野は、マルチモーダルインタラクションの、より広範な身体化された知的身体の側面をカバーしている。物理的な世界で行動し、相互作用するインテリジェンスに加えて、私たちは、人々があらゆる仮想現実やシミュレーションのシナリオを簡単に作成し、仮想環境に埋め込まれたインテリジェンスと相互作用できる未来を構想しています。

![Agent AI: 探索多模态交互的边界-1 Agent AI: 探索多模态交互的前沿世界[李飞飞-经典必读]](https://aisharenet.com/wp-content/uploads/2025/01/6dbf9ac2da09ee1.png)

エージェントAIは、一般人工知能(AGI)への有望な道筋として浮上している。エージェントAIのトレーニングは、物理世界においてマルチモーダルな理解を行う能力を実証している。エージェントAIのトレーニングは、物理世界でマルチモーダルな理解を行う能力を実証しています。エージェントAIは、生成AIと複数の独立したデータソースを活用することで、現実に依存しないトレーニングのフレームワークを提供します。クロスリアリティのデータでトレーニングすることで、知能や行動に関連するタスクのためにトレーニングされた大規模なベースモデルを物理世界と仮想世界の両方に適用することができる。我々は、多くの異なるドメインとアプリケーションにおいて知覚と行動が可能なエージェントAIシステムの一般的な概要を示し、知的身体パラダイムを用いたAGIへの道筋となる可能性がある。

ディレクトリ

- 1 紹介

- 1.1 機関車

- 1.2 コンテキスト

- 1.3 中抜き

- 2 エージェントAIの統合

- 2.1 無限のAIインテリジェンス

- 2.2 大規模なベースモデルを使用したエージェントAI

- 2.2.1 空想の産物

- 2.2.2 偏見と包括性

- 2.2.3 データのプライバシーと使用

- 2.2.4 解釈可能性と描写力

- 2.2.5 推論の強化

- 2.2.6 監督的

- 2.3 創発的能力のためのエージェントAI

- 3 エージェントAIのパラダイム

- 3.1 大規模言語モデルと視覚言語モデル

- 3.2 インテリジェント・ボディ・トランスの定義

- 3.3 インテリジェント・ボディ・トランスフォーマーの誕生

- 4 エージェントAI学習

- 4.1 戦略とメカニズム

- 4.1.1 強化学習(RL)

- 4.1.2 イミテーション・ラーニング(IL)

- 4.1.3 従来のRGB

- 4.1.4 状況学習

- 4.1.5 インテリジェントな身体システムにおける最適化

- 4.2 インテリジェント・ボディ・システム(ゼロおよび少数のサンプルレベル)

- 4.2.1 インテリジェント・ボディ・モジュール

- 4.2.2 インテリジェント・ボディ・インフラ

- 4.3 インテリジェント・ボディ・ベース・モデル(事前トレーニングおよび微調整レベル)

- 4.1 戦略とメカニズム

- 5 エージェントAIの分類

- 5.1 一般知能ボディ分野

- 5.2 具現化された知性

- 5.2.1 モバイルインテリジェンス

- 5.2.2 相互作用する知性

- 5.3 シミュレーションと環境知能

- 5.4 ジェネレーティブ・インテリジェンス

- 5.4.1 AR/VR/複合現実 インテリジェント・ボディ

- 5.5 知的・論理的推論の知性

- 5.5.1 インテレクチュアル・インテリジェンス・ユニット(KIU)

- 5.5.2 論理的知性

- 5.5.3 感情的推論のためのインテリゲンチア

- 5.5.4 ニューロシンボリック・インテリジェンス・ユニット(NSI)

- 5.6 大規模言語モデリングと視覚言語モデリングのインテリゲンチャ

- 6 エージェントAIアプリケーションのタスク

- 6.1 ゲーム用インテリジェント・ボディ

- 6.1.1 NPCの行動

- 6.1.2 人間とNPCの交流

- 6.1.3 インテリジェントなボディベースのゲーム分析

- 6.1.4 ゲームシーンの合成

- 6.1.5 実験と結果

- 6.2 ロボット工学

- 6.2.1 ロボット工学のための大規模言語モデル/視覚言語モデル知能。

- 6.2.2 実験と結果。

- 6.3 ヘルスケア

- 6.3.1 現在の医療能力

- 6.4 マルチモーダルインテリジェンス

- 6.4.1 画像言語理解と生成

- 6.4.2 映像と言語の理解と生成

- 6.4.3 実験と結果

- 6.5 ビデオ - 言語実験

- 6.6 自然言語処理のためのインテリジェンシア

- 6.6.1 ビッグ・ランゲージ・モデリング・インテリジェンス

- 6.6.2 ユニバーサル・ラージ・ランゲージ・モデリング・インテリジェンス(ULM)

- 6.6.3 コマンドに従う大規模言語モデル インテリジェンシア

- 6.6.4 実験と結果

- 6.1 ゲーム用インテリジェント・ボディ

- 7 モダリティ、ドメイン、現実を横断するエージェントAI

- 7.1 クロスモーダル理解のためのインテリジェンシア

- 7.2 領域を超えた理解のためのインテリジェンシア

- 7.3 クロスモーダル、クロスリアルのためのインタラクティブ・インテリジェンス

- 7.4 シミュレーションから現実への移行

- 8 エージェントAIの継続的な自己改善

- 8.1 人間の相互作用に基づくデータ

- 8.2 ベースモデルが生成したデータ

- 9 スマートボディのデータセットとリーダーボード

- 9.1 多知能ゲームのための「CuisineWorld」データセット

- 9.1.1 参照基準

- 9.1.2 マンデート

- 9.1.3 指標と判断

- 9.1.4 評価

- 9.2 音声-映像-言語の事前学習データセット。

- 9.1 多知能ゲームのための「CuisineWorld」データセット

- 10 より広範な影響に関する声明

- 11 倫理的配慮

- 12 ダイバーシティ・ステートメント

- A GPT-4V インテリジェント・ボディアラート 詳細

- B ブリーディング・エッジ用GPT-4V

- C マイクロソフトフライトシミュレータ用GPT-4V

- D アサシン クリード オデッセイ用GPT-4V

- E ギア・オブ・ウォー4用GPT-4V

- F スターフィールド用GPT-4V

1 はじめに

1.1 動機

歴史的に見ると、AIシステムは1956年のダートマス会議で、環境から情報を収集し、有用な方法で環境と相互作用できる「人工生命体」と定義された。この定義に触発されたMITのミンスキーのグループは、1970年に「レプリカ・デモンストレーション」と呼ばれるロボット・システムを構築し、「ブロック・ワールド」シナリオを観察し、観察された多面体ブロック構造の再構築に成功した。このシステムには、観察、計画、操作の各モジュールが含まれており、それぞれのサブ問題が困難であり、さらなる研究が必要であることが明らかになった。AIの分野は、これらの問題やその他の問題を解決するために大きな進歩を遂げた専門的なサブ分野に細分化されているが、単純化しすぎるとAI研究の全体的な目標が見えなくなってしまう。

現状を打破するためには、アリストテレス的全体論に基づくAIの基礎に立ち返る必要がある。幸いなことに、近年の大規模言語モデリング(LLM/Large Language Model)と視覚言語モデリング(VLM/Visual Language Model)の革命により、全体論的理想に適合する新しいタイプのAI知能を創造することが可能になった。この機会を捉え、本稿では言語能力、視覚認知、文脈記憶、直感的推論、適応性を統合したモデルを探求する。この全体論的統合を達成するために、大規模言語モデルと視覚言語モデルを使用する可能性を探る。また、これまでのAI開発では軽視されてきたと思われる、アリストテレスの「目的論的原因」、すなわち目的論的な「システムの存在理由」に基づくシステムの設計についても再考する。

自然言語処理とコンピュータ・ビジョンのルネッサンスは、強力な事前学習済みビッグ言語モデルと視覚言語モデルの出現によって促進された。ビッグ言語モデルは現在、実世界の言語データのニュアンスを解読する驚くべき能力を示しており、しばしば人間の専門知識に匹敵するか、それを上回ることさえある OpenAI (2023)。最近、研究者たちは、ビッグ言語モデルが以下のようなさまざまな環境で動作するように拡張できることを示している。インテリジェントボディXiら(2023)は、領域固有の知識やモジュールと組み合わせることで、複雑な行動やタスクを実行する知能を開発した。これらのシナリオは、複雑な推論、知能の役割と環境の理解、多段階の計画によって特徴付けられ、環境の制約の中で高度に微妙で複雑な意思決定を行う知能の能力が試される。Fundamental AI Research (FAIR) Diplomacy Team, Bakhtin, Brown, Dinan, Farina, Flaherty, Fried, Goff, Gray, Hu, et al.

このような初期の取り組みに基づき、AIコミュニティは、受動的で構造化されたタスクで使用するためのAIモデルの作成から、多様で複雑な環境において動的で知的な身体の役割を担うことができるモデルへと、大きなパラダイムシフトを遂げようとしている。このような背景から、本稿では、言語的能力、視覚的認知、文脈記憶、直感的推論、適応性を兼ね備えたモデルを重視し、大規模言語モデルと視覚言語モデルをインテリジェントとして使用することの大きな可能性を調査する。特にゲーム、ロボット工学、ヘルスケアなどの分野で、大規模言語モデルや視覚言語モデルを知能体として利用することは、最先端のAIシステムを評価するための厳密なプラットフォームを提供するだけでなく、知能体中心のAIが社会や産業にもたらす変革的な影響を予見させる。インテリジェント・ボディ・モデルが完全に活用されれば、人間の体験を再定義し、業務水準を向上させることができる。これらのモデルによる完全自動化の可能性は、産業と社会経済ダイナミクスの劇的な変化を予告している。これらの進歩は、セクション11で詳しく述べるように、技術的だけでなく倫理的にも、多面的なリーダーボードと絡み合うだろう。これらの知的身体AIのサブフィールドの重なり合う領域を掘り下げ、図1にその相互関連性を示す。

1.2 背景

ここでは、知的体のための人工知能のコンセプト、理論的背景、最新の実装を裏付ける関連研究論文を紹介する。

大規模なベースモデル。

大規模言語モデルや視覚言語モデルは、汎用的な知的機械の開発努力を後押ししてきた(Bubeck et al, 2023; Mirchandani et al, 2023)。これらは大規模なテキスト・コーパスを用いて学習されるが、その優れた問題解決能力は、正規の言語処理領域に限定されるものではない。大規模言語モデルは、数学的推論(Imani et al., 2023; Wei et al., 2022; Zhu et al., 2022)から特殊な法律問題への回答(Blair-Stanek et al.)2023; Nay, 2022)。最近の研究では、ロボット工学やゲームAI用の複雑な計画を生成するために大規模な言語モデルを使用することが可能であることが示されている(Liang et al., 2022; Wang et al., 2023a, b; Yao et al., 2023a; Huang et al.

エンボディドAI。

特に、複雑なタスクプランニングと推論を実行するための、ワールドワイドウェブ規模のドメイン知識と、大規模言語モデルの出現的なゼロサンプル具現化能力である。最近のロボット工学研究でも、自然言語コマンドを一連のサブタスク(自然言語形式またはPythonコード形式)に分解し、それを低レベルコントローラで実行することで、大規模言語モデルを活用してタスク計画を実行している(Ahn et al.さらに、タスクのパフォーマンスを向上させるために、環境フィードバックを組み込んでいる(Huangら、2022b)、(Liangら、2022)、(Wangら、2023a)、(Ikeuchiら、2023)。

インタラクティブな学習:

対話型学習のために設計されたAI知能は、機械学習技術とユーザーとの対話を組み合わせて動作する。最初に、AI知能は大規模なデータセットで学習される。このデータセットには、インテリジェンスが意図する機能に応じて、さまざまな種類の情報が含まれている。例えば、言語タスク用に設計されたAIは、テキストデータの大規模なコーパスで訓練される。学習には機械学習アルゴリズムが使用され、これにはディープラーニングモデル(ニューラルネットワークなど)が含まれることもある。これらの学習モデルにより、AIはパターンを認識し、予測を行い、訓練されたデータに基づいて応答を生成することができる。AIインテリジェンスは、ユーザーとのリアルタイムの対話からも学習することができる。1)フィードバックに基づく学習:AIは、ユーザーからの直接的なフィードバックに基づいて応答を調整する Li et al.2)観察学習:AIはユーザーとのやりとりを観察し、暗黙的に学習する。例えば、ユーザーが頻繁に似たような質問をしたり、特定の方法でAIと対話したりする場合、AIはこれらのパターンにうまく合うように応答を適応させることができる。これにより、AIインテリジェンスは、人間の言語、マルチモーダルな設定、クロスリアリティな状況の解釈、人間のユーザーからの応答の生成を理解し、処理することができる。時間の経過とともに、AI知能の性能は通常、ユーザーとの対話とフィードバックを重ねることで向上し続ける。このプロセスは通常、AIが適切に学習し、偏りや誤ったパターンが生じていないことを確認する人間のオペレーターや開発者によって監督される。

1.3 概要

マルチモーダル・エージェントAI(MAA/Multimodal Agent AI)は、マルチモーダルな感覚入力の理解に基づいて、与えられた環境において効果的な行動を生成するシステムの集合である。ラージ・ランゲージ・モデル(LLM/Large Language Model)やビジュアル・ランゲージ・モデル(VLM/Visual Language Model)の登場により、基礎研究から応用に至るまで、数多くのマルチモーダル・エージェントAIシステムが提案されている。これらの研究領域は、各領域における伝統的な技術(例えば、視覚的質問や視覚言語ナビゲーション)との統合を通じて急速に発展しているが、データ収集、ベンチマーク、倫理的観点などの共通の関心事を有している。本稿では、マルチモーダル知能AIの代表的な研究領域であるマルチモーダリティ、ゲーム(VR/AR/MR)、ロボティクス、ヘルスケアに焦点を当て、これらの領域で議論されている共通の関心事に関する包括的な知識を提供することを目的とする。そのため、マルチモーダルインテリジェンスのためのAIの基礎を学び、その研究をさらに進めるための知見を得たいと考えています。具体的な学習成果は以下の通り:

- マルチモーダルインテリジェンシアのための人工知能の概要:その原理と現代のアプリケーションにおける役割について深く考察し、研究者にその重要性と用途を包括的に把握させる。

- 方法:ゲーム、ロボット工学、ヘルスケアのケーススタディでは、マクロ言語モデルと視覚言語モデルが、マルチモーダルインテリジェンスの人工知能をどのように強化できるかを詳しく説明している。

- 性能評価:関連するデータセットを用いて、マルチモーダルインテリジェンスAIの有効性と汎化能力に焦点を当てて評価するためのガイド。

- 倫理的考察:インテリジェントボディAIの導入による社会的影響と倫理的ランキングについての考察。

- 新潮流と未来図:各分野の最新動向を分類し、今後の方向性を論じる。

コンピュータベースの行動知性体やジェネラリスト知性体(GA/Generalist Agent)は多くのタスクに有用である。ジェネラリスト・インテリジェント・ボディがユーザーにとって真に価値あるものとなるためには、自然なインタラクションが可能で、幅広い文脈やモダリティに汎化できることが必要です。我々の目標は、インテリジェントボディAIコミュニティ内に活気ある研究エコシステムを育成し、アイデンティティと目的意識を共有することである。マルチモーダル知能身体AIは、人間からの入力を含む幅広い文脈やモダリティに適用できる可能性を秘めています。したがって、この知的身体AIの分野は、多種多様な研究者を惹きつけ、それによってダイナミックな知的身体AIコミュニティと共通の目標を育むことができると考えています。学術界と産業界の著名な専門家が率いる本論文は、スマートボディのチュートリアル、ケーススタディ、タスクセッション、実験的なディスカッションを含むインタラクティブで有益な体験となり、すべての研究者にとって包括的で魅力的な学習体験となることを期待しています。

本稿の目的は、インテリジェンスのための人工知能分野における現在の研究について、一般的かつ包括的な知識を提供することである。そのために、本稿の残りの部分は以下のように構成されている。セクション2では、インテリジェントな身体AIが、関連する新技術、特に大規模なベースモデルとの統合からどのような利益を得ることができるかを概説する。セクション3では、知的身体AIをトレーニングするために我々が提案する新しいパラダイムとフレームワークについて説明する。セクション4では、知的身体AIのトレーニングに広く用いられている手法の概要を説明する。セクション5では、様々なタイプの知能を分類し、議論する。第6節では、ゲーム、ロボット工学、ヘルスケアにおける知的身体AIの応用について述べる。第7節では、様々なモダリティやドメインに適用でき、シミュレーションから現実へのギャップを埋めることができる汎用的な知的身体AIを開発するための研究コミュニティの取り組みを探る。セクション8では、事前に訓練されたベースモデルに依存するだけでなく、環境やユーザーとの相互作用を利用することで継続的に学習し、自己改善する知的身体AIの可能性について議論する。セクション9では、マルチモーダル知能身体AIのトレーニング用に設計された我々の新しいデータセットについて説明する。セクション11では、AI知能のホットトピック、限界、および本稿の社会的影響に関する倫理的考察について述べる。

2 インテリジェントボディ 人工知能の統合

先行研究で示唆されているように、マクロ言語モデルや視覚言語モデルに基づく基礎モデルは、特に未知の環境やシーンの理解、生成、編集、対話において、具現化AIの分野ではまだ限定的なパフォーマンスしか示さない。その結果、このような限界は、AI知能の出力が最適化されないことにつながる。知能中心のAIモデリングに対する現在のアプローチは、直接アクセス可能で明確に定義されたデータ(例えば、世界の状態のテキストまたは文字列表現)に焦点を当て、通常、大規模な事前学習から学習されたドメインや環境に依存しないパターンを使用して、各環境に対する行動出力を予測する Xi et al.ら(2023a); Wuら(2023)。(Huangら、2023a)では、大規模なベースモデルを組み合わせることにより、知識誘導型コラボレーションと対話型シーン生成のタスクを調査し、大規模言語モデルの知識ベースのインテリジェンスが、2Dおよび3Dシーンの理解、生成、編集、および他の人間とコンピュータの相互作用のパフォーマンスを向上させることができることを示唆する有望な結果を示しているHuangら(2023a)。).Intelligent Body AIフレームワークを統合することで、大規模ベースモデルはユーザー入力をより深く理解することができ、その結果、複雑で適応的なヒューマンコンピュータインタラクションシステムを実現することができる。大規模言語モデルと視覚言語モデルの創発的能力は、生成的AI、具現化AI、マルチモーダル学習のための知識増強、混合現実生成、テキストから視覚への編集、ゲームやロボットタスクにおける2D/3Dシミュレーションのための人間とコンピュータの相互作用において、未知の役割を果たす。知的身体AIの基礎的モデリングにおける最近の進歩は、具現化された知能における一般的な知能を解き放つための差し迫った触媒を提供する。大規模な行動モデルや知能の視覚言語モデルは、複雑な環境における計画、問題解決、学習など、汎用的な具現化システムの新たな可能性を開く。知的具現化AIは、メタ宇宙においてさらなる一歩を踏み出し、汎用AIの初期バージョンへの道を指し示す。

![Agent AI: 探索多模态交互的世界[李飞飞-经典必读]-1 Agent AI: 探索多模态交互的前沿世界[李飞飞-经典必读]](https://aisharenet.com/wp-content/uploads/2025/01/2dd99ca44577ecf.png)

図2:現実を超えた2D/3D具現化生成・編集インタラクションのためのマルチモーダル・スマートボディAI。

2.1 無限の人工知能インテリジェンス

人工知能は、訓練と入力データに基づいて解釈し、予測し、反応する能力を持っている。これらの能力は高度化し、向上しているが、その限界と、学習させる基礎データの影響を認識することが重要である。1) 予測モデリング: AIインテリジェンスは、過去のデータや傾向に基づいて、起こりそうな結果を予測したり、その後のステップを提案したりすることができる。例えば、テキストの続き、質問に対する答え、ロボットの次の行動、またはシナリオの解決策を予測することができる。2)意思決定:一部のアプリケーションでは、AI知能は推論に基づいて意思決定を行うことができる。通常、知能は、指定された目標を達成する可能性が最も高いものに基づいて意思決定を行う。推薦システムなどのAIアプリケーションでは、ユーザーの嗜好に関する推論に基づいて、どの製品やコンテンツを推薦するかを決定することができる。3) あいまいさの処理: AI知能は、文脈や訓練に基づいて最も可能性の高い解釈を推論することで、あいまいな入力を処理できることが多い。4) 継続的な改善: AI知能の中には、新しいデータや相互作用から学習する能力を持つものもあるが、多くの大規模な言語モデルは、学習後に知識ベースや内部表現を継続的に更新することはない。彼らの推論は通常、最後のトレーニング更新時に利用可能なデータのみに基づいている。

図2には、マルチモーダルかつクロスリアリティにとらわれない統合と、創発的メカニズムによる拡張対話型知能を示す。人工知能の知能体は、新しいタスクのたびに大量の学習データを収集する必要があるが、これは多くの領域ではコストがかかるか不可能である。本研究では、汎用ベースモデル(GPT-X、DALL-Eなど)から新しいドメインやシナリオにインメモリ情報を転送し、物理世界や仮想世界でのシナリオ理解、生成、対話的編集を学習する無限の知的体を開発する。

このような無限の知能をロボット工学に応用したものに、RoboGen Wangら(2023d)がある。この研究で著者らは、タスク提案、環境生成、スキル学習サイクルを自律的に実行するためのパイプラインを提示している。RoboGenは、大規模モデルに埋め込まれた知識をロボット工学に移転する取り組みである。

2.2 大規模なベースモデルを持つインテリジェンシアのための人工知能

最近の研究により、大規模なベースモデルは、環境による制約の中で知的体の行動を決定するためのベンチマークとして機能するデータを作成する上で、重要な役割を果たすことが示されている。例えば、ロボット操作のためのベースモデルの使用 Black et al.例を挙げると、Blackらは、低レベルの戦略Blackら(2023)を導くために、将来のサブゴールの画像を生成する高レベルのプランナーとして画像編集モデルを採用している。Shahらはロボットナビゲーションのために、テキストからランドマークを認識するマクロ言語モデルと、これらのランドマークを視覚入力と関連付ける視覚言語モデルを採用したシステムを提案しており、これにより自然言語コマンドによるナビゲーションを強化している。

また、言語的要因や環境的要因に合わせた条件付きの人間の動きを生成することへの関心も高まっている。Kimら(2023年)、Zhangら(2022年)、Tevetら(2022年)、Wangら(2022a)は、特定の言語コマンドにカスタマイズされた動きやアクションを生成し、さまざまな3Dシーンに適応させるAIシステムをいくつか提案している。この研究は、様々なシナリオにおけるAI知能の適応性と応答性を高める上で、生成モデルの能力が高まっていることを強調している。

2.2.1 幻覚

すなわち、生成されたテキストが無意味であったり、提供されたソース・コンテンツと一致しなかったりする状況である。幻覚は2つのカテゴリーに分けられる。錯覚歌で応える外部錯覚 Jiら(2023)。本質的な錯覚とは、原文と矛盾する錯覚であり、外在的な錯覚とは、生成されたテキストに原文に含まれていない追加情報が含まれている場合である。

言語生成における錯覚の割合を減らすための有望な手段には、生成を強化するために検索を使用するLewisら(2020); Shusterら(2021)や、外部知識検索によって自然言語出力をサポートする他のアプローチが含まれる Dziriら(2021); Pengら(2023)。一般的に、これらのアプローチは、他のソース資料を検索し、生成された応答とソース資料との間の矛盾をチェックするメカニズムを提供することによって、言語生成を強化することを目的としている。

マルチモーダル知的身体システムの文脈では、視覚言語モデルも幻覚を生成することが示されている Zhou et al.視覚ベースの言語生成における幻覚の一般的な原因は、学習データにおけるオブジェクトと視覚的手がかりの共起への過度の依存である Rohrbach et al.事前に訓練されたマクロ言語モデルまたは視覚言語モデルのみに依存し、限定的なコンテキスト固有の微調整を使用するAI知能は、行動を生成するために事前に訓練されたモデルの内部知識ベースに依存し、それらが展開される世界状態のダイナミクスを正確に理解していない可能性があるため、特に幻覚を起こしやすい可能性がある。

2.2.2 偏見と包括性

大規模言語モデル(LLM)や大規模マルチモーダルモデル(LMM)に基づくAI知能は、その設計と学習過程に内在する複数の要因によって偏りが生じている。このようなAI知能を設計する際には、包括性に留意し、すべてのエンドユーザーと利害関係者のニーズを意識する必要があります。AI知能の文脈では非独占性 とは、インテリゲンチャの対応や交流が、多様な背景を持つ幅広い利用者を包摂し、尊重し、配慮したものであることを保証するために採用される措置や原則のことである。以下に、インテリジェント・ボディの偏見と包摂性の重要な側面を示す。

- トレーニングデータ基礎となるモデルは、書籍、記事、ウェブサイト、その他のテキストソースを含む、インターネットから収集された大量のテキストデータに対して学習される。これらのデータは、人間社会に存在する偏見を反映していることが多く、モデルが不注意に学習し、再現する可能性がある。これには、人種、性別、民族、宗教、その他の個人的属性に関連するステレオタイプ、偏見、偏った見方が含まれる。特に、インターネットデータで学習し、多くの場合英語のテキストのみを学習に使用することで、モデルは、インターネット上で不釣り合いな存在感を示している、西洋、教育、工業化、富裕、民主的(WEIRD)社会の文化規範を暗黙のうちに学習してしまうHenrich et al.しかし、人間が作成したデータセットにバイアスが全くないとは言い切れないことを認識することが重要である。なぜなら、データセットには、最初にデータを作成・編集した個人のバイアスだけでなく、社会のバイアスが反映されていることが多いからである。

- 歴史的・文化的バイアスAIモデルは、多様なコンテンツの大規模なデータセットで学習される。そのため、学習データには歴史的なテキストや異なる文化圏の資料が含まれることが多い。特に、歴史的資料からの学習データには、特定の社会の文化的規範、態度、偏見を表す攻撃的または軽蔑的な言葉が含まれている可能性があります。その結果、時代遅れのステレオタイプを永続させたり、現代の文化の変化やニュアンスを十分に理解できないモデルが生まれる可能性があります。

- 言語と文脈の制約言語モデルは、皮肉やユーモア、文化的な暗示など、言葉のニュアンスを理解し、正確に表現することが難しい場合があります。これは、場合によっては誤解や偏った回答につながる可能性がある。さらに、話し言葉の多くの側面はテキストのみのデータでは捉えられないため、人間が言語を理解する方法とモデルが言語を理解する方法との間に断絶が生じる可能性がある。

- 方針とガイドラインAIインテリジェンスは、公平性と包括性を確保するための厳格なポリシーとガイドラインの下で運用されている。例えば、画像を生成する際には、登場人物の描写を多様化し、人種や性別、その他の属性に関連するステレオタイプを避けるためのルールがあります。

- 過度の一般化これらのモデルは、学習データに見られるパターンに基づいて回答を生成する傾向がある。これは過度の一般化につながる可能性があり、モデルは特定のグループをステレオタイプ化したり、大雑把な仮定をしたりするような回答を生成する可能性がある。

- 継続的なモニタリングと更新AIシステムは継続的に監視され、バイアスや包括性の新たな問題に対処するために更新されます。このプロセスでは、ユーザーからのフィードバックとAI倫理に関する継続的な研究が重要な役割を果たします。

- 主流派の見解を増幅トレーニングデータには通常、支配的な文化やグループのコンテンツが多く含まれるため、モデルはこれらの意見に偏り、少数派の意見を過小評価したり歪めたりする可能性があります。

- 倫理的で包括的なデザインAIツールは、倫理的配慮と包括性を基本原則として設計されるべきである。これには、文化の違いを尊重し、多様性を促進し、AIが有害なステレオタイプを永続させないようにすることが含まれる。

- ユーザーガイドユーザーは、包括性と尊重を促進する方法でAIと対話する方法についても指導されます。これには、偏った出力や不適切な出力につながる可能性のある要求を避けることも含まれます。さらに、モデルがユーザーとのやり取りから有害な内容を学習する状況を緩和するのにも役立ちます。

こうした対策にもかかわらず、AI知能の偏りは依然として残っている。AIの研究開発では、このようなバイアスをさらに低減し、AI知能システムの包括性と公平性を高めることに重点を置いた取り組みが続けられている。バイアス削減の取り組み

- 多様で包括的なトレーニングデータトレーニングデータに、より多様で包括的な情報源を含める努力を行っている。

- バイアスの検出と補正現在進行中の研究は、モデルの応答におけるバイアスの検出と修正に重点を置いている。

- 倫理指針および方針モデルは多くの場合、偏見を緩和し、敬意に満ちた包括的な交流を保証するために設計された倫理的ガイドラインやポリシーに拘束されている。

- 多様な表現AIインテリジェンスが生成または提供するコンテンツが、人間の経験、文化、民族、アイデンティティを幅広く表現するようにする。これは、画像生成や物語構築などのシナリオにおいて特に関連する。

- バイアスの緩和AIの対応における偏見を減らすために積極的に取り組む。これには、人種、性別、年齢、障害、性的指向、その他の個人的特徴に関連する偏見が含まれる。目標は、ステレオタイプや偏見を永続させるのではなく、公平でバランスの取れた回答を提供することです。

- 文化的感受性AIのデザインは、文化的規範、慣習、価値観の多様性を認識し、尊重する文化的配慮がなされています。これには、文化的な言及やニュアンスを理解し、適切に対応することも含まれます。

- アクセシビリティAIインテリジェンスが、障害者を含むさまざまな能力を持つユーザーにとって利用しやすいものであることを保証する。これには、視覚、聴覚、運動、認知に障害を持つ人々が対話しやすくする機能を組み込むことが含まれる。

- 言語ベースの包括性グローバルなユーザーのために、複数の言語や方言をサポートし、言語内のニュアンスや差異に敏感であること。

- 倫理的で尊敬に値する交流インテリジェンスは、すべてのユーザーと倫理的かつ敬意を持って対話し、攻撃的、有害、または無礼と見なされる可能性のある反応を避けるようにプログラムされています。

- ユーザーからのフィードバックと適応AIインテリジェンスの包括性と有効性を継続的に改善するために、ユーザーからのフィードバックを取り入れる。これには、多様なユーザーをよりよく理解し、サービスを提供するために、相互作用から学ぶことも含まれる。

- 包括的ガイドラインの遵守業界団体、倫理委員会、または規制機関によって設定されることが多い。

このような努力にもかかわらず、回答に偏りがある可能性を認識し、その解釈について批判的に考えることが重要である。AI知能技術と倫理的実践の継続的な改善は、時間の経過とともにこのような偏りを減らすことを目指している。知的な身体 AIによる包括性の包括的な目標の1つは、バックグラウンドやアイデンティティに関係なく、すべてのユーザーを尊重し、利用しやすい知的な身体を作ることである。

2.2.3 データのプライバシーと使用

AIインテリジェンスに関する重要な倫理的検討事項には、これらのシステムがどのようにユーザーデータを処理し、保存し、潜在的に取得するかを理解することが含まれる。以下に重要な側面について述べる:

データの収集、使用、目的

モデルのパフォーマンスを向上させるためにユーザーデータを使用する場合、モデル開発者は、AIインテリジェンスが生産時やユーザーとの対話時に収集したデータにアクセスすることができる。システムによっては、ユーザーがユーザーアカウントを通じて、またはサービスプロバイダーにリクエストすることで、自分のデータを見ることができます。このようなインタラクション中にAIインテリジェンスがどのようなデータを収集しているかを認識することが重要です。これには、テキスト入力、ユーザーの使用パターン、個人的な嗜好、場合によってはよりセンシティブな個人情報などが含まれる。ユーザーは、対話から収集されたデータがどのように使用されるかも理解する必要がある。何らかの理由で、AIが特定の個人やグループに関する誤った情報を保持している場合、それが認識された時点で、ユーザーがその誤りを修正できるような仕組みが必要です。これは、正確さと、すべてのユーザーとグループに対する尊重のために重要である。ユーザーデータを検索・分析する一般的な用途としては、ユーザーとのインタラクションの改善、応答のパーソナライズ、システムの最適化などがある。ユーザーが同意していない目的(例えば、未承諾のマーケティング)にデータが使用されないようにすることは、開発者にとって重要です。

保管とセキュリティ。

開発者は、ユーザのインタラクションデータがどこに保存されているか、また、不正なアクセスや開示からデータを保護するためのセキュリティ対策がどのように講じられているかを認識しておく必要があります。これには、暗号化、安全なサーバー、データ保護プロトコルが含まれる。スマートボディのデータが第三者と共有されるかどうか、またどのような条件で共有されるかを決定することが重要です。これは透明性のあるものでなければならず、通常はユーザーの同意を必要とする。

データの削除と保持

また、ユーザーにとって、ユーザーデータの保存期間と、ユーザーがデータの削除を要求する方法を理解することも重要です。AI Intelligentsiaは、EUのGDPRやカリフォルニア州のCCPAなどのデータ保護法を遵守する必要があります。これらの法律は、データ処理慣行とユーザーの個人データに対する権利を規定しています。

データポータビリティとプライバシーポリシー

さらに、開発者はAIインテリジェンスのプライバシーポリシーを作成し、データの取り扱い方法を文書化してユーザーに説明しなければならない。これには、データの収集、使用、保管、ユーザーの権利について詳述する必要がある。開発者は、特に機密情報については、データ収集についてユーザーの同意を確実に得るべきである。ユーザーは通常、提供するデータをオプトアウトまたは制限することができる。法域によっては、ユーザは他のサービスプロバイダに転送可能な形式で自分のデータのコピーを要求する権利を持っている場合もある。

匿名化。

より広範な分析やAIのトレーニングに使用されるデータについては、個人の身元を保護するために匿名化されることが理想的である。開発者は、AIインテリジェンスがインタラクション中に過去のユーザーデータをどのように取得し、使用するかを理解する必要がある。これはパーソナライゼーションのためかもしれないし、応答の関連性を高めるためかもしれない。

要約すると、AIインテリジェンスのデータプライバシーを理解することには、ユーザーデータがどのように収集、使用、保存、保護されるかを理解すること、そしてユーザーが自分のデータへのアクセス、修正、削除に関する権利を確実に認識することが含まれる。また、ユーザーとAIインテリジェンスのデータ検索メカニズムを理解することも、データプライバシーを完全に理解する上で極めて重要である。

2.2.4 解釈可能性と描写力

模倣による学習 → デカップリング

インテリジェンスは通常、強化学習(RL)や模倣学習(IL)の連続的なフィードバックループを用いて訓練される。しかし、このアプローチは、不慣れな環境で初期報酬を得る際にボトルネックに直面する。特に、報酬がまばらであったり、長いステップの相互作用の最後にしか得られなかったりする場合である。したがって、優れた解決策は、模倣学習によって訓練された無限記憶の知能を使用することである。この知能は、専門家のデータから戦略を学習することができ、図3に示すように、未知の環境空間の探索と利用の向上、および新たなインフラの構築につながる。未知の環境空間をより良く探索し、活用するための専門家の特徴を持つ。知能体AIは、専門家データから直接、戦略や新しいパラダイム・プロセスを学習することができる。

従来の模倣学習では、知的身体は専門家の実演者の行動を模倣することで戦略を学習する。しかし、専門家の戦略を直接学習することは、知能体が未知の状況にうまく汎化できない可能性があるため、必ずしも最善のアプローチとは限らない。この問題に対処するため、我々は、図3に示すように、専門家の行動の重要な側面を捉える文脈的手がかりや暗黙の報酬関数を用いて知的体を学習することを提案する。これにより、タスク実行のための専門家のデモンストレーションから学習した物理世界の行動データを、無限メモリ知能に装備する。これは、大量の専門家データの必要性や、複雑なタスクにおけるエラーの可能性など、既存の模倣学習の欠点を克服するのに役立つ。知的身体AIのキーとなるアイデアは2つある。1)物理世界の専門家のデモンストレーションを状態-動作のペアとして収集する無限知的身体と、2)模倣知的身体ジェネレータの仮想環境である。模倣知的身体は専門家の行動を模倣した行動を生成し、知的身体は専門家の行動と学習方針によって生成された行動との差の損失関数を減少させることによって、状態から行動への方針マッピングを学習する。

デカップリング → 一般化

タスク固有の報酬関数に依存する代わりに、知的身体は、タスクの様々な側面をカバーする多様な状態-動作ペアのセットを提供するエキスパートのデモンストレーションから学習する。そして知的身体は、エキスパートの行動を模倣することで、状態を行動にマッピングする戦略を学習する。模倣学習におけるデカップリングとは、学習プロセスをタスク固有の報酬関数から分離することであり、これにより、タスク固有の報酬関数に明示的に依存することなく、異なるタスク間で戦略を汎化することができる。デカップリングによって、知能指数は専門家の実演から学び、様々な状況に適応できる戦略を学習することができる。デカップリングは転移学習を可能にし、ある領域で学習した戦略を最小限の微調整で他の領域に適応させることができる。特定の報酬関数に縛られない一般化された戦略を学習することで、知的身体はあるタスクで得た知識を使って、関連する他のタスクで優れたパフォーマンスを発揮することができる。知的身体は特定の報酬機能に依存しないため、大規模な再訓練を行わなくても、報酬機能や環境の変化に適応することができる。これにより、学習された戦略はより頑健になり、異なる環境でも汎化できるようになる。この文脈では、デカップリングとは、学習プロセスにおける2つのタスク(報酬関数の学習と最適ポリシーの学習)を分離することを指す。

![Agent AI: 探索多模态交互的边界-3 Agent AI: 探索多模态交互的前沿世界[李飞飞-经典必读]](https://aisharenet.com/wp-content/uploads/2025/01/3cc0593b0703242.png)

図3:候補テキストから画像関連テキストを識別するための知能を用いた創発的相互作用メカニズムの例。このタスクでは、ネットワークからのマルチモーダルAI知能と手動でラベル付けされた知識対話サンプルを使って、外界の情報を統合する。

一般化 → 創発的行動

一般化とは、より単純な構成要素や規則から、どのように創発的な特性や振る舞いが生じるかを説明するものである。重要なアイデアは、個々のニューロンや基本的なアルゴリズムなど、システムの振る舞いを制御する基本的な要素やルールを特定することである。こうして、これらの単純な構成要素や規則がどのように相互作用するかを観察する。これらの構成要素の相互作用は、個々の構成要素を調べるだけでは予測できない複雑な行動の出現につながることが多い。さまざまな複雑さのレベルにわたって汎化することで、システムはこれらのレベルで適用される一般的な原理を学習し、創発的な特性を導き出すことができる。これによってシステムは新しい状況に適応することができ、より単純なルールからより複雑な行動が出現することを示す。さらに、異なる複雑さのレベルを超えて汎化する能力は、ある領域から別の領域への知識の伝達を容易にし、システムが適応するにつれて、新しい環境で複雑な行動を出現させるのに役立つ。

2.2.5 推論の強化

AI知能の推論能力は、訓練と入力データに基づいて解釈、予測、応答する能力にある。これらの能力は進歩し、向上しているが、その限界と、訓練される基礎データの影響を認識することが重要である。特に、大規模言語モデル(LLM)の文脈では、学習データと入力に基づいて結論を導き、予測し、応答を生成する能力を指す。AI知能における推論補強とは、AIのパフォーマンス、精度、実用性を向上させるために、AIの自然な推論能力を補強する追加のツール、技術、またはデータを使用することを指す。これは、複雑な意思決定シナリオや、微妙な内容や特殊な内容を扱う場合に特に重要です。以下に、推論強化の特に重要なソースを列挙します:

データの豊富さ。

より多くのコンテキストや背景を提供するために、追加の(多くの場合外部の)データソースを組み込むことで、AI知能は、特に学習データが限られている可能性のある領域において、より多くの情報に基づいた推論を行うことができます。例えば、AI知能は対話やテキストの文脈から意味を推測することができる。与えられた情報を分析し、それを使ってユーザーのクエリの意図や関連する詳細を理解する。これらのモデルはデータのパターンを認識するのが得意だ。この能力を利用して、学習中に学習したパターンに基づいて、言語、ユーザー行動、その他の関連する現象に関する情報を推論する。

アルゴリズムの強化。

より良い推論のために、AIの基礎となるアルゴリズムを改善する。これには、より高度な機械学習モデルの使用、異なるタイプのAIの統合(例えば、自然言語処理(NLP)と画像認識の組み合わせ)、複雑なタスクをよりうまく処理するためのアルゴリズムの更新などが含まれる。言語モデリングにおける推論には、人間の言語を理解し生成することが含まれる。これには、トーン、意図、異なる言語構造のニュアンスを把握することが含まれる。

ヒューマン・イン・ザ・ループ(HITL)。

AIの推論を補強するために人間を関与させることは、人間の判断が重要な分野(倫理的配慮、創造的なタスク、あいまいなシナリオなど)で特に有用である。人間はガイダンスを提供したり、エラーを修正したり、インテリジェンスが単独では推論できないような洞察を提供したりすることができる。

リアルタイムのフィードバック統合。

推論を補強するために、ユーザーや環境からのリアルタイムのフィードバックを使用することは、推論中のパフォーマンスを向上させるもう1つの有望なアプローチである。例えば、AIは、リアルタイムのユーザーの反応や、動的なシステムにおける状況の変化に基づいて、推薦を調整することができる。あるいは、AIがシミュレートされた環境で特定のルールに違反する行動を取った場合、AIがそれ自体を修正するのを助けるために、AIに動的にフィードバックが提供されることもある。

分野横断的な知識移転。

ある領域の知識やモデルを別の領域の推論を向上させるために使用することは、専門的な分野のアウトプットを生成する場合に特に有用である。例えば、言語翻訳のために開発された技術がコード生成に適用されるかもしれないし、医療診断からの洞察が機械の予知保全を強化するかもしれない。

特定のユースケースのためのカスタマイズ。

特定のアプリケーションや業界向けにAIの推論能力を調整するには、特殊なデータセットでAIを訓練したり、法律分析、医療診断、金融予測など、特定のタスクにより適したモデルに微調整したりする必要がある。ドメイン内の特定の言語や情報は、他のドメインの言語とは対照的である可能性があるため、ドメイン固有の知識でインテリジェンスを微調整することは有益である可能性がある。

倫理と偏見に関する考察。

強化の過程で、新たなバイアスや倫理的問題が生じないようにすることが重要である。これには、追加データのソースや新しい推論強化アルゴリズムが、公平性や透明性に与える影響を慎重に考慮する必要があります。AIインテリジェンスは、特にデリケートなトピックについて推論する際、倫理的な配慮に応じなければならないことがある。これには有害なステレオタイプの回避、プライバシーの尊重、公平性の確保などが含まれる。

継続的な学習と適応。

新しい開発、変化するデータ・ランドスケープ、進化するユーザー・ニーズに対応するため、AIの機能を定期的に更新し、改良する。

要約すると、AIインテリジェンスにおける推論拡張には、追加データ、改良されたアルゴリズム、人間の入力、およびその他の技術を使用して、自然な推論能力を拡張する方法が含まれます。ユースケースにもよるが、このような機能強化は、複雑なタスクを処理し、インテリジェンスの出力の正確性を確保するために不可欠であることが多い。

2.2.6 規制

近年、知的身体AIが大きく進歩し、具現化システムとの統合により、より没入感のあるダイナミックで魅力的な体験を通じて知的身体とインタラクションする新たな可能性が開かれている。このプロセスを加速し、知的身体AIの開発に伴う雑務を軽減するために、我々は次世代のAI対応知的身体インタラクションパイプラインの開発を提案する。人間と機械がコミュニケーションをとり、有意義に相互作用することを可能にする人間と機械のコラボレーションシステムを開発する。このシステムは、ラージ・ランゲージ・モデル(LLM)やビジュアル・ランゲージ・モデル(VLM)の会話能力と幅広いアクションを活用して、人間のプレーヤーと会話し、人間のニーズを特定することができる。そして、必要に応じて適切なアクションを実行し、人間のプレイヤーを支援する。

人間とロボットの協調システムに大規模言語モデル(LLM)/視覚言語モデル(VLM)を使用する場合、これらのモデルがブラックボックスとして動作し、予測不可能な出力を生成することに注意することが重要です。この不確実性は、物理的な設定(実際のロボットの操作など)において致命的になる可能性がある。この課題に対処する1つの方法は、キューエンジニアリングによって大規模言語モデル(LLM)/視覚言語モデル(VLM)の焦点を限定することです。例えば、指示に基づくロボットのタスクプランニングを行う場合、環境情報をキューに与えることで、テキストだけに頼るよりも安定した出力が得られることが報告されている Gramopadhye and Szafir (2022)。この報告は、MinskyのAIフレームワーク理論Minsky (1975)によって支持されており、Large Language Model (LLM)/Visual Language Model (VLM)が解決すべき問題空間は、与えられたプロンプトによって定義されることを示唆している。もう一つのアプローチは、大規模言語モデル(LLM)/視覚言語モデル(VLM)が、ユーザがモデルの着目点や認識点を理解できるような説明テキストを含むようなプロンプトを設計することである。さらに、実行前の検証や修正を人間がガイドできるような高いレベルを実装することで、そのようなガイドの下で動作するシステムの運用を容易にすることができる(図4)。

![Agent AI: 探索多模态交互的边界-4 Agent AI: 探索多模态交互的前沿世界[李飞飞-经典必读]](https://aisharenet.com/wp-content/uploads/2025/01/6ffe2854665853e.png)

図4:Wakeら(2023c)で開発されたロボット工学教育システム。(左)システムのワークフロー。このプロセスは3つのステップから構成される。 チャットGPT コマンドと環境情報に基づくロボットタスクのプランニング、ユーザーが動作シーケンスを視覚的に実演するデモンストレーション。すべてのステップをユーザーが確認し、失敗や不具合があれば、必要に応じて前のステップを見直すことができる。(右)デモデータのアップロードや、ユーザーとChatGPTのインタラクションを可能にするウェブアプリケーション。

2.3 創発的能力のためのインテリジェンシアAI

対話型知能AIシステムの採用が増加しているにもかかわらず、提案されているアプローチのほとんどは、未知の環境やシナリオにおける汎化性能の点で依然として課題に直面している。現在のモデリング手法では、モデルを微調整/事前訓練するために、開発者はドメインごとに大規模なデータセットを準備する必要があるが、このプロセスはコストがかかるか、ドメインが新しい場合は不可能でさえある。この問題に対処するために、我々は、新しいシナリオ、特に人間と知能間の協調空間を生成するために、汎用ベースモデル(ChatGPT、Dall-E、GPT-4など)の知識記憶を利用する対話型知能を構築した。我々は、複雑な実世界環境において困難な課題を解決するための人間との協働や、仮想現実に適応するための未知の環境を探索する能力を促進する、知識推論型相互作用との混合現実と呼ぶ創発的メカニズムを特定する。このメカニズムのために、知能はi)モダリティを超えたミクロな反応を学習する:各インタラクションタスクに関連する個々の知識を明示的なネットワークソース(例えば、未知のシナリオを理解する)から収集し、事前に訓練されたモデルの出力から暗黙的に推論することによって。ラージ・ランゲージ・モデル(LLM)における協調情報の影響力の多様性を推論する。我々は、様々なOpenAIモデルとのコラボレーションにおけるシナリオ生成のための知識誘導型インタラクションシナジーのタスクを調査し、我々のセットアップにおける大規模なベースモデルに対して、インタラクティブ・インテリジェンシア・システムがどのように有望な結果をさらに高めることができるかを示す。これは、複雑な適応AIシステムの汎化の深さ、認識、解釈可能性を統合し、改善します。

3 インテリジェント・ボディAIのパラダイム

本セクションでは、知能AIのトレーニングのための新しいパラダイムとフレームワークについて述べる。我々は提案するフレームワークによっていくつかの目標を達成したいと考えている:

- -

既存の事前学習モデルと事前学習ストラテジーを使用することで、私たちの知能は、テキスト入力や視覚入力などの重要なモダリティを理解するよう効果的に導かれる。 - -

十分な長期ミッション計画能力を支援する。 - -

学習内容を符号化して後日呼び出せるようにするニモニック・フレームワークの導入。 - -

どのような行動を取るべきかを学習する知能を効果的に訓練するために、環境フィードバックを使用できるようにする。

図5には、このようなシステムの重要なサブモジュールの概要を示す、ハイレベルな新しいインテリジェンスの図を示した。

![Agent AI: 探索多模态交互的边界-5 Agent AI: 探索多模态交互的前沿世界[李飞飞-经典必读]](https://aisharenet.com/wp-content/uploads/2025/01/893a5d2140b345e.png)

図5:マルチモーダル汎用知能のための新しい知的身体パラダイム。図に示すように、5つの主要なモジュールがある:1)タスク計画やスキル観察を含む環境と知覚、2)知的身体学習、3)記憶、4)知的身体行動、5)認知。

3.1 大言語モデルと視覚言語モデル

図5に示すように、知的体の構成要素をブートストラップするために、大規模言語モデル(LLM)または視覚言語モデル(VLM)のいずれかを使用することができる。特に、ラージ言語モデルは、タスク計画で良好な性能を発揮することが示されている Gong et al.(2023a)、大量の世界知識を含む Yu et al.(2023b)、印象的な論理的推論を示す Creswell et al.(2022)。さらに、CLIP Radford et al. (2021)のような視覚言語モデルは、言語に沿った汎用視覚コーダーを提供するだけでなく、ゼロサンプルの視覚認識能力を提供する。例えば、LLaVA Liuら(2023c)やInstructBLIP Daiら(2023)のような最先端のオープンソースのマルチモーダルモデルは、視覚エンコーダとしてフローズンCLIPモデルに依存している。

![Agent AI: 探索多模态交互的边界-4 Agent AI: 探索多模态交互的前沿世界[李飞飞-经典必读]](https://aisharenet.com/wp-content/uploads/2025/01/bbe6faec7c0ecfb.png)

図6:大規模言語モデル(LLM)と大規模視覚モデル(LVM)を組み合わせることによって、マルチモーダルAI知能を作成するための現在のパラダイムを示す。通常、これらのモデルは視覚的または言語的入力を受け取り、事前に訓練され凍結された視覚モデルと言語モデルを使用して、モダリティの小さなサブネットワークを接続し橋渡しすることを学習する。例としては、Flamingo Alayracら(2022)、BLIP-2 Liら(2023c)、InstructBLIP Daiら(2023)、LLaVA Liuら(2023)がある。

3.2 インテリジェント・ボディ・トランスの定義

凍結されたマクロ言語モデルと視覚言語モデルをAIインテリジェンスとして使用することに加え、単一のインテリジェンスを使用することもできる。 変圧器 ビジュアルを組み合わせたモデル トークン GatoReedら(2022)と同様に、入力として視覚的入力と言語的入力を追加する。視覚的入力と言語的入力に加えて、3つ目の一般的な入力タイプを追加する。インテリジェントボディ トークン:概念的には、知的ボディトークンは、モデルの入出力空間において、知的ボディの行動のために特定の部分空間を確保するために使用される。ロボットやゲームの場合、これはコントローラの入力アクション空間として表現できます。インテリジェント・ボディ・トークンは、画像生成や画像編集モデルなどの特定のツールを使用するように知的ボディを訓練するときや、図7に示すように、他のAPI呼び出しにも使用できます。ここでは、インテリジェント・ボディ・トークンをビジュアル・トークンおよび言語トークンと組み合わせて、マルチモーダル知的ボディAIを訓練するための統一インターフェースを生成できます。Intelligent Body Transformerを使用すると、インテリジェント・ボディとして独自の大規模な言語モデルを使用する場合と比べて、いくつかの利点がある。第一に、自然言語で表現することが困難な、非常に特殊な知的体のタスク(例えば、コントローラの入力やその他の特殊なアクション)に対して、モデルを簡単にカスタマイズすることができる。そのため、知能体は環境との相互作用やドメイン固有のデータから学習し、パフォーマンスを向上させることができる。第二に、知的体のトークンの確率にアクセスすることで、モデルが特定の行動を取る理由や取らない理由を理解しやすくなる。第三に、特定のドメイン(ヘルスケアや法律など)には厳しいデータプライバシー要件がある。最後に、比較的小型の知的ボディトランスフォーマーは、大型の独自言語モデルよりもはるかに安価である可能性がある。

![Agent AI: 探索多模态交互的边界-5 Agent AI: 探索多模态交互的前沿世界[李飞飞-经典必读]](https://aisharenet.com/wp-content/uploads/2025/01/b415bfaf197bc30.png)

図7:知能体のための統一されたマルチモーダルTransformerモデル。凍結されたサブモジュールを接続し、既存の基本モデルをビルディングブロックとして使用する代わりに、インテリジェントボディシステムのための統一されたエンドツーエンドのトレーニングパラダイムを提案する。図6の大規模な言語モデルと大規模な視覚モデルを使用してサブモジュールを初期化することもできますが、SmartBodyトークンを使用することもできます。SmartBodyトークンは、特定のドメイン(ロボット工学など)でSmartBodyの動作を実行するモデルを訓練するために使用される特殊化されたトークンです。

3.3 トランスフォーマーの作成

上の図5に示すように、ラージ・ランゲージ・モデルとビジュアル・ランゲージ・モデルによってガイドされるインテリジェント・ボディを備えた新しいインテリジェント・ボディ・パラダイムを使用し、ラージ・ベース・モデルによって生成されたデータを使用して、インテリジェント・ボディ・トランスフォーマー・モデルを訓練し、特定の目標を実行するように学習させることができる。その過程で、インテリジェント・ボディ・モデルは、特定のタスクやドメインに特化して調整されるように訓練される。このアプローチでは、既存のベースモデルから学習した特徴や知識を活用することができます。以下に、2つのステップでプロセスの概要を簡略化して示します:

ドメイン内のゴールを定義する。

知能ボディトランスフォーマーをトレーニングするためには、各特定の環境における知能ボディのゴールとアクションスペースを明確に定義する必要があります。これには、知能体が具体的にどのタスクやアクションを実行する必要があるかを特定し、各タスクやアクションに固有の知能体トークンを割り当てることが含まれます。さらに、タスクの成功完了を認識するために使用できる自動化されたルールや手順があれば、トレーニングに使用できるデータ量を大幅に増やすことができます。そうでない場合は、ベースモデルによって生成されたデータ、または手動で注釈を付けたデータが、モデルのトレーニングに必要となります。データを収集し、インテリジェンスのパフォーマンスを評価することができれば、継続的な改善のプロセスを開始することができます。

継続的な改善。

モデルのパフォーマンスを継続的にモニタリングし、フィードバックを収集することは、このプロセスの基本的なステップである。フィードバックは、さらなる微調整と更新のために利用されるべきである。また、モデルが偏った結果や非倫理的な結果を永続させないようにすることも極めて重要である。そのためには、学習データを精査し、出力に偏りがないか定期的にチェックし、必要であれば、偏りを特定し回避するためにモデルを訓練する必要がある。モデルが満足のいく性能に達すれば、目的のアプリケーションに導入することができる。モデルが期待どおりの性能を発揮し、必要な調整を促進するためには、継続的なモニタリングが不可欠である。このプロセスの詳細、トレーニングデータのソース、および知能AIの継続的学習の詳細については、セクション8を参照。

4 知能ある身体 AI学習

4.1 戦略とメカニズム

さまざまなドメインにおける対話型AIの戦略は、大規模なベースモデルを呼び出すために、ユーザーのフィードバック、行動情報、生成や対話に役立つ知識を積極的に収集しようとする学習済み知能を使用するというパラダイムを拡張する。時には、大規模な言語モデル/視覚言語モデルを再トレーニングする必要がなく、テスト時に改善された文脈上の手がかりを提供することで、インテリジェンスのパフォーマンスを向上させる。一方、知識/推論/常識/推論のインタラクションを、三項システムの組み合わせによってモデル化することが常に含まれる。1つのシステムは、マルチモデルクエリから知識検索を実行し、2つ目は関連する知能からインタラクション生成を実行し、最後のシステムは、強化学習や模倣学習を含む改良された方法で、新しい、情報量の豊富な自己教師付き訓練または事前訓練を行う。

4.1.1 学習の強化(RL)

知的行動を示す対話型知能を訓練するために、強化学習(RL)を利用してきた長い歴史がある。強化学習とは、行動に対して受け取る報酬(または罰)に基づいて、状態と行動の最適な関係を学習する手法である。強化学習は非常にスケーラブルなフレームワークであり、ロボット工学を含む幅広いアプリケーションに適用されているが、一般的にいくつかのリーダーボード問題に直面しており、大規模な言語モデル/視覚言語モデルは、これらの困難のいくつかを緩和または克服する可能性を示している:

- 報酬デザイン戦略学習の効率は報酬関数の設計に大きく依存する。報酬関数の設計には、強化学習アルゴリズムの理解だけでなく、タスクの性質に関する深い知識が必要であり、そのため多くの場合、専門家の経験に基づいて関数を設計する必要がある。いくつかの研究では、報酬関数を設計するために大規模言語モデル/視覚言語モデルを使用することが検討されている Yu et al (2023a); Katara et al (2023); Ma et al.

- データ収集と効率性 その探索的な性質から、強化学習に基づく戦略学習は大量のデータを必要とする。大量のデータの必要性は、戦略が長いシーケンスを管理したり、複雑なオペレーションを統合したりする場合に特に顕著になる。こうしたシナリオでは、より微妙な意思決定と、より幅広い状況からの学習が必要となるからだ。最近の研究では、戦略学習をサポートするためにデータ生成を強化する努力がなされている。さらに、戦略学習を改善するために、これらのモデルを報酬関数に統合した研究もある。これらの進展と並行して、別の研究では、視覚的言語モデルTang et al.

- 縦段 データ効率に関しては、行動シーケンスの長さが長くなるほど強化学習は難しくなる。これは、行動と報酬の関係が不明確であること(クレジット配分問題として知られている)、探索すべき状態数が増加し、大量の時間とデータを必要とすることによる。長く複雑なタスクに対する典型的なアプローチは、タスクを一連のサブゴールに分解し、各サブゴールを解くために事前に訓練された戦略を適用することである(例えば、Takamatsu et al.この考え方は、Garrettら(2021)のTask and Motion Planning(TAMP)フレームワークに属する。タスク・アンド・モーション・プランニングは、2つの主要なコンポーネントから構成される。タスク・プランニングは、高レベルの動作シーケンスを特定することを伴い、モーション・プランニングは、タスク・プランの目標を達成するために、物理的に一貫性があり、衝突のない軌道を見つけることを伴う。大規模言語モデルはタスク計画と運動計画に適しており、最近の研究では、高レベルのタスク計画は大規模言語モデルを用いて実行し、低レベルの制御は強化学習ベースの戦略で対処するというアプローチが一般的である。大規模言語モデルの高度な機能は、抽象的な命令をサブゴールに効率的に分解することを可能にする。

4.1.2 模倣学習(IL)

強化学習が、行動を探索し、環境と相互作用することで得られる報酬を最大化することに基づいて戦略を訓練することを目的としているのに対し、模倣学習(IL)は、経験豊富な知性や専門家の行動を模倣するために専門家のデータを使用することを目的としている。例えば、ロボット工学における模倣ベースの学習の主なフレームワークの1つに、行動クローニング(BC)がある。行動クローニングは、ロボットが専門家の行動を直接コピーすることで模倣するように訓練する方法である。このアプローチでは、特定のタスクを実行する際の専門家の行動が記録され、ロボットは同様の状況でこれらの行動を複製するように訓練される。行動クローニングに基づく最近のアプローチは、一般的に大規模言語モデル/視覚言語モデルの技術を組み合わせ、より高度なエンドツーエンドモデルを実現している。例えば、BrohanらはRT-1 Brohanら(2022)とRT-2 Brohanら(2023)を発表しており、一連の画像と言語を入力とし、ベース動作とアーム動作のシーケンスを出力するTransformerベースのモデルである。これらのモデルは、大量の学習データで学習されているため、高い汎化性能を示すと報告されている。

4.1.3 従来のRGB

画像入力を用いた知的な身体行動の学習は、長年にわたって関心を集めてきたMnihら(2015)。RGB入力を使用する固有の課題は、次元の破局である。この問題に対処するために、研究者はより多くのデータを使用する Jang et al.特に、Zeng et al. (2021); Shridhar et al. (2023); Goyal et al. (2023); James and Davison (2022)は、操作に使用するモデル構造に3D構造を組み込んでいる。ロボットのナビゲーションについては、Chaplotら(2020a, b)がマップを表現として利用している。マップは、過去のすべてのRGB入力を集約するニューラルネットワークや、神経放射場のような3D再構成手法によって学習することができる。

より多くのデータを得るために、研究者たちはグラフィカルシミュレーターを使用して合成データを合成してきた Mu et al.最近では、データ不足の問題を解決するために、大規模なデータセットをキュレートするための協調的な取り組みが行われている。一方、サンプルの複雑性を高めるために、データ拡張技術も広く研究されている。 Zeng et al. (2021); Rao et al. (2020); Haarnoja et al. (2023); Lifshitz et al.

4.1.4 コンテキスト学習

文脈学習は、GPT-3のような大きな言語モデルを使用した自然言語処理タスクを解くための効果的な方法であることが示されている Brown et al.大きな言語モデルのプロンプトのコンテキストでタスク例を提供することで、サンプルレスプロンプトが自然言語処理における様々なタスクでモデル出力をコンテキスト化する効果的な方法であることがわかる。例文の多様性や文脈の中で提示される例文の質などの要因は、モデル出力の質を向上させる可能性がある。マルチモーダルベースモデルの文脈では、少数の例しか与えられない場合、フラミンゴやBLIP-2 Alayracら(2022); Liら(2023c)のようなモデルが、多種多様な視覚理解タスクにおいて効果的であることが示されている。環境における知能の文脈学習は、特定の行動をとったときに文脈に応じたフィードバックを統合することで、さらに改善することができる Gong et al.

4.1.5 知的身体システムにおける最適化

知的身体システムの最適化は、空間的側面と時間的側面に分けることができる。空間的最適化では、知的体が物理的空間でどのように動作してタスクを実行するかを考える。これには、ロボット間の協調、資源配分、整理された空間の維持などが含まれる。

知的身体AIシステム、特に多数の知的身体が並行して動作するシステムを効果的に最適化するために、これまでの研究では、大量の強化学習を使用することに焦点が当てられてきた。タスクに特化した多知能体の相互作用データセットは稀であるため、自己ゲーム的な強化学習によって、知的体のチームは時間の経過とともに改善することができる。しかし、自己ゲーム学習パラダイムに適合しすぎるため、人間や他の独立した知性体とは機能せず、自己ゲーム下でのみ機能する非常に脆弱な知性体を生み出す可能性もある。この問題に対処するためには、代わりに様々な規約のセットを発見し、様々な規約を理解する知能を訓練することができる。ベースモデルはさらに、人間や他の独立した知能との規約を確立するのに役立ち、新しい知能とのスムーズな連携を可能にする。

一方、時間的最適化は、知能がどのように時間をかけてタスクを実行するかに焦点を当てる。これには、タスクのスケジューリング、順序付け、時間軸の効率化などが含まれる。例えば、ロボットアームの軌道の最適化は、連続するタスク間の移動を効率的に最適化する例であるZhou et al.タスクスケジューリングレベルでは、LLM-DPのようなアルゴリズム Dagan et al. リ・アクト Yaoら(2023a)のようなアプローチは、環境要因を相互作用的に統合することで、効果的なタスクプランニングに取り組んでいる。

4.2 エージェントシステム(ゼロおよび少数のサンプルレベル)

4.2.1 エージェント・モジュール

エージェントパラダイムに関する私たちの最初の研究は、ラージ言語モデル(LLM)またはビジュアル言語モデル(VLM)を使用した対話型マルチモーダルエージェントのためのエージェントAI「モジュール」の開発でした。私たちの初期のエージェントモジュールは、トレーニングや文脈学習に貢献し、エージェントが効果的にスケジュールや調整を行う能力を実証することを目的とした最小限の設計となっています。また、より良いプランニングに役立ち、現場での将来の行動方法に役立つ、初期の手がかりベースの記憶技術も探求しました。これを説明するために、我々の "MindAgent "インフラストラクチャは、図5に示すように、5つの主要なモジュールで構成されています:1)タスクプランニングを伴う環境認識、2)エージェントの学習、3)記憶、4)一般的なエージェントの行動予測、および5)認知。

4.2.2 代理店インフラ

エージェントベースのAIは、エンターテインメント、研究、産業において大規模かつ急速に成長しているコミュニティである。大規模なベースモデルの開発により、エージェントAIシステムの性能は大幅に向上している。しかし、この方法でエージェントを作成することは、高品質のデータセットを作成するために必要な作業量と全体的なコストの増加によって制限されています。マイクロソフトでは、先進的なハードウェア、多様なデータソース、堅牢なソフトウェアライブラリを使用することで、高品質のエージェントインフラを構築し、マルチモーダルエージェントの共同操縦に大きな影響を与えてきました。マイクロソフトがAgentテクノロジーの限界を押し広げ続けているため、AI Agentプラットフォームは今後数年間、マルチモーダルインテリジェンスにおいて支配的な存在であり続けることが予想されます。それにもかかわらず、エージェントAIとの対話は現在、複合的なスキルを必要とする複雑なプロセスのままです。大規模なジェネレーティブAIのモデリング分野における最近の進歩は、現在インタラクティブコンテンツに必要とされる高いコストと時間を大幅に削減する可能性を秘めており、大規模なスタジオにとっても、小規模な独立系コンテンツクリエイターにとっても、現在の能力を超えた高品質の体験をデザインする能力を提供することができる。マルチモーダル・エージェント 現在のHCIシステムは、大部分がルールベースである。それらは、人間/ユーザーのアクションに反応し、ある程度のネットワーク知識を持つインテリジェントな振る舞いをする。しかし、このようなインタラクションは、ソフトウェア開発のコストによって制限されることが多く、特定の動作をシステムに実装することができない。さらに、現在のモデルは、ユーザーが特定のタスクを実行できない状況において、ユーザーの目標達成を支援するようには設計されていない。そのため、ユーザーの行動を分析し、必要に応じて適切なサポートを提供するエージェントAIシステムのインフラが必要である。

4.3 エージェントベースのベースモデル(事前学習レベルと微調整レベル)

事前に訓練されたベースモデルの使用は、様々なユースケースに幅広く適用できるという点で大きな利点をもたらす。これらのモデルを統合することで、幅広い用途にカスタマイズされたソリューションの開発が可能になり、特定のタスクごとに大規模なラベル付きデータセットを準備する必要がなくなる。

ナビゲーション分野での注目すべき例は、GPT-3とCLIPを新しいアプローチで組み合わせたLM-NavシステムShahら(2023a)である。LM-Navシステムは、言語モデルによって生成されたテキストランドマークを効果的に利用し、ロボットが取得した画像に固定してナビゲーションに利用する。このアプローチは、テキストデータと視覚データのシームレスな融合を実証し、幅広い適用性を維持しながら、ロボットのナビゲーション能力を大幅に向上させている。

ロボット操作では、いくつかの研究が市販のLLM(ChatGPTなど)をオープン語彙オブジェクト検出器とともに使用することを提案している。LLMと高レベルオブジェクト検出器(Detic Zhouら(2022)など)を組み合わせることで、テキスト情報をシーン情報の中に位置付けながら、人間のコマンドを理解するのに役立つParakhら(2023).さらに最近の進歩は、GPT-4V(ision) Wakeら(2023b)のような先進的なマルチモーダルモデルと組み合わせて手がかり工学を使用する可能性を示している。この技術は、マルチモーダルなタスク計画への道を開き、様々な環境における事前学習済みモデルの多用途性と適応性を強調している。

5 エージェントAIの分類

5.1 ジェネリック・エージェント・ドメイン

コンピュータ・ベースのアクションやジェネラライズド・エージェント(GA)は、多くのタスクに有用である。大規模なベースモデルや対話型AIの分野における最近の進歩は、GAの新たな能力を可能にしている。しかし、GAがユーザーにとって真に価値あるものとなるためには、対話が容易で、幅広い環境やモダリティに汎化できなければならない。我々は、特に一般的にこれらのトピックに関連する分野において、第6節のエージェントベースAIに関する主要な章を高品質に拡張する:

Multimodal Agent AI (MMA)は、私たちの研究コミュニティと産業コミュニティが互いに、またより広範なエージェントAIの研究と技術コミュニティと交流するための、今後のフォーラムです^1^現在のURL: https://multimodalagentai.github.io/ 。大規模な基本モデルと対話型 AI の分野における最近の進歩により、制約のある環境におけるユーザー行動の予測やタスクの計画(例:MindAgent Gong et al.(2022b); Brohan et al. (2023))、あるいは知識フィードバックを含むチャットコンパニオンをユーザーに提供する(例えば、医療システムのウェブベースのカスタマーサポート Peng et al. (2023))。代表的な研究や最近の代表的な研究について、より詳細な情報を以下に示す。我々は、MAAの将来像について議論し、この分野で研究する未来の研究者を鼓舞したいと考えている。本稿と我々のフォーラムは、以下の主なトピックをカバーしているが、これらに限定されるものではない:

- 主なテーマ マルチモーダル・エージェントAI、ジェネリック・エージェントAI

- 第二のテーマ: 身体化エージェント、モーションエージェント、言語ベースエージェント、視覚・言語エージェント、知識・推論エージェント、ゲーム用エージェント、ロボット工学用エージェント、ヘルスケア用エージェントなど。

- 拡張テーマ: 視覚ナビゲーション、模擬環境、再配置、エージェントベースモデル、VR/AR/MR、具現化された視覚と言語。

次に、代表的なエージェントのカテゴリーを以下に挙げる:

5.2 所有権代理人

私たちの生物学的な脳は私たちの身体の中に存在し、私たちの身体は絶えず変化する世界の中を動いている。具現化AIの目標は、環境との相互作用を必要とする困難なタスクを創造的に解決することを学習するロボットなどのエージェントを創造することである。これは大きな挑戦であるが、ディープラーニングの大きな進歩や、イメージネットのような大規模なデータセットの利用可能性の増加により、以前は扱いが困難とされていた幅広いAIタスクにおいて、超人的なパフォーマンスが可能となっている。コンピュータビジョン、音声認識、自然言語処理は、言語翻訳や画像分類のような受動的な入出力タスクにおいて変革的な革命を遂げ、強化学習はゲームのような対話的タスクにおいて世界トップクラスの性能を達成した。これらの進歩は、より多くのユーザーが機械と対話できる知的エージェントへと迅速に移行することを可能にし、具現化AIに強い推進力を与えている。

5.2.1 アクション・エージェント

アクションエージェントは、シミュレートされた物理環境または現実世界で物理的なアクションを実行する必要があるエージェントである。アクションエージェントは、ゲームAIとロボット工学の2つに大別されます。

ゲームAIでは、エージェントはゲーム環境や他の独立したエンティティと対話します。このような環境では、自然言語がエージェントと人間の円滑なコミュニケーションを可能にします。ゲームによっては、実際の報酬シグナルを提供する特定のタスクを完了する必要があります。例えば、競争的な外交ゲームでは、人間の対話データと強化学習による行動戦略を使用して言語モデルを訓練することで、人間レベルのゲームを可能にすることができる。) Diplomacy Team, Bakhtin, Brown, Dinan, Farina, Flaherty, Fried, Goff, Gray, Hu, et al.

場合によっては、エージェントは町の普通の住人のように行動する Park et al.ベースモデルは、人間の行動を模倣することで、より自然なインタラクションをシミュレートできるため、このような設定で有用である。外部メモリで補強されると、会話し、日々の活動をスケジュールし、人間関係を築き、バーチャルな生活を送ることができる説得力のあるエージェントが生まれる。

5.2.2 インタラクティブ・エージェント

インタラクティブ・エージェントとは、単に世界と対話できるエージェントのことで、アクション・エージェントよりも広いクラスのエージェントである。理学療法しかし、ユーザーに情報を伝えたり、環境を変更したりすることもあります。例えば、具現化された対話型エージェントは、対話を通じてユーザーのトピックに関する質問に答えたり、チャットボットのようにユーザーが既存の情報を解析する手助けをしたりすることができます。エージェントの能力を情報共有を含むように拡張することで、エージェントAIの中核となる設計とアルゴリズムを、診断Leeら(2023)や知識検索エージェントPengら(2023)のような様々なアプリケーションに効果的に適応させることができる。

5.3 シミュレーションと環境エージェント

AIエージェントが環境においてどのように行動するかを学習する効果的な方法は、環境との相互作用を繰り返し試行する経験を通じて行うことである。代表的なアプローチは強化学習(RL)であり、エージェントを学習させるためには多数の失敗が必要である。物理エージェントを使用する方法も存在するが、Kalashnikov et al.さらに、実環境での失敗が危険な場合(自律走行、水中車両など)、物理環境でのトレーニングは実行不可能なことが多い。そのため、シミュレーターを使用して戦略を学習するのが一般的なアプローチである。

具現化AI研究のために、ナビゲーションTsoiら(2022);Deitkeら(2020);Kolveら(2017)から物体操作Wangら(2023d);Meesら(2022);Yangら(2023a)に至るまで、多くのシミュレーション・プラットフォームが提案されている。(2023a);Ehsaniら(2021)。その一例がHabitat Savvaら(2019); Szotら(2021)で、人間とロボットのエージェントがナビゲーション、コマンド追従、質問応答など様々なタスクを実行できる3D室内環境を提供する。もう一つの代表的なシミュレーション・プラットフォームは、VirtualHome Puig et al.(2018)であり、人間のアバターが3D室内環境でオブジェクトを操作することをサポートしている。ゲーム領域では、Carrollらが「Overcooked-AI」を紹介した。これは、人間とAIとの協調タスクを研究するために設計されたベンチマーク環境である。同様に、エージェントと環境の相互作用に焦点を当てるだけでなく、実際の人間の介入を組み込むことを目的とした研究もある。これらのシミュレータは、エージェントとロボットの相互作用を含む実世界環境における政策学習や、人間の実演行動を用いたILベースの政策学習を促進する。

場合によっては、戦略を学習する過程で、シミュレータに特殊な機能を統合することが必要になる。例えば、画像ベースの戦略を学習する場合、実環境への適応を容易にするために、現実的なレンダリングが必要になることが多い Mittal et al.リアルなレンダリングエンジンの使用は、様々な条件(照明環境など)を反映した画像を生成するのに有効である。また、物体との物理的な相互作用をシミュレートするためには、物理エンジンを採用したシミュレータが必要であるLiu and Negrut(2021)。シミュレーションに物理エンジンを組み込むことは、現実的なシナリオに適用できるスキルを習得するのに役立つことが示されている Saito et al.

5.4 生成エージェント

大規模なジェネレーティブAIモデルの分野における最近の進歩は、大規模なゲームスタジオにとっても、小規模な独立系スタジオにとっても、現在の能力を超える高品質な体験を生み出すために、インタラクティブコンテンツに必要な高いコストと時間を大幅に削減する可能性を秘めています。さらに、大規模なAIモデルをサンドボックス環境に組み込むことで、ユーザーは現在では不可能な方法で自らの体験をオーサリングし、創造性を表現することができるようになります。

このエージェントの目的は、単にインタラクティブな3Dコンテンツをシーンに追加することではない:

- オブジェクトに任意の動作ルールやインタラクションルールを追加することで、ユーザーは最小限のプロンプトで独自のVRルールを作成できます。

- レベル全体のジオメトリは、マルチモーダルGPT4-vモデルと、ビジュアルAIモデルを含む他のモデルチェーンを使用して、紙の上のスケッチから生成されます。

- 拡散モデルを使用したシーンのコンテンツの再テクスチャリング

- 簡単なユーザープロンプトでカスタムシェーダとビジュアルエフェクトを作成

短期的な応用例としては、VR制作のストーリーボード/プロトタイピング・ツールが考えられる。このツールを使えば、1人のユーザーが、現在実現可能なスピードよりも桁違いに速く、体験/ゲームの大まかな(しかし完全に機能する)スケッチを作成できる。このようなプロトタイプは、これらのツールを使って拡張・改善することができる。

5.4.1 AR/VR/複合現実エージェント

現在、AR/VR/Mixed Reality(総称してXR)環境では、仮想世界でのインタラクションをシミュレートするために、熟練したアーティストやアニメーターがキャラクター、環境、オブジェクトを作成する必要があります。これは、コンセプトアート、3Dモデリング、テクスチャリング、バインディング、アニメーションを含むコストのかかるプロセスです。 XRエージェントは、クリエイター間のインタラクションを促進し、最終的なバーチャル環境の構築を支援するツールを構築することで、このプロセスを支援することができます。

私たちの初期の実験では、GPT モデルを Unity エンジンのサンプルレス メカニズムで(追加の微調整なしで)使用し、API 呼び出しを使用してエンジ ン固有のメソッドを呼び出して、インターネットから 3D モデルをダウン ロードしてシーンに配置し、ステートツリーで挙動とアニメーションを割り当 てることができました。この挙動は、Unity を使用したオープンソースのゲームリポジトリに同様のコードが存在するために生じた可能性がある。その結果、GPT モデルは、シンプルなユーザーのプロンプトに基づいて多くのオブジェクトをシーンにロードすることで、リッチなビジュアル・シーンを構築できる。

このクラスのエージェントの目標は、大規模なAIモデル(GPTファミリーのモデルや拡散画像モデル)とレンダリングエンジンとの間の効率的なインタフェースを提供するプラットフォームとツールのセットを構築することです。ここでは、主に2つの道を探ります:

- 大規模なモデルをAgentインフラストラクチャの様々なエディタツールに統合し、開発を劇的にスピードアップします。

- ユーザーの指示に従ってコードを生成し、実行時にコンパイルすることで、ユーザー体験からレンダリング・エンジンをコントロールする。

XRのセットアップに特化したAIコパイロットの導入は、XRクリエイターにとって有用である。簡単なアセットの提供やコードサンプルの作成といった面倒な作業をコパイロットに任せることで、クリエイターはクリエイティブなビジョンに集中し、アイデアを素早く反復することができる。

さらに、エージェントは、新しいアセットを追加したり、環境のダイナミクスを変更したり、新しい設定を構築したりすることで、ユーザーがインタラクティブに環境を変更できるようにします。このような実行時の動的生成は、ユーザーの体験が新鮮に感じられ、時間とともに進化するように、作成者が指定することもできます。

5.5 知識と論理的推論の知能

知識を推論し適用する能力は、人間の認知を定義する特徴であり、論理的推論や心の理論の理解といった複雑なタスクにおいて特に顕著である^2^2^https://plato.stanford.edu/entries/cognitive-science。知識に関する推論を行うことで、AIの反応や行動が既知の事実や論理的原理と一致することが保証される。原理と一致することを保証します。この一貫性は、特に医療診断や法的分析などの重要なアプリケーションにおいて、AIシステムの信頼性と信頼性を維持するための重要なメカニズムである。ここでは、知識と推論の相互作用を組み合わせ、知能と推論の特定の側面に対処するように設計された多数の知能を紹介する。

5.5.1 ナレッジ・インテリジェンス

知識インテリジェンスは、獲得した知識体系を暗黙的と明示的の2つの方法で推論する。暗黙的知識とは、一般的に、大量のテキストデータで学習された後、GPTファミリーのBrownら(2020)やOpenAI(2023)のような大規模な言語モデルによってカプセル化された知識のことである。これらのモデルは、トレーニング中に暗黙的に学習されたパターンや情報を利用するため、理解しているような印象を与える応答を生成することができる。対照的に、明示的知識は構造化されており、知識ベースやデータベースにある情報のように直接問い合わせることができる。

言語モデルの進歩にもかかわらず、その暗黙知は静的なものであり、世界が進化するにつれて古くなっていく。この制限により、AIシステムが正確で最新の応答を提供できるようにするためには、継続的に更新される明示的知識のソースを統合する必要がある。暗黙知と明示知を統合することで、AI知能はよりニュアンスに富んだ理解と、人間の知能のように文脈の中で知識を適用する能力を備えることができる。この統合は、情報を持つだけでなく、その情報を理解し、解釈し、利用することができる知識中心のAI知能を構築する上で非常に重要であり、広範な学習と深い知識のギャップを埋めるものである(Marcus and Davis, 2019; Gao et al.)これらの知能は、柔軟な方法で、世界に関する動的な情報を使って推論し、その結果、頑健性と適応性を高めることを目指している(Marcus, 2020)。

5.5.2 論理的知性

通常、論理的知能は、論理的推論を適用してデータを処理したり、論理的推論や論理的論証に特化したタスクを解決したりするように設計されたシステムのコンポーネントです。GPT-4のような大規模な基本モデルのコンテキストでは、論理知能は、論理的推論タスクを処理するように設計された特殊化されたコンポーネントまたはサブモジュールを指します。これらのタスクは通常、抽象的な概念の理解と操作、与えられた前提からの結論の推論、または構造化された論理的アプローチを必要とする問題の解決を含みます。大まかに言えば、GPT-4のような基本モデルは、テキストデータの大規模なコーパスで学習され、何らかの論理的推論を必要とするタスクを含む様々なタスクを実行するように学習される。そのため、論理的推論能力は全体的なアーキテクチャに統合されており、通常、独立した「論理的インテリジェンス」は持っていません。GPT-4や類似のモデルは論理を含むタスクを実行することができますが、そのアプローチは人間や伝統的な論理ベースのシステムが動作する方法とは根本的に異なります。GPT-4は正式な論理ルールに従ったり、論理を明示的に理解したりするのではなく、学習データから学習したパターンに基づいて応答を生成する。その結果、論理タスクにおけるパフォーマンスは素晴らしいものになりますが、トレーニングデータの性質やモデル設計の本質的な限界により、一貫性を欠いたり、制限されたりすることもあります。アーキテクチャに別の論理サブモジュールを組み込んだ例として、(Wang et al., 2023e)がある。これは、テキストを論理セグメントに解析し、論理階層をトークン埋め込みで明示的にモデル化することで、事前学習時にLLMが使用するトークン埋め込みプロセスを変更する。

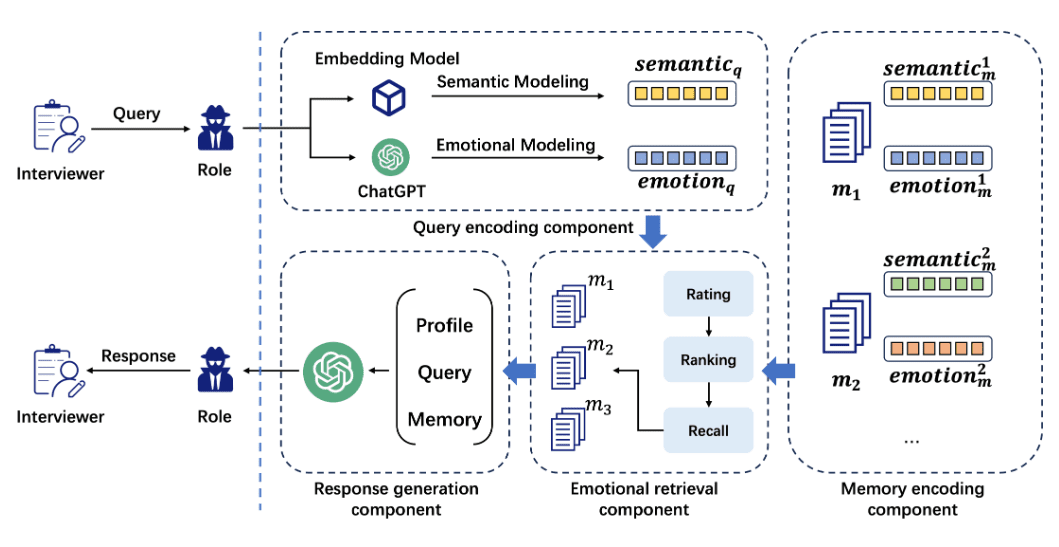

5.5.3 感情的推論のためのインテリゲンチア

感情理解と共感は、多くの人間とコンピュータの相互作用において知能が持つ必要のある重要なスキルである。この点を説明するために、魅力的な会話知能を作成する際の重要な目標は、知能が行動する際に、より大きな感情と共感を示す一方で、社会的に不適切または不快な出力を最小限に抑えることである。会話知能のこの目標を前進させるために、私たちは共感を伴う神経画像のレビュー(NICE)データセット Chen et al.(2021)は、約200万枚の画像と、それに対応する手動で生成されたコメント、人間の感情注釈のセットを含む。また、画像コメントに対するセンチメント生成をモデル化するための新しい事前学習済みモデル(マジック)Chenら(2021)は、スタイルと感情をとらえ、より共感的で、感情的で、魅力的で、社会的に適切なコメントを生成するのに役立つ言語表現を条件として、画像に対するコメントを生成することを目指している。我々の実験は、このアプローチが、より人間的で魅力的な画像コメント知能の訓練に効果的であることを示している。特に、現在の言語モデルの多くが感情理解や共感的推論能力に偏りを示していることを考えると、幅広いグループや集団のために感情理解を持つ知能を作成することは重要である。

5.5.4 神経象徴知能

神経記号的知性は、ニューロンと記号のハイブリッド・システムで動作する d'Avila Garcez and Lamb (2020).自然言語表現の問題を解決することは、入力に暗黙的に含まれる離散的な記号構造情報を明示的に捕捉する必要があるため、困難な課題である。TP-N2Fのエンコーダは、TPR「結合」を採用している。TP-N2FのエンコーダーはTPRの「バインディング」を用いて自然言語の記号構造をベクトル空間にエンコードし、デコーダーはTPRの「アンバインディング」を用いて記号空間の関係タプルで表現される逐次プログラムを生成する。

GPT-4のようなコマンド追従型視覚言語(VL)モデルは、ゼロサンプルで幅広いマルチモーダルなタスクをサポートする柔軟なインターフェースを提供する。しかし、完全な画像上で動作するインターフェースは、ユーザが画像内の特定の領域を「ポイント」してアクセスすることを直接的に可能にするものではない。この機能は、参照ベースのVLベンチマークをサポートするためだけでなく、正確な画像内推論を必要とする実世界のアプリケーションにとっても重要である。Park et al., 2023b)において、我々は、ユーザが(複数の)領域を入力として指定することを可能にする局所視覚的コモンセンスモデルを構築した。具体的には、LLMに、グローバルなリテラル画像記述と、VLモデルによって自動的に生成されたローカルなリテラル領域記述のセットに基づいて、コモンセンス知識を収集するように促した。このプロセスはスケーラブルで、画像とテキストのペアを整列させたり、手作業で記述したりする必要がないため、完全に自動化されている。選択された高品質な例のレビューモデルを個別に訓練することで、画像のみから拡張された一般的知識のローカルコーパスに対する訓練が、引用文を入力とするインターフェースをサポートするために、既存のVLモデルをうまく改良できることを発見する。ゼロサンプル設定と手動評価における経験的結果は、我々の洗練アプローチが、パス生成された参照表現のベースラインと比較して、より正確な推論VLモデルを生成することを示している。

5.6 大型言語モデルと視覚言語モデリング知能

多くの研究が、タスク計画を実行するための知能として大規模言語モデルを利用しており(Huang et al.タスクを実行している。最近のロボット工学の研究でも、自然言語コマンドを自然言語またはPythonコードの形で一連のサブタスクに分解し、それを低レベルのコントローラを使って実行することで、大規模言語モデルを活用してタスク計画を実行している(Ahn et al.、2022a; Huang et al.、2022b; Liang et al.、2022)。さらに、Huangら(2022b)、Liangら(2022)、Wangら(2023a)は、タスクパフォーマンスを向上させるために環境フィードバックも統合している。また、大規模なテキスト、画像、動画データで訓練された一般化された視覚的に整列された大規模言語モデルが、様々な環境で具現化され行動できるマルチモーダルインテリジェンスを作成するための基礎として使用できることを実証する多くの研究がある。

6 インテリジェントボディAIの応用課題

![Agent AI: 探索多模态交互的边界-2 Agent AI: 探索多模态交互的前沿世界[李飞飞-经典必读]](https://aisharenet.com/wp-content/uploads/2025/01/51782170a54f914.png)

図8:マインクラフトのダンジョンにおけるゲームプレイ感覚のシミュレーションと、GPT-4Vを介したユーザ対話型のゲーム行動予測とインタラクション編集のための具現化知能の生成。

6.1 ゲームインテリジェンス

このゲームは、大規模言語モデルと視覚言語モデルの両方から知能の振る舞いをテストするユニークなサンドボックスを提供し、共同作業や意思決定を行う能力の限界を押し広げる。特に、人間のプレイヤーや他の知能と相互作用し、その環境で意味のある行動をとる知能の能力を強調する3つの領域について説明する。

6.1.1 NPCの行動

最近のゲームシステムでは、ノンプレイヤーキャラクター(NPC)の行動は、開発者によって書かれた定義済みのスクリプトによってほぼ決定されます。これらのスクリプトには、ゲーム環境における様々なトリガーやプレイヤーのアクションに基づいた一連の反応やインタラクションが含まれています。しかし、このようなスクリプトの性質上、プレイヤーの行動やゲームの動的な環境に基づいて進化しない、予測可能または反復的なNPCの行動になってしまうことがよくあります。この硬直性は、ダイナミックなゲーム環境で期待される没入感を阻害します。そのため、大規模な言語モデルを使用してNPCの行動に自律性と適応性を持たせ、インタラクションをよりニュアンス豊かで魅力的なものにすることに関心が高まっています。人工知能主導のNPCは、プレイヤーの行動から学習し、異なる戦略に適応し、より挑戦的で予測不可能なゲーム体験を提供することができます。大規模言語モデル(LLM)は、ゲームにおけるNPCの行動の進化に大きく貢献することができます。大量のテキストを処理することで、LLMはパターンを学習し、より多様で人間に近い反応を生成することができます。LLMは、NPCとのインタラクションをより魅力的で予測不可能なものにする、ダイナミックなダイアログシステムを作成するために使用できます。さらに、ビッグ・ランゲージ・モデルは、プレイヤーのフィードバックやゲーム内のデータを使って学習させることができ、プレイヤーの期待やゲームのダイナミクスによりマッチするよう、NPCの行動を継続的に改善することができます。

6.1.2 マン・マシンNPCインタラクション

人間であるプレイヤーとNPCとのインタラクションは、ゲーム体験の重要な側面です。従来のインタラクションモデルは、NPCがあらかじめ定義された方法でプレイヤーの入力に反応するという、主に一次元的なものでした。この限界は、バーチャル領域内でより自然で豊かなインタラクション(人間対人間のインタラクションに近い)の可能性を阻害します。ビッグ・ランゲージ・モデリングとビジュアル・ランゲージ・モデリング技術の出現は、このパラダイムを変えることを約束する。これらの技術を採用することで、ゲームシステムは人間の行動を分析・学習し、より人間に近いインタラクションを提供することができる。これはゲームのリアリズムとエンゲージメントを高めるだけでなく、制御された複雑な環境における人間とコンピュータのインタラクションを探求し理解するためのプラットフォームを提供する。

![Agent AI: 探索多模态交互的边界-3 Agent AI: 探索多模态交互的前沿世界[李飞飞-经典必读]](https://aisharenet.com/wp-content/uploads/2025/01/8e683187a00e5d4.png)

図9:GPT-4Vは、キューに「動作履歴」と「ゲームゴール」が与えられると、高レベルの次の動作を予測するのに有効である。また、GPT-4Vはプレーヤーが木の丸太を手にしていることを正確に認識し、この認識した情報を将来の行動計画に組み込むことができる。GPT-4Vは、いくつかの低レベルの行動(例えば、バックパックを開けるために「E」キーを押す)を予測することができるようですが、このモデルの出力は、原始的な低レベルの行動予測(マウスの動きを含む)には本質的に不向きであり、低レベルの行動制御のための補足モジュールが必要になるかもしれません。

6.1.3 インテリジェントボディベースゲームの分析

ゲームは日常生活に欠かせないものであり、世界人口の推定半数を魅了している https://www.dfcint.com/global-video-game-audience-reaches-3-7-billion/ 。加えて、メンタルヘルスにも良い影響を与える https://news.microsoft.com/source/features/work-life/mind-games-how-gaming-can-play-a-positive-role-in-mental-健康にも良い影響を与える。しかし、現代のゲームシステムは、人間のプレイヤーとのインタラクションにおいて欠陥がある。これらのあらかじめプログラムされた行動は、プレイヤーのニーズに適応できないことが多い。そのため、プレイヤーの行動を分析し、必要に応じて適切なサポートを提供できる新しいAIシステムがゲームに必要とされている。インテリジェント・インタラクション・システムは、ゲーマーとゲームシステムとのインタラクション方法に革命をもたらす可能性を秘めています。NPCとゲーマーとのインタラクションは、もはやゲーム開発者によってデザインされた限定的なルールセットに縛られることはありません。NPCは、ゲーマーの経験にシームレスに適応し、ゲーム体験を豊かにするためのフィードバックをタイムリーに提供し、人間とコンピュータの相互作用の相乗効果を高める可能性を秘めています。

ビッグ・ランゲージ・モデルは、チャット記録、プレイヤーのフィードバック、ナラティブコンテンツなど、ゲーム内のテキストデータを分析するための強力なツールとなります。プレイヤーの行動、嗜好、インタラクションのパターンを特定するのに役立ち、ゲーム開発者がゲームメカニクスやナラティブを改善する上で非常に有益です。さらに、ビジュアル言語モデルは、ゲームセッションの大量の画像や動画データを解析し、ゲーム世界におけるユーザーの意図や行動を分析するのに役立ちます。さらに、ビッグ言語モデルとビジュアル言語モデルは、洗練された人間のような方法でプレイヤーや他のインテリジェンスとコミュニケーションできるインテリジェントなゲーム内インテリジェンスの開発を促進し、全体的なゲーム体験を向上させることができます。大規模な言語モデルと視覚言語モデルに加えて、ユーザー入力データは、人間のプレイヤーを模倣することによって知覚、ゲームプレイ、ゲーム理解をモデル化するゲームインテリジェンスを作成するための有望な手段を提供します。プレイヤーとのインタラクションやフィードバック、ピクセル入力、自然言語によるプランニングと理解を組み合わせることで、インテリジェントな身体モデルはゲームダイナミクスを継続的に改善し、ゲーム環境をよりプレイヤー中心に進化させることができます。

6.1.4 ゲームシーンの合成

![Agent AI: 探索多模态交互的边界-3 Agent AI: 探索多模态交互的前沿世界[李飞飞-经典必读]](https://aisharenet.com/wp-content/uploads/2025/01/0b63e575812de0a.png)

図10:未見のMinecraftビデオに対するマスクビデオ予測。左から右へ:元のフレーム、マスクされたフレーム、再構成されたフレーム、パッチを含む再構成されたフレーム。

シーン合成は、没入感のあるゲーム環境を作成し、強化するための重要な要素です。ゲーム内の3次元(3D)シーンや環境を、自動または半自動で生成します。このプロセスには、地形の生成、オブジェクトの配置、リアルな照明の作成、時には動的な天候システムも含まれます。

最近のゲームには、広大なオープンワールド環境がよく登場する。このような景観を手作業でデザインするのは、時間とリソースを必要とします。自動化された地形生成(多くの場合、手続き型またはAI駆動型の技術を使用)は、人間の介入をあまり必要とせずに、複雑でリアルな景観を作り出すことができる。ビッグ・ランゲージ・モデルとビジュアル・ランゲージ・モデルは、インターネット・スケールの知識を活用して、視覚的に印象的でユニークな非反復風景をデザインするためのルールを開発することができる。さらに、ビッグ言語モデルと視覚言語モデルは、生成されたアセットの意味的一貫性と可変性を保証するために使用することができます。建物、植生、その他の要素などのオブジェクトをシーンにリアルかつ美的に配置することは、没入感を高めるために非常に重要です。

![Agent AI: 探索多模态交互的世界[李飞飞-经典必读]-1 Agent AI: 探索多模态交互的前沿世界[李飞飞-经典必读]](https://aisharenet.com/wp-content/uploads/2025/01/dad22c0f828f9a2.png)

図11:マインクラフトのゲームシナリオにおいて、事前に訓練された小型知能モデルを使用した低レベルの次の行動予測。

ビジュアル言語モデルとビッグ言語モデルは、定義済みまたは学習済みのルールと美学に従ってオブジェクトを配置することで、レベル デザイン プロセスをスピードアップします。ビジュアル・ランゲージ・モデルやビッグ・ランゲージ・モデルは、プロシージャルなコンテンツ生成を支援するために、デザインや美学の原則を理解するようにさらに訓練することができる。視覚的に魅力的で文脈に適したオブジェクトやシーンを生成するために、手続き型アルゴリズムが従うルールやガイドラインの開発を支援することができる。

リアルな照明と大気効果は、信憑性が高く魅力的なゲーム環境を作成するための基礎です。高度なアルゴリズムにより、自然な照明条件やダイナミックな天候効果をシミュレートし、シーンのリアルさや雰囲気を向上させることができます。ビッグ言語モデルは、いくつかの革新的な方法で、よりリアルな照明と大気効果を実現するシステムの開発に役立ちます。ビジュアル言語モデルは、現実世界の照明や大気の状態から大規模なデータセットを分析し、ゲーム内でこれらの効果をシミュレートするための、よりリアルなアルゴリズムの開発に役立ちます。自然の照明や天候のパターンと複雑さを理解することで、これらのモデルは現実に近いアルゴリズムの開発に貢献することができます。ビッグ・ランゲージ・モデルやビジュアル・ランゲージ・モデルは、プレイヤーの行動、ゲームの状態、または外部入力に基づいて、照明や大気効果をリアルタイムで調整するシステムの開発にも使用できます。プレイヤーからの自然言語コマンドを処理してゲーム環境を変更し、よりインタラクティブで没入感のある体験を提供することができます。

6.1.5 実験と結果

大規模言語モデルまたは視覚言語モデルを用いたゼロサンプル/少数サンプル学習。

図8と図9に示すように、我々はGPT-4Vを高レベルの記述とアクション予測に使用している。図8は、GPT-4Vを使用してアクション記述と編集を生成した定性的な例を示しています。このようにGPT-4Vは、ゲームアクションを先験的に用いて3Dシーンを生成することで、シーンの自然さを向上させることができます。その結果、GPT-4Vはゲーム映像に関連する高レベルの説明を生成します。

小さな知能のための事前学習モデル。

インテリジェントボディのためのビジュアル言語アーキテクチャを実証するために、まず、ゲームインテリジェントボディのために広く使用されているドメインであるMinecraftデータの事前学習への適用を調査する。図7に示すように、入力されたアクション・インテリジェントボディ、ビデオキーフレーム、および対応するテキストが与えられた場合、インテリジェントボディのアクションと画像は、標準的なエンコーダ・デコーダを使用してアクションテキストトークンとイメージパッチトークンに変換することができ、次にインテリジェントボディ視覚言語デコーダを使用してアクション予測センテンスに変換することができる。全体的なアーキテクチャを図7に示す。Minecraftのビデオデータは5分のクリップで構成され、事前学習に使用するビデオには78Kのビデオが含まれ、事前学習の最初のラウンドには5Kのビデオ(事前学習データの6%を占める)を使用する。16台のNVIDIA v100 GPUで2億5,000万パラメータのモデルを1日トレーニングし、図10と図11でモデル出力を可視化します。図10は、私たちの比較的小さなスマートボディアーキテクチャが、トレーニング中に見られなかったMinecraftシーンに対して妥当な出力を生成できることを示しています。図11は、モデルの予測と実際の人間のプレイヤーの行動を比較したもので、私たちの小さなインテリジェントボディモデルの低レベルの理解の可能性を示しています。

![Agent AI: 探索多模态交互的边界-5 Agent AI: 探索多模态交互的前沿世界[李飞飞-经典必读]](https://aisharenet.com/wp-content/uploads/2025/01/f1d9e9333ec6a9c.png)

図 12:MindAgent for Contextual Learning Game Infrastructure(コンテキスト学習ゲームインフラストラクチャのための MindAgent)。 計画スキルとツールの使用:ゲーム環境では、タスクを完了するために、多様な計画スキルとツールの使用が必要となる。関連するゲーム情報を生成し、ゲームデータをビッグ言語モデルで処理できる構造化テキスト形式に変換します。ビッグ・ランゲージ・モデル: 私たちのインフラの主要な作業エンジンが意思決定を行い、その結果、マルチインテリジェントな身体システムのスケジューラーとして機能します。記憶履歴:関連情報を保存するためのユーティリティ。アクションモジュール:テキスト入力からアクションを抽出し、ドメイン固有の言語に変換する。

マルチ・インテリジェント・インフラストラクチャ。

図5の知的身体パラダイムに示すように、我々は「CuisineWorld」Gongら(2023a)と呼ばれる新しいゲームシナリオのための新しいインフラを設計した。図12で我々のアプローチを詳細に説明する。我々のインフラストラクチャーは、GPT-4を中央プランナーとして利用し、複数のゲーム・ドメインにまたがって作業することで、多知能コラボレーションを可能にする。このシステムの多知能プランニング能力を調査し、実世界のビデオゲームにインフラを導入して、多知能と人間とコンピュータのコラボレーションの有効性を実証する。さらに、マルチインテリジェンス・コラボレーションのためのテキストベースのベンチマークである "Cuisineworld "を実証し、コラボレーションの効率を定量化する新しい自動化指標Collaboration Score (CoS)を提供する。

ゲームの説明、高レベルの行動予測、GPT-4Vのヒントに関するより多くの例と詳細については、付録を参照。Bleeding Edge の例(図 32 と付録 B 参照)、Microsoft Flight Simulator の例(図 33 と付録 C 参照)、ASSASSIN'S CREED ODYSSEY の例(図 34 と付録 D 参照)、GEARS of WAR 4 の例(図 35 と付録 E 参照)、Starfield の例を示す。また、Minecraftの例を生成するために使用されたGPT4Vプロンプトプロセスの詳細なスクリーンショットも提供しています(図31と付録Aを参照)。

6.2 ロボット工学

ロボットは、環境と効果的に相互作用する必要のある典型的な知能である。ここでは、効率的なロボット操作のための重要な要素を紹介し、最新の大規模言語モデリング/視覚言語モデリング(LLM/VLM)技術が適用されている研究トピックをレビューし、最近の研究成果を共有する。

ビジュアルモーションコントロール。

視覚運動制御とは、ロボットシステムにおいてタスクを効率的に実行するために、視覚認識と運動動作を統合することを指す。この統合は、ロボットが環境からの視覚データを解釈し、それに応じて運動動作を調整し、環境と正確に相互作用することを可能にするため、非常に重要である。例えば、組立ラインにおいて、ビジョン・モーション・コントロールを備えたロボットは、物体の位置と向きを感知し、ロボットアームを正確に調節して、それらの物体と相互作用することができる。この機能は、産業オートメーションから高齢者の日常生活支援まで、幅広い用途でロボット操作の正確性と有効性を確保するために不可欠です。さらに、視覚的モーションコントロールは、環境の状態が急速に変化する可能性があり、視覚的フィードバックに基づいて動作アクションをリアルタイムで調整する必要があるダイナミックな環境にロボットが適応するのに役立ちます。

さらに、安全な操作の文脈では、視覚情報は、実行エラーを検出し、各ロボットの動作の前後条件を特定するために極めて重要である。未知の家庭環境のような制御されていない環境では、ロボットは家具の形状の変化、照明の変化、滑りなどの予測できない要因によって、意図しない結果にさらされる可能性が高くなる。事前に計画された動作シナリオをフィードフォワード方式のみで実行することは、このような環境では大きなリスクをもたらす可能性がある。したがって、視覚フィードバックを使用して各ステップの結果を継続的に検証することが、ロボットシステムの堅牢で信頼性の高い動作を保証する鍵となる。

言語条件付きオペレーション。

言語条件付き操作とは、ロボットシステムが言語的な指示に基づいてタスクを解釈し、実行する能力を指す。この側面は、直感的でユーザーフレンドリーな人間とロボットのインターフェースを作る上で特に重要である。自然言語コマンドを通じて、ユーザーは人間同士のコミュニケーションと同様の方法でロボットに目標やタスクを指定することができ、ロボットシステムを操作するための敷居を低くすることができる。例えば、実世界のシナリオでは、ユーザーがサービスロボットに「テーブルから赤いリンゴを拾って」と指示すると、ロボットはこのコマンドを解析し、それが指している物体を認識し、その物体を拾うタスクを実行する。核となる課題は、直接的な命令からより抽象的な命令まで、幅広い指示を正確に解釈し、ロボットがこれらの指示を実行可能なタスクに変換できるような、ロバストな自然言語処理・理解アルゴリズムを開発することである。さらに、ロボットがこれらの指示を異なるタスクや環境に汎化できるようにすることは、実世界のアプリケーションにおけるロボットの汎用性と有用性を高める上で極めて重要である。ロボットのタスクプランニングを導くために言語入力を使用することは、Task and Motion Planning Garrett et al.(2021)と呼ばれるロボット工学のフレームワークで注目されている。

スキルの最適化。

最近の研究では、ロボットのタスク計画における大規模言語モデリング(LLM)の有効性が強調されている。しかし、タスクの最適な実行、特に把持のような物理的インタラクションを伴うタスクの最適な実行には、人間の指示を解釈するだけでなく、環境をより深く理解する必要がある。例えば、ロボットによる把持では、その後の動作を効果的に実行するために、Wakeら(2023e)と腕の姿勢Sasabuchiら(2021)が正確な接触点を必要としている。これらの要素(正確な接触点や腕の姿勢)は人間にとって直感的なものであるが、言語によって表現することは困難である。インターネット規模の視覚言語モデリング(VLM)の進歩にもかかわらず、シーンからこれらの微妙な間接的手がかりを捉え、効果的にロボットのスキルに変換することは、依然として大きな課題である。これに対し、ロボット工学コミュニティでは、拡張データセットの収集(例えば、Wangら(2023d);Padalkarら(2023))や、人間のデモンストレーションから直接スキルを習得する手法の開発にますます注力している。実演からの学習や模倣による学習を含むフレームワークは、これらの開発をリードしており、物理スキルを最適化する上で重要な役割を果たしている。

6.2.1 ロボット工学のための大規模言語モデル/視覚言語モデル(LLM/VLM)インテリジェンシア。

最近の研究では、環境における人間との相互作用に関わるロボット知能のための大規模言語モデル/視覚言語モデル(LLM/VLM)の可能性が実証されている。最新のラージ・ランゲージ・モデリング/ビジュアル・ランゲージ・モデリング(LLM/VLM)技術の活用を目的とした研究テーマは以下の通り:

マルチモーダルシステム最近の研究では、最新の大規模言語モデリング(LLM)や視覚言語モデリング(VLM)技術を入力情報のエンコーダとして使用するエンドツーエンドシステムの開発が活発に行われている。特に、マルチモーダル情報を扱うために、これらの基礎となるモデルを修正することが重要な傾向となっている。Jiangら(2022);Brohanら(2023、2022);Liら(2023d);Ahnら(2022b);Shahら(2023b);Liら(2023e)。2023e).この適応は、効果的な具現化のために、言葉による命令と視覚的な手がかりに基づいてロボットの行動を誘導することを目的としている。

ミッション・プランニングとスキル・トレーニングエンド・ツー・エンドのシステムとは対照的に、タスク・アンド・モーション・プランニング(TAMP)ベースのシステムは、まず高レベルのタスクプランを計算し、それを低レベルのロボット制御(スキルと呼ばれる)によって実現する。

ラージ・ランゲージ・モデル(LLM)の高度な言語処理能力により、指示を解釈してロボットの行動ステップに分解できることが示されており、これによりタスク計画技術が大幅に進歩する。技能訓練については、報酬関数を設計するために大規模言語モデリング(LLM)/視覚言語モデリング(VLM)を使用することを検討した研究がいくつかある。 Yuら(2023a);Kataraら(2023);Maら(2023)、戦略学習のためのデータを生成するためにKumarら(2023);Duら(2023)、またはその一部として、LLM/視覚言語モデリング(VLM)を使用することを検討した研究がいくつかある。2023)、あるいは報酬機能の一部としてSontakke et al.強化学習や模倣学習などの学習フレームワークと組み合わせることで、これらの取り組みは効率的なロボット制御装置の開発に役立つだろう。

現場での最適化ロボット工学における長いタスクステップの実行は、予期しない予測不可能な環境条件のために困難な場合がある。そのため、ロボット工学の分野では、タスクプランニングとリアルタイムの環境データを組み合わせることで、ロボットのスキルを動的に適応・向上させることが大きな課題となっている。例えば、(Ahn et al., 2022b)は、視覚情報から行動の実現可能性(すなわち可用性)を計算し、計画されたタスクと比較する手法を提案した。さらに、タスクステップの実行を最適化するために、タスクステップの前提条件と事後条件(例えば、オブジェクトの状態とそれらの相互関係)を出力するための大規模言語モデル(Large Language Model:LLM)を有効にすることに焦点を当てたアプローチもある Zhou et al.これらの戦略は、環境情報を統合し、タスクプランまたはコントローラレベルでロボットの行動を適応させることで、環境指向のロボット実行を実現することを目的としている。

インテリゲンチアとの対話会話ロボットを作成する際、大規模言語モデル(LLM)は、人間との自然で文脈に即した対話を促進することができる。これらのモデルは、人間の対話を模倣した応答を処理・生成し、ロボットが意味のある会話に参加することを可能にする。さらに、大規模言語モデル(LLM)は、概念Henselら(2023);Teshimaら(2022)や感情属性Zhaoら(2023);Yangら(2023b);Wakeら(2023d)の評価において重要な役割を果たす。これらの属性は、人間の意図を理解し、意味のあるジェスチャーを生成するのに役立ち、人間とコンピュータのコミュニケーションの自然性と有効性に貢献する。

ナビゲーティング・インテリジェント・ボディ ロボットのナビゲーションは、マップベースの経路計画や、環境のマップを作成するための定位とマップの同時構築(SLAM)などの中核的な側面に焦点を当てた研究の長い歴史を持っている。これらの機能は、ロボット・オペレーティング・システム(ROS)Guimarães et al.

古典的なナビゲーション技術は今でも多くのロボットアプリケーションに普及しているが、それらは通常、静的なマップや事前に作成されたマップに依存している。近年、コンピュータ・ビジョンや自然言語処理などの分野における飛躍的な進歩を利用して、ロボットがより困難な環境でもナビゲートできるようにする高度な技術への関心が高まっている。代表的なタスクは物体ナビゲーションで、Chaplotら(2020a); Batraら(2020); Gervetら(2023); Ramakrishnanら(2022); Zhangら(2021)は、ロボットがナビゲーションのために地図座標ではなく物体名を使用している。この場合、環境内の物体名を視覚的に特定する必要がある。さらに、最近では、全く見慣れない新しい環境において、ベースモデルの上にゼロサンプル方式でロボットをナビゲートする技術、いわゆるゼロサンプルオブジェクトナビゲーションGadreら(2023); Dorbalaら(2023); Caiら(2023)が注目されている。さらに、Visual Linguistic Navigation (VLN)Andersonら(2018a)は代表的なタスクであり、このタスクでは、これまで見たことのない実環境において、自然言語コマンドを通じて知的身体をナビゲートすることが含まれる Shahら(2023a); Zhouら(2023a); Dorbalaら(2022);Liangら(2023); Huangら(2023b)。視覚言語ナビゲーション(VLN)は、オブジェクト名ではなく文章を解釈する。

この基礎となるモデルの出現は、人間の言語コマンドの理解と環境情報の視覚的解釈を強化することで、この適応的なその場ナビゲーション技術の発展に寄与してきた。代表的な視覚言語ナビゲーション(VLN)研究のより詳細な説明は6.2.2を参照。

6.2.2 実験と結果。

![Agent AI: 探索多模态交互的边界-7 Agent AI: 探索多模态交互的前沿世界[李飞飞-经典必读]](https://aisharenet.com/wp-content/uploads/2025/01/5e6a0728b9c2662.png)

図13:ChatGPT駆動タスクプランナーを統合したロボット教示システムの概要。このプロセスは2つのステップから構成される。タスクプランニングでは、ユーザがタスクプランナーを使用して一連の動作を作成し、必要に応じてフィードバックにより結果を調整する。デモでは、ユーザが一連の動作を視覚的に実演し、ロボット操作に必要な情報を提供する。ビジョンシステムは、ロボットの実行に使用される視覚パラメータを収集する。

最近の視覚言語モデル(VLM)や大規模言語モデル(LLM)が、シンボリックなタスク計画(例えば、何をするか)に対して優れた能力を持つという証拠が増えつつある。しかし、それぞれのタスクは、環境間のインタラクションを成功させるために、低レベルの制御戦略(例えば、どのように行うか)を必要とする。強化学習や模倣学習は、データ駆動的に戦略を学習するための有望なアプローチであるが、もう一つの有望なアプローチは、生きたデモンストレーションを通して人間から直接戦略を獲得することである。本節では、ChatGPTを用いてタスク計画を立て、その計画に可用性情報をパラメータとして付与することで、効率的かつ正確な実行を促進する研究を紹介する(図13)。

このプロセスは、タスクプランニングとパラメータ化の2つのモジュールで構成される。タスク計画では、システムは言語による指示と作業環境の説明を受け取ります。これらの指示は、事前に定義されたロボットの動作と出力仕様とともに、ChatGPTに提供される包括的なプロンプトにコンパイルされ、ChatGPTは一連の分解タスクとそのテキスト記述を生成します(図13;左ペイン)。注目すべきは、サンプルレスアプローチを採用していることです。つまり、ChatGPTはこのタスクのためにトレーニングされていません。これは、ハードウェア関連のデータ収集とモデルトレーニングの必要性を排除するため、適用可能性の点で有利です。さらに、出力にテキスト記述があるため、ユーザーは必要に応じて結果を確認・調整することができ、これは安全で信頼性の高い運用のための重要な機能です。図14は、VirtualHome Puig et al.(2018)の上で実行されたインテリジェンスのシミュレーションの定性的結果を示している。この結果は、合理的なタスク計画と出力の調整における柔軟性を示しており、我々のアプローチの幅広い適用可能性を示している。

![Agent AI: 探索多模态交互的世界[李飞飞-经典必读]-2 Agent AI: 探索多模态交互的前沿世界[李飞飞-经典必读]](https://aisharenet.com/wp-content/uploads/2025/01/09bc49e4acc235a.png)

図14:自動生成フィードバックによる出力シーケンスの調整例。実験にはオープンソースのシミュレータVirtualHomeを使用した。"テーブルの上のパイを取り、クッカーで加熱する。"という指示が与えられると、タスクプランナーはVirtualHomeで提供される一連の機能を計画する。タスク・プランナは、VirtualHomeで提供される機能のシーケンスを計画する。実行中にエラーが検出された場合、タスク・プランナは自動的に生成されるエラー・メッセージを用いて出力を修正する。

タスクプランナーがタスクシーケンス間の一貫性を保証する一方で、現実の操作を成功させるためには詳細なパラメータが必要です。例えば、内容物をこぼさずに容器を運ぶためには、把持のタイプが重要であるが、シミュレータでは通常無視されるパラメータである(図14のパイを把持する例を参照)。したがって、我々のロボットシステムでは、ユーザが各動作を視覚的に示す必要がある(図13;右ペイン)。これらのタスクには、実行に必要な事前定義されたパラメータがあり、我々のビジョンシステムは、Wakeら(2021b)のビデオからそれを抽出する。注目すべきは、我々のロボットシステムは人間の動作を正確に再現する(すなわち遠隔操作)ように設計されているのではなく、物体の位置の変化など、実世界の様々な状況に対応するように設計されていることである。そのため、人間のデモンストレーションから抽出されたパラメータには、正確な動作経路だけでなく、効果的な環境動作を示すアベイラビリティ情報(衝突回避のためのウェイポイントWakeら(2023a)、把持タイプWakeら(2023e)、上肢姿勢Sasabuchiら(2021)、Wakeら( 2021a)など)も含まれている。2021a)).上肢姿勢は自由度の高いロボットにおいて重要であり、操作ロボットと共存する人間にとって予測可能な姿勢を提示するように設計されている。利用可能なタスクのシーケンスは、強化学習によって習得され、ロボットによって実行される再利用可能なロボットスキルの集合に変換される Takamatsu et al.

![Agent AI: 探索多模态交互的边界-13 Agent AI: 探索多模态交互的前沿世界[李飞飞-经典必读]](https://aisharenet.com/wp-content/uploads/2025/01/3c95adeb261df8e.png)

図15:GPT-4VとGPT-4を用いたマルチモーダルタスクプランナの概要。このシステムはビデオプレゼンテーションとテキスト指示を処理し,ロボット実行のためのタスクプランを生成する.

![Agent AI: 探索多模态交互的世界[李飞飞-经典必读]-4 Agent AI: 探索多模态交互的前沿世界[李飞飞-经典必读]](https://aisharenet.com/wp-content/uploads/2025/01/48d540c768aad09.png)

図16:ビデオアナライザーの出力例。一定間隔で5フレームが抽出され、GPT-4Vに入力される。全プロセスについてはセクション6.2.2で説明する。

GPT-4V(ision)を視覚言語モデル(VLM)と統合することにより、大規模言語モデル(LLM)によって駆動されるタスクプランニングを拡張し、より一般化されたロボットシステムを実現することができる。ここでは、GPT-4V(ision)を用いて、マルチモーダル入力コンテキスト(図15)において、上記のタスクプランナを拡張した例を示す。本稿では、ヒントの一部のみを示す。完全なプロンプトはmicrosoft.github.io/GPT4Vision-Robot-Manipulation-Promptsにある。

このプロセスは、デモビデオとテキストを受け取り、一連のロボット動作を出力する。ビジュアルアナライザーは、映像の中で人間が行った動作を理解することを目的としている。我々はGPT-4Vを使用し、人間同士のコミュニケーションに似たテキスト形式のコマンドを生成するプロンプトを提供した。図16は、テキスト入力を使用することで、GPT-4Vの認識結果を修正するためのフィードバックをユーザーに提供できることを示している。この機能は、認識結果の精度を向上させるとともに、より堅牢な運用を可能にするものである。

![Agent AI: 探索多模态交互的边界-15 Agent AI: 探索多模态交互的前沿世界[李飞飞-经典必读]](https://aisharenet.com/wp-content/uploads/2025/01/68218e1642d53a3.png)

図17:GPT-4Vを使用したシーンアナライザーの出力例。6.2.2節で私たちのプロセス全体を説明する。

次に、シーンアナライザは、コマンドとビデオデータの最初のフレーム(または環境画像)に基づいて、予想される作業環境をテキスト情報にコンパイルします。この環境情報には、GPT-4Vが認識するオブジェクト名のリスト、オブジェクトの把握可能な属性、オブジェクト間の空間関係が含まれます。これらの計算処理はGPT-4Vではブラックボックス化されていますが、GPT-4Vの知識と画像・テキスト入出力情報に基づいています。図17にシーンアナライザーの出力例を示す。このように、GPT-4Vは操作に関連するオブジェクトをうまく選択している。例えば、人間がスパム容器をテーブルの上に移動させる場合、テーブルが出力に含まれるが、冷蔵庫を開けるタスクではテーブルは無視される。これらの結果は、シーンアナライザーが人間の行動に基づいてシーン情報をエンコードしていることを示唆している。我々はGPT-4Vに、オブジェクト選択プロセスの結果と、これらの選択の背後にある理由を説明するように促した。実際には、このアプローチは妥当な出力を生成することがわかった。最後に、与えられたテキスト指示と環境情報に基づいて、タスクプランナーは一連のタスクを出力する。

ロボットナビゲーションのための身体化された知能。

視覚言語ナビゲーション(VLN)の課題は、現実的な3D環境で自然言語コマンドを実行するために、具現化された知能をナビゲートすることである。3D環境でのナビゲーション Zhuら(2017a);Mirowskiら(2016);Mousavianら(2018);Hemachandraら(2015)は、物理世界で動作するモバイルインテリジェントシステムにとって不可欠な能力である。ここ数年、多数のタスクと評価プロトコルが提案されている Savva et al. (2017); Kolve et al. (2017); Song et al. (2017); Xia et al. (2018); Anderson et al.にまとめられている。視覚言語ナビゲーション(VLN)Andersonら(2018a)は、実際の3D環境における言語ベースのナビゲーションに焦点を当てている。Visual Linguistic Navigation (VLN)タスクに対処するために、(Anderson et al., 2018a)は注意ベースのシーケンス間ベースラインモデルを開発した。その後、(Wang et al., 2018)は、モデルの汎化を改善するために、モデルフリーとモデルベースの強化学習(RL)を組み合わせたハイブリッドアプローチを導入した。最後に、(Fried et al., 2018)は、データ増強、パノラマ行動空間、視覚言語ナビゲーション(VLN)のための修正ビーム探索を採用した話者フォロワーモデルを提案し、Room-to-Roomデータセットにおける現在の最先端性能を確立した。以前の研究を基に、我々は(Wang et al., 2019)で視覚言語ナビゲーション(VLN)のための強化クロスモーダルマッチング(RCM)を提示する。RCMモデルはFried et al.language navigation (VLN)と模倣学習を組み合わせているのに対し、Friedら(2018)の話者フォロワーモデルは、(Anderson et al., 2018a)に示されているように、教師あり学習のみを用いている。(2)RCM推論ナビゲータは、ユニモーダル入力に対する時間的注意メカニズムではなく、クロスモーダル定位を行っている。(3)RCMマッチング・クリティックは、アーキテクチャ設計の点ではスピーカーに似ているが、前者は強化学習(RL)および自己教師付き模倣学習(SIL)訓練のために内在的報酬の周期的再構成を提供するために使用され、後者は教師あり学習のための訓練データを増強するために使用される。Wang et al., 2019)において、我々はこのタスクの3つの重要なリーダーの課題である、クロスモーダル定位、非ポーズドネスに対するフィードバック、汎化問題に対処する方法を調査している。図18に示すように、我々は、強化学習(RL)を介して、局所的かつ大域的にクロスモーダル定位を強制する、新しい強化クロスモーダルマッチング法を提案する。特に、マッチングコメンテータは、指示と軌跡の大域的なマッチングを促すための内発的報酬を提供するために使用され、推論ナビゲータは、局所的な視覚シーンにおけるクロスモーダルローカリゼーションを実行するために使用される。Visual Linguistic Navigation (VLN)ベンチマークデータセットの評価により、我々のRCMモデルは、SPL上で従来のアプローチ10%を大幅に上回り、新たな最先端性能を達成することが示された。学習戦略の汎化能力を向上させるために、我々はさらに自己教師あり模倣学習(Self-Supervised Imitation Learning: SIL)アプローチを導入し、自身の過去の良い判断を模倣することで未知の環境を探索する。我々は、自己監視下模倣学習(SIL)が、より優れた効果的な戦略を近似できることを実証し、その結果、見た環境と見たことのない環境との間の成功率の性能差を大幅に縮めた(30.7%から11.7%へ)。さらにWangら(2019)では、探索のための自己教師付き模倣学習法を導入し、これまでの研究で十分に研究されていなかった汎化問題に明示的に対処している。この研究と同時に、Thomasonら(2018);Keら(2019);Maら(2019a、b)は視覚言語ナビゲーション(VLN)タスクを様々な側面から研究し、Nguyenら(2018)は視覚言語ナビゲーション(VLN)タスクの変形を導入した。言語的支援を要求してオブジェクトを見つける。なお、視覚言語ナビゲーション(VLN)タスクのために未見の環境を探索することを提案したのは我々が初めてである。

![Agent AI: 探索多模态交互的边界-10 Agent AI: 探索多模态交互的前沿世界[李飞飞-经典必读]](https://aisharenet.com/wp-content/uploads/2025/01/1414c9756505ddf.png)

図18:Wangら(2019)の視覚言語ナビゲーション(VLN)タスク具現化知能のデモ。トップビューでの指示、ローカルな視覚シーン、グローバルな軌跡が示されている。知的身体はトップビューにアクセスできない。経路Aは、指示に従ったデモンストレーション経路である。パスBとCは、知的ボディが実行する2つの異なるパスである。

6.3 健康管理

ヘルスケアにおいて、大規模言語モデル(LLM)と視覚言語モデル(VLM)は、診断インテリジェンス、患者ケアアシスタント、さらには治療補助として機能することができるが、独自のリーダーとしての課題と責任にも直面している。AIインテリジェンスには、患者ケアを向上させ、命を救う莫大な可能性があるため、誤用されたり、性急に導入されたりして、世界中の何千、何百万もの人々を危険にさらす可能性も同様に危険である。我々は、ヘルスケアにおけるAIインテリジェンスの有望な道筋のいくつかについて議論し、直面する重要なリーダーのジレンマのいくつかを取り上げる。

インテリゲンチアを診断する

大規模言語モデル(Large Language Models:LLM)を患者診断に利用する医療用チャットボットは、医療専門家に対する需要の高さと、患者の分類と診断に役立つLLMの可能性から、最近大きな注目を集めている Lee et al.会話知性、特に多様な患者集団の幅広い人々に重要な医療情報を効果的に伝えることができる会話知性は、歴史的に不利な立場に置かれてきた、あるいは社会から疎外されてきた集団に医療への公平なアクセスを提供する可能性を秘めている。加えて、世界中の医師や医療制度は、その大部分が過重な負担とリソース不足に陥っており、その結果、世界中で何億人もの人々が適切な医療を受けられなくなっている。 世界保健機関(WHO)と世界銀行(2015)。診断知能は、幅広い言語、文化、健康状態を理解する能力で構築することができるため、何百万人もの人々のヘルスケアを改善するために特に有利な道を提供する。予備的な結果では、大規模なネットワークデータを利用することで、ヘルスケアの知識を持つ大規模な言語モデル(LMM)を学習できることが示唆されている。これはエキサイティングな方向性ではあるが、診断インテリジェンスの見通しにはリスクがないわけではない。以下のセクションでは、医療現場における幻覚のリスクと、解決のための潜在的な道筋に焦点を当てる。

知識検索インテリジェンス。

医療においては、幻覚のモデリングは特に危険であり、誤りの程度によっては、患者の重傷や死亡につながることさえある。例えば、患者が実際には発症していない病態を示唆する診断を誤って受けた場合、破滅的な結果を招く可能性がある。こうした結果には、治療の遅れや不適切な治療、場合によっては必要な医療介入の完全な欠如などが含まれる。未診断や誤診の深刻さは、医療費の増大、治療の長期化による身体的ストレスの増大につながり、極端な場合には重傷や死に至ることさえある。したがって、知的体を用いてより信頼性の高い知識検索を可能にする手法 Peng et al.診断知能と医療知識検索知能を組み合わせることで、診断対話知能の応答の質と精度を向上させながら、幻覚を大幅に減らすことができる可能性がある。

遠隔医療と遠隔モニタリング。

インテリジェント・ボディ・ベースのAIは、遠隔医療や遠隔モニタリングにおいても、医療へのアクセスを改善し、医療提供者と患者のコミュニケーションを改善し、医師と患者の頻繁なやり取りの効率を高め、コストを削減する大きな可能性を秘めているAmjadら(2023)。プライマリ・ケアの臨床医は、患者のメッセージや報告書、電子メールに目を通すのに多くの時間を費やしている。医師、患者、その他の医療提供者からのメッセージを分類し、すべての関係者からの重要なメッセージを強調するのに役立つインテリジェンスをサポートすることは、大きな可能性を秘めている。遠隔医療とデジタルヘルス産業は、インテリジェントな身体AIシステムが患者、臨床医、その他のAIインテリジェンスと連携できるようにすることで、多大な変革の可能性を秘めている。

6.3.1 現在の医療能力

![Agent AI: 探索多模态交互的边界-19 Agent AI: 探索多模态交互的前沿世界[李飞飞-经典必读]](https://aisharenet.com/wp-content/uploads/2025/01/bf947d200d7b021.png)

図19:ヘルスケア画像理解領域でGPT-4Vを使用した場合のキューと応答の例。左から右へ:(1)看護師と医師が行ったCTスキャンの画像、(2)不規則な心電図スキャンの合成画像、(3)ISIC Codellaら(2018)の皮膚病変データセットからの画像。GPT-4Vは実質的な医療知識を持ち、医療画像について推論できることがわかる。しかし、セキュリティトレーニングのため、特定の医療画像を診断することができない。

![Agent AI: 探索多模态交互的边界-5 Agent AI: 探索多模态交互的前沿世界[李飞飞-经典必读]](https://aisharenet.com/wp-content/uploads/2025/01/f4fe292eb01627a.png)

図20:ヘルスケアビデオ理解領域でGPT-4Vを使用した場合のキューと応答の例。GPT-4Vは、2x2のグリッドで動画を入力し、フレームの順序を示すテキストを重ね合わせた。最初の2つの例では、GPT-4Vにビデオ内のフレームを調べさせ、ボランティア患者に行われたベッドサイドでの臨床活動を検出した。最後の例では、GPT-4Vに心エコービデオを評価するよう促したが、GPT-4Vの安全教育のため、詳細な回答は得られなかった。わかりやすくするため、関心のある活動を説明するテキストを太字で強調し、不必要なモデル回答は省略した。プライバシー保護のため、個人の顔はグレーアウトした。

イメージの理解。

GPT-4Vのような最新のマルチモーダルインテリジェンスのヘルスケアにおける現在の能力と限界を図19に示す。GPT-4Vは、病院ケアに関わる機器や手順に関する多くの内部知識を持っていますが、ユーザーからの処方的または診断的な問い合わせには必ずしも応答しないことがわかります。

ビデオの理解力

我々は、医療ビデオ理解における視覚言語モデル(VLM)知能のパフォーマンスを2つの文脈で調査した。第一に、視覚言語モデル(VLM)知能が臨床空間における重要な患者ケア活動を認識する能力を調査した。第二に、超音波検査などのより専門的なビデオへの視覚言語モデル(VLM)の適用を検討した。具体的には、図20に示すように、GPT-4Vの病院ケアと医療ビデオ解析における現在の能力と限界を示す。

6.4 マルチモーダルな知性

![Agent AI: 探索多模态交互的边界-18 Agent AI: 探索多模态交互的前沿世界[李飞飞-经典必读]](https://aisharenet.com/wp-content/uploads/2025/01/bc374a02016c66a.png)

図21:対話型マルチモーダルインテリジェンスは、対話、音声、視覚、言語の4つの柱で構成される。1) インタラクション・サービスは、自動化された操作、認知、意思決定のための統一プラットフォームの開発を支援する。3) ビジョン・サービスは、画像、ビデオ、デジタルインクのコンテンツを識別、分析する。

複雑なマルチモーダルAI知能の開発には、視覚と言語理解の統合が不可欠である。これには、画像キャプション付け、視覚的質問応答、ビデオ言語生成、ビデオ理解などのタスクが含まれる。我々は、このような視覚言語タスクを掘り下げ、AI知能の文脈におけるリーダーの課題と機会を探求することを目的とする。

6.4.1 画像言語理解と生成

画像言語理解とは、与えられた画像の視覚的内容を言語的に解釈し、関連する言語的説明を生成するタスクである。このタスクは、より人間に近い方法で世界と対話できるAI知能を開発する上で極めて重要である。最もポピュラーなタスクには、画像のキャプション付け Linら(2014)、Sharmaら(2018)、Youngら(2014)、Krishnaら(2016)、指の表現 Yuら(2016)、Karpathyら(2014)、視覚的質問応答Antolら(2015);Renら(2015);Singhら(2019)。

近年、OKVQA Marinoら(2019)、KB-VQA Wangら(2015)、FVQA Wangら(2017)、WebQA Changら(2021)などの知識集約型視覚質問応答タスクが導入されている。マルチモーダル知能は、画像内の物体を認識し、それらの空間的関係を理解し、シーンに関する正確な説明文を生成し、推論スキルを使用して知識集約的な視覚推論を処理できる必要があります。これには、物体認識能力だけでなく、空間的関係、視覚的意味論、これらの視覚的要素を世界知識を持つ言語構造にマッピングする能力についての深い理解も必要である。

6.4.2 映像と言語の理解と生成

ビデオ言語世代。

ビデオ字幕やビデオストーリーテリングは、一連のビデオフレームに対して首尾一貫した文章を生成するタスクである。ビデオや言語タスクで使用されるリカレント大規模ベースモデルの成功に触発され、インテリゲンサ駆動拡張モデルの変形がビデオ言語生成タスクで有望な結果を示す。基本的な課題は、ニューラル・エンコーダ・デコーダ・モデルのロバスト性が、ビジュアル・ストーリーテリングにはうまく働かないことである。この分野における重要な目標は、一連のフレームを効率的に符号化し、テーマ的に首尾一貫した複数文の段落を生成できる、インテリジェントな身体認識テキスト合成モデルを作成することである。

ビデオの理解力

ビデオ理解は、画像理解の範囲を動的なビジュアルコンテンツに拡張する。これには、ビデオ内の一連のフレームを解釈し、推論することが含まれ、多くの場合、付随する音声やテキスト情報と連動している。インテリジェン トは、ビデオコンテンツの高度な理解を示すために、ビジュアル、テキスト、オーディオなど、さまざまなモダリティを使用することができます。この分野のタスクには、ビデオキャプション、ビデオ質問応答、アクティビティ認識などがある。ビデオ理解におけるリーダーの課題は多面的である。映像コンテンツと言語コンテンツの時間的整合、長い連続フレームの処理、時間経過とともに展開する複雑な活動の解釈などである。音声に関しては、インテリゲンチアは話し言葉、背景雑音、音楽、イントネーションを処理し、ビデオコンテンツの雰囲気、設定、ニュアンスを理解することができる。

これまでの研究では、オンラインで入手可能な既存のビデオ言語学習データを利用して、ビデオベースモデルを構築することに焦点が当てられてきた。 Li et al. (2020, 2021b); Fu et al. (2022); Bain et al. (2021); Zellers et al. (2021, 2022); Fu et al. (2023).しかし、このような学習プロセスや機能をサポートすることは、これらのデータセットが限定的であり、しばしば一貫性がないため困難である。ビデオベースモデルは、マスクとコントラストの事前学習目標を用いて設計され、その後それぞれのタスクに適応される。マルチモーダルベンチマークで優れた結果を示しているにもかかわらず、これらのモデルは、ノイズの多い音声トランスクリプトから構築された限られたビデオテキストデータに依存しているため、行動認識のようなビデオのみのタスクで苦戦している。この制限はまた、一般的に大規模な言語モデルに備わっているロバスト性ときめ細かな推論スキルの欠如につながる。

他のアプローチは、画像言語理解で使用されるものと同様、ビデオ解釈のさまざまな側面を改善するために、大規模な言語モデルの強力な推論スキルと広範な知識を利用します。映像理解のタスクは、ChatGPTやGPT4のような言語のみのモデルや、GPT4-Vのような画像言語モデルによって単純化される。これらのモデルは、音声、映像、言語モダリティを別々の解釈可能な入力データ型として扱い、インテリゲンチャを強力なオープンソースモデルとして位置づける。例えば、Huang ら(2023c)、Li ら(2023g)は、オープンソースの視覚分類/検出/サブタイトリングモデルを使用してビデオコンテンツをテキスト化することにより、ビデオ理解を自然言語処理(NLP)の質問応答式に変換しています。Linら(2023)は、GPT4-Vを視覚、音声、スピーチの専用ツールと統合することで、長編動画におけるキャラクターの動作や操作のスクリプト化など、複雑な動画理解タスクを容易にする。

並行して行われた研究では、大規模なモデルからスケーリングされたデータセットを生成し、生成されたデータに視覚的な指示調整を適用することが検討された Liu et al.その後、多数の音声、発話、視覚の専門家の知覚モデルを用いて映像を表現した。音声は自動音声認識ツールを使って書き起こされ、映像の説明と関連データは、さまざまなラベリング、ポジショニング、キャプションモデルを使用して生成された。これらの技術は、生成されたデータセット上でビデオ言語モデルの命令を適応させることで、ビデオ推論とコミュニケーション能力を強化できることを示している。

6.4.3 実験と結果

- 知識集約型モデル: INK Parkら(2022)やKAT Guiら(2022a)で紹介されているように、人間の注釈に必要な知識を組み合わせて、知識集約的な検索タスクをサポートする集約的神経知識タスク。

- マルチモーダルな知性: Chameleon Luら(2023)やMM-React Yangら(2023c)のようなマルチモーダル言語モデルへの関心が高まっている。

- 視覚的なコマンドの調整: VCL Guiら(2022b)、Mini-GPT4 Zhuら(2023)、MPLUG-OWL Yeら(2023b)、LSKD Parkら(2023c)による画像レベルの命令調整データセットの生成。

![Agent AI: 探索多模态交互的边界-12 Agent AI: 探索多模态交互的前沿世界[李飞飞-经典必读]](https://aisharenet.com/wp-content/uploads/2025/01/4ddf9cd541df9e2.png)

図22: Intensive Neural Knowledge (INK)の例 Parkら(2022)のタスクは、テキスト候補の集合から画像関連テキストを識別するために知識を利用する。我々のタスクでは、ウェブから取得した視覚的・テキスト的知識と、手動で注釈を付けた知識を利用する。

知識集約型知能。

図22と図23に示すように、知識ベースの視覚的質問応答と視覚言語検索タスクは、画像コンテンツ以外の外部知識を必要とするマルチモーダル機械学習における挑戦的なタスクである。大規模Transformerに関する最近の研究は、主にモデルパラメータに関する情報を格納する効率を最大化することに焦点を当てている。この一連の研究は、マルチモーダルTransformerがその意思決定プロセスにおいて明示的な知識を利用できるかどうかという、異なる側面を探求している。Transformerに基づく事前学習法は、複数のモダリティにまたがる知識表現を暗黙的に学習することに優れた成功を示している。しかしながら、従来のアプローチ(主に単一モダリティ)では、主に知識検索とそれに続く解答予測について研究されており、検索された知識の質と関連性、また暗黙知と明示知の両方を用いた推論プロセスの統合について疑問が投げかけられている。これらの問題に対処するために、我々は、2022 OK-VQAオープンドメインマルチモーダル課題において他のモデルを6%上回ったKnowledge Augmentation Transformer (KAT)を導入する。KATは、エンコーダ・デコーダアーキテクチャを使用して、GPT3からの暗黙的知識とウェブサイトからの明示的知識を組み合わせ、回答生成時に両方の知識タイプを使用できるようにする。KATは、GPT3からの暗黙的知識とウェブサイトからの明示的知識をエンコーダ-デコーダ・アーキテクチャを用いて組み合わせ、解答生成時に両方の知識を同時に使用することを可能にする。さらに、明示的な知識を組み合わせることで、モデル予測の解釈可能性が向上します。コードと事前学習済みモデルはhttps://github.com/guilk/KAT。

![Agent AI: 探索多模态交互的边界-6 Agent AI: 探索多模态交互的前沿世界[李飞飞-经典必读]](https://aisharenet.com/wp-content/uploads/2025/01/f55f9a766b54ffb.png)

図23:KATモデル Guiら(2022a)は、対比学習ベースのモジュールを使用して、明示的知識ベースから知識エントリを取得し、GPT-3を使用して、裏付け証拠を持つ暗黙的知識を取得する。知識の統合はそれぞれのエンコーダTransformerによって処理され、回答生成はエンドツーエンドの訓練と推論モジュールとデコーダTransformerによって共同で実行される。

![Agent AI: 探索多模态交互的边界-21 Agent AI: 探索多模态交互的前沿世界[李飞飞-经典必读]](https://aisharenet.com/wp-content/uploads/2025/01/9d1c815ede9bca7.png)

図24:VLCモデルの一般的なアーキテクチャ Gui et al.我々のモデルは3つのモジュールから構成される。(2)マルチモーダル・エンコーダー。12層のViT Dosovitskiyら(2021)をMAE Heら(2022)(ラベルなしImageNet-1K)から初期化したものをバックボーンとして用いる。事前学習時にのみ使用される、マスクされた画像・言語モデリングと画像・テキストマッチングにより、マルチモーダル表現を学習する。下流タスクのマルチモーダルエンコーダを微調整するために2層MLPを使用する。重要なのは、マスク画像モデリングが、視覚トランスフォーマーの初期化だけでなく、事前学習の第2段階においても重要であるということである。

視覚言語 変容知性

次に、「キャプションからの視覚言語変換器の学習」(Training Visual Language Transformer from Captions)(VLC)モデルGuiら(2022b)を紹介する。VLCは、画像埋め込みに単純な線形射影層のみを用いるが、VLCは、オブジェクト検出器や教師ありCNN/ViTネットワークに依存する他の手法と比較して、様々な視覚言語タスクにおいて競争力のある結果を達成する。VLCは、物体検出器や教師ありCNN/ViTネットワークに依存する他の手法と比較して、様々な視覚言語タスクにおいて競争力のある結果を達成する。広範な分析を通じて、視覚言語変換知能としてのVLCの可能性を探る。例えば、VLCの視覚表現がImageNet-1Kの分類に非常に有効であることを示し、VLCが画像チャンクと対応するテキストトークンを正確にマッチングできることを視覚化により確認する。学習データの追加による性能のスケーリングは、大規模で弱教師付き、オープンドメインの視覚言語モデルを開発する大きな可能性を強調している。

6.5 ビデオ言語実験

ビデオ理解のために事前に訓練された画像大言語モデル(LLM)を使用することの有用性を理解するために、我々はビデオキャプション生成のためにInstructBLIP Dai et al.具体的には、InstructBLIPの視覚コーダー(EVA-CLIP-G Sunら(2023b))をFrozen in Time Bainら(2021)と同じセグメント化された時空間注意スキームを用いて拡張し、学習中のQ形成器とラージ言語モデル(LLM)を維持した(Flan-T5-XLChungら(2022))を凍結した。視覚コーダーのすべての空間レイヤーをフリーズさせ、一方、キャプション学習中の時間レイヤーはフリーズさせない。これにより、我々のモデルは画像や動画を入力とすることができる(InstructBLIPの画像レベルの性能と一致する)。我々はWebVid10M Bainら(2021)の500万のビデオキャプションのサブセットで学習した。図25に2つの出力例を示す。しかし、既存の知能では、ビデオコンテンツの正確できめ細かい視覚的詳細を完全に理解することはできない。視覚的コマンドの微調整手法は、マルチモーダルモデルやインテリジェンスが対処すべき一般的な人間レベルの知覚能力を欠いているという点で、同様の限界に苦しんでいる。

![Agent AI: 探索多模态交互的边界-14 Agent AI: 探索多模态交互的前沿世界[李飞飞-经典必读]](https://aisharenet.com/wp-content/uploads/2025/01/2436f23b98933a7.png)

図25:InstructBLIPのビデオ微調整バリアント(セクション6.5で説明した方法)を使用した場合のキューと回答の例。我々のモデルはシーンを説明する長いテキスト応答を生成することができ、ビデオ内のイベントの時間性に関連する質問に答えることができる。

コマンド微調整モデルは、図25に示すように、映像に見える行動を正確に要約し、「ベンチに座る人」などの行動を効果的に識別することに有望である。しかし、「カメラに向かって微笑む人」のような誤った詳細が追加されることもあり、対話のテーマやビデオの雰囲気など、人間の観察者には明らかな要素を捉えることができないという欠点が明らかになった。この欠点は、もう一つの重要な限界を浮き彫りにしている。それは、文脈を通じて映像の理解を豊かにし、より正確な解釈を助け、このような誤認を防ぐ音声や音声モダリティの省略である。このギャップを埋めるには、利用可能なモダリティを総合的に統合し、マルチモーダルインテリジェンスが人間の知覚と同様の理解レベルを達成できるようにし、ビデオ解釈への完全なマルチモーダルアプローチを確保する必要がある。

GPT-4Vベースの音声-映像-言語知能。

![Agent AI: 探索多模态交互的边界-5 Agent AI: 探索多模态交互的前沿世界[李飞飞-经典必读]](https://aisharenet.com/wp-content/uploads/2025/01/45dd597f5ea7d9d.png)

図26:セクション6.5で説明したオーディオ・マルチモーダルインテリジェンス。錯覚コンテンツは赤でハイライトされている。GPT-4Vを使用して、1)ビデオフレームを含むビデオチャット要約、2)フレームキャプションを含むビデオ要約、3)フレームキャプションと音声情報を含むビデオ要約を生成した。

![Agent AI: 探索多模态交互的边界-7 Agent AI: 探索多模态交互的前沿世界[李飞飞-经典必读]](https://aisharenet.com/wp-content/uploads/2025/01/c54bf06463fbace.png)

図27:ビデオ理解のために視覚、音声、テキストモダリティを組み合わせた対話型マルチモーダル知能。我々のプロセスは、VideoAnalyticaチャレンジのための難解なクエリを生成するために、難解な負のイリュージョンをマイニングする。Interactive Audio-Video-Language Intelligentsiaデータセットの詳細については、セクション9.2を参照。

次に、Lin et al. (2023)に概説されたアプローチに従って、映像を詳細かつ正確に理解するために、視覚、音声、発話を統合するマルチモーダルインテリジェンスとして動作するGPT-4Vの能力を評価する。図26に示す結果は、動画要約タスクにおける様々な動画知能の性能を比較したものである。ビデオ指示微調整モデル(Li et al., 2023g)は、正確な内容を提供するが、包括性と詳細性に欠け、ほうきを体系的に使って木の高さを測定するといった具体的な動作が省かれている。

映像の説明の精度を高めるため、GPT-4Vを使用してフレームに字幕を付け、音声とその書き起こしはOpenAIを使用しています。 ウィスパー モデル次に、GPT-4Vにフレームのみのキャプションを使用してビデオ要約を作成させ、次にフレームのみのキャプションと音声の書き起こしを行った。当初、フレームのみのキャプションでは、3番目のセグメントで誰かが棒を噛むなど、架空の事象が生じることが観察された。このような不正確さは、「面白いひねりを加えて、彼は棒を水平に持ちながら棒を噛んだ」というような説明のように、ビデオの要約にも残りました。音声入力がないと、知能はこのような字幕の誤りを修正することができず、意味的には正しいが視覚的には誤解を招く説明になってしまう。

しかし、インテリジェント・ボディに音声トランスクリプションを提供すると、内容を正確に描写し、「ほうきを体に対して垂直に、下に回転させる」といった細かい体の動きまで捉えることができる。このレベルの詳細な情報は、視聴者がビデオの目的や重要な詳細をより明確に理解することを可能にする。これらの発見は、質の高いマルチモーダルインテリジェンスを発達させるためには、音声、映像、言語によるインタラクションを統合することが重要であることを強調しており、GPT-4Vはそのような高度なマルチモーダル理解とインタラクションのための有望な基盤となっている。

GPT-4Vに基づく具現化されたマルチモーダルインテリジェンス。

図27に示すように、主にStackOverflowを使用して最初の質問を取得し、次に「Bing search」APIを使用して質問に関連するビデオとオーディオを取得する。次に、主にGPT-4Vを使用して、関連するテキスト情報と高レベルのビデオ説明を取得します。一方、ASRを使用して、キーフレームの音声をキーフレームの低レベルフラグメント記述に変換します。最後に、GPT-4Vを用いて、ビデオクイズの難易度の高いネガティブクエリとして使用できる、説得力のある「錯覚」を生成する。我々は、ビデオの現在のフレームでの対話とクイズをサポートするだけでなく、全体的な高レベルのビデオ記述を要約する。推論過程では、Web検索によって得られた外部知識も取り入れ、解答を改善する。

GPT-4Vの主なプロンプトについて説明します。プロンプト全体をわかりやすくするために字下げしてあります。

GPT-4Vは、映像を見ることはできても聞くことができない視覚障害者のために、映像の説明的で有益かつ包括的な詳細を提供するように設計されたアシスタントである。この作業は、与えられた注釈を合成し、JSONとして出力することで、高品質で高密度な動画説明を作成することで行われる。具体的には、GPT-4Vは、動画を検索するために使用される元のクエリ、動画のタイトル、説明、音声転写、および動画内の特定の時間における潜在的にノイズの多い説明を提供される。同じビデオの異なるセグメントは、「[時間開始 - 時間終了(秒単位)] 'text'」としてアノテーションされる。GPT-4Vは必要に応じてタイムスタンプを組み合わせたり分割したりして、映像の最適なセグメンテーションを提供します。

GPT-4Vの出力に期待:

- アクションを重視した描写:音声による説得力のあるアクション、動き、身体的なデモンストレーションを優先し、ダイナミックな視覚的合図で物語を豊かにする。

- ビデオを完全にカバー:ビデオのすべての瞬間をカバーする連続的で一貫性のある音声説明体験を提供し、コンテンツの取りこぼしをなくします。

- 簡潔なセグメンテーション:1~2センテンスの簡潔なセグメンテーションで、視覚的なアクションを効果的に伝える。

- 文脈に沿ったオーディオビジュアル合成:言葉によるオーディオコンテンツと、推測されるビジュアル要素をシームレスに融合させ、画面上の活動を反映した物語を形成する。

- 想像力豊かでもっともらしい推測:シーンの理解を深めるために、音声に対応する独創的かつもっともらしい視覚的な詳細を描写に盛り込む。

- 正確なタイムコード対応:説明的なスニペットを対応するタイムコードに合わせることで、推定されるビジュアルの詳細がオーディオナラティブのタイムラインと同期していることを確実にします。

- 自信に満ちた語り口:聞き手に自信を持たせるために、あたかも想定されたビジュアライゼーションが起こっているかのような描写を自信をもって提示する。

- 不合理な詳細の省略:視聴覚情報によって確立された文脈に合理的に適合しない対象物や出来事の記述を除外する。

最終的な出力は、それぞれが動画のセグメントを詳細に記述した辞書のリストを含むJSON形式で構造化されなければならない。

最終的な出力は、それぞれが動画のセグメントを詳細に記述した辞書のリストを含むJSON形式で構造化されなければならない。

['start': , 'end': , 'text':""].MCの作成:我々のタスクは、タイトルを見て音声トランスクリプションに目を通すことで簡単に解くことができる、ビデオからテキストへの検索タスクのための多肢選択問題を作成することである。そのために、動画を取得するために使用された元のクエリ、説明文、音声トランスクリプション、および動画の特定の時間に関する潜在的にノイズの多い説明文を取得します。

- 音声書き起こしのフォーマット: - [開始終了時間(秒)] "Transcribe"

- うるさい説明のフォーマット: - [時間(秒)] "description"

GPT-4Vは、4つのクエリを生成するように要求する。ここで、プライマリクエリはビデオコンテンツに沿ったものであり、他の3つのネガティブクエリはプライマリクエリとは少し異なるものである。プライマリクエリの選択は、例えば、テキストのオリジナルクエリが音声トランスクリプションに含まれている場合など、単純に音声トランスクリプションを聞くだけであってはならない。ネガティブクエリは、ビデオコンテンツと密接に関連しているが、完全には一致しておらず、区別するためにビデオの視覚的な理解が必要である。例えば、元のクエリを選択するために、ただ聞くのではなく、ビデオを見る必要があるように、微妙な方法でセマンティクスを変更する。4つのクエリを字幕のようなステートメントにまとめる。

ビデオの情報を使って否定的な発言をする方法を段階的に考える。そして、否定的なクエリは正しくないが、それでもビデオを注意深く理解する必要がある説得力のある選択であることを証明する。そして、人間が元のクエリよりも否定的なクエリを誤って選択しない方法を。

最後に、この作業を以下の分析と4つのクエリの形で紹介する。元のクエリをどのように翻訳するか生成する必要はない。

- ビデオ分析:xxx

- クエリ:[クエリ1、クエリ2、クエリ3、クエリ4]。

- 理由:xxx

6.6 自然言語処理(NLP)のためのインテリジェンシア

6.6.1 大言語モデル(LLM)インテリジェンシア

タスクの指示を認識し、それに基づいて行動することは、何十年もの間、対話型AIと自然言語処理における基本的な課題であった。最近のディープラーニングの進歩に伴い、人間とコンピュータの協働を改善するために、これらの分野で協働することへの関心が高まっている。我々は、言語ベースの知性を向上させるための3つの具体的な方向性と、その他の方向性を明らかにする:

- ツールの使用と知識ベースからのクエリ。 この方向性は、外部の知識ベースやウェブ検索、その他の有用なツールをAI知能の推論プロセスに統合することの重要性を強調している。様々なソースからの構造化・非構造化データを活用することで、インテリジェンスは理解を深め、より正確で文脈に関連した応答を提供することができる。さらに、不慣れな状況やクエリに直面したときに、インテリジェンスが主体的に情報を求める能力を育成し、より包括的で情報に基づいた応答を保証する。例えば、Toolformer Schickら(2023)やRetrieve What You Need Wangら(2023g)がある。

- インテリジェント・ボディの推論とプランニングの向上。 インテリジェンスの推論能力と計画能力を高めることは、人間と機械の効果的な協働に不可欠である。これには、複雑なコマンドを理解し、ユーザーの意図を推測し、潜在的な将来のシナリオを予測できるモデルを開発する必要がある。これは、ReAct Yao et al.(2023a)のように、インテリジェンスに過去の行動や失敗を振り返らせたり、探索の一形態としてインテリジェンスの思考プロセスを構築したりすることで実現できる。様々な結果をモデル化し、様々な行動の結果を評価することで、知能はより多くの情報に基づき、文脈に即した意思決定を行うことができる。

- システムと人間のフィードバックの統合。 AI知能は通常、2つの主要な環境で動作することができる。1つは、自分の行動の有効性について明確なシグナルを提供する環境(システムフィードバック)、もう1つは、言葉で批評を与えることができる人間と協働する環境(人間フィードバック)である。この方向性は、例えば、知能がその戦略を改善し、エラーを修正することを可能にする適応学習メカニズムの必要性を強調している。 オートジェン Wuら(2023)にある。様々なフィードバックソースから継続的に学習し、適応する能力によって、インテリジェンスはユーザーのニーズに役立ち、一貫性を保つことができる。

6.6.2 一般的な大規模言語モデル(LLM)インテリジェンシア

知的な身体内容や自然言語を認識・理解することは、対話型AIや自然言語処理における数十年来の基本的な課題である。最近のディープラーニングの進歩に伴い、知識推論や自然言語生成のための知的身体計画や人間のフィードバックをより深く理解するために、これら2つの分野を一緒に研究することへの関心が高まっている。これらは、"AutoGen "Wuら(2023)や "Retrieve What You Need "Wangら(2023g)など、多くのHCIインテリジェンスの重要な構成要素である。

6.6.3 指示はラージ・ランゲージ・モデル(LLM)知能に従う

さらに、人間の指示に効果的に従うように訓練できるLLM知能を作り出すことは、重要な研究分野となっている。初期のモデルでは、人間のフィードバックに基づく強化学習(Reinforcement Learning Based on Human Feedback:RLHF)と呼ばれるプロセスを通じて、人間の嗜好を模倣するエージェント報酬モデルを訓練するために、人間のフィードバックを使用していた。このプロセスはInstructGPTやChatGPTのようなモデルを生成する。人間のラベリングを必要とせず、より効率的にLLM知能に従った命令を訓練するために、研究者は、人間が生成した命令/応答ペア(例:Dolly 2.0 ^5^5^Dolly 2.0 Blog Post Link)、またはLLMから自動的に導出された命令/応答ペア(例:Alpaca)でLLM知能を直接訓練する、より効率的な命令微調整法を開発しました。Taoriら(2023)。Alpacaの全体的な学習プロセスを図28に示す。

![Agent AI: 探索多模态交互的边界-28 Agent AI: 探索多模态交互的前沿世界[李飞飞-经典必读]](https://aisharenet.com/wp-content/uploads/2025/01/f2eebf3df8eb7d5.png)

図28:Alpacaモデルの学習に使用された学習スキーム Taori et al.高レベルでは、利用可能なLLMは、少数のシードタスクセットから多数の命令追従例を生成するために使用される。生成された命令追従例は、次に、基礎となるモデルの重みに利用可能なLLMに命令を微調整するために使用される。

![Agent AI: 探索多模态交互的边界-29 Agent AI: 探索多模态交互的前沿世界[李飞飞-经典必读]](https://aisharenet.com/wp-content/uploads/2025/01/4cdda6b3845c3ba.png)

図29:Logic Transformer Intelligent Bodyモデル Wangら(2023e)。我々は、論理知能にテキストと対話論理を推論する力を与え、より質の高い抽象要約を生成し、事実誤認を減らすことを可能にするために、論理推論モジュールをTransformerベースの抽象要約モデルに統合する。

6.6.4 実験と結果

会話システムやセルフフィードバックシステムの人気が高まっているにもかかわらず、これらの形態のAIは、自身の暗黙知から事実に基づいて正しい応答を生成するという点ではまだ不十分であり、推論時に応答を補強するためにウェブ検索や知識検索メカニズムなどの外部ツールを使用することが多い。この問題を解決することは、多くの現実のアプリケーションにおいて、ユーザーにとってより魅力的な体験を生み出すことにつながる。社会的な会話(例えば、InstagramやFacebookなどのソーシャルメディアプラットフォーム上)や、質問と回答のサイト(例えば、AskやQuora)において、人々は通常、一連のコメントや、議論に関連する情報や知識をウェブで検索することによって、他者と対話する。そのため、この文脈で会話のラウンドを生成するタスクは、従来のNLPモデルやタスクに導かれるだけではなく、知識の検索と獲得を反映した知的な行動を通じてダイアログを生成するために知能を使用する Peng et al.このように、NLPタスクのためのインテリジェント・インテリジェンスは、対話中に明示的な知識検索・取得ステップを追加することで、タスク記述を拡張し、応答の解釈可能性を向上させる。このようなウェブ検索と検索インテリジェンスを対話中のフィードバックとして統合することで、人間とインテリジェンスの社会的相互作用をさらに深く促進することができる。図29に示すように、我々はTransformer言語モデルに新しいモデリングパラダイムを導入している。これは、入力テキストから重要な論理構造と情報を検出・抽出し、精巧な多層階層論理投影によってそれらを入力エンベッディングに統合することで、論理構造をNLP intelligiblesとして事前に訓練された言語モデルに注入するものである。2023e)は、論理検出、論理マッピング、階層的論理投影の組み合わせを通じて、Transformer言語モデルを構築する新しいアプローチを提案した。ロジックを意識した入力埋め込み新しいモデルは、既存のすべてのTransformer言語モデルをアップグレードするために開発することができます。ロジック・トランスのパフォーマンスを一貫して向上させる。提案する論理的Transformer知能は、テキストの論理構造をより深く理解することで、ベースラインのTransformerモデルよりも一貫して優れた性能を達成する。人間のユーザーにとって、対話と情報検索の間のインテリジェンスの調整を通じて、意味のある興味深い対話を提供するためには、多くの場合、これらの側面がより重要である。このトピックでは、自然言語処理をより深く掘り下げ、LLMをよりインテリジェントにし、様々な言語中心のタスクにより適したものにするための進歩とランキングについて議論する。

オープン・ドメインの質疑応答(QA)システムは、通常、次のようなものである。検索してから読むというパラダイムがある。レトリーバーは、大規模なコーパスから関連する文章を検索するために使用される。リーダー検索された文章とオリジナルの質問に基づいて解答を生成する。Wangら(2023g)では、次のようなフレームワークによって、相互学習のためのシンプルで新しいフレームワークを提案している。ナレッジセレクターインテリジェンス向上のための中間モジュール検索してから読むスタイルのモデル性能を向上させるために、強化学習を使ってモジュールをトレーニングする。きめ細かいナレッジセレクター取り込む取得してからリーダーこのパラダイムの目標は、質問に関連する情報を保持する段落の小さなサブセットを構築することである。図30に示すように、知識セレクタの知能は、知識セレクタと読者を反復的に学習させる新しい相互学習フレームワークのコンポーネントとして学習される。知識選択インテリジェンスを最適化するために、ポリシー勾配を使用するシンプルで斬新なアプローチを採用し、読者からのフィードバックを使用して、情報が豊富なパッセージの小さなセットを選択するように訓練する。このアプローチでは、総当たり検索や手作業によるヒューリスティックの設計を避けることができ、監視のための注釈付きクエリ文書ペアを必要としない。読み手と知識セレクタの知能を反復的に訓練することで、多くの公開されたオープンドメインのQ&Aベンチマークにおいて、予測性能が向上することを示す。