DeepSeek-R1の完全版を無料で利用できるAI推論プラットフォームトップ5

過度のトラフィックとサイバー攻撃により、DeepSeekのウェブサイトとアプリが数日間アップダウンし、APIが機能していません。

以前、DeepSeek-R1 をローカルに展開する方法を共有しました (DeepSeek-R1 のローカル展開)が、一般的なユーザーは、671bのフルモデルはおろか、70bモデルでさえ動かすのが難しいハードウェア構成に制限されている。

幸いなことに、主要なプラットフォームはすべてDeepSeek-R1にアクセスできるので、フラットな代替品として試すことができる。

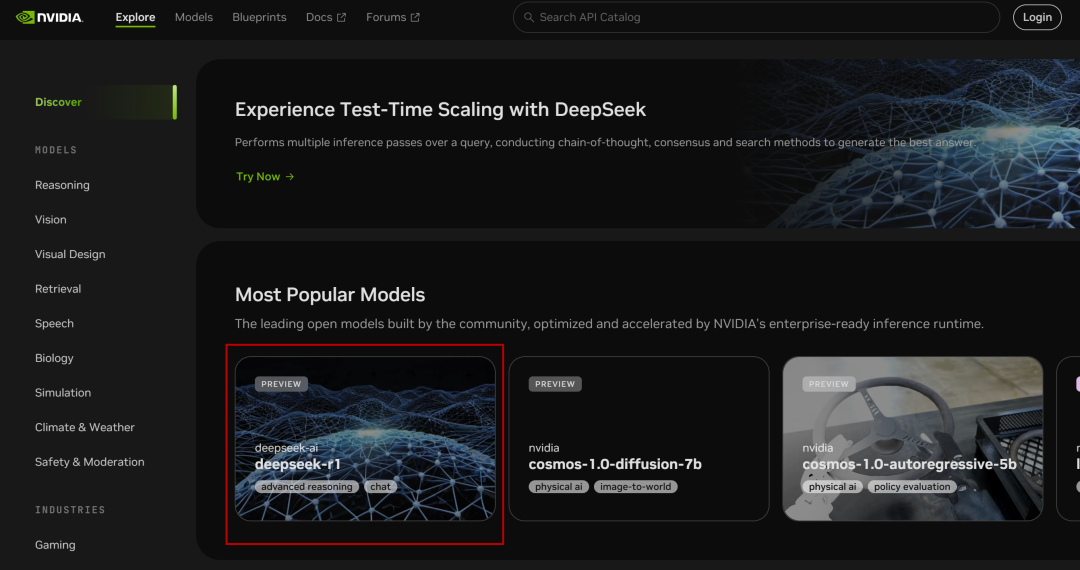

I. NVIDIA NIM マイクロサービス

NVIDIA Build:複数のAIモデルを統合し、無料で体験できる

ウェブサイト:https://build.nvidia.com/deepseek-ai/deepseek-r1

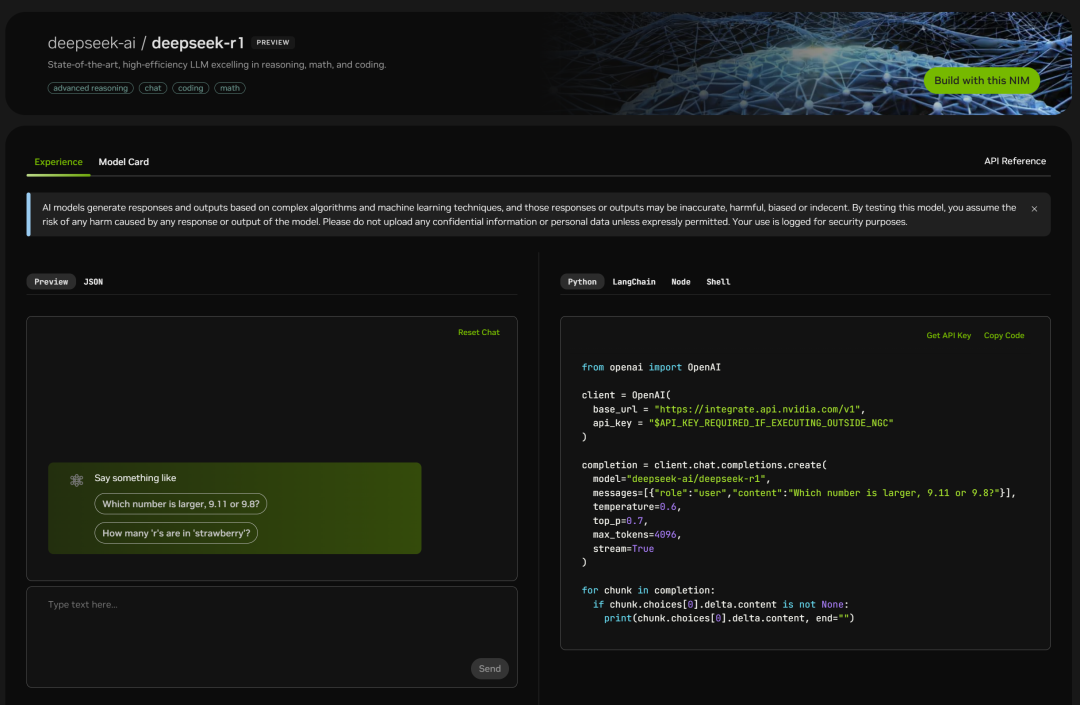

のフルボリュームパラメータ671Bを展開した。 ディープシーク-R1 モデル、ウェブ版の使い方は簡単で、クリックするとチャットウィンドウが表示される:

また、右側にはコードページも掲載されている:

テストするだけでいい:

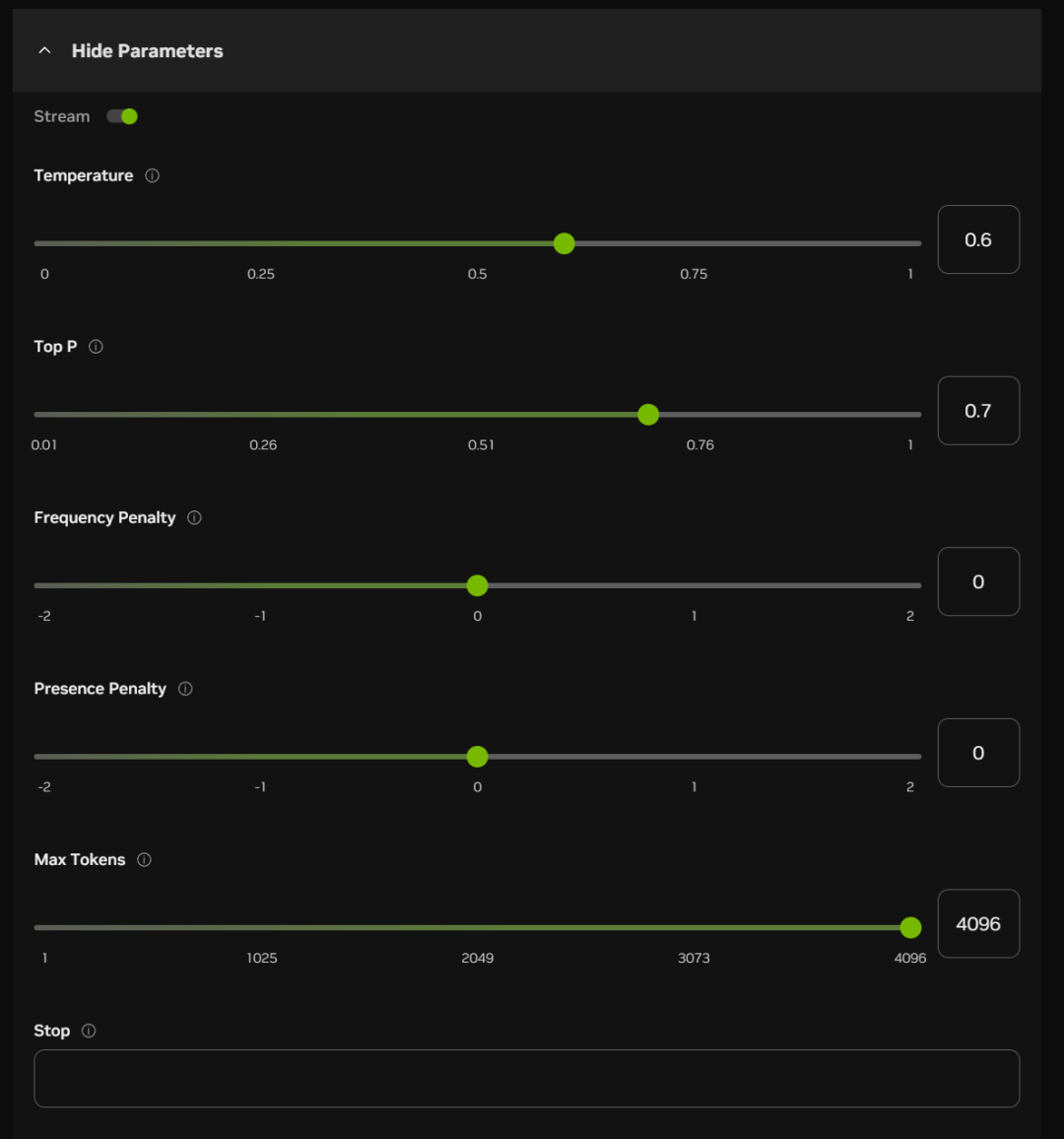

チャットボックスの下には、いくつかのパラメータ項目をオンにすることもできます(ほとんどの場合、デフォルトにすることができます):

これらのオプションのおおよその意味と機能を以下に示す:

温度だ:

値が高いほど、出力はよりランダムになり、より創造的な回答が生成される可能性がある。

トップP(核サンプリング):

高い値ほど確率的品質トークンを保持し、多様性を生み出す

回数ペナルティ:

値が高いほど、頻度の高い単語にペナルティを課し、冗長性や繰り返しを減らす。

プレゼンス・ペナルティ

この値が高いほど、モデルは新しい単語を試す傾向が強い。

最大トークン数

値が高いほど、応答の潜在的な長さは長くなる

止まれ:

特定の文字やシーケンスの生成時に出力を停止し、長すぎる生成やトピック切れを防ぐ。

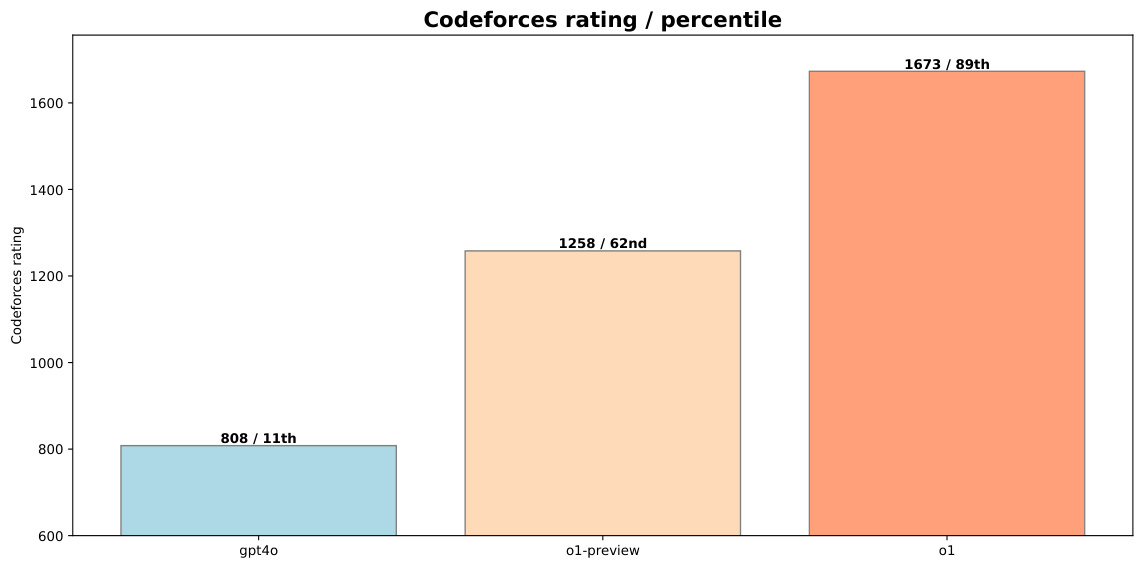

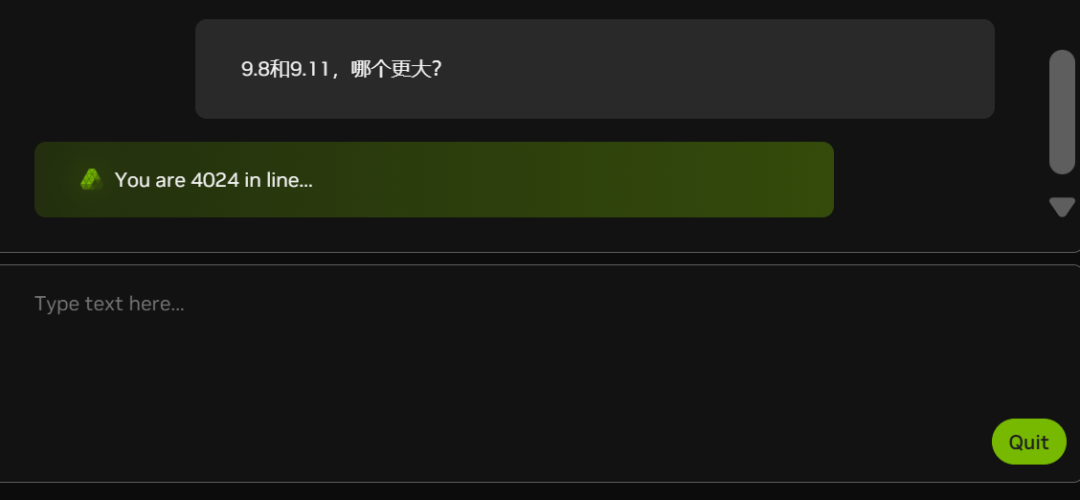

現在、白ジョンの数が増えているため(下のグラフの行列の人数を見てほしい)、NIMは一部遅れている:

エヌビディアもグラフィックカード不足?

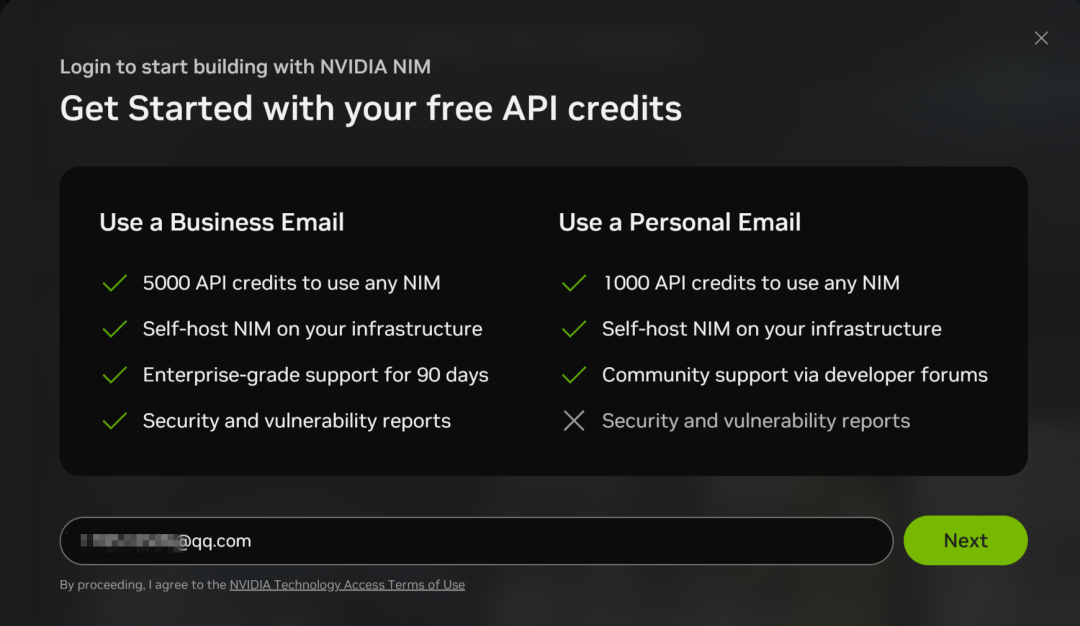

NIMマイクロサービスもDeepSeek-R1へのAPIコールをサポートしているが、電子メールアドレスでアカウントにサインアップする必要がある:

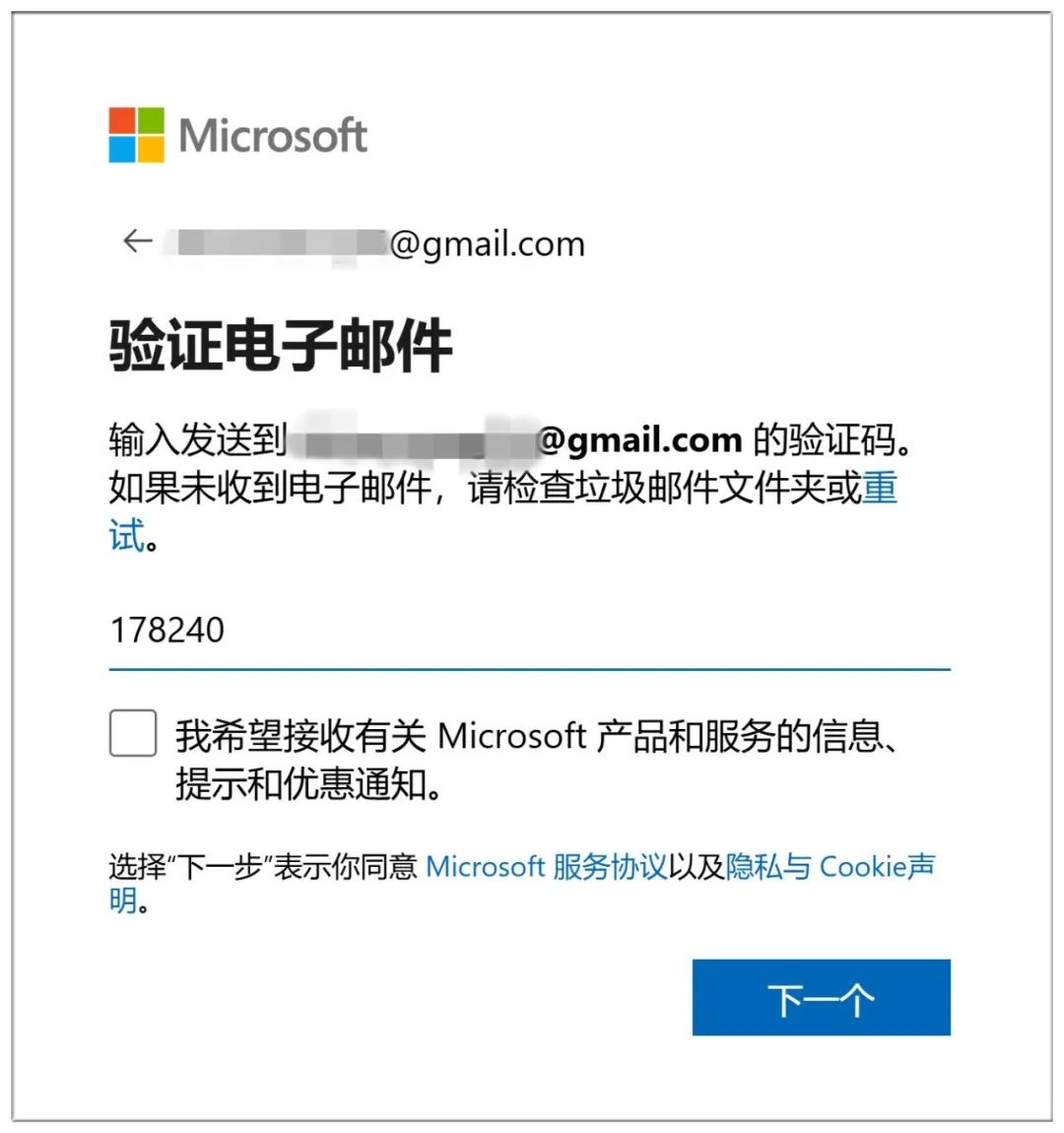

登録手続きは比較的簡単で、Eメールによる認証のみ:

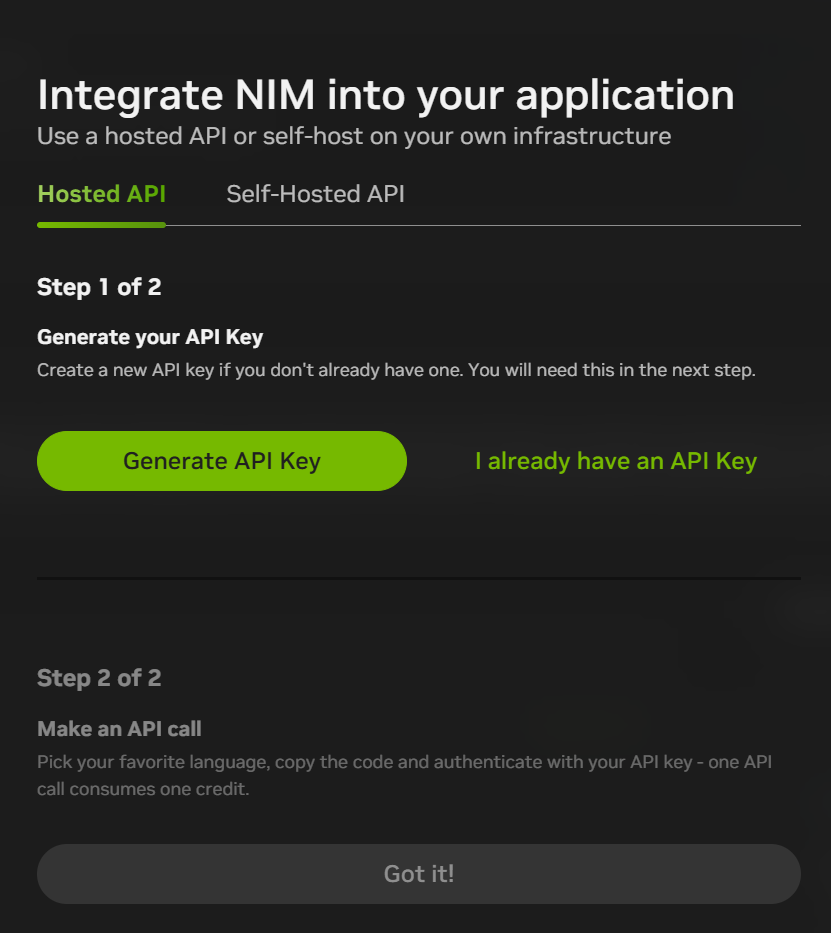

登録後、チャットインターフェースの右上にある「Build with this NIM」をクリックすると、API KEYが生成される。現在、登録すると1,000ポイント(1,000インタラクション)がもらえるので、それを使い切ってから新しいメールアドレスで再登録すればいい。

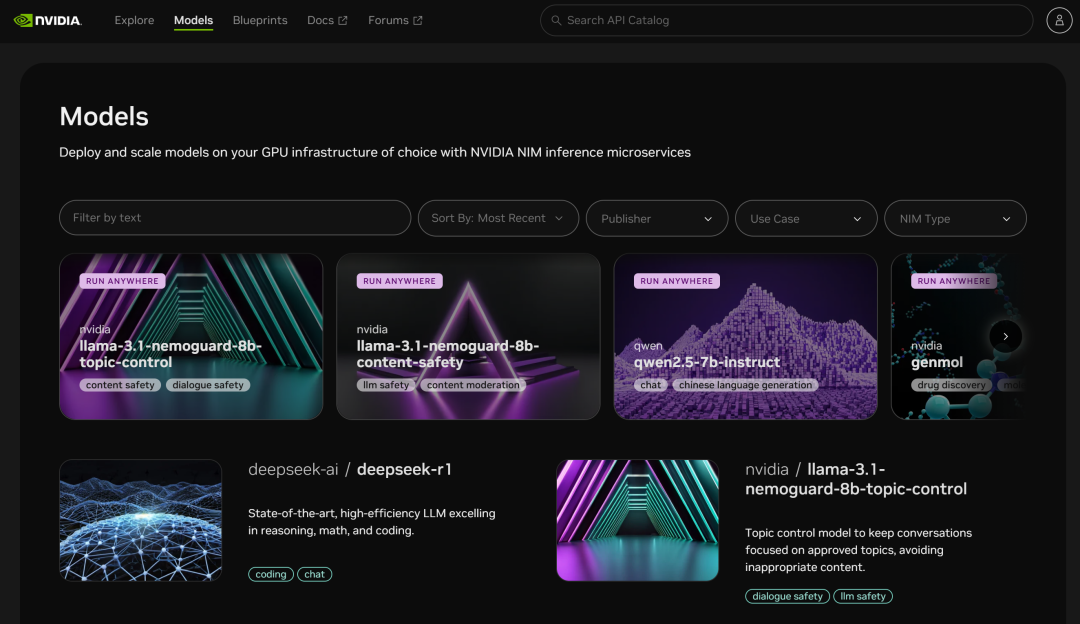

NIMのマイクロサービス・プラットフォームは、他の多くのモデルへのアクセスも提供する:

Microsoft Azure

ウェブサイト

https://ai.azure.com

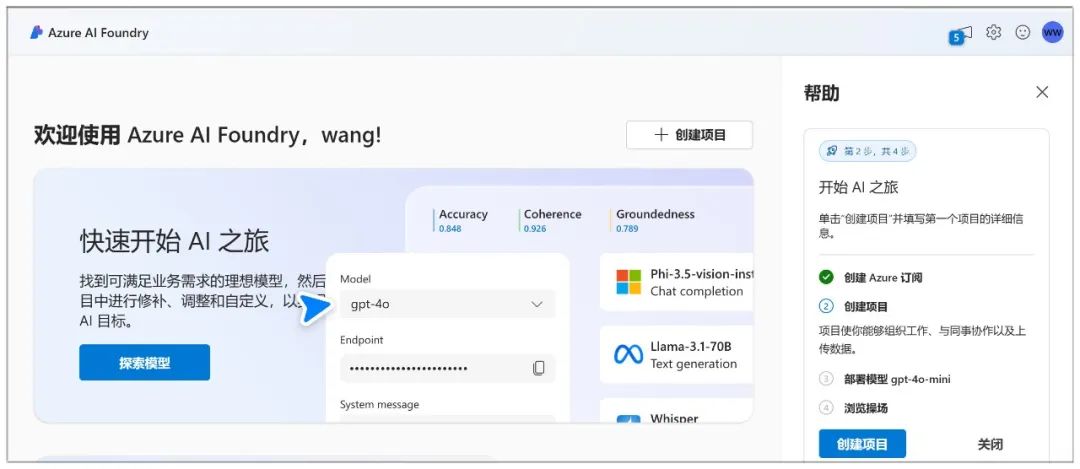

Microsoft Azureでは、チャットボットを作成し、チャットプレイグラウンドを通じてモデルと対話することができます。

Azureはサインアップが面倒で、まずマイクロソフトのアカウントを作成しなければならない(すでに持っている場合はログインするだけ):

アカウント作成にはEメール認証も必要です:

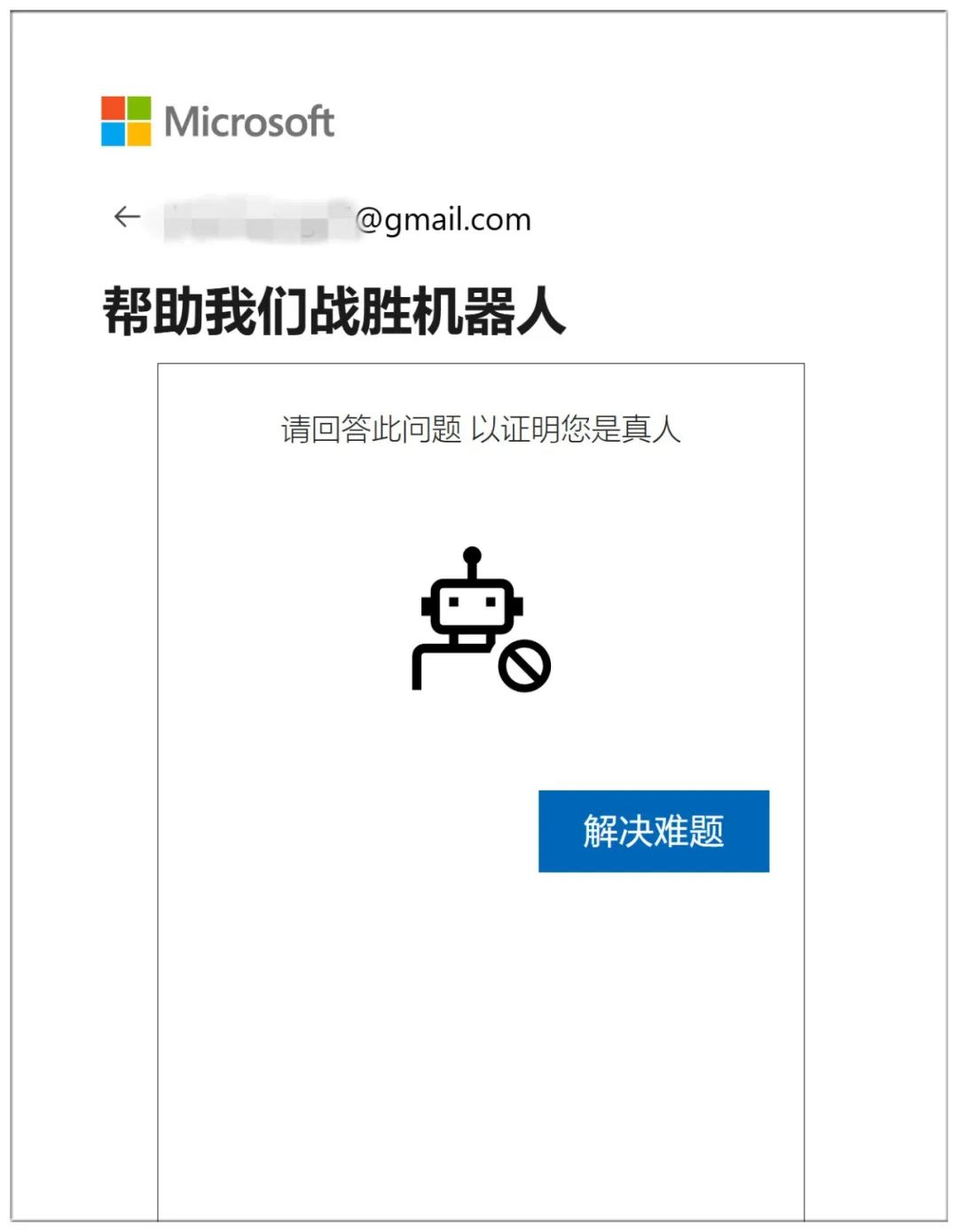

ネトゲの質問に10問連続で答えて人間であることを証明して終了:

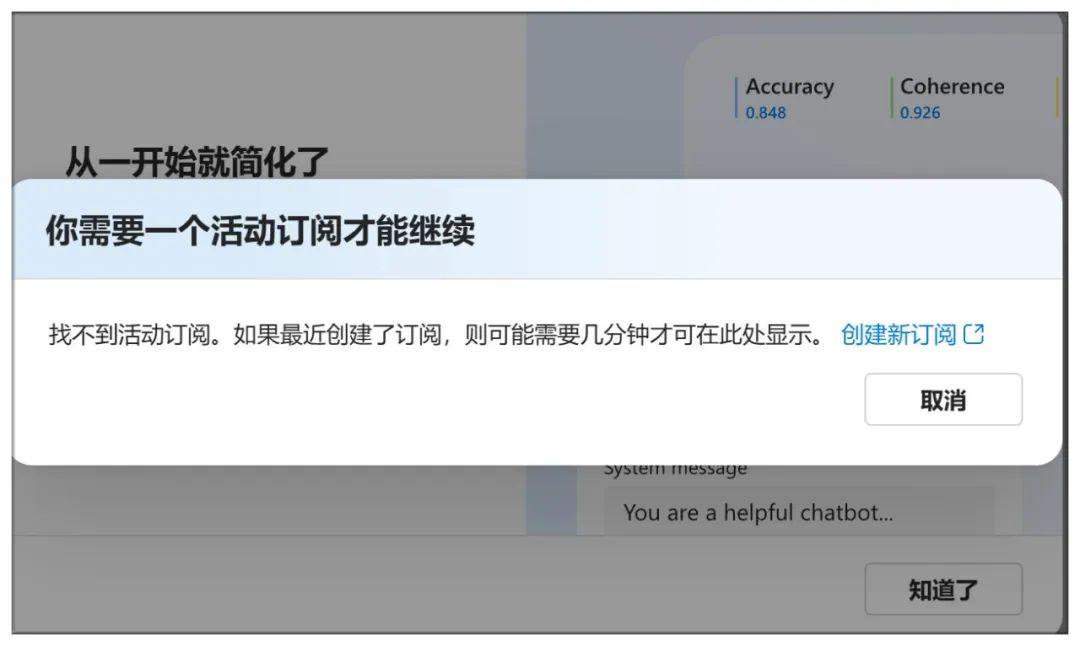

ここに来るだけでは定期購読は成立しない:

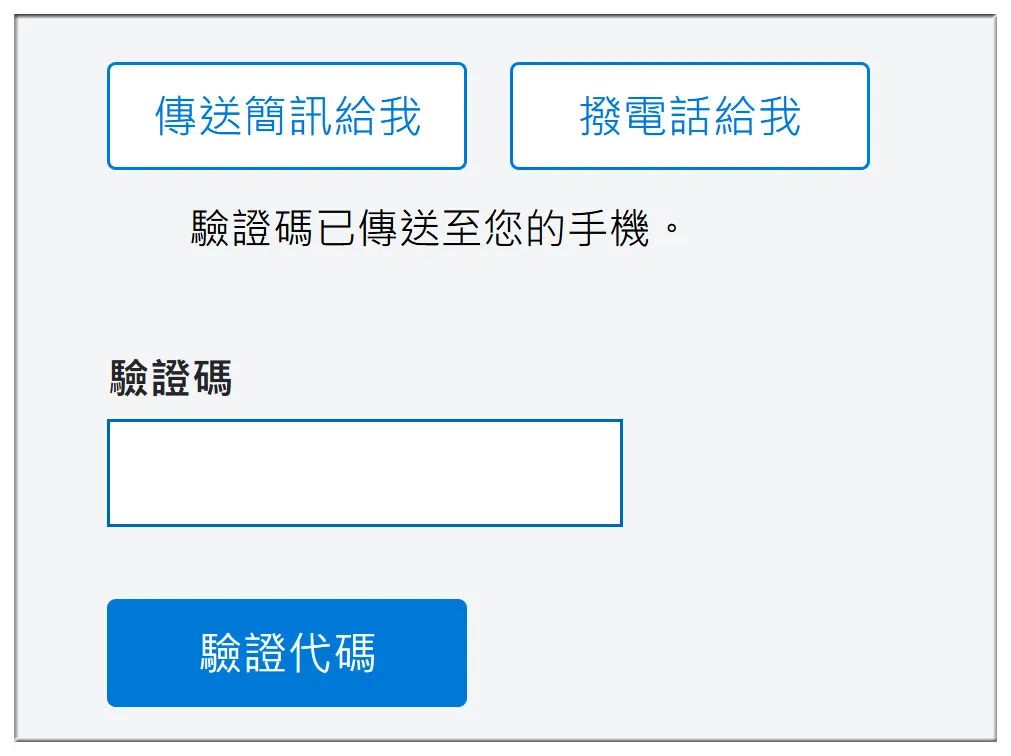

携帯電話番号だけでなく、銀行口座番号やその他の情報も確認する:

次に、"No technical support "を選択する:

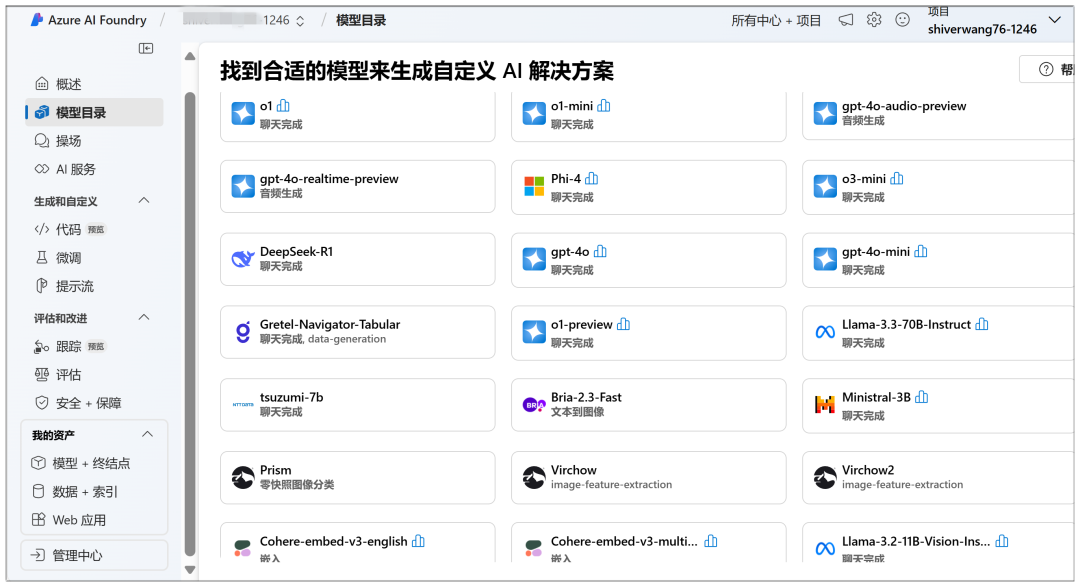

モデル・カタログ" に DeepSeek-R1 モデルが大きく表示されます:

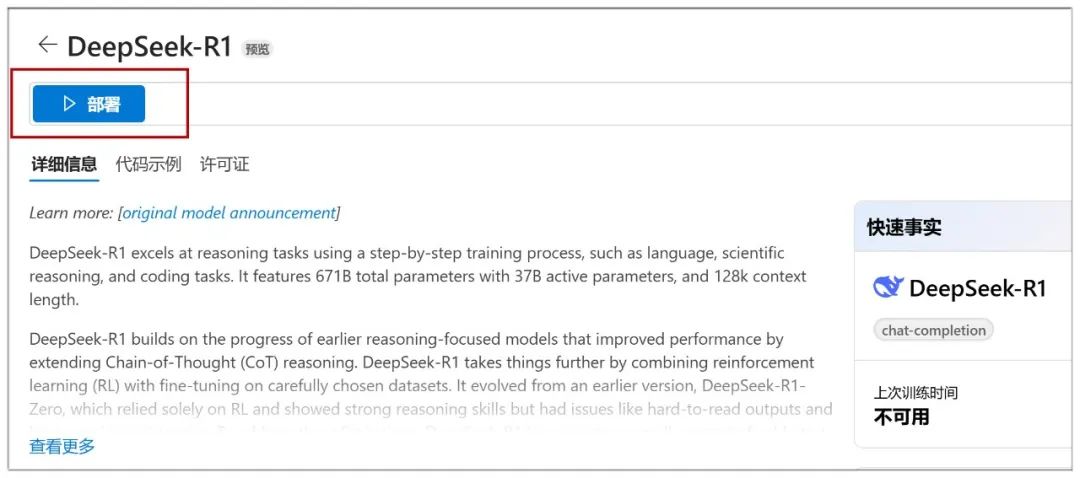

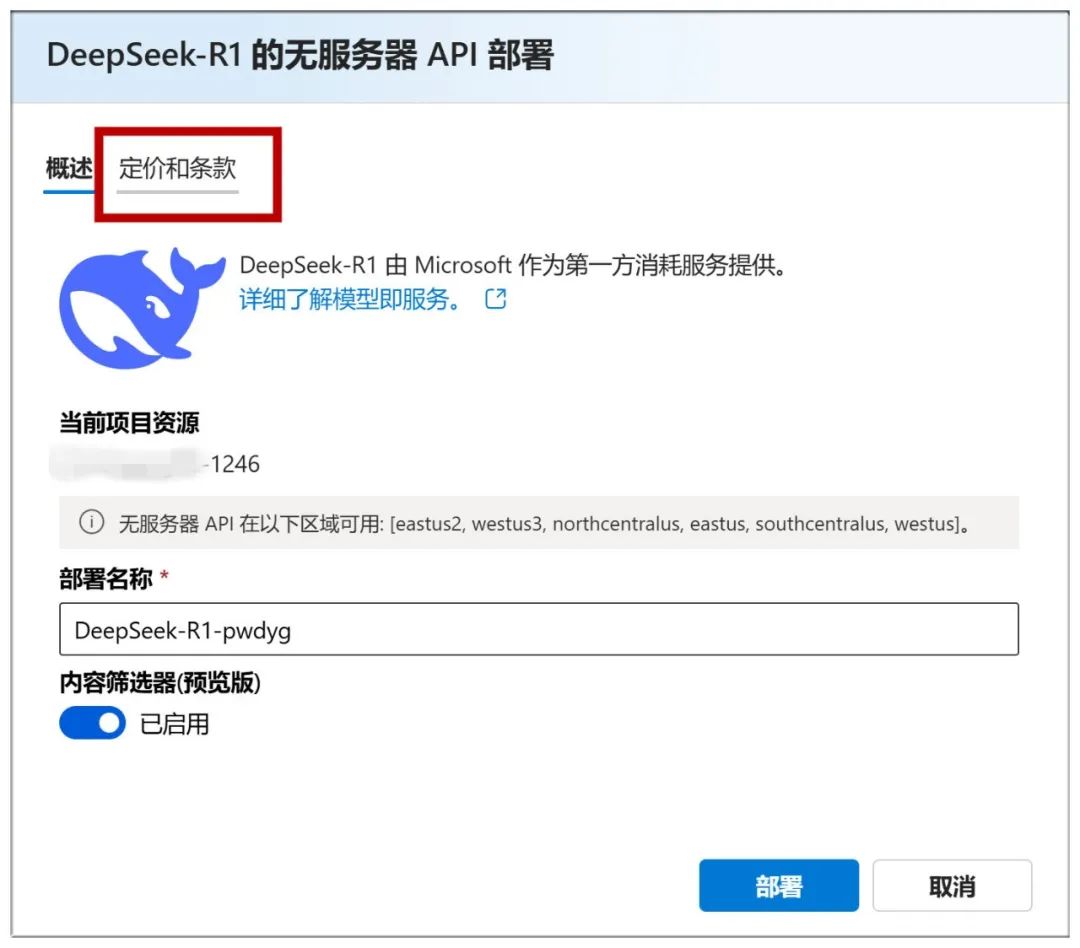

クリックしたら、次のページで「デプロイ」をクリックする:

次に、"Create new project "を選択します:

そして、すべてデフォルトにして「次へ」をクリックする:

次に「作成」をクリックする:

このページで作成が始まり、しばらく待たされる:

完了すると、このページが表示されますので、「Deploy」をクリックして次のステップに進みます:

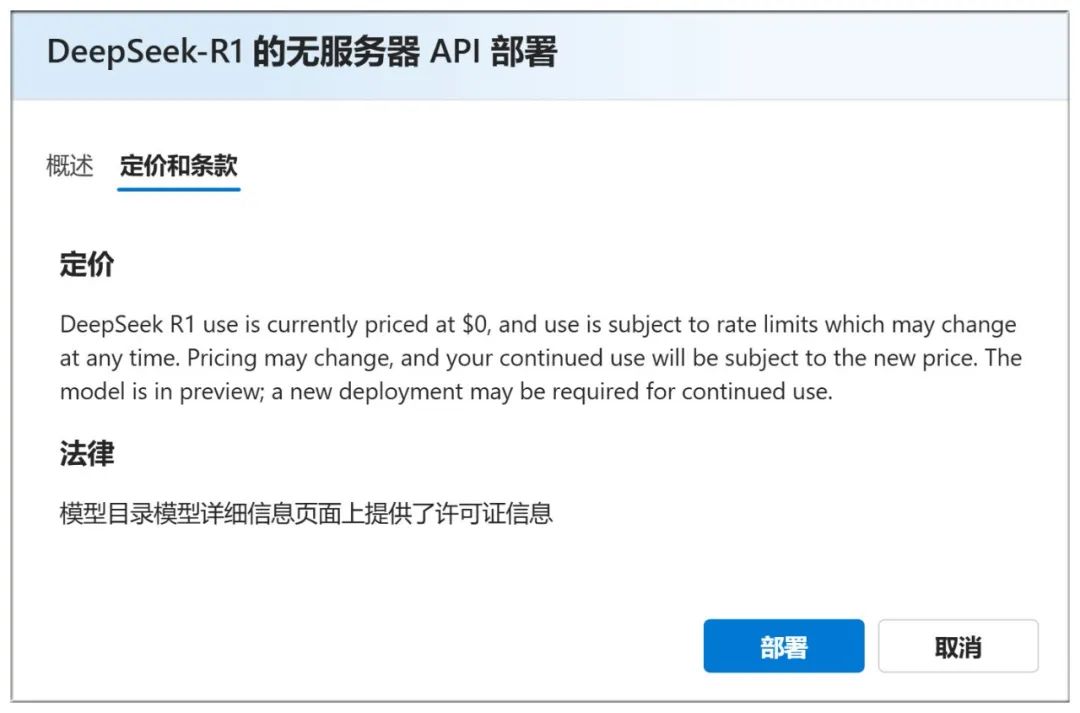

また、上記の「価格と条件」で、無料で使用できることを確認できる:

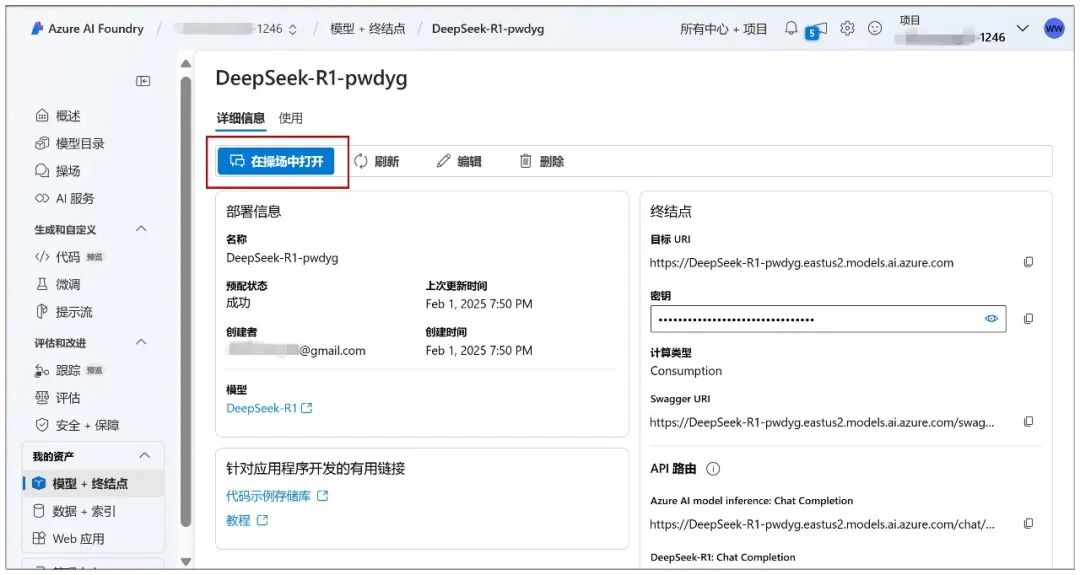

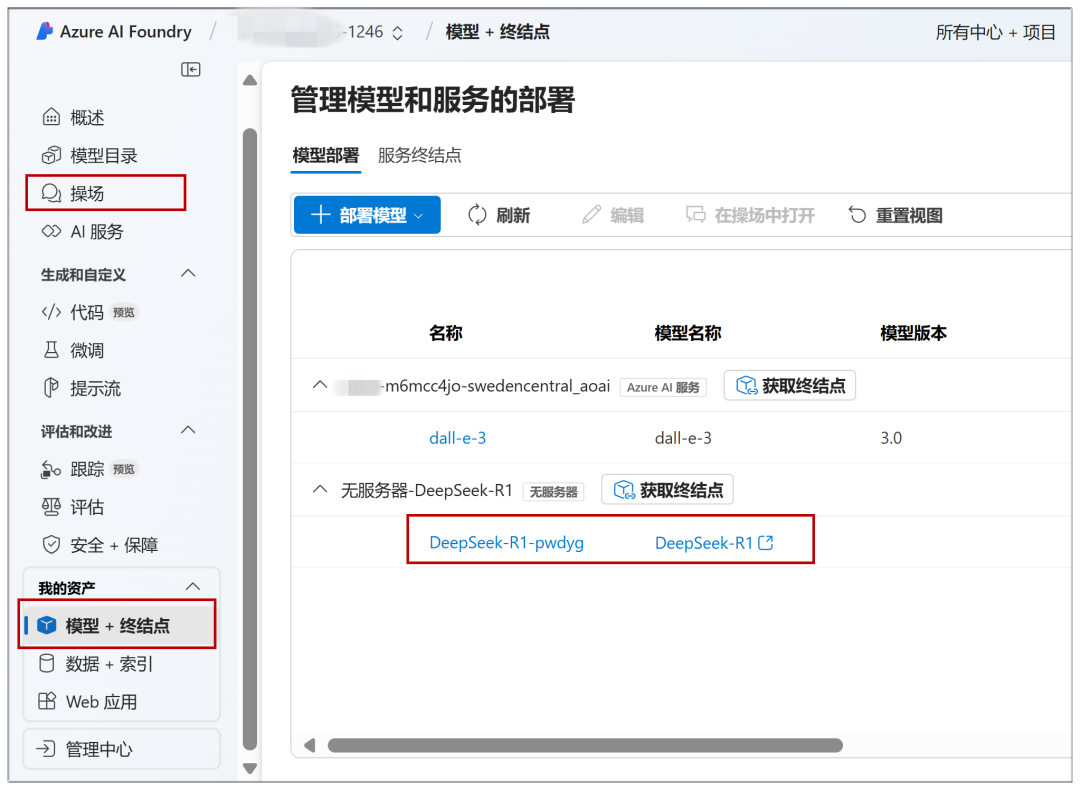

Deployment "をクリックしてこのページに進み、"Open in Playground "をクリックしてください:

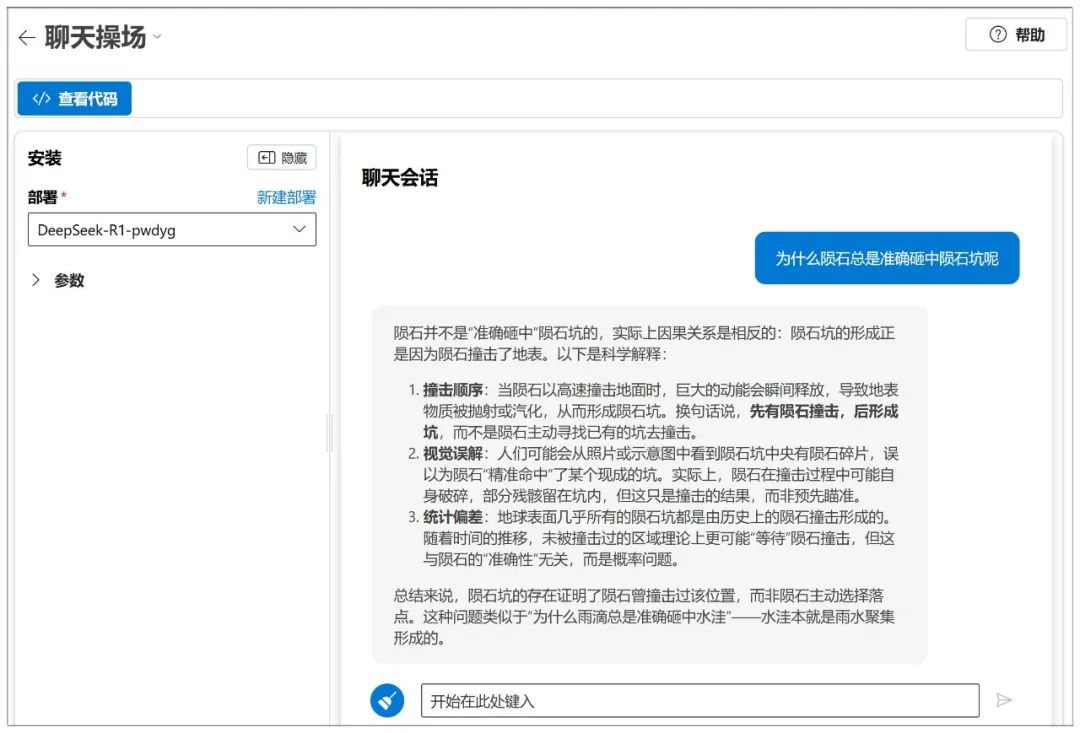

それから対話が始まる:

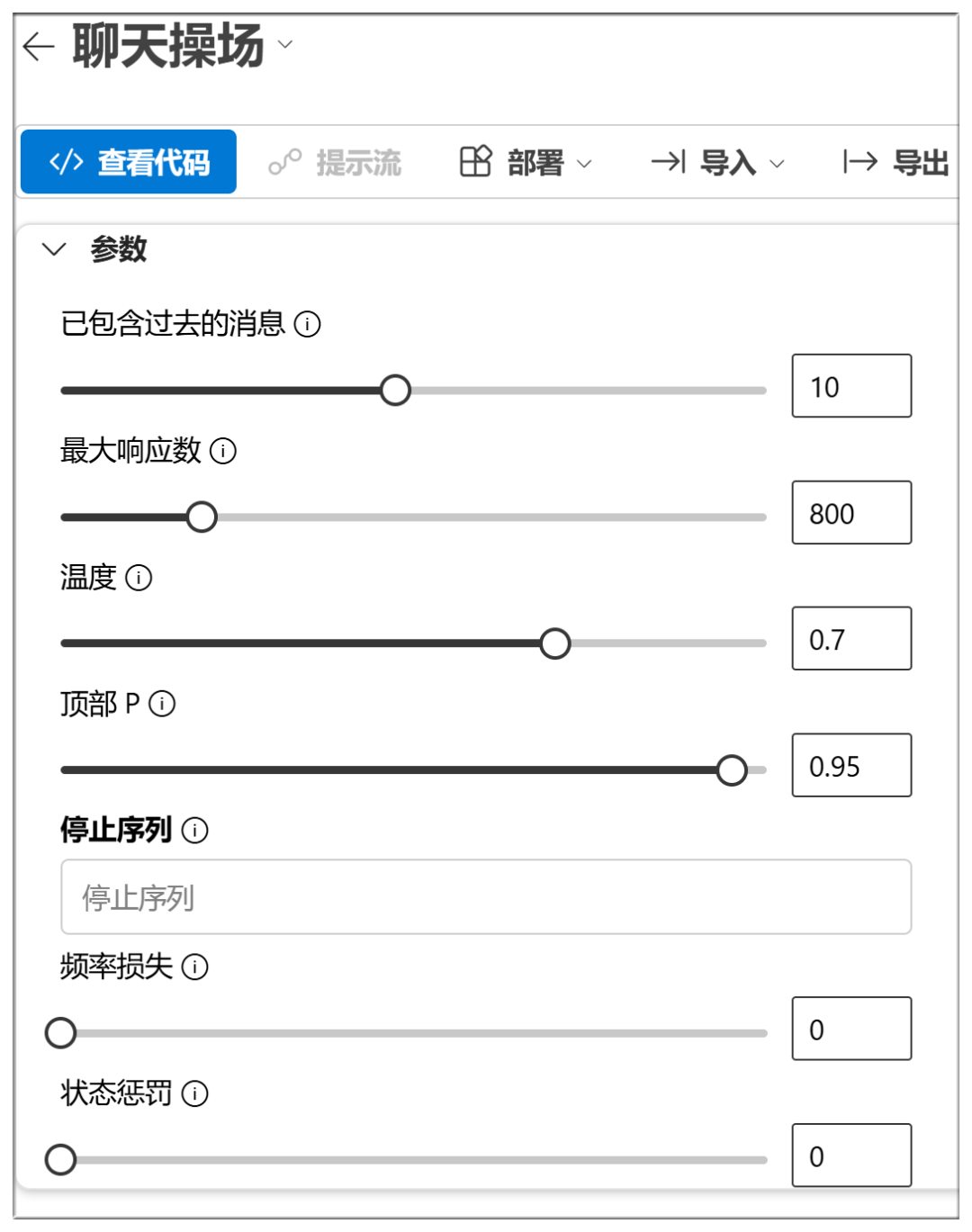

Azureには、NIMのようなパラメータ・チューニングも用意されている:

プラットフォームとして、展開できるモデルはたくさんある:

既にデプロイされたモデルは、左メニューの "Playground "または "Model + Endpoint "から素早くアクセスすることができます:

アマゾンAWS

ウェブサイト

https://aws.amazon.com/cn/blogs/aws/deepseek-r1-models-now-available-on-aws

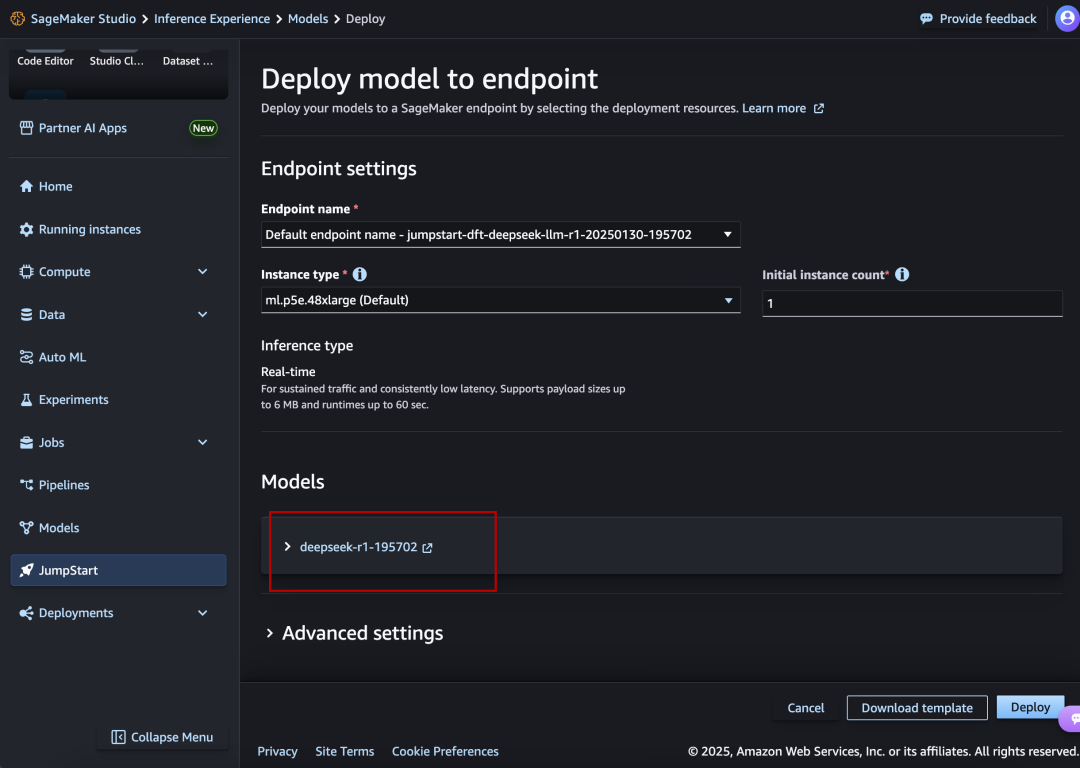

DeepSeek-R1も大きくフィーチャーされて並んでいる。

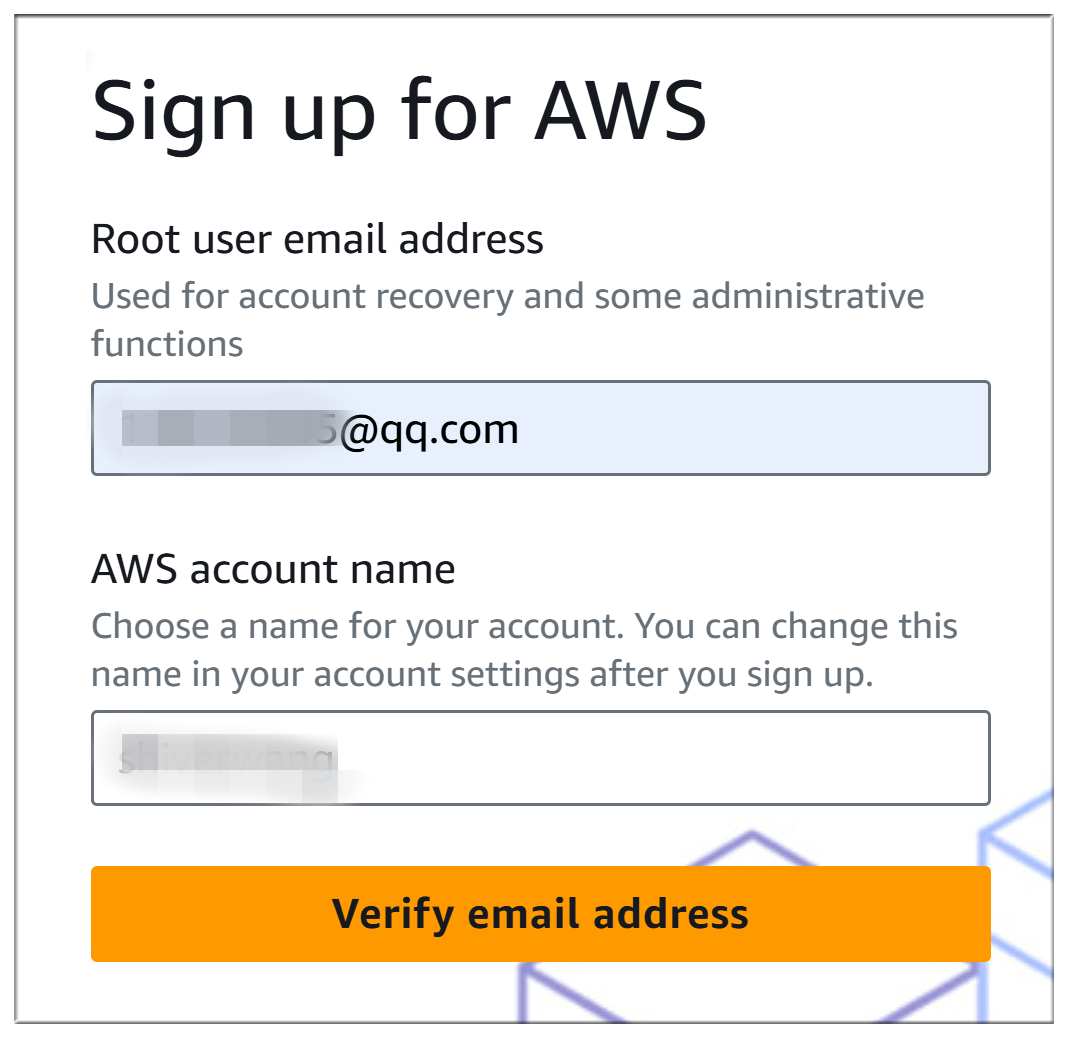

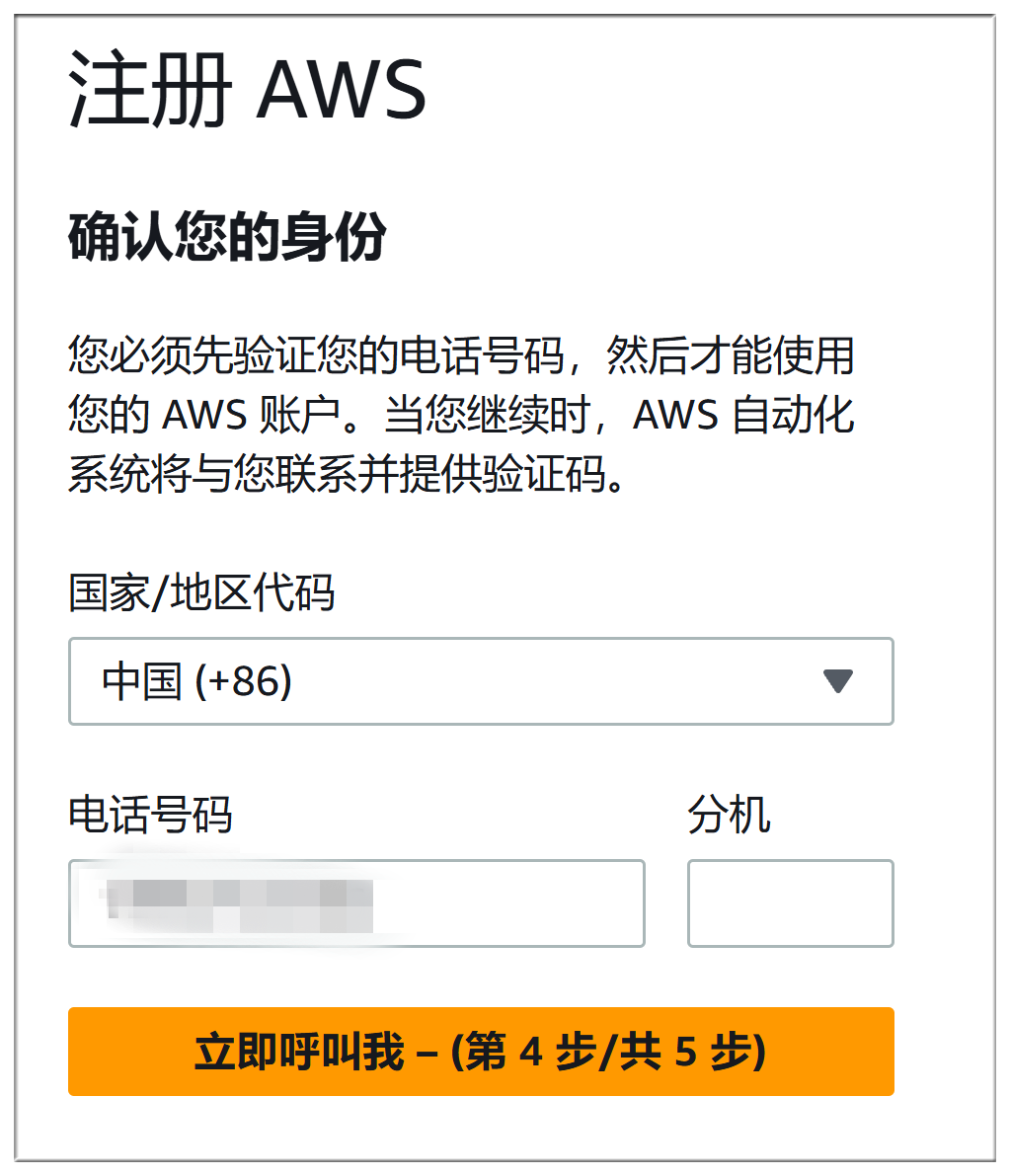

Amazon AWSの登録手続きとMicrosoft Azureの登録手続きはほぼ同じように面倒で、どちらも支払い方法を記入しなければならないだけでなく、電話認証+音声認証が必要だが、ここでは詳細は割愛する:

正確な導入プロセスはMicrosoft Azureとほぼ同じだ:

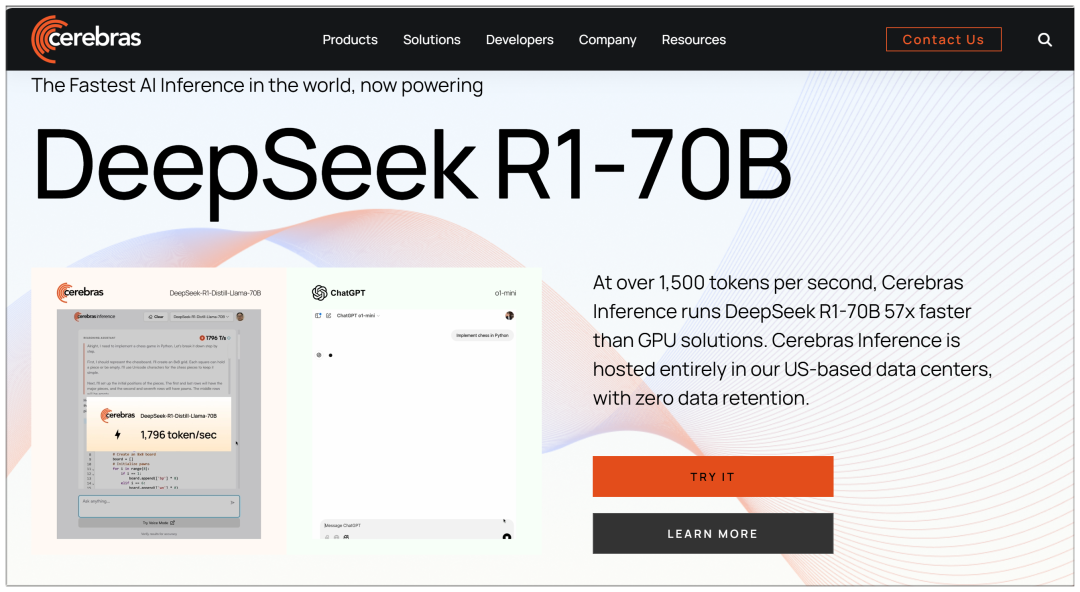

IV.セレブラ

セレブラス:現在利用可能な世界最速のAI推論、ハイパフォーマンス・コンピューティング・プラットフォーム

ウェブサイト:https://cerebras.ai

いくつかの大規模なプラットフォームとは異なり、セレブラスは70bモデルを使用しており、「GPUソリューションの57倍速い」と主張している:

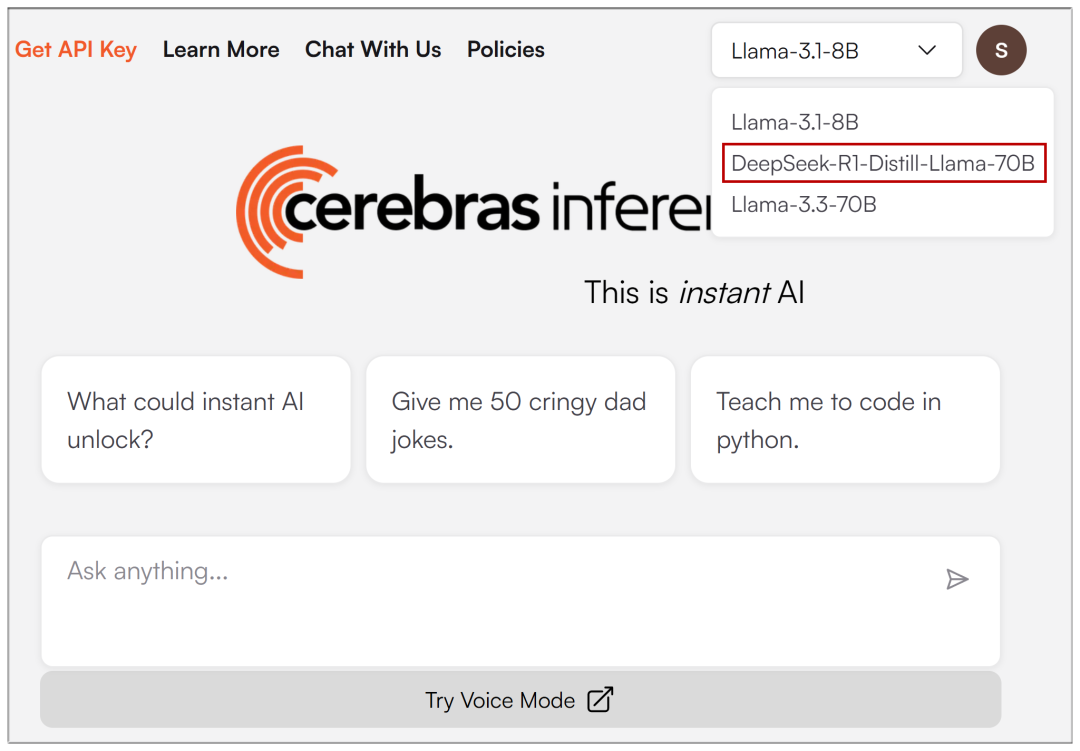

電子メール登録が入力されると、上部のドロップダウンメニューで DeepSeek-R1 を選択できます:

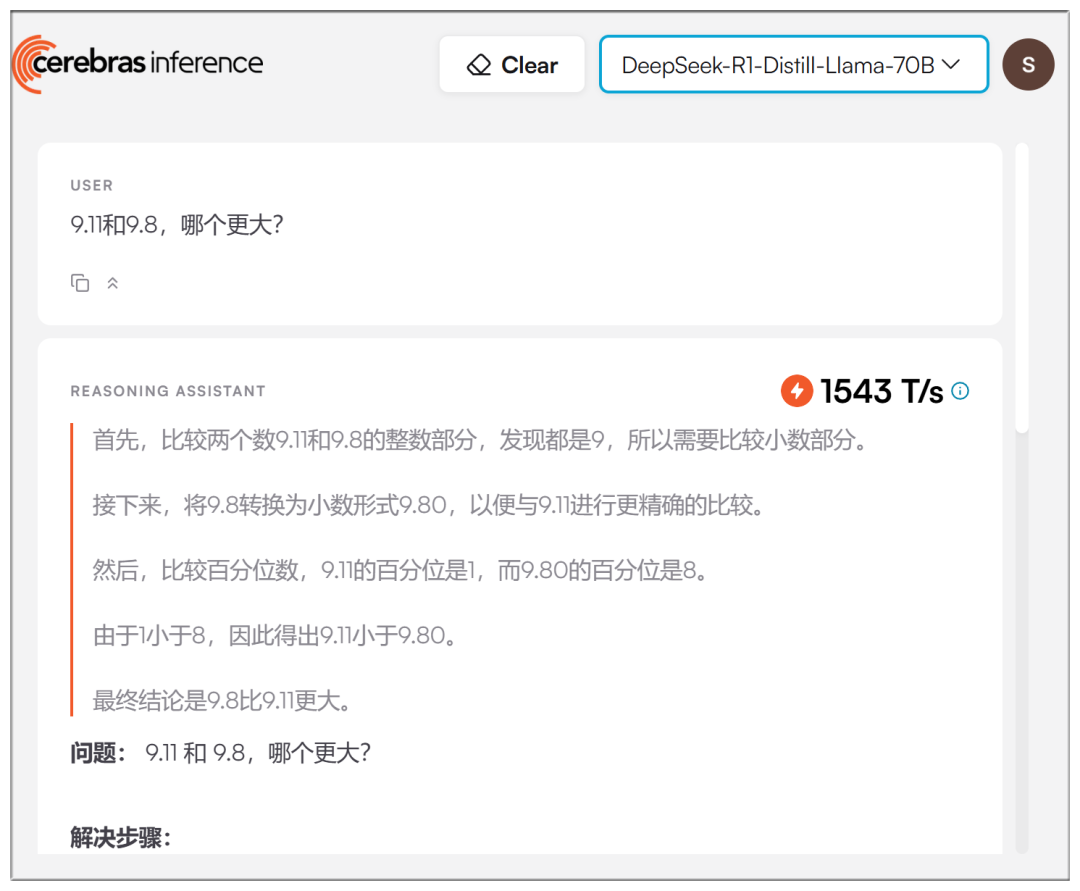

謳い文句ほど誇張されてはいないが、実際のスピードは確かに速い:

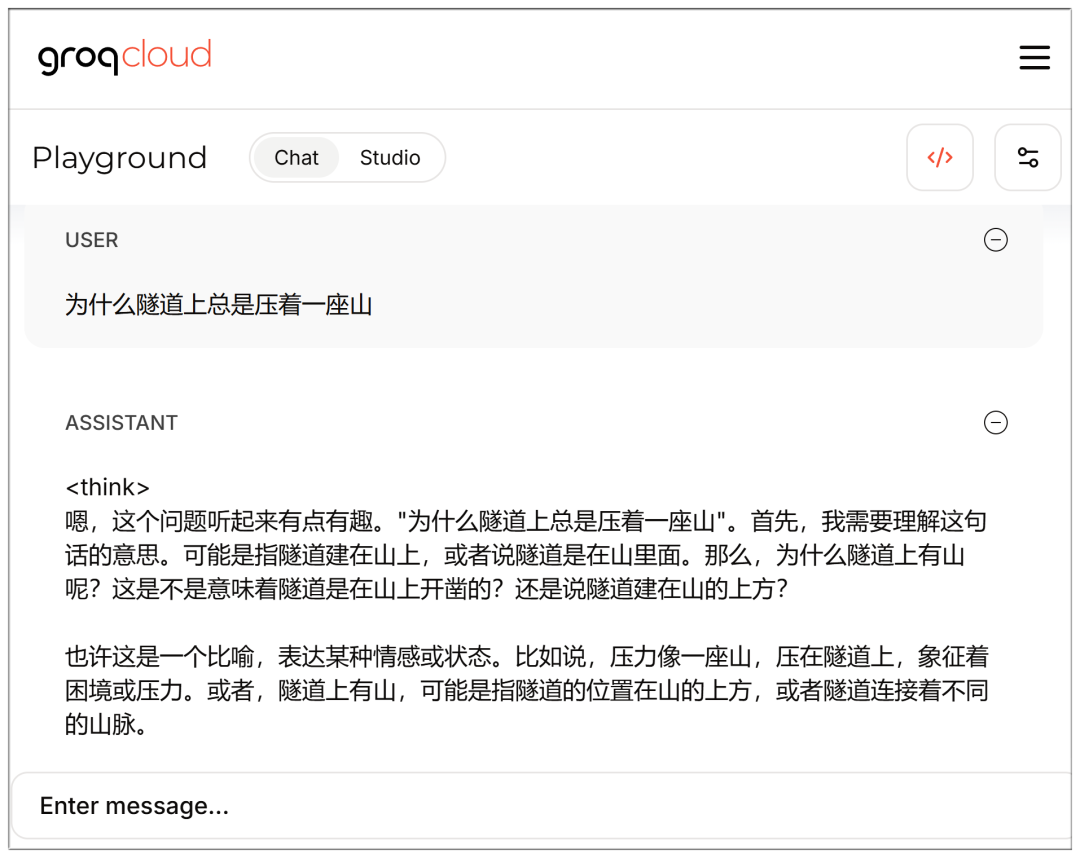

V・グロック

Groq:AI大規模モデル推論アクセラレーションソリューションプロバイダー、高速無料大規模モデルインターフェース

ウェブサイト:https://groq.com/groqcloud-makes-deepseek-r1-distill-llama-70b-available

Eメールを登録・入力すれば、モデルも選択できる:

スピードもあるが、やはり70bはセレブラより少し遅れている感じか?

なお、チャット・インターフェースには、ログインした状態で直接アクセスできる:

https://console.groq.com/playground?model=deepseek-r1-distill-llama-70b

DeepSeek V3およびR1の完全なリスト:

AMD

AMD Instinct™ GPUがDeepSeek-V3を強化:SGLangでAI開発に革命を起こす (AMD Instinct™ GPUs Power DeepSeek-V3: Revolutionising AI Development with SGLang)

エヌビディア

DeepSeek-R1 NVIDIAモデルカード (DeepSeek-R1 NVIDIAモデルカード)

マイクロソフト・アジュール

単一のNDv5 MI300X VM上でのDeepSeek-R1の実行 (単一のNDv5 MI300X VM上でDeepSeek-R1を実行)

バセテン

https://www.baseten.co/library/deepseek-v3/

ノビタAI

ノヴィタAI、OpenRouterでDeepSeek-V3を実行するSGLangを使用 (SGLangを使用してOpenRouter用のDeepSeek-V3を実行するNovita AI)

バイトダンス・ヴォルケエンジン

ディープシークのフルサイズモデルがボルケーノ・エンジンに着陸!

データクランチ

DeepSeek-R1 671Bを8x NVIDIA H200にSGLangで展開 (SGLangを使用した8x NVIDIA H200上でのDeepSeek-R1 671Bの展開)

ハイパーボリック

https://x.com/zjasper666/status/1872657228676895185

ウルトル

SGLangを使用したDeepseek V3大規模言語モデル(LLM)の展開方法 (SGLangでのデプロイ方法) ディープシーク V3 大言語モデリング(LLM))

ランポッド

2025年、RunPodにおけるサーバーレスLLM利用の新機能とは? (2025年にRunPodでサーバーレスLLMが使用する新機能とは?)

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません