Il est démontré que:RL surpasse SFT dans l'apprentissage de connaissances généralisables, en particulier dans les tâches multimodales, montrant des capacités de raisonnement et de reconnaissance visuelle plus fortes.

bref

Dans le domaine de l'intelligence artificielle.modèle de base(par exemple, les modèles linguistiques à grande échelle et les modèles linguistiques visuels) sont devenus un moteur essentiel du progrès technologique. Cependant, comment améliorer efficacement l'efficacité de ces modèles ?capacité de généralisationL'adaptation à la complexité et à la variabilité des scénarios de la vie réelle reste un défi majeur. Actuellement.Réglage fin supervisé (SFT) et apprentissage par renforcement (RL)sont deux méthodes de post-entraînement largement adoptées, mais leurs rôles et effets spécifiques dans l'amélioration de la capacité de généralisation des modèles restent peu clairs.

Cette thèse est étayée par uneÉtude comparative approfondieDans le cadre de ce projet, nous explorons systématiquement l'impact de SFT et RL sur les capacités de généralisation du modèle sous-jacent. Nous nous concentrons sur les deux aspects clés suivants :

- Généralisation basée sur des règles textuelles : Nous avons conçu un système appelé Points généraux d'un jeu de cartes de raisonnement arithmétique qui évalue les performances du modèle selon différentes variantes de règles.

- Généralisation visuelle : Nous avons utilisé le V-IRL un environnement de navigation basé sur des données visuelles réelles, afin de tester la capacité du modèle à s'adapter aux changements des données visuelles.

Grâce à une série deExpérimentation et analyse rigoureusesNous sommes parvenus aux conclusions importantes suivantes :

- Le RL est plus performant que le SFT en ce qui concerne la généralisation des règles et des images : RL est capable d'apprendre et d'appliquer de nouvelles règles efficacement tout en maintenant de bonnes performances en présence de variations de l'entrée visuelle. En revanche, SFT a tendance à mémoriser les données d'apprentissage et a du mal à s'adapter aux variantes inédites.

- Le RL améliore la reconnaissance visuelle : Dans la modélisation du langage visuel (VLM), le RL améliore non seulement le raisonnement mais aussi la reconnaissance visuelle, tandis que le SFT réduit la reconnaissance visuelle.

- La SFT est essentielle à la formation à la RL : Le SFT est un facteur clé de la réussite de l'apprentissage de la NR lorsque le modèle de base n'a pas une bonne capacité de suivi des instructions. Il stabilise le format de sortie du modèle afin que le RL puisse tirer pleinement parti de ses performances.

- L'augmentation du nombre d'itérations de vérification améliore la généralisation de la NR : Dans la formation RL, l'augmentation du nombre d'itérations de validation peut encore améliorer la généralisation du modèle.

Ces résultatsFournit des informations précieuses pour la recherche et les applications futures de l'IACette étude montre que le RL a plus de potentiel dans les tâches multimodales complexes. Notre étude révèle non seulement les rôles différents de la SFT et de la RL, mais fournit également de nouvelles idées sur la manière de combiner plus efficacement ces deux approches pour construire des modèles sous-jacents plus puissants et plus fiables.

Que vous soyez un chercheur en IA, un ingénieur ou un lecteur intéressé par l'avenir de l'IA, ce document vous fournira des informations et des conseils pratiques. Approfondissons les mystères de la SFT et de la RL pour révéler le chemin critique vers la généralisation du modèle sous-jacent.

Texte original :https://tianzhechu.com/SFTvsRL/assets/sftvsrl_paper.pdf

lecture rapide

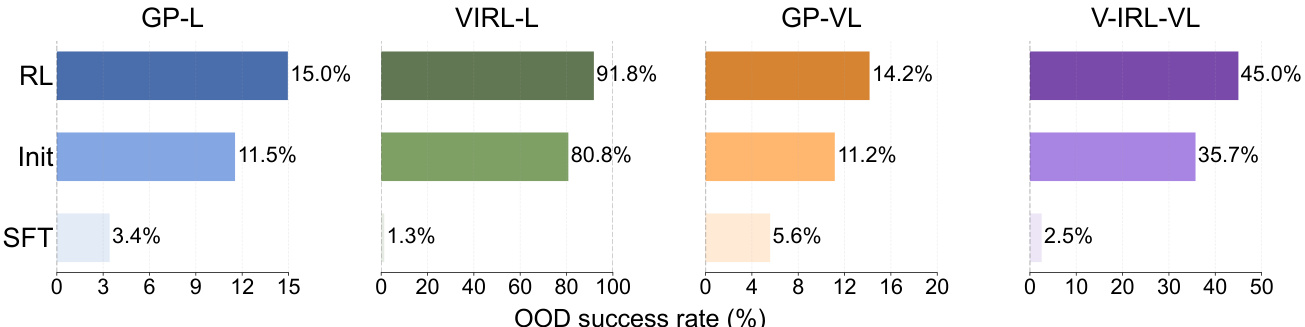

1. RL surpasse SFT dans la généralisation des règles

Conclusion :

Le RL est capable d'apprendre et de généraliser efficacement les règles textuelles, tandis que le SFT a tendance à mémoriser les données d'apprentissage et a du mal à s'adapter aux variantes de règles inédites.

Exemple :

RL surpasse SFT en termes de performances hors distribution (OOD) dans les tâches GeneralPoints et V-IRL.

- Points généraux (GP-L) :

- RL. Le taux de réussite était de 15,01 TP3T, ce qui représente une augmentation par rapport aux 11,51 TP3T du point de contrôle initial. +3.5%.

- SFT. Le taux de réussite était de 3,41 TP3T, soit une baisse par rapport aux 11,51 TP3T du point de contrôle initial. -8.1%.

- V-IRL (V-IRL-L) :

- RL. La précision par étape était de 91,8%, une amélioration par rapport aux 80,8% du point de contrôle initial. +11.0%.

- SFT. La précision par étape était de 1,31 TP3T, contre 80,81 TP3T au point de contrôle initial. -79.5%.

Figure 6 : Pour chaque sous-graphe, RL et SFT sont entraînés en utilisant la même quantité de calcul, et leur point de contrôle initial commun (étiqueté Init) est défini comme ligne de base. Voir l'annexe C.3 pour les paramètres détaillés.

2. RL se généralise également dans les tâches visuelles d'OOD, alors que SFT n'obtient que des résultats médiocres.

Conclusion :

Même dans les tâches contenant des modalités visuelles, RL est toujours capable de généraliser à des variantes visuelles inédites, alors que SFT souffre d'une dégradation des performances.

Exemple :

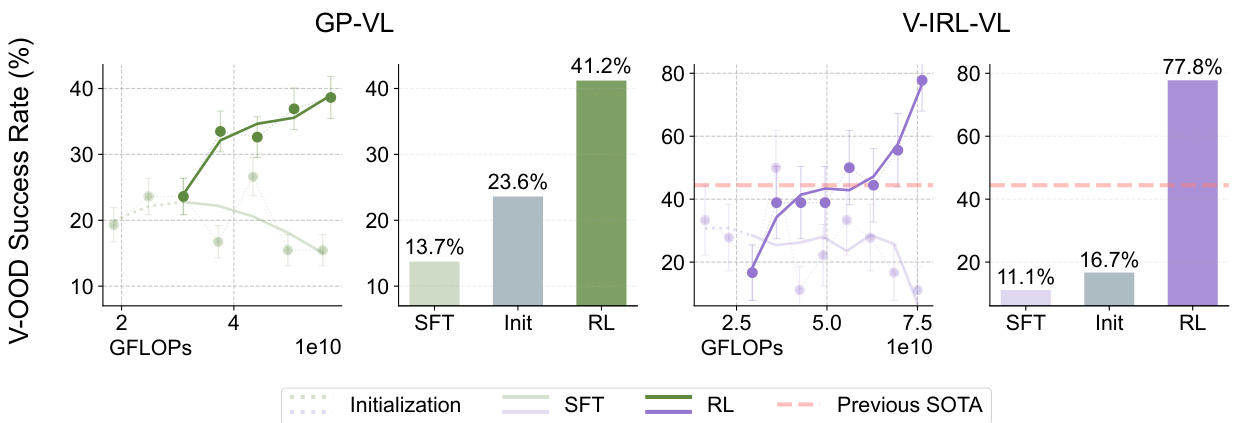

Dans les tâches GeneralPoints-VI et V-IRL-VL :

- Points généraux-VI (GP-VI) :

- RL. Le taux de réussite était de 41,21 TP3T, soit une augmentation par rapport aux 23,61 TP3T au point de contrôle initial. +17.6%.

- SFT. Le taux de réussite était de 13,71 TP3T, contre 23,61 TP3T au point de contrôle initial. -9.9%.

- V-IRL-VL (V-IRL-VL) :

- RL. La précision par étape était de 77,81 TP3T, une amélioration par rapport aux 16,71 TP3T au point de contrôle initial. +61.1%.

- SFT. La précision par étape était de 11,11 TP3T, contre 16,71 TP3T au point de contrôle initial. -5.6%.

Figure 7 : Comme pour les figures 5 et 6, nous montrons la dynamique de la performance (représentée par des lignes) et la performance finale (représentée par des barres) évaluée en dehors de la distribution visuelle. L'état de l'art précédent sur le test de référence V- IRL VLN small (Yang et al., 2024a) est indiqué en orange. Voir l'annexe C.3 pour la configuration détaillée de l'évaluation (et le lissage des courbes).

3. RL améliore la reconnaissance visuelle des VLM

Conclusion :

RL améliore non seulement l'inférence du modèle, mais aussi sa reconnaissance visuelle, tandis que SFT réduit la reconnaissance visuelle.

Exemple :

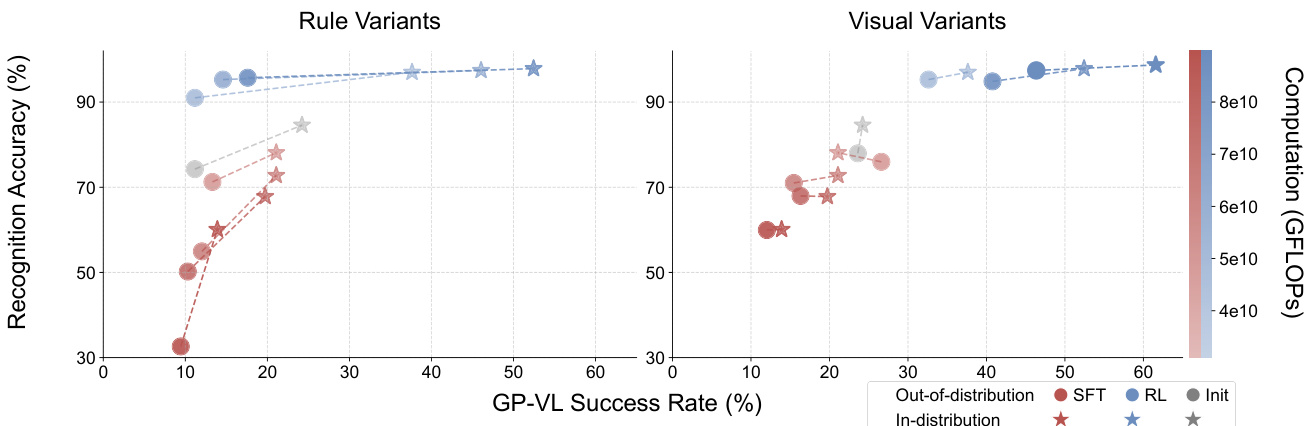

Dans la tâche GeneralPoints-VI :

- RL. Au fur et à mesure que la quantité de calculs d'apprentissage augmente, la précision de la reconnaissance visuelle et le taux de réussite global s'améliorent.

- SFT. Au fur et à mesure que la quantité de calculs d'apprentissage augmente, la précision de la reconnaissance visuelle et le taux de réussite global diminuent.

Figure 8 : Comparaison du taux de reconnaissance et du taux de réussite de l'apprentissage par renforcement (RL) et du réglage fin supervisé (SFT) pour différentes variantes de GP-VL. Les graphiques montrent les performances du taux de reconnaissance (axe des y) et du taux de réussite sur un seul écran (axe des x), correspondant respectivement aux données en distribution (rouge) et aux données hors distribution (bleu). La transparence des points de données (barres de couleur) représente la quantité de calculs d'entraînement. Les paires de données reliées par des lignes (⋆-◦ ) sont évaluées à l'aide des mêmes points de contrôle. Les résultats montrent que l'apprentissage par renforcement (RL) améliore à la fois le taux de reconnaissance et la précision globale à mesure que la quantité de calcul post-entraînement augmente, tandis que le réglage fin supervisé (SFT) montre la tendance inverse.

Figure 8 : Comparaison du taux de reconnaissance et du taux de réussite de l'apprentissage par renforcement (RL) et du réglage fin supervisé (SFT) pour différentes variantes de GP-VL. Les graphiques montrent les performances du taux de reconnaissance (axe des y) et du taux de réussite sur un seul écran (axe des x), correspondant respectivement aux données en distribution (rouge) et aux données hors distribution (bleu). La transparence des points de données (barres de couleur) représente la quantité de calculs d'entraînement. Les paires de données reliées par des lignes (⋆-◦ ) sont évaluées à l'aide des mêmes points de contrôle. Les résultats montrent que l'apprentissage par renforcement (RL) améliore à la fois le taux de reconnaissance et la précision globale à mesure que la quantité de calcul post-entraînement augmente, tandis que le réglage fin supervisé (SFT) montre la tendance inverse.

4. SFT est nécessaire pour la formation RL

Conclusion :

Le SFT est nécessaire pour la formation RL lorsque le modèle dorsal ne dispose pas d'un bon suivi des commandes.

Exemple :

Toutes les expériences dans lesquelles le RL de bout en bout a été directement appliqué à Llama-3.2 après l'entraînement, sans initialisation SFT, se sont soldées par un échec.

- Études de cas d'échec :

- Le modèle génère des réponses longues, dégressives et non structurées qui ne permettent pas de récupérer les informations et les récompenses associées à la formation en NR.

- Par exemple, le modèle tente de résoudre le jeu des 24 points en écrivant du code, mais ne parvient pas à générer du code, ce qui entraîne un échec de la validation.

![]()

Figure 20 : Nous avons enregistré les réponses du modèle en utilisant des indices similaires à ceux de la figure 11. Les résultats montrent que le lama-3.2-Vision-11B ne parvient pas à suivre correctement les instructions. Nous avons omis les longues réponses qui tentaient de résoudre l'énigme à l'aide d'un code, mais qui n'ont pas pu être complétées dans le temps limité du contexte.

5. L'augmentation du nombre d'itérations de validation améliore la capacité de généralisation de RL

Conclusion :

Dans la formation RL, l'augmentation du nombre d'itérations de validation améliore la généralisation du modèle.

Exemple :

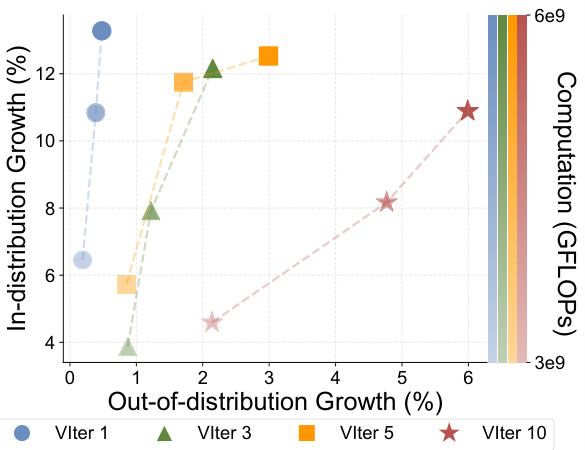

Dans la tâche GeneralPoints-Language (GP-L) :

- 1 itération de validation. La performance de l'OOD n'est améliorée que par +0.48%.

- 3 itérations de validation. Amélioration des performances de l'OOD +2.15%.

- 5 itérations de validation. Amélioration des performances de l'OOD +2.99%.

- 10 itérations de validation. Amélioration des performances de l'OOD +5.99%.

Figure 10 : Nous avons enregistré des expériences RL avec différents nombres d'itérations de validation (VIter) afin d'augmenter la quantité de calculs d'apprentissage (transparence des couleurs).

6. SFT surajouté aux marqueurs d'inférence et ignorant les marqueurs de reconnaissance

Conclusion :

SFT a tendance à surajuster les marqueurs inférés et à ne pas se concentrer sur les marqueurs identifiés, probablement en raison de la fréquence élevée des marqueurs inférés.

Exemple :

Dans la tâche GeneralPoints-VI, SFT n'a pas pu atteindre une performance intra-distribution comparable à celle de RL, même après ajustement des hyperparamètres.

- Étude sur l'ablation du SFT.

- Après ajustement du taux d'apprentissage et d'autres composantes ajustables, aucun des taux de réussite SFT n'a dépassé 30% et n'a montré de tendance à l'augmentation.

Figure 16 : Étude d'ablation de la SFT GeneralPoints-VL. Nous avons réalisé des expériences d'ablation sur le taux d'apprentissage et rapporté le taux de réussite à l'intérieur de la distribution, sur un seul écran (%) pour toutes les expériences. Aucune des expériences n'a eu de taux de réussite supérieur à 30% et n'a montré de tendance à l'augmentation.

7. RL ne peut pas récupérer les performances de l'OOD à partir de points de contrôle surajoutés

Conclusion :

Lorsqu'il a été initialisé à partir d'un point de contrôle surajusté, RL n'a pas été en mesure de retrouver les performances du modèle en matière de DOO.

Exemple :

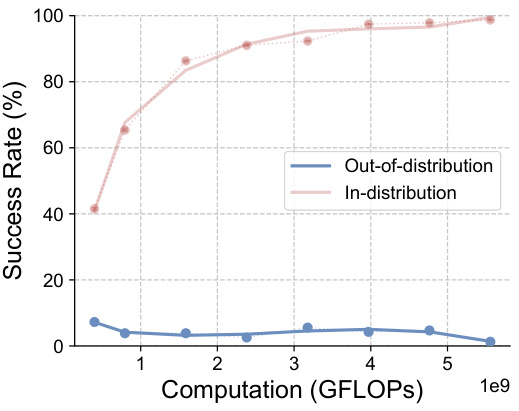

Dans la tâche V-IRL-VL :

- RL Initialisation à partir de points de contrôle surajoutés : la

- La précision initiale par étape est inférieure à 1% et RL ne peut pas améliorer la performance OOD.

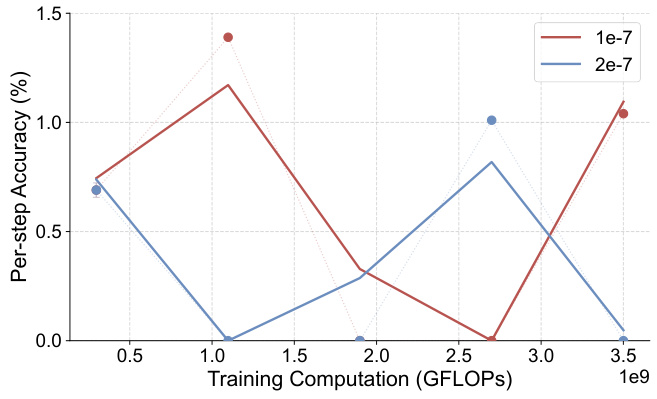

Figure 19 : Précision en une seule étape hors distribution (%) - GFLOPs : modèle V-IRL-VL sous variantes régulières (en utilisant des points de contrôle initiaux surajustés). Voir l'annexe C.3 pour plus de détails sur les mesures d'évaluation.

résumés

A travers une série d'expériences et d'analyses, cette thèse démontre les avantages du RL dans l'apprentissage de connaissances généralisables, et la tendance du SFT à se souvenir des données d'entraînement. La thèse met également en évidence l'importance de SFT pour la formation RL et l'impact positif de l'augmentation du nombre d'itérations de validation sur la capacité de généralisation de RL. Ces résultats fournissent des indications précieuses pour la construction de modèles de base plus robustes et plus fiables à l'avenir.

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...