XRAG : un outil d'évaluation visuelle pour optimiser les systèmes de génération d'amélioration de la recherche.

Introduction générale

XRAG (eXamining the Core) est un cadre d'analyse comparative conçu pour évaluer les composants sous-jacents des systèmes avancés de génération d'augmentation de la recherche (RAG). En profilant et en analysant chaque module central, XRAG permet de comprendre comment différentes configurations et différents composants affectent les performances globales d'un système RAG. Le cadre prend en charge plusieurs méthodes de recherche et métriques d'évaluation et est conçu pour aider les chercheurs et les développeurs à optimiser et à améliorer tous les aspects des systèmes RAG.

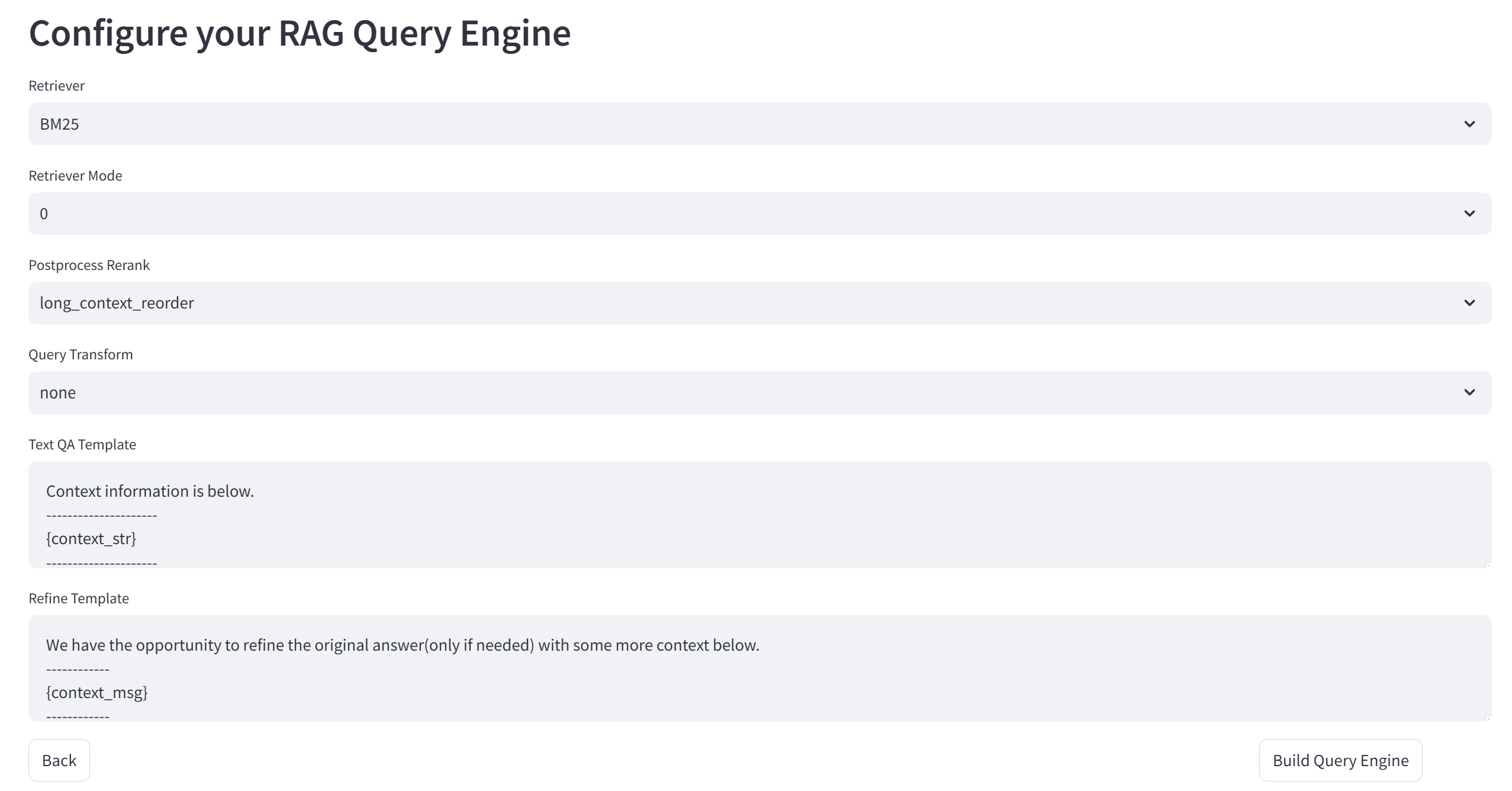

XRAG prend en charge le benchmark et la boîte à outils d'évaluation RAG complète, couvrant plus de 50+ métriques de test et l'évaluation complète de RAG ainsi que l'optimisation des points de défaillance, prend en charge la comparaison de 4 types de modules RAG avancés (Reconstruction de la requête, Récupération avancée, Modèles de question et de réponse, et Post-traitement), intègre plusieurs implémentations spécifiques dans les modules, et prend en charge l'API Big Model d'OpenAI. La version 1.0 de XRAG fournit également une démo simple de l'interface Web, un téléchargement interactif léger des données et un format standard unifié, et intègre les méthodes de détection des défaillances et d'optimisation de RAG. L'article et le code sont désormais en open source.

Liste des fonctions

- Cadre d'évaluation intégréeLes évaluations multidimensionnelles, y compris les évaluations basées sur l'apprentissage tout au long de la vie, les évaluations approfondies et les mesures traditionnelles, sont prises en charge.

- Architecture flexibleLes services de recherche : Conception modulaire pour prendre en charge de multiples méthodes de recherche et des stratégies de recherche personnalisées.

- Support multi-LLMIntégration transparente avec les modèles OpenAI et prise en charge des modèles natifs (par exemple Qwen, LLaMA, etc.).

- Un ensemble riche d'indicateurs d'évaluation: comprend les mesures traditionnelles (F1, EM, MRR, etc.) et les mesures basées sur le LLM (véracité, pertinence, etc.).

- Méthodes de recherche avancéeSupport BM25, recherche sémantique vectorielle, recherche arborescente et autres méthodes de recherche.

- interface convivialeLe système de gestion de l'information (SGI) est un outil de gestion de l'information qui fournit une interface de ligne de commande et une interface Web pour soutenir l'évaluation et la visualisation interactives.

Utiliser l'aide

Processus d'installation

- entrepôt de clones: :

git clone https://github.com/DocAILab/XRAG.git

cd XRAG

- Installation des dépendances: :

pip install -r requirements.txt

- Environnement de configuration: Modifié en fonction des besoins

config.tomlpour configurer les paramètres du modèle et les paramètres de l'API.

Lignes directrices pour l'utilisation

- Lancement de l'interface Web: :

xrag-cli webui

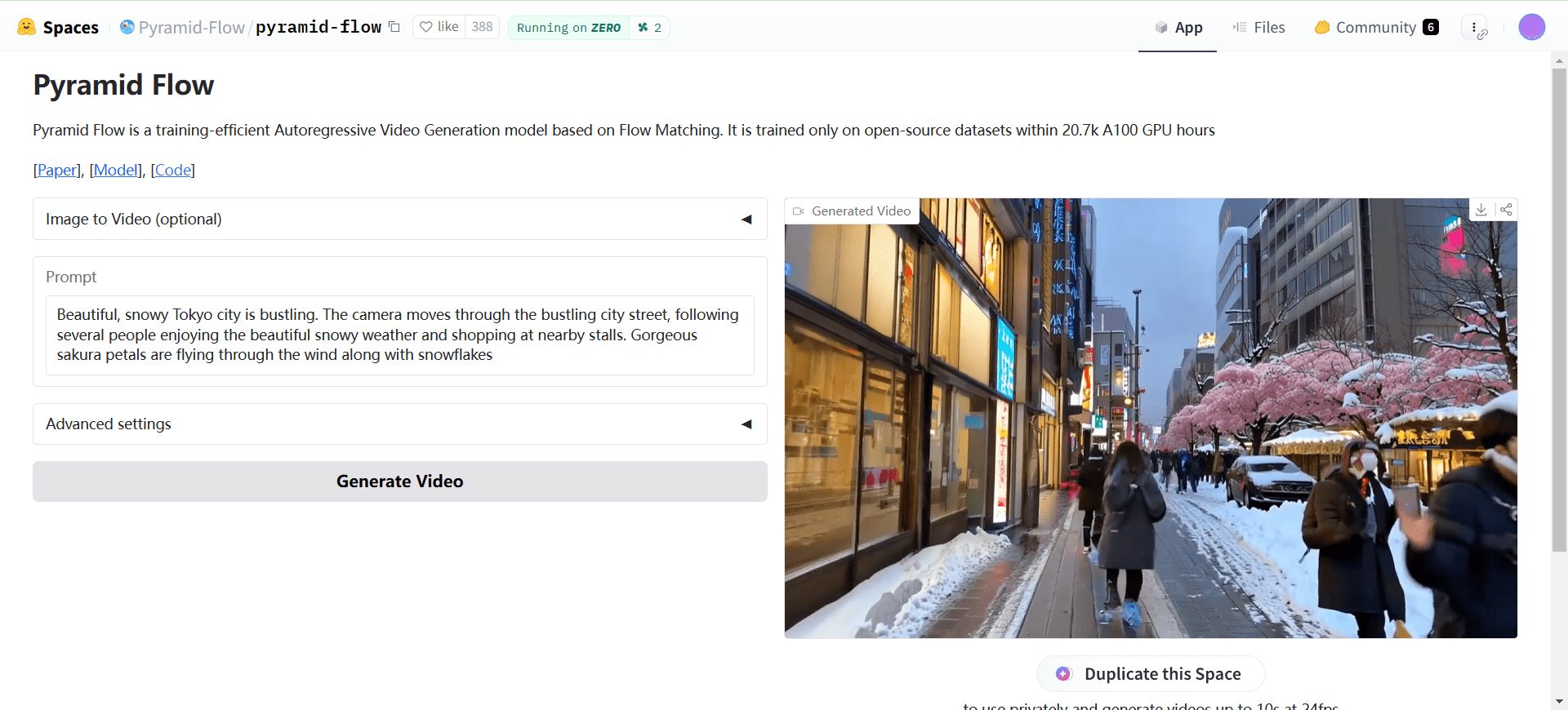

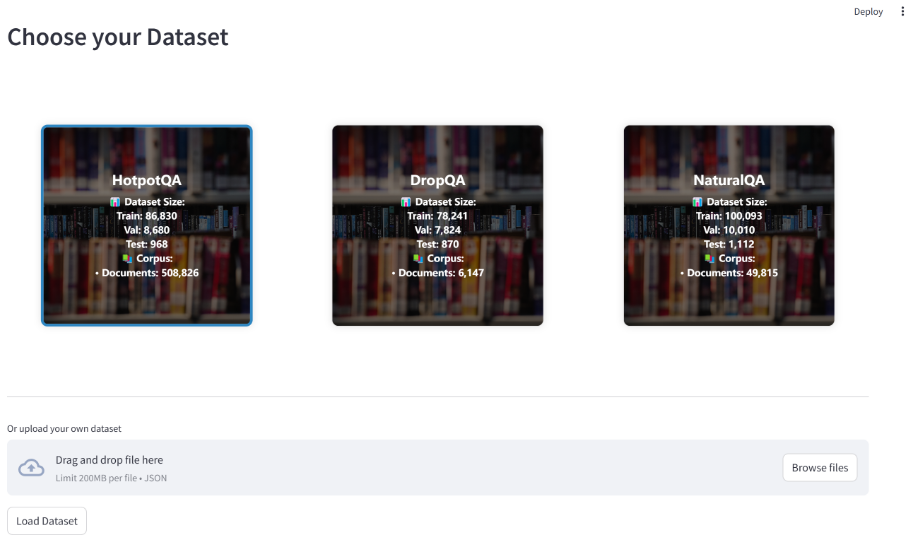

Téléchargement et configuration des ensembles de données via l'interface Web, avec prise en charge de plusieurs ensembles de données de référence (par exemple HotpotQA, DropQA, NaturalQA).

- Évaluation opérationnelleLancer l'évaluation à l'aide de l'outil de ligne de commande :

xrag-cli evaluate --dataset <dataset_path> --config <config_path>

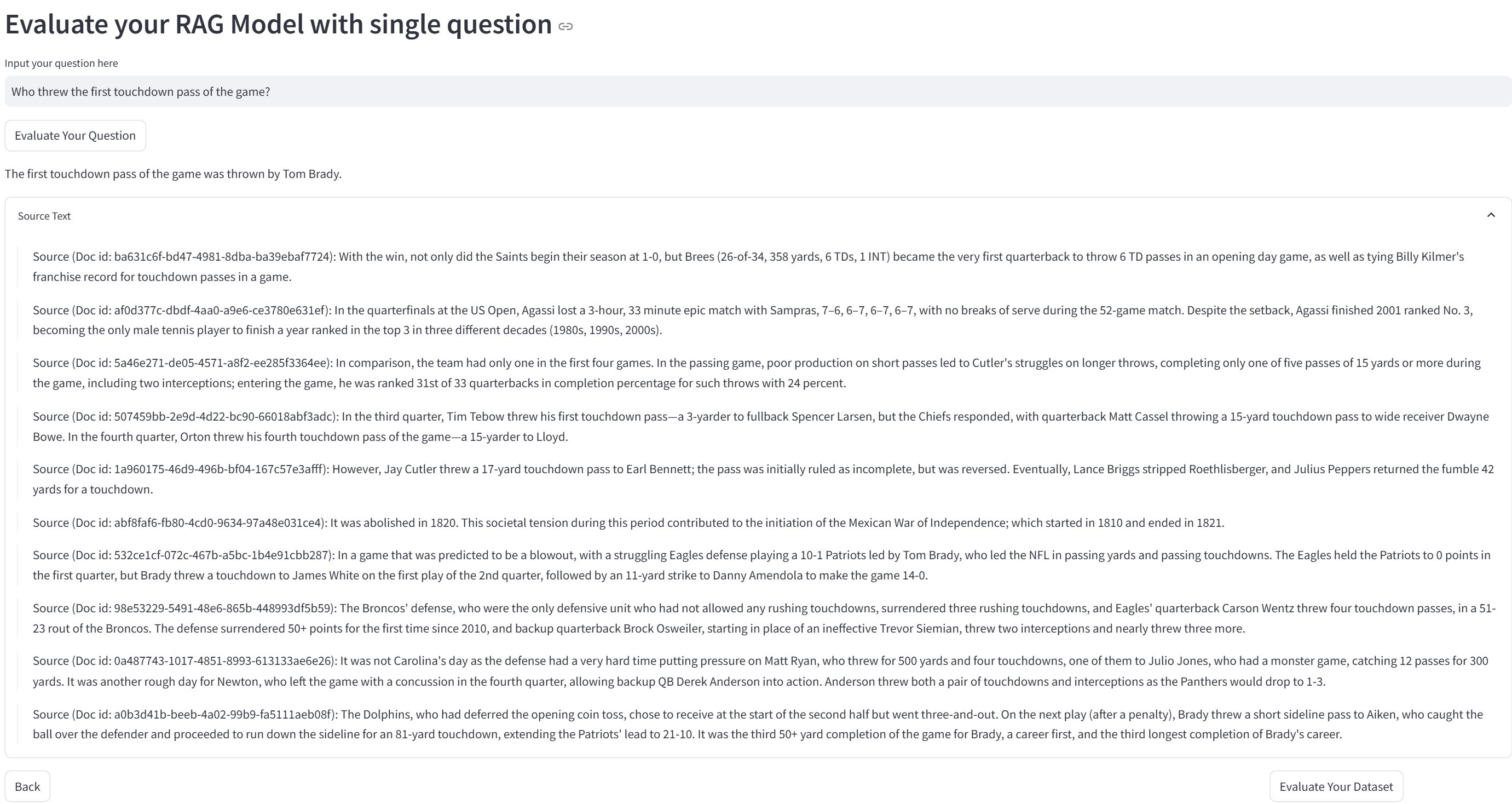

Des rapports détaillés et des tableaux de visualisation sont générés pour les résultats de l'évaluation.

- Stratégies de recherche personnaliséesModification de la loi sur la protection des données

src/xragpour ajouter ou ajuster des stratégies de recherche et des modèles d'évaluation.

Principales fonctions

- Téléchargement et configuration des ensembles de donnéesL'interface Web permet de télécharger le jeu de données et de le configurer comme il se doit.

- Les cycles d'évaluationLes résultats de l'évaluation peuvent être consultés sur le site web de la Commission européenne : sélectionnez les indicateurs d'évaluation et les méthodes de recherche, exécutez l'évaluation et consultez les résultats.

- Analyse des résultatsLes résultats de l'évaluation sont analysés et les performances du système sont optimisées grâce aux rapports et aux diagrammes visuels générés.

Le cadre Ollama : Permettre un raisonnement efficace de recherche localisée dans XRAG

Ollama joue un rôle crucial dans le cadre d'inférence de recherche localisée XRAG-Ollama. En tant que cadre libre et facile à utiliser pour l'exécution de grands modèles locaux, Ollama fournit à XRAG de puissantes capacités d'inférence de recherche localisée, ce qui permet à XRAG de tirer pleinement parti de sa génération d'amélioration de la recherche.

Pourquoi localiser le déploiement de XRAG ?

- Réduction du risque externe : Le déploiement local réduit la dépendance à l'égard des services externes et diminue les risques potentiels liés à des services tiers instables ou à des fuites de données.

- Disponibilité hors ligneLe système RAG localisé ne dépend pas d'une connexion internet et peut fonctionner normalement même en cas de panne du réseau, ce qui garantit la continuité et la stabilité du service.

- Gestion autonome des donnéesLe déploiement local permet aux utilisateurs de contrôler totalement la manière dont les données sont stockées, gérées et traitées, par exemple en intégrant des données privées dans des bases de données vectorielles locales, ce qui garantit que les données sont traitées conformément aux normes de sécurité de l'organisation et aux exigences de l'entreprise.

- Confidentialité et sécurité des donnéesL'exécution d'un système RAG dans un environnement local évite le risque de compromettre des données sensibles en les transmettant sur le réseau et garantit que les données sont toujours sous contrôle local. Ceci est particulièrement important pour les organisations qui traitent des informations confidentielles.

Pourquoi Ollama ?

Ollama est un cadre léger et extensible pour la construction et l'exécution de modèles de langage à grande échelle (LLM) sur des machines locales. Il fournit une API simple pour créer, exécuter et gérer des modèles, ainsi qu'une bibliothèque de modèles préconstruits qui peuvent être facilement utilisés dans une variété d'applications. Non seulement il prend en charge un large éventail de modèles, tels que DeepSeek, Llama 3.3, Phi 3, Mistral, Gemma 2, etc., mais il est également capable de tirer parti de l'accélération matérielle des calculs modernes, fournissant ainsi un support d'inférence haute performance pour XRAG. En outre, Ollama prend en charge la quantification des modèles, ce qui permet de réduire considérablement les besoins en mémoire graphique. Par exemple, la quantification sur 4 bits compresse les paramètres de poids en précision FP16 en précision entière sur 4 bits, ce qui réduit considérablement le volume de poids du modèle et la mémoire graphique requise pour l'inférence. Il est ainsi possible d'exécuter de grands modèles sur un ordinateur domestique moyen.

En s'associant à Ollama, XRAG est en mesure d'exécuter efficacement des modèles linguistiques à grande échelle au niveau local sans dépendre de configurations d'environnement complexes et de grandes quantités de ressources informatiques, ce qui réduit considérablement les coûts de déploiement et d'exploitation. En même temps, la solution de déploiement local donne aux développeurs un contrôle total sur le traitement des données, en prenant en charge l'ensemble de la chaîne de personnalisation, depuis le nettoyage des données brutes, le traitement vectorisé (par exemple, la construction d'une base de connaissances privée grâce à ChromaDB) jusqu'à la mise en œuvre de l'application finale. Son architecture de déploiement basée sur une infrastructure locale est naturellement capable de fonctionner hors ligne, ce qui non seulement assure la continuité du service, mais répond également aux exigences strictes en matière de fiabilité du système dans des environnements particuliers (par exemple, réseaux classifiés, etc.).

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...