Déploiement privé sans GPU locaux DeepSeek-R1 32B

en ce qui concerne Profondeur de l'eau-R1 Pour une utilisation quotidienne au bureau, le site web officiel est le meilleur choix, si vous avez d'autres préoccupations ou des besoins particuliers... Il doit être utilisé dans le Déploiement local de DeepSeek-R1 (avec un programme d'installation en un clic)Le tutoriel blanc présenté ici est tout à fait approprié pour vous.

Si vous avez un ordinateur mal configuré mais que vous voulez quand même déployer en utilisant DeepSeek-R1 privé... Alors envisagez d'utiliser des GPU gratuits, comme tout le monde l'a appris il y a longtemps. Déploiement en ligne du modèle open-source DeepSeek-R1 avec une puissance GPU gratuiteCependant, il y a un inconvénient fatal, c'est que le GPU gratuit ne peut installer que 14B, l'installation de 32B sera très carte, mais après avoir testé seulement installer DeepSeek-R1 32B ou plus de qualité de sortie pour répondre aux besoins du travail quotidien.

Donc... Ce que nous allons faire, c'est installer des GPUs libres dans le système qui fonctionne efficacement. Version quantitative de DeepSeek-R1 32B. Il arrive !

Dans le GPU libre, la vitesse de sortie peut être de 2 à 6 mots par seconde (en fonction de la complexité du problème, la vitesse de sortie fluctue). L'inconvénient de cette méthode est que vous devez activer le service de temps en temps.

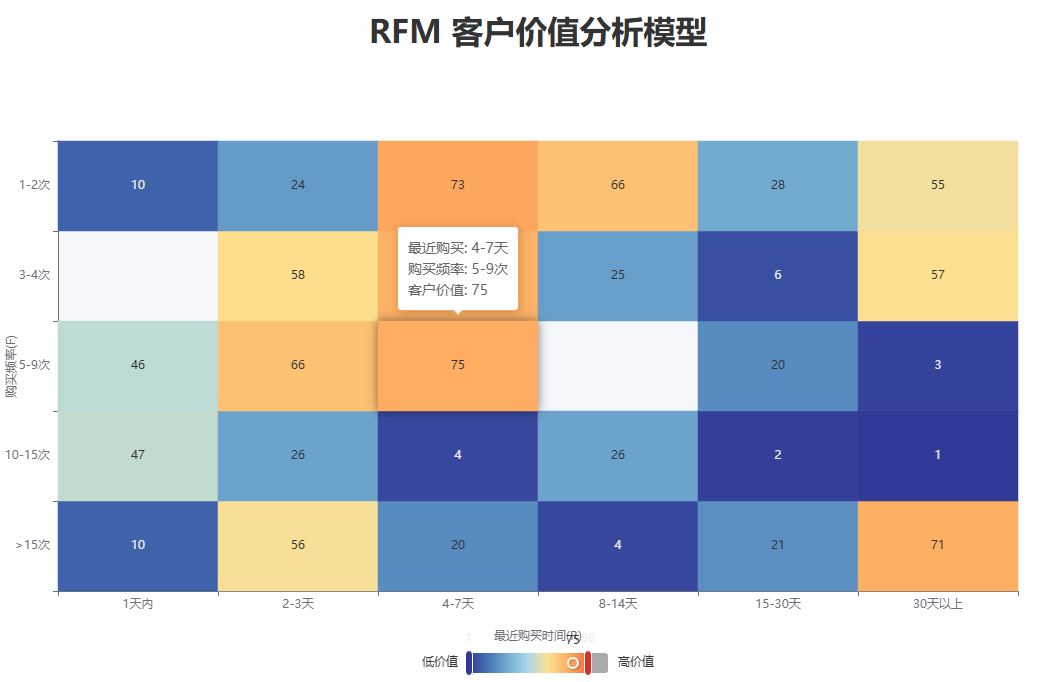

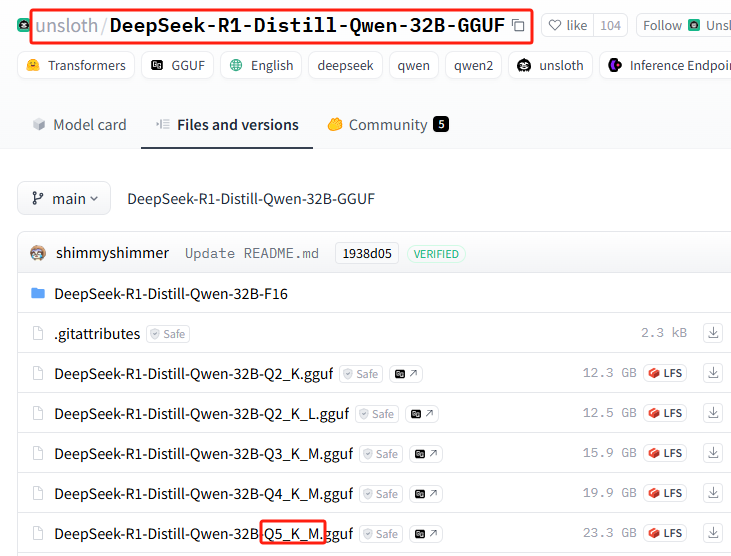

unsloth team quantised version DeepSeek-R1

non-loth La version fournie de Qwen-32B-Q4_K_M est compressée jusqu'à 20 Go, ce qui est déjà capable de fonctionner sur une carte simple grand public..

Un bref résumé des exigences en matière de performances informatiques pour la version quantifiée

DeepSeek-R1-Distill-Qwen-32B-GGUFDescription des différentes versions quantitatives du modèle

Le suffixe de chaque fichier (par exemple Q2_K_L, Q4_K_M, etc.) représente une quantification différente. Voici leurs principales différences :

q2_k_l, q3_k_m, q4_k_m, q5_k_m, q6_k, q8_0

Q2,Q3,Q4,Q5,Q6,Q8dénote le nombre de bits à calculer (par ex.Q4(Indique un calcul sur 4 bits).Kd'ailleursMIl peut s'agir d'une stratégie quantitative différente ou d'un niveau de précision différent.Q8_0Quantification typique sur 8 bits, proche de la précision FP16, avec les exigences de calcul les plus élevées mais une meilleure qualité d'inférence.

DeepSeek-R1-Distill-Qwen-32B-F16

F16indiquerVirgule flottante 16 bits (FP16)est le modèle non calculé, qui a la plus grande précision mais utilise le plus de mémoire vidéo.

Pour en savoir plus sur le concept de quantification, cliquez ici :Qu'est-ce que la quantification de modèle : explication des types de données FP32, FP16, INT8, INT4

Comment choisir la bonne version ?

- Dispositifs à faible mémoire vidéo (par exemple, GPU grand public) →SélectionnerQ4, Q5 quantificationpar exemple

Q4_K_Mpeut-êtreQ5_K_ML'équilibre entre performance et précision. - Dispositifs à mémoire extrêmement réduite (par exemple, fonctionnement de l'unité centrale) →SélectionnerQuantification Q2 ou Q3par exemple

Q2_K_Lpeut-êtreQ3_K_Mréduisant ainsi l'empreinte mémoire. - Serveurs GPU haute performance→SélectionnerQuantification Q6 ou Q8par exemple

Q6_Kpeut-êtreQ8_0et d'obtenir une meilleure qualité de raisonnement. - le plus efficace→Sélectionner

F16mais nécessite un espace de stockage important (environ 60 Go ou plus).

Version d'installation recommandée du GPU gratuit

Q2_K_L

Démarrer l'installation de DeepSeek-R1 32B

De la façon d'obtenir un GPU gratuit jusqu'à ce qu'il soit installé Ollama Processus d'écrémage ou de lecture :Déploiement en ligne du modèle open-source DeepSeek-R1 avec une puissance GPU gratuiteLa seule différence avec le tutoriel précédent est une légère modification de la commande d'installation.

Allez directement au processus d'installation d'une version quantifiée spécifique dans Ollama. Heureusement, Ollama a simplifié à l'extrême l'ensemble du processus d'installation, ne nécessitant qu'une seule commande d'installation à apprendre.

1. installer le modèle de version quantitative huggingface format de commande de base

N'oubliez pas le format de commande d'installation suivant

ollama run hf.co/{username}:{reponame}

2. sélection de la version quantitative

Liste de toutes les versions quantitatives : https://huggingface.co/unsloth/DeepSeek-R1-Distill-Qwen-32B-GGUF/tree/main

Cette installation utilise : Q5_K_M (à des fins de démonstration uniquement, l'optionEncore une fois, installez la version gratuite recommandée par le GPU !(Q5 nécessite 23G d'espace sur le disque dur pour l'installation)

3. commande d'installation d'épissures

{username}=unsloth/DeepSeek-R1-Distill-Qwen-32B-GGUF

{reponame}=Q5_K_M

Splice pour obtenir la commande d'installation complète :ollama run hf.co/unsloth/DeepSeek-R1-Distill-Qwen-32B-GGUF:Q5_K_M

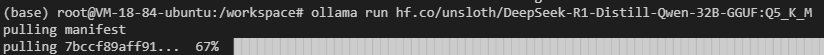

4) Effectuer l'installation dans Ollama

Exécuter la commande d'installation

Il se peut que vous rencontriez des problèmes de réseau (bonne chance), répétez la commande d'installation plusieurs fois...

Cela ne fonctionne toujours pas ? Exécutez la commande suivante pour essayer (basculer vers l'adresse miroir nationale) :ollama run https://hf-mirror.com/unsloth/DeepSeek-R1-Distill-Qwen-32B-GGUF:Q5_K_M

Pourquoi ne pas utiliser l'adresse du miroir pour télécharger, au lieu d'utiliser d'abord l'adresse officielle puis le miroir ?

En effet, l'installation intégrée est plus rapide !

Bien sûr, vous n'avez peut-être pas besoin de cette version quantifiée, voici une version populaire plus récente et non censurée : ollama run huihui_ai/deepseek-r1-abliterated:14b

5. rendre Ollama accessible aux exclus

Confirmez le port Ollama en entrant la commande dans le terminal

ollama serve

11414 ou 6399

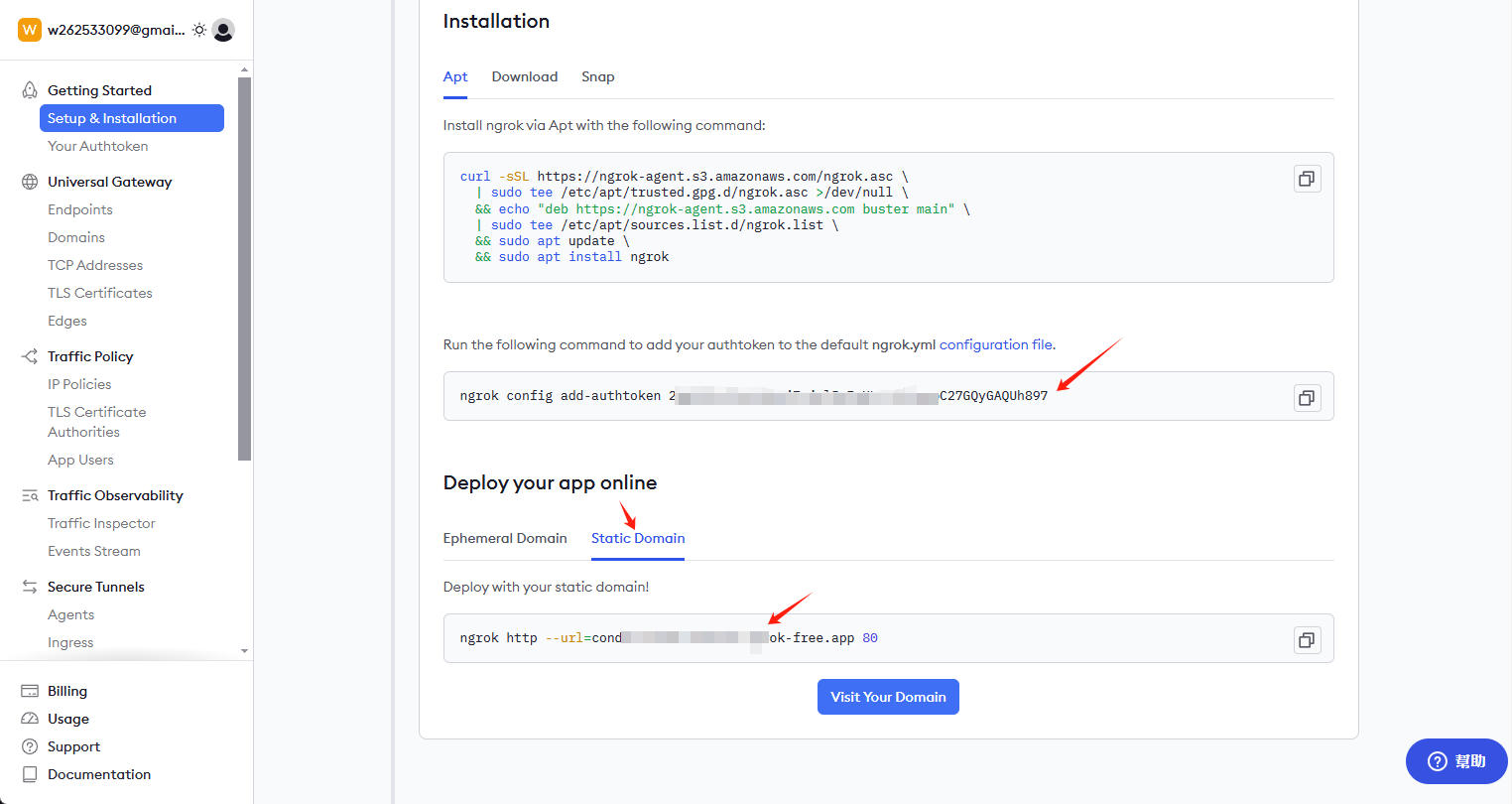

Installation de ngrok

curl -sSL https://ngrok-agent.s3.amazonaws.com/ngrok.asc \ | tee /etc/apt/trusted.gpg.d/ngrok.asc >/dev/null \ && echo "deb https://ngrok-agent.s3.amazonaws.com buster main" \ | tee /etc/apt/sources.list.d/ngrok.list \ && apt update \ && apt install ngrok

Obtenir la clé et le lien permanent

Visitez ngrok.com pour ouvrir un compte et allez sur la page d'accueil pour obtenir la clé et le lien permanent.

Installer la clé et activer l'adresse d'accès externe

Entrez la commande suivante dans le client :

ngrok config add-authtoken 这里是你自己的密钥

Continuez à entrer les commandes suivantes pour ouvrir l'accès externe : 6399 ce port peut être différent de chacun, vérifiez et modifiez le vôtre

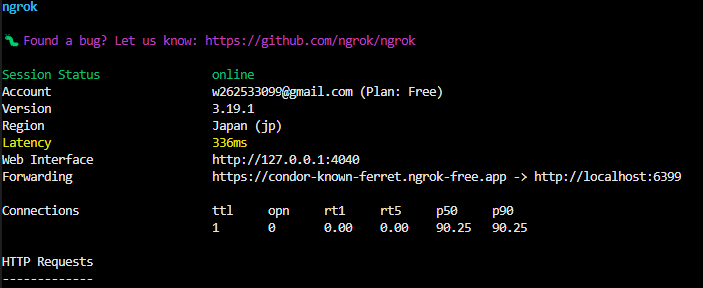

ngrok http --url=condor-known-ferret.ngrok-free.app 6399

Après avoir réussi, vous verrez dans le terminal

https://condor-known-ferret.ngrok-free.app est l'adresse d'accès à l'interface du modèle, ouvrez-la et vous verrez le contenu suivant

utiliser

Obtenu à partir de https://condor-known-ferret.ngrok-free.app如何使用 ?

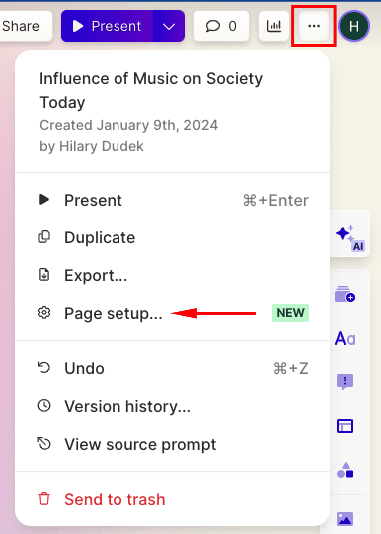

La manière la plus simple d'y parvenir est d'installer Page Assist Utilisé conjointement, l'outil est un plugin de navigateur qui s'installe de lui-même.

configurer

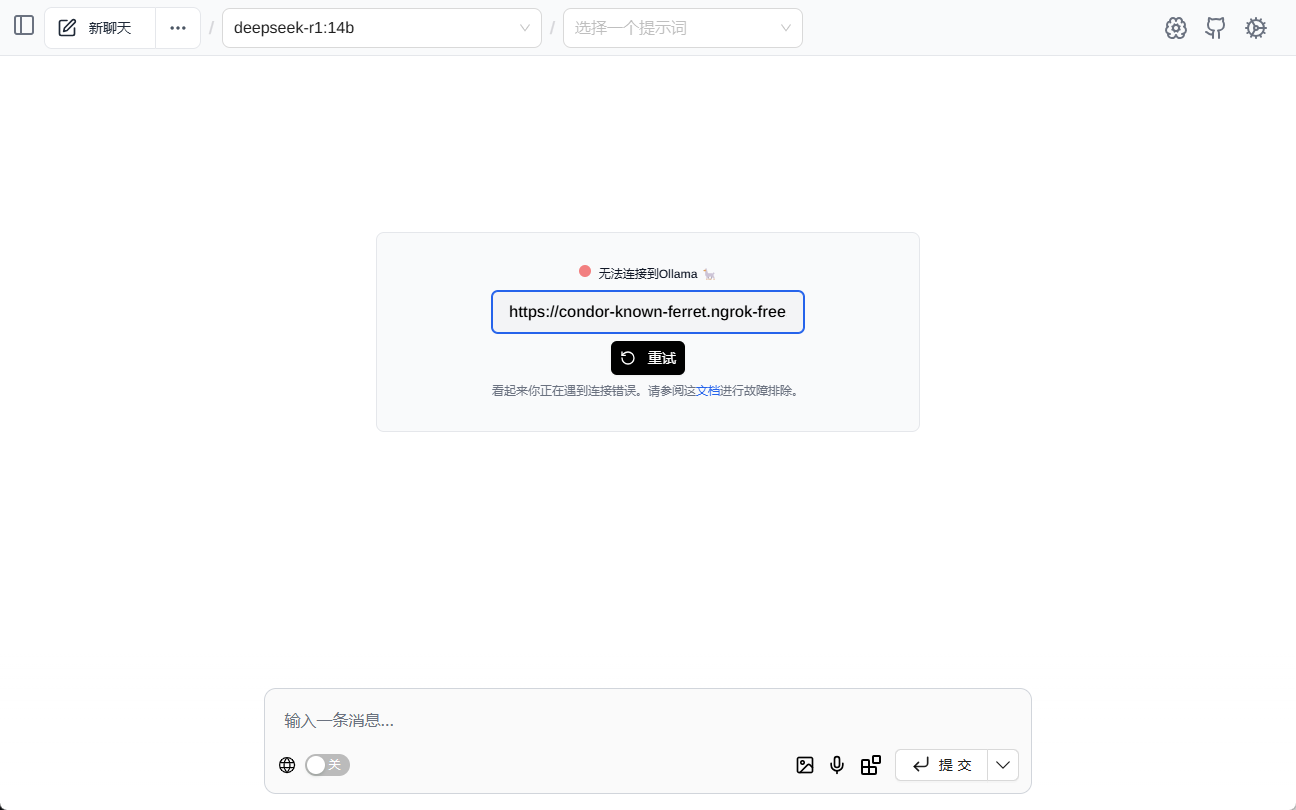

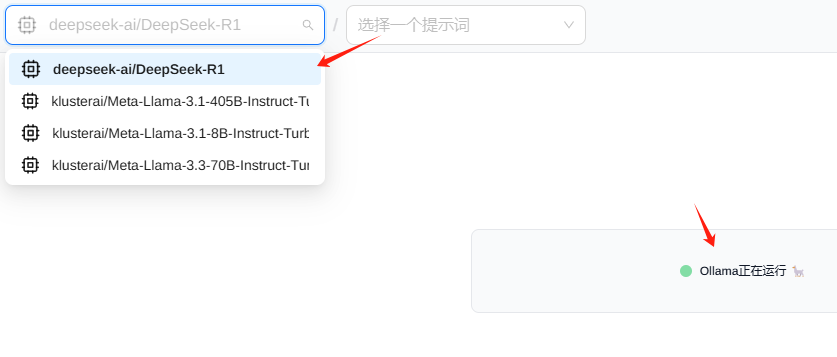

spectacle (un billet) Page Assist Après cela, vous verrez l'interface suivante, veuillez remplir l'adresse de l'interface

Normalement, le modèle est chargé automatiquement.

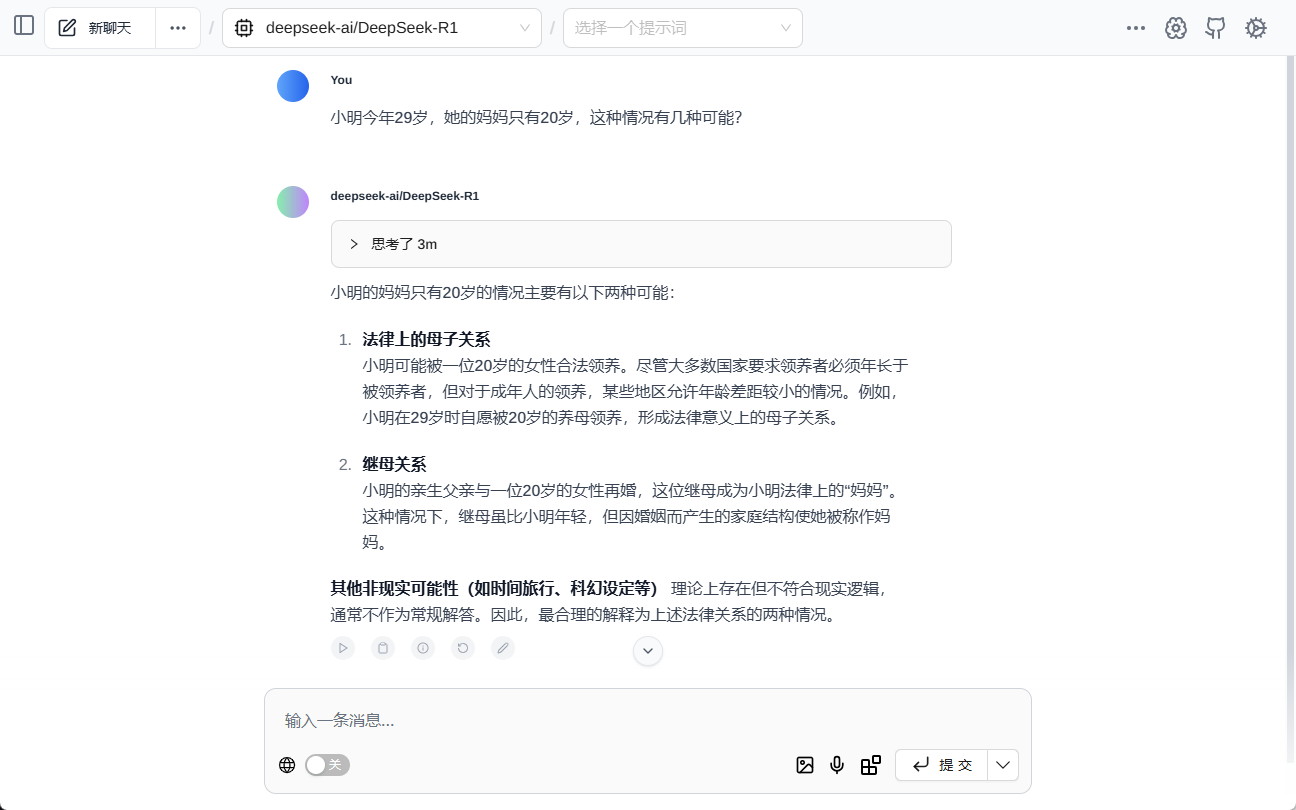

test (machines, etc.)

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...