Les produits PC Microsoft Azure+Copilot+AI prennent entièrement en charge les modèles DeepSeek R1

Le 30 janvier 2025, Microsoft a annoncé que le modèle R1 de DeepSeek était désormais disponible sur sa plateforme de cloud computing Azure et sur les outils GitHub pour les développeurs en général. Microsoft a également indiqué que les clients pourront bientôt utiliser le modèle R1 de DeepSeek sur leur site Web. Copilote + Exécuter le modèle R1 localement sur le PC.

Comme nous l'avons mentionné précédemment, copilot utilisera progressivement d'autres grands modèles que OpenAI :

Microsoft a fait parler d'elle ces derniers temps, et l'un des éléments les plus marquants est que l'entreprise a été mise à l'écart de l'actualité.Le copilote de GitHub est gratuit et ouvert !Le modèle a été élargi, bien qu'en plus petit nombre (2 000 par mois pour les complétions de code et 50 par mois pour les conversations en ligne), mais il s'agit au moins d'un événement marquant, et le modèle a été élargi de l'unique GPT 4o initial à o1 Claude répondre en chantant Gémeaux et de nombreux autres modèles.

Ce que cela signifie réellement, c'est que Microsoft s'éloigne maintenant de sa dépendance à l'égard de la technologie OpenAI qui, d'une certaine manière, n'est plus le meilleur modèle et n'est plus, je le crains, le plus rentable à exploiter.

À la suite de la récente recherche approfondie L'influence plus puissante dans le monde, une série de nouvelles fonctionnalités accrocheuses continuent d'être mises en ligne, mais ont également provoqué la concurrence entre la Chine et les États-Unis dans le domaine de l'IA, Microsoft afin de rendre copilote un meilleur soutien pour la langue chinoise, prêt à utiliser le modèle R1 de Deepseek dans copilote.

Le PDG de Microsoft, M. Indian, a également souligné lors de l'appel que les modèles DeepSeek R1 sont désormais disponibles sur la plateforme d'IA de Microsoft, Azure AI Foundry, et sur GitHub, et qu'ils pourront bientôt être exécutés sur les ordinateurs Copilot+. M. Nadella a déclaré que DeepSeek "présente de réelles innovations" et que le coût de l'IA a tendance à baisser : "La loi d'échelle s'accumule dans les calculs de pré-entraînement et de temps d'inférence. Au fil des ans, nous avons constaté des améliorations significatives dans l'efficacité de la formation et de l'inférence de l'IA. En ce qui concerne l'inférence, nous constatons généralement une amélioration de plus de 2 fois le rapport prix/performance par génération de matériel et de plus de 10 fois le rapport prix/performance par génération de modèles."

Nous nous en réjouissons.

copilot for Microsoft 365 est un plugin copilot natif pour office 365 (word, excel, ppt, OneNote, teams, etc.), qui permet de générer du contenu basé sur d'autres fichiers dans word, de générer des formules et des calculs dans excel, de créer des présentations basées sur d'autres fichiers dans PPT. Vous pouvez également créer des présentations à partir d'autres documents dans PPT, organiser des notes et en générer d'autres dans OneNote, résumer des réunions dans teams, et bien plus encore.

Lecture associée 1 : "Exécution locale de modèles DeepSeek R1 optimisés par distillation sur les PC Copilot+".

L'IA se déplace vers la périphérie, et les PC Copilot+ ouvrent la voie. Alors qu'Azure AI Foundry lance DeepSeek R1 hébergé dans le nuage (lire à ce sujet2), nous apportons une version de DeepSeek-R1 optimisée pour les NPU directement sur les PC Copilot+, avec les premières adaptations pour la plateforme Qualcomm Snapdragon X, suivies de la prise en charge de plateformes telles que Intel Core Ultra 200V. La première version de DeepSeek-R1-Distill-Qwen-1.5B sera disponible sur AI Toolkit, et les versions 7B et 14B suivront. Ces modèles optimisés permettent aux développeurs de créer et de déployer des applications d'IA qui fonctionnent efficacement sur l'appareil, en tirant pleinement parti de la puissance du NPU dans les PC Copilot+.

L'unité de traitement neuronal (NPU) de Copilot+ PC fournit un moteur très efficace pour l'inférence de modèles, ouvrant un nouveau paradigme pour l'IA générative, non seulement pour fonctionner à la demande, mais aussi pour permettre des services fonctionnant de manière semi-continue. Cela permet aux développeurs de créer des expériences continues proactives avec des moteurs d'inférence puissants. Grâce à l'accumulation de technologies issues du projet Phi Silica, nous sommes parvenus à une inférence efficace, minimisant l'autonomie de la batterie et la consommation des ressources du système tout en garantissant des temps de réponse et des débits compétitifs pour les premiers tokens.Le modèle DeepSeek optimisé par la NPU utilise un certain nombre de technologies clés issues du projet, notamment : modèle Le modèle DeepSeek optimisé par le NPU utilise un certain nombre de technologies clés du projet, notamment : la conception modulaire du modèle pour un équilibre optimal entre performance et efficacité, les techniques de quantification à faible largeur de bits et la stratégie de mappage de Transformer sur le NPU. En outre, nous nous appuyons sur le Windows Copilot Runtime (WCR) pour permettre une mise à l'échelle dans l'écosystème Windows via le format ONNX QDQ.

Faites-en l'expérience dès maintenant !

Tout d'abord... Commençons rapidement.

Pour expérimenter DeepSeek sur les PC Copilot+, il suffit de télécharger l'extension VS Code pour AI Toolkit. Les modèles DeepSeek optimisés au format QDQ d'ONNX seront bientôt disponibles dans le référentiel de modèles d'AI Toolkit et tirés directement de l'Azure AI Foundry. Cliquez sur le bouton "Download" pour télécharger localement. Une fois téléchargé, il suffit d'ouvrir le terrain de jeu, de charger le modèle "deepseek_r1_1_5" et de commencer à expérimenter avec les invites.

En plus du modèle ONNX optimisé pour Copilot+ PC, vous pouvez également utiliser le modèle ONNX pour Copilot+ PC en cliquant sur le bouton "DeepSeek R1"Try in". Terrain de jeux"pour découvrir le modèle original hébergé en nuage dans Azure Foundry.

L'AI Toolkit est une partie importante du flux de travail des développeurs, supportant l'expérimentation de modèles et la préparation au déploiement. Avec ce terrain de jeu, vous pouvez facilement tester les modèles DeepSeek dans Azure AI Foundry pour un déploiement local.

Optimisation au niveau de la puce

Le modèle Qwen 1.5B optimisé par distillation contient un tokenizer, une couche d'intégration, un modèle de traitement du contexte, un modèle d'itération des tokens, un en-tête de modèle linguistique et un module de détokenizer.

Nous utilisons la quantification par morceaux de 4 bits pour la couche d'intégration et l'en-tête du modèle de langage et exécutons ces opérations à forte intensité de mémoire sur l'unité centrale. En concentrant les principales ressources d'optimisation de l'unité centrale sur le module Transformer à forte intensité de calcul contenant le traitement du contexte et l'itération des jetons, la quantification canal par canal int4 est utilisée et un traitement sélectif en précision mixte est mis en œuvre pour les poids, tandis que les valeurs d'activation utilisent la précision int16.

Bien que la version 1.5B de Qwen de DeepSeek comporte une version int4, elle ne peut pas être directement adaptée aux NPU en raison de la présence de formes et de comportements d'entrée dynamiques - ceux-ci doivent être optimisés pour assurer la compatibilité et une efficacité optimale. En outre, nous utilisonsONNX QDQpour prendre en charge la mise à l'échelle de divers types de NPU dans l'écosystème Windows. Nous optimisons la disposition des opérateurs entre le CPU et le NPU afin d'obtenir le meilleur équilibre entre la consommation d'énergie et la vitesse.

Pour atteindre le double objectif d'une faible empreinte mémoire et d'une inférence rapide (similaire au schéma Phi Silica), nous apportons deux améliorations clés : premièrement, nous adoptons une conception à fenêtre coulissante, qui permet un temps de réponse ultra-rapide au premier jeton et une prise en charge des contextes longs, même lorsque la pile matérielle ne prend pas en charge le tenseur dynamique ; deuxièmement, nous utilisons un schéma de quantification QuaRot à 4 bits, qui tire pleinement parti du traitement à faible largeur de bits. QuaRot élimine les valeurs aberrantes des poids et des valeurs d'activation par une rotation de Hadamard, ce qui facilite la quantification du modèle. Par rapport aux méthodes existantes telles que GPTQ, QuaRot améliore considérablement la précision de la quantification, en particulier dans les scénarios à faible granularité tels que la quantification canal par canal. La combinaison de la quantification à faible largeur de bits et des optimisations matérielles telles que la conception de la fenêtre coulissante permet au modèle d'atteindre les propriétés comportementales d'un grand modèle avec une empreinte mémoire compacte. Grâce à ces optimisations, le modèle atteint un temps de réponse au premier jeton de 130 ms et un débit de 16 jetons/seconde dans des scénarios de repères courts (<64 jetons).

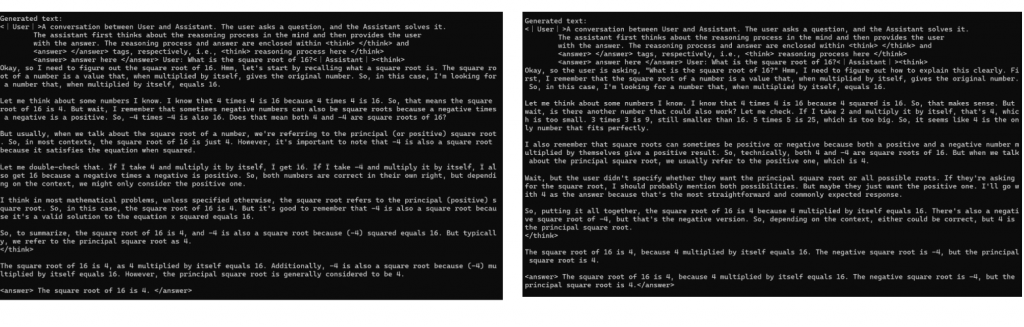

Nous démontrons les différences subtiles entre la réponse du modèle original et la réponse du modèle quantitatif à l'aide de l'exemple suivant, qui permet d'optimiser l'efficacité énergétique tout en maintenant des performances élevées :

Fig. 1 : Comparaison qualitative. Exemples du modèle original (à gauche) et du modèle optimisé par NPU (à droite) répondant aux mêmes indices, y compris une démonstration du pouvoir de raisonnement du modèle. Le modèle optimisé conserve le schéma de raisonnement du modèle original et parvient à la même conclusion, ce qui prouve qu'il conserve intact le pouvoir de raisonnement du modèle original.

Grâce à la vitesse supérieure et à l'efficacité énergétique du modèle DeepSeek R1 optimisé par le NPU, les utilisateurs pourront interagir avec ces modèles révolutionnaires localement et de manière totalement autonome.

Related reading 2 : "DeepSeek R1 désormais disponible sur Azure AI Foundry et GitHub

DeepSeek R1 est maintenant disponible Azure AI Foundry et le catalogue de modèles de GitHub, rejoignant un portefeuille diversifié de plus de 1 800 modèles couvrant des modèles d'IA de pointe, open-source, spécifiques à l'industrie et orientés vers les tâches. En tant que partie intégrante d'Azure AI Foundry, DeepSeek R1 est accessible via une plateforme fiable, évolutive et prête pour l'entreprise qui permet aux organisations d'intégrer de manière transparente des technologies d'IA avancées tout en respectant les accords de niveau de service, la sécurité et la promesse d'une IA responsable - le tout soutenu par la fiabilité et l'innovation de Microsoft. Le tout soutenu par la fiabilité et l'innovation de Microsoft.

Accélérer le raisonnement de l'IA pour les développeurs Azure AI Foundry

Le raisonnement par l'IA gagne en popularité à un rythme alarmant, changeant la façon dont les développeurs et les entreprises appliquent l'intelligence de pointe. Comme l'explique DeepSeek, R1 fournit des modèles puissants et rentables qui permettent à un plus grand nombre d'utilisateurs d'accéder aux capacités d'IA les plus avancées avec un investissement minimal dans l'infrastructure.

Le principal avantage de l'utilisation de DeepSeek R1 ou d'autres modèles dans Azure AI Foundry est la vitesse à laquelle les développeurs peuvent expérimenter, itérer et intégrer l'IA dans leurs flux de travail. Grâce aux outils intégrés d'évaluation des modèles, les développeurs peuvent rapidement comparer les résultats, évaluer les performances et mettre à l'échelle les applications basées sur l'IA. Cet accès rapide, inimaginable il y a encore quelques mois, est au cœur de notre vision d'Azure AI Foundry : rassembler les meilleurs modèles d'IA en un seul endroit, accélérer l'innovation et débloquer de nouvelles possibilités pour les organisations du monde entier.

Développer avec l'IA de confiance

Nous nous engageons à aider nos clients à créer rapidement des applications d'IA prêtes pour la production tout en maintenant les normes de sécurité les plus élevées. deepSeek R1 a passé des tests rigoureux en équipe rouge et des évaluations de sécurité, y compris des évaluations automatisées du comportement du modèle et un examen complet de la sécurité pour atténuer les risques potentiels. Le filtrage de contenu intégré est activé par défaut avec des options de retrait flexibles via Azure AI Content Security. En outre, un système d'évaluation de la sécurité aide les clients à tester efficacement les applications avant leur déploiement. Ces mesures de protection permettent à Azure AI Foundry de fournir aux organisations un environnement sécurisé, conforme et responsable pour le déploiement de solutions d'IA.

Comment utiliser DeepSeek dans un catalogue de modèles ?

- Si vous n'avez pas d'abonnement Azure, vous pouvez maintenantS'inscrire à un compte Azure

- Recherche de DeepSeek R1 dans le catalogue de modèles

- Ouvrez la carte de modèle dans le catalogue de modèles d'Azure AI Foundry.

- Cliquez sur "Deploy" pour obtenir l'API d'inférence et la clé et accéder au banc d'essai.

- Vous serez dirigé vers la page de déploiement indiquant l'API et la clé dans une minute et vous pourrez essayer de saisir les invites dans le banc d'essai.

- L'API et la clé peuvent être utilisées par divers clients

Commencer maintenant

DeepSeek R1 est désormais accessible via un point de terminaison sans serveur dans le catalogue de modèles Azure AI Foundry.Accédez à Azure AI Foundry dès aujourd'hui et sélectionnez le modèle DeepSeek.

Explorez plus de ressources et obtenez un guide étape par étape pour intégrer DeepSeek R1 dans votre application sur GitHub. Lire Modèles GitHub Blog Post.

Prochainement : les clients pourront utiliser localement sur les PC Copilot+ un modèle allégé de DeepSeek R1. En savoir plus Développeur Windows Blog Post.

Alors que nous continuons à développer le catalogue de modèles d'Azure AI Foundry, nous sommes impatients de voir comment les développeurs et les entreprises utilisent DeepSeek R1 pour relever les défis du monde réel et créer des expériences transformatrices. Nous nous engageons à fournir le portefeuille le plus complet de modèles d'IA afin de garantir que les organisations de toutes tailles aient accès à des outils de pointe pour stimuler l'innovation et le succès.

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...