voyage-3 et voyage-3-lite : une nouvelle génération de modèles d'intégration polyvalents, petits mais puissants

résumés - Nous avons le plaisir d'annoncer le lancement de voyage-3 répondre en chantant voyage-3-lite des modèles intégrés qui ont atteint de nouveaux sommets en termes de qualité de recherche, de latence et de coût.voyage-3 Amélioration moyenne des performances de 7,55% par rapport à OpenAI v3 large dans tous les domaines d'évaluation, y compris le code, le juridique, la finance, le multilingue et les contextes longs, ainsi qu'une réduction des coûts de 2,2 fois et une réduction des dimensions d'intégration de 3 fois, ce qui se traduit par une réduction du coût de vectorDB de 3 fois.voyage-3-lite Il améliore la précision de la recherche de 3,82% par rapport à OpenAI v3 large, réduit le coût par un facteur de 6, et réduit les dimensions d'intégration par un facteur de 6. Les deux modèles prennent en charge une longueur de contexte de 32 000 jetons, soit 4 fois plus que l'OpenAI.

Au cours des neuf derniers mois, nous avons lancé la série Voyage 2 de kits de modélisation embarqués, qui comprennent des fonctionnalités telles que le système de gestion de l'information et le système de gestion de l'information. voyage-large-2 Ces modèles généraux de pointe, ainsi qu'un certain nombre de modèles spécifiques à un domaine, tels que voyage-code-2,voyage-law-2,voyage-finance-2 répondre en chantant voyage-multilingual-2Tous ces modèles sont entraînés de manière adéquate sur des données provenant de leurs domaines respectifs. Par exemple.voyage-multilingual-2 D'excellentes performances en français, allemand, japonais, espagnol et coréen, ainsi que les meilleures performances de sa catégorie en anglais. Nous avons également affiné le modèle pour des cas d'utilisation spécifiques et des données pour des organisations spécifiques, telles que Harvey.ai du modèle d'intégration juridique.

Nous avons maintenant le plaisir de présenter la gamme de modèles embarqués Voyage 3, qui comprend les éléments suivants voyage-3 répondre en chantant voyage-3-liteet sera disponible dans quelques semaines voyage-3-large. Ces modèles sont plus performants que ceux de la concurrence en termes de qualité de recherche, tout en réduisant de manière significative le prix et le coût ultérieur de vectorDB. Plus précisément.voyage-3 Avec les caractéristiques suivantes :

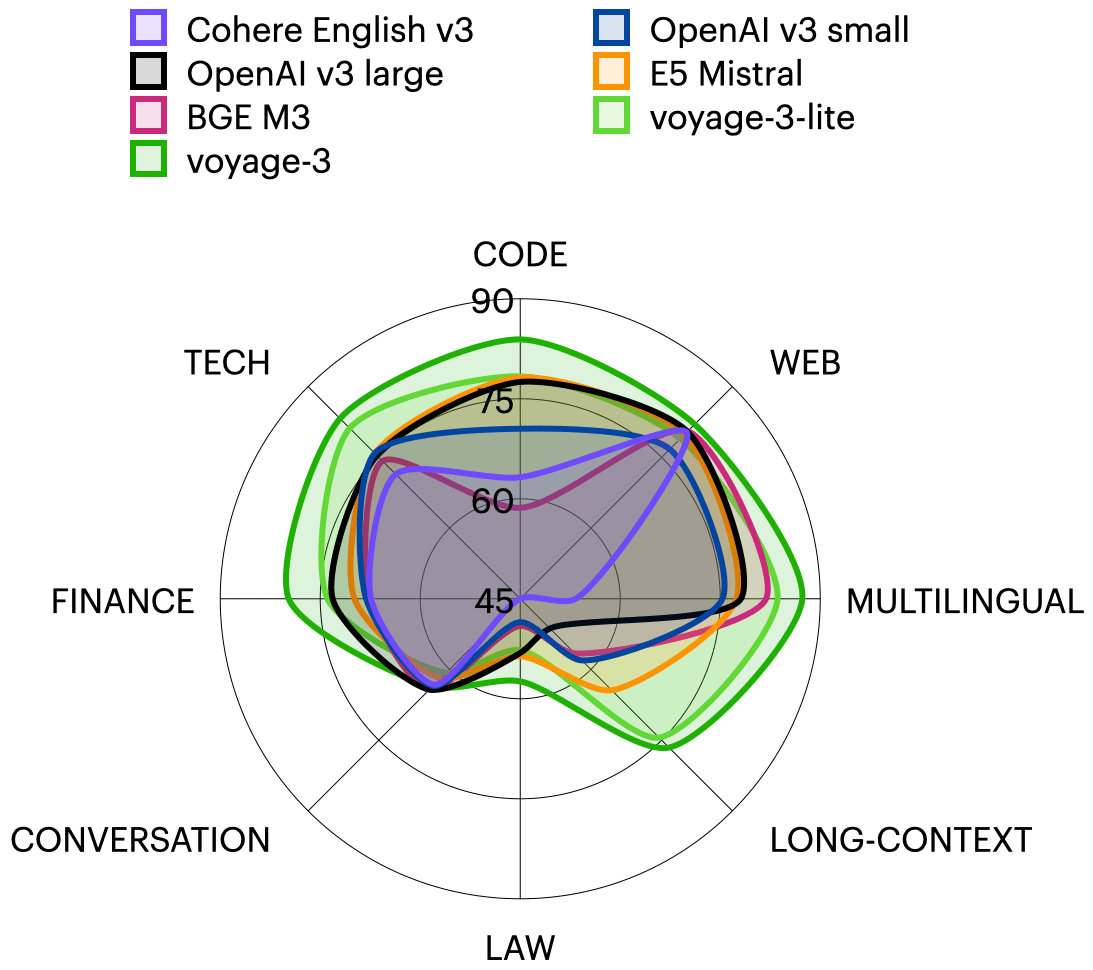

- Les performances sont en moyenne supérieures de 7,55% à celles de l'OpenAI v3 large dans les huit domaines d'évaluation (technique, code, web, juridique, financier, multilingue, protection et contexte long).

- Coûts 2,2x inférieurs à ceux d'OpenAI v3 large, 2,2x inférieurs à ceux d'OpenAI v3 large, 2,2x inférieurs à ceux d'OpenAI v3 large. Cohère L'anglais v3 est 1,6 fois moins élevé pour 1 million d'habitants. jetons Le coût est de $0.06.

- dimension d'intégration que l'OpenAI (3072) et l'E5 Mistral (4096) est 3 à 4 fois plus petit (1024), ce qui réduit le coût de vectorDB d'un facteur 3 à 4.

- Prise en charge de contextes de 32 000 jetons, contre 8 000 pour OpenAI et 512 pour Cohere.

voyage-3-lite est un modèle léger optimisé pour la latence et le faible coût, avec des caractéristiques telles que

- La performance moyenne sur l'ensemble des domaines est supérieure de 3,82% à celle de l'OpenAI v3 large.

- Le coût est 6,5 fois inférieur à celui de l'OpenAI v3 large, à $0,02 pour 1 million de jetons.

- Il surpasse OpenAI v3 small de 7,58% au même prix.

- La dimension d'intégration est 6 à 8 fois plus petite (512) que celle d'OpenAI (3072) et d'E5 Mistral (4096), ce qui réduit le coût de la base de données vectorielle de 6 à 8 fois.

- Prise en charge de contextes de 32 000 jetons, contre 8 000 pour OpenAI et 512 pour Cohere.

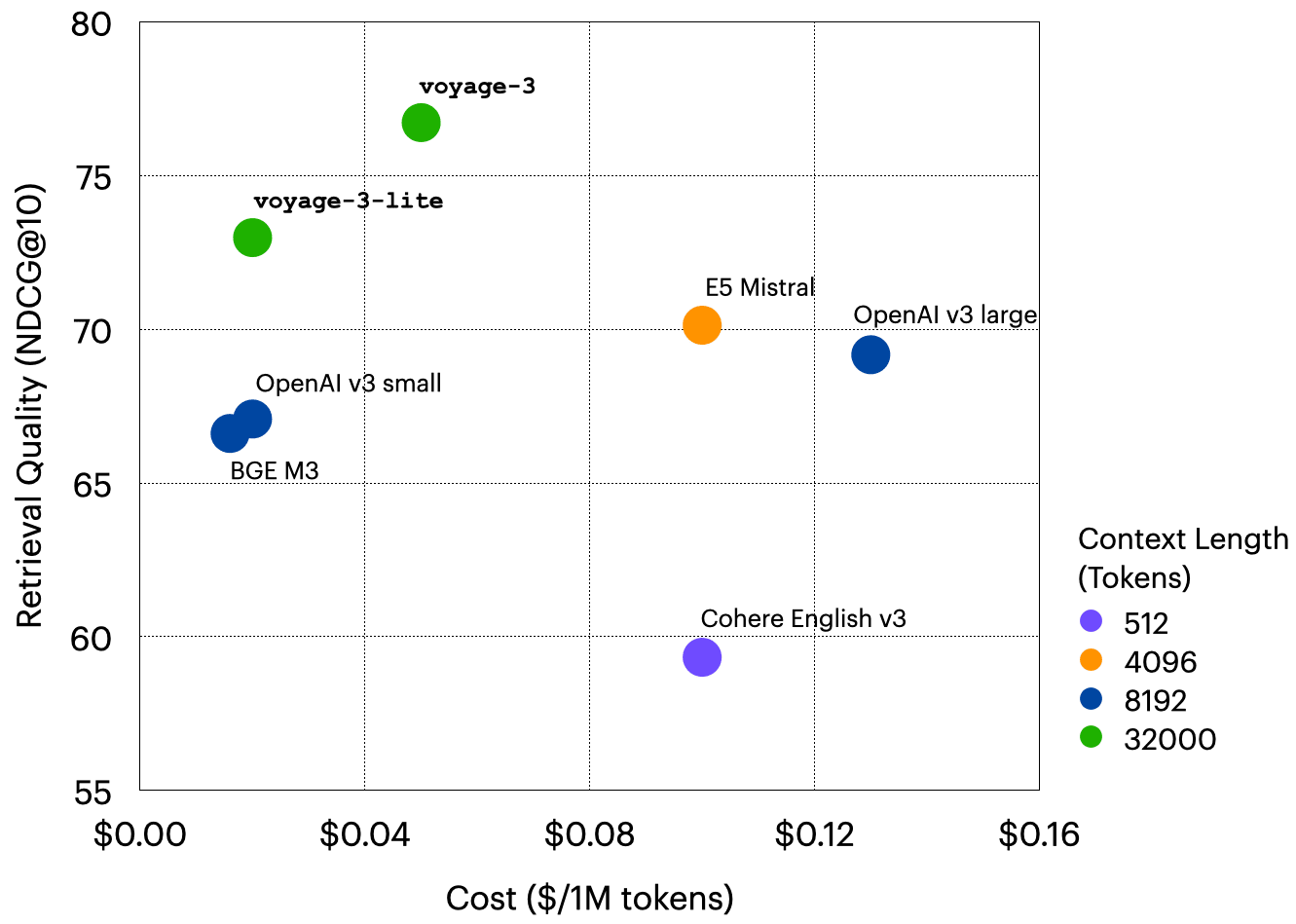

Le tableau suivant résume les aspects importants de ces modèles et de certains de leurs concurrents, et s'accompagne d'une représentation graphique de la relation entre la qualité de la recherche et le coût2 .

| modélisation | dimension (math.) | Contexte Longueur | Coût (par million de tokens) | Qualité de la recherche (NDCG@10) |

|---|---|---|---|---|

| voyage-3 | 1024 | 32K | $0.06 | 76.72 |

| voyage-3-lite | 512 | 32K | $0.02 | 72.98 |

| OpenAI v3 large | 3072 | 8K | $0.13 | 69.17 |

| OpenAI v3 petit | 1536 | 8K | $0.02 | 67.08 |

| Cohere English v3 | 1024 | 512 | $0.10 | 59.33 |

| E5 Mistral | 4096 | 4K | $0.10 | 70.13 |

| BGE M3 | 1024 | 8K | $0.016 | 66.61 |

voyage-3 répondre en chantant voyage-3-lite est le résultat d'un certain nombre d'innovations en matière de recherche, notamment des architectures améliorées, la distillation de modèles plus importants, plus de 2 000 milliards d'unités de haute qualité, et la mise en place d'un système de gestion de la qualité. Jeton de pré-entraînement, et l'alignement des résultats de recherche par le biais d'un retour d'information humain.

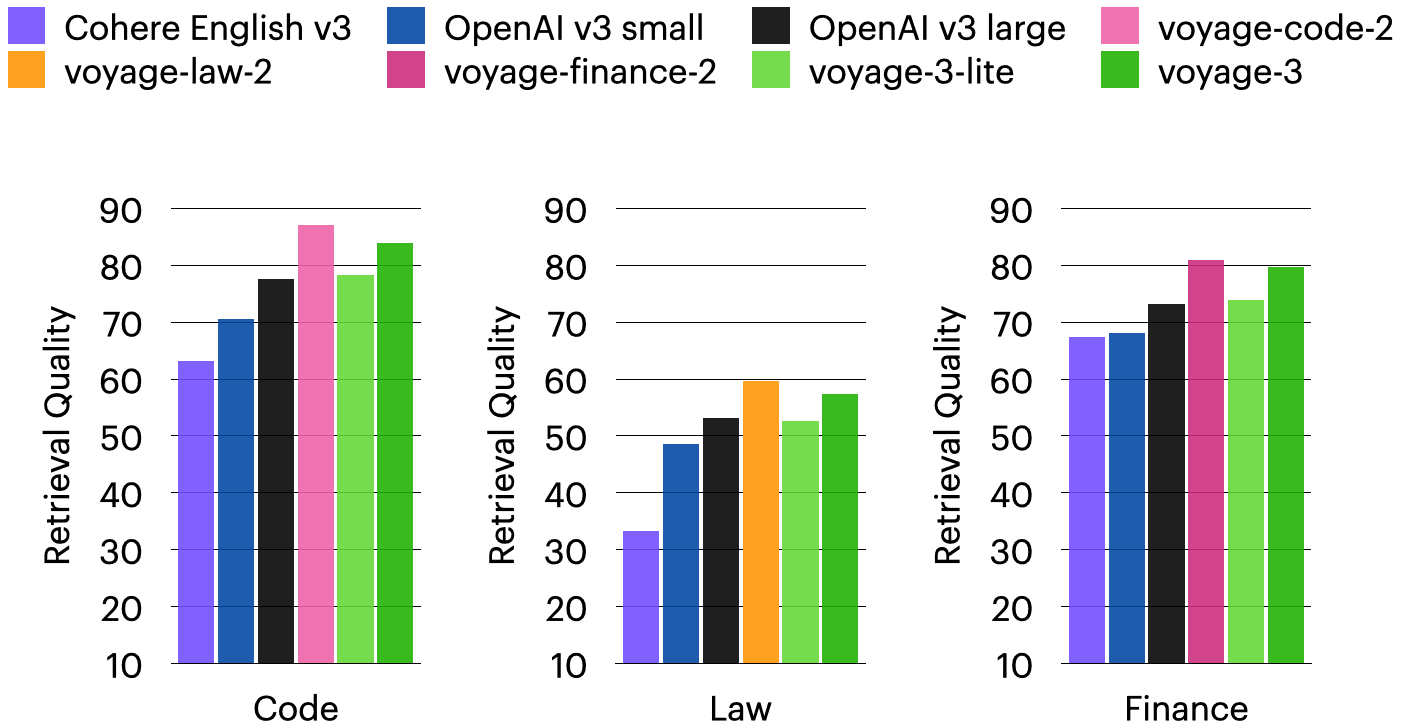

témoignages. Tout utilisateur générique embarqué peut passer à la version voyage-3 une meilleure qualité de recherche à un faible coût, ou choisir de voyage-3-lite Des économies supplémentaires. Si vous êtes particulièrement concerné par la recherche de codes, la recherche juridique, la recherche financière et la recherche multilingue, les modèles spécifiques au domaine de la série Voyage 2 (voyage-code-2,voyage-law-2,voyage-finance-2 répondre en chantant voyage-multilingual-2) restent le meilleur choix dans leurs domaines respectifs, même si les voyage-3 est également très compétitif (voir section ci-dessous). Si vous utilisez déjà Voyage Embedding, il vous suffit d'ajouter une nouvelle section à la page d'accueil de Voyage Embedding. API Voyage L'appel model Le paramètre est spécifié comme suit "voyage-3" peut-être "voyage-3-lite"qui peut être utilisé pour le corpus et l'interrogation.

Détails de l'évaluation

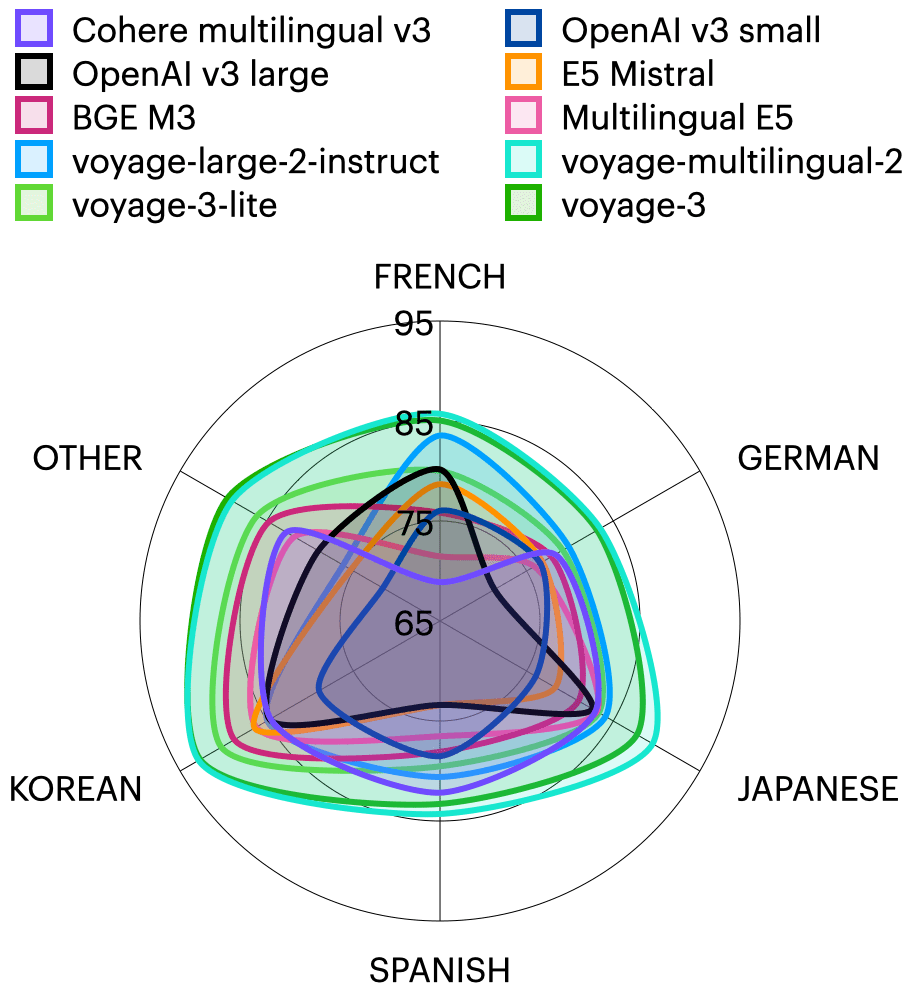

ensemble de données. Nous avons évalué 40 ensembles de données de recherche spécifiques à un domaine, couvrant huit domaines, dont les documents techniques, le code, le droit, la finance, les revues en ligne, les documents multilingues, les documents longs et les dialogues. Chaque ensemble de données contient un corpus à extraire et un ensemble de requêtes. Le corpus se compose généralement de documents dans un domaine particulier, tels que des réponses de StackExchange, des avis de tribunaux, des documents techniques, etc. ; les requêtes peuvent être des questions, des résumés de longs documents ou des documents individuels. Les requêtes peuvent être des questions, des résumés de longs documents ou des documents individuels. Le tableau ci-dessous répertorie les ensembles de données dans huit catégories en plus du domaine multilingue. Le domaine multilingue couvre 62 ensembles de données dans 26 langues, dont le français, l'allemand, le japonais, l'espagnol, le coréen, le bengali, le portugais et le russe. Les cinq premières de ces langues ont plusieurs ensembles de données, tandis que les autres langues contiennent un ensemble de données par langue et sont regroupées dans la catégorie AUTRES dans le diagramme radar multilingue ci-dessous.

| formulaire | descriptions | ensemble de données |

|---|---|---|

| compétence | document technique | Cohere, 5G, OneSignal, LangChain, PyTorch |

| codification | Extraits de code, chaînes de documents | LeetCodeCpp, LeetCodeJava, LeetCodePython, HumanEval, MBPP, DS1000-referenceonly, DS1000, apps_5doc |

| législation | Affaires, avis de la Cour, codes, brevets | LeCaRDv2, LegalQuAD, Résumé juridique, AILA casedocs, Statuts de l'AILA |

| financière | Dépôts auprès de la SEC, assurance qualité financière | RAG benchmark (Apple-10K-2022), FinanceBench, TAT-QA, Finance Alpaca, FiQA Personal Finance, Stock News Sentiment, ConvFinQA, FinQA, HC3 Finance |

| réticulation | Commentaires, messages sur les forums, pages de politique générale | Huffpostsports, Huffpostscience, Doordash, Health4CA |

| contexte long | Longs dossiers de rapports gouvernementaux, de documents universitaires, de dialogues, etc. | NarrativeQA, Aiguille, Passe-partout, QMSum, SummScreenFD, WikimQA |

| dialogues | Actes, dialogue | Somme de dialogue, Conv. AQ, AQG |

Une liste de tous les ensembles de données d'évaluation est disponible dans la section Cette feuille de calcul Voir dans.

modélisation. Nous avons évalué les voyage-3 répondre en chantant voyage-3-liteainsi qu'un certain nombre de modèles alternatifs, notamment : OpenAI v3 small (text-embedding-3-small) et de grande taille (text-embedding-3-large), E5 Mistral (intfloat/e5-mistral-7b-instruct), BGE M3 (BAAI/bge-m3Cohere English v3.embed-english-v3.0) et voyage-large-2-instruct. Pour les ensembles de données spécifiques à un domaine et multilingues, nous avons également évalué voyage-law-2,voyage-finance-2,voyage-multilingual-2Multilingue E5.infloat/multilingual-e5-large) et Cohere multilingue v3 (embed-multilingual-v3.0).

norme. Pour la requête, nous extrayons les 10 premiers documents sur la base de la similarité cosinus et nous indiquonsGain cumulé actualisé normalisé(NDCG@10), qui est un indicateur standard de la qualité de l'extraction et une variante du rappel.

en fin de compte

Recherche inter-domaines. Comme nous l'avons déjà mentionné, et comme le montre le premier graphique radar de ce document, lavoyage-3 est en moyenne 7.55% plus performant que l'OpenAI v3 large sur plusieurs domaines. en outre, comme le montre l'histogramme ci-dessous, l'OpenAI v3 large est plus performant que l'OpenAI v3 large sur plusieurs domaines.voyage-3 n'est que légèrement inférieure à celle du modèle spécifique au domaine de Voyage.

recherche multilingue. Comme le montre la carte radar ci-dessous.voyage-3 La qualité de la recherche multilingue n'est que légèrement inférieure à celle de la recherche en ligne. voyage-multilingual-2mais avec une latence plus faible et un coût deux fois moindre.voyage-3-lite Surpasse tous les modèles non Voyage de 4,55%, 3,13% et 3,89% par rapport à OpenAI v3 large, Cohere multilingual v3 et Multilingual E5 respectivement.

Tous les résultats des évaluations sont disponibles sur Cette feuille de calcul Voir dans.

Essayez la série Voyage 3 !

Essayez-le maintenant voyage-3 répondre en chantant voyage-3-lite! Les premiers 200 millions de Tokens sont gratuits. Rendez-vous sur notre fichier (informatique) Pour en savoir plus. Si vous souhaitez peaufiner l'intégration, nous serions ravis d'entendre parler de vous. contact@voyageai.com Nous contacter. Suivez-nous sur X (Twitter) répondre en chantant LinkedInet rejoignez notre Discord pour plus d'informations.

- Le NDCG@10 moyen pour Cohere English v3 sur les ensembles de données LAW et LONG-CONTEXT est respectivement de 33,32% et de 42,48%. Dans la visualisation du radargramme, nous avons arrondi ces valeurs à 45%.

- E5 Mistral et BGE M3 sont des modèles open source. Nous utilisons $0.10 comme coût de E5 Mistral, ce qui correspond à la norme de l'industrie pour les modèles paramétriques 7B, et $0.016 pour BGE M3, ce qui est basé sur le coût de Fireworks.ai pour les modèles paramétriques 350M. prix Estimation.

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...

![[转]Deepseek R1可能找到了超越人类的办法](https://aisharenet.com/wp-content/uploads/2025/01/5caa5299382e647.jpg)