VITA : Open Source Multimodal Large Language Models for Real-Time Visual and Speech Interaction (modèles multimodaux de langage à grande échelle pour l'interaction visuelle et vocale en temps réel)

Introduction générale

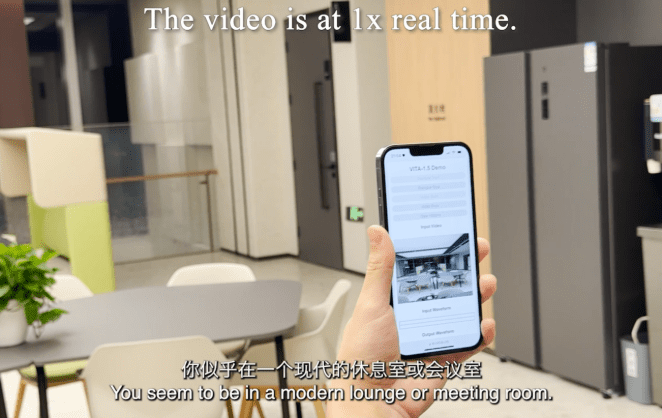

VITA est un projet open source de modélisation interactive multimodale du langage, pionnier dans la capacité à réaliser une véritable interaction multimodale complète. Le projet a lancé VITA-1.0 en août 2024, inaugurant le premier modèle de langage interactif multimodal à code source ouvert, et en décembre 2024, le projet a lancé une version de mise à jour majeure, VITA-1.5, qui améliore considérablement l'expérience d'interaction et les performances.Le modèle VITA prend en charge les entrées et sorties multimodales, telles que l'image, la vidéo et l'audio, et est équipé de capacités d'interaction en temps réel, réduisant considérablement la latence d'interaction vocale de bout en bout de 4 secondes à 1,5 seconde. Le modèle VITA prend en charge les entrées et sorties multimodales telles que l'image, la vidéo et l'audio, et dispose de capacités d'interaction en temps réel, ce qui réduit considérablement le temps de latence de l'interaction vocale de bout en bout de 4 secondes à 1,5 seconde, améliorant ainsi grandement l'expérience de l'utilisateur. En tant que projet à code source ouvert, VITA constitue une plateforme idéale pour les chercheurs et les développeurs qui souhaitent explorer l'IA multimodale.

Liste des fonctions

- Traitement multimodal des entrées : prend en charge les images, la vidéo, l'audio et d'autres formes d'entrées.

- Interaction vocale en temps réel : latence de l'interaction vocale de bout en bout de seulement 1,5 seconde

- Capacités d'analyse visuelle : puissantes capacités de compréhension et d'analyse d'images et de vidéos

- Traitement audio : prise en charge de la reconnaissance et de la synthèse vocales

- Compréhension multimodale : vers une corrélation intelligente entre le texte, l'image et l'audio

- Support open source : l'ensemble du code de formation et d'inférence est ouvert

- Modèles pré-entraînés : plusieurs versions de modèles pré-entraînés sont disponibles

- Options de déploiement flexibles : prise en charge des déploiements de plates-formes matérielles multiples

Vue d'ensemble de VITA-1.5

Le 12 août 2024, nous avons publié le VITA-1.0Il s'agit de Le premier modèle de macrolangue multimodale interactive tout-en-un à source ouverte. Et maintenant (20 décembre 2024), nous vous présentons la Nouvelle version VITA-1.5!

Quelles sont les nouveautés de VITA-1.5 ?

Nous avons le plaisir de vous présenter VITA-1.5qui a introduit une série d'avancées :

- Réduction significative de la latence d'interaction.. La latence de l'interaction vocale de bout en bout est passée de Environ 4 secondes Réduction à 1,5 secondepermettant une interaction quasi instantanée et améliorant considérablement l'expérience de l'utilisateur.

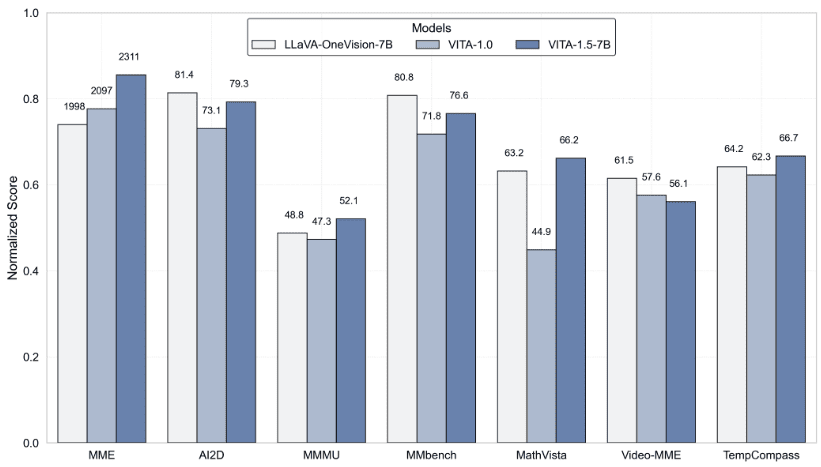

- Amélioration des performances multimodales. En MME,MMBench répondre en chantant MathVista La performance moyenne dans les benchmarks multimodaux, tels que le 59.8 l'élever à 70.8.

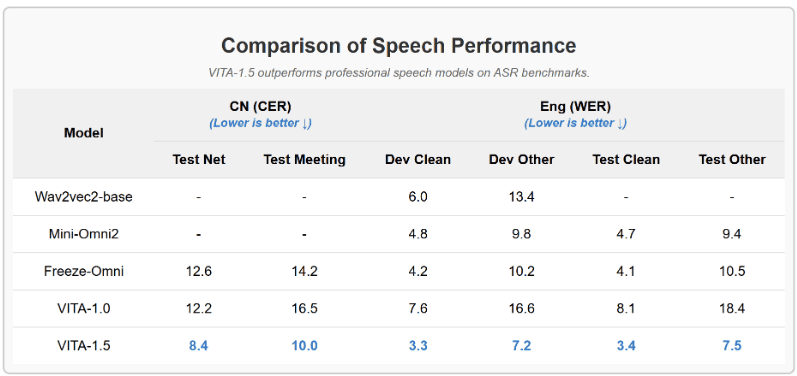

- Amélioration des capacités de traitement de la parole.. Un nouveau niveau de puissance de traitement de la parole a été atteint, avec un ASR WER (Word Error Rate, Test Other) qui est passé de 18.4 Réduire à 7.5. En outre, nous avons utilisé Module TTS de bout en bout Remplace le module TTS autonome de VITA-1.0, qui accepte en entrée l'intégration de grands modèles linguistiques.

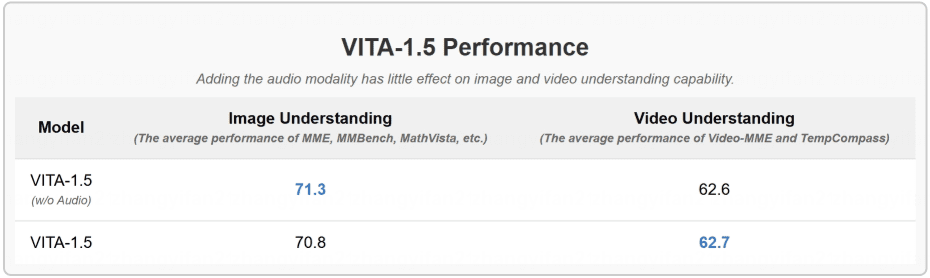

- Stratégies d'entraînement progressif. Ainsi, l'inclusion du module vocal a peu d'effet sur les autres performances multimodales (visuelles-verbales). La performance moyenne de la compréhension des images n'a diminué que de 71,3 à 70,8.

Résultats

- Évaluation des tests de référence pour la compréhension des images et des vidéos

- VITA-1.5 surpasse les modèles vocaux professionnels dans les tests de référence ASR

- L'inclusion de la modalité audio a peu d'effet sur la compréhension des images et des vidéos.

Utiliser l'aide

1. configuration et installation de l'environnement

1.1 Exigences relatives aux fondations :

- Environnement Python

- Cadre PyTorch

- Prise en charge de CUDA (accélération GPU recommandée)

1.2 Étapes de l'installation :

# 克隆项目仓库

git clone https://github.com/VITA-MLLM/VITA.git

cd VITA

# 安装依赖

pip install -r requirements.txt

2. utilisation de modèles

2.1 Chargement du modèle pré-entraîné :

from vita.model.builder import load_pretrained_model

from vita.conversation import conv_templates

from vita.util.mm_utils import get_model_name_from_path

# 加载模型

model_path = 'VITA/vita'

model_name = get_model_name_from_path(model_path)

tokenizer, model, image_processor, _ = load_pretrained_model(

model_path,

None,

model_name,

model_type='mixtral-8x7b',

device_map='auto'

)

2.2 Configuration du traitement audio :

# 初始化音频编码器

audio_encoder = model.get_audio_encoder()

audio_encoder.to(dtype=torch.float16)

audio_processor = audio_encoder.audio_processor

3. fonctions interactives en temps réel

- Prise en charge de la saisie et de la réponse vocales en temps réel

- Reconnaissance et analyse d'images intégrées

- Prise en charge des interactions de dialogue à plusieurs tours

- Fournir un système complet de modèles de dialogue

4. utilisation des fonctions avancées

4.1 Traitement multimodal des données :

- Prise en charge du traitement d'images par lots

- Analyse en temps réel des flux vidéo

- Traitement et synthèse de flux audio

4.2 Entraînement et mise au point du modèle :

- Fournit des scripts de formation complets

- Soutien aux fonctions d'apprentissage continu

- Soutien à la formation de jeux de données personnalisés

5. l'évaluation et les tests

- Prise en charge des principaux critères d'évaluation multimodale

- Outil d'évaluation intégré VLMEvalKit

- Fournit des mesures détaillées des tests de performance

6) Précautions

- Les GPU sont recommandés pour l'inférence des modèles

- Veillez à la gestion de la mémoire, en particulier lorsque vous traitez des données multimodales volumineuses.

- Vérifier régulièrement les mises à jour du projet pour connaître les dernières fonctionnalités et optimisations.

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...