Dépasser les silos d'information : Dify ajoute la recherche connectée à l'assistant IA localisé DeepSeek

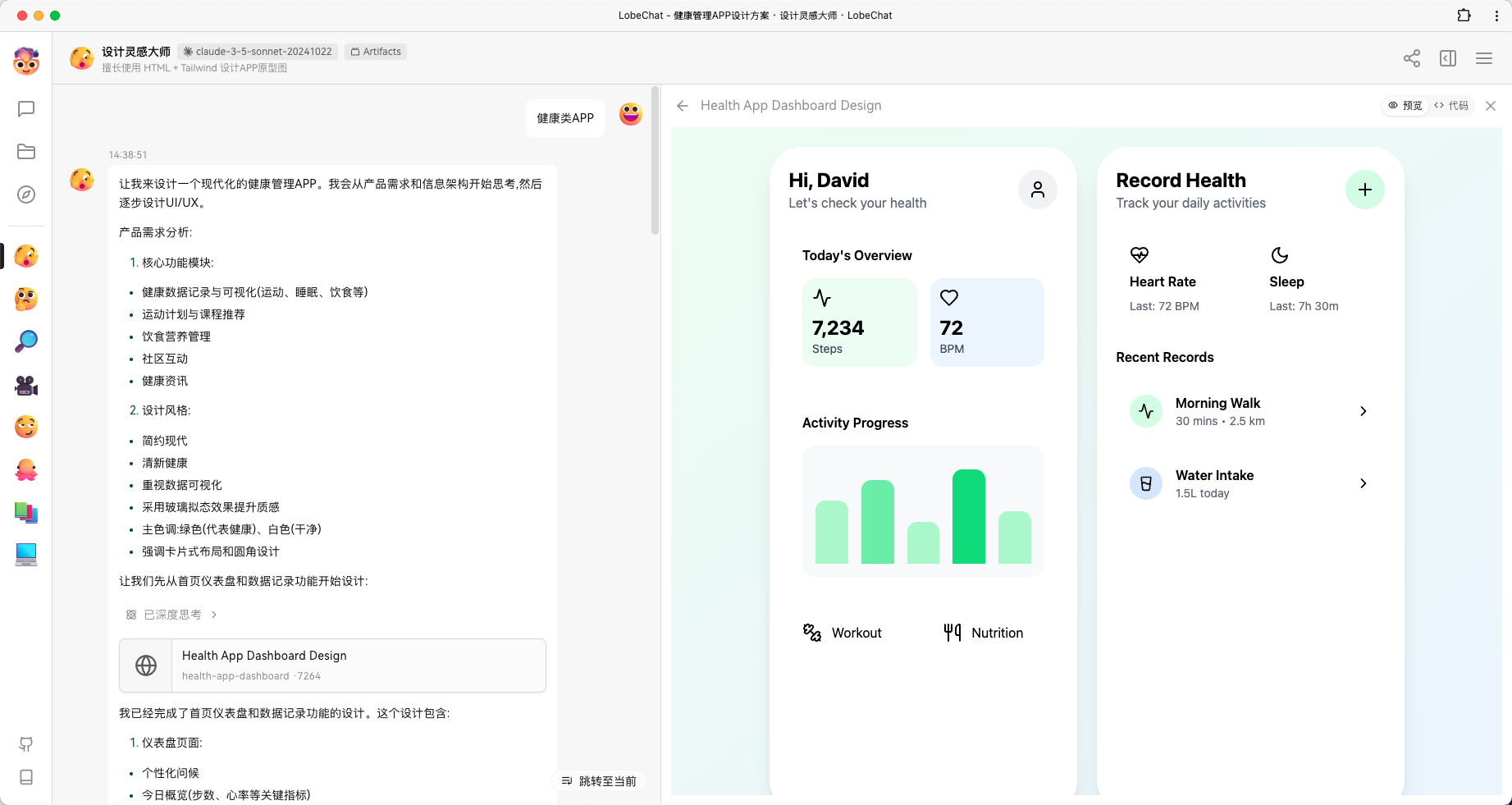

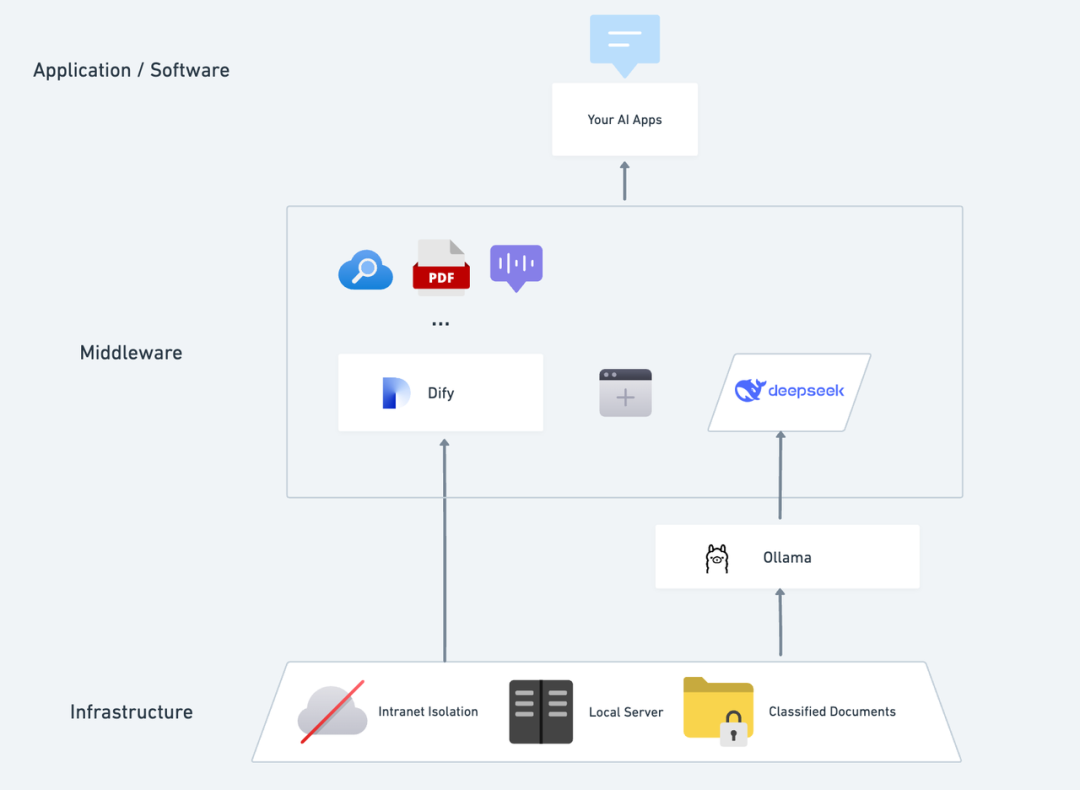

Imaginez ce que serait une application d'IA privée, autonome, confidentielle et capable d'analyser du texte local, de fournir des conversations précises à tout moment et d'effectuer des recherches sur internet. Dans cet article, nous allons vous guider pas à pas dans le processus de création d'une telle application. DeepSeek + Ollama + Dify L'assistant d'IA est un assistant d'IA privatisé et complet qui peut être déployé rapidement.

DeepSeek Il s'agit d'un modèle linguistique innovant à source ouverte, dont l'architecture algorithmique avancée et la capacité de "chaîne réflexive" rendent l'interaction du dialogue avec l'IA plus intelligente et plus naturelle. Grâce au déploiement privé, vous pouvez contrôler entièrement la sécurité de vos données et ajuster de manière flexible le plan de déploiement en fonction de vos besoins, créant ainsi votre propre système d'information. "Système d'exploitation de l'IA .

Dify En tant que plateforme de développement d'applications d'IA open source, elle fournit également une solution complète de déploiement privé et un support puissant d'outils tiers. Comprend des fonctions de recherche en réseau, d'analyse de documents, etc. Dify prend en charge plus de 1000 modèles open-source ou closed-source dans le monde entier.) En même temps, Dify prend en charge plus de 1000 modèles open-source ou fermés dans le monde entier, de sorte que vous pouvez appeler n'importe quel modèle pour renforcer vos applications d'IA.

L'intégration transparente de DeepSeek dans la plateforme Dify garantit non seulement la confidentialité des données, mais permet également aux développeurs de démarrer facilement et de créer de puissantes applications d'IA sur des serveurs locaux, ce qui permet aux entreprises ou aux équipes d'exploiter pleinement la puissance de DeepSeek. "Autonomie des données" et "personnalisation flexible" . Si vous avez déployé entreDéploiement privé de DeepSeek + Dify : construction d'un système d'assistant IA local sécurisé et contrôlable vous pouvez accéder directement à la section de recherche sur les réseaux.

Dify X DeepSeek Avantages du déploiement privé :

- Appeler plus de 1000 modèles : Dify est une plateforme neutre en termes de modèles qui utilise pleinement les capacités d'inférence de différents grands modèles (PS : peut être appelé en utilisant plusieurs plateformes MaaS tierces prises en charge par Dify). DeepSeek R1 pour résoudre le problème de l'instabilité des appels officiels à l'API, voir la fin de la méthode de configuration détaillée)

- Excellente performance : Une expérience de dialogue comparable à un modèle d'entreprise qui permet de gérer facilement une variété de scénarios complexes.

- L'isolement environnemental : Fonctionne entièrement hors ligne, ce qui élimine tout risque de fuite de données.

- Les données peuvent être contrôlées : Vous avez le contrôle total des données et vous répondez aux exigences de conformité de l'industrie.

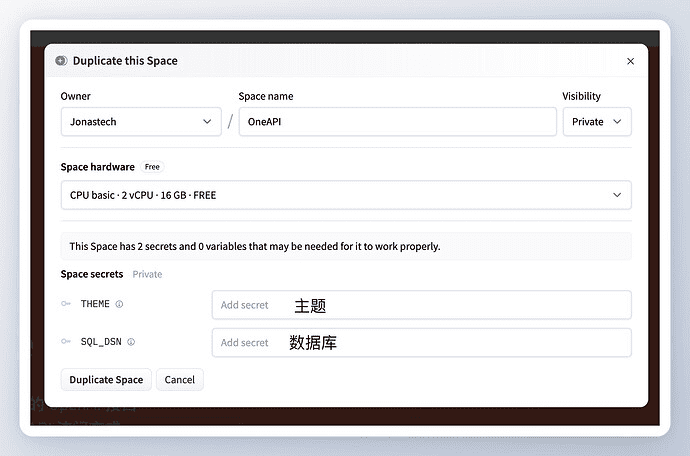

prépositionnementAcquérir un serveur (VPS ou VDS) qui répond aux conditions suivantes :Environnement matériel :

prépositionnementAcquérir un serveur (VPS ou VDS) qui répond aux conditions suivantes :Environnement matériel :

- CPU >= 2 Core

- Mémoire vidéo/RAM ≥ 16 GiB (recommandé)

Environnement logiciel :

- Docker

- Docker Compose

- Ollama

- Dify Community Edition

Démarrer le déploiement 1. installer Ollama

Tout comme les téléphones portables disposent généralement d'une boutique d'applications pour vous aider à trouver et à télécharger rapidement des applications, les modèles d'IA ont leur propre "boutique d'applications".

Ollama est un client de gestion de grands modèles open source multiplateforme (macOS, Windows, Linux) conçu pour déployer de manière transparente de grands modèles de langage (LLM) tels que DeepSeek, Llama, Mistral et d'autres.

Les grands modèles peuvent être installés et déployés à l'aide d'une seule commande, et toutes les données d'utilisation du LLM sont stockées localement sur la machine, ce qui garantit la confidentialité et la sécurité des données et permet de répondre aux exigences de conformité.

Visitez le site web d'Ollama (https://ollama.com/) et suivez les instructions de la page web pour télécharger et installer le client Ollama. Une fois l'installation terminée, exécutez ollama -v dans le terminal pour obtenir le numéro de version.

~ ollama -v

ollama version is 0.5.5

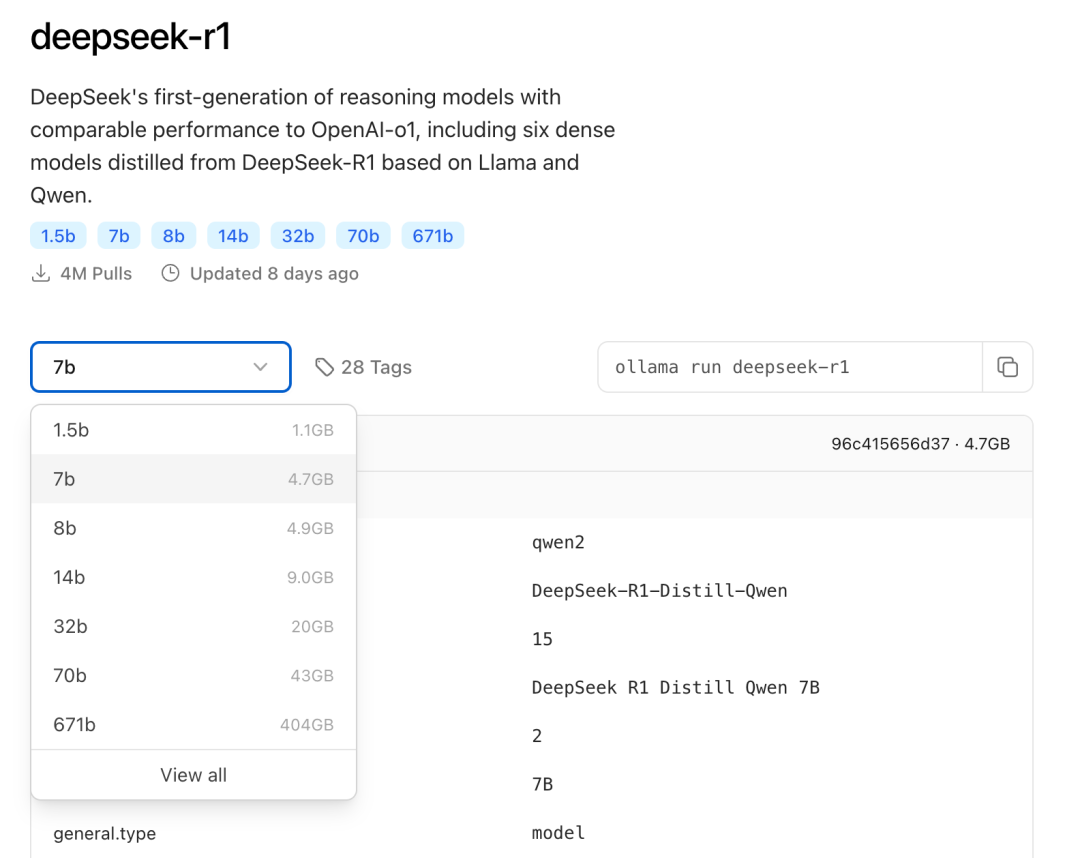

Sélectionnez le modèle de taille DeepSeek approprié pour le déploiement en fonction de la configuration réelle de l'environnement. Le modèle de taille 7B est recommandé pour l'installation initiale.

Le suffixe B indique les paramètres d'apprentissage du modèle. En théorie, plus le paramètre est élevé, plus les performances du modèle sont élevées et plus la mémoire graphique requise est importante.

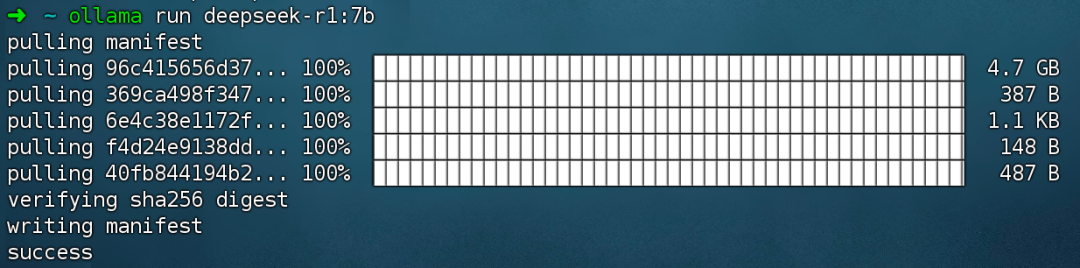

Exécuter la commande ollama run deepseek-r1:7b Installez le modèle DeepSeek R1.

2. installer Dify Community Edition

Tout comme une maison a besoin de plomberie et d'électricité, elle a également besoin d'une cuisine entièrement fonctionnelle pour que le chef puisse produire des plats délicieux, et c'est là que Dify entre en jeu. En tant que projet open source GitHub populaire, Dify dispose d'une chaîne d'outils intégrée qui couvre toute la gamme des éléments nécessaires à la création d'une application d'IA. Grâce aux puissantes capacités de modélisation de DeepSeek, tout le monde peut rapidement créer son application d'IA idéale sans avoir besoin de connaissances complexes en matière de code.

Visitez l'adresse du projet GitHub de Dify et exécutez les commandes suivantes pour compléter le dépôt de code et le processus d'installation.

git clone https://github.com/langgenius/dify.git

cd dify/docker

cp .env.example .env

docker compose up -d # 如果版本是 Docker Compose V1,使用以下命令:docker-compose up -d

Après avoir exécuté la commande, le terminal affichera automatiquement l'état et le mappage des ports de tous les conteneurs. S'il y a des interruptions ou des erreurs, assurez-vous que Docker et Docker Compose sont installés. Pour des instructions détaillées, veuillez vous référer à ce qui suit.

Déployer Dify Community Edition :

https://docs.dify.ai/zh-hans/getting-started/install-self-hosted/docker-compose

Dify Community Edition utilise le port 80 par défaut, et vous pouvez accéder à votre plateforme Dify privatisée en vous connectant à http://your_server_ip.

Pour changer de port d'accès, veuillez vous référer à ce document : https://docs.dify.ai/zh-hans/getting-started/install-self-hosted/faq#id-5.-ru-he-xiu-gai-ye-mian-duan-kou

3. connecter DeepSeek à Dify

Après avoir déployé le modèle DeepSeek avec Dify Community Edition, cliquez sur le lien http://your_server_ip pour entrer dans la plateforme Dify, puis cliquez sur le coin supérieur droit. Avatar → Paramètres → Fournisseur du modèle Sélectionnez Ollama et appuyez sur Ajouter un modèle.

Sélectionnez le type de modèle LLM.

- Model Name (Nom du modèle), indiquez le nom du modèle déployé. Le modèle déployé ci-dessus est deepseek-r1 7b, donc remplissez : deepseek-r1:7b.

- Base URL, indiquez l'adresse à laquelle le client Ollama s'exécute, généralement http://your_server_ip:11434. En cas de problèmes de connexion, veuillez lire la FAQ à la fin de cet article.

- Toutes les autres options sont laissées à leur valeur par défaut. Selon la description du modèle DeepSeek, la longueur maximale générée est de 32 768 tokens.

Commencer à créer des applications d'IA

Les sections suivantes vous montrent comment créer différents types d'applications d'IA :

- Application d'un dialogue simple

- Applications de dialogue simple avec des capacités d'analyse de documents

- Applications programmables avec recherche en réseau

DeepSeek AI Chatbot (application simple)

- Appuyez sur "Create a Blank App" sur le côté gauche de la page d'accueil de la plateforme Dify, sélectionnez le type d'application "Chat Assistant" et donnez-lui un nom simple.

- Dans le coin supérieur droit, sous Type d'application, sélectionnez le cadre Ollama dans la liste des applications.

deepseek-r1:7bModèles.

- Vérifiez que l'application AI fonctionne en saisissant du contenu dans la boîte de dialogue de prévisualisation. L'obtention d'une réponse signifie que la construction de l'application AI est terminée.

- Appuyez sur le bouton Publier en haut à droite de l'application pour obtenir un lien vers l'application AI et la partager avec d'autres personnes ou l'intégrer dans un autre site web.

DeepSeek AI Chatbot + Base de connaissances

Un défi important pour la modélisation linguistique à grande échelle (LLM) est que les données d'apprentissage ne sont pas mises à jour en temps réel et que la quantité de données peut être insuffisante, ce qui peut conduire le modèle à générer des réponses "fantômes".

Pour résoudre ce problème, la technologie Retrieval Augmented Generation (RAG) a vu le jour. En récupérant les connaissances pertinentes et en fournissant au modèle les informations contextuelles nécessaires, ces informations sont intégrées dans le processus de génération de contenu, ce qui améliore la précision et le professionnalisme de la réponse.

En pratique, lorsque vous téléchargez des documents internes ou des informations professionnelles, la fonction de base de connaissances de Dify peut jouer le rôle de RAG en aidant le LLM à fournir des réponses plus ciblées basées sur des informations spécialisées, ce qui compense efficacement le manque de données d'apprentissage du modèle.

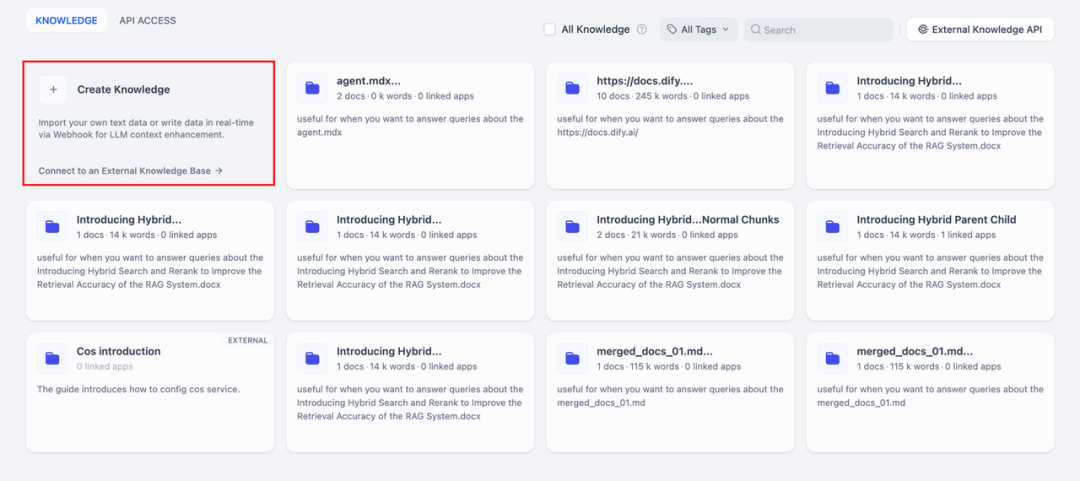

1. créer une base de connaissances

Téléchargez dans la base de connaissances les documents qui doivent être analysés par l'IA. Pour que le modèle DeepSeek comprenne correctement le contenu du document, il est recommandé de traiter le texte à l'aide d'un modèle de "segmentation parent-enfant" - ce modèle préserve mieux la structure hiérarchique et le contexte du document.

Pour les étapes de configuration détaillées, veuillez vous référer à ce document :

https://docs.dify.ai/zh-hans/guides/knowledge-base/create-knowledge-and-upload-documents

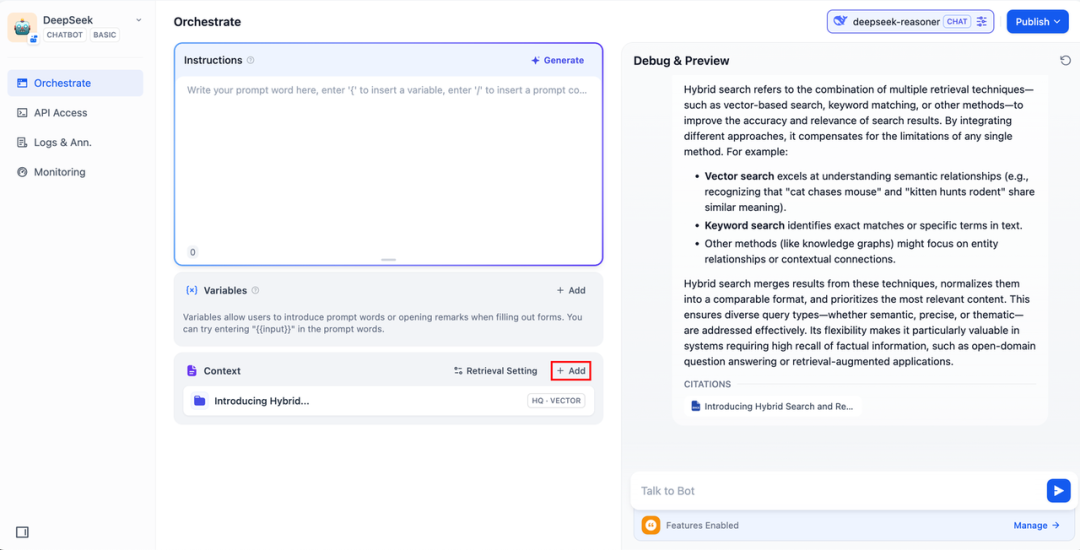

2. l'intégration de la base de connaissances dans les applications d'intelligence artificielle

Ajoutez une base de connaissances au "contexte" de l'application d'IA et saisissez la question pertinente dans la boîte de dialogue. lLM extrait d'abord de la base de connaissances le contexte pertinent pour la question, puis le résume et fournit une réponse de meilleure qualité.

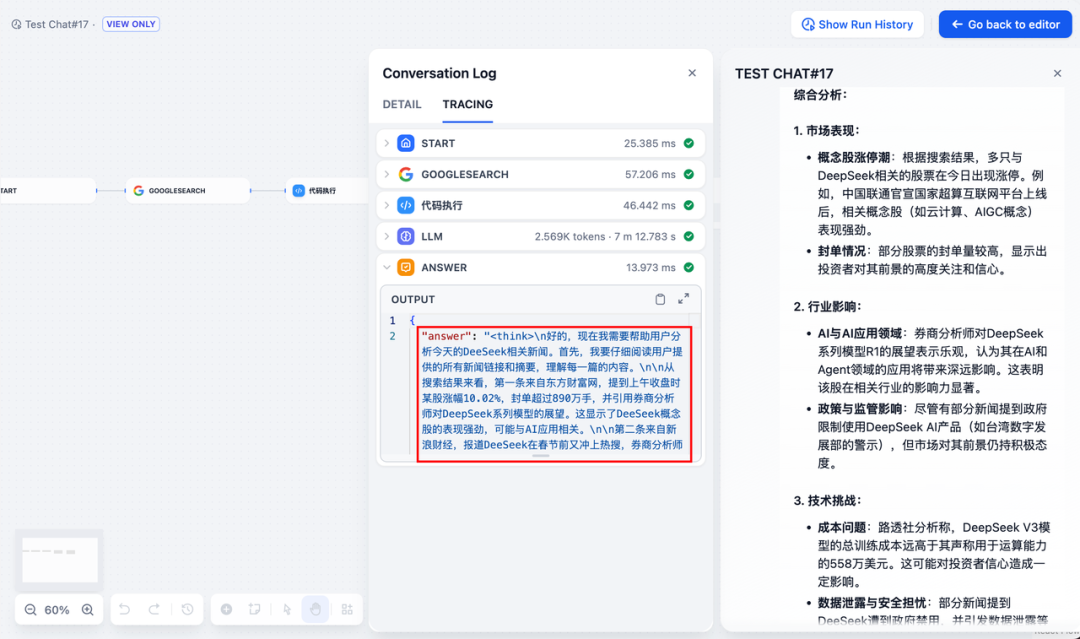

DeepSeek AI Chatflow / Workflow (recherche en réseau)

Chatflow / Flux de travail Les applications peuvent vous aider à orchestrer et à créer des applications d'IA dotées de fonctionnalités plus complexes, par exemple en donnant à DeepSeek la possibilité d'effectuer des recherches en réseau, la reconnaissance de fichiers, la reconnaissance vocale et bien d'autres choses encore. Pour des raisons d'espace, les sections suivantes vous montrent comment donner à DeepSeek la capacité d'effectuer des recherches en réseau, la reconnaissance de fichiers, la reconnaissance vocale, etc. Activer les capacités de recherche en réseau .

Pour utiliser l'application directement, vous pouvez télécharger le fichier DSL en cliquant sur le lien ci-dessous et l'importer dans la plateforme Dify.

Adresse de téléchargement du fichier DSL de l'application :

https://assets-docs.dify.ai/2025/02/41a3564694dd3f2803ad06a29f5b3fef.yml

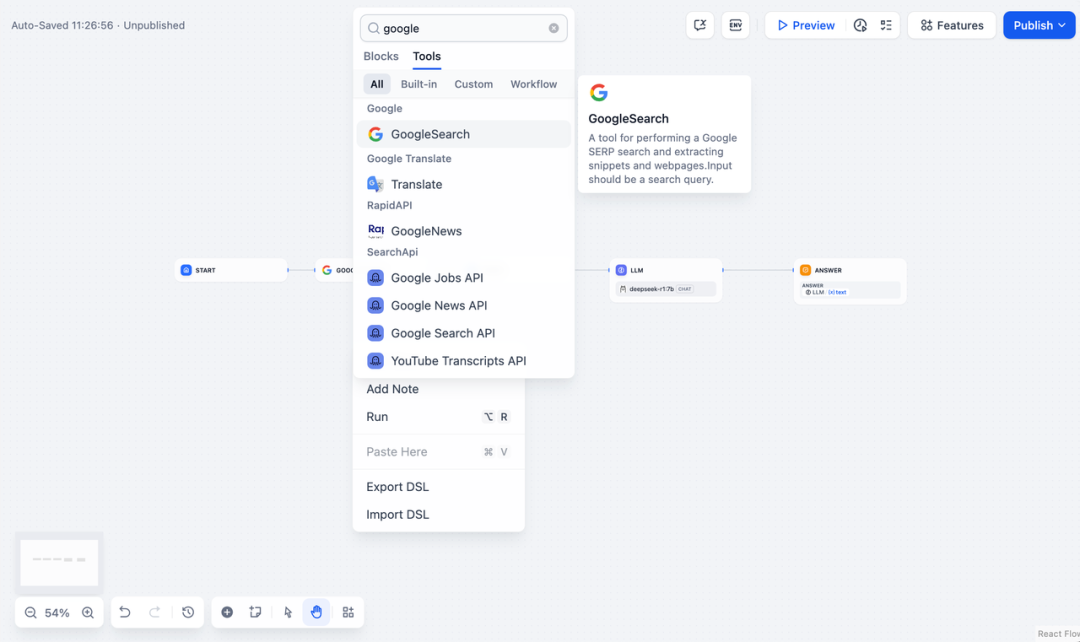

- Appuyez sur "Créer une application vierge" sur le côté gauche de la page d'accueil de la plateforme Dify, sélectionnez une application de type "Chatflow" ou "Workflow" et donnez-lui simplement un nom.

2. ajouterRecherche sur Internetremplissez la clé API pour activer la fonctionnalité du nœud. Remplissez le champ Requête avec la clé API fournie par le nœud initial. {{#sys.query#}} Variables.

Visitez le site web suivant pour obtenir une clé API :

https://serpapi.com/users/sign_in

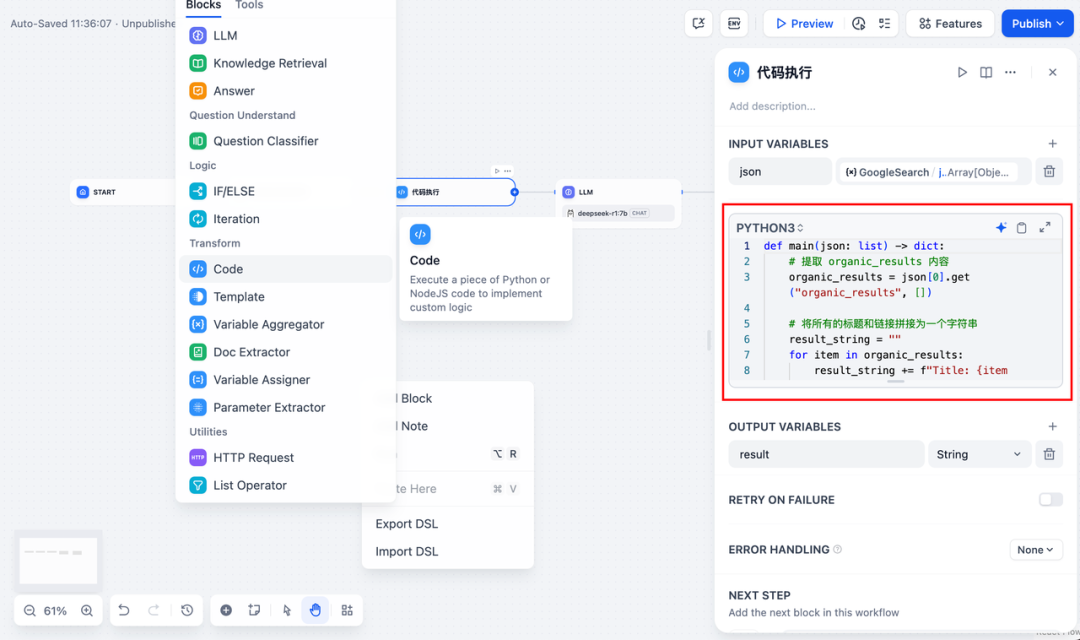

3. ajouterexécution du codenode. Comme la sortie de l'outil de recherche est un morceau de code JSON, vous devez ajouter un nœud d'exécution de code pour extraire le contenu nécessaire. Remplissez la variable d'entrée avec la variable de sortie JSON de l'outil de recherche et insérez le code suivant dans le nœud d'exécution de code :

def main(json: list) -> dict:

# 提取 organic_results 内容

organic_results = json[0].get("organic_results", [])

# 将所有的标题和链接拼接为一个字符串

result_string = ""

for item in organic_results:

result_string += (

f"Title: {item['title']}\n"

f"Link: {item['link']}\n"

f"Snippet: {item['snippet']}\n\n"

)

# 返回拼接后的字符串作为 result

return {

"result": result_string,

}

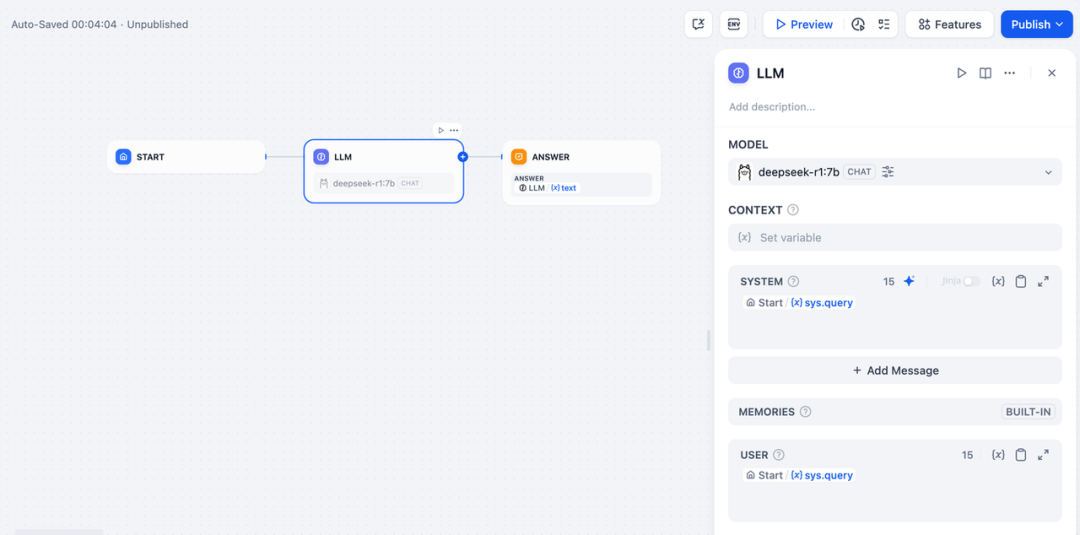

- Pour ajouter un nœud LLM, sélectionnez le cadre Ollama dans la liste des nœuds LLM.

deepseek-r1:7bet ajouter le mot-clé du système dans le{{#sys.query#}}pour traiter les commandes du nœud de départ saisies par l'utilisateur.

En cas d'anomalies de l'API, celles-ci peuvent être traitées de manière flexible par la fonction d'équilibrage de la charge ou par le nœud de traitement des anomalies.

équilibrage de la chargeLes demandes d'API peuvent être réparties entre plusieurs points d'extrémité d'API, comme décrit en détail à l'adresse https://docs.dify.ai/zh-hans/guides/model-configuration/load-balancing.

Mécanisme de gestion des exceptionsPossibilité d'envoyer des messages d'erreur en cas d'erreur de nœud sans interrompre le processus principal. Pour une description détaillée, veuillez consulter : https://docs.dify.ai/zh-hans/guides/workflow/error-handling

- Ajoutez le nœud final, référencez les variables de sortie du nœud LLM et terminez la configuration. Vous pouvez saisir du contenu dans la boîte de prévisualisation à des fins de test. La génération d'une réponse signifie que la construction de l'application d'IA est terminée et vous pouvez voir le processus de raisonnement de LLM dans le journal.

problèmes courants

1. erreurs de connexion lors du déploiement de Docker

Les erreurs suivantes peuvent être rencontrées lors du déploiement de Dify et Ollama avec Docker :

HTTPConnectionPool(host=127.0.0.1, port=11434): Max retries exceeded with URL: /cpi/chat

(Caused by NewConnectionError('<urllib3.connection.HTTPConnection object at 0x7f8562812c20>:

Failed to establish a new connection: [Errno 111] Connection refused'))

HTTPConnectionPool(host=localhost, port=11434): Max retries exceeded with URL: /cpi/chat

(Caused by NewConnectionError('<urllib3.connection.HTTPConnection object at 0x7f8562812c20>:

Failed to establish a new connection: [Errno 111] Connection refused'))

Cause de l'erreur : Cette erreur se produit parce que le service Ollama n'est pas accessible dans le conteneur Docker. localhost pointe généralement vers le conteneur lui-même, et non vers l'hôte ou un autre conteneur. Pour résoudre ce problème, vous devez exposer le service Ollama au réseau.

méthode de configuration de l'environnement macOS :

Si Ollama fonctionne comme une application macOS, vous devez définir les variables d'environnement à l'aide de launchctl :

- Définissez les variables d'environnement en appelant launchctl setenv :

launchctl setenv OLLAMA_HOST "0.0.0.0" - Redémarrer l'application Ollama.

- Si les étapes ci-dessus ne fonctionnent pas, vous pouvez utiliser la méthode suivante : le problème est qu'à l'intérieur de docker, vous devez vous connecter à host.docker.internal afin d'accéder à l'hôte de docker, donc remplacer localhost par host.docker.internal service fonctionnera : http://host. docker.internal:11434

Méthode de configuration de l'environnement Linux : Si Ollama fonctionne en tant que service systemd, vous devez utiliser l'option s ystemctl Définition des variables d'environnement :

- Pour ce faire, il suffit d'appeler la fonction

systemctl edit ollama.serviceModifiez le service systemd. Cela ouvrira un éditeur. - Pour chaque variable d'environnement, la fonction

[Service]Ajouter une ligne sous la sectionEnvironment: :[Service] Environment="OLLAMA_HOST=0.0.0.0" - Sauvegarder et quitter.

- Rechargez systemd et redémarrez Ollama :

systemctl daemon-reload systemctl restart ollama

Méthode de configuration de l'environnement Windows :

Sous Windows, Ollama hérite des variables d'environnement de l'utilisateur et du système.

- Tout d'abord, cliquez sur Ollama dans la barre des tâches pour quitter le programme.

- Modifier les variables d'environnement du système à partir du panneau de contrôle

- Modifiez ou créez de nouvelles variables pour votre compte d'utilisateur, telles que

OLLAMA_HOST,OLLAMA_MODELSetc. - Cliquez sur OK / Appliquer pour sauvegarder

- Exécuter dans une nouvelle fenêtre de terminal

ollama

2) Comment modifier l'adresse et le numéro de port du service Ollama ?

Ollama Default Binding 127.0.0.1 port 11434, auquel vous pouvez accéder par l'intermédiaire de la commande OLLAMA_HOST Les variables d'environnement modifient l'adresse de liaison.

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...