Trieve : une infrastructure en nuage RAG offrant un service complet de recherche, de recommandations et d'analyse.

Introduction générale

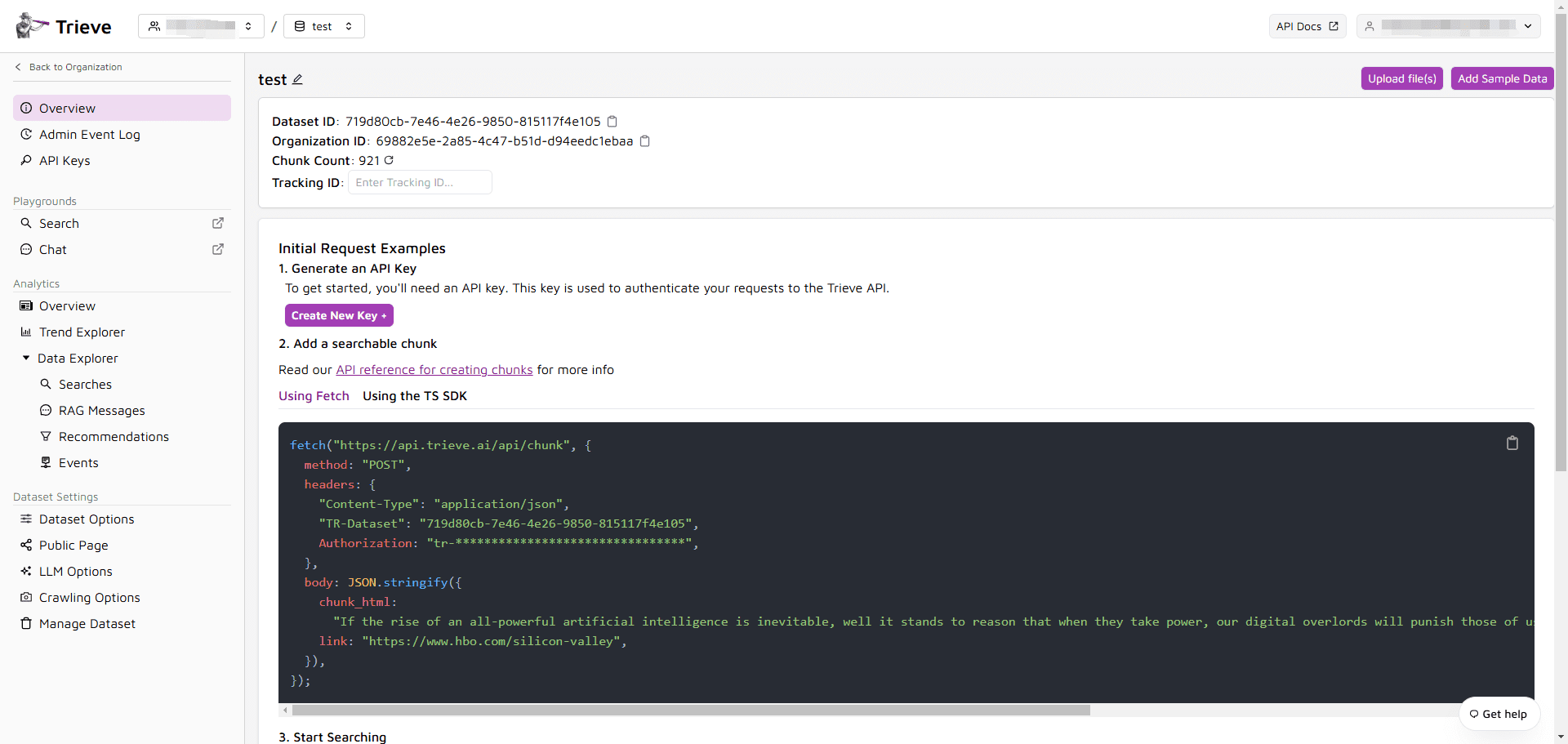

Trieve est une infrastructure globale développée par Devflow, Inc. conçue pour la recherche, les recommandations, RAG (retrieval augmentation generation) et l'analytique. La plateforme est servie par une API, est auto-hébergée et est disponible pour des environnements tels que AWS, GCP, Kubernetes et Docker Compose.Trieve intègre OpenAI et le modèle d'intégration de Jina, fournit une recherche vectorielle sémantique et prend en charge la recherche plein texte/neurale tolérante aux fautes de frappe. Son système de recommandation fournit des recommandations de contenu personnalisées basées sur le comportement de l'utilisateur afin d'améliorer l'expérience utilisateur, et Trieve prend en charge de multiples fonctions de filtrage et de regroupement pour garantir la précision et la pertinence des résultats de recherche.

PDF to Markdown (PDF2MD) : https://github.com/devflowinc/trieve/tree/main/pdf2md

Liste des fonctions

- auto-hébergéLa solution d'auto-hébergement dans des environnements VPC ou locaux, avec des guides détaillés sur l'auto-hébergement.

- recherche vectorielle sémantiqueRecherche vectorielle sémantique : intégrer les modèles d'intégration d'OpenAI ou de Jina pour fournir une recherche vectorielle sémantique de haute qualité.

- Recherche de tolérance aux fautes de frappe: Fournir une recherche neuronale de vecteurs épars tolérante aux fautes de frappe en utilisant le modèle naver/efficient-splade-VI-BT-large-query.

- mise en évidence des clausesAméliorer l'expérience de l'utilisateur en mettant en évidence les mots ou les phrases correspondants dans les résultats de la recherche.

- système de recommandationLes recommandations personnalisées sont basées sur le comportement de l'utilisateur (par exemple, les favoris, les signets, les goûts).

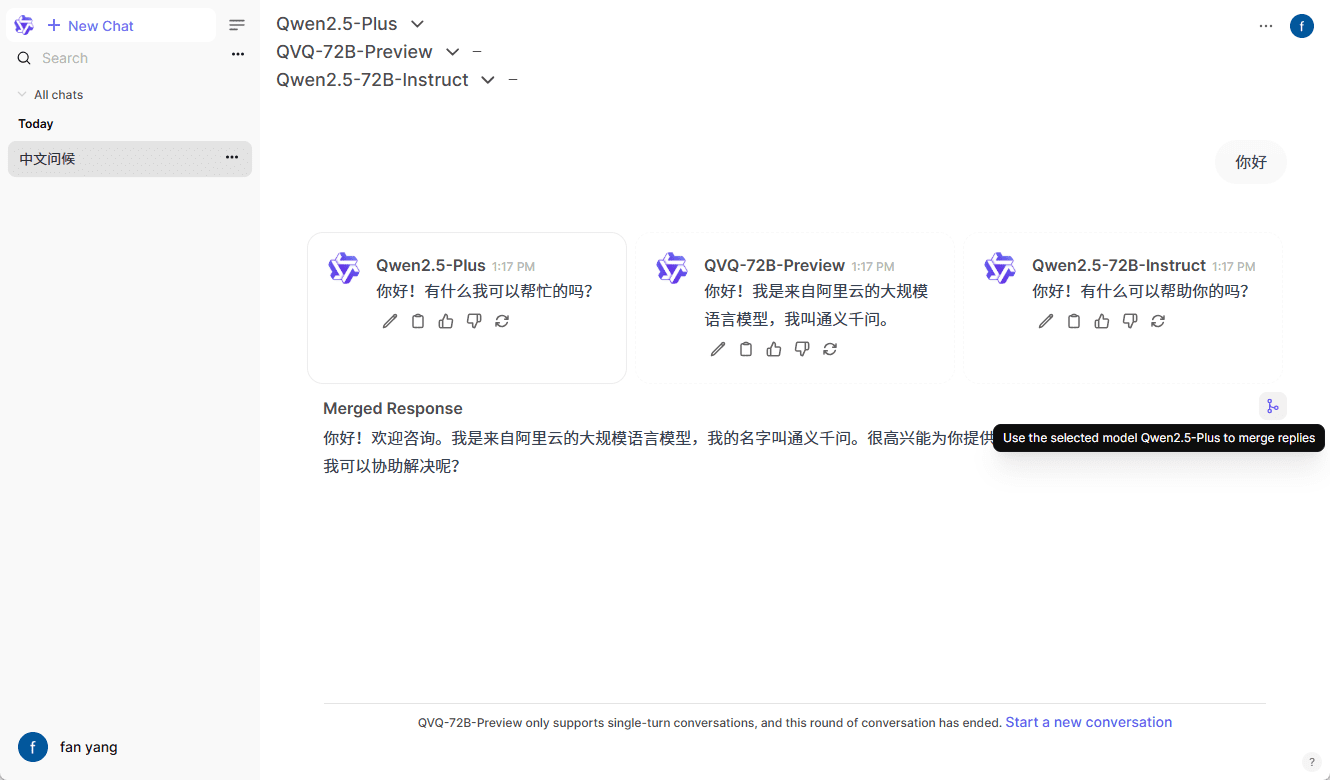

- RAG API Routage: s'intègre à OpenRouter, fournit plusieurs options d'accès LLM et prend en charge la gestion de la mémoire thématique.

- Recherche hybrideL'optimisation de la réorganisation avec BAAI/bge-reranker-large permet d'obtenir les meilleurs résultats de recherche.

- Préjugé favorable à la fraîcheurLes résultats de la recherche peuvent être modifiés en fonction du contenu le plus récent, ce qui permet d'éviter les résultats périmés.

- Une commercialisation adaptéeLes services d'aide à la décision : Ajuster la pertinence sur la base de signaux tels que les clics, l'ajout au panier ou les citations.

- Filtration multipleFiltres : Prise en charge des plages de dates, des correspondances de sous-chaînes, des étiquettes, des valeurs numériques et de bien d'autres types de filtres.

- fonction de regroupementLa prise en charge du marquage de plusieurs blocs comme faisant partie du même fichier garantit que les meilleurs résultats ne sont pas dupliqués.

Utiliser l'aide

Processus d'installation

- Préparation de l'environnementLes logiciels suivants sont installés : curl, gcc, g++, make, pkg-config, python3, libpq-dev, libssl-dev, etc.

- Installation de NodeJS et YarnInstallation de la version LTS de NodeJS à l'aide de NVM et installation globale de Yarn.

- Définition des variables d'environnementCopier le fichier .env dans le répertoire approprié et ajouter la clé de l'API OpenAI.

- Démarrer le service DockerDémarrer le service de conteneur requis à l'aide de docker-compose.

- développement localLes services de développement local : Utilisez tmuxp ou les onglets du terminal pour gérer les services de développement local et démarrer les modules.

Lignes directrices pour l'utilisation

- Créer un compteLa méthode est la suivante : se rendre sur un serveur local, créer un compte et télécharger un ensemble de données de test.

- Recherche d'ensembles de donnéesRecherche d'un ensemble de données : Effectuez une recherche d'ensemble de données à l'aide d'un serveur local afin de vérifier que la configuration fonctionne correctement.

- Débogage et assistanceSi vous rencontrez des problèmes, obtenez de l'aide via Discord ou utilisez diesel::debugquery(&query).tostring() permet de déboguer les requêtes SQL.

Principales fonctions

- recherche vectorielle sémantiqueAprès avoir téléchargé les données, le système effectue automatiquement la vectorisation et l'utilisateur peut effectuer une recherche sémantique par le biais de l'API.

- système de recommandationLe système génère automatiquement des contenus recommandés sur la base des données relatives au comportement des utilisateurs, et les utilisateurs peuvent obtenir les résultats recommandés par l'intermédiaire de l'API.

- RAG API RoutageLes utilisateurs peuvent sélectionner différents LLM pour le RAG le système fournira les meilleurs résultats en fonction de la gestion de la mémoire.

- Recherche hybrideRecherche hybride : Grâce à la fonction de recherche hybride, le système réorganise et optimise automatiquement les résultats de la recherche pour qu'ils soient les plus pertinents possible.

- Filtrage et regroupementLes utilisateurs peuvent définir différents filtres et regroupements selon les besoins pour garantir la précision et la pertinence des résultats de la recherche.

Grâce au guide d'installation et d'utilisation détaillé ci-dessus, les utilisateurs peuvent facilement commencer à utiliser les fonctionnalités de Trieve et profiter pleinement de ses puissantes capacités de recherche, de recommandation et d'analyse.

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...