Cours gratuit sur le fonctionnement des LLM Transformer par Enda Wu

Comment fonctionnent les LLM Transformer ?

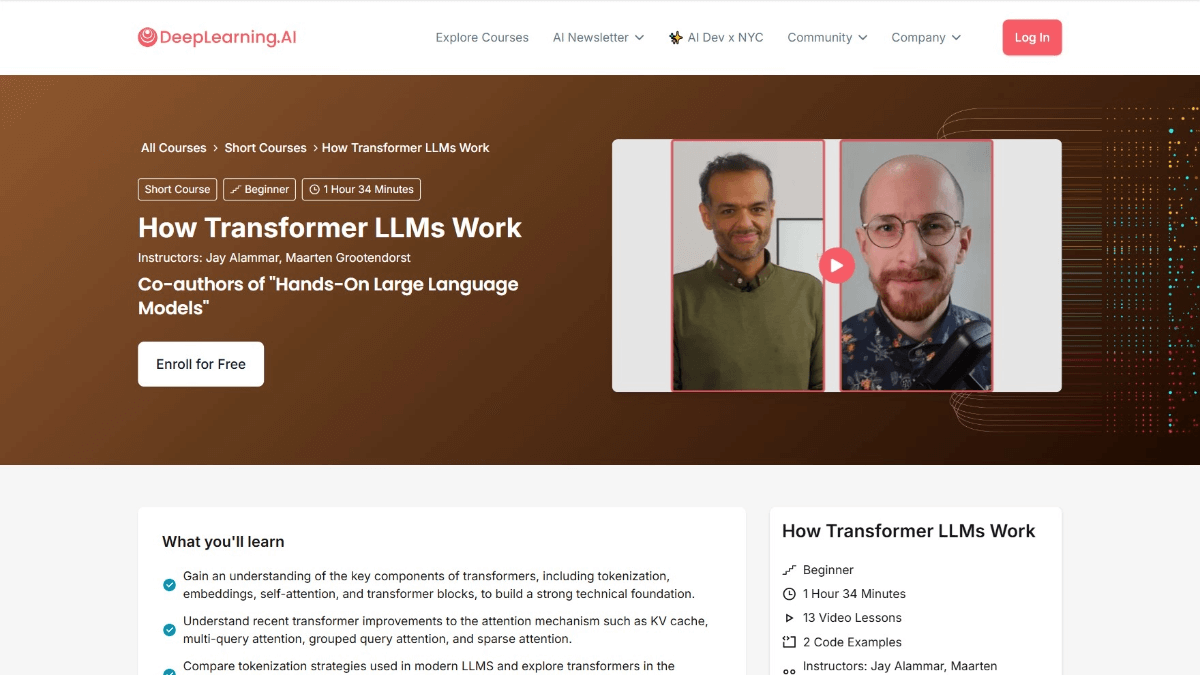

Transformateur How LLMs Work est un cours de DeepLearning.AI en collaboration avec Jay Alammar et Maarten Grootendorst, auteurs de Hands-On Large Language Models. Le cours fournit un aperçu approfondi de l'architecture Transformer qui prend en charge les grands modèles de langage (LLM). Le cours commence par l'évolution de la représentation numérique des langues et couvre des sujets tels que la désambiguïsation, le mécanisme d'attention et la couche feedforward des blocs Transformer, et la manière d'améliorer les performances en mettant en cache les calculs. À l'issue du cours, les utilisateurs auront une compréhension approfondie de la manière dont les LLM traitent les langues, seront capables de lire et de comprendre les articles pertinents et amélioreront leur capacité à construire des applications LLM.

Objectifs du cours sur le fonctionnement des LLM pour transformateurs

- Comprendre l'évolution de la représentation numérique du langageComprendre comment le langage est représenté numériquement, depuis les modèles simples de sacs de mots jusqu'aux architectures complexes de transformateurs.

- Maîtriser le traitement des participesApprendre à décomposer un texte d'entrée en "tokens" et comprendre comment les tokens sont introduits dans le modèle linguistique.

- Plongée dans l'architecture du transformateurLes trois principales phases de l'architecture Transformer sont étudiées en détail : la désambiguïsation et l'intégration, l'empilement des blocs Transformer et les en-têtes de modèles linguistiques.

- Comprendre les détails du bloc TransformateurLes mécanismes d'attention et les couches d'anticipation, ainsi que la manière dont ils fonctionnent ensemble pour traiter et générer du texte.

- Optimisation des performances d'apprentissageLes techniques de calcul de cache : Apprenez à améliorer les performances de Transformer grâce à des techniques telles que le calcul de cache.

- Application pratique ExplorationLa bibliothèque Hugging Face Transformer permet d'explorer les récentes mises en œuvre de modèles pour des applications pratiques améliorées.

Schéma de cours pour le fonctionnement des LLM de transformateurs

- Vue d'ensemble des LLM de transformateursIntroduction aux objectifs du cours, à la structure et à l'importance de l'architecture Transformer dans le contexte des grands modèles linguistiques (LLM) modernes.

- Évolution de la représentation linguistique: Un regard sur l'évolution de la modélisation du langage, du sac de mots à Word2Vec, en passant par l'architecture Transformer.

- le participe et l'encastrementApprendre comment un texte d'entrée est décomposé en tokens et comment convertir les tokens en vecteurs d'intégration, y compris l'application du codage positionnel.

- Bloc transformateurComprendre la structure du bloc Transformateur, y compris le mécanisme d'auto-attention et le rôle des réseaux de rétroaction.

- Longue attentionLes mécanismes attentionnels à têtes multiples peuvent améliorer les performances des modèles en saisissant différents aspects de l'entrée par l'intermédiaire de plusieurs "têtes".

- Empilage de blocs de transformateursLes modèles profonds : Apprenez à construire des modèles profonds en empilant plusieurs blocs Transformer, et le rôle de la liaison résiduelle et de la normalisation des couches.

- Modèle linguistique En-têteComprendre comment Transformer met en œuvre la génération de texte en générant la distribution de probabilité du prochain jeton à partir de l'en-tête du modèle de langue.

- mécanisme de mise en cacheLes modèles de Transformer : Découvrez comment améliorer la vitesse d'inférence des modèles de Transformer grâce à des mécanismes de mise en cache, et des applications pratiques de la mise en cache.

- Dernières innovations architecturalesLe site présente les dernières innovations en matière de mélange d'experts (MoE) et d'autres architectures de transformateurs.

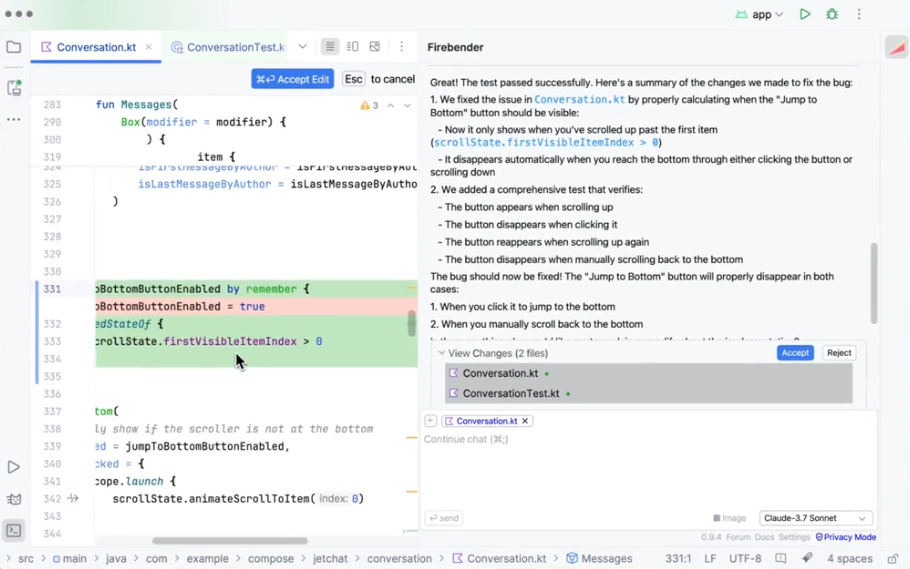

- Mise en œuvre du transformateur à visage embrassantLa bibliothèque de transformateurs Hugging Face : Découvrez comment charger et affiner des modèles de transformateurs pré-entraînés avec la bibliothèque de transformateurs Hugging Face.

- Codage pratique du transformateurLes exercices de codage pratiques permettent d'apprendre à mettre en œuvre les composants clés du transformateur et à construire des modèles simples de transformateur.

- Document de recherche sur la lecture et la compréhensionLes articles de recherche sur les transformateurs : Apprenez à lire et à comprendre les articles de recherche sur les transformateurs, en analysant les articles récents et leurs contributions dans ce domaine.

- Construire des dossiers de candidature pour le LLMLes applications basées sur le LLM : Explorer comment développer des applications basées sur le LLM et discuter des orientations futures et des applications potentielles de l'architecture Transformer.

Adresse du cours sur le fonctionnement des LLM Transformer

- Adresse du cours: :DeepLearning.AI

Pour qui travaillent les MLD transformateurs

- chercheur en traitement du langage naturel (NLP)Le projet "Transformer" : étude approfondie de l'architecture Transformer, exploration des applications de pointe dans les domaines de la compréhension, de la génération et de la traduction des langues, et promotion du développement de la technologie du traitement du langage naturel.

- Ingénieur en apprentissage automatiqueMaîtriser le fonctionnement de Transformer afin d'optimiser les performances des modèles, d'améliorer leur précision et leur efficacité, et de développer des applications de modèles linguistiques plus puissantes.

- scientifique des donnéesTraitement et analyse de données textuelles à grande échelle à l'aide de l'architecture Transformer, recherche de modèles et d'informations dans les données afin de faciliter la prise de décision.

- développeur de logiciels: Intégrer les LLM Transformer dans diverses applications logicielles, telles que les chatbots, les systèmes de recommandation de contenu, etc. afin d'améliorer l'intelligence des produits.

- Les passionnés d'intelligence artificielleVous êtes intéressé par l'architecture Transformer et vous souhaitez apprendre comment elle fonctionne, acquérir une meilleure compréhension de la technologie de l'IA et élargir vos horizons techniques.

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...