Together : une plateforme en nuage pour construire et exécuter des plateformes d'entraînement de modèles d'IA générative

Introduction générale

Together AI est une plate-forme axée sur les modèles génératifs d'IA, qui fournit une gamme complète de services allant de l'entraînement des modèles à l'inférence, en passant par le réglage fin. Les utilisateurs peuvent exploiter le moteur d'inférence hautement efficace de Together AI et les clusters de GPU pour déployer et exécuter rapidement une variété de modèles open source. La plateforme prend en charge plusieurs architectures de modèles pour répondre aux différentes exigences des applications d'IA.

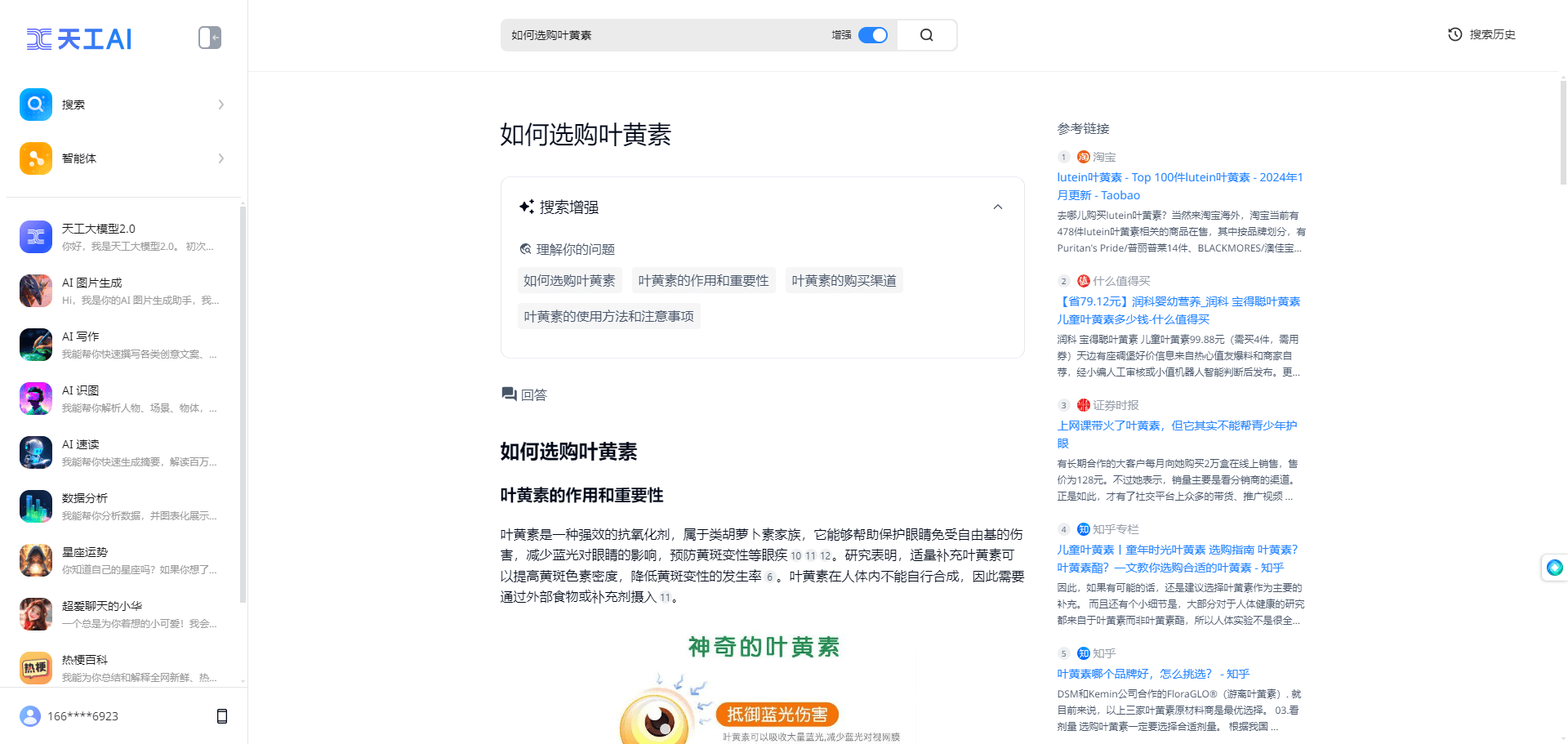

Interface de démonstration du chat pour les grands modèles

Liste des fonctions

- API d'inférenceLe système de gestion de l'information de l'entreprise : Il prend en charge le raisonnement sur plus de 100 modèles open-source et fournit des modèles d'instance dédiés et sans serveur.

- fonction de réglage finLes utilisateurs peuvent affiner les modèles d'IA générative à l'aide de leurs propres données, tout en conservant la propriété des données.

- Grappe de GPULe programme de formation à l'utilisation des GPU : Il fournit des grappes de pointe de 16 à plus de 1 000 GPU pour prendre en charge la formation de modèles à grande échelle.

- Formation à un modèle personnaliséLes services d'assistance technique : Former des modèles de pointe à partir de zéro et prendre en charge de multiples architectures de modèles.

- modèle multimodalLes logiciels de reconnaissance et d'inférence d'images, de génération d'images et autres sont pris en charge par le système.

- Moteur d'inférence efficaceLes technologies d'inférence les plus récentes, telles que FlashAttention-3 et Flash-Decoding, sont intégrées afin de fournir des services d'inférence rapides et précis.

Utiliser l'aide

Installation et utilisation

- S'inscrire et se connecter: :

- Visitez le site web de Together AI (https://www.together.ai/) et cliquez sur le bouton "Commencer à construire" pour vous inscrire.

- Une fois l'inscription terminée, connectez-vous à votre compte et accédez au panneau de contrôle de l'utilisateur.

- Sélectionner un service: :

- Dans le panneau de configuration, sélectionnez le module de service que vous devez utiliser, tel que l'API d'inférence, la fonction de réglage fin ou le cluster GPU.

- Sélectionnez le mode d'instance sans serveur ou dédié selon les besoins.

- Utilisation de l'API d'inférence: :

- Sélectionnez le modèle open source que vous souhaitez exécuter, tel que Llama-3, RedPajama, etc.

- Intégrez le modèle dans votre application via l'interface API fournie par Together AI.

- Créez votre propre application RAG en utilisant les points d'extrémité intégrés de Together AI.

- fonction de réglage fin: :

- Téléchargez votre ensemble de données et sélectionnez les modèles qui doivent être affinés.

- Configurez les paramètres de réglage fin pour lancer le processus de réglage fin.

- Une fois la mise au point terminée, téléchargez le modèle mis au point et déployez-le.

- Utilisation de la grappe de GPU: :

- Sélectionnez la taille de la grappe de GPU souhaitée et configurez les paramètres matériels.

- Téléchargez les données d'entraînement et le code du modèle pour commencer l'entraînement.

- Une fois la formation terminée, le modèle formé est téléchargé en vue d'une inférence ou d'une mise au point supplémentaire.

- Formation à un modèle personnalisé: :

- Sélectionnez le module Custom Model Training pour configurer l'architecture du modèle et les paramètres de formation.

- Téléchargez l'ensemble de données et démarrez le processus de formation.

- Une fois la formation terminée, le modèle est téléchargé pour être déployé et inféré.

flux de travail

- Accès au panneau de contrôleAprès s'être connecté, aller dans le panneau de contrôle et sélectionner le module de service désiré.

- Paramètres de configurationLes paramètres d'inférence, de réglage fin ou d'entraînement sont configurés en fonction des besoins.

- Télécharger les donnéesTélécharger le jeu de données ou le code du modèle requis.

- Début de la missionLes tâches de raisonnement, de mise au point ou de formation peuvent être lancées et la progression des tâches est suivie en temps réel.

- Télécharger les résultatsLe modèle ou les résultats de l'inférence sont téléchargés une fois la tâche achevée, en vue de l'intégration de l'application.

problèmes courants

- Comment choisir le bon modèle ?

- Sélectionnez le modèle open source approprié en fonction du scénario de l'application, comme la génération de texte, la reconnaissance d'images, etc.

- Que se passe-t-il si je rencontre une erreur lors du réglage fin ?

- Vérifiez le format du jeu de données et la configuration des paramètres, et reportez-vous à la documentation officielle pour les ajustements.

- Mauvaises performances lors de l'utilisation d'un cluster GPU ?

- Confirmez que la configuration matérielle répond aux exigences et ajustez les paramètres de formation pour améliorer l'efficacité.

modèle utilisable

| Points d'extrémité sans serveur | Auteur | Type | Prix (par 1M) jetons) | |

|---|---|---|---|---|

| Meta Llama 3.2 11B Vision Instruct Turbo | ||||

| Méta | chat | $0.18 | ||

| Meta Llama 3.2 90B Vision Instruct Turbo | ||||

| Méta | chat | $1.20 | ||

| Qwen2.5 7B Instruct Turbo | ||||

| Qwen | chat | $0.30 | ||

| Qwen2.5 72B Instruct Turbo | ||||

| Qwen | chat | $1.20 | ||

| FLUX.1 [schnell] | ||||

| Laboratoire de la Forêt Noire | image | Voir les tarifs | ||

| FLUX 1.1 [pro] | ||||

| Laboratoire de la Forêt Noire | image | Voir les tarifs | ||

| FLUX.1 [pro] | ||||

| Laboratoire de la Forêt Noire | image | Voir les tarifs | ||

| FLUX.1 [schnell] Gratuit | ||||

| Laboratoire de la Forêt Noire | image | Voir les tarifs | ||

| Meta Llama 3.2 3B Instruct Turbo | ||||

| Méta | chat | $0.06 | ||

| Meta Llama Vision Gratuit | ||||

| Méta | chat | Gratuit | ||

| Meta Llama Guard 3 11B Vision Turbo | ||||

| Méta | modération | $0.18 | ||

| Meta Llama 3.1 8B Instruct Turbo | ||||

| Méta | chat | $0.18 | ||

| Mixtral-8x22B Instruct v0.1 | ||||

| mistralai | chat | $1.20 | ||

| Diffusion stable XL 1.0 | ||||

| Stabilité AI | image | Voir les tarifs | ||

| Meta Llama 3.1 70B Instruct Turbo | ||||

| Méta | chat | $0.88 | ||

| Meta Llama 3.1 405B Instruct Turbo | ||||

| Méta | chat | $3.50 | ||

| Gryphe MythoMax L2 Lite (13B) | ||||

| Gryphe | chat | $0.10 | ||

| Rang du lama de Salesforce V1 (8B) | ||||

| salesforce | rerank | $0.10 | ||

| Meta Llama Guard 3 8B | ||||

| Méta | modération | $0.20 | ||

| Meta Llama 3 70B Instruct Turbo | ||||

| Méta | chat | $0.88 | ||

| Meta Llama 3 70B Instruct Lite | ||||

| Méta | chat | $0.54 | ||

| Meta Llama 3 8B Instruct Lite | ||||

| Méta | chat | $0.10 | ||

| Meta Llama 3 8B Instruct Turbo | ||||

| Méta | chat | $0.18 | ||

| Référence de l'instruction Meta Llama 3 70B | ||||

| Méta | chat | $0.90 | ||

| Référence de l'instruction Meta Llama 3 8B | ||||

| Méta | chat | $0.20 | ||

| Qwen 2 Instruct (72B) | ||||

| Qwen | chat | $0.90 | ||

| Gemma-2 Instruct (27B) | ||||

| Google Société Internet | chat | $0.80 | ||

| Gemma-2 Instruct (9B) | ||||

| chat | $0.30 | |||

| Mistral (7B) Instruct v0.3 | ||||

| mistralai | chat | $0.20 | ||

| Qwen 1.5 Chat (110B) | ||||

| Qwen | chat | $1.80 | ||

| Meta Llama Guard 2 8B | ||||

| Méta | modération | $0.20 | ||

| WizardLM-2 (8x22B) | ||||

| microsoft | chat | $1.20 | ||

| DBRX Instruct | ||||

| Les banques de données | chat | $1.20 | ||

| DeepSeek Chat LLM (67B) | ||||

| DeepSeek | chat | $0.90 | ||

| Gemma Instruct (2B) | ||||

| Google Société Internet | chat | $0.10 | ||

| Mistral (7B) Instruct v0.2 | ||||

| mistralai | chat | $0.20 | ||

| Mixtral-8x7B Instruct v0.1 | ||||

| mistralai | chat | $0.60 | ||

| Mixtral-8x7B v0.1 | ||||

| mistralai | langue | $0.60 | ||

| Qwen 1.5 Chat (72B) | ||||

| Qwen | chat | $0.90 | ||

| Garde de lamas (7B) | ||||

| Méta | modération | $0.20 | ||

| Nous Hermes 2 - Mixtral 8x7B-DPO | ||||

| NousResearch | chat | $0.60 | ||

| Mistral (7B) Instruire | ||||

| mistralai | chat | $0.20 | ||

| Mistral (7B) | ||||

| mistralai | langue | $0.20 | ||

| LLaMA-2 Chat (13B) | ||||

| Méta | chat | $0.22 | ||

| LLaMA-2 Chat (7B) | ||||

| Méta | chat | $0.20 | ||

| LLaMA-2 (70B) | ||||

| Méta | langue | $0.90 | ||

| Code Llama Instruct (34B) | ||||

| Méta | chat | $0.78 | ||

| Upstage SOLAR Instruct v1 (11B) | ||||

| en amont | chat | $0.30 | ||

| M2-BERT-Retrieval-32k | ||||

| Ensemble | intégration | $0.01 | ||

| M2-BERT-Retrieval-8k | ||||

| Ensemble | intégration | $0.01 | ||

| M2-BERT-Retrieval-2K | ||||

| Ensemble | intégration | $0.01 | ||

| EAU-Large-V1 | ||||

| OùIsAI | intégration | $0.02 | ||

| BAAI-Bge-Large-1p5 | ||||

| BAAI | intégration | $0.02 | ||

| BAAI-Bge-Base-1p5 | ||||

| BAAI | intégration | $0.01 | ||

| MythoMax-L2 (13B) | ||||

| Gryphe | chat | $0.30 |

exemple d'utilisation

Exemples de raisonnement par modèle

import os

import requests

url = "https://api.together.xyz/v1/chat/completions"

payload = {

"model": "mistralai/Mixtral-8x7B-Instruct-v0.1",

"max_tokens": 512,

"temperature": 0.7,

"top_p": 0.7,

"top_k": 50,

"repetition_penalty": 1

}

headers = {

"accept": "application/json",

"content-type": "application/json",

"Authorization": "Bearer TOGETHER_API_KEY"

}

response = requests.post(url, json=payload, headers=headers)

print(response.text)

Exemple de mise au point du modèle

import os

import requests

url = "https://api.together.xyz/v1/fine-tune"

payload = {

"model": "togethercomputer/llama-2-70b-chat",

"data": "path/to/your/data",

"epochs": 3,

"batch_size": 8

}

headers = {

"accept": "application/json",

"content-type": "application/json",

"Authorization": "Bearer TOGETHER_API_KEY"

}

response = requests.post(url, json=payload, headers=headers)

print(response.text)© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...