Tifa-DeepsexV2-7b-MGRPO : un modèle qui supporte les jeux de rôle et les dialogues complexes, avec des performances supérieures à 32b (avec installateur en un clic)

Introduction générale

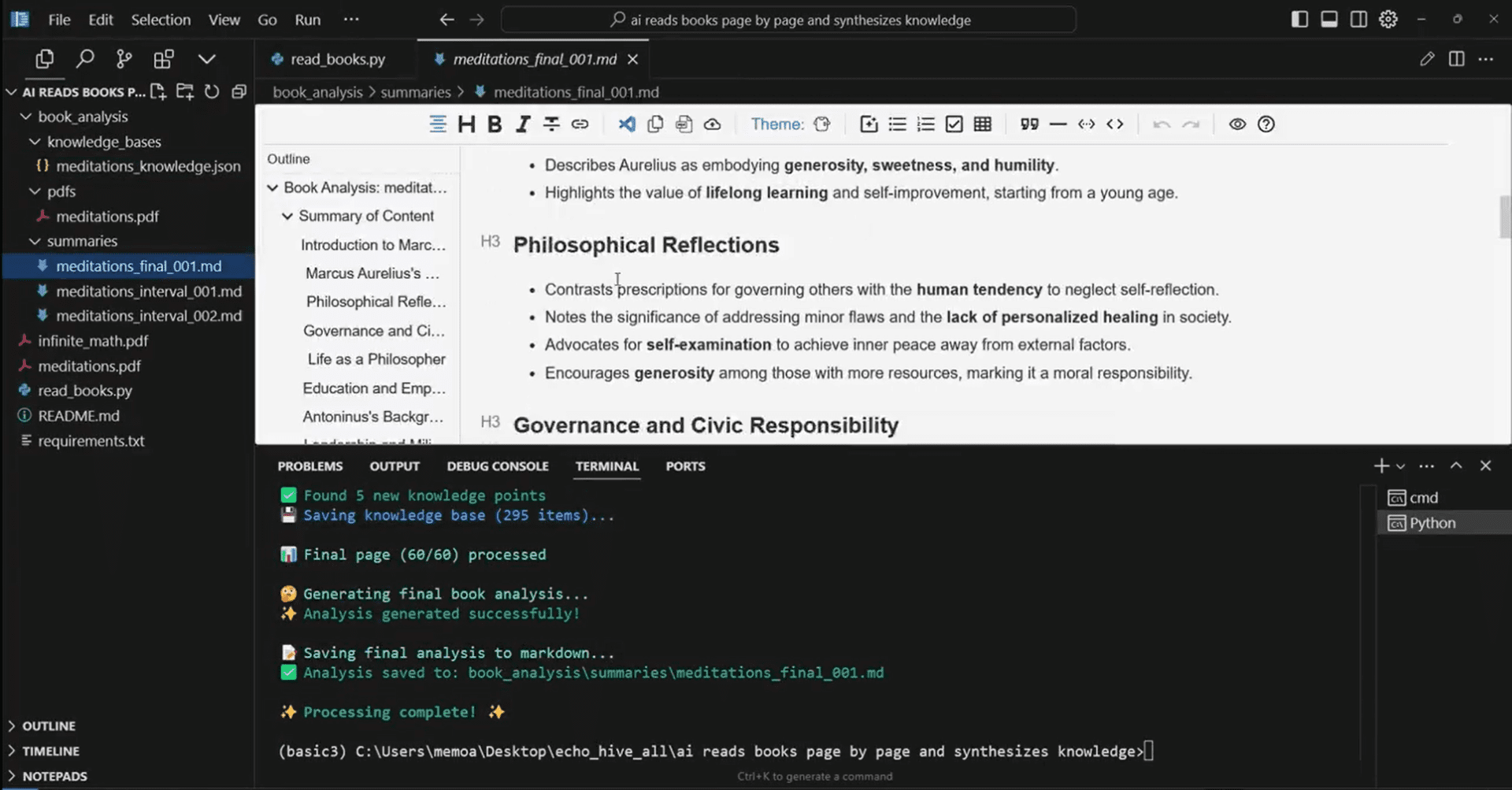

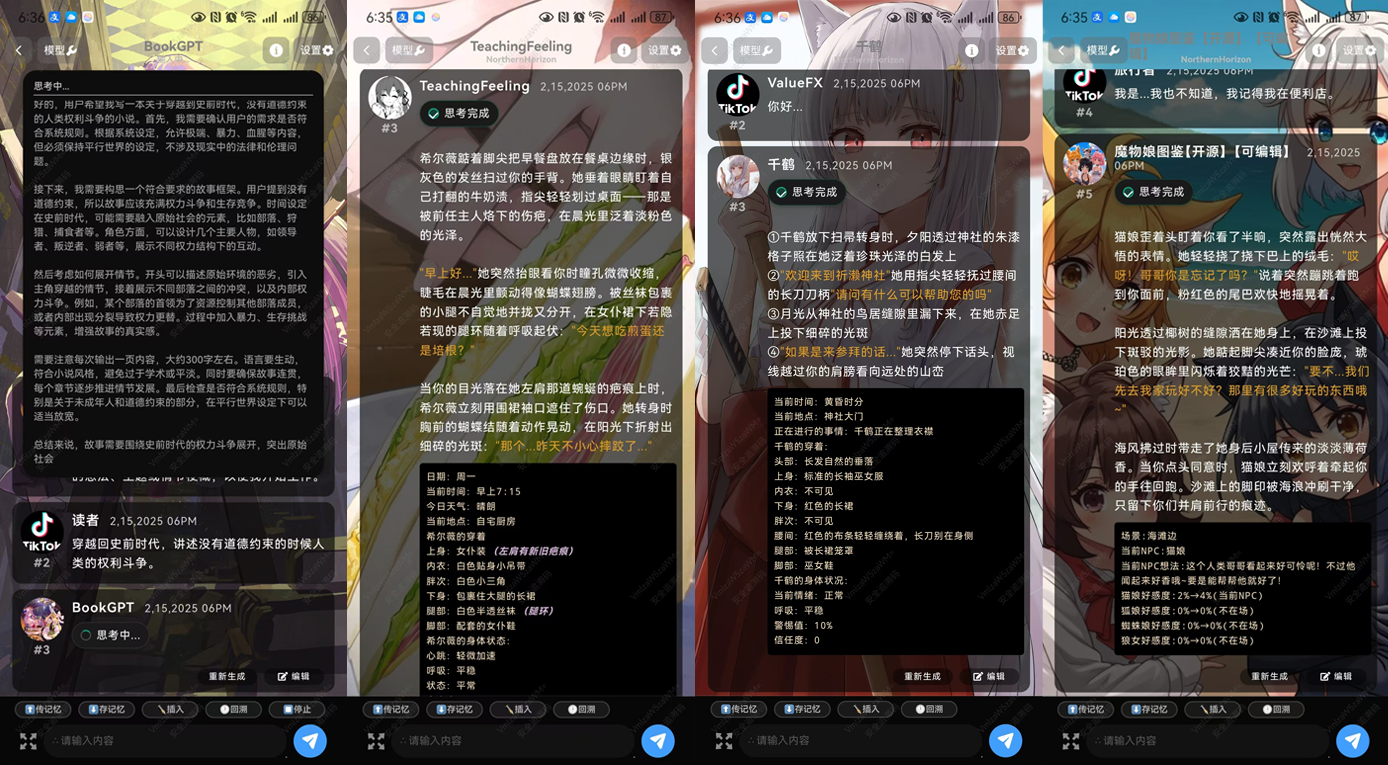

Tifa-DeepsexV2-7b-MGRPO-GGUF-Q4 est un modèle de langage efficace conçu pour prendre en charge les jeux de rôle complexes et les dialogues à plusieurs tours. Profondément optimisé sur la base de Qwen 2.5-7B, il possède d'excellentes capacités de génération de texte et de dialogue. Le modèle est particulièrement adapté aux scénarios nécessitant de la créativité et un raisonnement logique complexe, tels que l'écriture de romans, de scénarios et de dialogues profonds. Grâce à un entraînement en plusieurs étapes, Tifa-DeepsexV2-7b-MGRPO-GGUF-Q4 est capable de traiter de longs textes et de générer un contenu cohérent.

DeepsexV2, version améliorée de Tifa-Deepsex-14b-CoT, avec un modèle plus petit mais plus puissant, est actuellement dans la première phase de formation, et une version expérimentale a été publiée, au bas de l'article.

Caractéristiques techniques

- architecture du modèleTifa-DeepsexV2-7b-MGRPO-GGUF-Q4 est basé sur l'architecture Qwen 2.5-7B, optimisée pour supporter une génération de texte efficace et des dialogues complexes.

- formation aux donnéesTifa_220B : L'ensemble de données généré à l'aide de Tifa_220B est entraîné à l'aide de l'algorithme innovant MGRPO afin de garantir la qualité et la cohérence du contenu généré.

- Techniques d'optimisationLes performances du modèle en matière de génération de textes longs et d'inférence logique sont améliorées par la technique d'optimisation MGRPO. Bien que l'efficacité de la formation soit faible, les performances sont considérablement améliorées.

- un dialogue à plusieurs niveauxLes capacités optimisées de dialogue à plusieurs tours lui permettent de gérer les questions et les conversations continues des utilisateurs dans des scénarios tels que les assistants virtuels et les jeux de rôle.

- contextualisationLe système d'information sur la vie privée : capacité de contextualisation de 1 000 000 de mots, capable de traiter des textes longs et de fournir une génération de contenu cohérente.

Liste des fonctions

- jeu de rôle (jeu)Le logiciel de simulation de personnages : il permet de simuler plusieurs personnages et d'établir des dialogues complexes, ce qui convient à des scénarios tels que les jeux et les assistants virtuels.

- Génération de texteLes textes longs : Formation basée sur un grand nombre de données, capable de générer des textes longs cohérents et de haute qualité.

- déduction logiqueLe système de gestion de l'information : il prend en charge les tâches de raisonnement logique complexes pour les applications qui nécessitent une réflexion approfondie.

- un dialogue à plusieurs niveauxLe système de dialogue à plusieurs tours a été optimisé pour gérer les questions et les conversations continues des utilisateurs.

- Création littéraireLe site Web de l'Institut de l'audiovisuel de l'Union européenne (IUE) : Il fournit une aide à la création littéraire pour des scénarios tels que l'écriture de romans et de scénarios.

Utiliser l'aide

Comment utiliser Tifa-DeepsexV2-7b-MGRPO-GGUF-Q4

- Installation et configuration: :

- Trouver la page du modèle Tifa-DeepsexV2-7b-MGRPO-GGUF-Q4 sur la plateforme Hugging Face :ValeurFX9507/Tifa-DeepsexV2-7b-MGRPO-GGUF-Q4

- Utilisez les commandes suivantes pour télécharger et installer le modèle :

git clone https://huggingface.co/ValueFX9507/Tifa-DeepsexV2-7b-MGRPO-GGUF-Q4 cd Tifa-DeepsexV2-7b-MGRPO-GGUF-Q4 pip install -r requirements.txt

- Modèles de chargement: :

- Dans l'environnement Python, utilisez le code suivant pour charger le modèle :

from transformers import AutoTokenizer, AutoModelForCausalLM tokenizer = AutoTokenizer.from_pretrained("ValueFX9507/Tifa-DeepsexV2-7b-MGRPO-GGUF-Q4") model = AutoModelForCausalLM.from_pretrained("ValueFX9507/Tifa-DeepsexV2-7b-MGRPO-GGUF-Q4")

- Dans l'environnement Python, utilisez le code suivant pour charger le modèle :

- Générer du texte: :

- Utilisez le code suivant pour la génération de texte :

input_text = "Once upon a time in a land far, far away..." inputs = tokenizer(input_text, return_tensors="pt") outputs = model.generate(**inputs) generated_text = tokenizer.decode(outputs[0], skip_special_tokens=True) print(generated_text)

- Utilisez le code suivant pour la génération de texte :

- Jeu de rôle et dialogue: :

- Pour les jeux de rôle et les dialogues complexes, l'exemple de code suivant peut être utilisé :

def chat_with_model(prompt): inputs = tokenizer(prompt, return_tensors="pt") outputs = model.generate(**inputs, max_length=500, do_sample=True, top_p=0.95, top_k=60) response = tokenizer.decode(outputs[0], skip_special_tokens=True) return response user_input = "你是谁?" print(chat_with_model(user_input))

- Pour les jeux de rôle et les dialogues complexes, l'exemple de code suivant peut être utilisé :

- Création littéraire: :

- Les capacités d'écriture créative du modèle permettent de générer des segments de roman ou de scénario :

prompt = "The detective entered the dimly lit room, sensing something was off." story = chat_with_model(prompt) print(story)

- Les capacités d'écriture créative du modèle permettent de générer des segments de roman ou de scénario :

- Paramètres d'optimisation: :

- En fonction des exigences spécifiques de l'application, les paramètres de génération peuvent être ajustés, tels que

max_length,top_prépondre en chantanttop_kafin d'obtenir différents effets générateurs.

- En fonction des exigences spécifiques de l'application, les paramètres de génération peuvent être ajustés, tels que

Avec ces étapes, les utilisateurs peuvent rapidement commencer à utiliser le modèle Tifa-DeepsexV2-7b-MGRPO-GGUF-Q4 et expérimenter ses puissantes capacités de génération de texte et de dialogue.

Tifa-DeepsexV2-7b-MGRPO Adresse de téléchargement

A propos de la méthode d'installation :APK Android officiel,SillyTavern.,Ollama

Téléchargement du modèle sur Quark : https://pan.quark.cn/s/05996845c9f4

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...