Think&Cite : Améliorer la précision des citations de textes en utilisant des techniques de recherche arborescente

résumés

Bien que les grands modèles de langage (LLM) soient performants, ils sont susceptibles d'halluciner et de générer des informations inexactes sur le plan factuel. Ce défi a motivé les efforts en matière de génération de textes d'attributs, qui incitent les LLM à générer un contenu contenant des preuves à l'appui. Dans cet article, nous proposons un nouveau cadre appelé Think&Cite et formulons la génération de texte d'attribut comme un problème de raisonnement en plusieurs étapes avec recherche intégrée. Plus précisément, nous proposons une recherche d'arbre de Monte Carlo auto-guidée (SG-MCTS), qui utilise la capacité d'auto-réflexion des LLM pour réfléchir aux états intermédiaires des MCTS, guidant ainsi le processus d'expansion de l'arbre. Pour fournir un retour d'information fiable et complet, nous avons introduit le modèle de récompense des progrès (PRM), qui mesure les progrès de la recherche arborescente depuis le nœud racine jusqu'à l'état actuel, tant du point de vue génératif que du point de vue des attributs. Nous avons mené des expériences approfondies sur trois ensembles de données et les résultats montrent que notre méthode est nettement plus performante que la méthode de base.

1 Introduction

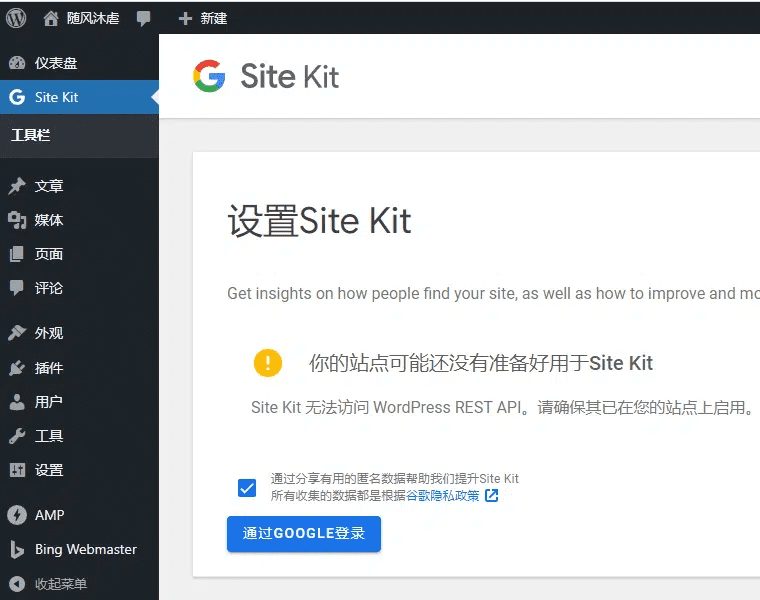

Les modèles de langage à grande échelle (LLM) (Zhao et al., 2023) donnent de bons résultats dans de nombreuses tâches de traitement du langage naturel. Malgré ces progrès, les LLM génèrent souvent des réponses qui contiennent des informations illusoires et inexactes (Ji et al., 2023 ; Huang et al., 2023 ; Zhang et al., 2023). Ce problème compromet leur fiabilité et, plus important encore, la confiance des utilisateurs dans les LLM. Pour améliorer la fiabilité des MLD, un nouveau paradigme de génération, la génération de texte d'attribut, a été proposé pour permettre aux MLD de générer des réponses contenant des citations dans le texte afin de fournir des preuves (Gao et al., 2023b), comme le montre la figure 1.

Figure 1 : À partir d'une question, le modèle génère un texte en citant des passages du corpus comme preuves à l'appui.

La plupart des travaux existants (Slobodkin et al., 2024 ; Sun et al., 2024 ; Fierro et al., 2024) invitent simplement les LLM à fournir des citations lors de la génération de texte. En outre, d'autres travaux (Li et al., 2024 ; Huang et al., 2024) tentent d'affiner les LLM sur de grandes quantités de données d'entraînement supervisées contenant du texte avec des citations annotées.Malgré ces efforts récents, le développement de LLM qui apprennent à générer un contenu fidèle avec des citations fiables reste un défi ouvert. Tout d'abord, les méthodes existantes utilisent un paradigme de génération autorégressif, qui peut être caractérisé de "système 1", un mode de pensée rapide et instinctif, mais insuffisamment précis (Kahneman, 2011). Par conséquent, toute erreur de génération intermédiaire (par exemple, une mauvaise représentation ou une mauvaise citation) peut entraîner une réponse finale incorrecte. Inspirés par la recherche sur le raisonnement complexe (Zhang et al., 2024 ; Wang et al., 2024), nous avons cherché à développer un modèle pour le paradigme du "système 2" pour la citation de preuves externes, qui exige une réflexion plus approfondie, plus prudente et plus logique (Kahneman, 2011). Deuxièmement, la génération de textes d'attributs implique souvent la génération de textes longs. liu et al. (2023) ont constaté que les réponses longues aux MLD existantes contiennent souvent des déclarations non étayées et des citations inexactes. Nous soutenons que le manque de planification explicite de la génération dans les travaux antérieurs a entravé les progrès de ces systèmes.

Dans cet article, nous présentons Think&Cite, un nouveau cadre pour l'intégration d'algorithmes de recherche dans la génération de textes d'attributs. Nous conceptualisons la tâche de génération comme un problème d'inférence en plusieurs étapes dans lequel le modèle génère une phrase à chaque étape par le biais d'un paradigme itératif penser-exprimer-référencer. Pour améliorer ce processus génératif, nous proposons la recherche d'arbre de Monte Carlo autoguidée (SG-MCTS), qui étend le MCTS classique avec deux innovations. Premièrement, notre approche utilise la capacité d'auto-réflexion des LLM pour réfléchir sur les états intermédiaires du MCTS en temps réel, guidant ainsi le processus d'expansion de l'arbre et évitant activement les chemins d'inférence insuffisants. Ceci contraste avec les travaux précédents qui réfléchissent principalement sur le résultat final ou la trajectoire complète. Deuxièmement, nous proposons le modèle de récompense des progrès (PRM), qui mesure les progrès de la recherche arborescente depuis le nœud racine jusqu'à l'état actuel du point de vue de la génération et des attributs. Contrairement à l'évaluation des étapes individuelles, le modèle de récompense basé sur la progression fournit une évaluation fiable et complète pour guider le processus de recherche des SCTM.

À notre connaissance, nous sommes les premiers à appliquer un algorithme de recherche arborescente à la tâche de génération de texte d'attribut. Nous avons mené des expériences approfondies sur trois ensembles de données pour valider l'efficacité de notre approche. Les résultats montrent que notre modèle surpasse de manière significative les indices précédents et les lignes de base affinées.

2 Travaux connexes

Génération de texte avec attribution. Les grands modèles de langage (LLM) ont été utilisés pour la génération de textes avec attribution en raison de leurs excellentes capacités de génération de langage (Gao et al., 2023b ; Huang et al., 2024 ; Sun et al., 2024 ; Li et al., 2024 ; Slobodkin et al., 2024). Les LLM pour la génération de textes avec attribution peuvent être divisés en deux grandes catégories. Le travail généré peut être divisé en deux catégories. Le premier type implique un réglage fin du LLM à l'aide de l'apprentissage des préférences (Li et al., 2024) et de l'apprentissage par renforcement (Huang et al., 2024), qui apprend au LLM à générer des citations de soutien et pertinentes afin d'obtenir des récompenses plus élevées. Cependant, cette approche repose sur des humains pour collationner des ensembles de données de haute qualité avec des citations dans le texte annotées. Une autre catégorie de travaux demande directement au LLM de générer du texte avec des attributions par le biais de la planification de l'attribution puis de la génération (Slobodkin et al., 2024) ou en utilisant un validateur externe pour guider la génération (Sun et al., 2024). Cependant, cette approche génère du texte et des citations de manière autorégressive, où toute génération intermédiaire imprécise est susceptible d'échouer dans le processus ultérieur. En revanche, notre approche propose une recherche arborescente autoguidée avec des récompenses progressives pour prendre en compte plusieurs chemins.

LLM avec recherche d'arbre : l'intégration des algorithmes de recherche d'arbre avec LLM a attiré une attention significative. Des études récentes ont examiné l'utilisation de méthodes de recherche d'arbres pour améliorer les performances du LLM pendant l'inférence (Zhang et al., 2024 ; Wang et al., 2024 ; Ye et Ng, 2024).Sutton (2019) a souligné la supériorité de la mise à l'échelle dans l'apprentissage et la recherche par rapport à d'autres méthodes. Des preuves empiriques suggèrent en outre que le calcul du temps d'inférence étendu peut améliorer de manière significative la performance des LLM sans nécessiter de formation supplémentaire (Brown et al., 2024 ; Snell et al., 2024).Une recherche (Hart et al., 1968) et une recherche d'arbre de Monte Carlo (MCTS) (Browne et al., 2012) sont utilisées comme techniques de planification pour améliorer la performance des LLM dans la résolution de problèmes d'inférence complexes. Ces algorithmes de recherche ont été largement utilisés dans l'apprentissage par renforcement (Silver et al., 2017) et dans de nombreuses applications réelles telles qu'AlphaGo (Silver et al., 2016). Notre travail est le premier à appliquer un algorithme de recherche arborescente (c'est-à-dire la recherche arborescente de Monte Carlo) pour résoudre la tâche de génération de texte avec attribution. En outre, nous proposons un MCTS auto-guidé, qui s'appuie sur le pouvoir de réflexion du LLM pour améliorer l'expansion de l'arbre.

3 Formulation du problème

Le cadre que nous proposons vise à permettre à la LLM Mθ La génération de réponses avec des citations dans le texte qui servent de preuve du contenu de la sortie est appelée génération de texte avec attribution (Slobodkin et al., 2024 ; Gao et al., 2023a).

Formellement, étant donné une question d'entrée x et un corpus de passages de textes D, le modèle Mθ Besoin de générer une réponse y = (y 1 , ... , y T ), la réponse consiste en T phrases, où chaque phrase yt Références à la liste des paragraphes de D, notées Ct = {C t,1 , ... , C t,m } En raison de l'avantage marginal de combiner plus de citations (Gao et al., 2023b), nous autorisons dans ce document jusqu'à trois citations par phrase (m ≤ 3) et celles-ci sont placées entre crochets, par exemple [1][2]. Nous nous concentrons également sur des scénarios à forte intensité de connaissances où le problème implique des connaissances sur le monde et où la plupart des phrases du MLD contiennent des faits multiples et nécessitent des citations à l'appui en tant que preuves. Conformément aux travaux antérieurs (Gao et al., 2023b ; Piktus et al., 2021), nous divisons le corpus D en paragraphes de 100 mots pour la recherche, ce qui facilite la vérification par les humains et n'introduit pas trop d'informations non pertinentes.

Grâce à un paradigme itératif "penser-exprimer-citer", nous proposons une recherche d'arbre de Monte Carlo auto-guidée (SG-MCTS), qui étend les MCTS classiques grâce à deux innovations. Pour améliorer ce processus génératif, nous proposons une recherche d'arbre de Monte Carlo auto-guidée (SG-MCTS), qui étend les MCTS classiques grâce à deux innovations : premièrement, notre approche utilise la capacité d'auto-réflexion du LLM pour réfléchir sur les états intermédiaires des MCTS en temps réel, guidant ainsi le processus d'expansion de l'arbre et évitant activement les chemins d'inférence insuffisants. Ceci contraste avec les travaux précédents qui réfléchissent principalement sur le résultat final ou la trajectoire complète. Deuxièmement, nous proposons le modèle de récompense des progrès (PRM) pour mesurer la progression de la recherche arborescente depuis le nœud racine jusqu'à l'état actuel en termes de deux aspects, à savoir la progression de la génération et la progression de l'attribution. Par rapport à l'évaluation d'étapes individuelles, le modèle de récompense basé sur la progression peut fournir une évaluation fiable et complète pour guider le processus de recherche des SCTM.

À notre connaissance, nous sommes les premiers à appliquer un algorithme de recherche arborescente à la tâche de génération de texte avec attribution. Nous avons mené des expériences approfondies sur trois ensembles de données pour valider l'efficacité de notre approche. Les résultats montrent que notre modèle est nettement plus performant que les précédents modèles basés sur les indices et les lignes de base affinées.

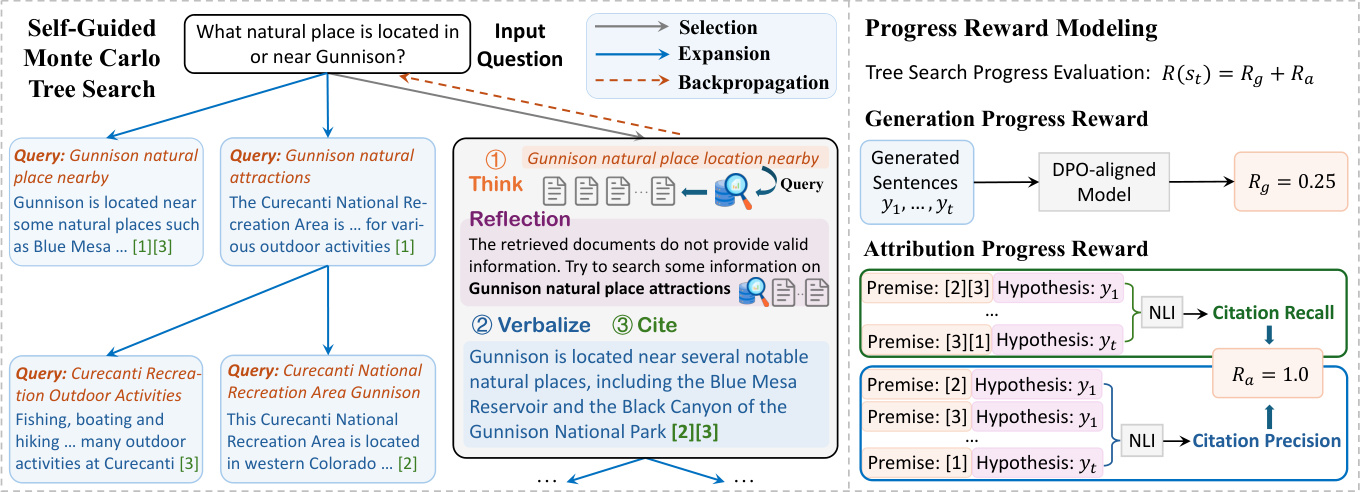

Figure 2 : Le cadre général de l'approche Think&Cite que nous proposons.

4 Méthodologie

Le cadre THINK&CITE proposé repose sur un agent linguistique pour la génération de textes d'attributs, qui utilise la recherche arborescente Monte Carlo autoguidée (SG-MCTS) pour planifier et rechercher des chemins de génération multiples et la modélisation de la récompense des progrès (PRM) pour fournir des signaux asymptotiquement fins au processus de recherche. La figure 2 illustre l'architecture globale de notre approche.

4.1 Agent de génération de textes d'attributs

Inspirés par des travaux antérieurs (Yao et al., 2022 ; Chen et al., 2023), nous développons un agent linguistique pour résoudre la tâche de génération de texte avec attribution, qui exécute un processus itératif penser-verbaliser-citer qui tire parti des capacités d'inférence et de planification du LLM.

Pour générer la tième phrase, l'agent réfléchit d'abord activement au prochain plan à générer (par exemple, un sujet de contenu ou un résumé) sous la forme d'une requête de recherche q t L'agent utilise ensuite l'outil de recherche pour récupérer les K premiers paragraphes D les plus pertinents du corpus D donné par le biais de l'opération de recherche (c.-à-d. "Search : {query}"). L'agent utilise ensuite l'outil de recherche pour extraire les k paragraphes D les plus pertinents du corpus D par le biais de l'opération de recherche (c.-à-d. "Recherche : {requête}"). t . Sur la base des passages récupérés, l'agent référence, via l'opération Generate (c'est-à-dire "Generate : {sentence}"), le texte de la base de données Dt Liste des paragraphes Ct pour exprimer une phrase y t . La requête historique, les paragraphes retrouvés, les phrases générées et les citations (désignées par H = {(q i , D i , y i , C i )}^t^ i=1 ) sera utilisé comme contexte pour l'étape suivante de la réflexion et de l'expression. Si l'agent considère que la tâche est résolue, il peut émettre "End" pour mettre fin au processus. De cette manière, l'agent peut planifier et récupérer différentes informations de manière réfléchie, ce qui peut prendre en compte de manière dynamique les changements d'orientation du contenu au fur et à mesure du processus de génération, contrairement aux travaux antérieurs qui s'appuyaient sur des corpus de référence statiques (Slobodkin et al., 2024 ; Huang et al. ..., 2024). En outre, ce paradigme est similaire aux travaux récents sur la génération itérative améliorée par la récupération (Jiang et al., 2023 ; Shao et al., 2023), mais diffère en ce que notre travail exige que le modèle prédise les plans de contenu pour la génération suivante afin de récupérer les informations pertinentes et de sélectionner soigneusement les références appropriées afin de les fusionner aux endroits appropriés dans le texte généré.

4.2 Recherche d'arbre Monte Carlo autoguidée

Nous formulons la génération de texte avec attribution comme un problème d'inférence en plusieurs étapes dans lequel le modèle réfléchit à l'attribution du texte. La recherche arborescente de Monte Carlo est devenue un algorithme de recherche efficace pour de nombreuses tâches de prise de décision (Silver et al., 2016 ; Ye et al., 2021). Dans ce travail, nous proposons une recherche d'arbre de Monte Carlo auto-guidée (SG-MCTS), qui utilise la capacité d'auto-réflexion du LLM pour guider le processus de recherche du MCTS. Les travaux précédents (Shinn et al., 2023 ; Zhou et al., 2024 ; Yu et al., 2024) réfléchissent généralement sur le résultat final ou la trajectoire complète, ce qui est inefficace et peu dense. En revanche, notre approche vise à critiquer et à réfléchir sur l'état intermédiaire des SCTM pour guider l'expansion de l'arbre en temps réel et ignorer activement les chemins de génération erronés.

En règle générale, les SCTM reposent sur un modèle de stratégie πθ Construire l'arbre de recherche T, qui est généralement LLM M θ . Dans cet arbre, le nœud st = [q t , D t , y t , C t ] représente l'état du tième niveau de l'arbre, y compris la requête de recherche q t D. Paragraphes récupérés t Phrases d'expression yt et les paragraphes cités C t . Le nœud racine s0 = [x] représente le problème d'entrée. À chaque itération, SG-MCTS suit quatre étapes, à savoir la sélection, l'extension guidée par la réflexion, l'évaluation et la rétropropagation.

Phase de sélection. La phase de sélection vise à identifier un nœud s dans l'arbre de recherche Tt pour une expansion ultérieure. L'algorithme UCT (Upper Confidence Constraint) appliqué aux arbres (Kocsis et Szepesvári, 2006) est utilisé pour sélectionner le meilleur nœud avec le score UCT le plus élevé :

UCT(s) t ) = V(s t ) + w √(ln N(p) / N(s)) t )) (1)

où V(s t ) est estimée au stade de l'évaluation st La fonction de valeur (récompense attendue), N(s t ) est st le nombre de visites, w le poids de l'exploration de contrôle, et p la valeur st du nœud parent.

Phase d'extension guidée par la réflexion . Dans la phase d'extension, en générant plusieurs nœuds successeurs s t+1 Les nœuds sélectionnés sont étendus par le processus think-verbalize-cite. s t L'étape Think génère d'abord un plan sous la forme d'une requête de recherche q̂ t+1 Il extrait le sujet et le contenu de la phrase suivante, qui sera utilisée pour récupérer le paragraphe D̂. t+1 . Cependant, le modèle de stratégie peut se tromper dans la phase d'extension, par exemple en générant des requêtes non spécifiques ou non pertinentes, ce qui peut entraver la recherche ultérieure de preuves et finalement conduire à une génération de phrases incorrectes. C'est pourquoi nous introduisons le modèle Réflexion où le modèle de stratégie est basé sur la question x et le passage récupéré D̂t+1 Enquête réflexive q̂t+1 pour identifier les erreurs :

u = M θ (q̂ t+1 , D̂ t+1 , x), (2)

où le texte de réflexion u contient des suggestions sur certains aspects de la recherche, par exemple que la requête devrait être plus ciblée sur le sujet de la recherche. Sur la base de la réflexion, le modèle stratégique reformule une nouvelle requête qt+1 pour retrouver le paragraphe D correspondant t+1 : :

q t+1 , Dt+1 = M θ (u, q̂ t+1 , D̂ t+1 , H), (3)

où H est la trace de l'historique. Il convient de noter que le processus ci-dessus peut être itéré jusqu'à ce que le modèle détermine que les preuves extraites sont favorables ou que le nombre maximum d'itérations soit atteint. Enfin, les étapes Verbalize et Cite sont extraites de Dt+1 Générer la phrase suivante y t+1 et avec des citations précises C t+1 : :

y t+1 , Ct+1 = M θ (q t+1 , D t+1 , H). (4)

Le nouveau nœud est constitué de la requête, du corpus récupéré, de la phrase générée et du paragraphe cité, notés st+1 = [q t+1 , D t+1 , y t+1 , C t+1 ] Par rapport aux expansions simples dans les SCTM typiques, notre approche améliore les nœuds d'expansion défectueux afin d'éviter une génération de mauvaise qualité. Les arbres des SCTM étant construits de manière incrémentale, l'amélioration de la qualité de l'opération suivante permet au modèle d'emprunter des chemins plus favorables dans un vaste espace de recherche, améliorant ainsi la qualité de recherche globale de l'arbre.

Phase d'évaluation. La phase d'évaluation vise à utiliser le modèle de récompense des progrès (voir section 4.3) pour calculer le nouveau nœud d'extension st+1 La récompense attendue de R(s t+1 ). L'évaluation des progrès comporte deux aspects : la création et l'attribution. Générer des incitations au progrès Rg Mesure des phrases générées jusqu'à présent y 1 , ... , yt+1 la qualité du texte. Acquisition Progression Récompense Ra Évaluation des phrases générées y 1 , ... , yt+1 et les paragraphes cités C 1 , ... , Ct+1 la cohérence attributionnelle entre eux. Enfin, la récompense totale est calculée comme la somme des deux : R(s t+1 ) = R g + R a .

Phase de rétropropagation. Dans la phase de rétropropagation, le nouveau nœud st+1 La récompense pour R(s t+1 ) est propagé vers son nœud parent s t qui met à jour chaque nœud sur le chemin allant du nœud racine à son parent s 0 , s 1 , ... , st La fonction de valeur du

N nouveau (s i ) = N ancien (s i ) + 1, 0 ≤ i ≤ t (5)

V nouveau (s i ) = (V ancien (s i )N ancien (s i ) + R(s t+1 )) / N nouveau (s i ) (6)

où N ancien (s i ) et V ancien (s i ) sont les nœuds si des fonctions de comptage et de valeur précédemment accédées.

4.3 Modèle de récompense des progrès

Les modèles antérieurs de récompense des résultats (Cobbe et al., 2021 ; Hosseini et al., 2024) et les modèles de récompense des processus (Lightman et al., 2024 ; Dai et al., 2024) se sont concentrés sur l'évaluation du résultat final ou des étapes intermédiaires. Dans ce travail, nous proposons qu'après l'étape suivante, la recherche de l'arbre de mesure à partir de la racine s0 à l'état st+1 Le progrès. Étant donné que le texte avec attribution comprend le contenu du texte et ses citations, nous avons conçu deux types de primes de progrès, les primes de progrès de génération et les primes de progrès d'attribution, afin d'évaluer respectivement la qualité du contenu du texte généré et la pertinence des citations.

4.3.1 Créer des incitations au progrès

Dans l'optimisation directe des préférences (DPO) (Rafailov et al., 2023), les rapports logarithmiques au niveau des marqueurs peuvent être interprétés comme suit

des récompenses implicites au niveau des marqueurs dans le cadre de l'apprentissage par renforcement à entropie maximale (RL). Nous proposons donc d'utiliser le modèle d'alignement DPO existant pour mesurer la génération de la phrase suivante yt+1 Phrases post-générées y1:t+1 = y 1 , ... , yt+1 Le score de qualité de R g .

Plus précisément, nous définissons un processus de décision de Markov (PDM) au niveau de la phrase où l'état st = (x, y 1 , ... , y t ) représente les entrées et les phrases générées jusqu'à présent, et l'état initial s0 = x est un problème d'entrée. L'action at = yt+1 désigne la phrase suivante à générer. Ainsi, l'objectif d'optimisation du RLHF peut être réécrit comme un problème de RL à entropie maximale au niveau de la phrase :

E àπθ(-|st)~ [∑^T^t=1 r'(s t , a t )] + βE s0x~ [H(π θ (-|s 0 ))],

où la fonction de récompense au niveau de la phrase r' peut être calculée comme suit :

r'(s t , a t ) = { βlog π ref (a t |s t ), si st+1 ce n'est pas la fin de la ligne

{r'(y|x) + βlog π ref (a t |s t ) Si s t+1 C'est la fin de la ligne.

La formule RL à entropie maximale permet de dériver la fonction de valeur optimale V et la fonction Q Q comme suit :

Q(s t , a t ) = r'(s t , a t ) + V(s t+1 ),

V(s t ) = log ∑a exp(Q(s t , a)), lorsque t ≤ T .

Par conséquent, la politique optimale π est dérivée comme suit :

⇒ βlog π(a) t |s t ) = Q(s t , a t ) - V(s t ),

⇒ βlog (π(a)) t |s t ) / π ref (a t |s t )) = V(s t+1 ) - V(s t ).

Cela nous a incités à utiliser la stratégie DPO pour dériver la somme partielle des récompenses afin de formuler des réponses partielles y1:t+1 Incitations au progrès R g : :

∑^t^k=0 βlog (π(a k |s k ) / π ref (a k |s k )) = V(s t+1 ) - V(s 0 ),

⇒ R g (y 1:t+1 ) = ∑^t^k=0 wk log (π(y k+1 |x, y 1:k ) / π ref (y k+1 |x, y 1:k )),

où y1:k dénote y 1 , ... , y k wk = 1 / (t+1) est le poids de chaque rapport de log-vraisemblance au niveau de la phrase.

4.3.2 Récompenses pour la progression des attributs

Nous utilisons deux mesures de citations utilisées dans des travaux antérieurs (Gao et al., 2023b), le rappel et la précision des citations, pour représenter la récompense de la progression de l'attribution R a .

Plus précisément, le rappel de citations mesure la réponse partielle y1:t+1 de phrases pouvant être étayées par le passage cité correspondant. Nous avons utilisé le modèle NLI (Honovich et al., 2022) pour vérifier si les passages cités pouvaient dériver les réponses du modèle. Pour chaque phrase yi (1 ≤ i ≤ t + 1), nous aurons Ci Les passages cités dans sont joints en tant que prémisse et la phrase générée yi comme hypothèses pour le modèle NLI. Nous fixons le rappel de la citation à 1 si la prémisse contient une hypothèse et à 0 dans le cas contraire. La précision de la citation évalue le pourcentage de citations qui soutiennent la phrase correspondante. Nous utilisons le même modèle NLI que ci-dessus pour calculer le score de précision. Pour chaque citation c i,j Si (1) Ci Toutes les citations dans y contiennent la phrase générée yi et (2) Ci \ {c i,j } sans la phrase y i Nous calculons le score de précision (0 ou 1) pour chaque citation et en faisons la moyenne pour toutes les citations. Enfin, nous calculons le score F1 en tant que récompense de progrès attribuée R a (y 1:t+1 , C 1 , ... , C t+1 ) afin de fournir une mesure de qualité d'attribution équilibrée entre les phrases générées et les passages cités.

5 expériences

5.1 Dispositif expérimental

Jeux de données. Pour l'évaluation, nous utilisons le test de référence ALCE (Gao et al., 2023b), qui se compose de trois ensembles de données : (1) ASQA (Stelmakh et al., 2022), un ensemble de données d'AQ de forme longue contenant des questions ambiguës qui nécessitent des réponses multiples pour couvrir différents aspects ; (2) QAMPARI (Amouyal et al. 2022), un ensemble de données factuelles d'AQ dans lequel la réponse à chaque question est une liste d'entités extraites de différents passages ; et (3) ELI5 (Fan et al., 2019), un ensemble de données d'AQ de longue durée contenant des questions de type comment/pourquoi/quoi. Pour ASQA et QAMPARI, la plupart des questions peuvent être répondues via Wikipédia, nous utilisons donc l'instantané de Wikipédia du 20/12/2018 comme corpus. Pour ELI5, les questions étant thématiquement diverses, nous utilisons Sphere (Piktus et al., 2021) (une version filtrée de Common Crawl) comme corpus. À l'instar de Gao et al. (2023b), nous utilisons GTR (Ni et al., 2022) pour Wikipedia et Sphere BM25 (Robertson et al., 2009) pour récupérer les 100 premiers passages en tant que corpus pour chaque question. Voir l'annexe A pour plus de détails.

Paramètres d'évaluation. Nous utilisons les paramètres d'évaluation du test de référence ALCE original. Pour évaluer l'exactitude des résultats, nous utilisons Exact Match (EM) Recall de l'ASQA, Recall-5 de QAMPARI et Statement Recall de ELI5 pour mesurer le pourcentage de réponses en or (éléments d'information clés) dans les résultats. Nous calculons également la précision en tant que mesure d'exactitude pour l'ensemble de données QAMPARI afin de mesurer le pourcentage de réponses correctes dans les réponses générées. Pour évaluer la qualité des citations du résultat, nous calculons le rappel de citations, qui mesure le pourcentage de phrases du résultat qui peuvent être déduites des passages qu'elles citent, et la précision des citations, qui mesure le pourcentage de citations qui peuvent aider à étayer les phrases du résultat.

Base de référence. Nous comparons notre approche avec celle basée sur ChatGPT et GPT-40 sont comparés aux valeurs de référence suivantes :

Vanille RAG Le modèle a été directement chargé de générer des réponses basées sur les 5 premiers paragraphes donnés et de les citer en conséquence. Nous utilisons l'apprentissage contextuel avec deux présentations (Brown et al., 2020).

Le RAG "Résumé/Snippet" fournit un résumé ou un extrait du paragraphe, plutôt que le texte intégral. Le modèle génère des réponses avec des citations basées sur les 10 premiers résumés ou extraits de paragraphes.

Interact permet au modèle d'accéder au texte intégral de certains paragraphes dans la méthode RAG Résumé/Snippet. Le modèle peut présenter une action "Vérifier : Document [1] [2]" pour obtenir le texte intégral du document correspondant.

La recherche en ligne permet au modèle de demander une action "Recherche : {requête}" pour récupérer les paragraphes les plus pertinents parmi les 100 premiers. Cette méthode est similaire à la nôtre en ce sens qu'elle agit comme une comparaison directe.

ReRank tire au sort quatre réponses pour chaque question et sélectionne la meilleure réponse sur la base d'une métrique de rappel de citation.

La ligne de base ci-dessus a été appliquée et évaluée dans le test de référence ALCE original, comme indiqué dans (Gao et al., 2023b). En outre, nous comparons notre approche avec des travaux antérieurs sur la génération de texte avec attribution.FG-Reward (Huang et al., 2024) suggère l'utilisation de récompenses à grain fin comme signaux de formation pour affiner LLaMA-2-7B (Touvron et al., 2023) afin de générer des réponses attribuables.VTG (Sun et al., 2024) utilise des mémoires évolutives et un validateur à deux couches pour générer des réponses attribuables.VTG (Sun et al., 2024) utilise des mémoires évolutives et un validateur à deux couches pour générer des réponses attribuables. APO (Li et al., 2024) a rassemblé un ensemble de données de paires de préférences et a appliqué l'optimisation des préférences à LLaMA-2-13B pour la génération de texte avec attribution.

Détails de la mise en œuvre. Nous utilisons LLaMA-3.1-8B-Instruct et GPT-40 comme modèles de stratégie pour évaluer la performance de notre approche. Pour les modèles de récompense, nous utilisons le modèle DPO, Llama-3-8B-SFR-Iterative-DPO-R¹, pour calculer les récompenses de progrès génératif et le modèle NLI, T5-XXL-TRUE-NLI-Mixture (Honovich et al., 2022), pour calculer les récompenses de progrès attributif. Pour chaque requête de recherche, nous récupérons les 3 premiers passages du corpus comme références candidates D t . Dans l'algorithme UCT (équation 1), le poids w est fixé à 0,2. Pour le SG-MCTS, nous étendons trois nœuds enfants pour chaque nœud parent et fixons le niveau maximal de l'arbre à 6 et le nombre maximal d'itérations pour le MCTS à 30.

5.2 Principaux résultats

Le tableau 1 présente les résultats de notre méthode et de la méthode de référence sur les trois ensembles de données.

Tout d'abord, on peut observer que les trois méthodes RAG (Retrieval Augmented Generation) présentent des performances modérées, bien que l'utilisation de résumés ou de snippets puisse améliorer l'exactitude. ReRank entraîne une amélioration constante de la qualité des citations dans les trois ensembles de données (par exemple, vanilla RAG améliore le rappel des citations de 73,61 TP3T à 84,81 TP3T dans ASQA). À titre de comparaison directe, la recherche en ligne est similaire à notre approche, mais ses performances sont inférieures à celles des autres lignes de base. Cela est dû au fait que les requêtes de recherche sont simplement demandées sans tenir compte de la qualité et de la pertinence des preuves.

Deuxièmement, en affinant le LLM sur des données de formation supervisées avec des citations annotées, FG-Reward et APO montrent une qualité de citation accrue dans les ensembles de données ASQA et ELI5, mais pas de performance améliorée dans QAMPARI. En outre, VTG utilise un validateur génératif et un validateur en mémoire pour évaluer le soutien logique de la preuve, ce qui conduit à une qualité de citation élevée (par exemple, rappel de citation de 86,71 TP3T dans ASQA). Cependant, les LLM affinés sont limités par la qualité et la quantité des données de formation supervisées, où les preuves à l'appui nécessitent un coût important pour établir un lien avec la source correcte. En outre, ces méthodes reposent toujours sur la génération autorégressive, qui est un mode de pensée rapide mais moins précis. Par conséquent, toute erreur de génération intermédiaire (par exemple, des représentations erronées ou des citations inadéquates) entraînera des problèmes dans la réponse finale.

| ASQA | QAMPARI | ELI5 | |

|---|---|---|---|

| La régularité | Citation | La régularité | Citation |

| EM Rec. | Rec. | Préc. | Rappel-5 |

| ChatGPT | |||

| Vanille RAG | 40.4 | 73.6 | 72.5 |

| avec ReRank | 40.2 | 84.8 | 81.6 |

| Résumé RAG | 43.3 | 68.9 | 61.8 |

| avec Interact | 39.1 | 73.4 | 66.5 |

| Snippet RAG | 41.4 | 65.3 | 57.4 |

| w/Interact | 41.2 | 64.5 | 57.7 |

| Recherche en ligne | 32.4 | 58.3 | 58.2 |

| GPT-40 | |||

| Vanille RAG | 41.3 | 68.5 | 75.6 |

| avec ReRank | 42.1 | 83.4 | 82.3 |

| Résumé RAG | 46.5 | 70.2 | 67.2 |

| avec Interact | 48.1 | 73.1 | 72.8 |

| Snippet RAG | 45.1 | 68.9 | 66.5 |

| w/Interact | 45.2 | 67.8 | 66.7 |

| Recherche en ligne | 40.3 | 65.7 | 66.9 |

| FG-Récompense | 40.1 | 77.8 | 76.3 |

| VTG | 41.5 | 86.7 | 80.0 |

| APO | 40.5 | 72.8 | 69.6 |

| La nôtre (LLaMA) | 45.2 | 82.3 | 80.6 |

| Le nôtre (GPT-40) | 50.1 | 89.5 | 87.1 |

Tableau 1 : Résultats de l'évaluation de la génération de textes d'attributs sur trois ensembles de données. Les abréviations "Rec." et "Prec." désignent le rappel et la précision. Les caractères gras et soulignés indiquent respectivement les meilleurs et les deuxièmes meilleurs résultats dans chaque ensemble de données.

Think&Cite formule la tâche de génération de texte d'attribut comme un problème de raisonnement en plusieurs étapes et introduit un mode de réflexion lent et délibéré pour rechercher la meilleure solution. En proposant un algorithme MCTS auto-guidé, Think&Cite utilise la capacité d'auto-réflexion des LLM pour guider le processus d'expansion de l'arbre. En outre, le modèle de récompense des progrès proposé peut fournir un retour d'information complet et fiable pour aider le modèle à explorer de meilleures réponses générées.

5.3 Analyses complémentaires

Nous présentons d'autres analyses de notre méthode sur l'ASQA en utilisant le GPT-40, car nous avons obtenu des résultats similaires sur d'autres ensembles de données.

Étude d'ablation. Pour valider l'efficacité du cadre proposé, nous avons analysé ses principaux éléments de conception pour l'ablation. Nous avons conçu quatre variantes : (1) w/o SG-MCTS supprime l'algorithme MCTS autoguidé et génère directement les réponses étape par étape ; (2) w/o Reflection supprime l'étape de réflexion et utilise l'algorithme MCTS vanille ; (3) w/o GP Reward supprime la nécessité de générer des récompenses de progrès R g (4) sans récompense de PA Suppression des récompenses d'acquisition de progrès R a Les résultats sont présentés dans le tableau 2. Nous présentons les résultats dans le tableau 2. Toutes les variantes sont moins performantes que la méthode originale, ce qui montre l'efficacité de chaque composant. En particulier, les performances de w/o SG-MCTS sont nettement inférieures, ce qui suggère que l'intégration d'un algorithme de recherche dans la génération de texte avec attribution est très bénéfique. L'utilisation de MCTS vanille (sans réflexion) entraîne une baisse de la qualité des citations, en raison de l'introduction de fausses références sans réflexion sur les résultats récupérés. De même, l'absence de récompense GP et l'absence de récompense AP entraînent une baisse des performances, ce qui suggère que le contrôle de la qualité de la génération et de la citation sont tous deux essentiels.

| Méthode | La régularité | Citation |

|---|---|---|

| EM Rec. | Rec. | Préc. |

| Think&Cite | 50.1 | 89.5 |

| w/oSG-MCTS | 42.1 | 78.2 |

| sans réflexion | 46.5 | 83.6 |

| w/oGPReward | 47.1 | 86.2 |

| w/oAPReward | 46.7 | 81.3 |

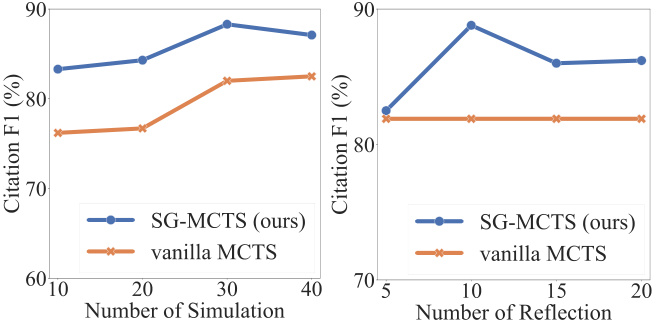

Auto-réflexion et simulation. Dans chaque simulation, SG-MCTS suit quatre étapes clés et utilise l'autoréflexion pour améliorer la qualité des états intermédiaires dans l'extension en critiquant et en améliorant les requêtes d'erreur. Pour vérifier l'efficacité de la réflexion, nous avons comparé les performances entre l'augmentation du nombre maximal de simulations et l'augmentation du nombre maximal d'opérations de réflexion. Nous avons d'abord modifié le nombre maximal de simulations en {10, 20, 30, 40} et fixé le nombre maximal de réflexions à 10. De même, nous avons modifié le nombre maximal de réflexions en {5, 10, 15, 20} et fixé le nombre maximal de simulations à 30. Nous présentons les scores F1 basés sur le rappel et la précision des citations dans la figure 3. La figure montre que l'augmentation du nombre de simulations et du nombre de réflexions améliore les performances de la génération de texte avec attribution. Ce résultat est attendu, car une exploration plus poussée améliore la probabilité de trouver la génération correcte. SG-MCTS est plus performant que vanilla MCTS sans réflexion parce qu'il peut y avoir des recherches incorrectes dans le nœud parent, ce qui fait que le processus de raisonnement dans le nœud enfant étendu continue sur la mauvaise voie. L'étape de réflexion améliore les extractions incorrectes dues à des requêtes insuffisantes, ce qui permet à l'exploration ultérieure de se dérouler avec plus de précision.

Figure 3 : Résultats de l'ASQA concernant le nombre de simulations (à gauche) ou le nombre d'étapes de réflexion (à droite).

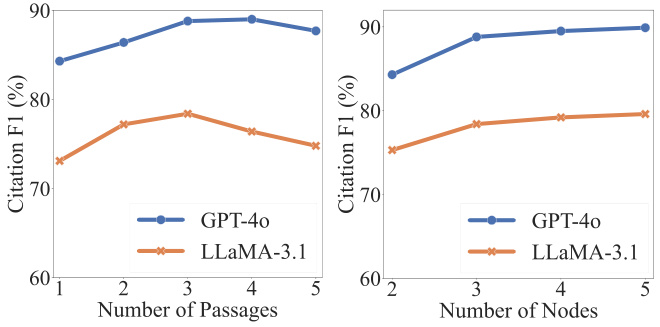

Analyse des hyperparamètres. Deux hyperparamètres sont essentiels pour l'exactitude et la qualité des citations : chaque requête qt Nombre de paragraphes récupérés |D t | Les nœuds enfants et les nœuds enfants étendus dans la recherche arborescente st+1 Le nombre de paragraphes récupérés. Comme le montre la figure 4, la qualité des citations peut être initialement améliorée en augmentant le nombre de paragraphes récupérés. Cependant, au-delà d'un certain seuil, les performances se dégradent, principalement parce que la fusion d'un plus grand nombre de paragraphes introduit du bruit qui affecte négativement la fiabilité du contenu généré. D'autre part, nous observons que l'augmentation du nombre de nœuds développés conduit à une amélioration constante, bien que l'amélioration se stabilise par la suite. Étant donné que l'expansion d'un plus grand nombre de nœuds entraîne des coûts de calcul plus élevés, nous extrayons trois enfants pour chaque nœud parent.

Figure 4 : Résultats de l'ASQA concernant le nombre de paragraphes (à gauche) ou le nombre de nœuds étendus (à droite).

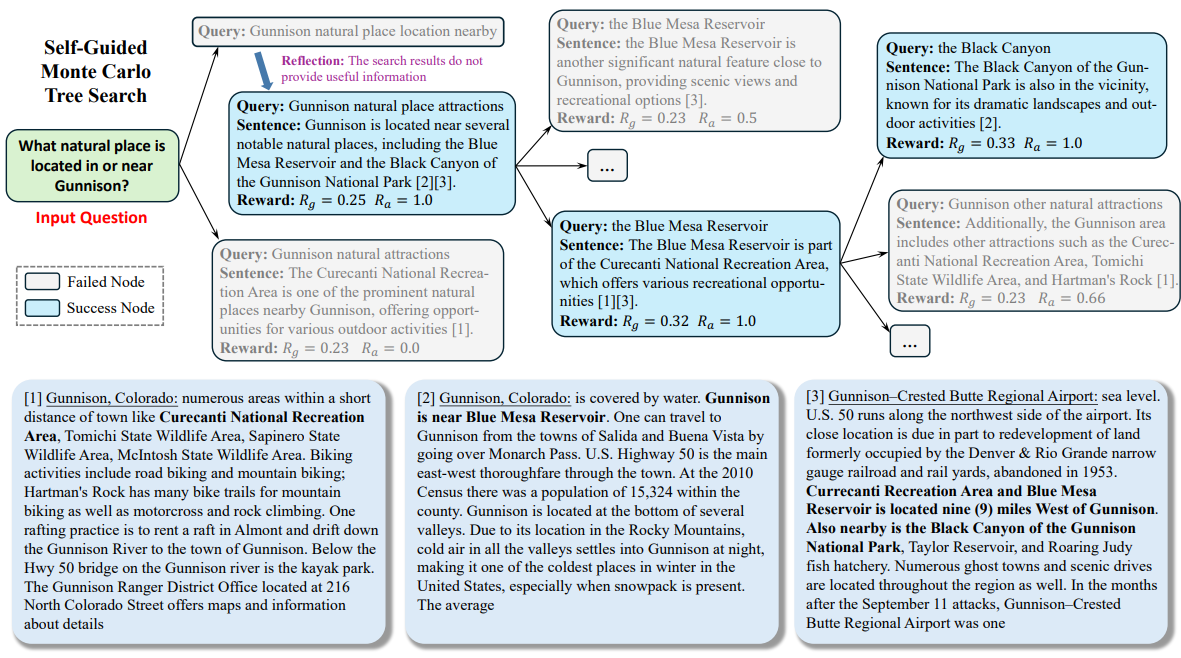

5.4 Études de cas

Afin de faciliter la compréhension de l'ensemble du processus de notre méthode, nous avons effectué une analyse qualitative dans ASQA. Nous montrons un exemple dans l'annexe C. Tout au long du processus de recherche, LLM traite le problème d'entrée comme le nœud racine et étend progressivement l'arbre de recherche pour atteindre l'état de terminaison. Comme montré, le modèle génère d'abord une requête (i.e., "Location of nearby Gunnison natural attractions") pour récupérer des passages. Comme le passage ne contient pas d'informations valides nécessaires pour répondre à la question, le modèle réfléchit et propose une nouvelle requête (par exemple, "Sites d'attractions naturelles de Gunnison") pour la récupération. Sur la base des paragraphes extraits, le modèle génère des phrases et des références aux deuxième et troisième paragraphes (c'est-à-dire "[2][3]"). En suivant un processus de génération en plusieurs étapes, le modèle peut réfléchir en profondeur au sujet et produire un contenu fiable avec des citations précises.

6 Conclusion

Dans ce travail, nous présentons Think&Cite, un nouveau cadre pour la génération de texte d'attribut avec recherche d'arbre intégrée. Think&Cite s'appuie sur le paradigme de génération itérative penser-exprimer-citer. Pour améliorer le processus de génération, nous proposons une recherche d'arbre Monte Carlo auto-guidée, qui exploite la capacité d'autoréflexion des LLM pour critiquer et corriger les états intermédiaires des MCTS afin de guider l'expansion de l'arbre. En outre, nous proposons le modèle de récompense du progrès pour mesurer le progrès de la recherche d'arbre et fournir un retour d'information fiable. Des expériences approfondies sur trois ensembles de données montrent que notre proposition Think&Cite est plus performante que les méthodes traditionnelles d'indication et de réglage fin.

limitations

La portée de nos expériences est limitée par le coût informatique important des méthodes de recherche basées sur les arbres. Les travaux futurs pourraient porter sur un plus grand nombre d'ensembles de données de génération de textes d'attributs. Dans notre modèle, la recherche arborescente de Monte Carlo est utilisée pour la génération autoguidée. Les travaux futurs pourraient porter sur d'autres algorithmes de recherche afin d'évaluer la généralité et la robustesse du cadre proposé.

annexe

Un ensemble de données

Nous évaluons notre approche sur le benchmark ALCE, qui se compose de trois ensembles de données. Plus précisément, l'ensemble de données ASQA (Stelmakh et al., 2022) contient 948 questions dont les réponses peuvent être trouvées sur Wikipedia ; l'ensemble de données QAMPARI (Amouyal et al., 2022) contient 1 000 questions basées sur Wikipedia ; et l'ensemble de données ELI5 (Fan et al., 2019) contient 1 000 questions dont les réponses peuvent être trouvées dans Sphere (Piktus et al., 2021). questions et les réponses peuvent être trouvées dans Sphere (Piktus et al., 2021). Les détails de ces trois ensembles de données sont présentés dans le tableau 3.

| ensemble de données | Corpus (passages #) | Type de problème |

|---|---|---|

| ASQA | Wikipedia (21 millions) | factuel |

| QAMPARI | Wikipedia (21 millions) | Factuel (tabulation) |

| ELI5 | Sphère (899 millions) | Pourquoi/comment/quoi |

B Conseils

Nous avons demandé au LLM d'effectuer une recherche d'arbre auto-guidée pour générer des textes d'attribut d'une manière d'apprentissage sans échantillon.Les indices d'apprentissage contextuel pour les ensembles de données ASQA, QAMPARI, et ELI5 sont montrés dans les tableaux 4, 5, et 6, respectivement.Dans ces indices, nous avons d'abord défini quatre opérations dans le paradigme itératif penser-exprimer-référencer pour le LLM. Ensuite, nous avons construit quatre exemples contextuels qui ont été sélectionnés pour être cohérents avec le benchmark ALCE (Gao et al., 2023b).

C Études de cas

La figure 5 présente un exemple tiré de l'ASQA.

Votre objectif est de rédiger une réponse précise, intéressante et concise à une question donnée en utilisant uniquement les résultats de recherche fournis et en les citant correctement. Utilisez un ton juste et journalistique. Citez toujours un fait. Vous pouvez utiliser quatre actions :

- """Recherche : mots-clés"", qui demande certains mots-clés et extrait les documents les plus pertinents sur la base de l'historique de recherche et de génération.

- "Réfléchir : idées"""" et réfléchir aux résultats de la recherche si aucun document valide n'a été obtenu pour répondre à la question.

- """Sortie : phrase """qui produit une réponse longue basée sur le document récupéré. Dans la réponse, le document est correctement cité en utilisant [1][2][3]. Citez au moins un document et jusqu'à trois documents par phrase. Si plusieurs documents étayent la phrase, seul le sous-ensemble de documents le moins suffisant est cité.

- """Fin"", il met fin à la tâche du quiz.

Voici quelques exemples :

Question : Qui a établi le record du tir à la plus longue distance ?

Recherche : Record du tir à la plus longue distance

Document[1] (Légende : David Akers) a établi un record pour le plus long field goal en bottant un field goal de 63 yards au-dessus de la barre transversale.

Documentation[2] (Titre : Dirk Borgognone) Dirk Borgognone, Dirk Ronald Borgognone (né le 9 janvier 1968) est un ancien...

Document[3] (Titre : Russell Elkseben) contre l'Université du Colorado. Malgré des difficultés en début de match, dont...

Réflexion : Les résultats de la recherche ne fournissent pas d'informations valables pour répondre à la question. Il est préférable de rechercher le record du plus long field goal de la NFL.

Recherche : Record du plus long field goal en NFL

Document[4] (Titre : Field Goal) vers votre propre zone d'en-but. Le plus long field goal de l'histoire de la NFL est de 64 yards, un record établi par...

Document [5] (Titre : Portée des buts) zone d'en-but à chaque extrémité) n'était que de 66 yards. Scaccia, qui jouait au football en salle, a tenté un...

Document[6] (Titre : Gamme de tirs) Ce résultat n'est pas un record officiel. Tous les tirs ci-dessus ont été réussis...

Résultat : Le record du plus long field goal dans un match de NFL est de 64 yards, établi par Matt Prater[4].

Recherche : Record du tir le plus long à tous les niveaux de compétition, université

Document[7] (Titre : Field Goal) vers votre propre zone d'en-but. Le plus long field goal de l'histoire de la NFL est de 64 yards, un record établi par...

Documentation[8] (Titre : Portée des tirs) La ligne des 35 à 40 yards (plus proche par vent de travers) tente généralement les...

Document[9] (Titre : Field goal range) NFL, et est interdit par la NCAA depuis 1989) est de 68 yards, détenu par Fabrizio Scaccia...

Résultat : Toutefois, le record du plus long field goal, tous niveaux de compétition confondus, est de 69 yards, botté par le botteur universitaire Ove Johansson lors d'un match de football opposant en 1976 l'Abilene Christian University à l'East Texas State University[8]. La fin.

Votre objectif est de rédiger une réponse précise, intéressante et concise à une question donnée en utilisant uniquement les résultats de recherche fournis et en les citant correctement. Utilisez un ton juste et journalistique. Citez toujours un fait. Vous pouvez utiliser quatre actions :

- """Recherche : mots-clés"", qui demande certains mots-clés et extrait les documents les plus pertinents sur la base de l'historique de recherche et de génération.

- "Réfléchir : idées"""" et réfléchir aux résultats de la recherche si aucun document valide n'a été obtenu pour répondre à la question.

- """Sortie : phrase """qui produit une réponse longue basée sur le document récupéré. Dans la réponse, le document est correctement cité en utilisant [1][2][3]. Citez au moins un document et jusqu'à trois documents par phrase. Si plusieurs documents étayent la phrase, seul le sous-ensemble de documents le moins suffisant est cité.

- """Fin"", il met fin à la tâche du quiz.

Voici quelques exemples :

Question : Quels sont les livres écrits par Nevil Shute ?

Recherche : Neville Shute Thèmes Troubles sociaux

Document[1] (Titre : Nevil Shute) Premières étapes. Mes félicitations". Sa réputation d'écrivain a conduit le ministère de l'Information à l'envoyer...

Document [2] (Titre : Nevil Shute) Le thème est le franchissement des barrières sociales telles que la classe ("The Lonely Road" et "The Landing"), la race...

Document[3] (Titre : Nevil Shute) Entreprise de construction aéronautique, Airspeed Ltd. Ses romans gagnent en popularité, mais il devient plus célèbre...

Production : Beyond the Black Stump [2], Lonely Road [2], Chessboard [2], In the Damp [2], Toolroom Trustee [2], Around the Bend [2].

Recherche : Nevil Shute Simple Readable Style

Documents[4] (Nevil Shute) Entreprise de construction aéronautique, Airspeed Ltd. Ses romans gagnent en popularité, mais il devient plus célèbre...

Document[5] (Checkerboard) People of Burma", qui sont tous deux au cœur de l'histoire du livre. Schutt s'inquiète des ventes du livre...

Documentation[6] (humide) Il a utilisé l'idée du vote à plusieurs reprises dans la nouvelle "The Curious Republic of Gondor"...

Réflexion : Les résultats de la recherche n'ont pas fourni d'informations utiles pour répondre à la question. Il est préférable de rechercher des livres de Nevil Shute datant des années 1950.

Recherche : Livres des années 1950 de Nevil Shute

Document[7] (Nevil Shute) Premiers stades. Mes félicitations". Sa réputation d'écrivain a conduit le ministère de l'Information à l'envoyer...

Document [8] (Nevil Shute) Le thème est le franchissement des barrières sociales telles que la classe ("The Lonely Road" et "The Landing"), la race ("The Chessboard")....

Documents[9] (Nevil Shute) Entreprise de construction aéronautique, Airspeed Ltd. Ses romans gagnent en popularité, mais il devient plus célèbre...

Sortie : Malazan [7], Stephen Morris [7].

fermer

Votre objectif est de rédiger une réponse précise, intéressante et concise à une question donnée en utilisant uniquement les résultats de recherche fournis et en les citant correctement. Utilisez un ton juste et journalistique. Citez toujours un fait. Vous pouvez utiliser quatre actions :

- """Recherche : mots-clés"", qui demande certains mots-clés et extrait les documents les plus pertinents sur la base de l'historique de recherche et de génération.

- "Réfléchir : idées"""" et réfléchir aux résultats de la recherche si aucun document valide n'a été obtenu pour répondre à la question.

- """Sortie : phrase """qui produit une réponse longue basée sur le document récupéré. Dans la réponse, le document est correctement cité en utilisant [1][2][3]. Citez au moins un document et jusqu'à trois documents par phrase. Si plusieurs documents étayent la phrase, seul le sous-ensemble de documents le moins suffisant est cité.

- """Fin"", il met fin à la tâche du quiz.

Voici quelques exemples :

问题 :是什么导致了双相情感障碍?

搜索 :什么是双相情感障碍?

La recherche suggère les éléments suivants...

文档[2] (标题:双相情感障碍的生物学)位于这些区域的大脑区域被假设为双相情感障碍的机制...

文档[3] (标题:双相情感障碍的生物学)无论极性如何。炎症在双相情感障碍中一直有报道...

Réflexion : Les résultats de la recherche n'ont pas fourni d'informations valables pour répondre à la question.

Combien de temps durent-ils ?

文档[4] (标题:双相情感障碍 | 医学词典中的定义)双相情感障碍 | 双相情感障碍的定义...

文档[5] (标题:躁狂和双相情感障碍)可以从抑郁到“非常快乐”都在一天中,甚至在几天内,这...

Document [6] (Titre : Pour les particuliers - Adam Schwartz) Pour les particuliers 2014 Adam Schwartz Les informations sont nombreuses et couvrent...

Les sautes d'humeur peuvent durer de quelques jours à plusieurs mois [5].

搜索 :是什么导致了双相情感障碍?

文档[7] (标题:双相情感障碍)双相情感障碍通常是一种循环性疾病,个体表现出抑郁...

Document [8] (Titre : Depression Bipolar Disorder Symptoms 2019 | Beat Depression) Depression Bipolar Disorder Symptoms 2019.

La documentation[9] (Titre : Troubles mentaux) peut inclure des facteurs parentaux, notamment le rejet parental, le manque de chaleur parentale...

OUTPUT : Nous ne connaissons pas encore les facteurs exacts qui contribuent à cette maladie, mais on pense que la génétique est un facteur majeur [7].

fermer

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...