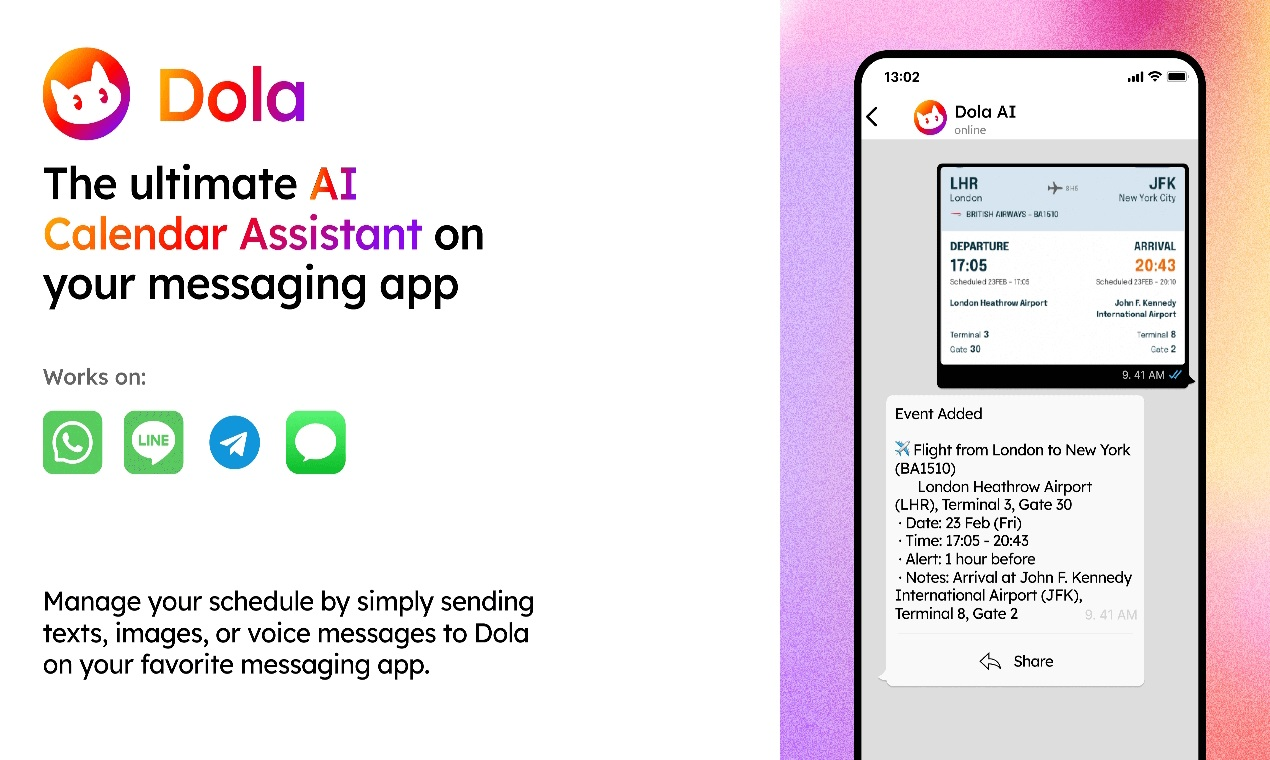

Dola : un assistant mobile d'IA pour une gestion rapide des horaires dans WhatsApp

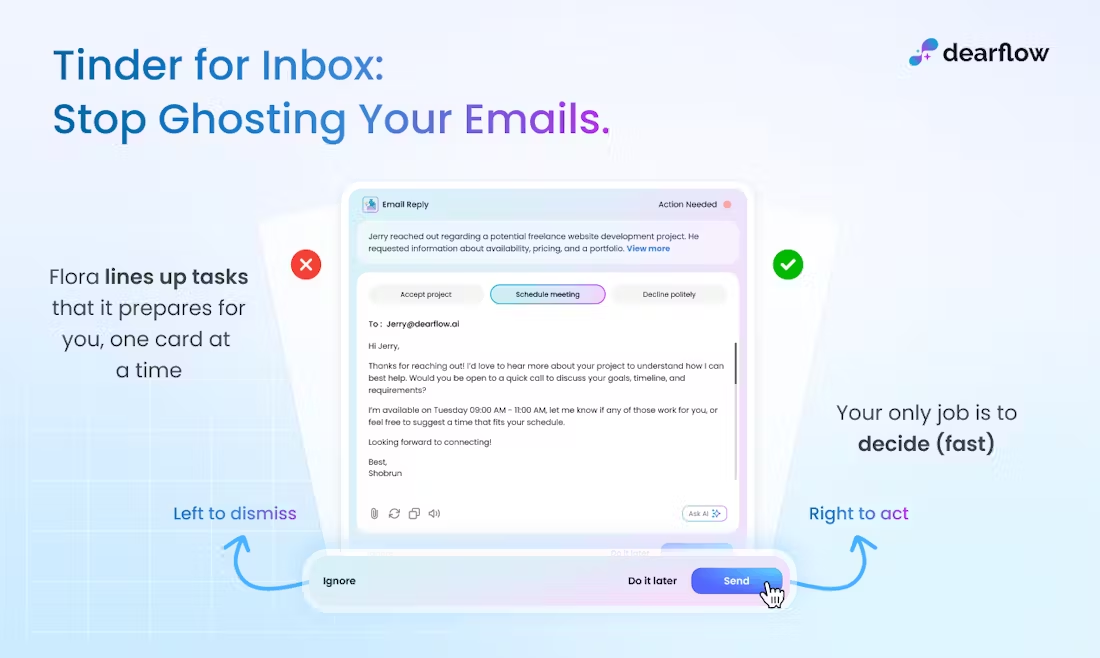

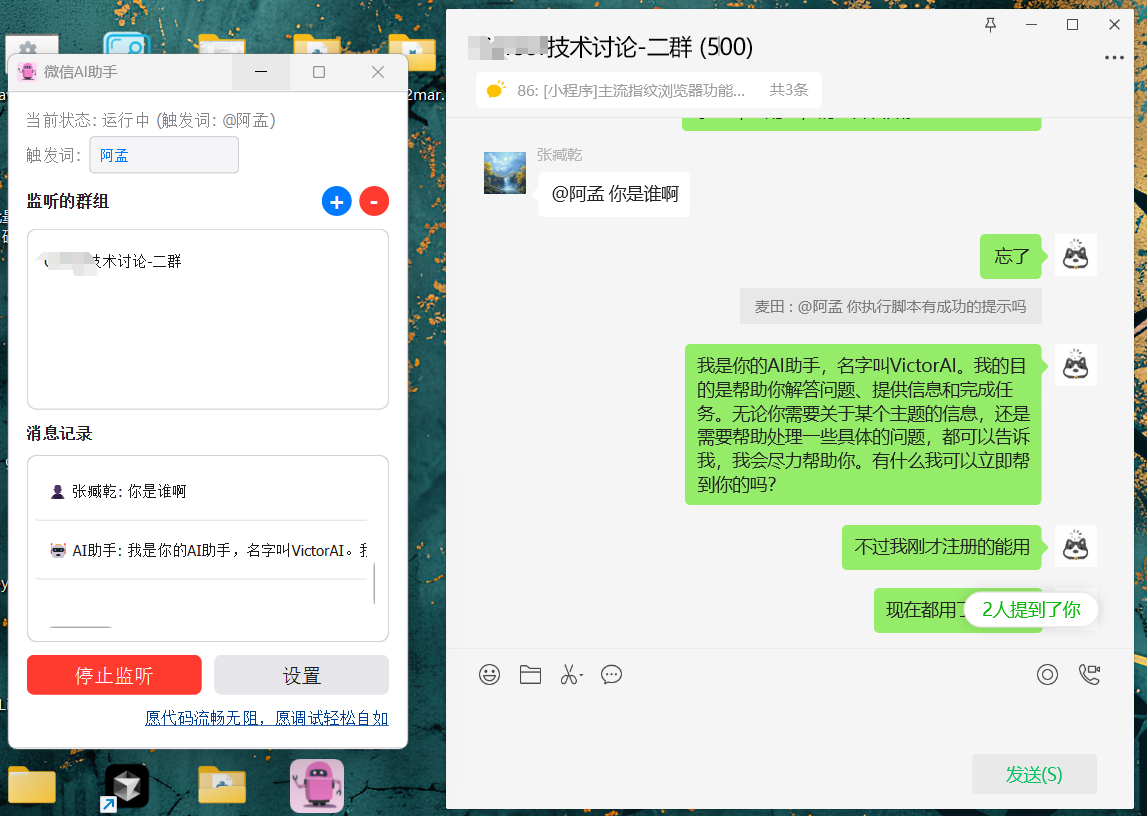

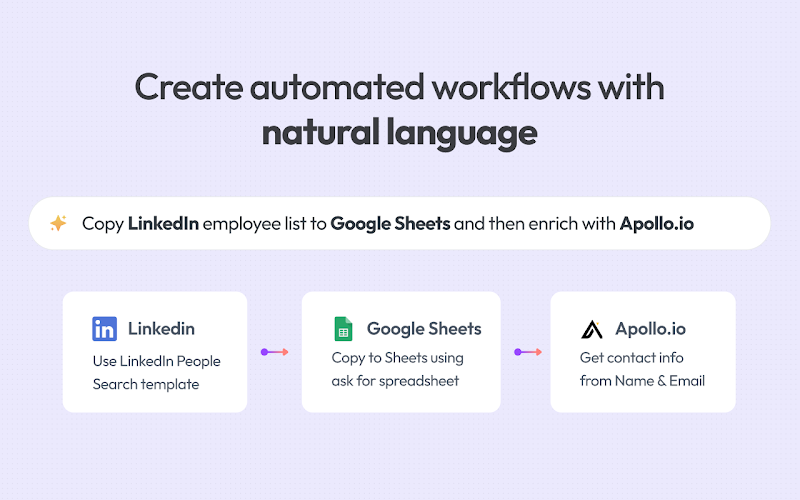

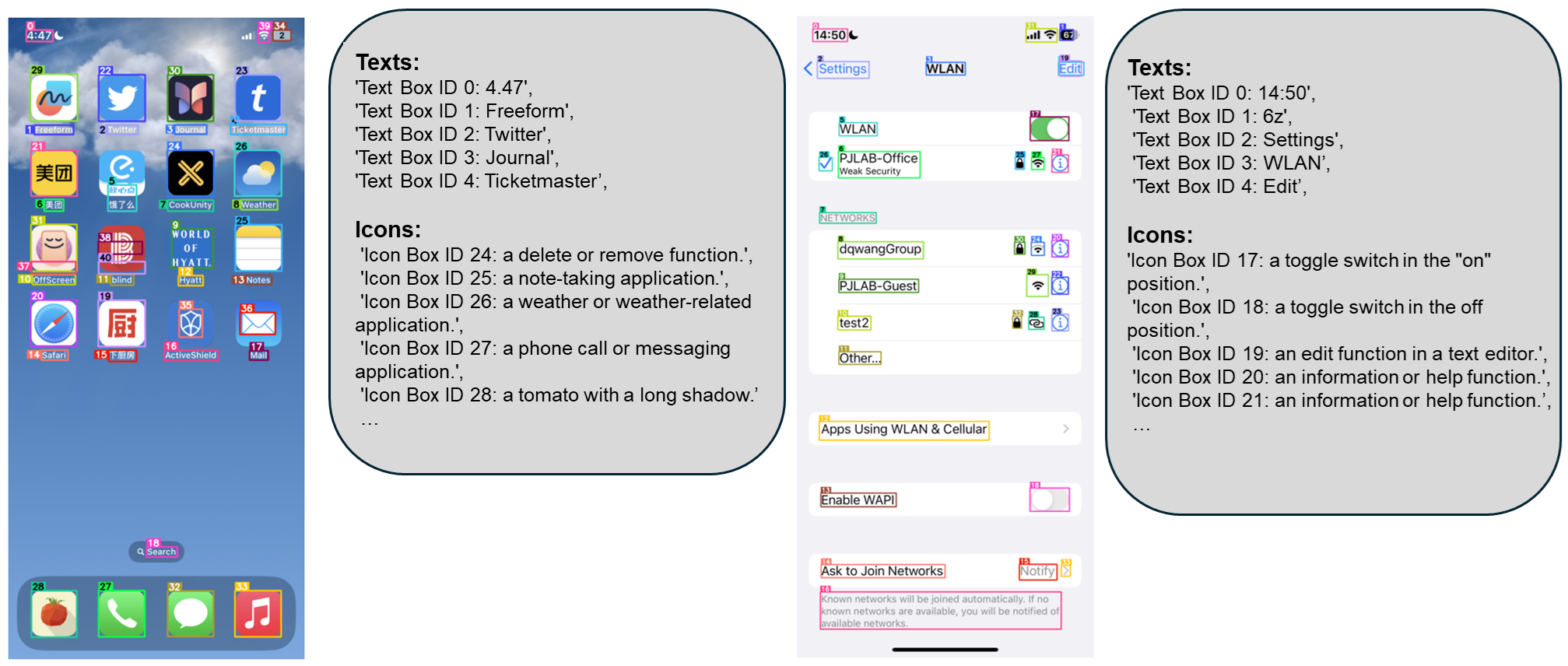

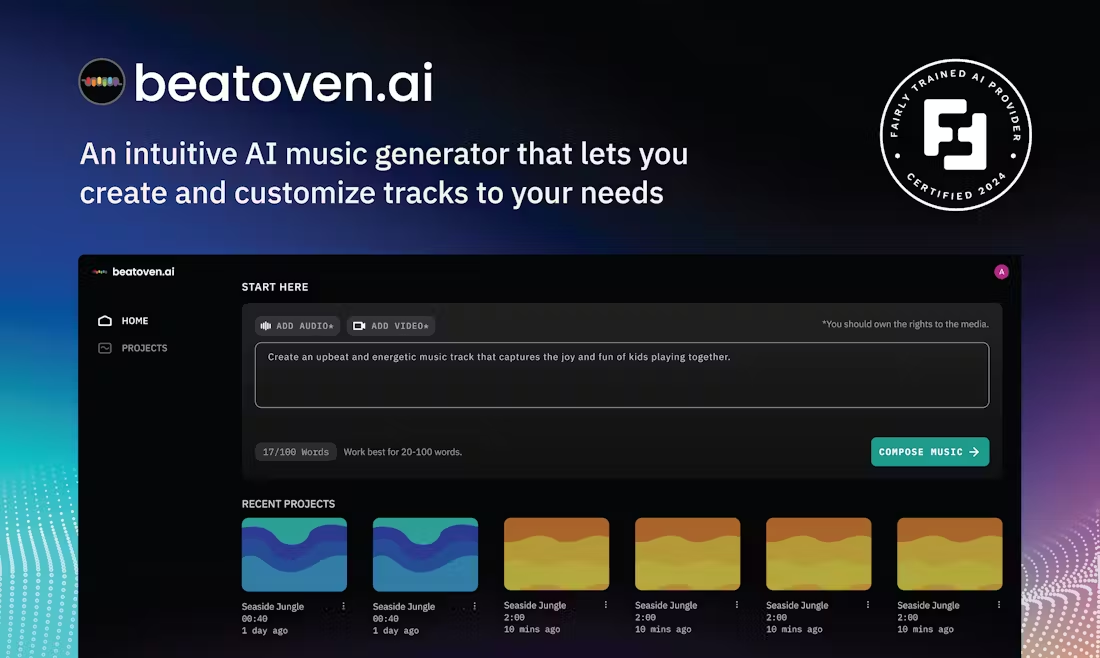

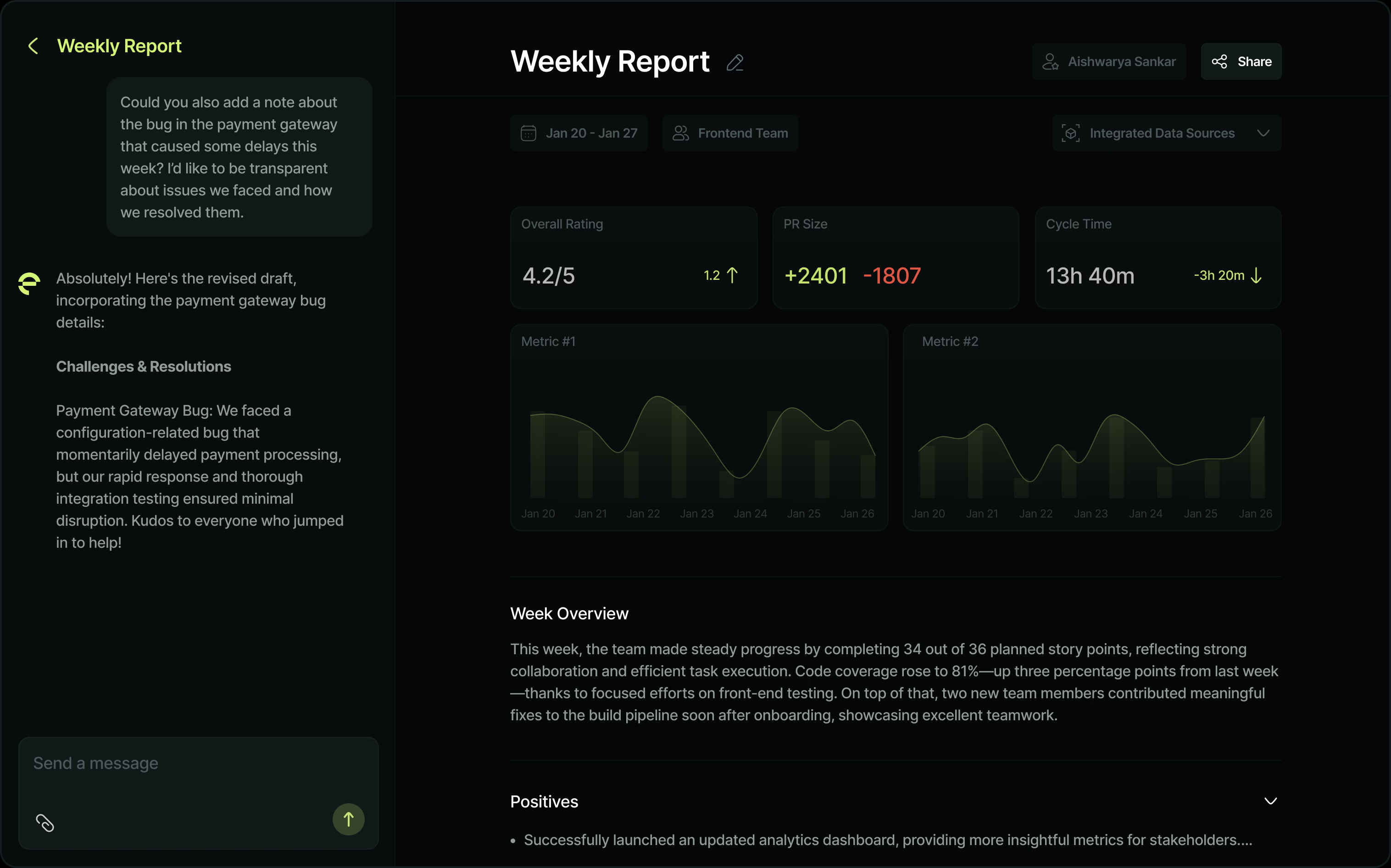

Introduction générale Dola est un outil intelligent de gestion d'horaires conçu pour aider les utilisateurs à planifier efficacement des horaires individuels et de groupe par le biais d'une simple communication vocale ou textuelle. Sans avoir besoin de télécharger des applications supplémentaires, les utilisateurs peuvent interagir directement avec Dola via WhatsApp et d'autres outils de...