Text2Edit : A Native Multimodal Model for Text-Driven Video Ad Creation (non publié)

Introduction générale

Text2Edit est un projet open source, hébergé sur GitHub, qui vise à fournir des fonctions efficaces d'édition de texte et de génération de publicité. L'objectif principal du projet est d'aider les utilisateurs à traiter rapidement des contenus textuels et à générer du matériel publicitaire de haute qualité grâce à une interface facile à utiliser et à des fonctionnalités puissantes.Text2Edit est maintenu par un groupe de développeurs, la base de code est ouverte, les utilisateurs peuvent librement y accéder et y contribuer. Les principaux langages de programmation du projet sont JavaScript, HTML et CSS, ce qui garantit une compatibilité multiplateforme et une excellente expérience utilisateur.

Caractéristiques techniques

1. les modèles linguistiques multimodaux à grande échelle (MLLM)

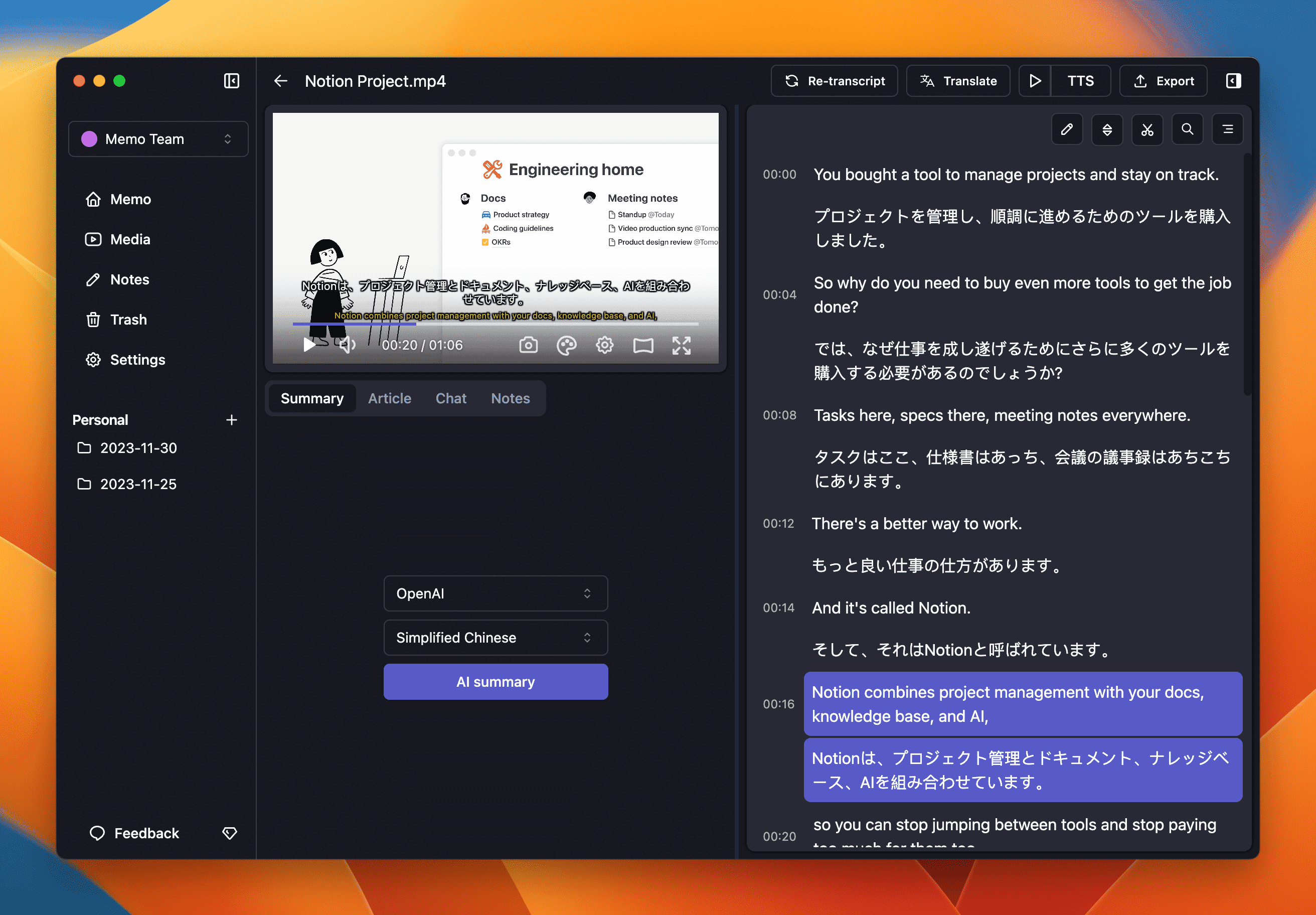

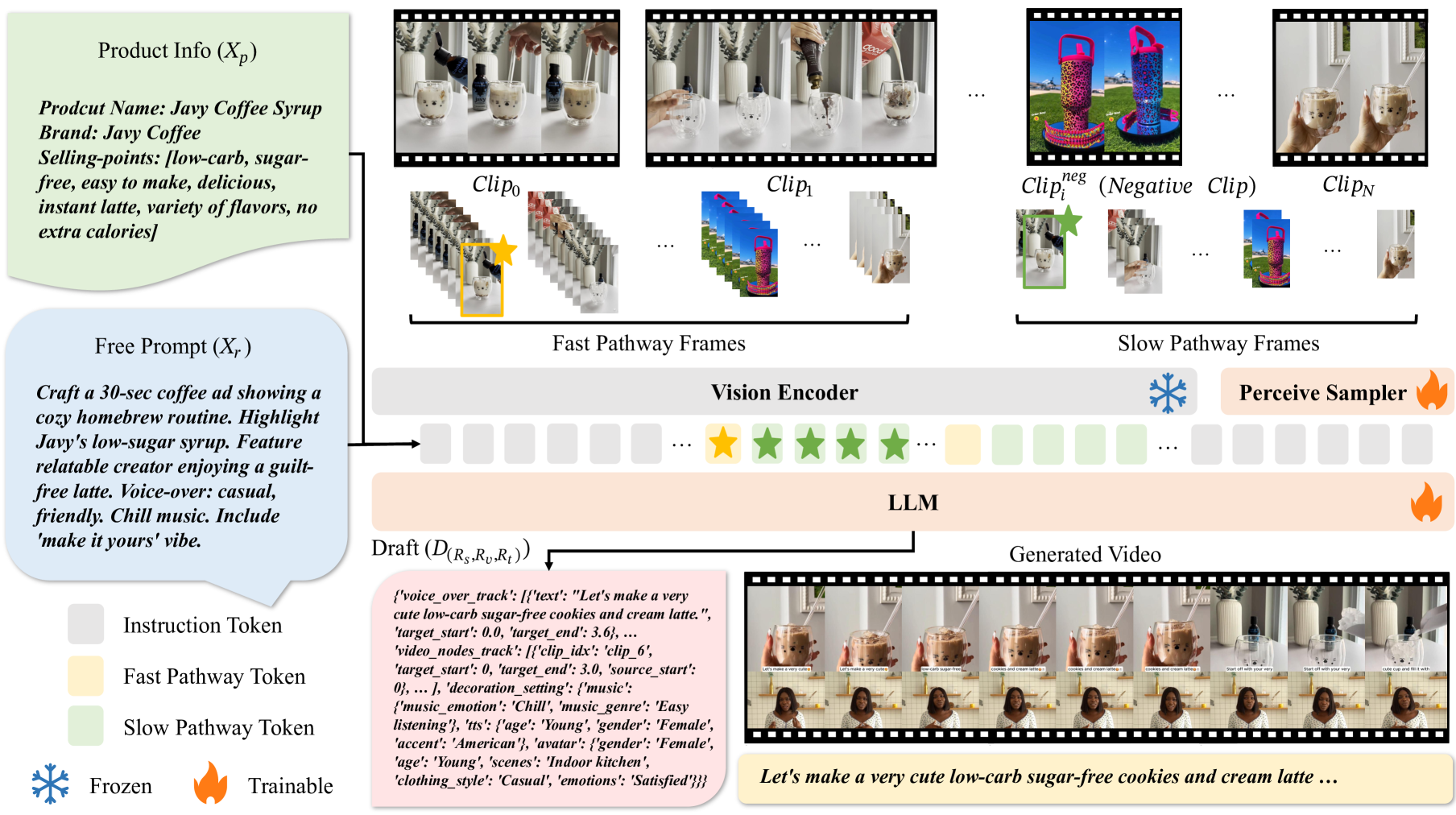

Le projet s'appuie sur le modèle multimodal du grand langage, qui est capable de traiter simultanément des informations dans des modalités multiples telles que le texte, les images et la vidéo.

2. échantillonnage à haute fréquence d'images et techniques de traitement lent-rapide

Afin de mieux comprendre les informations spatio-temporelles contenues dans la vidéo, le projet utilise des techniques d'échantillonnage à haute fréquence d'image et de traitement lent-rapide :

- Échantillonnage à haute fréquence : en échantillonnant des images vidéo à une fréquence de 2 images par seconde (ips), le modèle est capable de capturer de manière plus sensible les changements temporels dans la vidéo. Cette approche améliore considérablement la capacité du modèle à comprendre les changements dans la dynamique de la vidéo.

- Technique de traitement lent-rapide : le modèle traite les images vidéo en utilisant deux chemins simultanément.

- Chemin lent : les images sont traitées à une fréquence plus faible (par exemple 0,5 ips), mais davantage de jetons sont attribués par image afin de capturer des informations spatio-temporelles détaillées.

- Voie rapide : traitement des images à une fréquence élevée (par exemple, 2 images par seconde) mais attribution de moins d'éléments par image, en se concentrant sur la capture de scènes à évolution rapide. Cette stratégie à double voie permet d'équilibrer les informations spatio-temporelles et sémantiques de la vidéo et d'améliorer considérablement la compréhension du contenu de la vidéo par le modèle.

3. l'édition pilotée par le texte

Le mécanisme d'édition piloté par le texte permet aux utilisateurs de contrôler avec précision le résultat de l'édition vidéo grâce à la saisie de texte. Les utilisateurs peuvent spécifier la durée de la vidéo, le scénario, le public cible, le style du script, les arguments de vente du produit à mettre en avant et d'autres informations. Le modèle génère un projet de montage vidéo qui répond aux besoins de l'utilisateur sur la base de ces invites textuelles, ce qui garantit un degré élevé de contrôle et de variété dans le résultat.

4. mise en œuvre spécifique du montage vidéo

- Intégration et traitement des images vidéo : les images vidéo sont d'abord converties en vecteurs d'intégration par un codeur visuel tel que CLIP ou OpenCLIP. Ces vecteurs sont introduits dans le LLM avec les vecteurs d'intégration de texte, et le modèle traite ces vecteurs d'intégration par le biais d'un mécanisme auto-attentif afin de générer des ébauches pour l'édition vidéo.

- Génération d'ébauches et post-traitement : l'ébauche issue du modèle comprend la disposition des clips vidéo, des scripts de voix off et des éléments décoratifs (par exemple, bandes sonores, images humaines numériques, etc.) Ces ébauches sont traitées par post-traitement (par exemple, synthèse vocale, récupération de musique, etc.) pour produire la vidéo finale pouvant être rendue.

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...