Step-Audio : un cadre d'interaction vocale multimodale qui reconnaît la parole et communique à l'aide de la parole clonée, entre autres caractéristiques.

Introduction générale

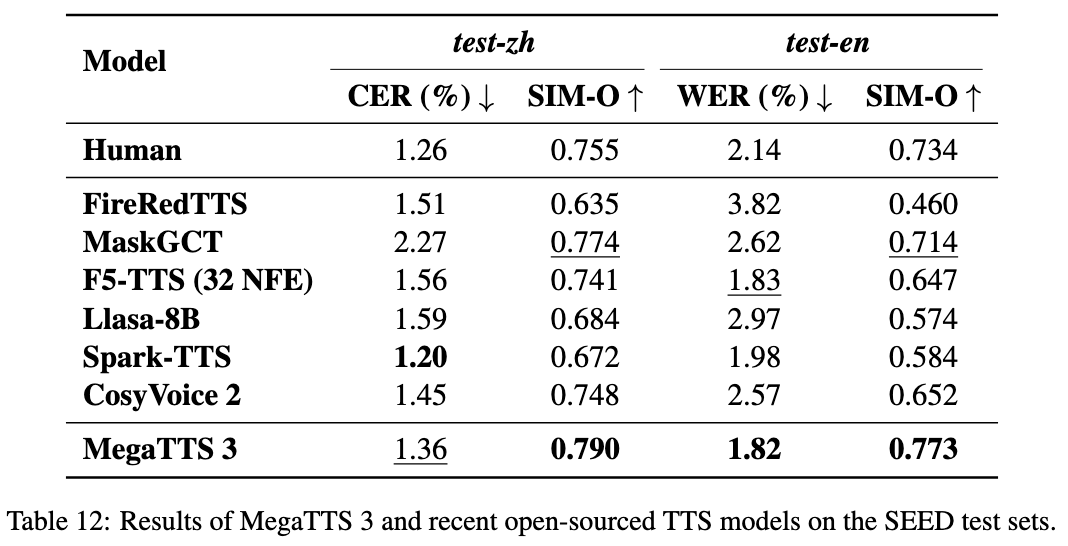

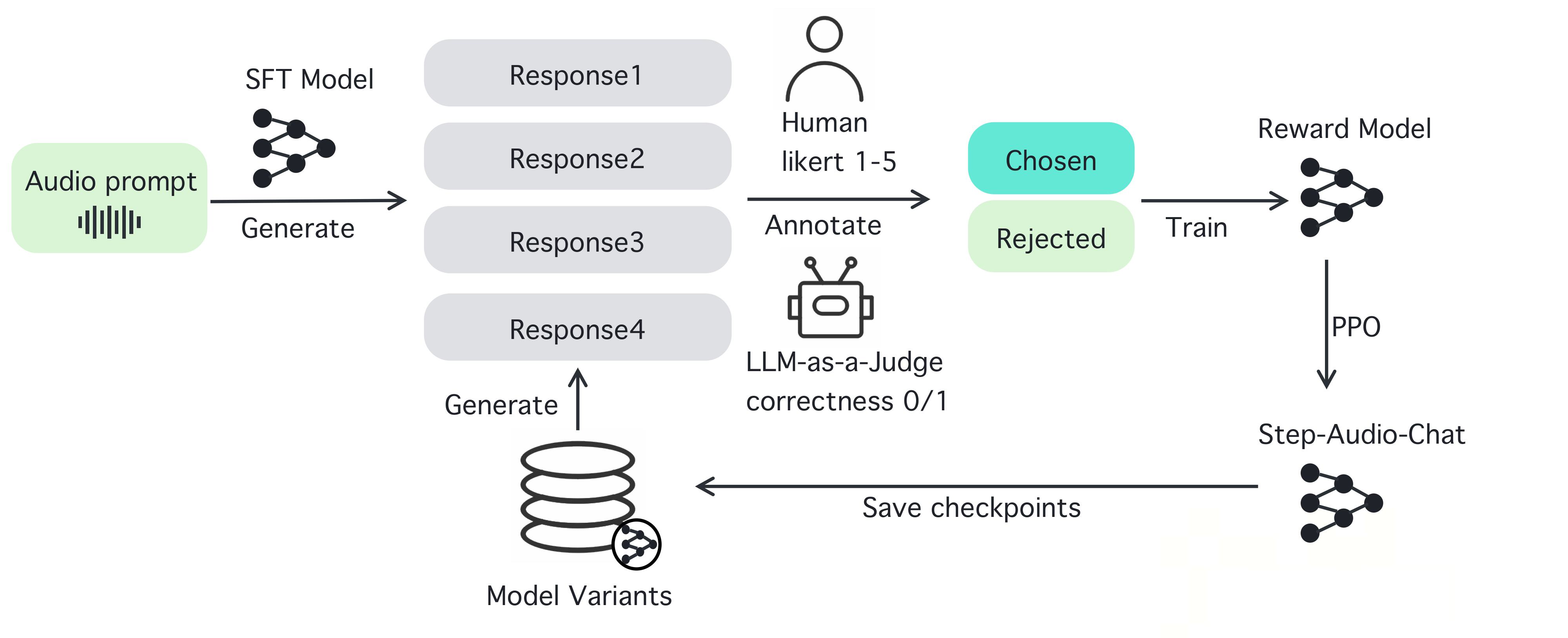

Step-Audio est un cadre d'interaction vocale intelligente open source conçu pour fournir des capacités de compréhension et de génération de la parole prêtes à l'emploi pour les environnements de production. Il prend en charge les dialogues multilingues (chinois, anglais, japonais), les discours émotionnels (heureux, triste), les dialectes régionaux (cantonais, sichuanais), le débit de parole réglable et les styles de rimes (rap, par exemple). Step-Audio met en œuvre la reconnaissance vocale, la compréhension sémantique, le dialogue, le clonage de la parole et la synthèse vocale à l'aide d'un modèle multimodal à 130 paramètres. Son moteur de données génératif élimine la dépendance à l'égard de la collecte manuelle traditionnelle de données TTS en générant des données audio de haute qualité pour entraîner et publier le modèle Step-Audio-TTS-3B, qui est économe en ressources.

Liste des fonctions

- Reconnaissance vocale en temps réel (ASR) : convertit la parole en texte et permet une reconnaissance de haute précision.

- Synthèse texte-parole (TTS) : convertit le texte en parole naturelle, en prenant en charge une large gamme d'émotions et d'intonations.

- Prise en charge multilingue : Prise en charge de langues telles que le chinois, l'anglais, le japonais et de dialectes tels que le cantonais et le sichuanais.

- Contrôle de l'émotion et de l'intonation : ajustement de l'émotion du discours (par exemple, heureux, triste) et du style de rime (par exemple, RAP, fredonner).

- Clonage de la voix : génère une voix similaire à partir de la voix d'entrée, ce qui permet de personnaliser la conception de la voix.

- Gestion du dialogue : Maintenez la continuité du dialogue et améliorez l'expérience de l'utilisateur grâce au gestionnaire de contexte.

- Chaîne d'outils open source : fournit un code complet et des poids de modèle que les développeurs peuvent utiliser directement ou développer deux fois.

Utiliser l'aide

Step-Audio est un puissant framework d'interaction vocale multimodale open source permettant aux développeurs de créer des applications vocales en temps réel. Vous trouverez ci-dessous un guide détaillé, étape par étape, de l'installation et de l'utilisation de Step-Audio, ainsi que de ses fonctionnalités, afin de vous assurer que vous pourrez facilement commencer à l'utiliser et en tirer tout le potentiel.

Processus d'installation

Pour utiliser Step-Audio, vous devez installer le logiciel dans un environnement équipé d'un GPU NVIDIA. Vous trouverez ci-dessous les étapes détaillées :

- Préparation de l'environnement: :

- Assurez-vous que Python 3.10 est installé sur votre système.

- Installez Anaconda ou Miniconda pour gérer l'environnement virtuel.

- Vérifiez que le pilote du GPU NVIDIA et la prise en charge CUDA sont installés. Il est recommandé d'utiliser des GPU 4xA800/H800 (80 Go de RAM) pour obtenir une meilleure qualité de génération.

- entrepôt de clones: :

- Ouvrez un terminal et exécutez la commande suivante pour cloner le dépôt Step-Audio :

git clone https://github.com/stepfun-ai/Step-Audio.git cd Step-Audio

- Ouvrez un terminal et exécutez la commande suivante pour cloner le dépôt Step-Audio :

- Créer un environnement virtuel: :

- Créer et activer un environnement virtuel Python :

conda create -n stepaudio python=3.10 conda activate stepaudio

- Créer et activer un environnement virtuel Python :

- Installation des dépendances: :

- Installer les bibliothèques et les outils nécessaires :

pip install -r requirements.txt git lfs install - Clonage de poids de modèles supplémentaires :

git clone https://huggingface.co/stepfun-ai/Step-Audio-Tokenizer git clone https://huggingface.co/stepfun-ai/Step-Audio-Chat git clone https://huggingface.co/stepfun-ai/Step-Audio-TTS-3B

- Installer les bibliothèques et les outils nécessaires :

- Vérifier l'installation: :

- Exécution d'un script de test simple (comme dans le code d'exemple)

run_example.py) pour s'assurer que tous les composants fonctionnent correctement.

- Exécution d'un script de test simple (comme dans le code d'exemple)

Une fois l'installation terminée, vous pouvez commencer à utiliser les différentes fonctions de Step-Audio. Vous trouverez ci-dessous des instructions détaillées sur l'utilisation des fonctions principales et des fonctions vedettes.

Principales fonctions

1. la reconnaissance vocale en temps réel (ASR)

La fonction de reconnaissance vocale de Step-Audio convertit la voix de l'utilisateur en texte, ce qui permet de créer des assistants vocaux ou des systèmes de transcription en temps réel.

- procédure: :

- Assurez-vous que le microphone est connecté et configuré.

- Utiliser le formulaire fourni

stream_audio.pyScript pour démarrer la diffusion audio en direct :python stream_audio.py --model Step-Audio-Chat - Lorsque vous parlez, le système convertit la parole en texte en temps réel et affiche le résultat sur le terminal. Vous pouvez vérifier le journal pour confirmer la précision de la reconnaissance.

- Fonctions vedettesReconnaissance des langues et des dialectes : prise en charge de la reconnaissance des langues et des dialectes, comme la saisie mixte du chinois et de l'anglais, ou de la parole localisée, comme le cantonais et le sichuan.

2. la synthèse vocale (TTS)

Grâce à la fonction TTS, vous pouvez convertir n'importe quel texte en parole naturelle, en prenant en charge un large éventail d'émotions, de rythmes et de styles d'élocution.

- procédure: :

- Préparer le texte à synthétiser, par exemple en l'enregistrant sous

input.txt. - utiliser

text_to_speech.pyScripts pour générer de la parole :python text_to_speech.py --model Step-Audio-TTS-3B --input input.txt --output output.wav --emotion happy --speed 1.0 - Paramètre Description :

--emotion: Définir l'émotion (par exemple, joyeux, triste, neutre).--speed: Permet de régler la vitesse d'élocution (0,5 pour lent, 1,0 pour normal, 2,0 pour rapide).--output: Spécifie le chemin d'accès au fichier audio de sortie.

- Préparer le texte à synthétiser, par exemple en l'enregistrant sous

- Fonctions vedettesLe système permet de générer des styles de discours RAP et de fredonnement, par exemple :

python text_to_speech.py --model Step-Audio-TTS-3B --input rap_lyrics.txt --style rap --output rap_output.wav

这将生成一段带有 RAP 节奏的音频,非常适合音乐或娱乐应用。

#### 3. 多语言与情感控制

Step-Audio 支持多种语言和情感控制,适合国际化应用开发。

- **操作步骤**:

- 选择目标语言和情感,例如生成日语悲伤语气语音:

python generate_speech.py --language japanese --emotion sad --text "私は悲しいです" --output sad_jp.wav

- 方言支持:如果需要粤语输出,可以指定:

python generate_speech.py --dialect cantonese --text "I'm so hung up on you" --output cantonese.wav

- **特色功能**:通过指令可以无缝切换语言和方言,适合构建跨文化语音交互系统。

#### 4. 语音克隆

语音克隆允许用户上传一段语音样本,生成相似的声音,适用于个性化语音设计。

- **操作步骤**:

- 准备一个音频样本(如 `sample.wav`),确保音频清晰。

- 使用 `voice_clone.py` 进行克隆:

python voice_clone.py --input sample.wav --output cloned_voice.wav --model Step-Audio-Chat

- 生成的 `cloned_voice.wav` 将模仿输入样本的音色和风格。

- **特色功能**:支持高保真克隆,适用于虚拟主播或定制语音助手。

#### 5. 对话管理与上下文保持

Step-Audio 内置上下文管理器,确保对话的连续性和逻辑性。

- **操作步骤**:

- 启动对话系统:

python chat_system.py --model Step-Audio-Chat

- Saisissez du texte ou de la parole et le système génère une réponse en fonction du contexte. Exemple :

- Utilisateur : "Quel temps fait-il aujourd'hui ?"

- SYSTÈME : "Dites-moi où vous vous trouvez et je vérifierai."

- Utilisateur : "Je suis à Pékin".

- SYSTÈME : "Pékin est ensoleillé aujourd'hui, avec une température de 15°C".

- Fonctions vedettesIl peut prendre en charge plusieurs cycles de dialogue, conserver les informations contextuelles et convenir aux robots de service à la clientèle ou aux assistants intelligents.

mise en garde

- exigences en matière de matérielPour des performances optimales, il est recommandé de disposer d'au moins 80 Go de mémoire.

- connexion au réseauCertains poids du modèle doivent être téléchargés à partir de Hugging Face pour assurer la stabilité du réseau.

- détection des erreursSi vous rencontrez des erreurs d'installation ou d'exécution, vérifiez les fichiers journaux ou consultez la page GitHub Issues pour obtenir de l'aide.

En suivant ces étapes, vous pouvez tirer pleinement parti de la puissance de Step-Audio, que vous développiez des applications vocales en temps réel, que vous créiez des contenus vocaux personnalisés ou que vous construisiez un système de dialogue multilingue. La nature open-source de Step-Audio vous permet également de modifier le code et d'optimiser le modèle en fonction des besoins spécifiques de votre projet.

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...