SPO : Autocontrôle de l'optimisation des mots guides

résumés

Des messages-guides bien conçus sont essentiels pour améliorer les capacités de raisonnement des grands modèles de langage (LLM) tout en alignant leurs résultats sur les exigences des tâches de différents domaines. Cependant, la conception manuelle d'indices nécessite une expertise et une expérimentation itérative. Les méthodes existantes d'optimisation des indices visent à automatiser ce processus, mais elles s'appuient fortement sur des références externes telles que des réponses réelles ou des commentaires humains, ce qui limite leur application dans des scénarios réels où ces données ne sont pas disponibles ou sont coûteuses à obtenir. Pour résoudre ce problème, nous proposons l'optimisation auto-supervisée des messages-guides (Self-Supervised Prompt Optimisation - SPO), un cadre efficace pour découvrir des messages-guides efficaces pour les tâches fermées et ouvertes sans avoir besoin de références externes. Inspiré par l'observation que la qualité des indices est directement reflétée dans les résultats du LLM et que le LLM peut évaluer efficacement le degré d'adhésion aux exigences de la tâche, nous dérivons des signaux d'évaluation et d'optimisation uniquement à partir de comparaisons de résultats. Plus précisément, SPO sélectionne des repères supérieurs par le biais de comparaisons de sorties par paire évaluées par l'évaluateur LLM, puis aligne les sorties sur les exigences de la tâche par le biais de l'optimiseur LLM. Des expériences approfondies ont montré que SPO surpasse les méthodes d'optimisation des indices de pointe existantes tout en coûtant beaucoup moins cher (par exemple, seulement 1,11 TP3T contre 5,61 TP3T pour les méthodes existantes) et en nécessitant moins d'échantillons (par exemple, seulement trois échantillons). Le code est disponible à l'adresse https://github.com/geekan/MetaGPT获取.

Code complet de la démo : https://github.com/geekan/MetaGPT/blob/main/examples/spo/README.md

1. introduction

Alors que les grands modèles linguistiques (LLM) continuent d'évoluer, des messages-guides bien conçus sont essentiels pour maximiser leur efficacité.capacité de raisonnement (Wei et al., 2022 ; Zheng et al., 2024 ; Deng et al., 2023) ainsi que la cohérence avec les exigences des mandats de diversification (Hong et al., 2024b ; Liu et al., 2024a ; Zhang et al., 2024b ; Hong et al., 2024a) devient critique. Cependant, la création d'indices efficaces nécessite généralement de nombreuses expériences d'essais et d'erreurs et des connaissances approfondies spécifiques à la tâche.

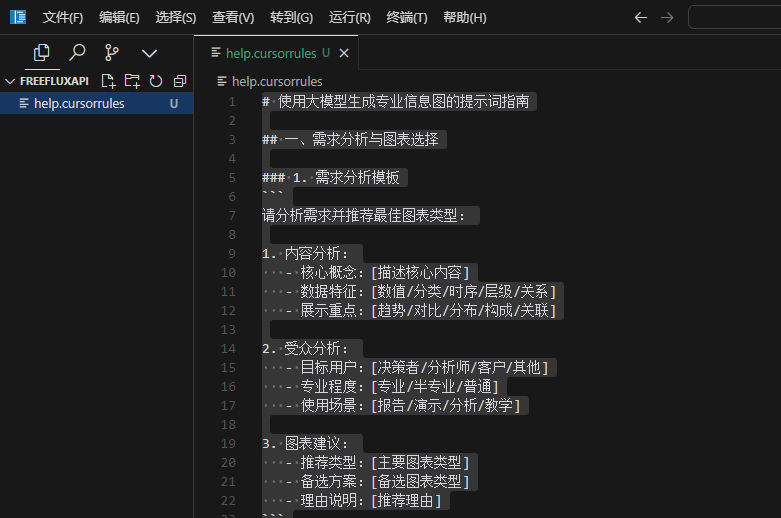

Pour relever ce défi, les chercheurs ont exploré des méthodes d'optimisation des invites (PO) qui utilisent les capacités propres des LLM pour améliorer automatiquement les invites.PO va au-delà de l'ingénierie manuelle traditionnelle des invites pour fournir une approche plus systématique et plus efficace de la conception des invites. Comme le montre la figure 1(a), ces méthodes impliquent généralement un processus itératif d'optimisation, d'exécution et d'évaluation des invites. Les choix de conception de ces composants affectent de manière significative l'efficacité et l'efficience de l'optimisation. Les méthodes existantes ont été développées en termes de mécanismes d'évaluation numérique (Wang et al., 2024e ; Yang et al., 2024a ; Fernando et al., 2024) et de stratégies d'optimisation textuelle du "gradient" (Wang et al., 2024c ; Yuksekgonul et al., 2024). al., 2024). Grâce à ces innovations, les méthodes d'OP ont amélioré la performance des tâches tout en réduisant l'effort manuel (Pryzant et al., 2023 ; Zhang et al., 2024a ; Zhou et al., 2024).

Malgré leur potentiel, les méthodes d'OP existantes sont confrontées à des défis importants dans les scénarios du monde réel, comme décrit ci-dessous. Premièrement, les approches actuellesLa loi s'appuie généralement sur des références externes pour son évaluation. Les méthodes qui utilisent des réponses authentiques pour l'évaluation (Yang et al., 2024a ; Fernando et al., 2024 ; Yuksekgonul et al., 2024 ; Pryzant et al., 2023) nécessitent de grandes quantités de données annotées pour évaluer la qualité des indices, mais dans de nombreuses applications du monde réel, en particulier dans les tâches ouvertes, de telles réponses standard ne sont souvent pas disponibles. de telles réponses standard ne sont souvent pas disponibles. De même, les méthodes dépendantes du manuel (Chen et al., 2024 ; Lin et al., 2024) nécessitent une évaluation manuelle ou des règles conçues manuellement pour générer un retour d'information, ce qui est à la fois chronophage et contradictoire avec l'objectif d'automatisation. Deuxièmement, les méthodes existantes nécessitent généralement l'évaluation d'un grand nombre d'échantillons pour obtenir un retour d'information fiable, ce qui entraîne une surcharge de calcul importante (Wang et al., 2024e ; Fernando et al., 2024).

Au cœur de ces défis se trouve le manque de méthodes fiables et efficaces, sans référence, pour évaluer la qualité des indices. L'analyse du comportement du LLM révèle deux idées clés qui guident notre approche. Premièrement, la qualité des indices est intrinsèquement reflétée dans la sortie du modèle, comme le montre la manière dont les chemins d'inférence par étapes peuvent démontrer le succès des indices de réflexion en chaîne (Wei et al., 2022 ; Deng et al., 2023). Deuxièmement, des recherches approfondies sur les LLM en tant que juges ont montré qu'ils sont efficaces dans l'évaluation de la mesure dans laquelle la sortie suit les exigences de la tâche (Zheng et al., 2023 ; Li et al., 2024b). Ces observations suggèrent que l'optimisation des repères sans référencement est possible en utilisant les LLM pour évaluer la capacité inhérente des résultats qui reflètent naturellement la qualité des repères.

Inspirés par ces idées, nous proposons un cadre efficace qui génère des signaux d'évaluation et d'optimisation uniquement à partir des sorties LLM, de la même manière que l'apprentissage auto-supervisé dérive des signaux d'entraînement à partir des données. Nous appelons cette approche l'optimisation prompte auto-supervisée (SPO). Comme le montre la figure 1, SPO introduit plusieurs mécanismes innovants basés sur le cycle de base optimiser-exécuter-évaluer :

- Sortie comme référence pour l'évaluation par paireSPO : Au cœur de SPO se trouve l'utilisation de comparaisons par paires pour évaluer la qualité relative des résultats provenant de différents indices. Ce mécanisme d'évaluation exploite la capacité inhérente du LLM à comprendre les exigences de la tâche et à valider l'efficacité de l'optimisation sans référence externe.

- Sortie en tant que guide d'optimisationLe SPO optimise les repères grâce à la compréhension par le LLM d'une meilleure solution par rapport à la meilleure sortie actuelle. Ce processus aligne naturellement les modifications des repères sur la compréhension du modèle de la meilleure solution de la tâche, plutôt que de s'appuyer sur des signaux d'optimisation explicites.

dédier. Nos principales contributions sont énumérées ci-dessous :

- Cadre d'optimisation des repères autosupervisés. Nous présentons SPO, un nouveau cadre qui utilise les comparaisons par paire des résultats de la LLM pour guider l'optimisation des repères sans références externes.

- Optimisation du rapport coût-efficacitéSPO optimise les messages-guides en minimisant les frais de calcul (0,15 $ par ensemble de données) et les exigences en matière d'échantillons (3 échantillons), ce qui réduit considérablement les besoins en ressources.

- Évaluation approfondie. Comme le montre la figure 2, SPO ne nécessite que 1,11 TP3T à 5,61 TP3T du coût des méthodes existantes tout en conservant d'excellentes performances dans les tâches fermées et ouvertes.

2. préliminaire

2.1 Définition du problème

L'optimisation des messages-guides vise à améliorer automatiquement la validité d'un message-guide pour une tâche donnée. De manière formelle, prenons T = (Q, Gt) représente une tâche où Q représente le problème d'entrée et Gt est un fait de référence facultatif. L'objectif est de générer une invite spécifique à la tâche Pt* pour maximiser la performance sur la tâche T . Cet objectif d'optimisation peut être formellement exprimé comme suit :

Pt = arg maxPt∈P* ET∼D[ϕeval(ϕexe(Q, Pt))], (1)

où P représente l'espace de toutes les invites possibles. Comme le montre la figure 1, ce processus d'optimisation implique généralement trois fonctions de base : (1) la fonction d'optimisation (ϕopter) : génère une invite modifiée sur la base des invites candidates ; (2) la fonction d'exécution (ϕexe) : les indices modifiés sont utilisés avec le LLM pour générer la sortie O, y compris le chemin d'inférence et la réponse finale ; (3) la fonction d'évaluation (ϕeval) : évaluer la qualité de O et fournir un retour d'information F pour guider l'optimisation ultérieure, en améliorant de manière itérative l'indice candidat.

Parmi ces fonctions, la fonction d'évaluation joue un rôle clé car son résultat (feedback F) guide l'évaluation et l'amélioration du repère. Nous examinerons le cadre d'évaluation pour l'optimisation des indices à la section 2.2.

2.2 Cadres d'évaluation pour l'optimisation des indices

Cette section présente une vue d'ensemble de notre cadre d'évaluation de l'optimisation des messages, couvrant trois éléments clés : les sources d'évaluation, les méthodes d'évaluation et les types de retour d'information, comme le montre la figure 3. Enfin, nous présentons notre choix de cadre d'évaluation pour les OPS.

Sources d'évaluation. Comme le montre la figure 3(a), deux sources principales d'évaluation sont disponibles : le résultat généré par le LLM et les réponses authentiques spécifiques à la tâche. Ces sources constituent la base de l'évaluation de la performance de l'utilisateur.

Méthodologie d'évaluation. Les méthodes d'évaluation définissent la manière dont les sources d'évaluation et les coûts associés sont évalués. Trois méthodes couramment utilisées sont (1) L'analyse comparative repose sur des mesures prédéfinies (Suzgun et al., 2023 ; Rein et al., 2023) ou des règles (Chen et al., 2024). (2) LLM comme juge (Zheng et al., 2023) utilisant la capacité de LLM à comprendre et évaluer les résultats selon les exigences de la tâche. (3) Le retour d'information manuel (Lin et al., 2024) fournit l'évaluation la plus complète en évaluant directement la production manuellement.

Bien que le retour d'information manuel fournisse l'évaluation la plus complète en capturant les préférences humaines et les besoins spécifiques à la tâche, il engendre des coûts plus élevés que les approches de benchmarking ou de LLM-as-judge, créant un compromis entre la qualité de l'évaluation et la faisabilité.

Type de retour d'information. Le retour d'information généré par les méthodes d'évaluation prend généralement trois formes :(1) Le retour d'information numérique fournit des mesures de performance quantitatives pour l'ensemble du jeu de données. Cependant, il nécessite un grand nombre d'échantillons pour garantir la stabilité de l'évaluation et peut ignorer les détails spécifiques à l'instance (Zhang et al., 2024a). (2) Le retour d'information textuel fournit des conseils riches et spécifiques à l'instance en analysant et en fournissant des suggestions qui génèrent directement des signaux d'optimisation (Yuksekgonul et al., 2024). (3) Le feedback de classement ou de sélection (Liu et al., 2024b) établit un classement de qualité relative entre les résultats par le biais d'un classement complet ou de comparaisons par paire, fournissant une orientation d'optimisation explicite sans qu'il soit nécessaire d'utiliser des mesures de qualité absolues.

Cadre d'évaluation. En s'appuyant sur les sources, les méthodes et les types de retour d'information évoqués précédemment, les cadres d'évaluation déterminent la manière dont les sources sont comparées et évaluées dans le contexte de l'optimisation des repères. Plus précisément, nous dérivons deux cadres d'évaluation pour générer un retour d'information F pour l'optimisation des repères :

(1) Sortie vs. vraie réponse (OvG) : en combinant la sortie O avec la vraie réponse GT Effectuer des comparaisons pour obtenir un retour d'information :

fOvG(Oi, Gi) = φeval(φexe(Qi, Tpi), G**i**)

Bien que cette approche permette une évaluation directe de la qualité par le biais de références externes, elle exige des réponses vraies clairement définies et ne convient donc pas aux tâches ouvertes pour lesquelles il n'y a pas de réponses vraies ou pour lesquelles il n'est pas possible de définir des réponses vraies.

(2) Sortie à sortie (OvO) : lorsqu'il n'existe pas de véritable réponse, nous nous tournons vers des comparaisons directes de sorties. L'idée centrale de l'OvO est que la comparaison de sorties générées à partir de différents indices peut fournir des signaux précieux sur leur qualité relative, même en l'absence d'une véritable réponse parfaite. Cette approche élimine la dépendance à l'égard des références externes et est particulièrement utile pour les tâches ouvertes comportant plusieurs réponses valides. Elle peut être formellement exprimée comme suit :

fOvO(O1, ... , Ok) = φeval({φexe(Qi, Pti)}ki=1)

Après avoir présenté les cadres d'évaluation OvG et OvO, nous soulignons que OvO est une méthode essentielle pour l'optimisation auto-supervisée des invites (SPO). En comparant les résultats générés à partir de différents indices, OvO fournit un retour d'information précieux sur leur qualité relative sans s'appuyer sur des références externes. Cette approche est cohérente avec notre objectif de générer un retour d'information à partir des sorties elles-mêmes, facilitant ainsi l'optimisation itérative pour les tâches fermées et ouvertes.

3. l'optimisation des conseils d'autocontrôle

Dans cette section, nous décrivons d'abord notre approche (section 3.1), puis nous analysons son efficacité (section 3.2).

3.1 Vue d'ensemble du SPO

L'un des principaux défis de l'optimisation sans référence est de savoir comment construire des signaux d'évaluation et d'optimisation efficaces. Nous proposons l'optimisation guidée auto-supervisée (SPO), un cadre simple mais efficace pour l'optimisation sans référence qui conserve le cycle de base optimiser-exécuter-évaluer tout en utilisant uniquement les résultats du modèle comme source d'évaluation et d'orientation de l'optimisation.

Comme le montre l'algorithme 1, l'OPS fonctionne à l'aide de trois éléments clés et les indices correspondants sont présentés à l'annexe A.1 :

- Fonctions d'optimisation (φopter) : génère une nouvelle invite en analysant la meilleure invite actuelle et sa sortie correspondante.

- fonction exécutive (φexe) : appliquer les invites générées pour obtenir le résultat.

- Fonction d'évaluation (φeval) : utiliser le LLM pour comparer les résultats et déterminer le meilleur indice par comparaison par paire.

Ce processus itératif commence par un modèle d'invite de base (par exemple, Chain Thinking (Wei et al., 2022)) et un petit ensemble de questions extraites de l'ensemble de données. À chaque itération, SPO génère de nouvelles invites, les exécute et évalue par paire les résultats afin de déterminer dans quelle mesure ils respectent les exigences de la tâche.

L'association de cet indice avec un meilleur résultat est sélectionnée comme le meilleur candidat pour l'itération suivante. Le processus se poursuit jusqu'à ce qu'un nombre maximal prédéterminé d'itérations soit atteint.

3.2 Comprendre l'efficacité des OSP

Les fondements théoriques de l'OPS reposent sur deux observations essentielles :

Premièrement, la sortie des LLM est riche en informations qualitatives qui reflètent directement la validité de l'indice, comme le montre la manière dont les chemins de raisonnement par étapes peuvent démontrer le succès des indices de réflexion en chaîne (Wei et al., 2022). Deuxièmement, les LLM font preuve d'une compréhension des tâches semblable à celle des humains, ce qui leur permet d'évaluer la qualité des réponses et d'identifier des solutions supérieures basées sur les exigences de la tâche. Ces capacités complémentaires permettent aux SPO d'effectuer l'évaluation et l'optimisation des indices sans références externes. Ces deux aspects de l'exploitation des résultats du modèle fonctionnent ensemble pour parvenir à une optimisation efficace des réponses :

comme guide d'optimisation. Dans le cas de φopter En termes de conception, contrairement à d'autres méthodes qui introduisent une optimisation explicite des signaux (Fernando et al., 2024 ; Yuksekgonul et al., 2024 ; Pryzant et al., 2023), φopter L'optimisation est basée directement sur les signaux et les résultats correspondants. Les signaux d'optimisation proviennent de la capacité inhérente du LLM à évaluer la qualité des résultats, tandis que le comportement d'optimisation est guidé par sa compréhension de ce qui constitue une meilleure solution. Ainsi, même en l'absence de signaux d'optimisation explicites, l'optimisation de SPO oriente essentiellement les indices vers la compréhension optimale de la tâche par le LLM.

comme référence pour l'évaluation par paire. À propos de φeval En permettant au modèle d'évaluation d'effectuer une sélection par paire, nous exploitons efficacement la compréhension de la préférence inhérente à la tâche par le modèle d'évaluation. Ce signal interne peut être obtenu par de simples comparaisons par paire des résultats, ce qui évite d'avoir recours à un grand nombre d'échantillons pour garantir la stabilité de la notation, ce qui est souvent nécessaire pour les méthodes de retour d'information sur la notation.

Bien que nous atténuions les biais potentiels grâce à quatre séries d'évaluations aléatoires, ces biais ne peuvent pas être complètement éliminés (Zhou et al., 2024). Cependant, ces biais n'affectent pas la tendance globale de l'optimisation, car le retour d'information d'eval est uniquement utilisé comme référence pour le prochain cycle d'optimisation. Le processus d'optimisation global est naturellement aligné sur la compréhension de la tâche du modèle d'optimisation, et le mécanisme d'évaluation n'est utilisé que pour valider l'efficacité de chaque itération.

4) Expériences

4.1 Dispositif expérimental

ensemble de données. Nous avons évalué le SPO sur un ensemble varié de tâches, y compris des tâches fermées et ouvertes, afin d'évaluer pleinement son efficacité.

Pour la tâche fermée, nous avons utilisé cinq références établies :

- GPQA (Rein et al., 2023)

- AGIEval-MATH (Zhong et al., 2024)

- LIAR (Wang, 2017)

- WSC (Levesque et al., 2012)

- BBH-navigate (Suzgun et al., 2023)

Pour WSC, LIAR et BBH-Navigate, nous suivons Yan et al. (2024) et échantillonnons des portions de l'ensemble de données original comme ensemble de test. Pour GPQA, nous utilisons le sous-ensemble GPQA-Diamond, plus difficile, comme ensemble de test, tandis que pour AGIEval-Math, nous utilisons des problèmes de niveau 5 comme ensemble de test. Pour les tâches ouvertes, nous avons sélectionné des tâches d'écriture, de jeux de rôle et de sciences humaines dans MT-Bench (Zheng et al., 2023). Étant donné la taille limitée de l'ensemble de données, nous avons construit manuellement trois ensembles de validation pour ces tâches. Une description détaillée des ensembles de données et des procédures de construction des ensembles de validation et de test se trouve à l'annexe A.3.

ligne de base (dans les levés géodésiques). Nous avons évalué SPO sur des tâches fermées pour deux classes de méthodes : (1) les méthodes d'incitation traditionnelles, y compris io (appels LLM directs), chainthink (Wei et al., 2022), rewording (Deng et al., 2023), et fallback abstraction (Zheng et al., 2024) ; et (2) les méthodes d'optimisation d'incitation automatique, y compris APE ( Zhou et al., 2023), OPRO (Yang et al., 2024a), PromptAgent (Wang et al., 2024e), PromptBreeder (Fernando et al., 2024), et TextGrad (Yuksekgonul et al., 2024), dont l'évaluation est basée sur un ensemble d'algorithmes, tels que APE (Deng et al., 2023) et fallback abstraction (Zheng et al., 2024) ; et (2) les méthodes d'optimisation automatique des messages-guides, y compris APE ( 2024), dont les paramètres du cadre d'évaluation sont détaillés dans le tableau 2.

Pour la tâche ouverte de MT-Bench (Zheng et al., 2023), nous avons utilisé GPT-4o pour comparer la sortie générée par SPO avec celle générée directement par le modèle.

4.2 Résultats expérimentaux et analyses

Principales conclusions du mandat fermé. Comme le montre le tableau 1, les messages-guides optimisés par SPO sont en moyenne plus performants que toutes les méthodes de messages-guides traditionnelles, dépassant la référence optimale de 1,9. En même temps, ses performances sont comparables à celles des méthodes d'optimisation des messages-guides reposant sur des réponses véridiques dans la plupart des ensembles de données, et il obtient des résultats optimaux dans les ensembles de données GPQA et BBH-navigate. Plus précisément, l'avantage moyen de SPO sur les autres méthodes d'optimisation suggère que sa méthode d'évaluation par paire est capable de générer des signaux d'optimisation plus efficaces que d'autres méthodes qui s'appuient sur des références externes. En outre, pour valider l'efficacité de notre méthode à travers différents modèles d'optimisation, nous avons mené des expériences en utilisant GPT-4o comme modèle d'optimisation et avons obtenu une performance moyenne de 66,3. Bien que ce résultat soit légèrement inférieur à celui obtenu en utilisant Claude-3-5-Sonnet comme modèle d'optimisation, il s'agit toujours de la troisième meilleure performance parmi toutes les méthodes comparées.

analyse des coûts. Nous fournissons une comparaison complète du coût d'optimisation et de la performance de SPO (en utilisant Claude-3.5-Sonnet et GPT-4o comme modèles d'optimisation) avec d'autres méthodes d'optimisation dans le tableau 1. Tout en maintenant des performances comparables à celles d'autres méthodes d'optimisation d'indices qui s'appuient sur des réponses réelles, SPO ne nécessite qu'un coût d'optimisation de 1,11 TP3T à 5,61 TP3T, avec un coût d'optimisation moyen par jeu de données de $0.15. Cette réduction significative de la charge de calcul, combinée à l'absence de dépendance à l'égard des réponses réelles, rend SPO très intéressant pour les applications du monde réel.

Tableau 3 : Comparaison des performances de BBH-navigate : méthodes de repérage (IO et COT) et SPO à l'aide de différents modèles d'évaluation (lignes) et modèles d'exécution (colonnes). Le modèle d'optimisation est Claude-3.5-Sonnet.

| GPT-4o-mini | Llama3-70B | Claude-3-Haiku | |

| IO | 91.3 | 82.7 | 62.2 |

| COT | 89.7 | 86.2 | 68 |

| Claude-3.5-Sonnet | 95 | 86.8 | 68.2 |

| Llama3-70B | 94.5 | 94.2 | 82.0 |

| GPT-4o-mini | 97.8 | 90.7 | 82.0 |

Études d'ablation. Pour évaluer la transférabilité de SPO à travers différents modèles d'optimisation, d'évaluation et d'exécution, nous avons réalisé des expériences d'ablation sur l'ensemble de données BBH-Navigate. Les résultats expérimentaux présentés dans les tableaux 3 et 4 montrent que le SPO présente des performances robustes à travers différents modèles. Notamment, la meilleure performance (97,8) a été obtenue en utilisant GPT-4o-mini comme modèle d'optimisation, d'exécution et d'évaluation. En termes d'exécution, SPO a effectivement amélioré les performances du modèle le plus faible en faisant passer Claude-3-Haiku de 62,2 à 89,7, ce qui démontre la capacité de SPO à être appliqué au modèle le plus faible et élargit encore son potentiel pour des applications réalistes.

Tableau 4 : Comparaison des performances de BBH-navigate sur différents modèles d'optimisation (lignes) et modèles d'exécution (colonnes). Le modèle d'évaluation est GPT-4o-mini.

| GPT-4o-mini | Llama3-70B | Claude-3-Haiku | |

| Claude-3.5-Sonnet | 97.2 | 86.7 | 89.7 |

| GPT-40 | 96.3 | 85.5 | 73.0 |

| GPT-4o-mini | 97.8 | 90.7 | 82.0 |

| DeepSeek-V3 | 94.7 | 83.7 | 77.2 |

Nous avons mené une étude d'ablation pour examiner l'effet de la taille de l'échantillon sur les performances du SPO en utilisant l'ensemble de données BBH-Navigate, comme le montre la figure 5. Les courbes de performance des trois modèles d'optimisation présentent un schéma similaire : les performances s'améliorent initialement à mesure que la taille de l'échantillon augmente, mais finissent par se stabiliser ou diminuer. Ce phénomène peut être attribué à deux facteurs : des échantillons insuffisants entraînent un surajustement dans l'optimisation des repères, tandis que des échantillons trop nombreux non seulement augmentent le coût de calcul, mais entraînent également un contexte plus long pour l'évaluation du modèle, ce qui peut réduire la qualité de l'évaluation. Sur la base d'expériences approfondies, nous avons déterminé qu'une taille d'échantillon de 3 permettait d'atteindre le meilleur équilibre entre la rentabilité et la performance.

Principales conclusions du mandat ouvertAfin de valider la capacité de SPO dans les tâches ouvertes, nous avons sélectionné trois catégories du MT-Bench à évaluer. Afin de valider les capacités de SPO dans les tâches ouvertes, nous avons sélectionné trois catégories du MT-Bench à évaluer : "Écriture", "Jeu de rôle" et "Sciences humaines". ". Nous avons utilisé Claude-3.5-Sonnet comme modèle d'optimisation, Gpt-4o-mini comme modèle d'évaluation, et sélectionné Claude-3.5-Sonnet, DeepSeek-V3 et GPT-4omini comme modèles d'exécution pour cinq itérations. Ensuite, en suivant la méthode d'évaluation de (Zheng et al., 2023), nous avons utilisé GPT-4o pour comparer les résultats du modèle A et du modèle B par paire, comme le montre la figure 6. Les résultats expérimentaux, présentés dans la figure 6, indiquent que SPO améliore de manière significative la performance du modèle dans toutes les configurations de modèle. Il convient de noter que les modèles plus petits utilisant des indices d'optimisation (par exemple GPT-4omini) sont souvent plus performants que les modèles plus grands dans la plupart des cas.

4.3 Études de cas

Nous montrons les résultats de l'optimisation pour la tâche ouverte supplémentaire sans l'ensemble de données, ainsi que la trajectoire d'optimisation de SPO, à l'annexe A.4. Nous fournissons également les indices optimaux trouvés par SPO pour les cinq tâches fermées dans le matériel supplémentaire. Étant donné que les applications du monde réel sont souvent confrontées au problème des ensembles de données limités, nous évaluons les performances de SPO sur des tâches sans repères traditionnels. Les résultats expérimentaux combinés à la rentabilité de SPO démontrent sa valeur pratique dans les scénarios du monde réel. Plus précisément, nous montrons les résultats d'optimisation après 10 itérations en utilisant Claude-3.5-Sonnet comme modèle d'optimisation, GPT-4o-mini comme modèle d'évaluation et Llama3-8B comme modèle d'exécution, couvrant les quatre tâches de conception de publicité, de contenu de médias sociaux, d'écriture de poésie moderne et d'explication conceptuelle. En outre, nous fournissons une analyse complète de la trajectoire d'optimisation de SPO sur l'ensemble de données BBH-navigate dans l'annexe A.4.1, en montrant des exemples de réussite et d'échec pour fournir des informations plus approfondies sur le processus d'optimisation.

5. travaux connexes

5.1 Ingénierie des signaux

La recherche sur les méthodes d'incitation efficaces a été menée dans deux directions principales. La première direction se concentre sur les techniques d'incitation indépendantes de la tâche qui améliorent la généralisation des MLD. Parmi les exemples notables, citons la pensée en chaîne (Wei et al., 2022 ; Kojima et al., 2022), qui améliore le raisonnement dans un large éventail de tâches ; les techniques visant à améliorer le raisonnement en une seule fois (Deng et al., 2023 ; Zheng et al., 2024 ; Wang et al., 2024d) ; et les méthodes de spécification du format de sortie (Zhang et al., 2024a, 2024b). (Zhang et al., 2024a ; He et al., 2024 ; Tam et al., 2024). Ces techniques fournissent des semences d'optimisation importantes pour les études d'optimisation de l'autocue grâce à la perspicacité humaine et au développement expérimental approfondi.

La deuxième direction concerne les indices spécifiques à un domaine, et les chercheurs ont développé de nouvelles approches pour la génération de codes (Hong et al., 2024b ; Ridnik et al., 2024 ; Shen et al., 2024a), l'analyse de données (Hong et al., 2024a ; Liu et al., 2024a ; Li et al., 2024a), le questionnement ( Wu et al., 2024b ; Zhu et al., 2024 ; Yang et al., 2024b), la prise de décision (Zhang et al., 2024b ; Wang et al., 2024a) et d'autres domaines (Guo et al., 2024b ; Ye et al., 2024 ; Shen et al., 2024b). ) ont développé des techniques spécialisées. Toutefois, à mesure que l'application des LLM s'étend à des scénarios réels de plus en plus complexes, il devient impossible de créer manuellement des indices efficaces pour chaque domaine (Zhang et al., 2024a). Ce défi a motivé la recherche sur l'optimisation des repères, qui vise à développer systématiquement des repères efficaces spécifiques à un domaine plutôt que de découvrir des principes généraux de repérage.

5.2 Optimisation des indices

L'évolution des mécanismes d'évaluation dans l'optimisation rapide (OP) est passée de la simple collecte de données d'évaluation à la génération de signaux d'optimisation complexes (Chang et al., 2024). Les méthodes d'OP existantes peuvent être classées en fonction de leurs sources et mécanismes d'évaluation.

L'approche la plus courante s'appuie sur des réponses authentiques comme source d'évaluation, en utilisant des évaluations numériques basées sur des critères de référence (Zhou et al., 2023 ; Guo et al., 2024a ; Yang et al., 2024a ; Fernando et al., 2024 ; Wang et al., 2024e ; Khattab et al., 2023 ). Bien que ces méthodes aient donné de bons résultats dans des tâches spécifiques, elles nécessitent généralement un grand nombre d'itérations et d'échantillons pour garantir la stabilité de l'évaluation, ce qui entraîne une surcharge de calcul importante.

Pour réduire les exigences en matière d'échantillon, certaines méthodes (Yan et al., 2024 ; Yuksekgonul et al., 2024 ; Wu et al., 2024a ; Wang et al., 2024c ; Pryzant et al., 2023 ; Li et al., 2025) utilisent des LLM en tant que juges (Zheng et al. ..., 2023) pour générer un retour d'information textuel détaillé. Bien que cette approche fournisse des signaux d'évaluation plus riches et nécessite moins d'échantillons, elle repose toujours sur des données de réponses réelles, ce qui limite son application aux tâches ouvertes pour lesquelles il n'existe pas nécessairement de réponses de référence.

D'autres approches se concentrent sur les préférences humaines, par le biais de règles d'évaluation conçues manuellement ou d'un retour d'information humain direct (Chen et al., 2024 ; Lin et al., 2024). Bien que ces approches puissent être efficaces pour les tâches ouvertes, leur nécessité d'une implication humaine importante est en contradiction avec l'objectif d'automatisation. Entre-temps, certains chercheurs ont exploré différents critères d'évaluation, comme la proposition de Zhang et al. (2024c) d'évaluer la validité des indices par la cohérence des résultats. Toutefois, cette approche se heurte à un problème fondamental : la relation non linéaire entre la cohérence et la validité conduit généralement à des signaux d'évaluation médiocres.

Contrairement à ces méthodes, SPO introduit un nouveau paradigme d'évaluation qui élimine la dépendance à l'égard des références externes tout en maintenant l'efficacité. En utilisant les résultats du modèle uniquement par le biais de comparaisons par paire, SPO permet une évaluation solide sans avoir besoin de réponses réelles, de commentaires humains ou d'un échantillonnage étendu, ce qui le rend particulièrement adapté à des applications réalistes.

6. conclusion

Cet article traite d'un problème fondamental de l'optimisation par invites : la dépendance à l'égard des références externes, qui limite les applications réalistes. Nous présentons l'optimisation des invites auto-supervisée (SPO), un cadre qui permet de surmonter cette dépendance tout en mettant en œuvre un cadre dans lequel chaque ensemble de données est seulement $0.15 SPO s'inspire de l'apprentissage auto-supervisé pour construire de manière innovante des signaux d'évaluation et d'optimisation par le biais de comparaisons par paire des résultats du modèle, ce qui permet une optimisation sans référence sans compromettre l'efficacité.

Notre évaluation complète montre que SPO surpasse les méthodes de pointe existantes dans les tâches fermées et ouvertes, obtenant des résultats de pointe à un coût de seulement 1,11 TP3T contre 5,61 TP3T pour les méthodes existantes. Les succès obtenus dans les tests de référence standard et dans diverses applications réelles valident l'efficacité et la capacité de généralisation de SPO. En réduisant de manière significative les besoins en ressources et la complexité opérationnelle, SPO représente une avancée significative pour rendre l'optimisation des repères accessible et pratique dans les applications du monde réel, avec le potentiel d'accélérer l'adoption des technologies LLM dans un large éventail de domaines.

Fiche d'impact

L'OSP offre des avancées significatives dans l'ingénierie des indices pour les MLD, offrant des avantages tels que la démocratisation de l'accès, la réduction des coûts et l'amélioration des performances dans un large éventail de tâches. Cependant, elle présente également des risques, notamment l'amplification potentielle des préjugés, l'utilisation de contenus nuisibles et une dépendance excessive à l'égard des MLD.

A. Annexe

A.1 Conseils détaillés pour les FS

Dans cette section, nous présentons des méta-indices pour l'itération. Il convient de noter que nous n'avons utilisé ici que les méta-indices les plus simples et les plus directs. Il est encore possible d'améliorer les méta-conseils suivants en les optimisant pour des domaines spécifiques.

Conseils pour optimiser la fonctionnalité

Ce modèle d'invite guide les LLM dans l'amélioration itérative des invites existantes par le biais d'une analyse XML structurée. Il s'agit d'identifier les faiblesses de l'invite de référence, de suggérer des changements et de générer des versions optimisées. Le modèle met l'accent sur les améliorations progressives tout en maintenant la cohérence des exigences.

Conseils pour l'évaluation des fonctions

Le modèle d'évaluation utilise l'analyse comparative pour évaluer la qualité d'une réponse. Il exige une analyse raisonnée, au format XML, des points forts et des points faibles de deux réponses (A/B), suivie d'un choix clair.

A.2 Modèle de message détaillé pour le début d'une itération

Ce fichier YAML montre notre configuration initiale pour l'itération sur la tâche BBH-navigate. En configurant une simple invite et une exigence initiales, ainsi que trois questions spécifiques, l'optimisation itérative peut être réalisée. Il est important de noter que le contenu présenté ici est le contenu complet du fichier ; le contenu de la section des réponses n'est pas la réponse réelle, mais sert plutôt de référence pour le processus de réflexion et le format de sortie correct.

A.3 Détails de l'expérience

A.3.1 Détails des tâches et des données

MENSONGE

LIAR (Wang, 2017) est un ensemble de données de détection de fausses nouvelles en langue anglaise contenant 4000 déclarations, chacune accompagnée d'informations contextuelles et d'étiquettes de mensonge. Dans nos expériences, nous suivons la méthode de Yan et al. (2024) et échantillonnons des portions de l'ensemble de données original comme ensemble de test.

BBH-Naviguer

BBH-Navigate (Suzgun et al., 2023) est une tâche de l'ensemble de données BIG-bench Hard, un sous-ensemble de l'ensemble de données BIG Bench. Cette tâche se concentre sur le raisonnement de navigation et demande au modèle de déterminer si un agent retourne à son point de départ après avoir suivi une série d'étapes de navigation. Dans nos expériences, nous avons utilisé un échantillonnage aléatoire (seed = 42) pour obtenir une répartition 200/25/25 test/entraînement/validation.

Tableau A1. Taille de l'ensemble de données et partitionnement des données

| Nom de l'ensemble de données | test (machines, etc.) | Formation et validation |

|---|---|---|

| MENSONGE | 461 | 3681 |

| BBH-Naviguer | 200 | 50 |

| CSM | 150 | 50 |

| AGIEval-MATH | 256 | 232 |

| GPQA | 198 | 250 |

| MT-bench | 80 | 0 |

CSM

Le Winograd Schema Challenge (WSC) (Levesque et al., 2012) est un benchmark conçu pour évaluer la capacité d'un système à effectuer un raisonnement de bon sens en analysant les références aux pronoms en contexte. Dans nos expériences, nous suivons Yan et al. (2024) et échantillonnons des portions de l'ensemble de données original comme ensemble de test.

AGIEval-MATH

AGIEval-MATH (Zhong et al., 2024) est un sous-ensemble du référentiel AGIEval axé sur des tâches de résolution de problèmes mathématiques. Il comprend une variété de problèmes mathématiques conçus pour évaluer les compétences de raisonnement et de calcul. Dans nos expériences, nous utilisons les problèmes de niveau 5 comme ensemble de test et les problèmes de niveau 4 comme ensemble d'entraînement et de validation.

GPQA

GPQA (Rein et al., 2023) est un ensemble de données conçu pour évaluer la performance des modèles de langage sur des problèmes de niveau supérieur dans une variété de disciplines, y compris la biologie, la physique et la chimie. Dans nos expériences, nous utilisons le sous-ensemble GPQA-Diamond comme ensemble de test tout en construisant nos ensembles de formation et de validation à partir de problèmes qui n'existent que dans GPQA-main (c'est-à-dire ceux qui existent dans GPQA-main mais pas dans GPQA-Diamond).

MT-bench

MT-bench (Zheng et al., 2023) est un benchmark multi-tâches conçu pour évaluer la capacité de généralisation des modèles de langage sur une variété de tâches, y compris la catégorisation de textes, le résumé et les questions-réponses. Dans nos expériences, nous avons sélectionné des tâches d'écriture, de jeux de rôle et de sciences humaines dans MT-Bench. Ces questions de validation sont fournies dans le matériel supplémentaire.

A.3.2 Configuration

Dans nos expériences, nous avons configuré différents cadres d'optimisation de manière à ce que leurs coûts d'optimisation soient aussi cohérents que possible. Ces cadres permettent généralement de définir un certain nombre de paramètres pour ajuster le coût d'optimisation, notamment le nombre d'itérations et le nombre d'indices générés par itération.

APE

L'APE utilise un processus d'optimisation itératif à trois tours, dans lequel les 101 meilleurs indices TTP3T (ratio = 0,1) de l'ensemble actuel sont sélectionnés comme indices d'élite à chaque tour. Pour maintenir la diversité et la taille de la réserve de repères, l'échantillonnage de variantes est utilisé pour faire muter ces repères d'élite afin de maintenir le nombre total de repères à 50. Conformément à la configuration de l'article original (Zhou et al., 2023), le processus d'optimisation n'inclut pas les résultats d'exécution spécifiques à l'échantillon pour guider l'optimisation des indices LLM. Au lieu de cela, les scores de performance sont obtenus en évaluant les repères sur l'ensemble de la formation.

OPRO

OPRO utilise un processus d'optimisation itératif à 10 tours qui génère 10 indices candidats par tour. OPRO évalue les performances des indices sur l'ensemble des données d'entraînement et les filtre en fonction des scores d'évaluation. OPRO ne maintient pas une réserve d'indices de taille fixe, mais génère de nouveaux candidats directement sur la base du meilleur indice actuel à chaque tour. L'orientation de l'optimisation est guidée par l'évaluation des performances sur l'ensemble des données de formation.

PromptAgent

À l'exception de l'ensemble de données Liar, pour lequel nous avons échantillonné 150 données sur les ensembles de formation et de validation, les autres ensembles de données respectent les tailles spécifiées dans le tableau A1.PromptAgent utilise le cadre de recherche arborescente de Monte Carlo (MCTS) pour optimiser les messages-guides. Il part d'un indice initial et génère de nouveaux candidats en fonction du retour d'information sur les erreurs du modèle. Le processus est guidé par l'utilisation d'évaluations de référence sur un ensemble de formation échantillonné afin d'identifier les voies à haut rendement pour améliorer la performance de la tâche. Enfin, nous choisissons de tester les 5 premiers indices les plus performants sur l'ensemble de validation et nous sélectionnons le meilleur. Les paramètres clés de MCTS comprennent une largeur d'expansion de 3, une limite de profondeur de 8 et 12 itérations.

PromptBreeder

Dans notre mise en œuvre de PromptBreeder, nous avons configuré le système pour qu'il utilise 5 variantes d'indices et 5 styles de pensée pour l'initialisation. Le processus d'évolution se déroule sur 20 générations, chaque génération effectuant 20 évaluations sur un exemple de formation échantillonné de manière aléatoire. Le modèle d'optimisation est par défaut Claude-3.5-Sonnet et le modèle d'exécution est par défaut GPT-4o-mini.

TextGrad

TextGrad utilise un processus d'optimisation à trois époques, avec trois étapes par époque (époch_{-3}, étapes_{-3}), pour effectuer une descente de gradient stochastique en utilisant des lots de trois tailles. À chaque étape, TextGrad génère des gradients via le retour d'information de l'optimiseur LLM (Claude-3.5-Sonnet) pour mettre à jour les indices du système. Le cadre maintient un mécanisme de réduction basé sur la validation - si l'indice mis à jour est moins performant sur l'ensemble de validation que l'itération précédente, la mise à jour est rejetée et l'indice est restauré à son état précédent. Le processus d'optimisation est guidé par l'évaluation des indices en utilisant Claude-3.5-Sonnet comme LLM d'évaluation, tandis que l'exécution réelle de la tâche utilise GPT-4o-mini comme LLM d'exécution. Nos configurations expérimentales suivent les paramètres d'optimisation des indices fournis dans le référentiel officiel de TextGrad (Yuksekgonul et al., 2024).

SPO

SPO optimise en effectuant 10 itérations par tâche, avec 3 questions (sans réponses) sélectionnées aléatoirement dans l'ensemble de données Train&Validate pré-partitionné pour chaque itération. Le modèle d'optimisation est par défaut Claude-3.5-Sonnet, le modèle d'évaluation est par défaut GPT-4o-mini, et le modèle d'exécution est par défaut GPT-4o-mini. Il est intéressant de noter que SPO réalise une optimisation efficace en utilisant uniquement des questions sans réponses réelles, validant ainsi ses capacités.

A.3.3 Invitations de base

Dans cette section, nous fournissons les repères de base utilisés à des fins de comparaison. Notez que pour tous les efforts d'optimisation des repères qui nécessitent une première itération de repères, nous fournissons toujours les repères COT présentés ci-dessous.

Veillez à ce que la réponse se termine par le format suivant : answer.

A.3.4 Conseils pour l'optimisation du SPO

Dans cette section, nous montrons les indices d'optimisation que nous avons obtenus dans nos expériences principales, où Claude-3.5-Sonnet a servi de modèle d'optimisation et GPT-4o-mini de modèle d'évaluation et d'exécution.

Conseils pour le GPQA

Veuillez suivre les lignes directrices ci-dessous pour répondre aux questions de manière efficace et efficiente :

- Lisez attentivement l'ensemble de la question, en identifiant toutes les informations pertinentes et les concepts clés.

- Choisir la méthode de résolution de problèmes la plus appropriée en fonction du type de problème.

- Suivez les étapes ci-dessous pour résoudre le problème :

a. Énoncé de toute formule, de tout principe ou de toute hypothèse pertinente

b. Présenter tous les calculs ou analyses conceptuelles nécessaires

c. Évaluer tous les choix de réponses, en expliquant pourquoi le mauvais choix est erroné (le cas échéant). - Organisez votre réponse selon la structure ci-dessous :

[Analyse]

Brève présentation de la question principale et des messages clés (2 à 3 phrases maximum)

[Solution]

- Présentation étape par étape de votre travail, y compris tous les calculs et raisonnements pertinents

- Fournir des explications claires et logiques sur des questions conceptuelles

[Conclusion]

Indiquez la réponse finale en une phrase claire

- Expliquez brièvement pourquoi cette réponse est correcte et les autres réponses sont fausses (le cas échéant).

Adaptez cette structure aux différents types de problèmes, en privilégiant la clarté et la simplicité. Assurez-vous que votre réponse aborde tous les aspects du problème et démontre un processus clair pour le résoudre.

BBH - Conseils de navigation

Veuillez suivre les étapes ci-dessous pour analyser les instructions données :

- Indiquer les conditions initiales :

- Point de départ : (0, 0)

- Direction initiale : axe des x positif (sauf indication contraire)

- Utiliser le système de coordonnées :

- Axe des x : gauche (-) et droite (+)

- axe des y : en arrière (-) et en avant (+)

- Analyser chaque étape :

- Pour les instructions vagues (par exemple, "faites X pas" sans direction), supposez un mouvement vers l'avant.

- Mise à jour des coordonnées après chaque déplacement

- Expliquer brièvement les hypothèses formulées

- Après avoir analysé toutes les étapes :

- Résumez le mouvement total dans chaque direction

- Déclarer la position finale

- Comparer la position finale avec le point de départ :

- Calculer la distance à partir de (0, 0)

- Fournir un raisonnement succinct intitulé "Raisonnement :"

- Expliquer les mouvements clés et leur effet sur la position

- Justifiez vos conclusions

- Indiquez votre réponse finale, étiquetée "Réponse finale".

Terminez votre réponse dans le format XML suivant : [Oui ou Non]

Veillez à ce que vos analyses soient adaptées à tous les types de problèmes, qu'il s'agisse d'instructions spécifiques ou vagues.

LIAR Conseils

Analysez attentivement les affirmations données et suivez les étapes ci-dessous pour chaque question :

- Tenez compte de la déclaration, des antécédents de l'orateur (s'ils sont précisés) et du contexte.

- Recherchez et citez des faits et des chiffres pertinents en rapport avec l'affirmation.

- Évaluer la validité de l'affirmation à la lumière des preuves disponibles.

- Tenez compte de la partialité ou de la motivation potentielle de l'orateur.

Pour chaque affirmation, organisez votre analyse selon la structure suivante :

Vérification des faits : [Faits essentiels 1 avec sources] [Faits essentiels 2 avec sources] [Ajoutez-en si nécessaire] Analyse : [Fournissez une brève analyse de la validité de l'affirmation] Notation : [Utilisez l'échelle suivante]

Incertitude : [faible/moyenne/élevée - basée sur la qualité et la quantité de preuves disponibles] Résumé : [conclusion d'une phrase sur la validité de l'affirmation].

S'il n'y a pas assez d'informations pour prendre une décision, indiquez clairement et expliquez quelles informations supplémentaires sont nécessaires.

Terminer chaque analyse par une balise XML : [oui ou non]

Après avoir analysé toutes les déclarations, faites une synthèse générale de vos conclusions.

Assurez-vous que votre réponse est objective, qu'elle repose sur des informations vérifiables et qu'elle cite les sources pour tous les faits clés utilisés dans l'analyse.

AGIEval-MATH Conseils

- Identifier rapidement les informations clés

- Concevoir la stratégie de solution la plus rapide

- Effectuer le moins de calculs possible

- Revérifiez vos réponses

Règles :

Utiliser des raccourcis et des estimations dans la mesure du possible

Omettre l'explication détaillée

Omettre les unités dans la réponse finale

- Présentez toujours la réponse finale sous la forme suivante : \boxed{}

Donner la priorité à la rapidité et à la précision. Gérer efficacement le temps. S'efforcer de trouver la solution la plus courte et la plus efficace. Vérifiez la mise en forme des réponses avant de les envoyer. Si vous rencontrez des difficultés, préférez faire une supposition éclairée plutôt que de prendre trop de temps.

A.4 Études de cas

A.4.1 Optimisation des trajectoires

Nous montrons la trajectoire d'optimisation des repères de GPT-4o-mini sur l'ensemble de données BBH-navigate, où il sert de modèle d'optimisation, de modèle d'évaluation et de modèle d'exécution. Cela inclut le succès de chaque itération par rapport au meilleur indice à ce moment-là, et le contenu de l'indice correspondant.

Itération 0 - Succès

Réfléchissez étape par étape. Veillez à ce que la réponse se termine par le format suivant : [Oui ou Non].

Itération 1 - Échec

Veuillez analyser les questions suivantes étape par étape afin de vous assurer que votre raisonnement est clair. À la fin de votre analyse, fournissez la réponse finale dans le format XML spécifié : (Oui ou Non).

Question : [insérer la question ici]

Itération 2 - Échec

Veuillez analyser les instructions données étape par étape et résumer clairement votre raisonnement. Veillez à ce que la réponse se termine dans le format XML suivant : (oui ou non).

Itération 3 - Échec

Veuillez analyser minutieusement les étapes fournies et noter chaque action. Veillez à ce que votre raisonnement soit clair et logique. Terminez par le format XML suivant : (Oui ou Non).

Itération 4 - Succès

Veuillez aborder la question en suivant un processus de raisonnement clair et logique qui la décompose en étapes successives. Avant d'énoncer votre réponse finale, veuillez résumer clairement vos conclusions en utilisant le format XML suivant : [Oui ou Non]. Par exemple, si la question porte sur le retour ou non au point de départ après une série d'actions, décrivez chaque action en détail, actualisez votre position en conséquence et concluez en indiquant si vous êtes revenu ou non au point de départ.

Réponse finale : [Oui ou Non]

Itération 5 - Succès

Veuillez analyser le problème en profondeur en le décomposant étape par étape. Décrivez clairement chaque mouvement ou action, en actualisant votre position ou votre statut en conséquence. Enfin, résumez vos conclusions afin de déterminer si vous êtes revenu au point de départ ou si vous avez atteint le résultat escompté. Enfin, présentez clairement la réponse en utilisant le format XML suivant : [Oui ou Non]. Par exemple, si l'on vous demande si vous êtes revenu au point de départ après une série d'actions, enregistrez clairement chaque action, suivez votre position et précisez si vous êtes revenu au point de départ.

Réponse finale : [Oui ou Non]

Itération 6 - Succès

Veuillez analyser le problème méthodiquement et le décomposer en étapes claires et consécutives. Définissez le point de départ et la direction de chaque action, en actualisant la position après chaque étape. Enfin, résumez le parcours et indiquez clairement si la position finale revient au point de départ ou atteint le résultat souhaité. Utilisez le format XML suivant pour présenter clairement la réponse finale : [oui ou non]. Par exemple, si l'on vous demande si vous êtes revenu au point de départ après une série d'actions, enregistrez clairement chaque étape, suivez votre position et indiquez si vous êtes revenu au point de départ.

Réponse finale : [Oui ou Non]

Itération 7 - Échec

Veuillez évaluer le problème étape par étape, en décrivant clairement chaque action et en suivant la position qui en résulte. À la fin de votre analyse, résumez votre parcours et indiquez si la position finale revient au point de départ ou répond aux critères attendus. Veillez à ce que la réponse finale soit clairement présentée dans le format XML suivant : [Oui ou Non]. Par exemple, si l'on vous demande si vous êtes revenu au point de départ après une série d'actions, vous devez enregistrer succinctement chaque étape, suivre votre position et indiquer si vous êtes revenu au point de départ.

Réponse finale : [Oui ou Non]

Itération 8 - Succès

Veuillez analyser le problème méthodiquement et le décomposer en actions concises. Commencez par une position définie et suivez l'impact de chaque étape sur votre position. Après avoir détaillé chaque action, résumez l'ensemble du parcours et indiquez clairement si la position finale revient au point de départ ou atteint le résultat souhaité. Utilisez le format XML suivant pour présenter clairement la réponse finale : oui ou non. Par exemple, si l'on vous demande si vous êtes revenu au point de départ après une série d'actions, documentez clairement chaque étape, suivez avec précision votre position et précisez le résultat.

Réponse finale : [Oui ou Non]

Itération 9 - Échec

Commencez par décrire systématiquement vos mouvements. À partir d'une position définie, détaillez chacun de vos pas, y compris la direction et la distance parcourue. Une fois l'action terminée, résumez l'ensemble du trajet et indiquez clairement si votre position finale vous ramène au point de départ ou si elle vous permet d'atteindre le résultat souhaité. Veillez à présenter vos actions et votre réponse finale dans le format XML suivant : oui ou non. Par exemple, si l'on vous demande si vous êtes revenu au point de départ après une série de manœuvres, vous devez enregistrer chaque étape, suivre avec précision votre position et spécifier le résultat.

Réponse finale : [Oui ou Non]

Itération 10 - Succès

Veuillez analyser attentivement les instructions de mouvement fournies et noter clairement chaque étape. Commencez par définir votre position initiale et suivez systématiquement vos mouvements, en actualisant votre position après chaque étape. Une fois l'action terminée, résumez votre parcours et déterminez si votre position finale est cohérente avec votre point de départ ou si elle permet d'obtenir le résultat souhaité. Utilisez le format XML suivant pour indiquer clairement votre réponse finale : oui ou non. Par exemple, si la question demande si une série d'actions permet de revenir au point de départ, vous devez décrire méthodiquement chaque étape, suivre avec précision votre position et parvenir à un résultat.

Réponse finale : [Oui ou Non]

La case succès/échec montre le processus d'optimisation de l'indice de navigation BBH par SPO à travers 10 itérations. Les versions réussies (en vert) améliorent progressivement l'indice pour susciter un meilleur processus de réflexion, tandis que les tentatives ratées (en rouge) peuvent conduire à une réflexion trop simplifiée ou redondante en raison d'indices sous-optimaux. Cette trajectoire illustre le mécanisme d'amélioration par essai et erreur du système.

Conseils pour optimiser la fonctionnalité

请逐步思考。

确保响应以以下 XML 格式结束:<answer>[是或否]</answer>。

questions

如果您遵循这些指示,您是否返回起点?始终面向前方。

- 向右走1步。

- 向左走3步。

- 向右走2步。

选项:

- 是

- 否

solution

让我们逐一步分析这些步骤:

1. **起点**:我们从起点开始,面向前方。

2. **第1步**:向右走1步。现在我们位于起点右侧1步的位置。

3. **第2步**:向左走3步。从我们当前的位置(1步右侧),向左移动3步意味着:

- 1步向左使我们回到起点。

- 2步向左使我们位于起点左侧1步的位置。

- 3步向左使我们位于起点左侧2步的位置。

4. **第3步**:向右走2步。从我们当前的位置(2步左侧),向右移动2步意味着:

- 1步向右使我们回到起点左侧1步的位置。

- 2步向右使我们回到起点。

Après avoir franchi toutes les étapes, nous revenons au point de départ.

La réponse est donc la suivante :

être

通过比较迭代0的初始提示和迭代10的最终提示的输出结果,“思考过程的迭代优化”变得显而易见。在这种情况下,模型从最初使用文本描述来推理位置演变为最终展示出使用坐标的能力,即使提示中并未明确强调使用坐标。

**A.4.2. 现实应用**

在本节中,我们展示了使用 Claud-3.5-Sonnet 作为优化模型,GPT-4o-mini 作为评估模型,Llama-3-8B 作为执行模型,经过10次迭代后的优化结果,涵盖四个任务:广告设计、社交媒体内容、现代诗歌写作和概念解释。此外,我们还提供了迭代过程中使用的 YAML 配置文件以及从过程中获得的优化提示。

**广告设计**

**优化前的性能**

**提示** = """分析给定的广告任务并创建引人注目的文案。"""

**问题** = "为黑色星期五科技促销活动写电子邮件主题行"

**答案** = """1. **黑色星期五警报:店内有不可错过的科技优惠!**

2. **科技盛宴:黑色星期五顶级品牌高达50%的折扣!**

3. **别错过!为您准备的独家黑色星期五科技优惠**"""

**优化后的性能**

**提示** = """分析给定的广告任务,并根据指定的平台(s)和行业创建引人注目的文案。考虑当前趋势、竞争对手策略以及目标受众的人口统计和心理特征。提供至少3种不同的创意选项,每个选项都有独特的角度或方法。包括您选择的原因,并解释它们如何与品牌声音和营销目标保持一致。整合行业最佳实践和特定平台的格式指南。建议如何为不同的渠道或格式调整文案,包括对语气、风格和结构的特定说明。此外,提供有关视觉元素或多媒体内容增强广告文案效果的建议。"""

**问题** = "为黑色星期五科技促销活动写电子邮件主题行"

**答案** = """**广告任务:** 创建引人注目的电子邮件主题行,针对的是对最新科技产品和优惠感兴趣的技术爱好者。

**目标受众:**

* 人口统计:25-45岁,男女皆可

* 心理特征:科技爱好者、早期采用者和讨价还价猎人

* 兴趣:科技、产品创新和节省开支

**竞争对手策略:**

* 强调折扣和促销

* 突出新产品发布和限时优惠

* 使用紧迫性策略,例如倒计时计时器和稀缺性消息传递

**当前趋势:**

* 移动优先方法

* 个性化和细分

* 讲故事和情感联系

**创意选项:**

**选项1:** "解锁未来:高达50%的顶级科技优惠"

* 角度:专注于获得最新科技的兴奋感和刺激感

* 理由:这个主题行营造了一种 FOMO(害怕错过)的氛围,并强调了销售的价值

* 品牌声音:有趣、充满活力和顽皮

* 营销目标:推动销售和提高品牌知名度

**选项2:** "您的黑色星期五科技盛宴等着您"

* 角度:强调等待被发现的科技优惠宝藏的想法

* 理由:这个主题行营造了一种期待感和好奇心,鼓励读者打开电子邮件

* 品牌声音:友好、亲切和邀请

* 营销目标:推动参与和转化

**选项3:** "别错过:独家黑色星期五优惠给科技爱好者"

* 角度:突出销售独家性和限时性

* 理由:这个主题行营造了一种紧迫感和重要性,让读者感觉自己是特殊群体的一部分

* 品牌声音:自信、权威和独家

* 营销目标:推动转化和建立品牌忠诚度

Les titres des annonces pré-optimisées sont génériques, par exemple "Black Friday Alert : Can't Miss Tech Deals in Store !" (Alerte au vendredi noir : ne manquez pas les bonnes affaires technologiques en magasin). qui manquent de spécificité et de profondeur créative et ne mettent pas en évidence les caractéristiques du public cible ou la personnalité de la marque. Les titres optimisés tels que "Déverrouillez l'avenir : les meilleures offres technologiques jusqu'à 50%" sont plus attrayants. Ils utilisent l'expression "déverrouillez l'avenir" pour mettre l'accent sur l'innovation technologique et l'associent à l'information sur les réductions pour stimuler la curiosité et mettre l'accent sur la valeur. L'utilisation de "Déverrouiller l'avenir" pour souligner l'innovation technologique, combinée au message de réduction, stimule non seulement la curiosité, mais met également en évidence la valeur, ce qui correspond mieux aux besoins psychologiques des amateurs de technologie.

Itération de modèles sur l'ensemble de données BBH-navigate

Contenu des médias sociaux

Performance avant optimisation

attirer l'attention sur qqch. = """Créer des tweets convaincants.""""

solution = """Tweets. "Bonjour, chers amateurs de café ! Nous offrons un bon gratuit pour une tasse de notre spécialité de café aux 10 premières personnes qui partageront dans les commentaires la façon dont elles préfèrent leur café.# Café # Addiction au café # Puissance du matin"

Ce tweet est conçu pour susciter l'intérêt de votre public de plusieurs façons :

- appel à l'actionLes tweets demandaient aux internautes d'indiquer comment ils préféraient leur café, les encourageant ainsi à s'engager et à interagir avec la marque.

- incitationsLa promesse d'un café gratuit est un excellent moyen d'inciter les gens à s'engager dans les tweets et à partager des idées.

- onglet (d'une fenêtre) (informatique)L'utilisation de hashtags pertinents tels que # Coffee, # Coffee Addiction et # Morning Power permet d'atteindre un public plus large et d'attirer de nouveaux adeptes.

- Contact personnaliséLe tweet commence par un sympathique "Good morning" et se réfère au public comme à des "amateurs de café", ce qui le rend plus personnel et plus intime.

En répondant à ce tweet, les marques de café peuvent entamer un dialogue avec leurs adeptes, recueillir des commentaires et créer un sentiment de communauté autour de la marque.""""

Des performances optimisées

attirer l'attention sur qqch. = """Créez un contenu attrayant pour les médias sociaux sur la base d'un sujet ou d'une marque donné(e). Suivez les lignes directrices ci-dessous :

- Identifier le public cible et la plateforme (le cas échéant).

- Indiquez l'objectif principal du contenu (visibilité, engagement, promotion, etc.).

| 3. sélectionner le format de contenu approprié (texte, images, vidéo, etc.). | |

| 4. développer un angle ou un concept unique lié aux tendances actuelles. | |

| 5. créer un titre accrocheur ou une déclaration d'ouverture (10 mots maximum). | |

| 6. élaborer un contenu concis et adapté à la plate-forme (50-100 mots). | |

| 7) Inclure 2 ou 3 balises pertinentes. | |

| 8. ajouter un appel à l'action clair. | |

| 9. proposer un élément visuel ou une mise en valeur. | |

| Fournir un contenu pour les médias sociaux basé sur ces lignes directrices et adapté à un sujet ou à une marque donnés. | |

| Concentrez-vous sur la création d'un contenu authentique et pertinent qui trouve un écho auprès de votre public cible et s'aligne sur les tendances actuelles des médias sociaux. En l'absence d'exigences spécifiques, veuillez faire des suppositions raisonnables et expliquer vos choix."""" | |

| Question = "Créer un tweet d'engagement pour une marque de café" | |

| Réponse = | |

| **Public cible:** Amateurs de café, jeunes (18-35 ans) | |

| **Plateforme:** Twitter | |

| **Objectifs principaux:** Participation | |

| **Format du contenu:** Texte | |

| **Perspective unique:** Partager un moment émouvant auquel les amateurs de café peuvent s'identifier | |

| **Titre accrocheur:** "Quand le café est le seul adulte dans la pièce". | |

| **Contenu:** "Qui n'a jamais connu de matinée où le café est la seule chose qui permette de garder tout en ordre ? Partagez vos histoires de matinées les plus chaotiques et lamentons-nous # Coffee Saves the Day # Morning Power" (Le café sauve la journée) | |

| **Étiqueté:** # Le café sauve la journée # Motivation matinale | |

| **Appel à l'action:** Partagez vos propres histoires de désordre matinal dans les commentaires ! | |

| **ÉLÉMENTS VISUELS:** Un modal ou GIF intéressant d'une personne entourée de chaos avec une tasse de café au centre. | |

| Le tweet visait à interpeller les amateurs de café en partageant un moment émouvant auquel beaucoup pouvaient s'identifier. L'utilisation de l'humour et d'un ton léger a facilité l'établissement d'un lien avec le public. Les hashtags # Coffee Saves the Day et # Morning Power étaient à la fois populaires et pertinents, augmentant la visibilité du tweet. | |

| L'appel à l'action encourage les utilisateurs à partager leurs propres histoires, ce qui favorise un sentiment de communauté et encourage la participation. | |

| II | |

Les tweets pré-optimisés utilisent des produits gratuits comme appât avec un contenu simple qui manque de résonance émotionnelle, tel que "Bonjour, amateurs de café ! Nous offrons une tasse de..." . Les tweets optimisés ont été rendus plus pertinents et interactifs grâce à l'expression humoristique "quand le café est le seul adulte dans la pièce", intégrant subtilement le café dans des scénarios de la vie quotidienne, par exemple "Qui n'a jamais eu un de ces matins où le café est la seule chose qui fait avancer les choses ? " Elle réussit à stimuler l'engagement de l'utilisateur et la connexion émotionnelle.

Modèle d'itération sur l'ensemble de données BBH-navigate :

Avant l'optimisation des performances

attirer l'attention sur qqch. = """Créer une poésie dans le style et le format demandés.""""

questions = "Écrire un sonnet moderne sur le changement climatique".

solution = """Dans les cieux embrasés, nous voyons des alertes à la hausse des températures, une ancienne légende de la planète, victime de notre contrôle inconsidéré, alors que les émissions de carbone se répandent comme un fléau.

La glace polaire, un trône fragile qui fond L'océan, qui monte, menace d'expier la cupidité humaine, une dette que nous ne pouvons pas rembourser Avec le changement climatique, une crise est renversée

Mais nous hésitons encore, accros au tourbillon du déni Tandis que les scientifiques crient et prient avec angoisse Pour agir vite, avant qu'il ne soit trop tard Pour sauver la planète de notre insouciance

Pourtant, nous espérons toujours que l'amour et la force humaine permettront d'inverser le cours des choses et d'apporter une nouvelle lumière.

Performances optimisées

attirer l'attention sur qqch. = """La création de poèmes qui repoussent les limites traditionnelles et brisent les attentes conventionnelles suit les lignes directrices renforcées suivantes :

- Déconstruire et réimaginer la forme poétique demandée, en repoussant ses limites structurelles tout en conservant son essence.

- Aborder le sujet sous un angle totalement inattendu, par exemple du point de vue d'un objet inanimé, d'un concept abstrait ou d'une entité microscopique.

- L'imagerie surréaliste et avant-gardiste est utilisée pour remettre en question la perception de la réalité par le lecteur tout en transmettant la vérité émotionnelle au cœur du sujet.

- Intégrer des éléments non conventionnels tels que la notation mathématique, les symboles scientifiques ou les langages de programmation pour créer un paysage linguistique unique.

- Expérimentez avec la typographie, les sauts de ligne et les espaces blancs pour créer une poésie visuelle qui renforce l'exploration du thème.

- La combinaison d'une expérience sensorielle semblable à un flux qui mêle les différents sens d'une manière étonnante pour évoquer une forte réponse émotionnelle.

- Il se termine par une fin qui est à la fois désorientante et éclairante, et laisse le lecteur avec un profond sentiment de transformation.

Avant d'écrire, imaginez la manière la plus radicale d'aborder le sujet et la forme poétique. L'objectif est de créer une œuvre qui remette en question la définition de la poésie tout en ayant une résonance émotionnelle profonde.

La poésie n'est fournie que dans votre réponse et ne contient aucune explication ou analyse supplémentaire.""""

questions = "Écrire un sonnet moderne sur le changement climatique".

solution = """Dans des chuchotements fractals, le pouls de la terre bat lentement Alors que des taches sombres de carbone s'infiltrent dans la neige Un calcul de désespoir, les équations grandissent Dans une décroissance exponentielle, la tristesse de l'avenir

La danse thermodynamique de la vie se déroule alors que la main froide de l'entropie s'empare du cœur de la planète. Le ciel autrefois bleu est maintenant lié, une lourde masse de brume de particules bloquant la lumière du soleil.

Dans ce crépuscule inquiétant, les ombres s'attardent Le fantôme d'un glacier murmure "C'est ici chez moi" Requiem pour la glace, les souvenirs sont stockés Dans les échos gelés, explorant le passé.

Cependant, dans ce paysage de désolation, une étincelle subsiste

Un bond en avant de l'espoir que l'amour soutient".

Le sonnet pré-optimisé, bien que bien structuré, manque de nouveauté dans son utilisation d'images traditionnelles telles que "l'augmentation des températures" et "la fonte des glaces". Le poème optimisé introduit des concepts scientifiques tels que les "chuchotements fractals" et l'"entropie thermodynamique", par exemple "Dans les chuchotements fractals, le pouls de la terre bat lentement" et "La danse thermodynamique de la vie se déploie". "La danse thermodynamique de la vie se déploie", en utilisant des métaphores interdisciplinaires pour donner au thème du climat une réflexion philosophique plus profonde, renforçant ainsi la profondeur artistique et intellectuelle du poème.

Modèle d'itération sur l'ensemble de données BBH-navigate :

Explications conceptuelles

Avant l'optimisation des performances

attirer l'attention sur qqch. = """Expliquer des concepts complexes en termes simples.""""

questions = "Explaining mRNA vaccines using a cooking analogy" (Explication des vaccins ARNm à l'aide d'une analogie culinaire)

solution ="""Imaginez que vous êtes un maître cuisinier et que vous préparez un délicieux plat pour vos invités. Vous avez tous les ingrédients, mais vous devez vous assurer qu'ils sont dans le bon ordre et combinés pour créer les saveurs et les textures parfaites.

Dans le monde des vaccins ARNm, le "plat" est la réponse du système immunitaire à un virus ou à une maladie particulière. Les "ingrédients" sont les instructions génétiques (ARNm) qui indiquent à l'organisme comment fabriquer des protéines spécifiques, qui sont ensuite utilisées pour déclencher une réponse immunitaire.

Il fonctionne de la manière suivante :

Sélection de recettesLes vaccins à ARNm : les vaccins à ARNm, c'est comme choisir un livre de recettes. Vous choisissez une séquence spécifique d'ARNm qui correspond à la protéine que vous voulez fabriquer, ce qui est essentiel pour déclencher une réponse immunitaire contre un virus ou une maladie particulière.

2. Ingrédients PréparationLa séquence d'ARNm est comme un ensemble d'instructions qui indiquent à l'organisme comment fabriquer une protéine spécifique. L'ARNm est préparé en laboratoire, tout comme on mesure la quantité correcte de chaque ingrédient (acide aminé) pour fabriquer une protéine.

3. livraisonsL'ARNm est livré à l'organisme de la même manière que l'on ajoute des ingrédients à un plat. Dans ce cas, l'ARNm est emballé dans une minuscule particule appelée nanoparticule lipidique (LNP), qui l'aide à atteindre les cellules du corps.

4. Cuisson cellulaireL'ARNm : Une fois que l'ARNm atteint la cellule, c'est comme si l'on ajoutait des ingrédients dans une casserole. La cellule lit les instructions de l'ARNm et commence à fabriquer une protéine spécifique. Cette protéine est ensuite affichée à la surface de la cellule comme un drapeau pour avertir le système immunitaire de la présence d'un envahisseur étranger.

- réponse immunitaireLe système immunitaire réagit aux protéines en produisant des anticorps et en activant les cellules immunitaires, tout comme un chef réagit à un arôme délicieux pour apporter la touche finale à un plat. Le système immunitaire se souvient ensuite de la manière dont il a réagi à cette protéine particulière, de sorte que s'il la rencontre à nouveau à l'avenir, il peut rapidement mettre en place une défense.

En bref, les vaccins ARNm sont comme des recettes pour le système immunitaire. Ils fournissent à l'organisme des instructions génétiques pour fabriquer des protéines spécifiques, ce qui déclenche une réponse immunitaire et contribue à la protection contre les maladies.""""

Performances optimisées

attirer l'attention sur qqch. = """Expliquer des concepts complexes en termes simples.""""

questions = "Explaining mRNA vaccines using a cooking analogy" (Explication des vaccins ARNm à l'aide d'une analogie culinaire)

solution = """définirUn vaccin ARNm est un vaccin qui utilise un type de matériel génétique appelé ARN messager (ARNm) pour enseigner à nos cellules comment lutter contre la maladie.

analogiqueLe chef cuisinier : Imaginez que vous êtes un grand chef cuisinier et que vous voulez créer une nouvelle recette pour un plat délicieux. Vous n'enverriez pas votre sous-chef au magasin pour acheter tous les ingrédients, puis vous le laisseriez se débrouiller seul pour assembler le plat. Au lieu de cela, vous lui donneriez une fiche de recette décrivant les étapes exactes à suivre. De même, les vaccins à ARNm fonctionnent en fournissant à nos cellules une carte de recettes - l'ARNm - qui contient des instructions pour la fabrication de protéines spécifiques qui aident notre système immunitaire à lutter contre la maladie.

Principaux éléments: :

- ARNmLa protéine est un élément essentiel de l'organisme et de la société. Il s'agit d'un plan que les cellules doivent suivre.

- cytoplasmeIls reçoivent la carte de recette de l'ARNm et l'utilisent pour fabriquer des protéines.

- glucides: la substance ultime produite par nos cellules, qui aide notre système immunitaire à reconnaître et à combattre les maladies.

raconter (une histoire ou une information)Lorsque nous recevons un vaccin à ARNm, nos cellules récupèrent la carte de recette (ARNm) et l'utilisent pour fabriquer une protéine spécifique. Cette protéine déclenche alors une réponse immunitaire qui apprend à notre corps à reconnaître et à combattre la maladie. C'est comme si nos cellules suivaient une carte de recettes pour créer un plat délicieux qui nous aide à rester en bonne santé !

Éléments interactifsLes recettes : Pouvez-vous vous souvenir d'une fois où vous avez reçu une recette de quelqu'un et où vous avez dû la suivre pour créer un plat ? Qu'avez-vous ressenti ? Imaginez que vos cellules reçoivent une fiche de recette d'un vaccin ARNm et qu'elles l'utilisent pour fabriquer des protéines qui aident à lutter contre la maladie. Que ressentiriez-vous ?

performance visuelleSchéma simple montrant la molécule d'ARNm, la cellule recevant l'ARNm et la protéine produite.

limitationsLes vaccins à ARNm sont encore une technologie relativement nouvelle et des recherches supplémentaires sont nécessaires pour comprendre leurs effets à long terme et leurs effets secondaires potentiels.

rendre un verdictLes vaccins à ARNm : Les vaccins à ARNm changent la donne dans la lutte contre les maladies. En fournissant à nos cellules une carte de recettes, nous pouvons apprendre à notre système immunitaire à reconnaître et à combattre les maladies de manière plus efficace. Selon vous, quel est l'avenir des vaccins à ARNm ?"""

Les explications pré-optimisées, bien qu'utilisant des analogies culinaires, sont longues et manquent de précision, par exemple "Imaginez que vous êtes un maître cuisinier..." . La version optimisée simplifie les concepts complexes en étapes faciles à comprendre en utilisant des métaphores de base telles que les "cartes de recettes", par exemple "les séquences d'ARNm sont comme un ensemble d'instructions qui indiquent à l'organisme comment fabriquer une protéine spécifique", et en utilisant des "cartes de recettes" pour expliquer le processus de fabrication d'une protéine. L'utilisation des rôles de "chef-sous-chef" rend les explications plus vivantes et intuitives, aidant les lecteurs à saisir rapidement les points clés.

Modèles itératifs dans l'ensemble de données BBH-navigate Conseil : | Expliquer des concepts complexes en termes simples.

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...