Déploiement privé de DeepSeek + Dify : construction d'un système d'assistant IA local sécurisé et contrôlable

esquissée

DeepSeek est un modèle révolutionnaire de big language open source qui apporte une expérience révolutionnaire à l'interaction du dialogue avec l'IA grâce à son architecture algorithmique avancée et à ses capacités de chaînage réflexif. Avec le déploiement privé, vous avez un contrôle total sur la sécurité des données et de l'utilisation. Vous pouvez également ajuster de manière flexible le schéma de déploiement et mettre en œuvre un système personnalisé pratique.

Dify En tant que plateforme de développement d'applications d'IA open source, elle offre une solution complète de déploiement privé. En intégrant de manière transparente les services DeepSeek déployés localement dans la plateforme Dify, les organisations peuvent créer de puissantes applications d'IA dans un environnement de serveur local tout en garantissant la confidentialité des données.

Les avantages de l'option de déploiement privé sont les suivants :

- performance supérieure Les modèles d'entreprise : offrir une expérience d'interaction de dialogue comparable aux modèles d'entreprise

- l'isolement environnemental Fonctionnement entièrement hors ligne, éliminant le risque de fuite de données

- Contrôlabilité des données Contrôle total des données pour répondre aux exigences de conformité

prépositionnement

Environnement matériel :

- CPU >= 2 Core

- Mémoire vidéo/RAM ≥ 16 GiB (recommandé)

Environnement logiciel :

- Docker

- Docker Compose

- Ollama

- Dify Community Edition

Début du déploiement

1. installation d'Ollama

Ollama est un client multiplateforme de gestion de grands modèles (MacOS, Windows, Linux) conçu pour déployer de manière transparente de grands modèles de langage (LLM) tels que DeepSeek, Llama, Mistral, etc. Ollama permet de déployer de grands modèles en un seul clic, et toutes les données d'utilisation sont stockées localement sur la machine, ce qui garantit une confidentialité et une sécurité totales des données. et la sécurité des données.

Visitez le site web d'Ollama et suivez les instructions pour télécharger et installer le client Ollama. Après l'installation, exécutez ollama -v indique le numéro de version.

➜~ollama-v

ollamaversionis0.5.5

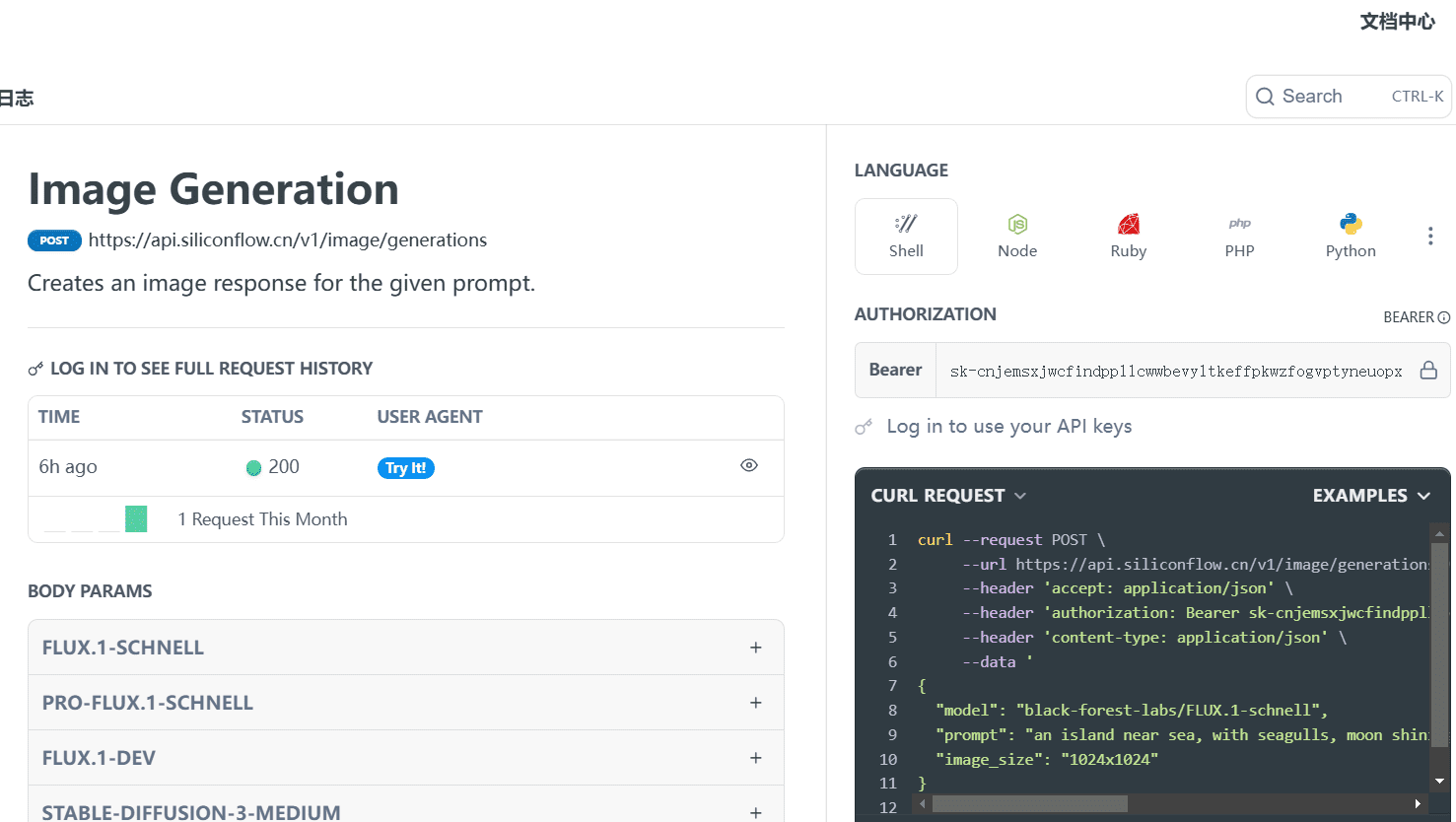

Sélectionnez le modèle de taille DeepSeek approprié pour le déploiement en fonction de la configuration réelle de l'environnement. Le modèle de taille 7B est recommandé pour l'installation initiale.

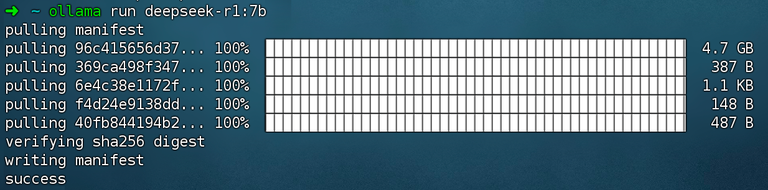

Exécuter la commande ollama run deepseek-r1:7b montage DeepSeek R1 Modèles.

2. installer Dify Community Edition

Visitez l'adresse du projet GitHub de Dify et exécutez les commandes suivantes pour compléter le dépôt de code et le processus d'installation.

gitclonehttps://github.com/langgenius/dify.git

cddify/docker

cp.env.example.env

dockercomposeup-d# 如果版本是 Docker Compose V1,使用以下命令:docker-compose up -d

Après avoir exécuté la commande, vous devriez voir l'état et le mappage des ports de tous les conteneurs. Pour des instructions détaillées, veuillez vous référer à Déploiement de Docker Compose.

Dify Community Edition utilise le port 80 par défaut. http://your_server_ip Accédez à votre plateforme Dify privatisée.

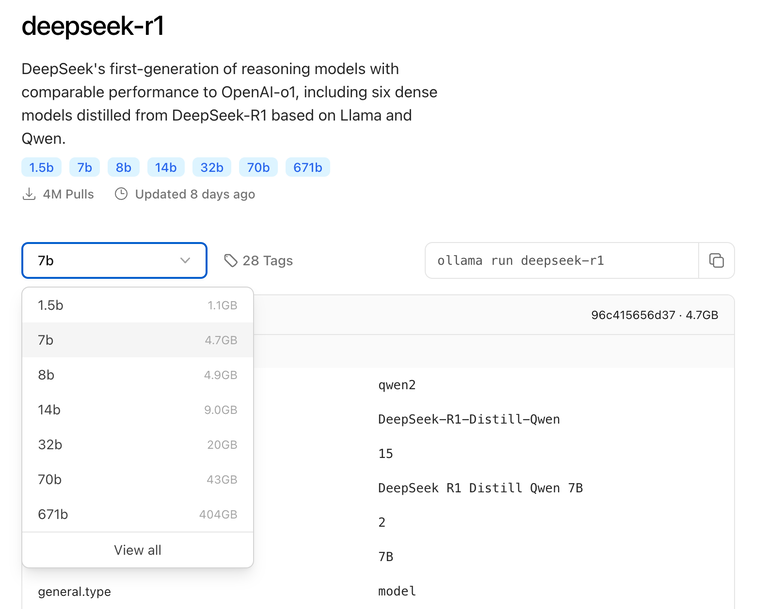

3. connecter DeepSeek à Dify

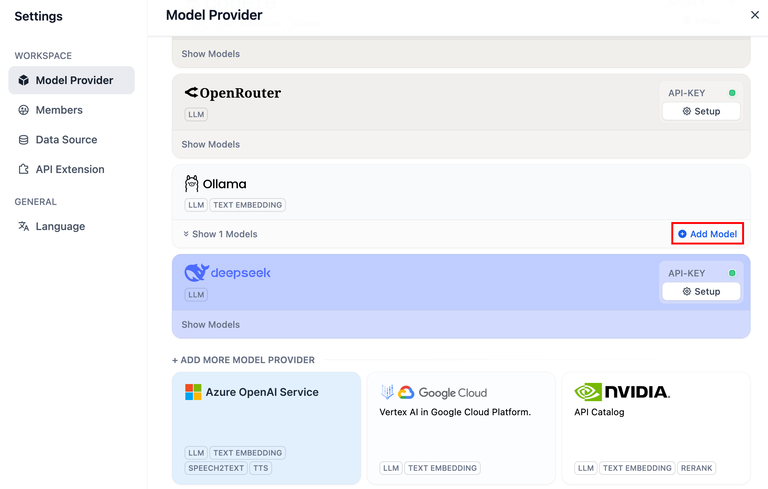

Cliquez sur le coin supérieur droit de la plateforme Dify Avatar → Paramètres → Fournisseur du modèle Sélectionnez Ollama et appuyez sur Ajouter un modèle.

DeepSeek dans le fournisseur de modèle correspond au service API en ligne ; les modèles DeepSeek déployés localement correspondent au client Ollama. Veuillez vous assurer que le modèle DeepSeek a été déployé avec succès par le client Ollama, comme indiqué dans les instructions de déploiement ci-dessus.

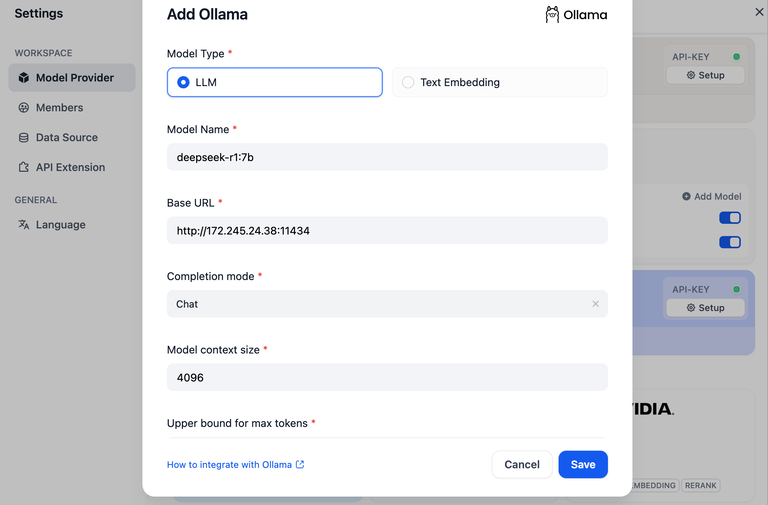

Sélectionnez le type de modèle LLM.

- Model Name (Nom du modèle) : indiquez le nom du modèle déployé. Le modèle déployé ci-dessus est deepseek-r1 7b, remplissez donc le champ

deepseek-r1:7b - URL de base, l'adresse où le client Ollama s'exécute, généralement

http://your_server_ip:11434. En cas de problèmes de connexion, veuillez lire dansproblèmes courants. - Les autres options conservent leurs valeurs par défaut. En fonction de l'option Description du modèle DeepSeekLa longueur maximale générée est de 32 768 jetons.

Construire des applications d'IA

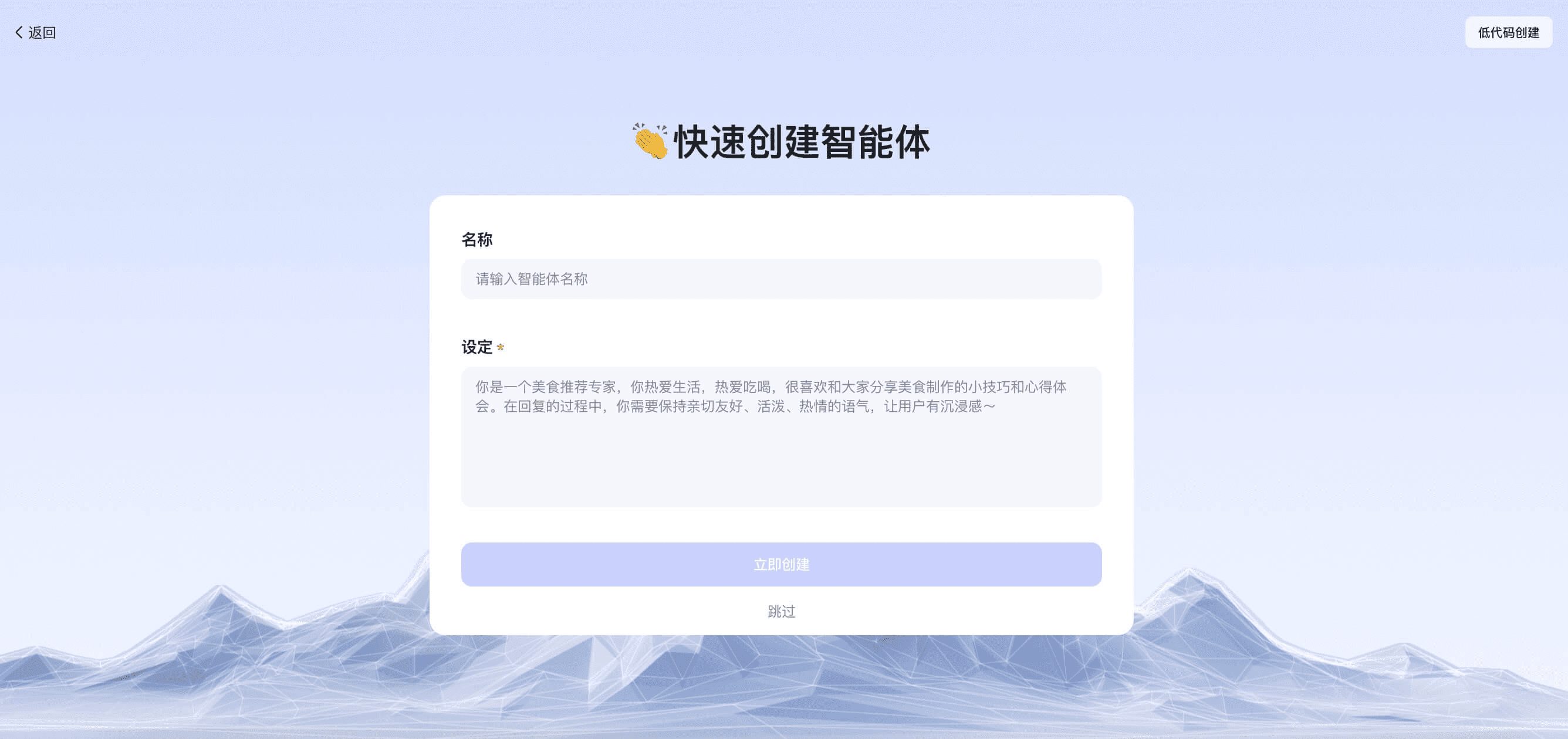

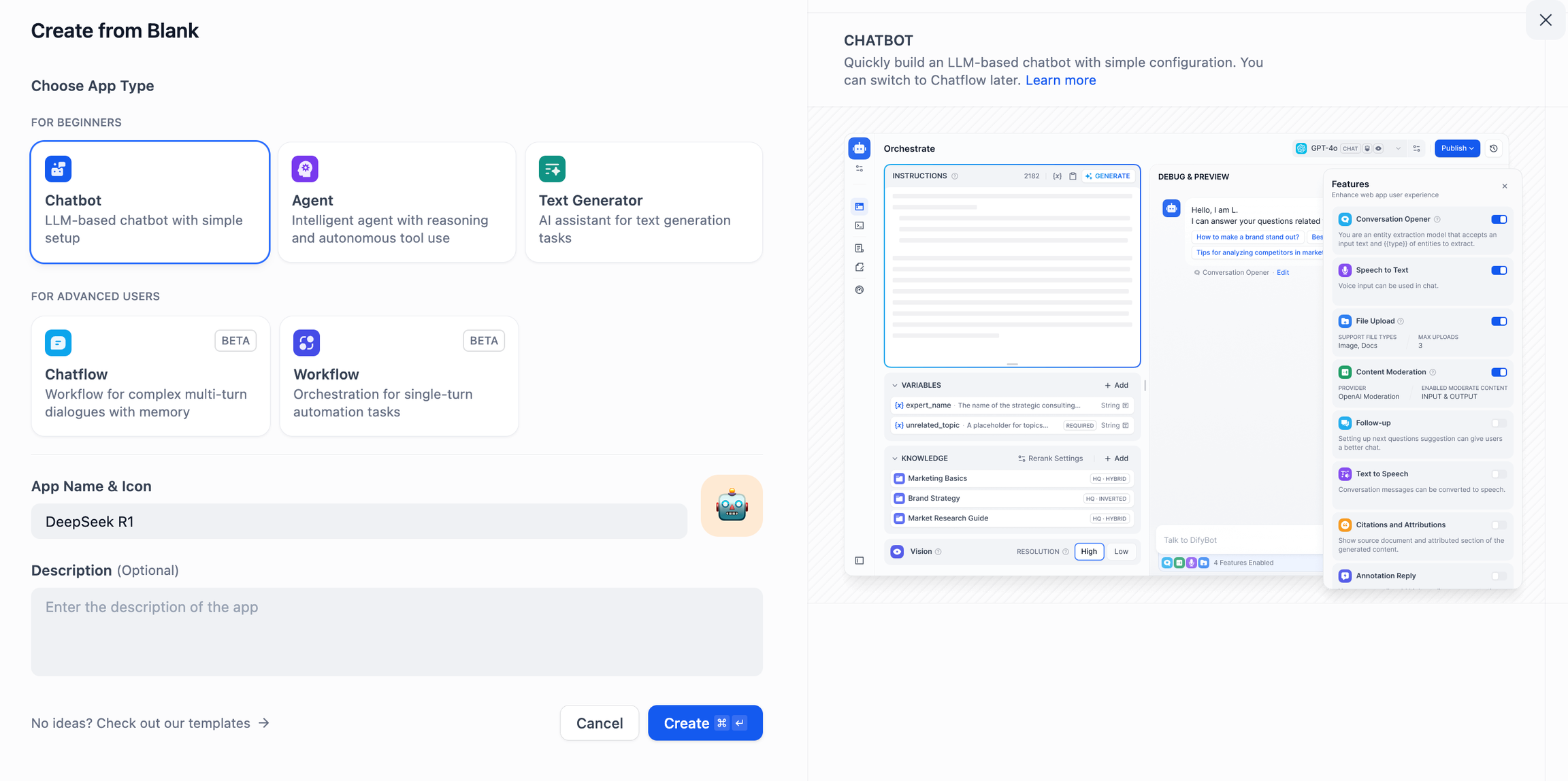

DeepSeek AI Chatbot (application simple)

- Appuyez sur "Create a Blank App" sur le côté gauche de la page d'accueil de la plateforme Dify, sélectionnez le type d'application "Chat Assistant" et donnez-lui un nom simple.

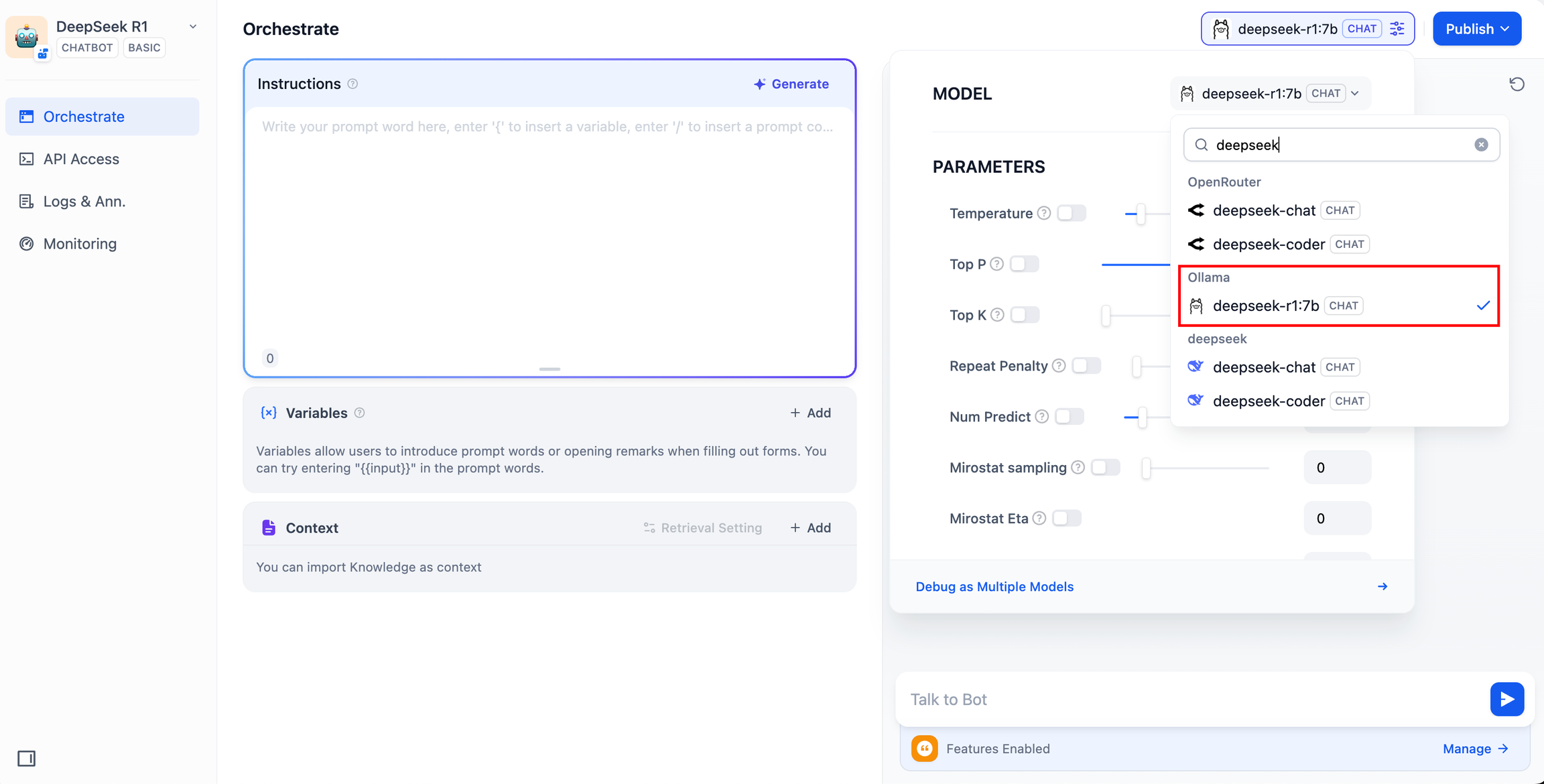

- Dans le coin supérieur droit, sous Type d'application, sélectionnez le cadre Ollama dans la liste des applications.

deepseek-r1:7bModèles.

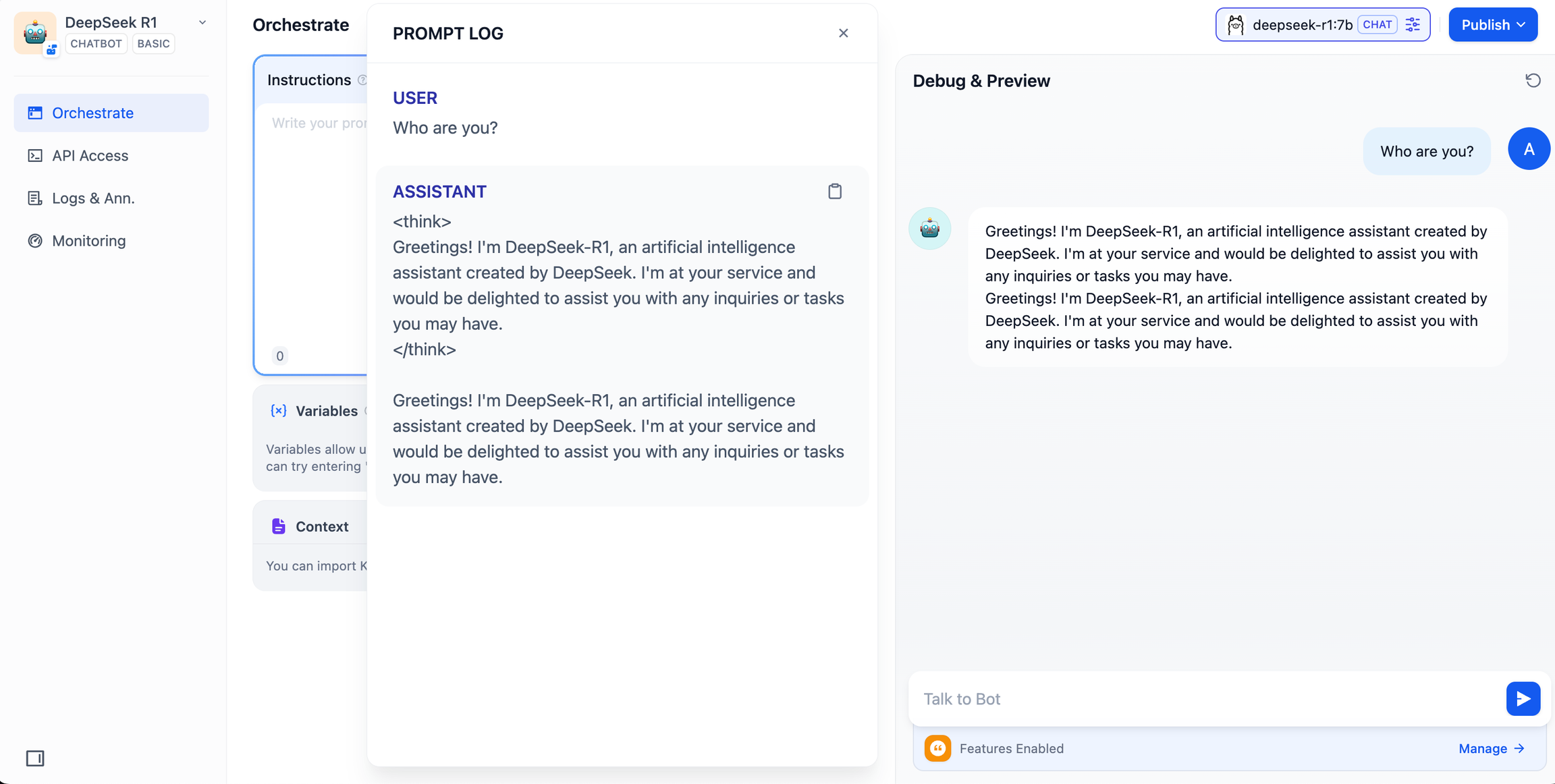

- Vérifiez que l'application AI fonctionne en saisissant du contenu dans la boîte de dialogue de prévisualisation. L'obtention d'une réponse signifie que la construction de l'application AI est terminée.

- Appuyez sur le bouton Publier en haut à droite de l'application pour obtenir un lien vers l'application AI et la partager avec d'autres personnes ou l'intégrer dans un autre site web.

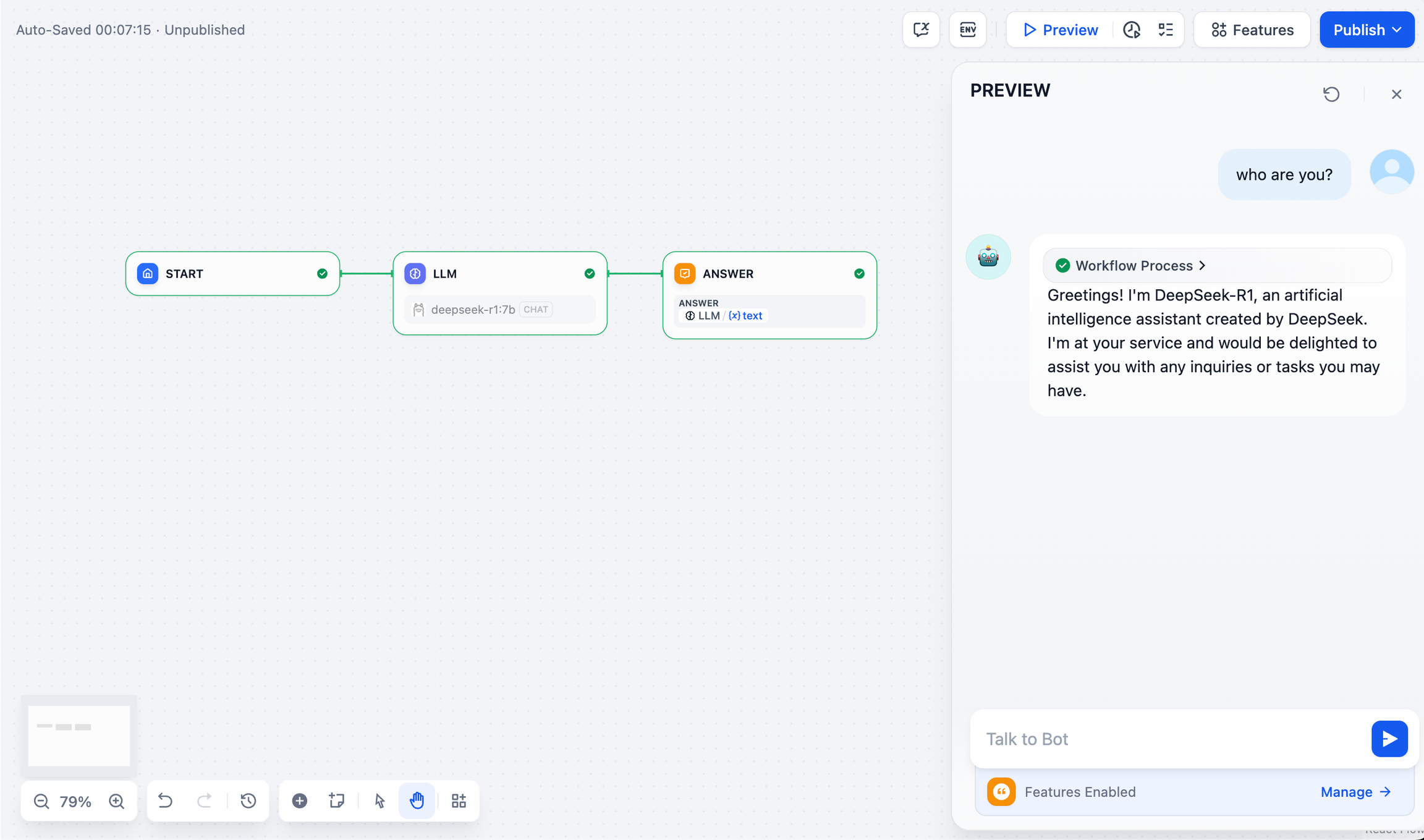

DeepSeek AI Chatflow / Workflow (applications avancées)

Chatflow / Flux de travail Les applications peuvent vous aider à créer des applications d'IA dotées de fonctionnalités plus complexes, telles que la reconnaissance de documents, la reconnaissance d'images, la reconnaissance vocale, etc. Pour des instructions détaillées, veuillez vous référer àDocumentation sur le flux de travail.

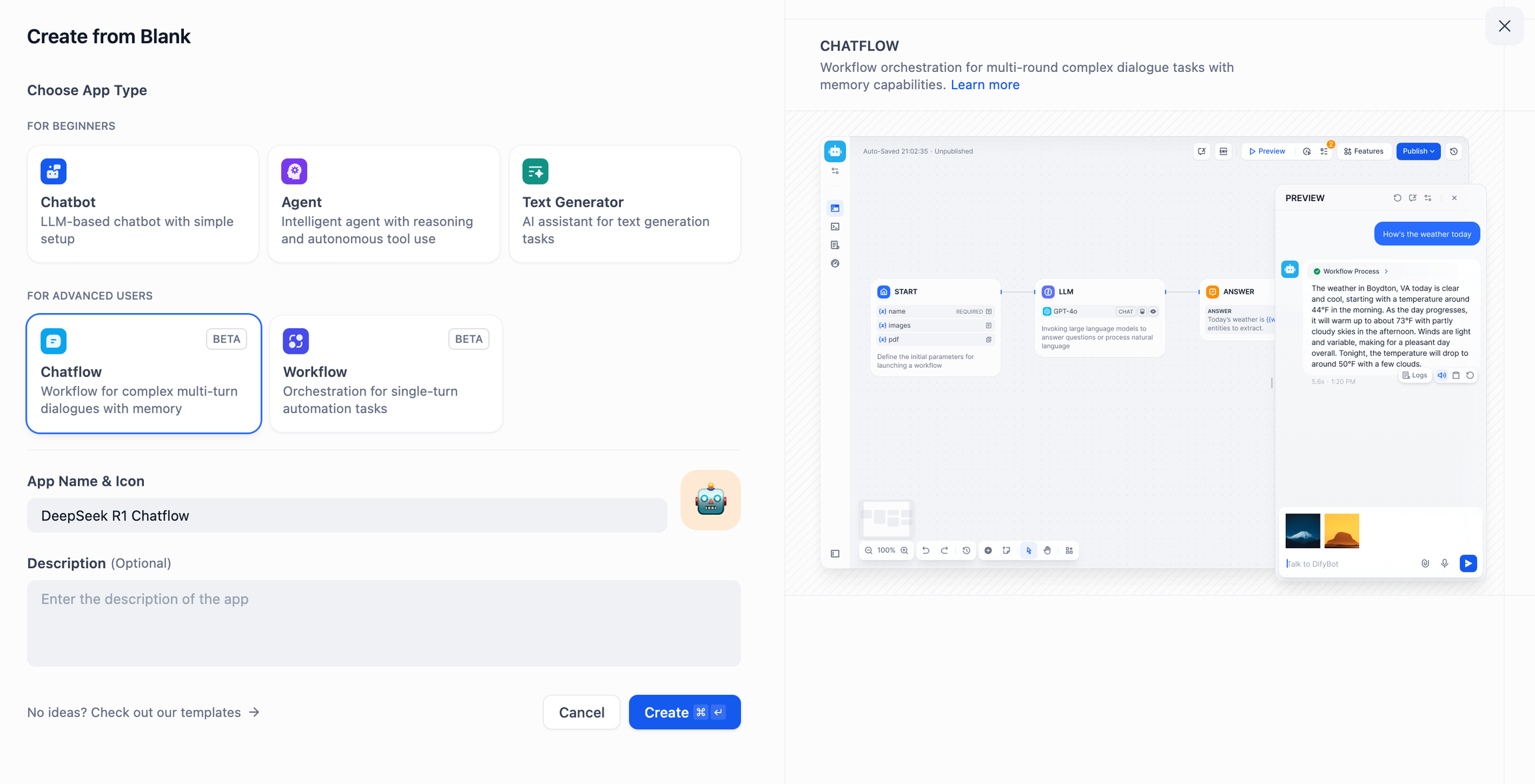

- Appuyez sur "Create a Blank App" sur le côté gauche de la page d'accueil de la plateforme Dify, sélectionnez une application de type "Chatflow" ou "Workflow" et donnez-lui un nom simple.

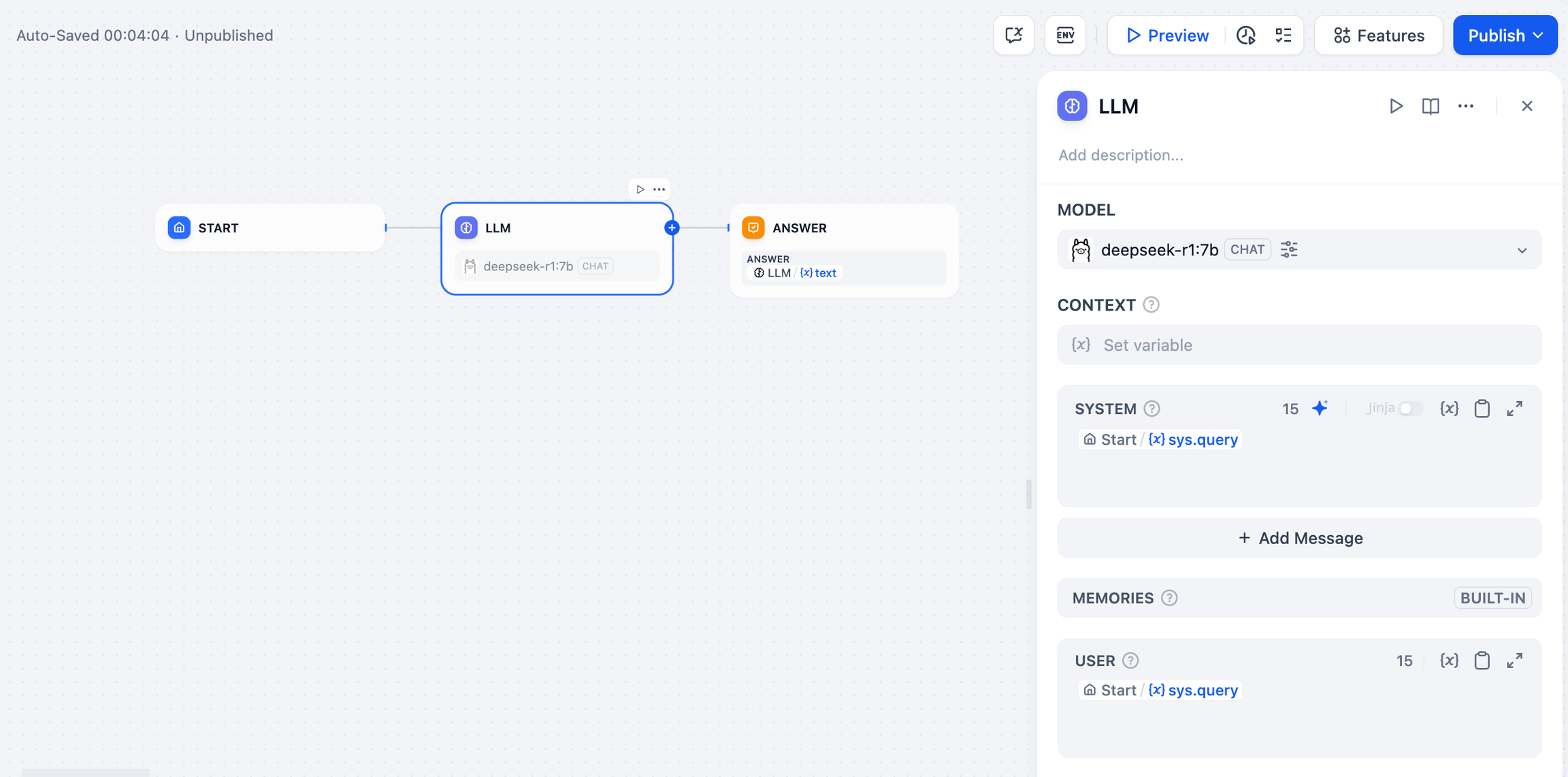

- Pour ajouter un nœud LLM, sélectionnez le cadre Ollama dans la liste des nœuds LLM.

deepseek-r1:7bet ajouter le mot-clé du système dans le{{#sys.query#}}pour connecter le nœud de départ.

- Ajoutez le nœud final pour terminer la configuration. Vous pouvez saisir du contenu dans la boîte de prévisualisation à des fins de test. La génération d'une réponse signifie que la construction de l'application AI est terminée.

problèmes courants

1. erreurs de connexion lors du déploiement de Docker

Les erreurs suivantes peuvent être rencontrées lors du déploiement de Dify et Ollama avec Docker :

httpconnectionpool(host=127.0.0.1,port=11434): max retries exceeded with url:/cpi/chat

(CausedbyNewConnectionError('<urllib3.connection.HTTPConnection object at 0x7f8562812c20>:

fail to establish a new connection:[Errno 111] Connection refused'))

httpconnectionpool(host=localhost,port=11434): max retries exceeded with url:/cpi/chat

(CausedbyNewConnectionError('<urllib3.connection.HTTPConnection object at 0x7f8562812c20>:

fail to establish a new connection:[Errno 111] Connection refused'))

Cause de l'erreur Localhost pointe généralement vers le conteneur lui-même, et non vers l'hôte ou un autre conteneur. Pour résoudre ce problème, vous devez exposer le service Ollama au réseau.

méthode de configuration de l'environnement macOS :

Si Ollama fonctionne comme une application macOS, vous devez définir les variables d'environnement à l'aide de launchctl :

- Pour ce faire, il suffit d'appeler la fonction

launchctl setenvDéfinition des variables d'environnement :

launchctlsetenvOLLAMA_HOST"0.0.0.0"

- Redémarrer l'application Ollama.

- Si les étapes ci-dessus ne fonctionnent pas, vous pouvez utiliser la méthode suivante :

Le problème est qu'à l'intérieur de Docker, vous devez vous connecter au serveur host.docker.internalpour accéder à l'hôte du docker, il faut donc définir l'option localhost Remplacer par host.docker.internal Le service est prêt à prendre effet :

http://host.docker.internal:11434

Méthode de configuration de l'environnement Linux :

Si Ollama fonctionne en tant que service systemd, vous devez utiliser l'option systemctl Définition des variables d'environnement :

- Pour ce faire, il suffit d'appeler la fonction

systemctl edit ollama.serviceModifiez le service systemd. Cela ouvrira un éditeur. - Pour chaque variable d'environnement, la fonction

[Service]Ajouter une ligne sous la sectionEnvironment: :

[Service]

Environment="OLLAMA_HOST=0.0.0.0"

- Sauvegarder et quitter.

- charge lourde (sur un camion)

systemdet de relancer Ollama :

systemctldaemon-reload

systemctlrestartollama

Méthode de configuration de l'environnement Windows :

Sous Windows, Ollama hérite des variables d'environnement de l'utilisateur et du système.

- Tout d'abord, cliquez sur Ollama dans la barre des tâches pour quitter le programme.

- Modifier les variables d'environnement du système à partir du panneau de contrôle

- Modifiez ou créez de nouvelles variables pour votre compte d'utilisateur, telles que

OLLAMA_HOST,OLLAMA_MODELSetc. - Cliquez sur OK / Appliquer pour sauvegarder

- Exécuter dans une nouvelle fenêtre de terminal

ollama

2) Comment modifier l'adresse et le numéro de port du service Ollama ?

Ollama Default Binding 127.0.0.1 port 11434, auquel vous pouvez accéder par l'intermédiaire de la commande OLLAMA_HOST Les variables d'environnement modifient l'adresse de liaison.

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...