SILICONFLOW (Silicon Flow) : accélérer l'AGI pour l'humanité, en intégrant une interface libre pour les grands modèles.

Introduction générale

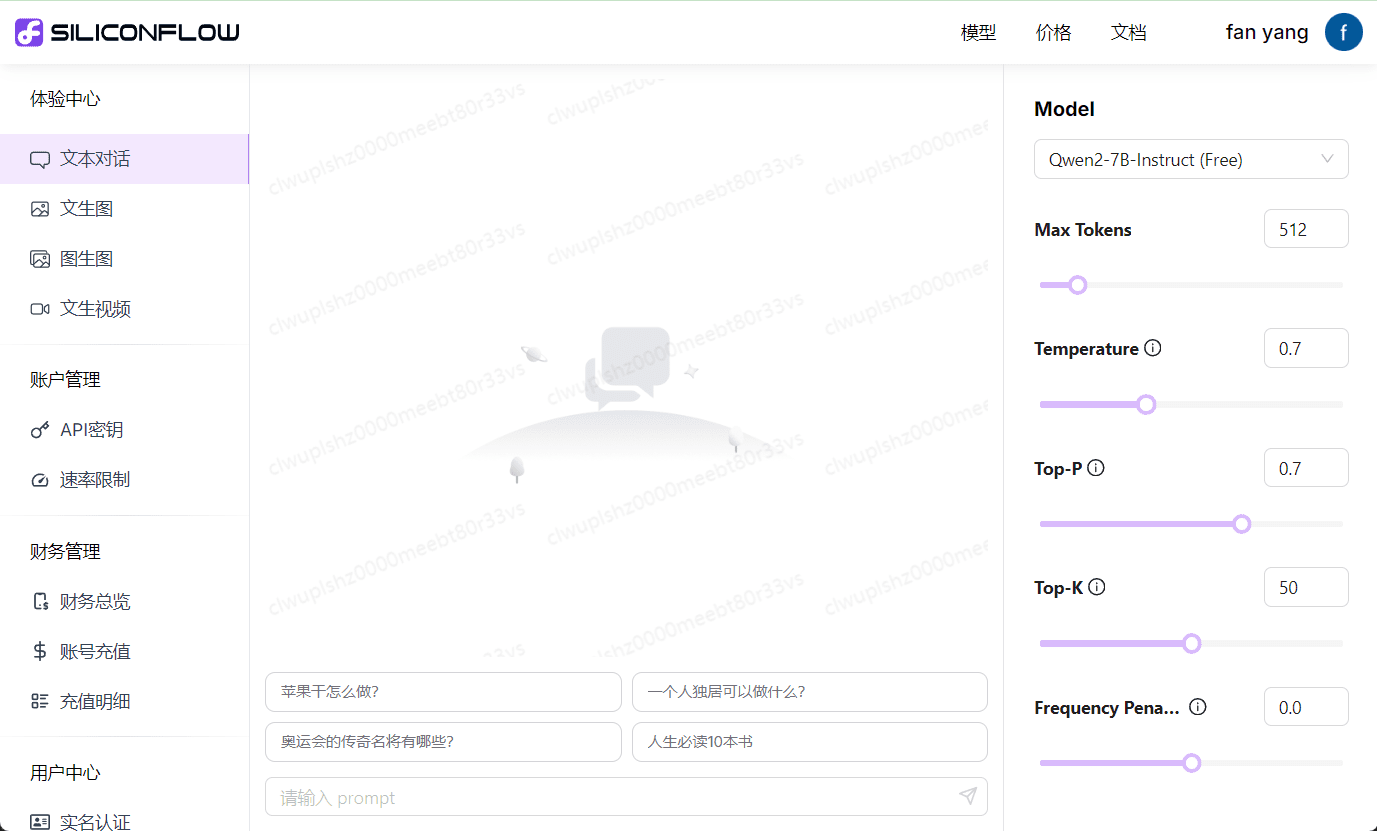

SiliconCloud fournit des services GenAI rentables basés sur d'excellents modèles de base open source.

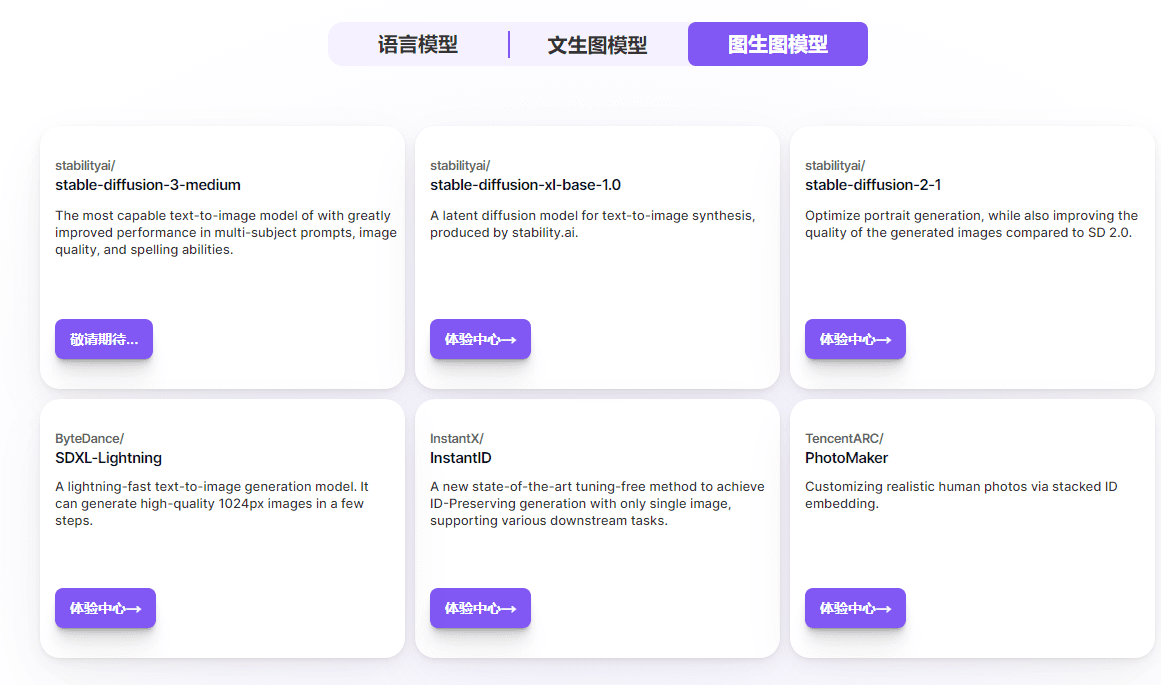

Contrairement à la plupart des plateformes de services en nuage de grands modèles qui ne fournissent que leurs propres API de grands modèles, SiliconCloud dispose d'une large gamme de grands modèles linguistiques et de modèles de génération d'images open source, notamment Qwen, DeepSeek, GLM, Yi, Mistral, LLaMA 3, SDXL et InstantID, ce qui permet aux utilisateurs de passer librement d'un modèle à l'autre en fonction des différents scénarios d'application. Les utilisateurs peuvent passer librement d'un modèle à l'autre en fonction des différents scénarios d'application.

De plus, SiliconCloud propose des services prêts à l'emploi d'accélération de l'inférence de grands modèles afin d'offrir une expérience utilisateur plus efficace à vos applications GenAI.

Pour les développeurs, SiliconCloud offre un accès en un clic aux meilleurs modèles open source. Cela permet aux développeurs de bénéficier d'une plus grande rapidité et d'une meilleure expérience dans le développement d'applications, tout en réduisant de manière significative le coût des essais et des erreurs dans le développement d'applications.

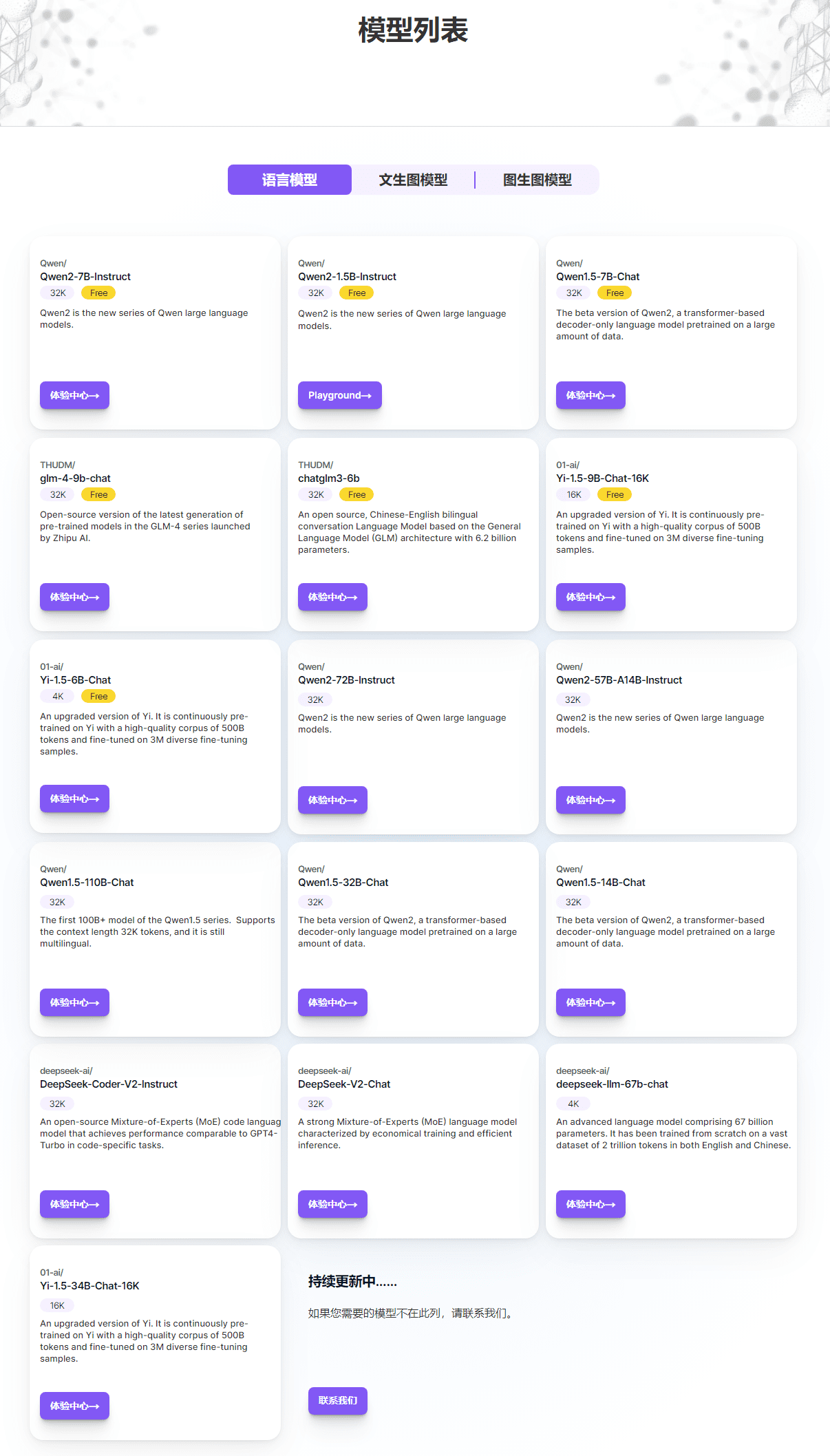

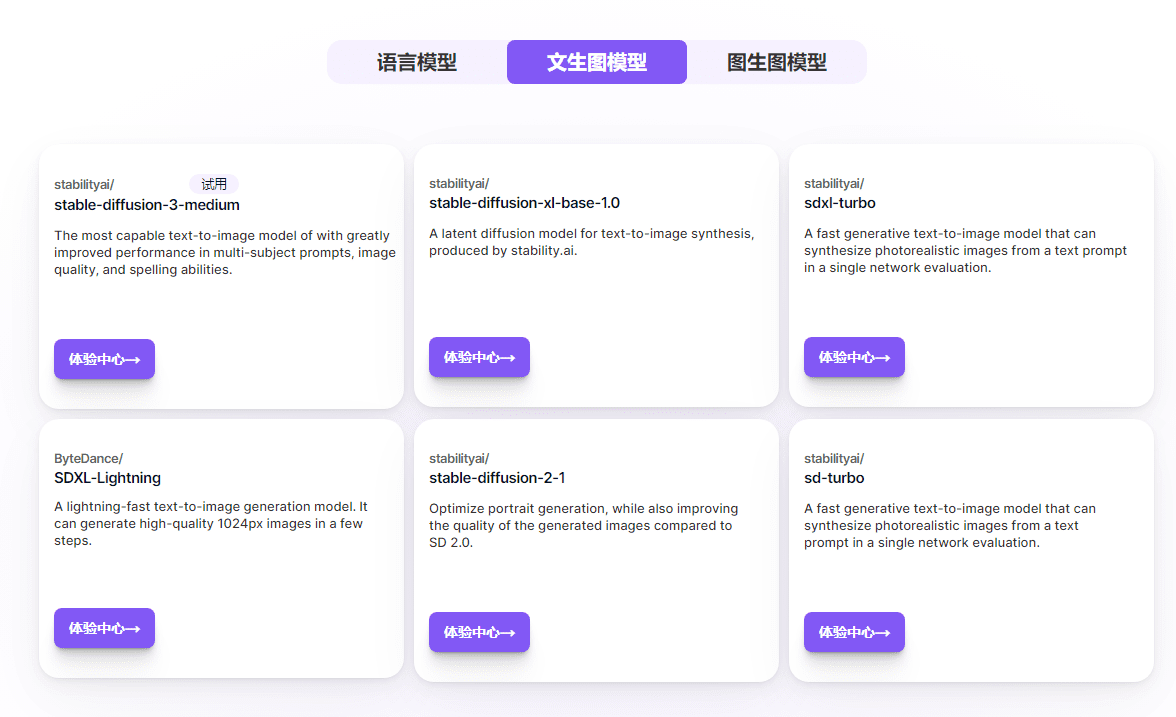

Sur la page Modèles SiliconCloud, vous pouvez consulter les modèles linguistiques, les modèles texte-graphe et les modèles graphique-graphe que nous prenons actuellement en charge, et cliquer sur "Centre d'expérience" pour tester les modèles en action.

Portail d'enregistrement des récompenses de 20 millions de tokens de Silicon Mobility

Liste des modèles

Liste de modèles gratuits

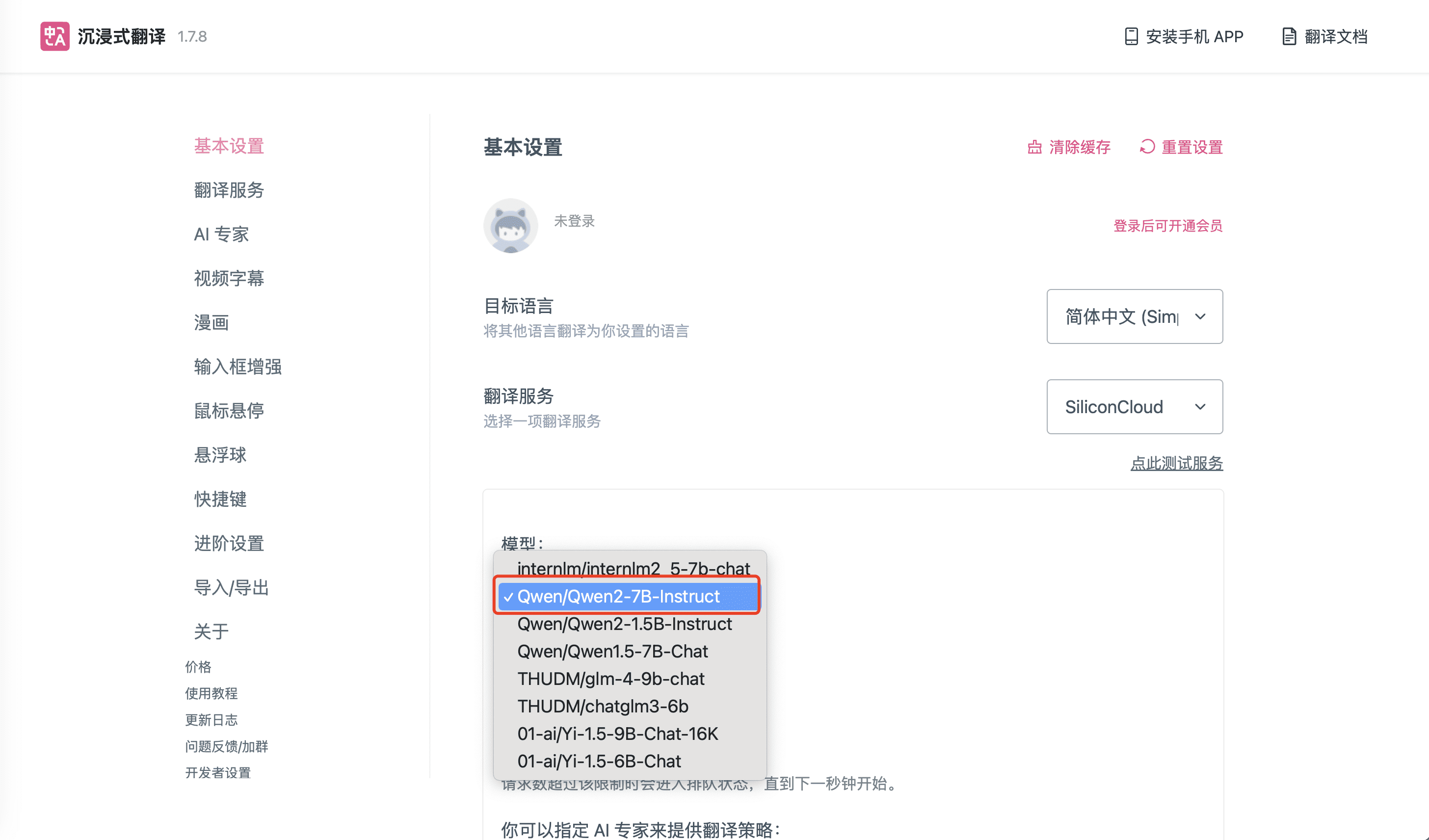

| Qwen/Qwen2-7B-Instruct | 32K |

|---|---|

| Qwen/Qwen2-1.5B-Instruct | 32K |

| Qwen/Qwen1.5-7B-Chat | 32K |

| thudm/glm-4-9b-chat | 32K |

| THUDM/chatglm3-6b | 32K |

| 01-ai/Yi-1.5-9B-Chat-16K | 16K |

| 01-ai/Yi-1.5-6B-Chat | 4K |

| google/gemma-2-9b-it | 8K |

| internlm/internlm2_5-7b-chat | 32K |

| meta-llama/Meta-Llama-3-8B-Instruct | 8K |

| meta-llama/Meta-Llama-3.1-8B-Instruct | 8K |

| mistralai/Mistral-7B-Instruct-v0.2 | 32K |

Utiliser l'API SiliconCloud

URL de base : https://api.siliconflow.cn/v1

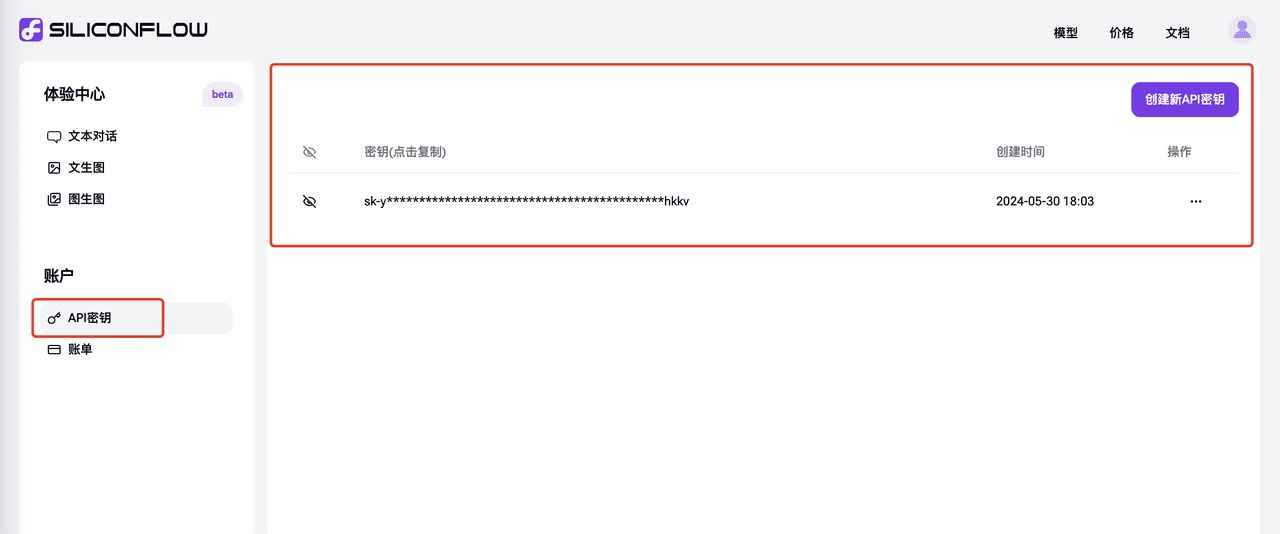

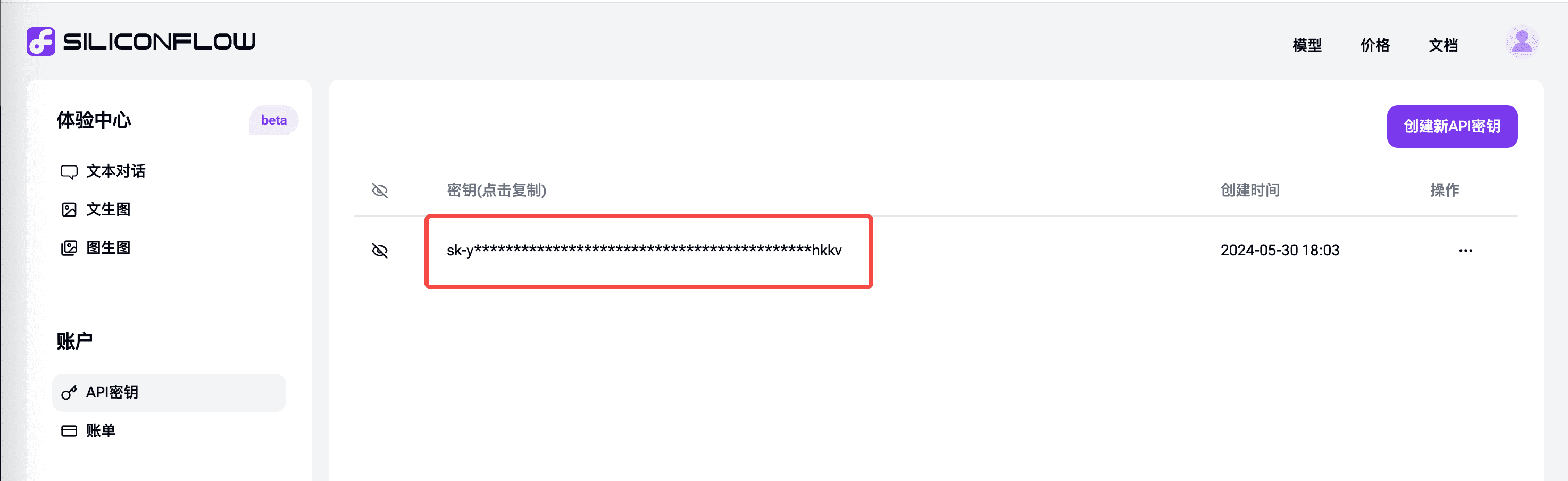

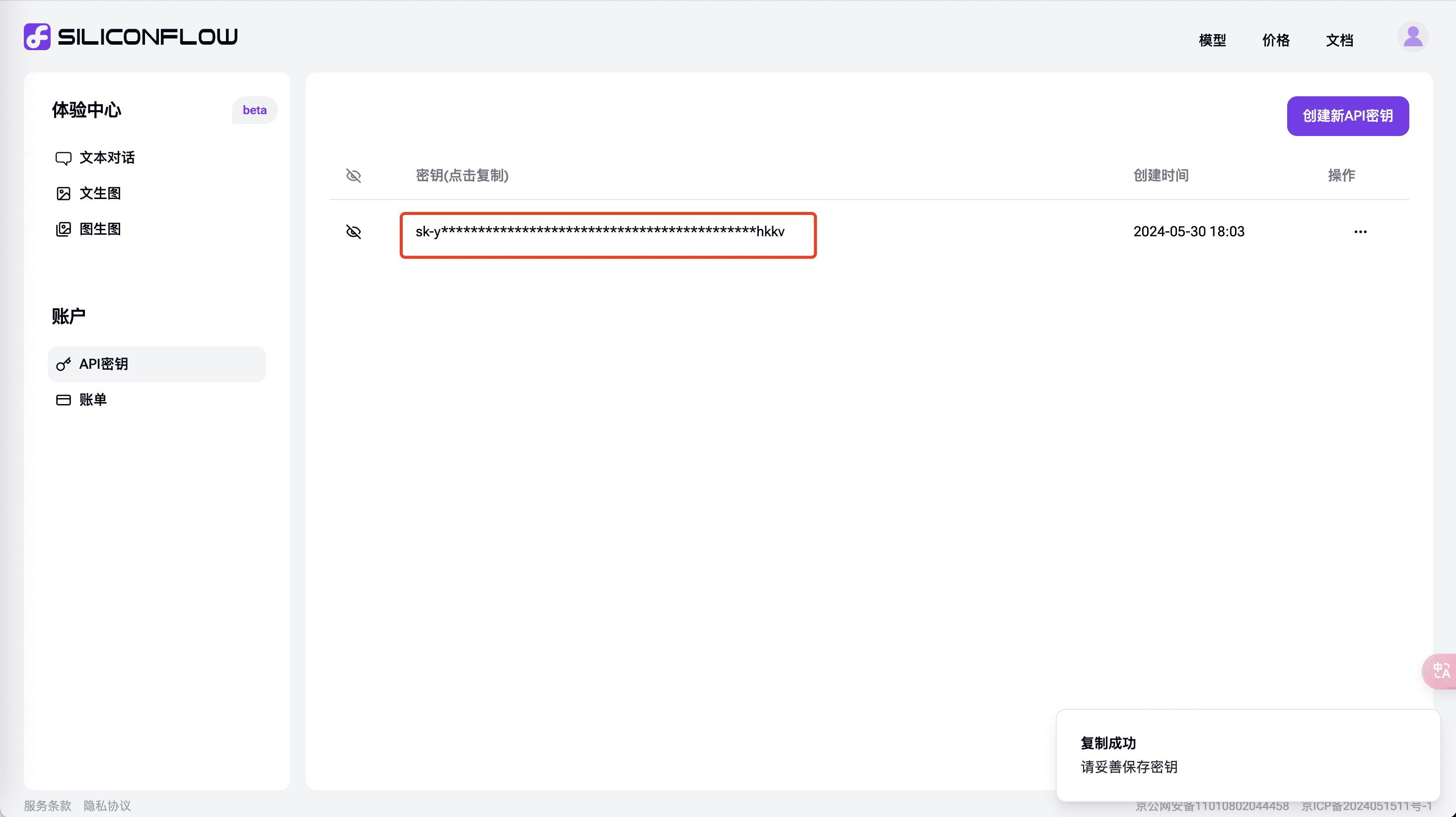

Générer une clé API

Dans l'onglet "Clé API Cliquez sur Créer une nouvelle clé API et sur Copier pour l'utiliser dans votre scénario API.

Utilisation de l'API SiliconCloud dans la traduction immersive

Utiliser les capacités de l'API de SiliconCloud pour obtenir une traduction multilingue rapide dans le cadre d'une traduction immersive.

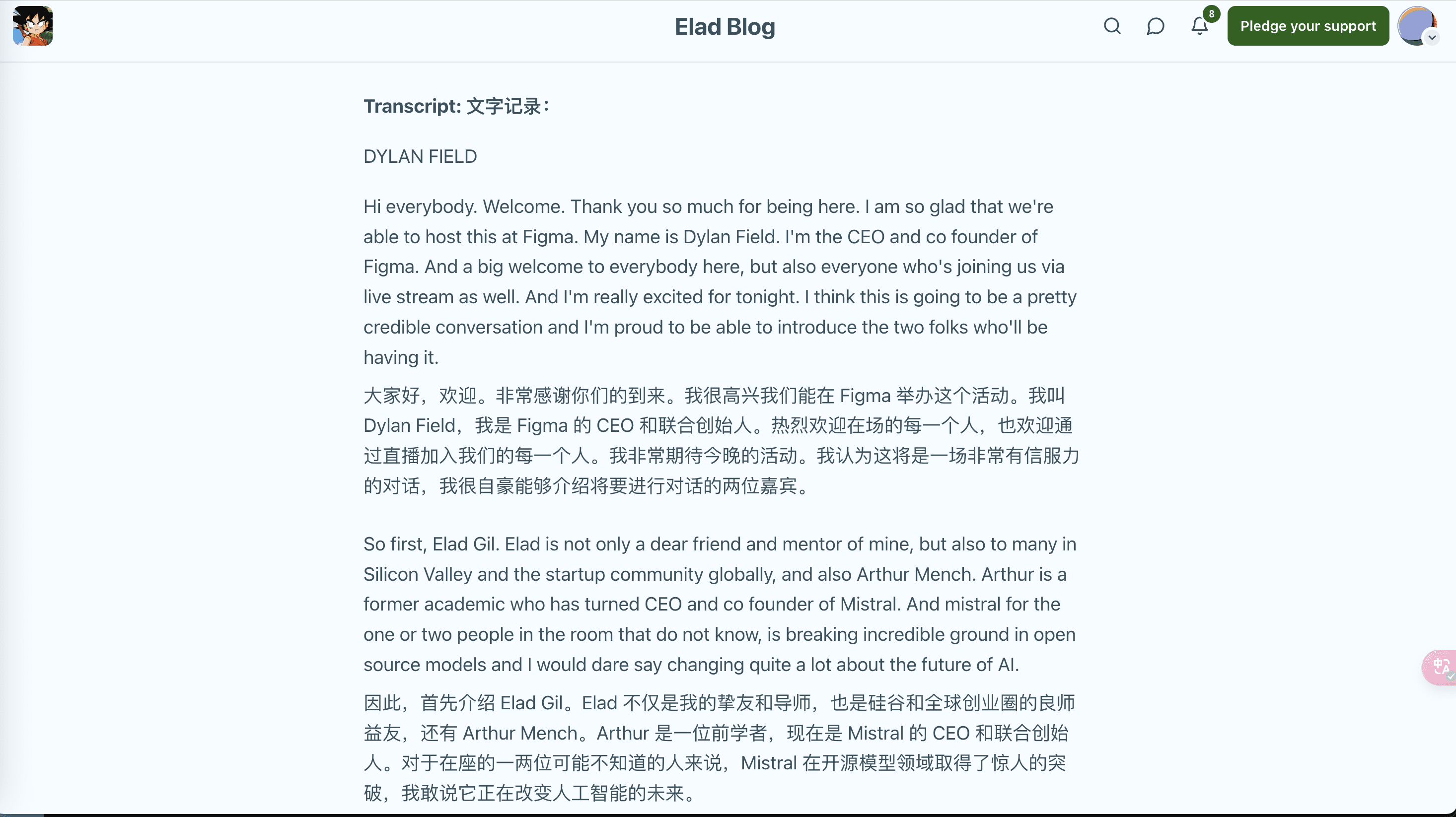

En tant que plugin de traduction bilingue de pages web jouissant d'une réputation explosive en ligne, Immersive Translation combine la capacité de compréhension interlinguistique du Big Language Model pour traduire le contenu en langue étrangère en temps réel, ce qui peut être appliqué à la lecture de pages web, à la traduction de PDF, à la traduction de livres électroniques EPUB, à la traduction de sous-titres vidéo bilingues et à d'autres scénarios, et prend en charge l'utilisation d'une variété de plugins de navigateur et d'applis. Depuis son lancement en 2023, cette extension de traduction de pages web bilingues par l'IA a aidé plus d'un million d'utilisateurs à franchir la barrière de la langue et à s'inspirer librement de la sagesse mondiale.

SiliconCloud de SiliconFlow a récemment été le premier à fournir une série de grands modèles tels que GLM4, Qwen2, DeepSeek V2, Yi, etc. Comment ces deux éléments peuvent-ils être combinés pour améliorer les capacités dans les scénarios de traduction immersive ?

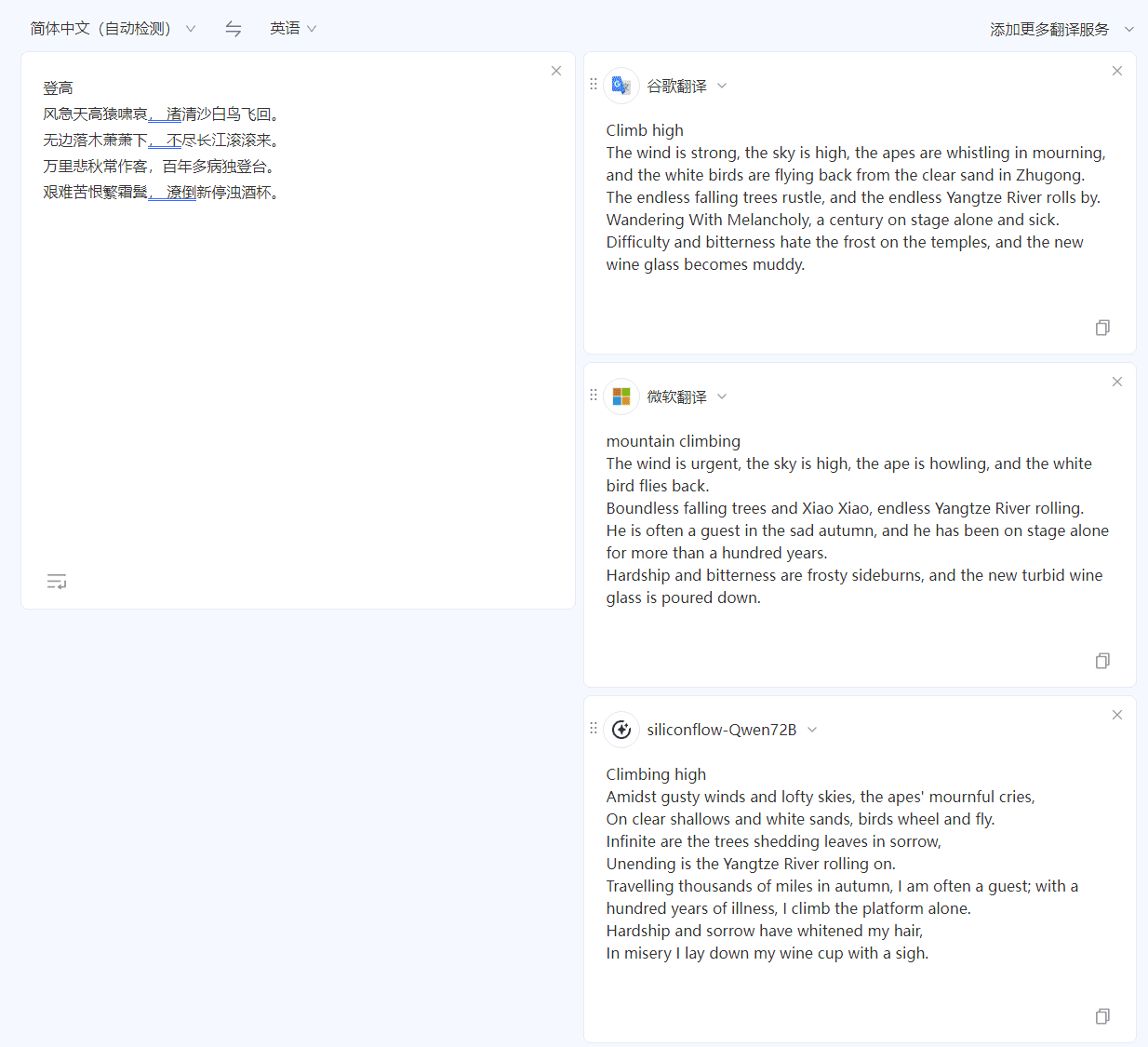

Examiner d'abord l'efficacité du traitement

Prenons l'exemple d'une traduction familière chinois-anglais. En utilisant le classique "Ascending Heights" de Du Fu pour le test "chinois-anglais", comparé à Google Translate et Microsoft Translate, le modèle QWen 72B fourni par Silicon Mobility offre une compréhension plus authentique de la langue chinoise, et la traduction est également plus proche du style du texte original.

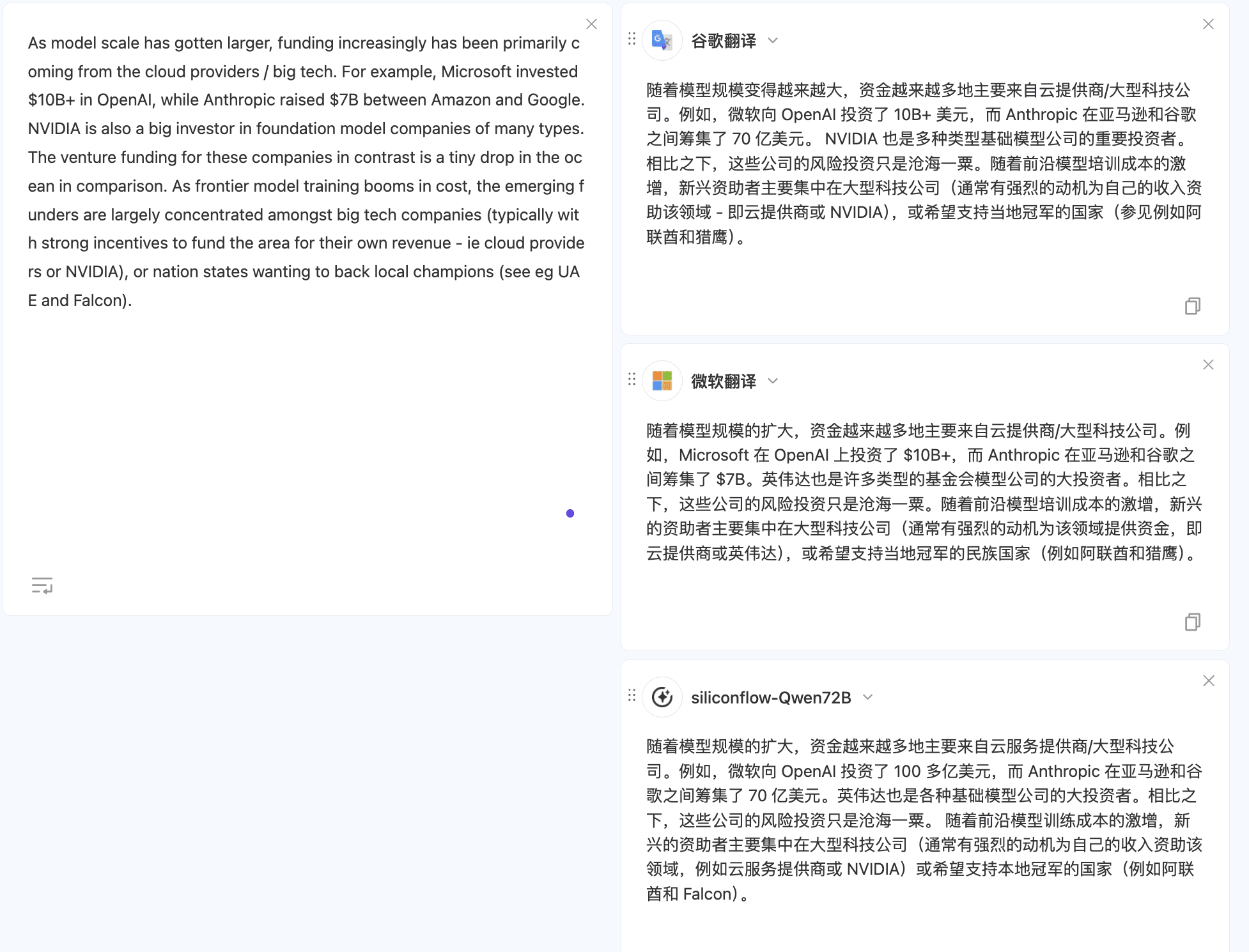

Le modèle fourni par Silicon Mobility donne également de meilleurs résultats dans la traduction du même texte de l'anglais vers le chinois, avec des traductions plus fluides.

Pour essayer d'autres scénarios, il suffit d'utiliserComparaison multi-modèle de documents traduits La configuration des modèles liés à SiliconCloud est détaillée dans la section "Procédure de configuration".

Procédure de configuration : configuration par défaut

- Sélectionnez "Install Browser Plug-in" sur le site web d'Immersive Translation et suivez les instructions. Si vous avez déjà installé le plug-in correspondant, veuillez sauter cette étape.

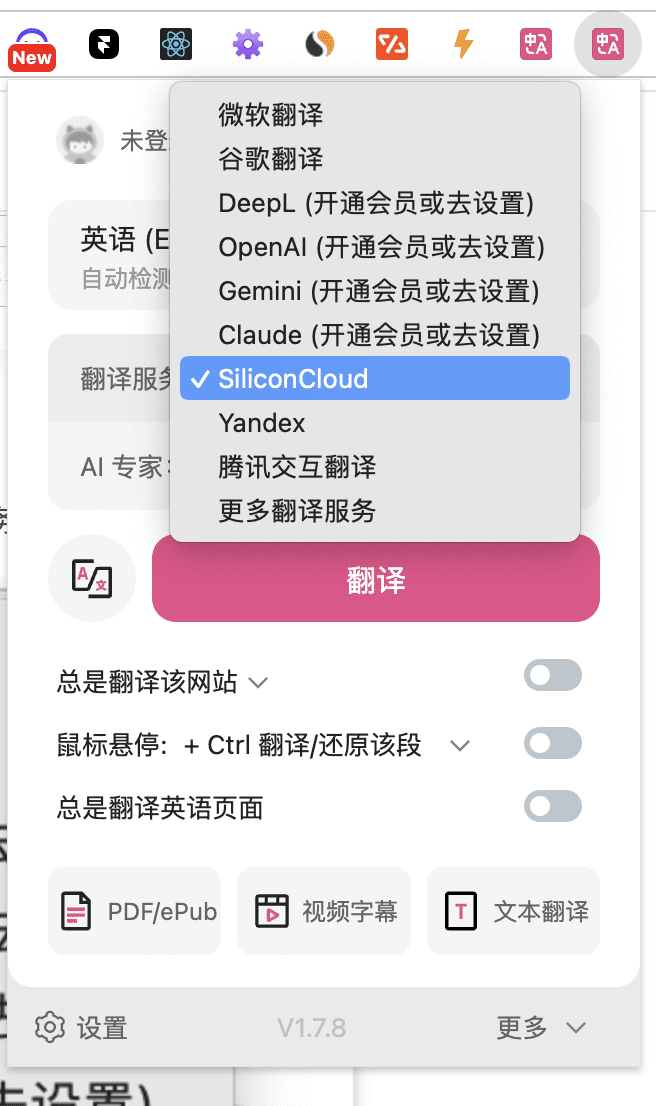

- Réglez "Service de traduction" sur "SiliconCloud" dans l'icône de traduction immersive pour utiliser le service de traduction de SiliconCloud.

Les paramètres ci-dessus sont les paramètres par défaut.

Sélectionnez d'autres modèles gratuits de SiliconCloud en dehors des paramètres par défaut :

- Le modèle par défaut dans les réglages ci-dessus est "Qwen/Qwen2-7B-Instruct" de SiliconCloud, si vous avez besoin de passer à d'autres modèles SiliconCloud, cliquez sur "Settings" dans l'icône ci-dessus. Si vous souhaitez passer à d'autres modèles SiliconCloud, cliquez sur "Settings" dans l'icône ci-dessus pour effectuer les réglages relatifs à SiliconCloud.

Sélectionnez d'autres modèles de taille pour SiliconCloud en dehors des paramètres par défaut :

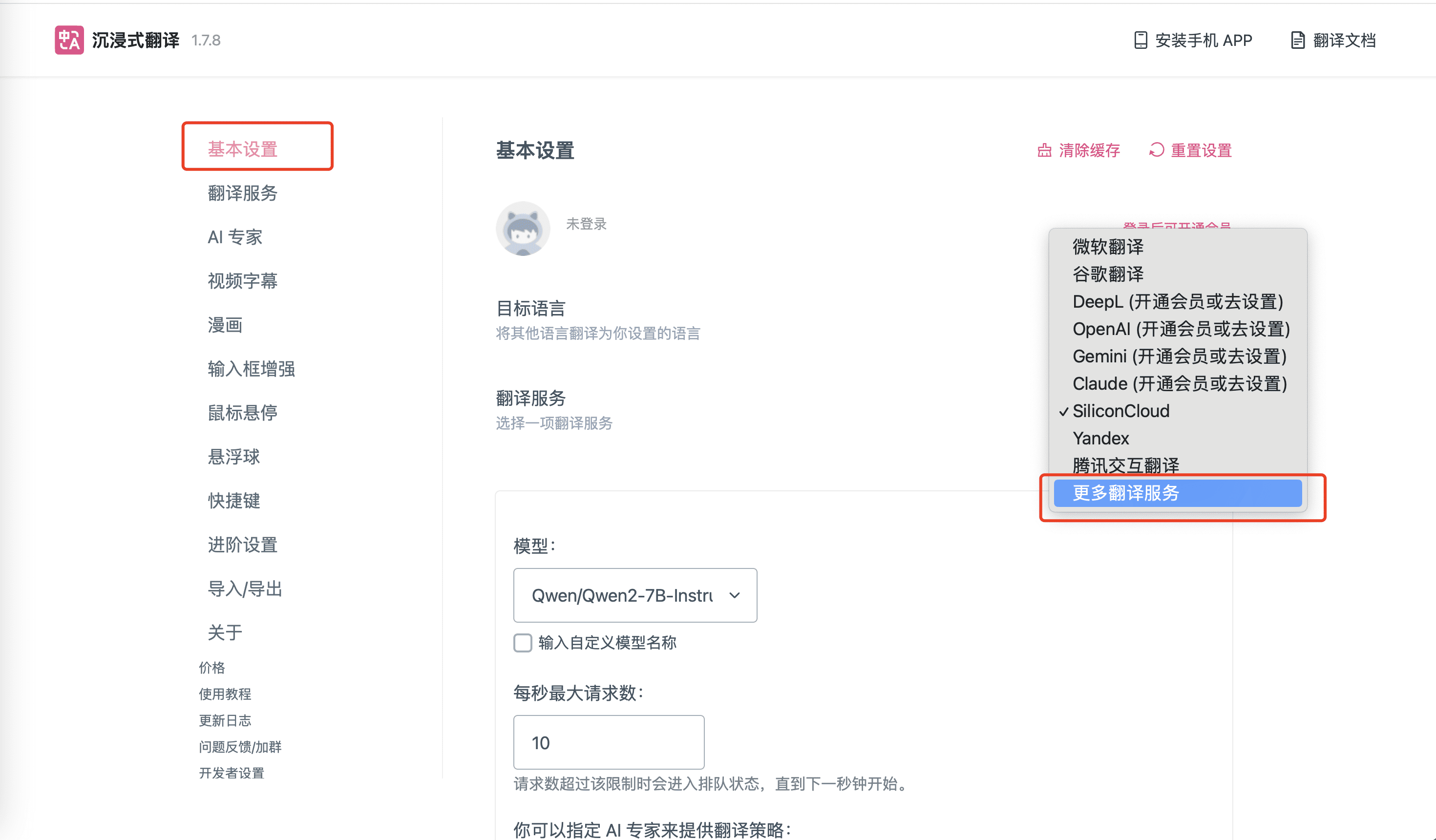

- Si vous avez besoin d'utiliser d'autres modèles SiliconCloud que les 8 modèles ci-dessus, cliquez sur l'icône de l'extension Immersive Translation et trouvez l'option "Settings" correspondante, comme indiqué dans la figure ci-dessous, et sélectionnez "More Translation Services".

- Ajoutez-y des informations sur le modèle SiliconCloud !

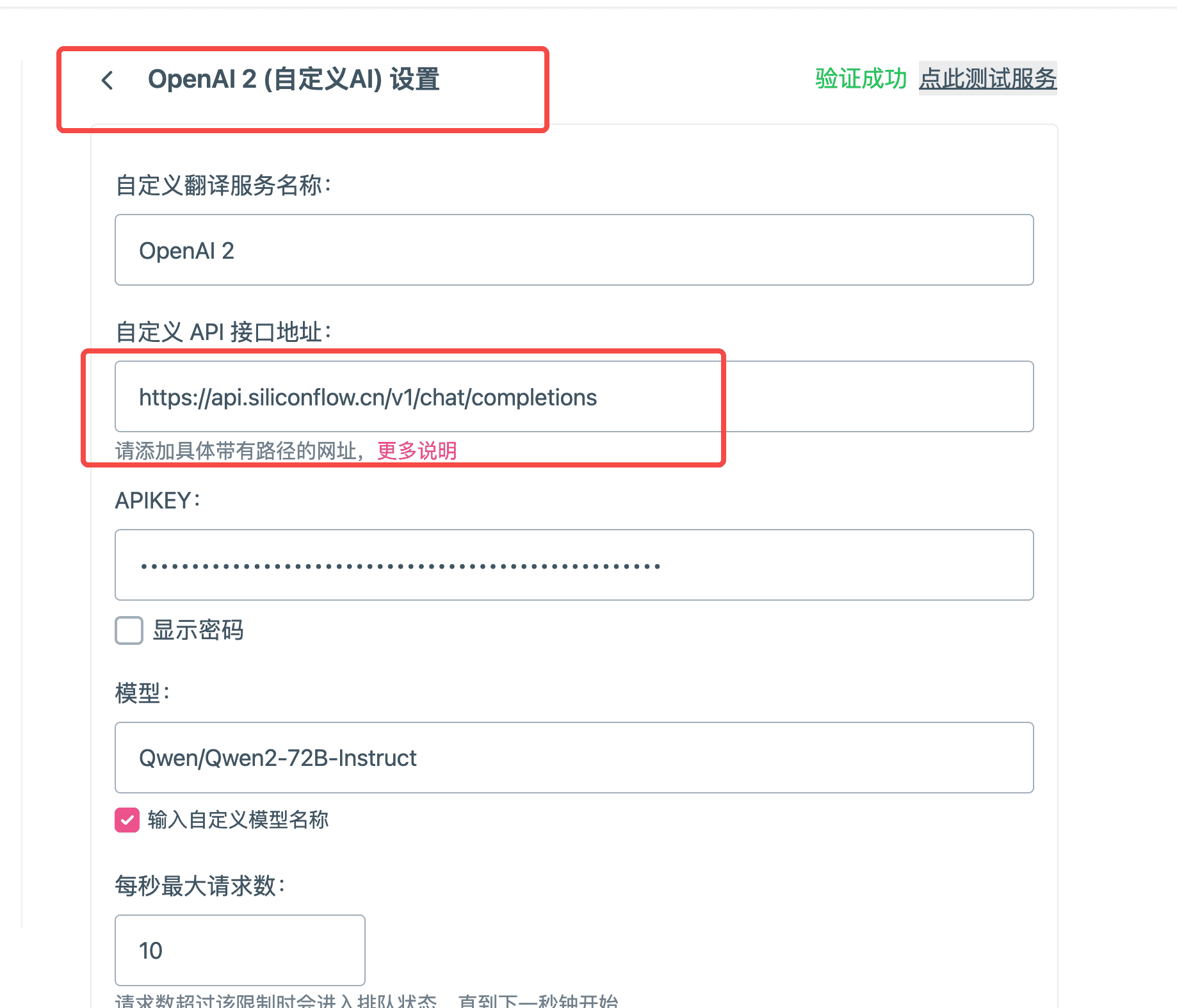

- Nom du service de traduction personnalisé : il suffit d'indiquer le nom en fonction de votre situation réelle, ici nous indiquons "Qwen/Qwen2-72B-Instruct".

- Adresse de l'interface API personnalisée :

- Adresse API :https://api.siliconflow.cn/v1/chat/completions

- Pour en savoir plus, vous pouvez consulterhttps://docs.siliconflow.cn/reference/chat-completions-1

APIKEY : DeClé API Cliquez sur Copier sur dans la fenêtre

- Nom du modèle : le nom du modèle dans Siliconcloud, ici "Qwen/Qwen2-72B-Instruct", il peut être utilisé.Liste des modèles de plates-formesObtenir les noms de tous les modèles actuellement pris en charge.

- Vérifiez que le test a réussi en cliquant sur Test dans le coin supérieur droit.

- Maintenant que vous avez complété les éléments de configuration du modèle, vous pouvez utiliser le grand modèle linguistique fourni par SiliconCloud pour fournir des traductions dans le plugin Immersive Translator.

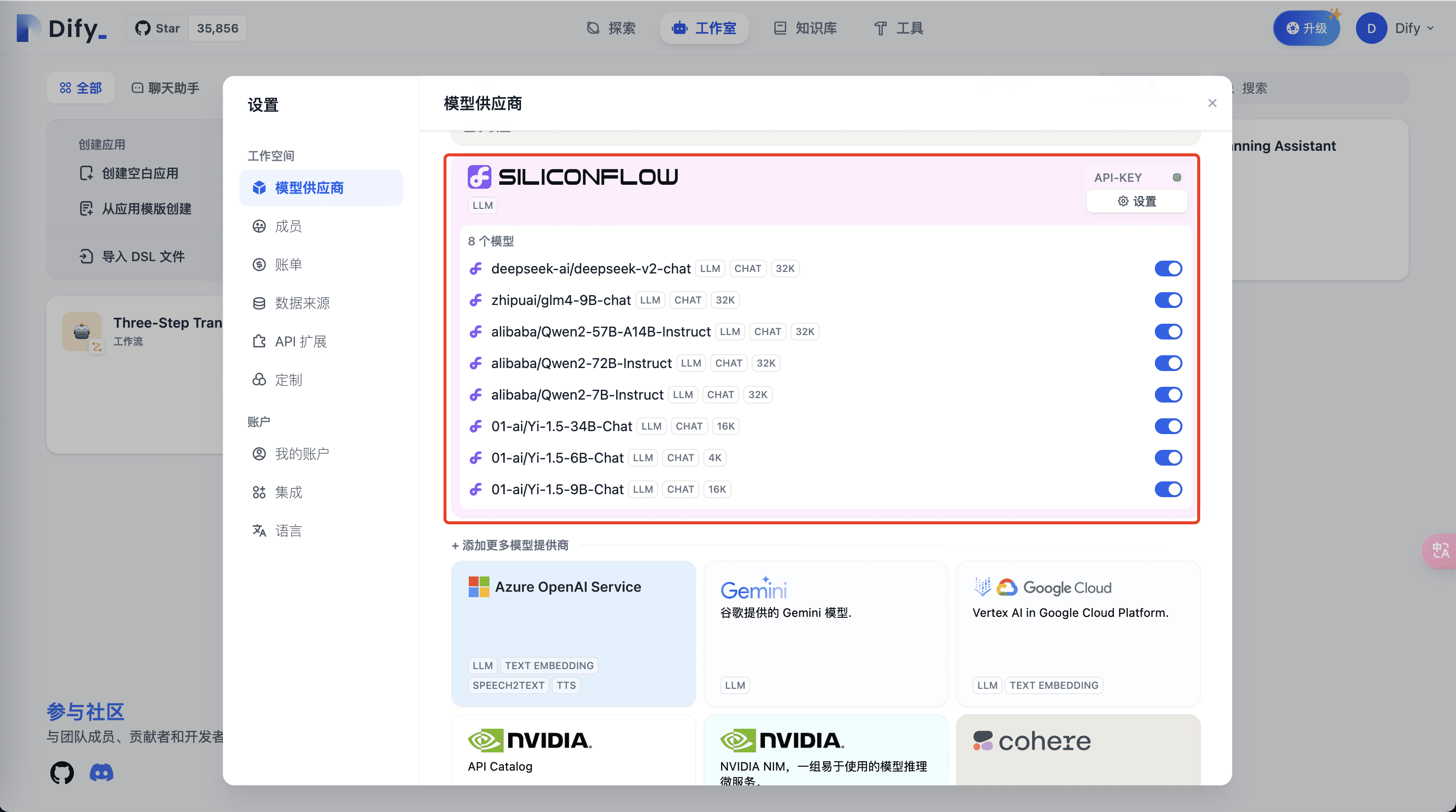

Utilisation de l'API SiliconCloud dans dedify

utiliser dify pour le modèle SiliconCloud intégré dans le logiciel

En tant qu'utilisateur fréquent de flux de travail divers, SiliconCloud fournit les derniers modèles tels que GLM4, Qwen2, DeepSeek V2, Yi, etc. dès la première fois et les modèles sont très rapides, ce qui doit être la première fois à s'amarrer !

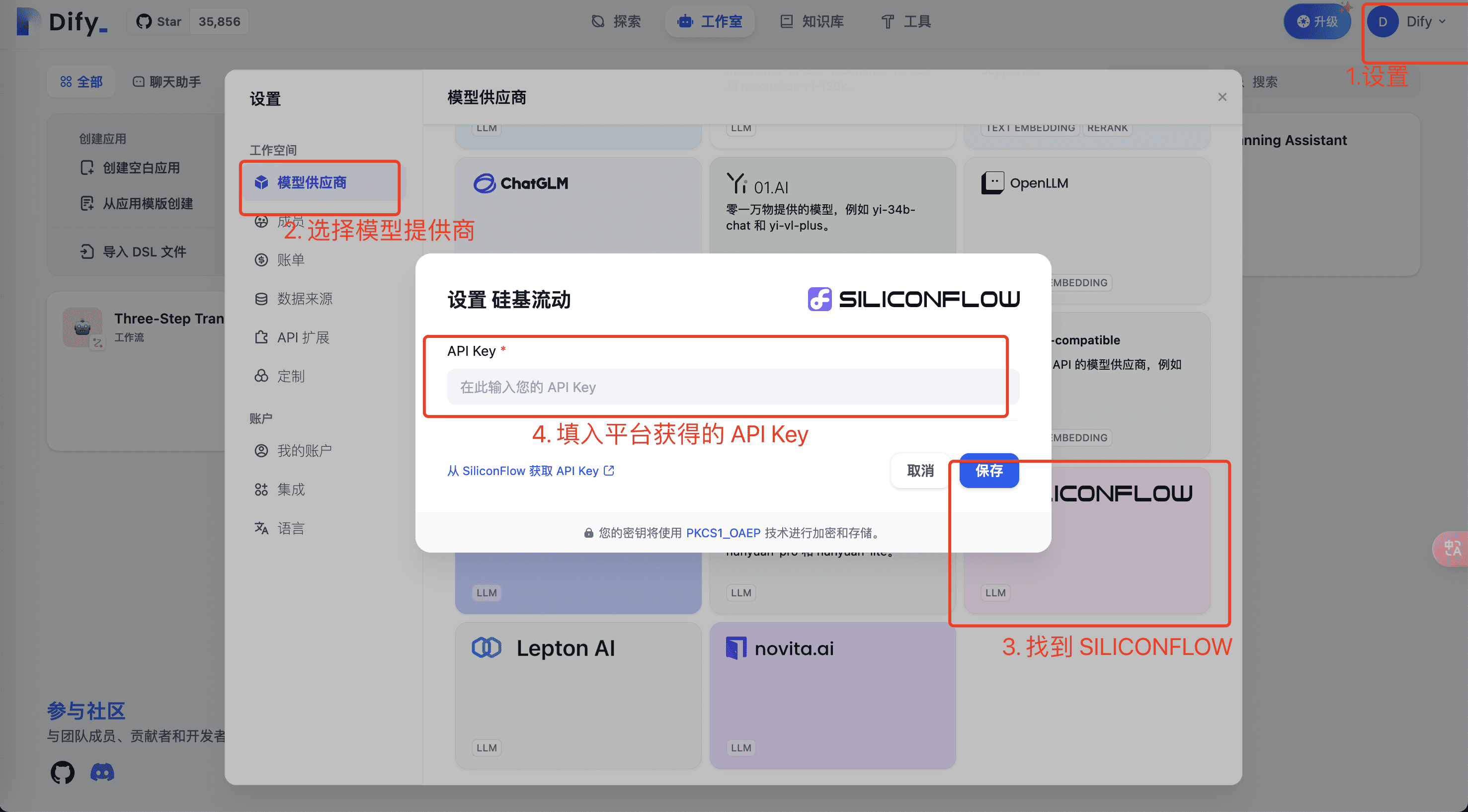

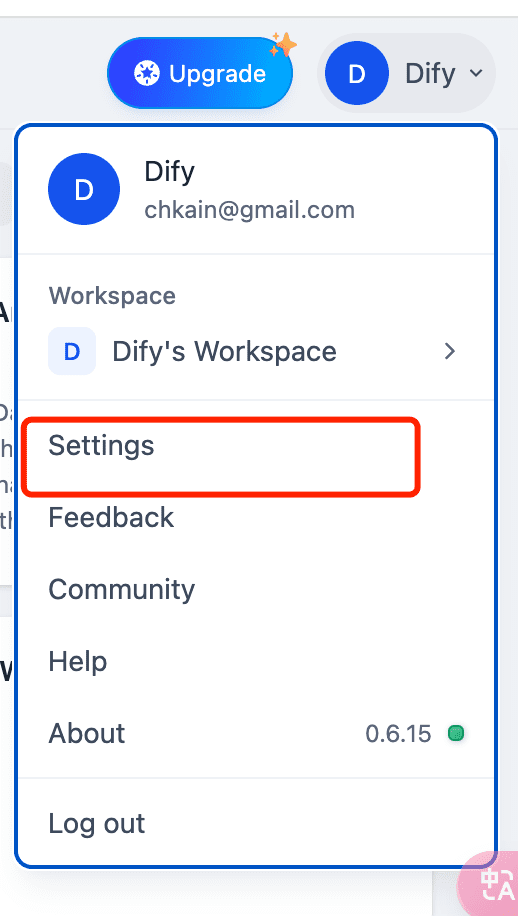

- Dans Setup, définissez le modèle et la clé API de votre compte de la plateforme SiliconCloud pour configurer le grand modèle.

- Remplissez les informations relatives au modèle et à la clé API de la plateforme SiliconCloud et cliquez sur Enregistrer pour vérifier. Utiliser leClé APIK de SiliconCloudObtenir la clé API de l'utilisateur actuel et la copier dans l'environnement ci-dessus.

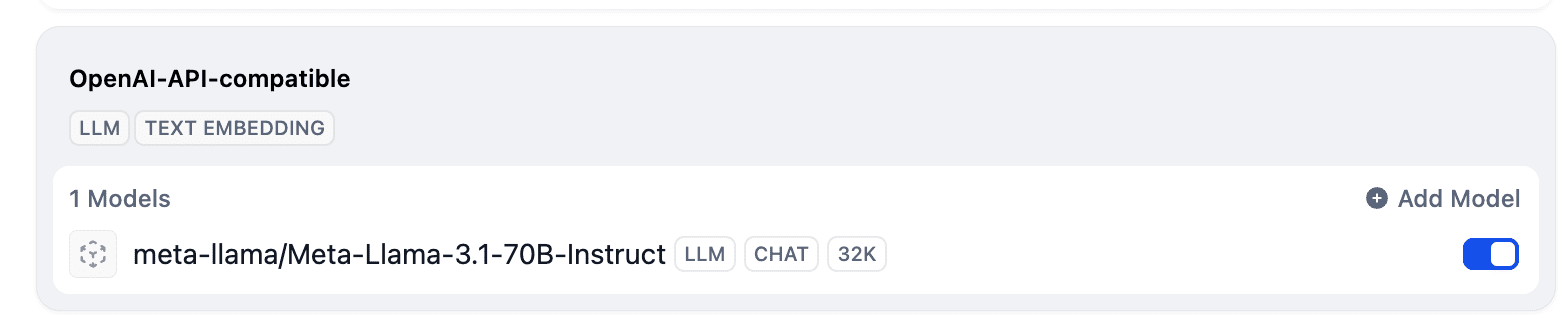

- Ensuite, vous pouvez voir les modèles liés à SiliconFlow dans la zone supérieure du fournisseur de modèles.

- Utilisation des modèles de correspondants SiliconCloud dans les applications

Après ces étapes, vous êtes prêt à utiliser les modèles LLM riches et rapides fournis par SiliconFlow dans vos applications de développement Dify.

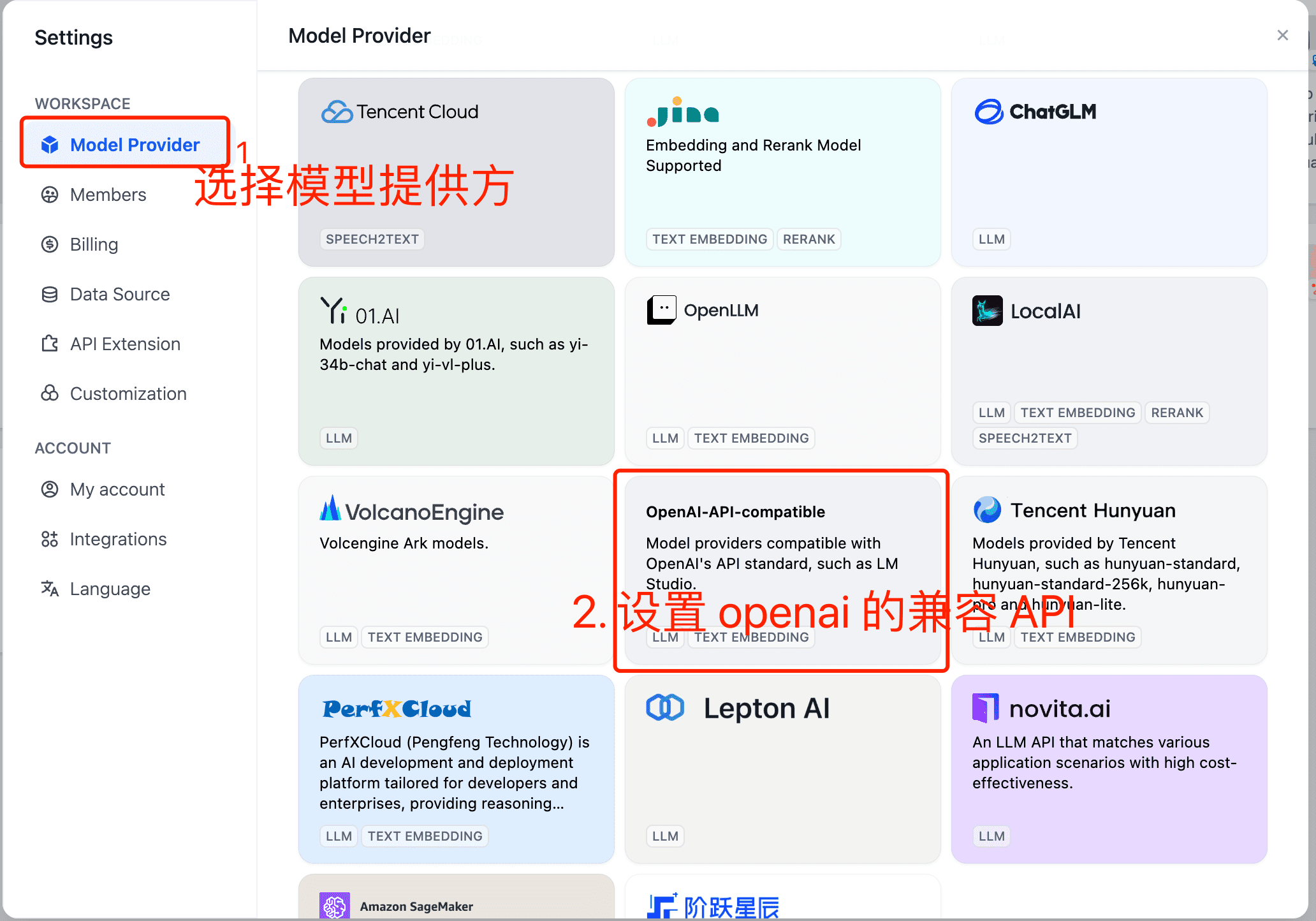

Les modèles SiliconCloud ne figurent pas actuellement dans le code source dify

À l'heure actuelle, de nouveaux modèles sont encore introduits dans SiliconCloud, en raison du rythme itératif des deux parties, certains modèles ne peuvent pas être présentés dans Dify dès la première fois, et nous les mettons en place selon le processus suivant.

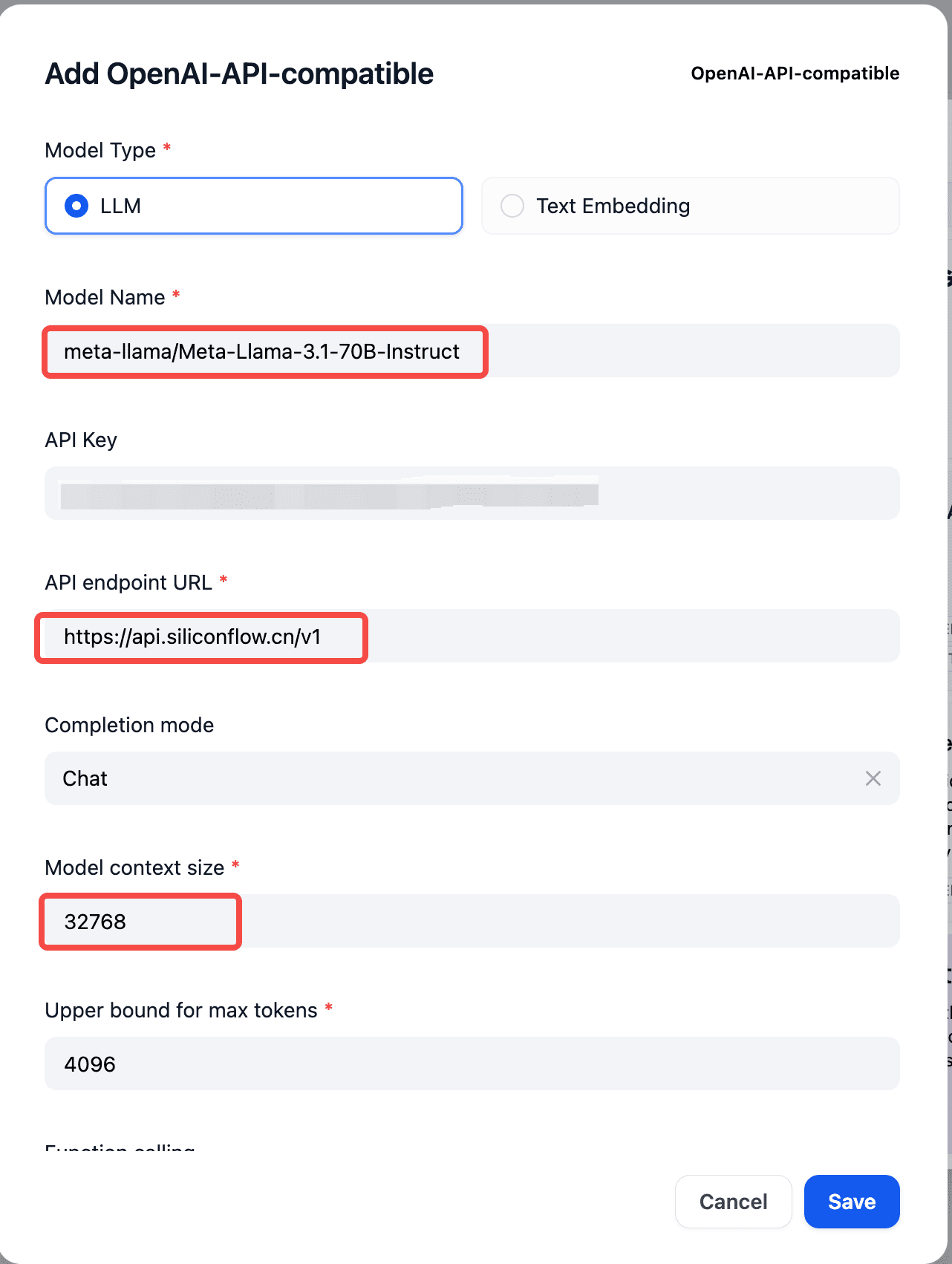

- Ouvrez les paramètres de l'appareil pour le régler.

- Sélectionnez le fournisseur de modèle dans les paramètres et définissez "openai compatible API".

- Définissez le nom du modèle SiliconCloud correspondant, la clé API, le point d'arrivée API dans le champ

Nom du modèle : dehttps://docs.siliconflow.cn/reference/chat-completions-1 Regardez dans le document.

Clé API : dehttps://cloud.siliconflow.cn/account/ak Veuillez noter que si vous utilisez un modèle étranger, vous devez vous conformer à la législation en vigueur.https://docs.siliconflow.cn/docs/use-international-outstanding-models Règles de documentation pour l'authentification par nom réel.

URL du point de terminaison de l'API :https://api.siliconflow.cn/v1

- Une fois la configuration terminée, vous pouvez voir les modèles ajoutés ci-dessus dans la liste des modèles.

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...