Qwen2.5-Coder Full Series : puissant, polyvalent et pratique.

bref

Aujourd'hui, nous sommes heureux d'ouvrir la famille de modèles Qwen2.5-Coder, puissante, diversifiée et utile, et nous nous engageons à poursuivre le développement des Open CodeLLM.

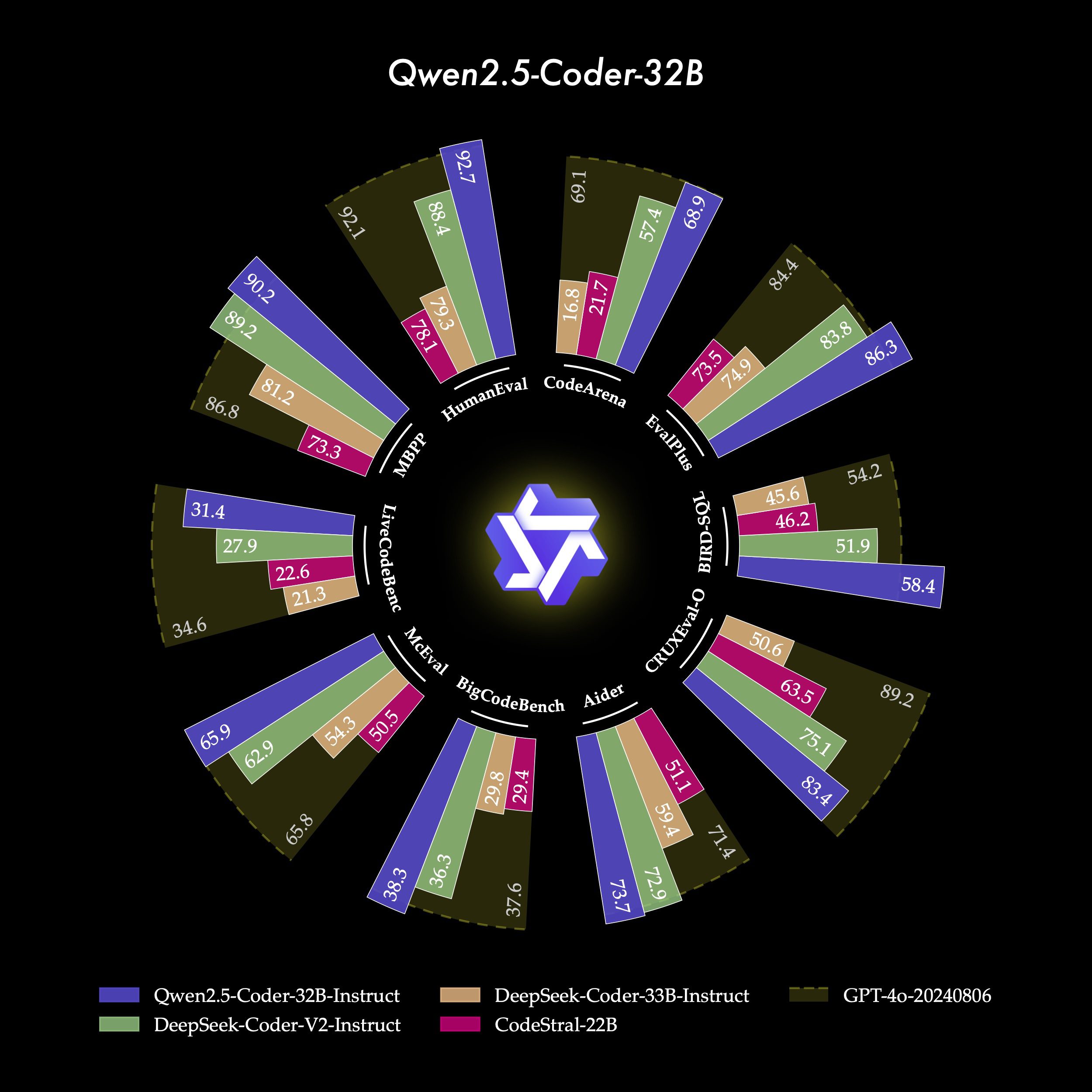

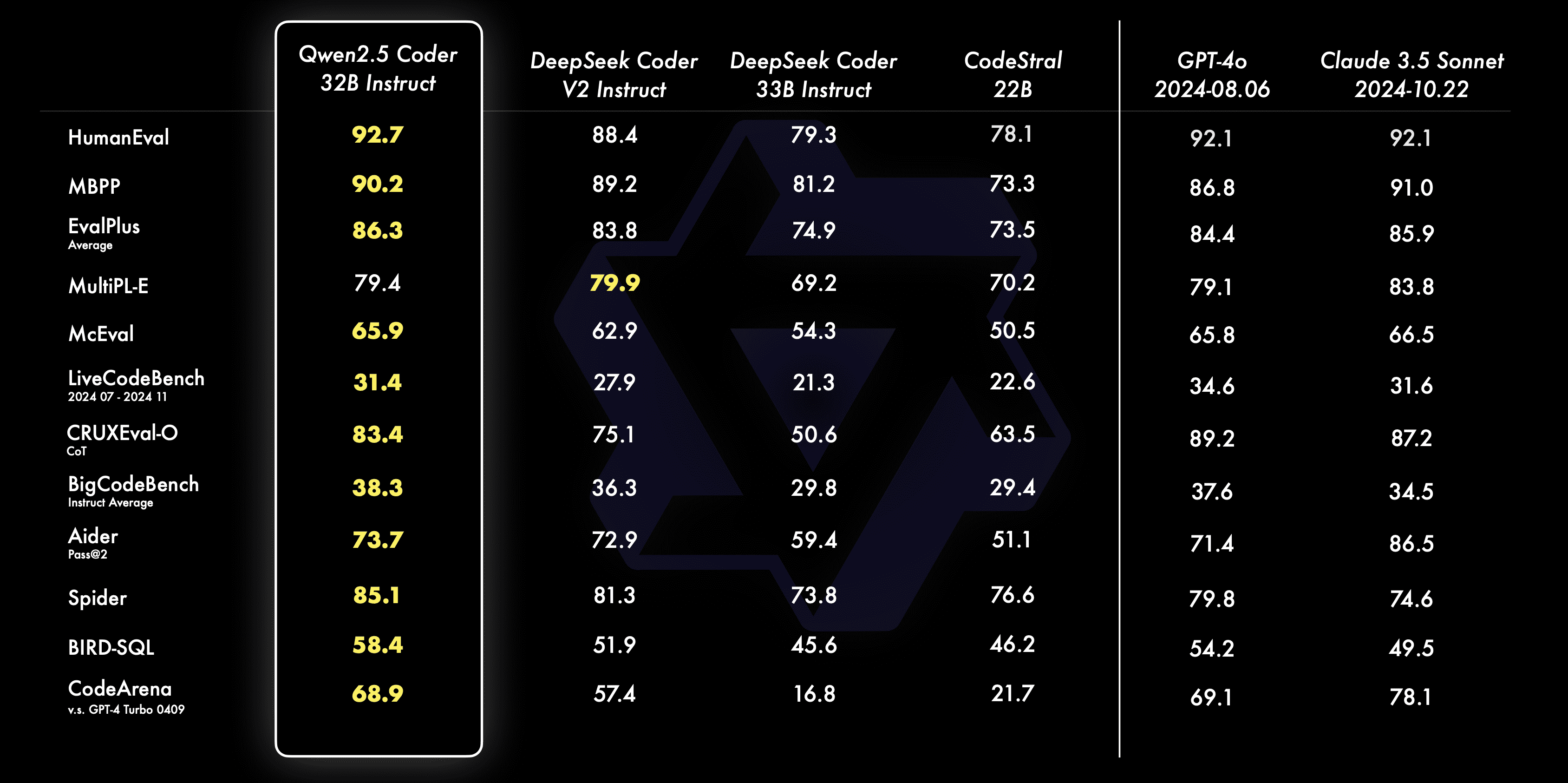

- formidableQwen2.5-Coder-32B-Instruct devient le modèle open-source actuel pour SOTA, avec des capacités de codage qui égalent celles de GPT-4o, démontrant des capacités de codage fortes et complètes, ainsi que de bonnes capacités générales et mathématiques.

- collecteurQwen2.5-Coder a couvert les six tailles de modèle principales pour répondre aux besoins des différents développeurs : le mois dernier, nous avons ouvert les tailles 1,5B et 7B, et cette fois-ci, nous avons ouvert les tailles 0,5B, 3B, 14B et 32B.

- pragmatiqueNous explorons l'utilité de Qwen2.5-Coder dans les scénarios de l'assistant de code et des artefacts, et nous utilisons quelques exemples pour démontrer le potentiel de Qwen2.5-Coder dans les scénarios du monde réel.

Puissant : capacité de codage jusqu'au modèle open source SOTA

- génération de codesQwen2.5-Coder-32B-Instruct, le modèle phare de cette source ouverte, a obtenu les meilleures performances parmi les modèles de source ouverte sur plusieurs bancs d'essai populaires de génération de code (par exemple, EvalPlus, LiveCodeBench et BigCodeBench), et a atteint des performances compétitives par rapport à GPT-4o.

- Corrections de codeQwen2.5-Coder-32B-Instruct peut aider les utilisateurs à corriger les erreurs dans leur code et à rendre la programmation plus efficace. Aider est un benchmark populaire pour la correction de code, et Qwen2.5-Coder-32B-Instruct obtient un score de 73,7, ce qui est comparable à GPT sur Aider. Qwen2.5-Coder-32B-Instruct a obtenu un score de 73,7 sur Aider et a fait aussi bien que GPT-4o.

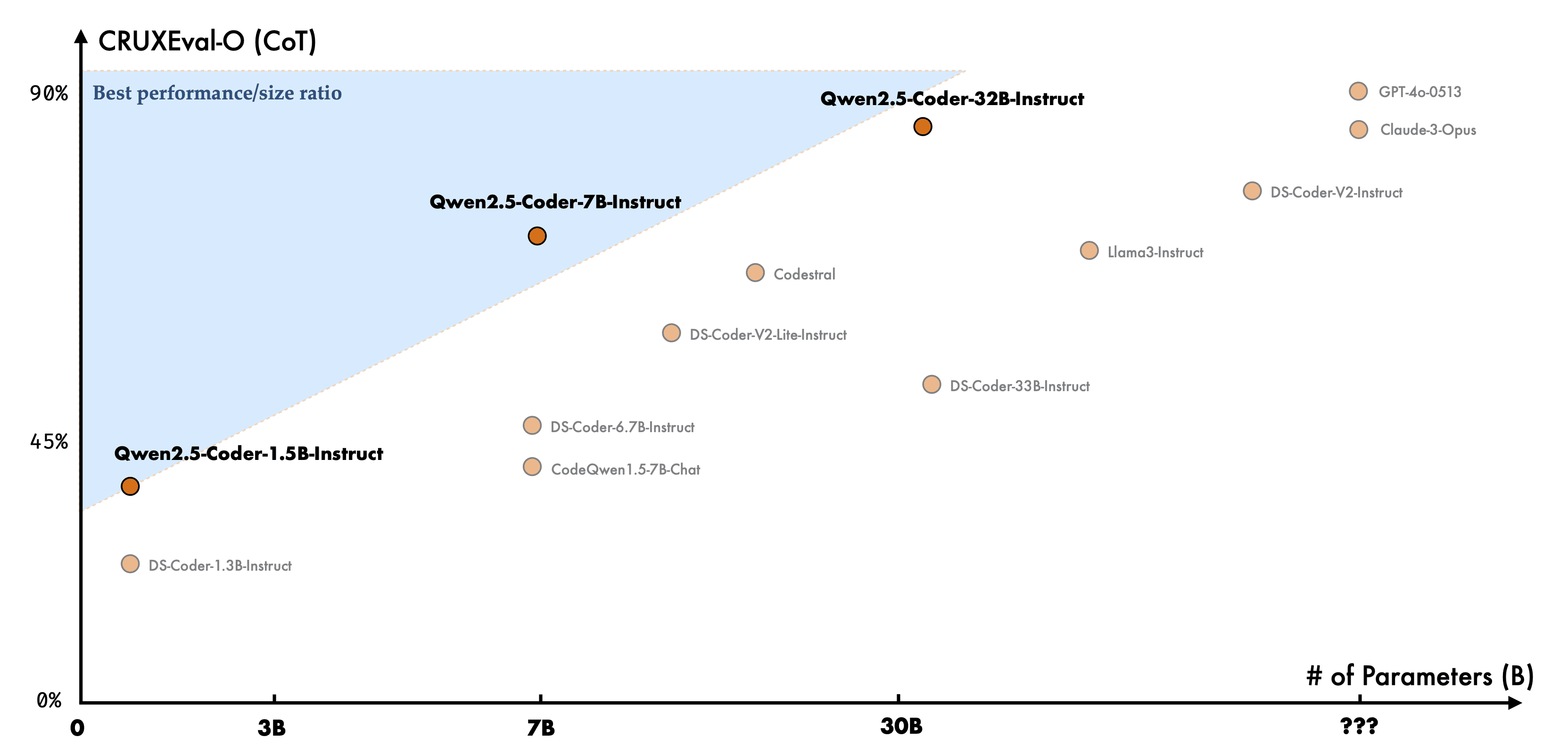

- raisonnement codéQwen2.5-Coder-7B-Instruct : L'inférence de code fait référence à la capacité d'un modèle à apprendre le processus d'exécution du code et à prédire avec précision les entrées et les sorties du modèle. Qwen2.5-Coder-7B-Instruct, publié le mois dernier, a déjà montré de bonnes performances en matière de capacité de raisonnement du code, et le modèle 32B va encore plus loin.

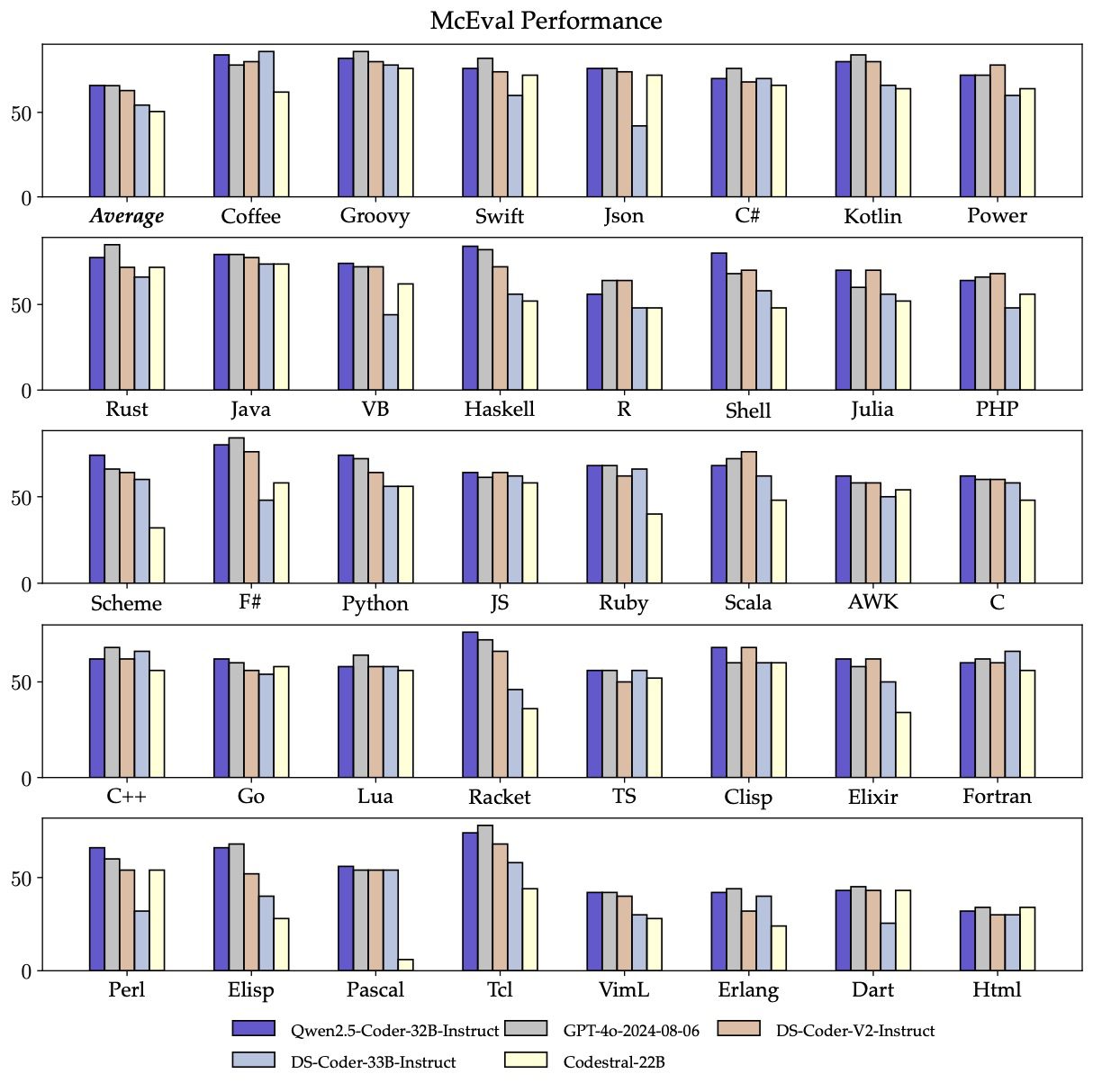

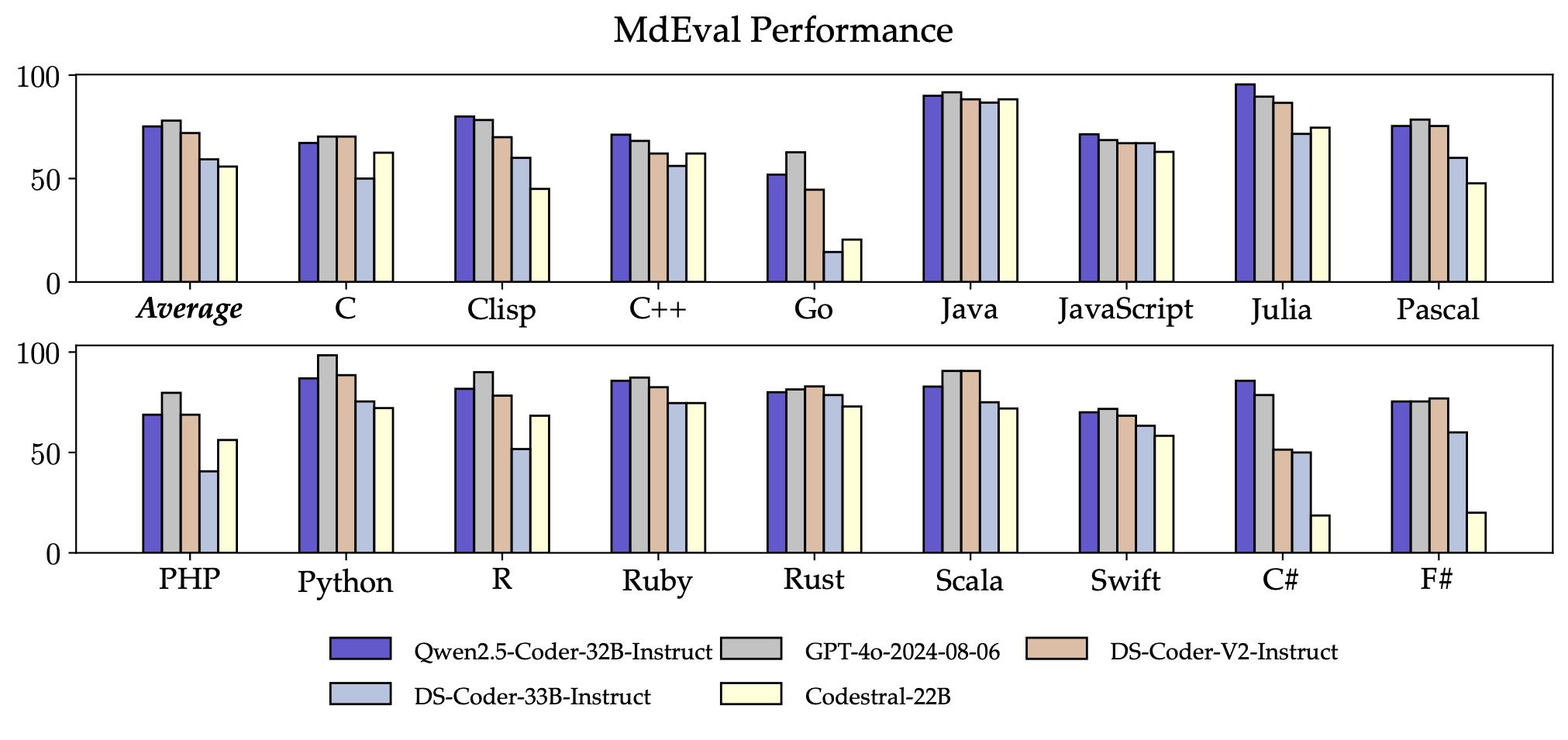

- multilingueQwen2.5-Coder-32B-Instruct est performant dans plus de 40 langages de programmation, atteignant un score de 65,9 sur McEval, avec des performances impressionnantes sur Haskell, Racket et d'autres, grâce à notre nettoyage de données unique et au rationnement dans la phase de pré-entraînement.

En outre, la capacité de Qwen2.5-Coder-32B-Instruct à fixer le code de plusieurs langages de programmation est également surprenante, ce qui aidera les utilisateurs à comprendre et à modifier leurs langages de programmation familiers et réduira considérablement le coût d'apprentissage des langages non familiers.

À l'instar de McEval, MdEval est un test de référence pour la fixation du code dans plusieurs langages de programmation. Qwen2.5-Coder-32B-Instruct a obtenu un score de 75,2 sur MdEval, soit le meilleur score parmi tous les modèles open source.

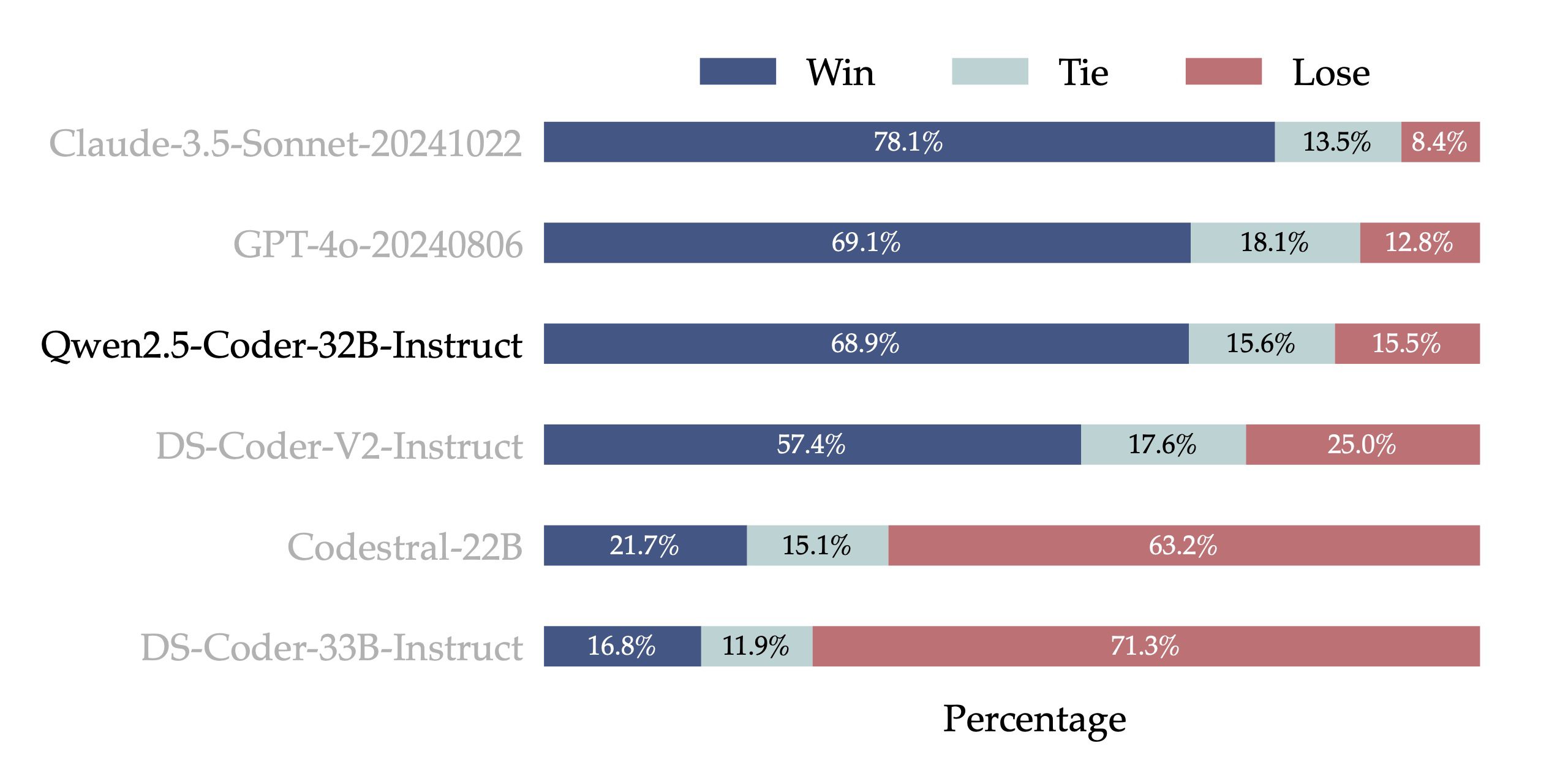

- Alignement des préférences humainesPour tester les performances d'alignement de Qwen2.5-Coder-32B-Instruct sur les préférences humaines, nous avons construit Code Arena (similaire à Arena Hard), un benchmark d'évaluation des préférences de code à partir d'annotations internes. Nous utilisons GPT-4o comme modèle d'évaluation pour l'alignement des préférences, avec une évaluation "A vs. B win" - c'est-à-dire le pourcentage par lequel le score du modèle A dépasse le score du modèle B dans l'ensemble d'instances testé. Les résultats de la figure suivante montrent l'avantage de Qwen2.5-Coder-32B-Instruct dans l'alignement des préférences.

Polyvalence : une multitude de tailles de modèles

La famille de modèles open source Qwen2.5-Coder se compose de six tailles : 0,5B, 1,5B, 3B, 7B, 14B et 32B, ce qui permet non seulement de répondre aux besoins des développeurs dans différents scénarios de ressources, mais aussi de fournir un bon terrain d'expérimentation à la communauté des chercheurs. Le tableau suivant présente les informations détaillées du modèle :

| Modèles | Params | Params non-Emb | Couches | Têtes (KV) | Encastrement de la cravate | Contexte Longueur | Licence |

|---|---|---|---|---|---|---|---|

| Qwen2.5-Coder-0.5B | 0.49B | 0.36B | 24 | 14 / 2 | Oui | 32K | Apache 2.0 |

| Qwen2.5-Coder-1.5B | 1.54B | 1.31B | 28 | 12 / 2 | Oui | 32K | Apache 2.0 |

| Qwen2.5-Coder-3B | 3.09B | 2.77B | 36 | 16 / 2 | Oui | 32K | Recherche Qwen |

| Qwen2.5-Coder-7B | 7.61B | 6.53B | 28 | 28 / 4 | Non | 128K | Apache 2.0 |

| Qwen2.5-Codeur-14B | 14.7B | 13.1B | 48 | 40 / 8 | Non | 128K | Apache 2.0 |

| Qwen2.5-Coder-32B | 32.5B | 31.0B | 64 | 40 / 8 | Non | 128K | Apache 2.0 |

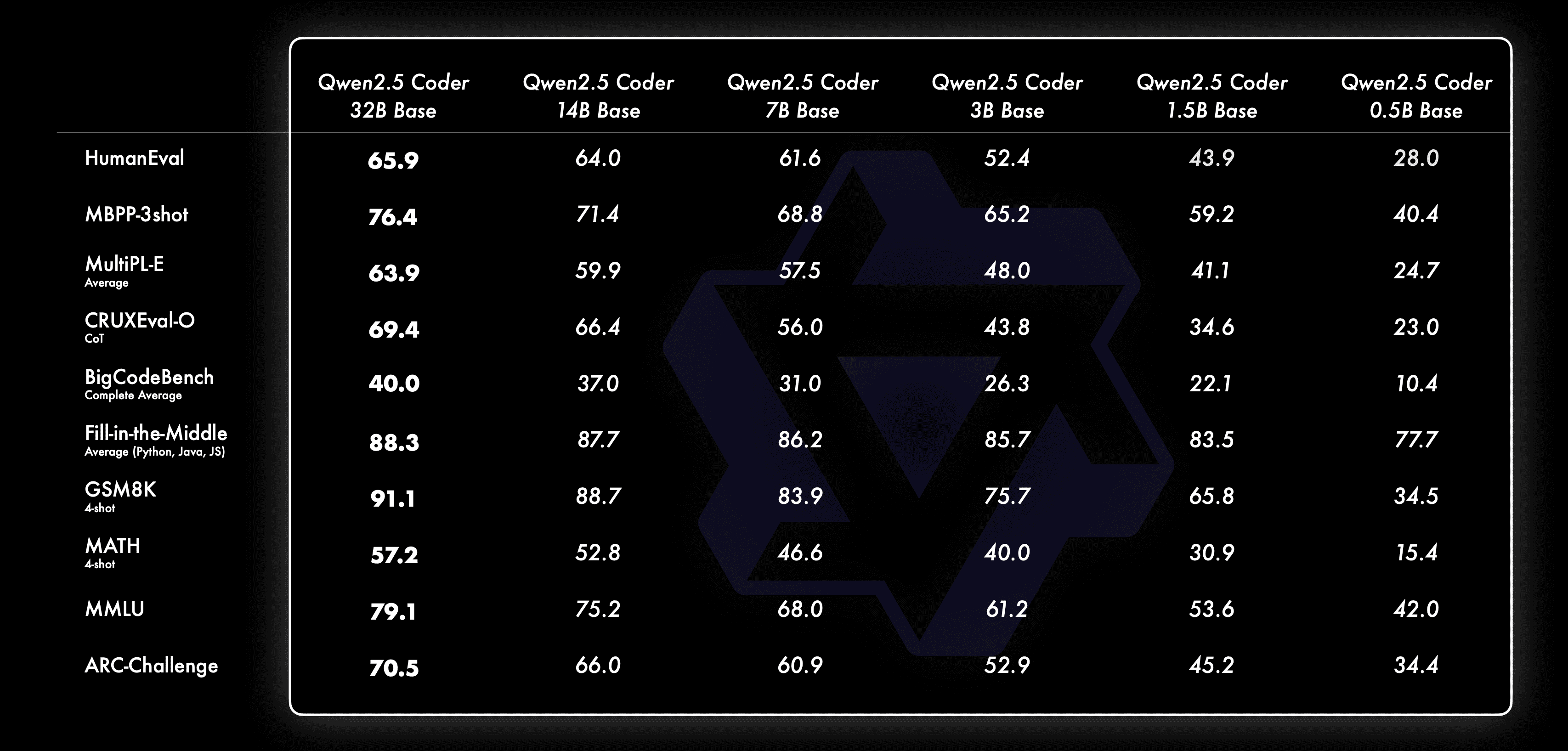

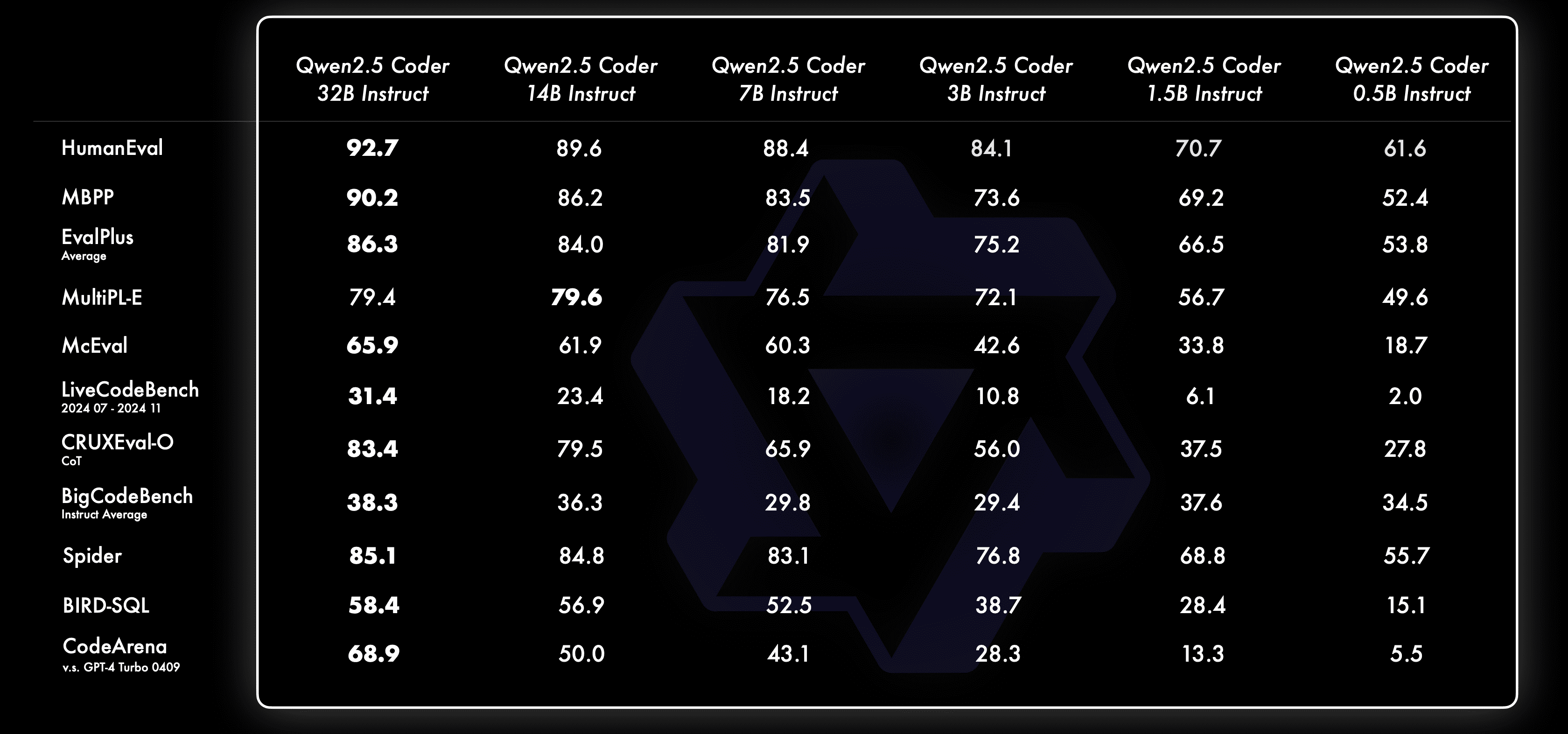

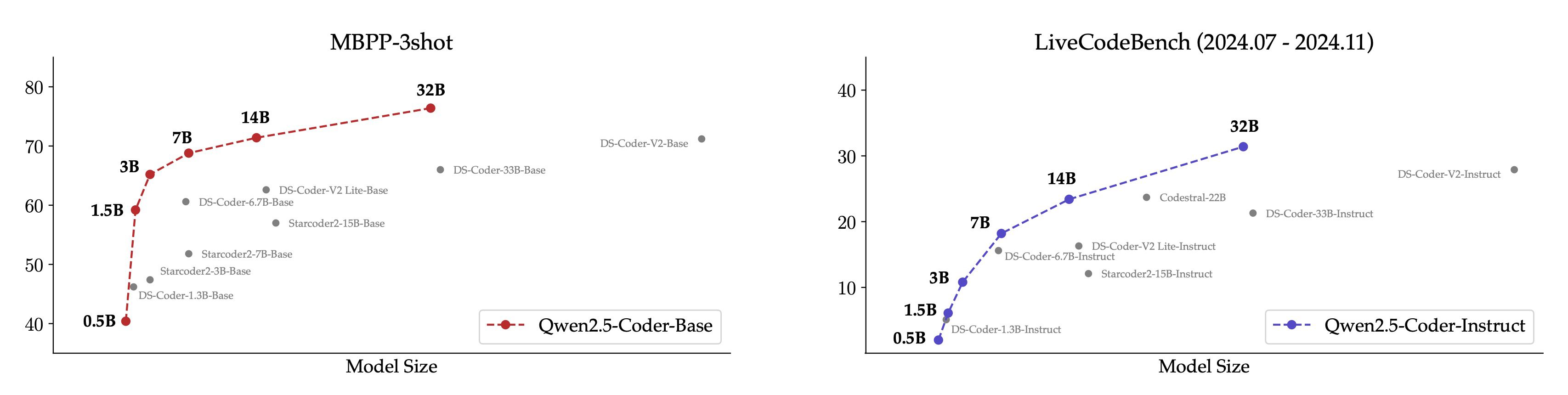

Nous avons toujours cru Loi d'échelle Philosophie. Nous évaluons la performance des modèles Qwen2.5-Coder de différentes tailles sur tous les ensembles de données pour vérifier l'efficacité de Scaling on Code LLMs.

Pour chaque taille, nous avons mis en libre accès les modèles Base et Instruct, le modèle Base servant de base aux développeurs pour affiner leurs modèles, et le modèle Instruct étant le modèle d'alignement officiel disponible pour le chat direct.

Voici comment le modèle de base se comporte à différentes tailles :

Voici comment le modèle Instruct se comporte à différentes tailles :

Pour être plus intuitif, nous montrons une comparaison entre différentes tailles du modèle Qwen2.5-Coder et d'autres modèles open source sur l'ensemble de données de base.

- Pour le modèle de base, nous choisissons MBPP-3shot comme indice d'évaluation, et nos expériences approfondies montrent que MBPP-3shot est plus adapté à l'évaluation du modèle de base et peut être en corrélation avec l'effet réel du modèle.

- Pour le modèle Instruct, nous avons choisi les sujets LiveCodeBench des 4 derniers mois (2024.07 - 2024.11) pour l'évaluation, et ces sujets récemment publiés qui sont peu susceptibles de fuir dans l'ensemble de formation reflètent la capacité OOD du modèle.

La corrélation positive attendue entre la taille et l'efficacité du modèle, et le fait que le codeur Qwen2.5 ait atteint la performance SOTA à toutes les tailles, nous encouragent à continuer à explorer des modèles de codeur plus grands.

Pratique : Présentation du curseur et des artefacts

Un codeur pratique a toujours été notre vision. À cette fin, nous avons exploré l'application pratique du modèle Qwen2.5-Coder dans le contexte des assistants de code et des artefacts.

Qwen2.5-Codeur 🤝 Curseur

Les assistants de code intelligents sont déjà largement utilisés, mais ils reposent actuellement sur des modèles à code fermé. Nous espérons que l'émergence de Qwen2.5-Coder offrira aux développeurs une alternative conviviale et puissante.

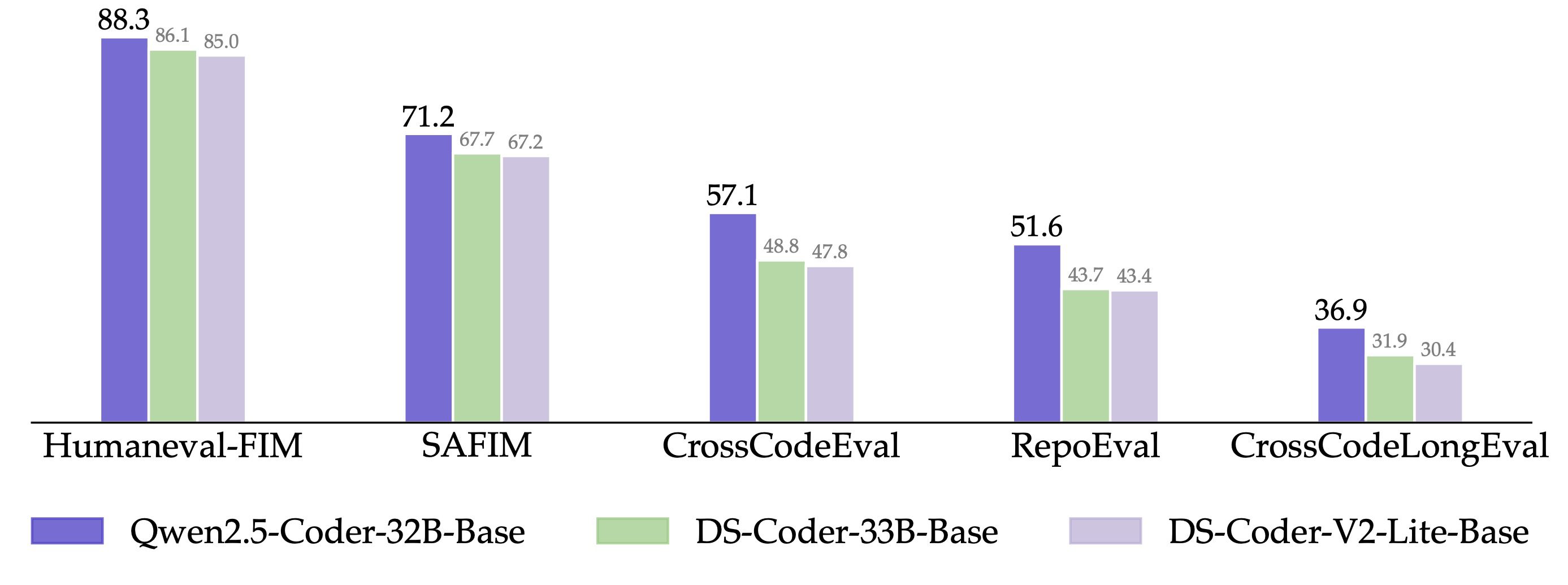

En outre, Qwen2.5-Coder-32B a démontré une forte capacité de complétion de code sur le modèle pré-entraîné et a atteint les performances SOTA sur cinq ensembles d'évaluation, notamment Humaneval-Infilling, CrossCodeEval, CrossCodeLongEval, RepoEval et SAFIM.

Afin de maintenir une comparaison équitable, nous contrôlons la longueur maximale de la séquence à 8k et utilisons le mode Fill-in-the-Middle pour les tests. Dans les 4 ensembles de tests CrossCodeEval, CrossCodeLongEval, RepoEval et Humaneval-Infilling, nous avons évalué si le contenu généré est absolument égal aux étiquettes réelles (Exact Match) ; et dans SAFIM, nous avons utilisé le taux de réussite de l'exécution en une seule fois (Pass@1) pour l'évaluation. l'évaluation.

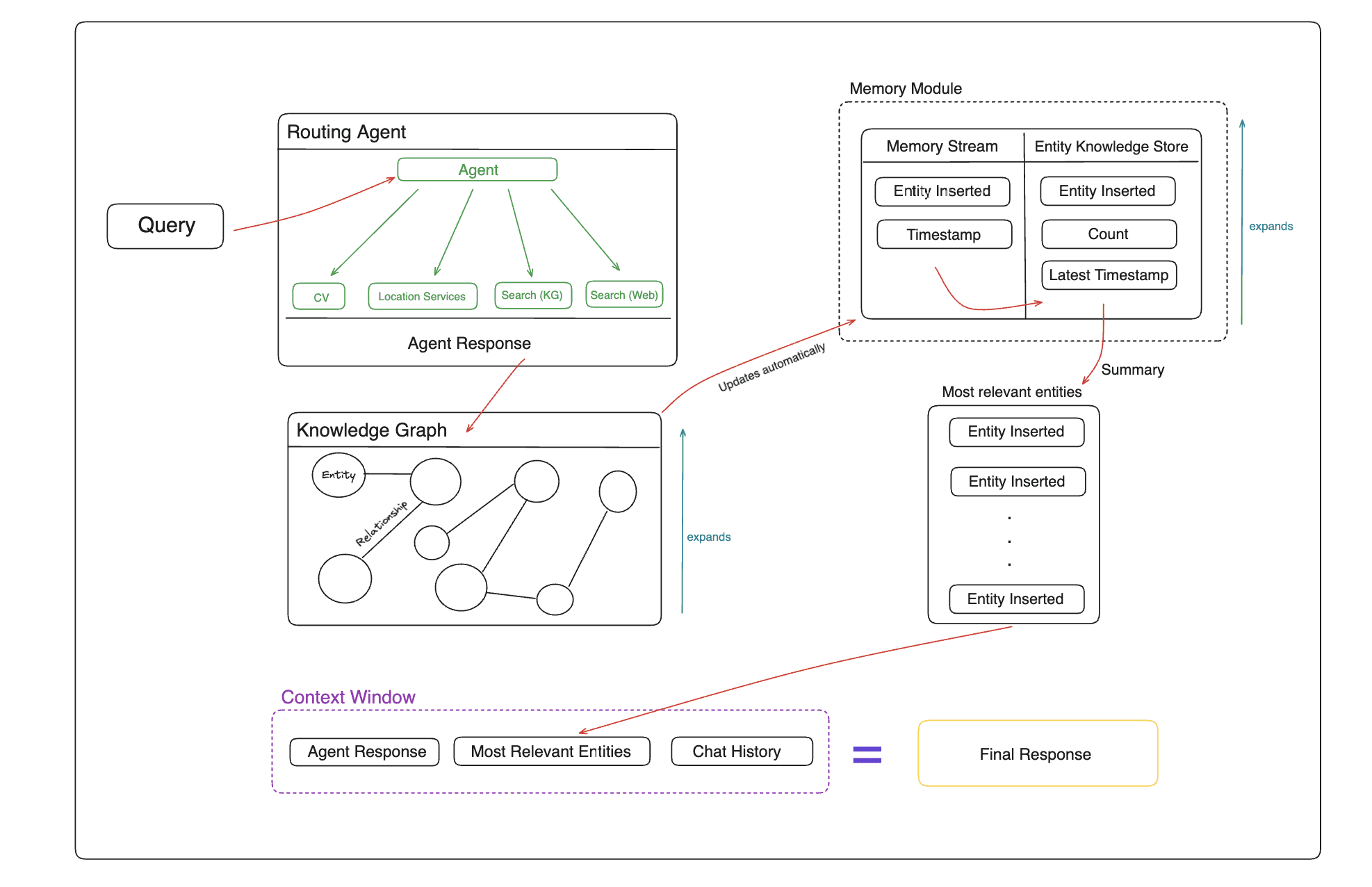

Qwen2.5-Coder 🤝 Artifacts

Artifacts est l'une des applications les plus importantes pour la génération de code qui peut aider les utilisateurs à créer quelque chose de convenable pour la visualisation. Ouvrir l'interface WebUI Explorer le potentiel de Qwen2.5-Coder dans les scénarios Artifacts, voici quelques exemples concrets :

Nous allons bientôt mettre en ligne le mode code sur le site officiel de Tongyi https://tongyi.aliyun.com, qui prend en charge toutes sortes d'applications de visualisation telles que des sites web générés en une phrase, des mini-jeux et des graphiques de données. Nous vous invitons à en faire l'expérience !

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Postes connexes

Pas de commentaires...