OpenWebUI Déploiement de l'interface de dialogue visuel Ollama

I. Déploiement avec Node.js

1. installer Node.js

Télécharger et installer Node.js Outils : https://www.nodejs.com.cn/download.html

Définissez la source du miroir, par exemple, utilisez la source du miroir suivante.

npm config set registry http://mirrors.cloud.tencent.com/npm/

2. cloner le dépôt ollama-webui

Clonez le dépôt ollama-webui dans le terminal et changez le répertoire du code ollama-webui.

git clone https://github.com/ollama-webui/ollama-webui-lite.git

cd ollama-webui-lite

3. installation des dépendances

Installez la dépendance dans le terminal.

npm ci

4. fonctionnement

npm run dev

frappe (sur le clavier) http://localhost:3000/ , ouvrir la page.

Déploiement avec Docker

Cette sous-section déploie open-webui en utilisant Docker sur Windows.

Tutoriel de référence Installation et configuration d'Ollama sur WindowsPour installer Ollama à l'avance, utilisez la commande suivante dans le terminal pour extraire le fichier ghcr.io/open-webui/open-webui:main Mettez-le en miroir et exécutez-le.

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

Le résultat suivant apparaît dans le terminal de commande, indiquant que l'exécution a réussi.

Une fois que la commande s'est exécutée avec succès, la commande suivante apparaît sous le conteneur de Docker open-webuiLa figure ci-dessous présente les éléments suivants.

Cliquez ensuite sur Port Access comme indiqué ci-dessous. Vous pouvez également taper directement dans le navigateur http://localhost:3000/ Accès.

Lorsque vous l'ouvrirez, il apparaîtra que vous êtes connecté à Open WebUI, il vous suffit de créer un compte.

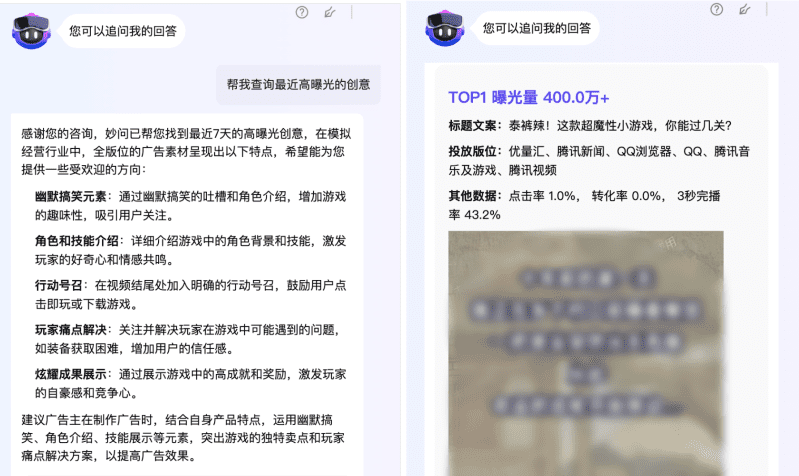

Après avoir sélectionné le modèle, vous pouvez entamer le dialogue.

Vous trouverez ci-dessous une liste des façons les plus courantes d'utiliser la fonction qwen2:1.5b Un exemple de dialogue.

Si vous souhaitez découvrir d'autres fonctionnalités, vous pouvez vous référer à : https://github.com/open-webui/open-webui

Adresse de l'entrepôt de référence : https://github.com/ollama-webui/ollama-webui-lite

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...