OpenManus-RL : affiner les grands modèles pour améliorer le raisonnement et la prise de décision des organismes intelligents

Introduction générale

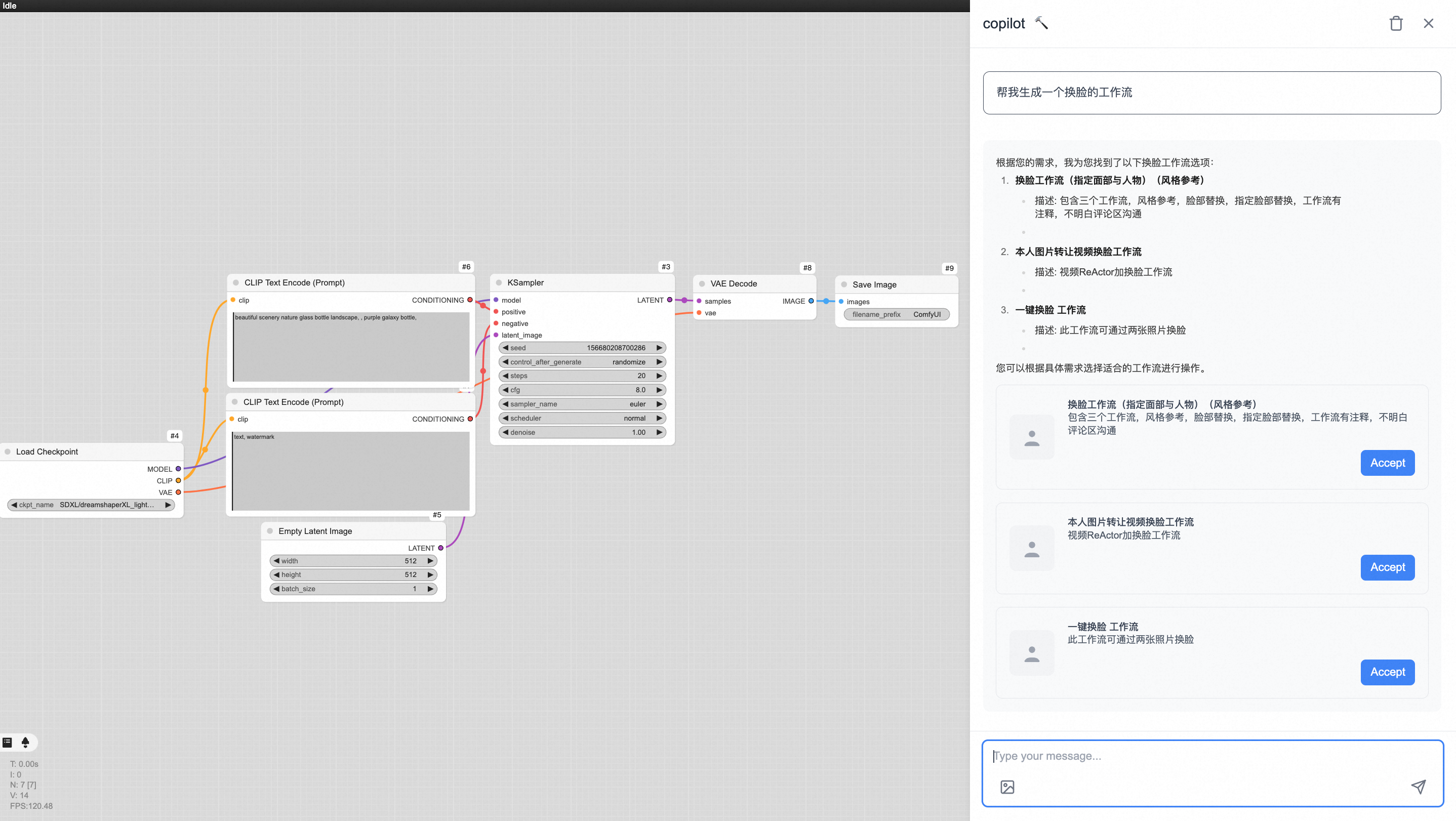

OpenManus-RL est une collaboration entre l'UIUC-Ulab et l'Institut de recherche sur le cancer. MetaGPT Ce projet open source, développé conjointement par l'équipe OpenManus de la communauté et hébergé sur GitHub, améliore les capacités de raisonnement et de prise de décision des intelligences à grand modèle de langage (LLM) grâce à des techniques d'apprentissage par renforcement (RL), en explorant de nouvelles méthodes de réglage basées sur l'expérience de modèles tels que Deepseek-R1 et QwQ-32B. L'équipe publie régulièrement les progrès réalisés, avec une transparence totale du code, des ensembles de données et des résultats des tests, et soutient la validation des résultats dans des tests de référence tels que GAIA, AgentBench, WebShop, OSWorld et d'autres. Le projet encourage les développeurs du monde entier à contribuer au code, aux ensembles de données ou aux ressources informatiques afin de construire ensemble un écosystème efficace pour le développement de corps intelligents.

Jusqu'à présent, la création de logiciels libres Manus Avec la dernière pièce du puzzle en place, MetaGPT se lance dans la course... Mais... MGX Le naturel peut être couvert Manus Avec toutes les possibilités qu'elle offre, la reproduction à code source ouvert est en fait un piggybacking.

Liste des fonctions

- Construction d'un environnement corporel intelligentRL tuning : permet de régler en ligne l'outil de configuration de l'environnement Smartbody.

- Collecte de données sur la trajectoireLes modèles de connexion tels que Deepseek-R1 et QwQ-32B permettent de collecter des données comportementales pour des tâches complexes.

- RL Tuning SupportLe comportement du corps intelligent personnalisé : méthodes d'apprentissage par renforcement pour soutenir le comportement du corps intelligent personnalisé.

- Intégration de l'étalonnage des performancesLes environnements de test : WebShop, GAIA, OSWorld, AgentBench et d'autres environnements de test sont intégrés.

- stratégie de diversificationIntégration de stratégies RL telles que l'arbre de pensée, la recherche arborescente de Monte Carlo.

- Collaboration communautaireLa soumission de codes, d'ensembles de données, etc. est autorisée et les contributeurs importants peuvent devenir co-auteurs de l'article.

- Partage des progrès en temps réelLes résultats de la mise à jour dynamique de la RL : Démontrer le processus de mise au point de la RL et les résultats obtenus.

Utiliser l'aide

Processus d'installation

OpenManus-RL est facile à installer et convient aux utilisateurs ayant des compétences de base en Python. Voici les étapes détaillées :

1. création de l'environnement Conda

Pour éviter les conflits de dépendances, il est recommandé d'utiliser Conda :

conda create -n openmanus-rl python=3.10

conda activate openmanus-rl

- Conditions préalables : Conda doit être installé et peut être téléchargé à partir du site webSite officiel d'AnacondaTélécharger.

- Après l'activation, le terminal affiche

(openmanus-rl).

2. clonage de projets

Assurez-vous que Git est installé (check :git --versionSi vous n'installez pas le logiciel, vous pouvez le télécharger à partir de la pagegit-scm.(Télécharger) :

git clone https://github.com/OpenManus/OpenManus-RL.git

cd OpenManus-RL

- Téléchargez le code et allez dans le répertoire du projet.

3. installation des dépendances

Exécutez-le dans le répertoire racine du projet :

pip install -r requirements.txt

- Si le téléchargement est lent, utilisez un miroir national :

pip install -r requirements.txt -i https://pypi.tuna.tsinghua.edu.cn/simple

- Les outils de visualisation nécessitent une installation supplémentaire :

pip install matplotlib numpy

4. modèles de configuration et ensembles de données

- Réglage fin supervisé (SFT)Spécifier le modèle et l'ensemble de données :

python -m openmanus_rl.sft --model_name_or_path Qwen/Qwen2.5-1.5B-Instruct --dataset_name CharlieDreemur/OpenManus-RL

- Apprentissage par renforcement (GRPO): Configurer la fonction de récompense :

python -m openmanus_rl.grpo --model_name_or_path Qwen/Qwen2.5-1.5B-Instruct --dataset_name CharlieDreemur/OpenManus-RL-GRPO --reward_funcs accuracy format tag_count

- L'ensemble des données est disponible sur le siteVisage étreintObtenir.

5. exécuter le projet

- GPU unique exécutant SFT :

python -m openmanus_rl.sft --output_dir data/sft-output

- GRPO multi-GPU (configuration requise)

zero3.yaml) :

accelerate launch --config_file=configs/accelerate_configs/zero3.yaml openmanus_rl/grpo.py --output_dir data/grpo-output

Principales fonctions

Construction d'un environnement corporel intelligent

- procédure: :

- être en mouvement

python -m openmanus_rl.sftGénérer l'environnement de base. - Modifier les fichiers de configuration (par exemple, les objectifs de la mission ou les fonctions de récompense).

- réaliser

python -m openmanus_rl.grpoCommencez à régler.

- être en mouvement

- Scénarios d'utilisationLes services d'aide à la décision : personnalisation de l'environnement du corps intelligent pour des tâches spécifiques (par exemple, décisions d'achat).

Collecte de données et tests

- procédure: :

- Modèle de configuration (par exemple, Deepseek-R1) :

python -m openmanus_rl.grpo --model_name_or_path Deepseek-R1

- Exécutez le test :

--benchmark GAIALes résultats sont enregistrés dansdata/Catalogue.

- Scénarios d'utilisation: Analyser la performance des intelligences dans des tâches complexes.

Opérations d'accord RL

- procédure: :

- Exécuter le mode GRPO :

python -m openmanus_rl.grpo --reward_funcs accuracy

- Visualiser les journaux de formation, les modèles sauvegardés dans

data/grpo-output.

- Scénarios d'utilisationOptimisation du comportement du corps intelligent, par exemple pour améliorer le succès d'un achat dans une boutique en ligne.

Contributions communautaires

- procédure: :

- Transférez le projet sur votre compte GitHub personnel.

- Modification et soumission au niveau local :

git add .

git commit -m "优化RL策略"

git push origin main

- Soumettre une demande de retrait, ou contacter par courriel

kunlunz2@illinois.edu.

- Scénarios d'utilisationLes tâches sont multiples : contribuer à l'élaboration de nouveaux algorithmes ou ensembles de données et participer au développement du noyau dur.

Fonctions vedettes

RL Tuning Support

- Comment cela fonctionne-t-il ?: Exécuter le GRPO, en spécifiant la fonction de récompense (par ex.

accuracy), le processus de formation affiche un journal en temps réel et le modèle est enregistré dans un répertoire spécifié une fois terminé. - effetLes corps intelligents peuvent adapter leur comportement à la tâche, par exemple en optimisant la performance des tâches multimodales dans OSWorld.

Intégration de l'étalonnage des performances

- Comment cela fonctionne-t-il ?: Run

python -m openmanus_rl.grpo --benchmark AgentBenchLe système génère automatiquement des rapports sur les taux de réussite, les temps de réponse, etc. - effetLes modèles d'évaluation de l'impact sur l'environnement : ils fournissent des mesures quantitatives pour aider les développeurs à comparer les performances des modèles.

stratégie de diversification

- Comment cela fonctionne-t-il ?Sélectionnez la politique dans le fichier de configuration (par exemple, la politique d'accès à l'Internet).

Tree-of-Thoughts), exécutez la commande d'accord pour tester l'effet. - effetLe projet de recherche sur la planification à long terme de l'Intelligentsia : Améliorer la capacité de raisonnement de l'Intelligentsia dans les tâches de planification à long terme.

OpenManus-RL utilise ces fonctionnalités pour aider les utilisateurs à démarrer rapidement. Le projet propose également un groupe communautaire (voir GitHub "Community Group"), que vous pouvez rejoindre pour communiquer avec les développeurs et obtenir les dernières informations.

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...