Les modèles de nouvelle génération d'OpenAI se heurtent à un goulot d'étranglement important, l'ancien scientifique en chef révèle une nouvelle voie

Orion, le modèle de langage étendu de nouvelle génération d'OpenAI, pourrait se heurter à un goulot d'étranglement sans précédent. Selon The Information, les employés d'OpenAI affirment que les gains de performance du modèle Orion n'ont pas été à la hauteur des attentes et que les gains de qualité sont "beaucoup plus faibles" que la mise à niveau de GPT-3 à GPT-4.

En outre, Orion n'est pas aussi stable que son prédécesseur GPT-4 pour certaines tâches. Malgré les capacités linguistiques accrues d'Orion, les performances de programmation pourraient ne pas dépasser celles de GPT-4. La diminution des ressources pour la formation de textes de haute qualité et d'autres données a rendu plus difficile la recherche de données de formation de haute qualité, ralentissant ainsi le développement de grands modèles linguistiques (LLM).

En outre, les formations futures seront encore plus gourmandes en calcul, en termes d'argent et même d'électricité, ce qui signifie que le coût du développement d'Orion et des grands modèles linguistiques ultérieurs augmentera considérablement. Noam Brown, chercheur à l'openAI, a récemment déclaré lors de la conférence TED sur l'IA que des modèles plus avancés pourraient être "économiquement impossibles à mettre en œuvre" :

Allons-nous vraiment dépenser des centaines de milliards ou des milliers de milliards de dollars pour former des modèles ? À un moment donné, la loi de la mise à l'échelle s'effondrera.

L'OpenAI a mis en place une équipe de base, dirigée par Nick Ryder, afin d'étudier la manière de gérer la pénurie croissante de données d'entraînement et la durée des lois de mise à l'échelle des grands modèles.

Noam Brown

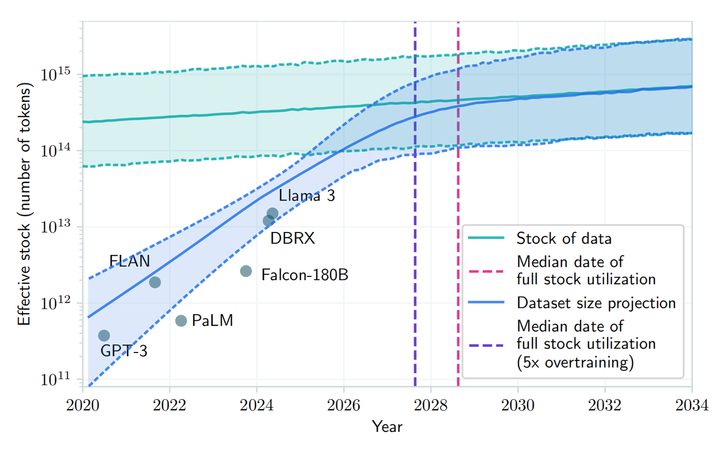

Les lois de mise à l'échelle sont l'une des hypothèses fondamentales de l'IA : tant qu'il y a plus de données pouvant être apprises et plus de puissance de calcul pour piloter le processus de formation, les performances d'un grand modèle linguistique continueront à s'améliorer au même rythme. En bref, la loi d'échelle décrit la relation entre les ressources utilisées (quantité de données, puissance de calcul, taille du modèle) et les performances du modèle. C'est-à-dire la mesure dans laquelle les performances s'améliorent lorsque davantage de ressources sont investies dans le grand modèle linguistique.

Par exemple, la formation d'un grand modèle linguistique peut être comparée à la production d'une voiture : au départ, l'usine est petite, avec seulement quelques machines et quelques travailleurs, et à ce stade, chaque machine ou travailleur supplémentaire entraîne une augmentation significative de la production, car les ressources supplémentaires sont directement traduites en productivité. Toutefois, au fur et à mesure que l'usine grandit, l'augmentation de la production par machine ou travailleur supplémentaire diminue, peut-être en raison de la complexité accrue de la gestion ou d'une collaboration moins efficace entre les travailleurs.

Lorsqu'une usine atteint une certaine taille, l'ajout de machines ou de travailleurs peut entraîner une augmentation plus limitée de la production, et l'usine peut alors approcher les limites de ses ressources, telles que l'approvisionnement en terres et la logistique. C'est exactement le dilemme auquel est confronté le modèle d'Orion : à mesure que la taille du modèle augmente (de la même manière que l'on ajoute des machines et des travailleurs), l'amélioration des performances du modèle est très importante au début et à moyen terme, mais dans les phases ultérieures, même si la taille du modèle ou la quantité de données d'apprentissage augmente, l'amélioration des performances devient plus faible. C'est ce que l'on appelle "toucher le mur".

Selon un article publié sur arXiv, le développement de grands modèles de langage pourrait épuiser les ressources publiques de textes humains entre 2026 et 2032 en raison de la demande croissante et de la disponibilité limitée des données publiques de textes humains. Bien qu'il ait souligné les "problèmes économiques" liés à la formation des futurs modèles, Norm Brown s'inscrit en faux contre cette affirmation, estimant que "le développement de l'IA n'est pas près de ralentir".

Les chercheurs de l'OpenAI partagent généralement ce point de vue et, bien que la loi d'échelle puisse ralentir, le développement global de l'IA ne sera pas affecté de manière significative par l'optimisation des temps d'inférence et les améliorations post-entraînement.Mark Zuckerberg, PDG de Meta, Sam Altman, PDG de l'OpenAI, et d'autres PDG de développeurs d'IA ont également déclaré publiquement que les limites traditionnelles de la loi d'expansion n'ont pas encore été atteintes et qu'ils continuent à développer des centres de données coûteux pour améliorer les performances des modèles pré-entraînés.

Peter Welinder, vice-président des produits d'OpenAI, s'est également exprimé sur les médias sociaux pour dire que "les gens sous-estiment la puissance du calcul en temps réel". Le calcul en temps réel (TTC) est un concept d'apprentissage automatique qui fait référence au calcul qui se produit lorsqu'un modèle est déployé pour effectuer une inférence ou une prédiction par rapport à de nouvelles données d'entrée, indépendamment du calcul qui se produit pendant la formation. La phase de formation est le processus par lequel le modèle apprend des modèles de données, tandis que la phase de test est le processus par lequel le modèle est appliqué à des tâches réelles.

Les modèles traditionnels d'apprentissage automatique prédisent généralement de nouvelles instances de données sans calcul supplémentaire une fois qu'ils ont été formés et déployés. Cependant, certains modèles plus complexes, tels que certains types de modèles d'apprentissage profond, peuvent nécessiter des calculs supplémentaires au moment du test (temps d'inférence). Le modèle "o1" développé par OpenAI utilise ce type de modèle d'inférence. L'industrie de l'IA dans son ensemble se concentre désormais sur la phase d'optimisation du modèle, une fois l'apprentissage initial terminé.

Peter Welinder

Ilya Sutskever, l'un des cofondateurs d'OpenAI, a admis dans un entretien récent avec Reuters que la phase de pré-entraînement consistant à utiliser de grandes quantités de données non étiquetées pour entraîner les modèles d'IA à comprendre les modèles et les structures linguistiques a atteint un plateau en termes de gains d'efficacité. "Les années 2010 ont été l'ère de l'expansion, et nous sommes maintenant revenus à l'ère de l'exploration et de la découverte", a-t-il déclaré. Il a également noté que "l'amélioration de la précision est plus importante que jamais".

Le lancement d'Orion est prévu pour 2025, et OpenAI l'a baptisé "Orion" au lieu de "GPT-5", ce qui laisse peut-être présager une toute nouvelle révolution. Bien qu'il soit actuellement "difficile à produire" en raison de limitations théoriques, on s'attend à ce que ce "nouveau-né" apporte une opportunité de transformation pour la macromodélisation de l'IA.

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...