OpenAI-o3 avec des idées de Monte-Carlo

o3 est ici pour partager quelques idées personnelles. À propos de Test-time Loi d'échelle Les progrès sont beaucoup plus rapides qu'on ne le pensait. Mais je dirais que le chemin est en fait un peu alambiqué - c'est la façon dont l'OpenAI prend une balle courbe dans sa poursuite de l'AGI.

Apprentissage intensif et pensée rapide

Pourquoi en est-il ainsi ? Explorons cette question à l'aide de deux exemples.

Le premier exemple provient de l'apprentissage par renforcement. Dans l'apprentissage par renforcement, le facteur d'actualisation joue un rôle clé, ce qui implique que la récompense obtenue diminue progressivement au fur et à mesure que l'on avance dans la prise de décision. Par conséquent, l'objectif de l'apprentissage par renforcement est généralement de maximiser les récompenses en un minimum de temps et d'étapes. Au cœur de cette stratégie, l'accent est mis sur les "raccourcis", c'est-à-dire sur l'obtention de la récompense le plus rapidement possible.

Le deuxième exemple est le processus de mise au point de grands modèles. Un modèle pré-entraîné qui n'a pas été affiné n'a souvent pas de direction ou de contrôle clairs. Lorsque nous demandons au modèle "Où se trouve la capitale de la Chine ? il peut d'abord répondre "C'est une bonne question", puis prendre la tangente avant de finalement donner la réponse "Pékin". Cependant, lorsque la même question est posée à un modèle affiné, la réponse est directe et claire : "Pékin".

Ce modèle affiné permet d'obtenir des raccourcis grâce à des stratégies d'optimisation, à l'instar du parcours évolutif des êtres humains, qui s'efforcent toujours de consommer le moins d'énergie possible et d'emprunter le chemin le plus court.

Pourquoi le raisonnement ?

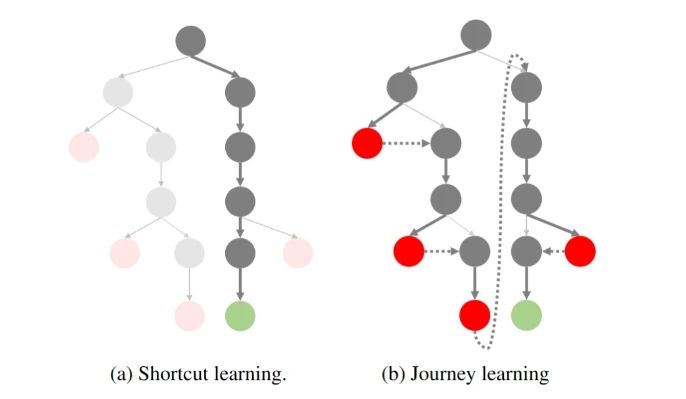

Si vous visualisez le processus d'échantillonnage de raisonnement comme un arbre :

L'aventure de la réplication O1 : Partie 1

À gauche se trouve l'apprentissage par raccourci que nous avons poursuivi dans le passé : le moins d'étapes possible pour arriver au bon résultat. À droite, le paradigme "réfléchi, rétrospectif" représenté par l'OpenAI o1.

Nous savons que lorsque o1 effectue une recherche, le modèle est constamment en train de réfléchir et de revenir en arrière, et ce processus s'accompagne souvent de frais généraux supplémentaires. Le problème est le suivant : qui veut consacrer du temps et de l'argent à une recherche complexe si le modèle peut donner la bonne réponse encore et encore ? l'OpenAI n'est pas stupide, et nous savons tous que les raccourcis sont préférables !

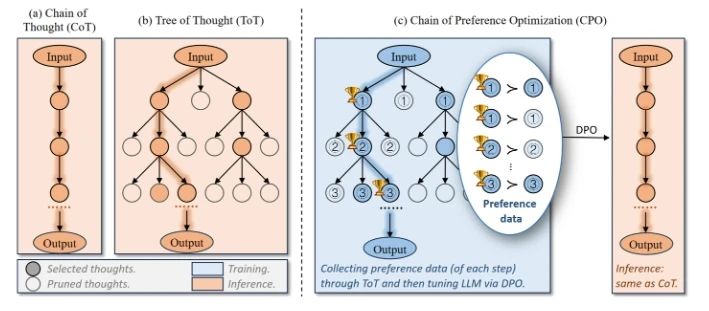

Plus le problème est difficile, plus l'arbre d'idées potentiel est large, plus il y a d'espace de recherche à chaque étape, et moins il est probable qu'un raccourci conduise à la bonne réponse. Que faire alors ? Une façon intuitive d'y penser est d'opter pour l'élagage ! Couper les nœuds de l'arbre qui ont peu de chances d'atteindre le point final à l'avance, en comprimant l'espace de recherche - en transformant l'arbre en un arbre étroit. C'est ce que de nombreux efforts actuels tentent de faire, par exemple :

Optimisation de la chaîne de préférences (CPO)

L'optimisation de la chaîne de préférence consiste à construire naturellement des données de préférence à partir de l'arbre de réflexion, puis à utiliser la DPO pour l'optimiser afin que le modèle ait une plus grande probabilité de sélectionner le nœud de l'arbre qui atteindra le point final.

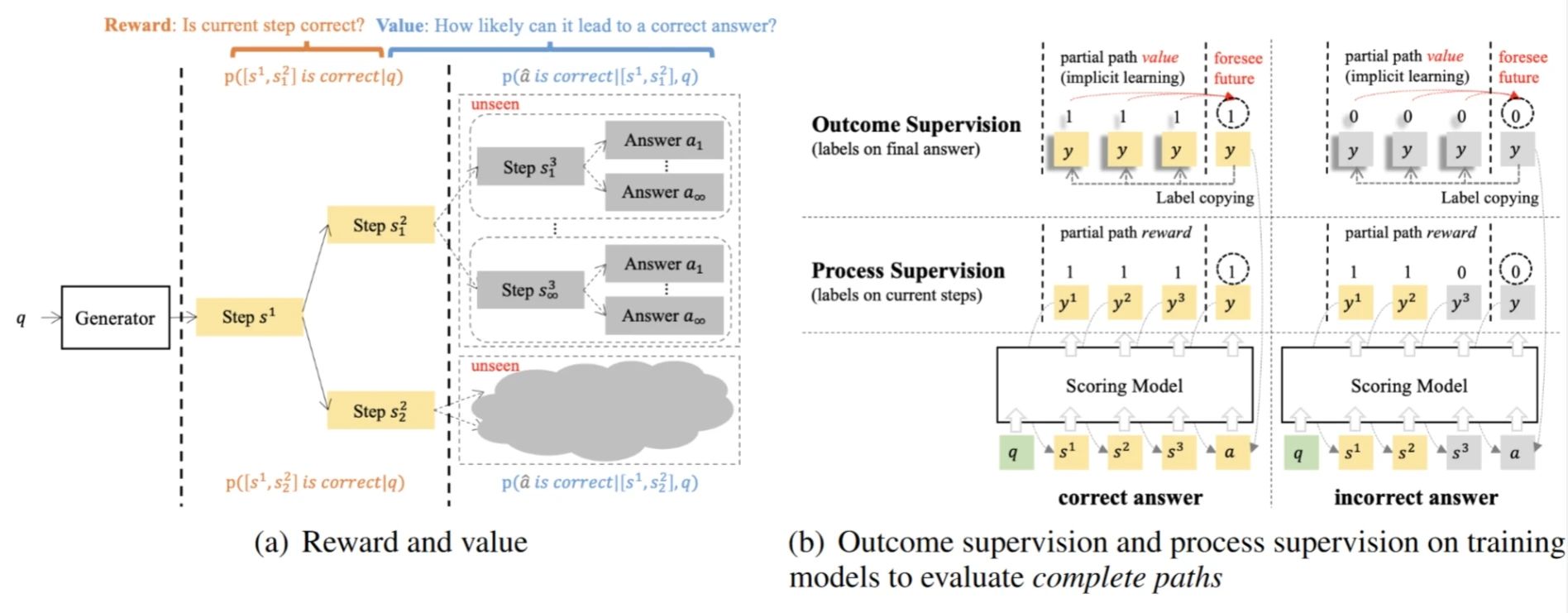

Modèles de valeur supervisés par les résultats (OVM)

Les modèles de valeur supervisés par les résultats consistent à modéliser le raisonnement comme un processus MDP, où la probabilité d'arriver à la bonne réponse à l'étape actuelle (valeur) est utilisée pour guider l'optimisation de la stratégie.

Pourquoi OpenAI a-t-elle choisi de rompre avec les raccourcis traditionnels ?

Pour en revenir à l'article 1, pourquoi avez-vous choisi de rompre avec l'idée traditionnelle du raccourci et d'opter pour le "détour" de la recherche arborescente ?

Si, dans le passé, nous avons eu tendance à exploiter les capacités de base des modèles (Exploit), on peut supposer que les modèles GPT-4 existants ont pu satisfaire la plupart des besoins en matière de dialogue et de raisonnement simple. Et ces tâches peuvent être bien échantillonnées, les préférences évaluées et optimisées de manière itérative.

Mais cette perspective ignore le besoin de tâches plus complexes - telles que le raisonnement mathématique (AIME, Frontier Math), la génération de code (SWE-Bench, CodeForce), etc. qui sont souvent difficiles à récompenser à court terme - leurs récompenses sont très éparses, et les récompenses ne deviennent apparentes que lorsque la bonne réponse est finalement obtenue.

Par conséquent, l'apprentissage par raccourci traditionnel n'est plus adapté à ce type de tâche complexe : comment parler d'optimisation de la probabilité que le modèle choisisse le bon chemin alors que l'on ne peut même pas échantillonner un chemin correct ?

En revenant à l'"idée de Monte-Carlo" du titre de cet article, nous pouvons voir qu'il s'agit en fait de la même chose : le cœur de l'approche Monte-Carlo de l'apprentissage par renforcement réside dans l'estimation de la valeur d'une politique en l'échantillonnant plusieurs fois, et donc en optimisant le modèle. Cependant, cette approche a une limite naturelle : si les politiques échantillonnées ne peuvent pas échantillonner les chemins optimaux, l'optimisation du modèle aboutira toujours à un optimum local. C'est pourquoi nous optons pour des stratégies plus exploratoires dans MC Learning.

OpenAI a donc choisi de briser les échelles de l'apprentissage par renforcement en s'éloignant de la mentalité traditionnelle du raccourci en faveur de l'exploration du renforcement (Explore).

o1 Percées : de l'exploration à l'optimisation

Dans ce contexte, OpenAI a proposé le paradigme o1. Ce changement permet au modèle d'obtenir progressivement des récompenses éparses lorsqu'il est confronté à des tâches complexes ! Et grâce à ces récompenses, la stratégie peut être continuellement optimisée. Bien que ce processus d'exploration puisse sembler lourd et inefficace, il jette les bases d'une optimisation ultérieure du modèle.

D'où vient donc l'o1 ? De nombreux travaux sur la réplication de o1 sont également apparus récemment, que font-ils ? Si la politique comportementale utilisée pour l'exploration est l'approche On-Policy, elle est échantillonnée avec le modèle actuel (par exemple GPT-4o), qui est encore trop inefficace.

C'est donc à l'unanimité qu'ils ont choisi la méthode "hors politique" :

OpenAI dépense beaucoup d'argent pour engager des doctorants afin d'annoter les données Long CoT ; pas d'argent ? Que pouvons-nous faire si nous n'avons pas d'argent ? Nous pouvons alors collaborer avec des humains et des machines pour annoter les données (distiller manuellement o1), et réduire les exigences pour les annotateurs ; Nous n'avons même pas d'argent pour trouver des annotateurs ? Alors nous devons distiller R1 / QwQ, ou penser à d'autres moyens (Critique, PRM, etc.). J'aimerais également rappeler aux grands fabricants et laboratoires qui reproduisent activement l'o1 de ne pas oublier que le but ultime de l'exploration reste l'optimisation !

插一句题外话,虽然大家都在骂 o1 隐藏了真正的思维链,只展示 Summary 的捷径版本。殊不知这个 Summary 才是优化策略的关键数据!但 OpenAI 并不害怕其他人蒸馏这些 Summary,因为蒸馏这些数据还有一个前提——基础模型的能力足够强大,不然步子迈太大还容易闪了腰。

并且 OpenAI 还将探索的成本转嫁给了用户。虽然在初期花很多钱来标注探索型数据,但现在有了 o1 后,用户使用的过程中又无形地为他标注了更多数据。OpenAI 再次实现了伟大的数据飞轮!

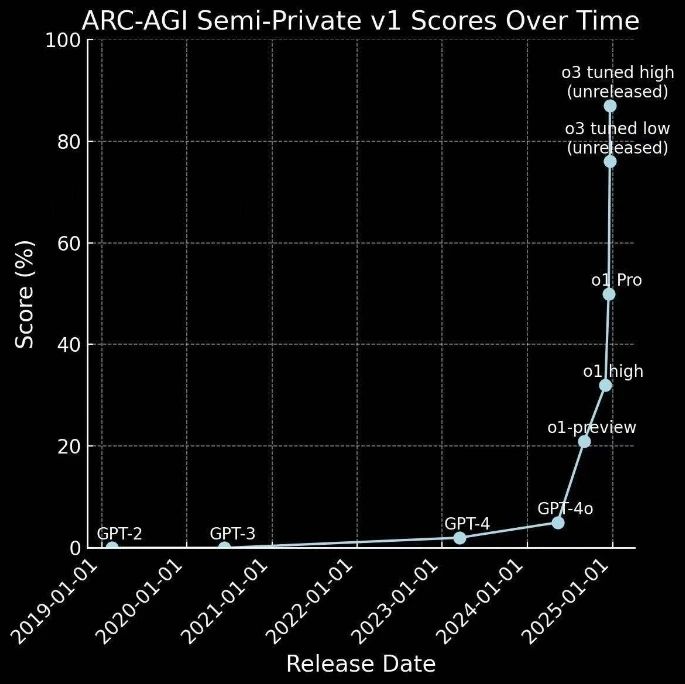

Evolution rapide de o1 à o3

L'o1 est sorti il y a quelques mois et voici l'o3.

En fait, cela va à l'encontre de la conjecture précédente : si le GPT-4 représente une progression de 0 à 1 - c'est-à-dire de tâches simples à l'obtention de récompenses -, o1 représente un saut de 1 à 10 - en explorant des tâches complexes et en obtenant des récompenses rares, ce qui fournit une quantité sans précédent de données de haute qualité pour l'optimisation ultérieure des stratégies. récompenses rares, fournissant une quantité sans précédent de données de haute qualité pour l'optimisation ultérieure de la stratégie.

Elle a donc progressé plus rapidement que prévu :

Il s'agit non seulement d'une application réussie de la stratégie d'exploration, mais aussi d'une étape importante pour la technologie de l'IA vers l'AGI.

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...