Introduction au macromodèle OpenAI o1-mini

Promouvoir des techniques de raisonnement rentables.

Nous avons lancé OpenAI o1-mini, un modèle d'inférence rentable. o1-mini excelle dans les STEM, en particulier en mathématiques et en programmation, avec des performances presque aussi bonnes que celles de l'OpenAI o1-mini. OpenAI o1 des performances comparables sur des tests de référence tels que AIME et Codeforces. Nous pensons que o1-mini deviendra une option plus rapide et plus abordable pour les scénarios d'application qui nécessitent un raisonnement mais ne reposent pas sur une connaissance approfondie du monde.

Aujourd'hui, nous proposons l'OpenAI o1-preview pour 80% moins cher que l'OpenAI o1-preview. utilisateurs de l'API de niveau 5 (s'ouvre dans une nouvelle fenêtre) Lancement de o1-mini. Les utilisateurs de ChatGPT Plus, Team, Enterprise et Edu peuvent utiliser o1-mini comme alternative à o1-preview, en bénéficiant de limites d'utilisation plus élevées et d'une latence plus faible, voir [Model Speed.

Optimisé pour le raisonnement STEM

Les grands modèles linguistiques tels que o1 sont généralement pré-entraînés sur des ensembles de données textuelles à grande échelle. Malgré leur connaissance approfondie du monde, ces modèles à grande capacité peuvent être coûteux et lents dans les applications du monde réel. En revanche, o1-mini est un petit modèle spécifiquement optimisé pour l'inférence STEM au cours de la phase de pré-entraînement. Après avoir été formé à l'aide du même pipeline d'apprentissage par renforcement (RL) à haut volume informatique que o1, o1-mini obtient des résultats comparables dans de nombreuses tâches de raisonnement pratiques, tout en étant nettement plus rentable.

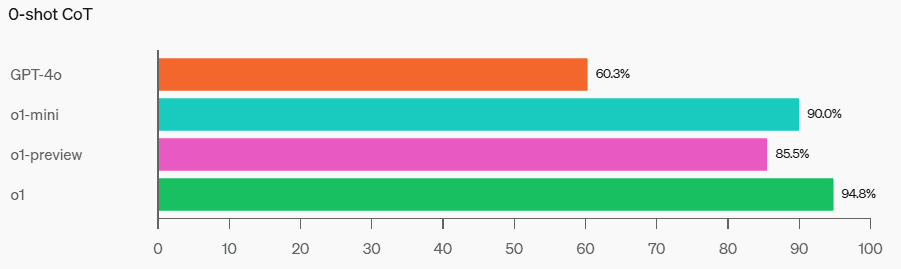

Dans les tests de référence faisant appel à l'intelligence et au raisonnement, o1-mini surpasse o1-preview et o1. Cependant, o1-mini est moins performant dans les tâches nécessitant des connaissances factuelles non-STEM, voir [Limites].

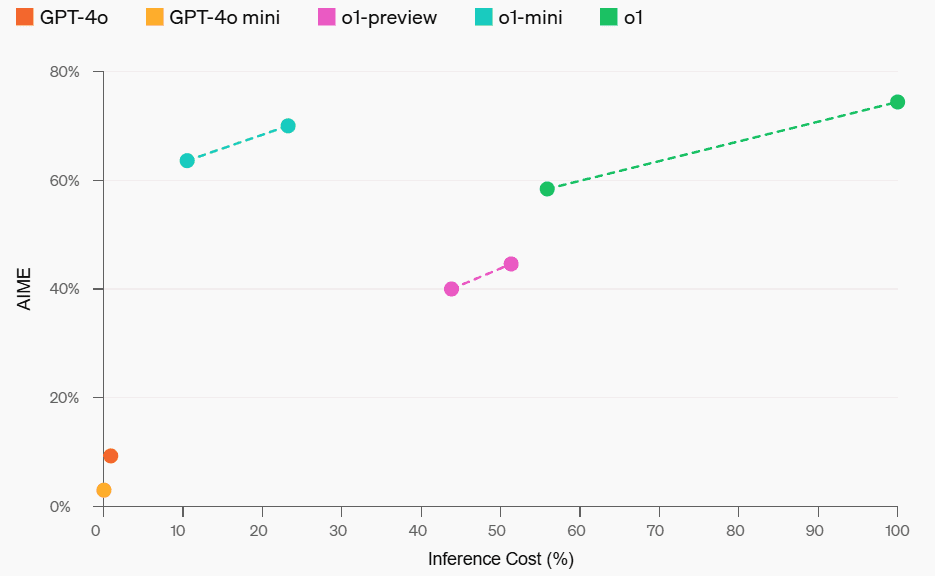

Coûts de la performance et du raisonnement en mathématiques

Maths : Lors du concours de mathématiques AIME pour lycéens, l'o1-mini (70,0%) a obtenu des résultats comparables à ceux de l'o1 (74,4%) - qui était nettement moins cher - et meilleurs que ceux de l'o1-preview ( 44,6%). Les résultats obtenus par o1-mini (environ 15 réponses correctes sur 11 questions) le placent approximativement dans le top 500 des lycéens américains.

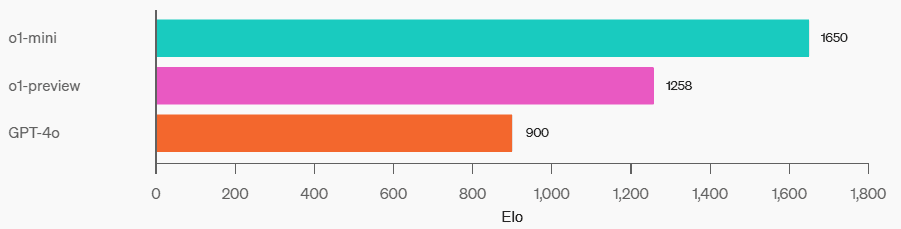

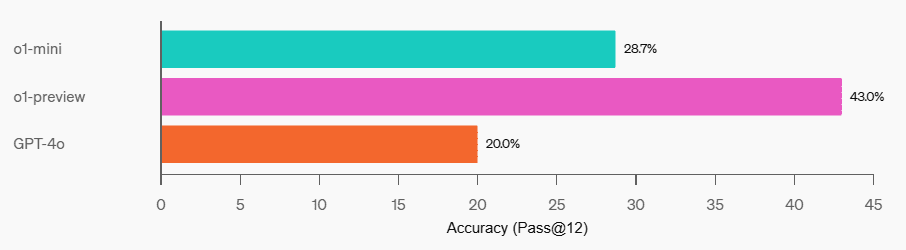

Programmation : Sur le site de compétition Codeforces, o1-mini a un score Elo de 1650, ce qui est comparable à o1 (1673) et supérieur à o1-preview (1258). Ce score Elo place o1-mini dans le 86e percentile des programmeurs sur la plateforme Codeforces. o1-mini a également obtenu de très bons résultats dans les tests de programmation HumanEval et les défis Capture the Flag (CTF) de cybersécurité au niveau lycée.

Codeforces

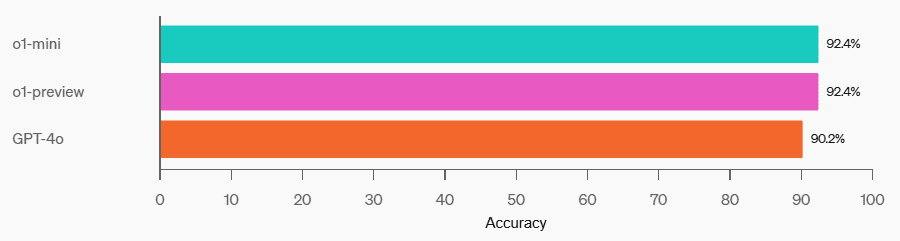

HumanEval

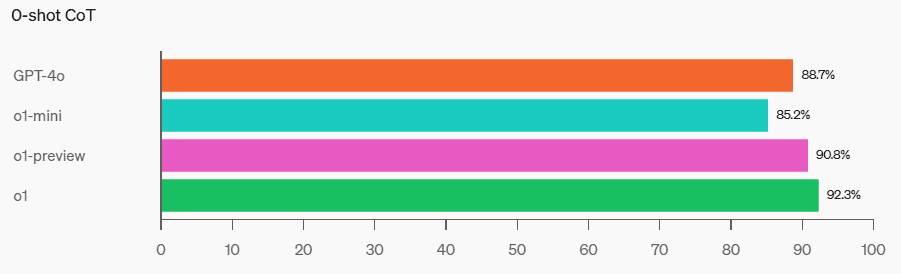

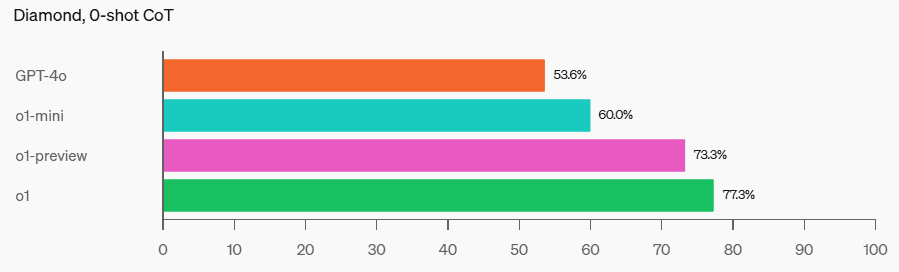

FFC Cybersécurité

STEM : Dans certains tests académiques nécessitant un raisonnement, tels que le GPQA (sciences) et le MATH-500, o1-mini surpasse le GPT-4o. o1-mini n'est pas aussi performant que le GPT-4o dans la tâche MMLU et est à la traîne de o1-preview dans le GPQA parce qu'il ne dispose pas d'une connaissance approfondie du monde.

MMLU

GPQA

MATH-500

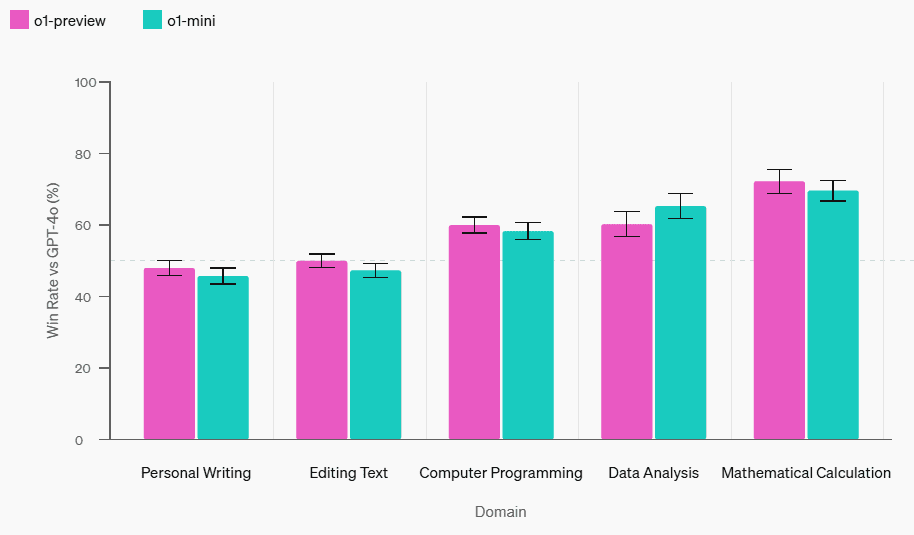

Évaluation des préférences humaines : Nous avons demandé aux évaluateurs de comparer o1-mini avec GPT-4o sur des puzzles ouverts dans une variété de domaines, en utilisant la même méthodologie que celle utilisée dans [o1-preview compared to GPT-4o] (https://openai.com/index/learning-to-reason-with-llms/). Comme pour o1-preview, o1-mini est plus populaire que GPT-4o dans les domaines nécessitant un raisonnement, mais moins populaire que GPT-4o dans les domaines axés sur le langage.

Évaluation des préférences humaines vs chatgpt-4o-latest

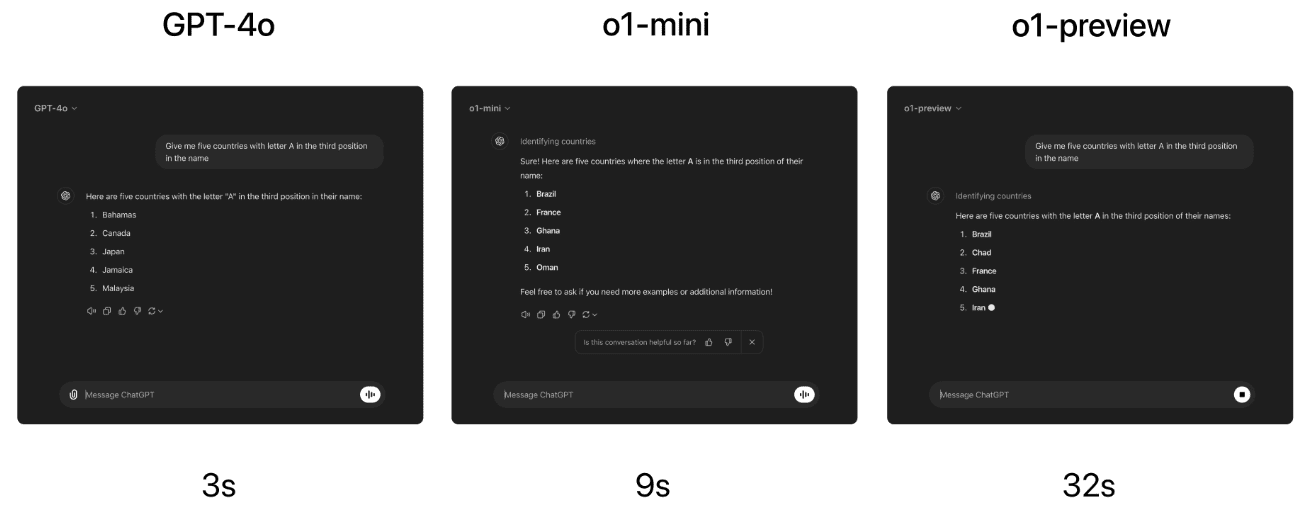

vitesse du modèle

À titre d'exemple concret, nous comparons les réponses de GPT-4o, o1-mini et o1-preview à un problème de raisonnement lexical. Alors que GPT-4o a donné une réponse incorrecte, o1-mini et o1-preview ont tous deux donné la bonne réponse, et o1-mini a répondu environ 3 à 5 fois plus vite.

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...